一種基于LDA模型的關鍵詞抽取方法

朱澤德,李淼,張健,曾偉輝,曾新華

?

一種基于LDA模型的關鍵詞抽取方法

朱澤德1, 2,李淼2,張健2,曾偉輝2,曾新華2

(1. 中國科學技術大學自動化系,安徽合肥,230026 2. 中國科學院合肥智能機械研究所,安徽合肥,230031)

為解決現有方法未能綜合考察文檔主題的全面性、關鍵詞的可讀性以及差異性,提出一種基于文檔隱含主題的關鍵詞抽取新算法TFITF。算法根據大規模語料產生隱含主題模型計算詞匯對主題的TFITF權重并進一步產生詞匯對文檔的權重,利用共現信息排序和選擇相鄰詞匯形成候選關鍵短語,再使用相似性排除隱含主題一致的冗余短語。此外,從文檔統計信息、詞匯鏈和主題分析3方面來進行關鍵詞抽取的對比測試,實驗在1 040篇中文摘要及5 408個關鍵詞構成的測試集上展開。結果表明,算法有效地提高文檔關鍵詞抽取的準確率與召回率。

信息抽取;關鍵詞抽取;LDA模型;主題相似性

關鍵詞多為幾個詞或短語構成的文檔內容概要,關鍵詞抽取是信息時代人們從海量文檔數據中快速、準確地掌握感興趣內容的重要途徑。關鍵詞抽取也稱關鍵詞標注,被大量用于文檔摘要、文本分類、信息過濾和全文檢索等文本處理領域。隨著Web2.0時代的到來,關鍵詞抽取被注入新的活力,網站標簽的自動推薦系統為關鍵詞抽取提供了廣闊的應用空間。近年來,文檔隱含主題分析被研究者大量應用于自然語言處理領域,該技術在關鍵詞抽取方面也發揮了重要的價值。Chen等[1]利用候選關鍵詞的潛在語義索引權重頻率來選擇關鍵詞,Liu等[2]根據文檔主題和候選關鍵詞主題分布的相似度抽取關鍵詞。此類方法通過大規模文檔集合學習隱含主題,避免了單篇文檔信息不足的缺陷。然而在主題層次推薦的關鍵詞傾向于主題常用詞,無法全面覆蓋文檔的主旨信息;單個詞匯表達主題的準確性不強,推薦的關鍵詞可讀性較差;同義詞或近義詞與文檔有相似的主題關系,導致推薦的關鍵詞出現冗余,無法實現詞匯的差異性。針對上述問題,以文檔隱含主題分析為基礎提出一種新的關鍵詞抽取算法詞頻?逆主題頻率(TFITF),該算法基于LDA(latent dirichlet allocation)模型對文檔主題分布進行分析,在關鍵詞與文檔主題一致的條件下增強詞匯對不同主題的表征性,選取能夠充分反映文檔主題且富含更多信息的短語作為候選關鍵詞,并進一步根據詞匯的主題分布的相似性消除冗余短語。此外,從文檔統計頻率信息和詞匯鏈2個方面選擇關鍵詞與主題分析進行實驗對比。

1 相關工作

關鍵詞抽取方法可分為有監督和無監督2類,有監督方法將關鍵詞抽取看成二元分類問題:訓練時提取關鍵詞特征構造分類模型,分類時根據模型判斷詞語是否為關鍵詞。李素建等[3]采用最大熵模型抽取關鍵詞;Nguyen等[4]利用顯著的形態特征抽取科學文獻關鍵詞;Treeratpituk[5]使用隨機森林識別關鍵詞;為改變分類方法無法區分關鍵詞代表文檔的強弱,Jiang等[6]提出學習產生排序器來排序不同的候選關鍵詞。然而有監督方法標注訓練集耗時耗力,分類器受限于特定領域且存在過擬合問題。

無監督方法涉及統計方法、圖模型和語義方法。統計方法主要利用詞頻、詞頻-逆文檔頻率、詞性、詞語位置、詞語同現頻率等信息抽取關鍵詞;Liu等[7]將關鍵詞抽取作為文檔到關鍵詞的翻譯。在圖模型的研究中,Mihalcea等[8]基于詞匯的共現鏈提出TextRank模型排序關鍵詞;Wan等[9]根據鄰近文檔知識將TextRank擴展成ExpandRank;Litvak等[10]將網頁排序的HITS算法引入關鍵詞抽取;李鵬等[11]在TextRank基礎上通過Tag引入相關文檔來估計詞項圖的邊權重并計算詞項的重要度;Bougouin等[12]將詞匯聚類后作為TextRank圖的頂點。在語義的方法中,隱含主題[1?2]通過分析候選關鍵詞的主題分布抽取關鍵詞;胡學鋼等[13]利用詞語在文檔中語義聯系將文檔表示成詞匯鏈形式抽取關鍵詞。

基于語義的方法是一種重要的無監督方法,因無需標注文檔的關鍵詞作為訓練集,又有效利用外部知識輔助關鍵詞抽取。因此,目前關鍵詞抽取研究廣泛關注語義的方法。本文也在隱含主題模型分析文檔語義的基礎上,針對現有方法無法現實文檔主題全面性、關鍵詞可讀性和差異性的綜合考察,提出關鍵詞抽取算法TFITF模型。

在此,重點介紹本文實驗對比中的3個經典無監督模型。

TFIDF模型詞匯的TFIDF權重與詞匯在文檔中出現的頻率成正比,與詞匯在所有文檔中出現的頻率成反比:

其中:N為詞匯在文檔中出現次數,N為文檔中所有詞總數,為文檔集中所有文檔的數目,D為包含詞匯的所有文檔數目。

TextRank模型 借鑒于網頁排序的PageRank算法,TextRank將文檔看作一個詞的網絡,網絡鏈接表示詞v與詞v之間的語義關系。TextRank認為一個詞的重要性S(v)由鏈向它的其他詞的重要性決定:

其中:w為頂點v和v的權重;數值由1個窗口內共現次數確定;A(v)為鄰近頂點集;為衰減因子,設置為0.85。

ExpandRank模型 通過鄰近文檔擴展更多的知識提高關鍵詞抽取的準確性。針對文檔d先用余弦相似性從文檔集中選擇個近鄰的文檔,共現詞匯鏈由1個文檔構建。文檔用1個TFIDF計算詞權重的詞向量表示,給定文檔d和個鄰近文檔構成+1個文檔集,={0,1,2,…,}。頂點來自中詞匯,窗口內共現詞匯v和v頂點鏈接構成邊,邊的權重(v,v)為

其中:simdoc(0,d)為文檔0和d的余弦相似性;countdp(v,v)為文檔d中詞匯v和v的共現次數。

2 關鍵詞抽取

文檔的關鍵詞集合應具備完備性、確定性和獨立性,即關鍵詞的全體能夠全面覆蓋文檔的主題信息,每個關鍵詞應能表達準確的意義,同時關鍵詞間應具有一定的差異性。本節主要闡述為保持關鍵詞集合具備上述特征而提出的TFITF模型具體計算方式,該模型先根據TFITF權值計算候選關鍵詞對文檔的權重,隨后根據同現率合并相鄰候選關鍵詞再按權重大小排序,最后根據短語的主題分布消除冗余。

2.1 LDA模型

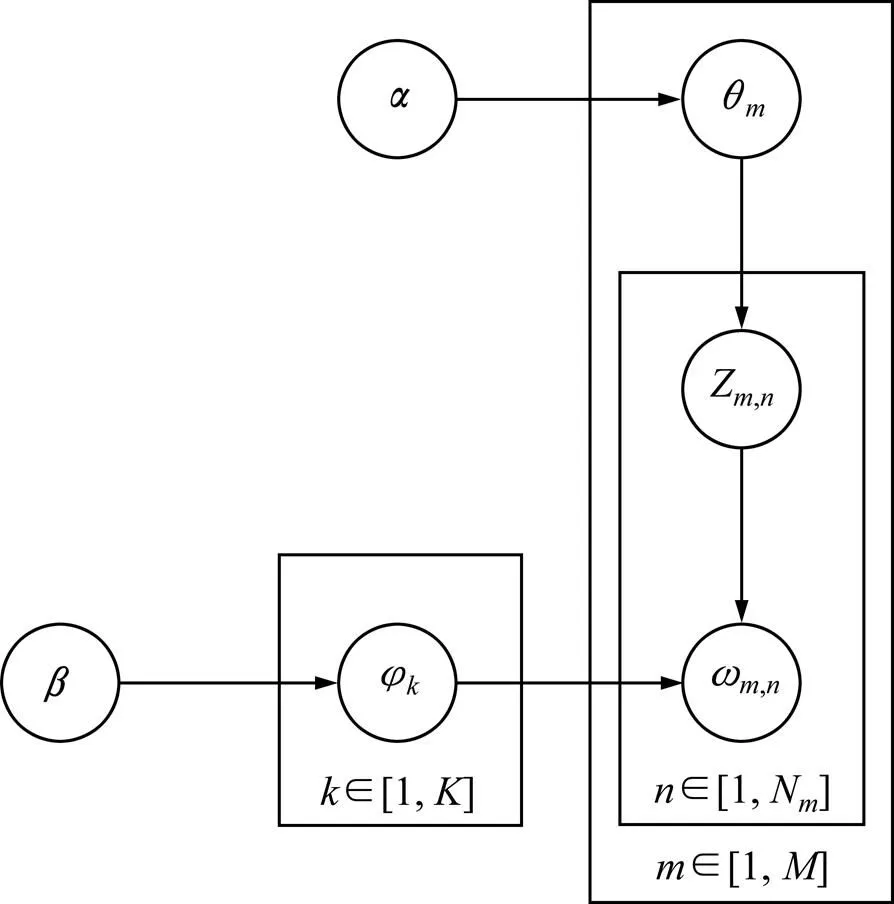

LDA作為一種主題模型被廣泛地用于自然語言處理[14?15],實現對文本數據的主題信息進行完全建模。LDA模型包含詞、主題和文檔三層結構,如圖1所示。LDA最早是Blei等[16]以pLSI為基礎,提出一個服從Dirichlet分布的維隱含隨機變量表示文檔的主題概率分布,模擬文檔的產生過程;Griffiths等[17]對參數施加Dirichlet先驗分布,使得LDA模型成為一個完整的生成模型。

圖1中:φ為主題中的詞匯概率分布,θ為第篇文檔的主題概率分布,φ和θ服從Dirichlet分布,φ和θ作為多項式分布的參數分別用于生成主題和單詞;和分別為φ和θ的分布參數,反映了文檔集中隱含主題間的相對強弱,為所有隱含主題自身的概率分布;為主題數目;為文檔集中文檔數目;N為第篇文檔的詞總數;ω和Z分別為第篇文檔中第個單詞及其隱含主題。

圖1 LDA的圖模型

2.2 TFITF模型

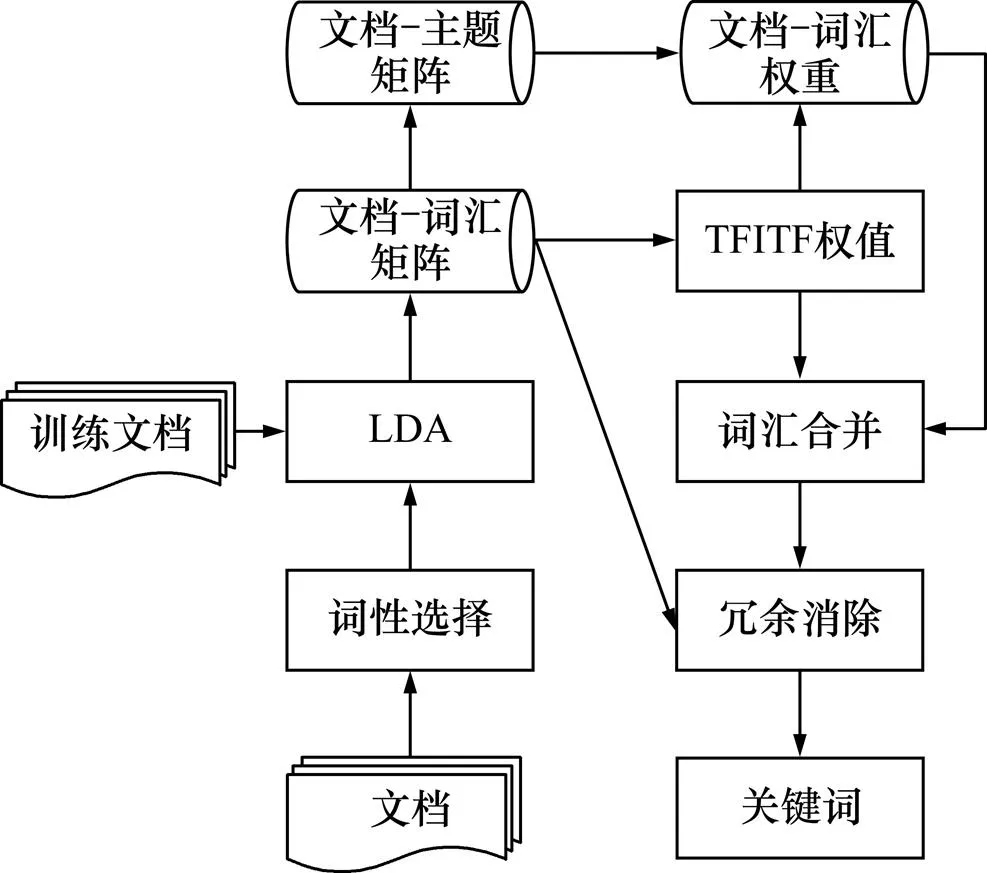

TFITF模型在分析文檔主題信息的基礎上進行文檔關鍵詞抽取,基本流程如圖2所示,主要分為以下5個步驟;

1) 預處理:為排除無關信息對訓練主題模型和關鍵詞抽取的干擾,依據關鍵詞多為名詞性短語的特點,對訓練主題文檔和待抽取關鍵短語文檔分別進行分詞、詞性標注和選取名詞與形容詞等預處理。

2) 主題分析:利用訓練文檔集產生主題模型,預測新文檔集的詞匯對主題的權重以及主題對文檔的權重。

3) TFITF權值計算:根據詞匯對主題的權重以及詞匯在所有主題中出現頻率計算詞匯對主題的TFITF權值,并進一步計算詞匯對文檔的權重。

4) 詞匯合并:利用詞性搭配規則從未預處理的原始文檔篩選出二元候選短語,根據候選短語中各詞匯的共現率以及候選短語權重計算短語構成候選關鍵短語的權值,對預處理文檔中二元短語進行排序形成候選關鍵短語集合{H}。

5) 冗余消除:根據短語的主題分布篩選{H}權值較大且反映文檔不同子主題的個短語構成關鍵詞短語輸出。

圖2 基于TFITF的關鍵詞提取流程

本小節后續內容重點講述以上TFITF權值計算、詞匯合并以及冗余短語消除三步驟的具體實現方法。

2.2.1 TFITF權值計算

選擇Collapsed Gibbs采樣法抽取文檔集的主題模型,具體實現通過每個單詞的主題進行采樣,在獲得單詞ω的主題標號的條件下,計算主題Z中詞匯的概率為

文檔D中主題Z的概率為

其中:C為語料庫中詞被賦予主題Z的次數,C為文檔d中詞被賦予主題Z的次數。

詞匯權重不僅與單一主題相關,也與所有主題集合相關。類比TFIDF模型的思想,詞匯對主題的權值TFITF定義為與詞匯在主題中出現的概率成正比,與詞匯在所有主題中出現的頻率成反比。其中,詞頻(TF)為詞匯對主題的頻率,詞匯對主題Z的詞頻Tf取為φ,反映詞匯對主題Z的重要性;逆主題頻率(ITF)為詞匯對所有主題的逆主題頻率,避免了某些詞匯出現在主題的頻數過高而降低對不同主題的區分能力,n對Z的逆主題頻率如下式計算:

則在給定詞匯條件下,對主題Z的TFITF權重定義為:

其中:為詞匯對主題的噪聲閾值。在LDA概率主題模型中,所有詞匯都以一定的概率出現在每個主題,小概率的詞匯無法體現主題的實際內容且構成計算相似度的“噪音”。實驗中設定閾值為0.005,即若φ<,則認為主題Z不體現在詞匯上。

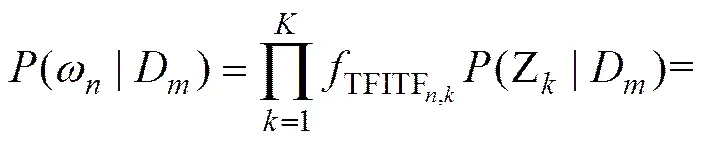

根據對主題Z的權重,結合主題Z在文檔D的概率θ,詞匯對文檔D的權重計算公式如下:

2.2.2 詞匯合并

短語比單個詞匯具有更強的可讀性和語義的完整性,能準確地表達文檔的主旨信息。根據大部分手工標注的關鍵詞為二元結構的名詞短語,文中構成名詞短語的搭配模板采用“名詞+名詞”或“形容詞+名詞”的結構。

為檢測搭配模板構成短語的可能性,針對短語的內部詞匯計算共現概率,通過共現概率的大小反映不同詞匯間相關性的強弱。當2個詞匯的共現概率越高,它們具有的相關性越強,構成短語的可能性越大。選擇待抽取關鍵詞文檔中滿足搭配模板的詞匯1和2,計算構成候選短語的可能性如下式:

其中:(1,2)為1和2在待抽取關鍵詞文檔中滿足詞法構成規則共現的次數,(ω)(=1,2)為詞ω在待抽取關鍵詞文檔中出現次數。

根據的構成詞匯ω對文檔D的權重,按式(10)計算對D的權重(|D)。

候選短語對文檔D的綜合權值P(|D)融合了自身構成的可能性和對D的權重,如式(11)計算。

(11)

根據綜合權重大小排序二元短語構成形成候選關鍵短語集合{H}。

2.2.3 冗余短語消除

關鍵詞集合中所有詞匯或短語應盡可能反映文檔的不同主題或從不同的角度反映文檔主題,避免出現同義或近義的冗余短語。短語對主題Z的權值定義為所有構成詞匯ω對主題的乘積,如式(12)所示。

根據貝葉斯公式計算短語的主題Z概率為:

其中:參數(Z)/()近似為訓練集中主題Z出現的次數N除以出現的次數N。

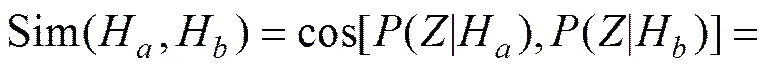

由式(13)計算短語對各主題的分布(|),候選關鍵詞集合{H}中的詞匯或短語H和的相似性由主題分布的余弦來衡量,如下式:

利用短語的相似性排除{H}中與權值較大的短語相似度過高的短語,形成新的候選關鍵短語集合{H′}。當限制關鍵詞輸出數目時,則截斷輸出{H’}中權值排序較大的短語形成關鍵詞集合。

3 實驗

3.1 實驗數據與評價

選取碩博論文數據進行關鍵詞抽取實驗,數據由1 040篇論文摘要構成,涵蓋了基礎科學、工程科技、農業科技、醫藥衛生科技、哲學與人文科技、社會科學、信息科學和經濟科學領域,手工標注了5 408個關鍵詞,平均每篇文檔關鍵詞個數為5.2,數據集稱為THESIS。對THESIS中的文檔進行分詞和詞性標注,過濾停用詞,將名詞、動詞和形容詞作為候選關鍵詞。因THESIS包含文檔數較少,不足以訓練隱含主題模型,在THESIS的基礎上增加網絡獲取的中文新聞語料,過濾長度小于200個詞的短小文本,得到10 640篇文檔訓練隱含主題模型。

實驗采用準確率、召回率和1(Precision/Recall/F1-Measure)來評價關鍵詞抽取的效果。correct/extract,correct/standard,1/ ()。其中,correct為正確抽取的關鍵詞數目,extract為所有抽取的關鍵詞數目,而standard為所有人工標注的標準關鍵詞數目。

3.2 結果和分析

為測試本文提出的關鍵詞抽取算法的性能,計算了TFITF模型抽取文檔關鍵詞的準確率和召回率,并同詞匯頻率信息、詞匯鏈信息、擴展詞匯鏈信息其他3個無監督算法進行對比,最后進一步闡述了各算法的參數選擇依據。

3.2.1 實驗對比

實驗中采用的文檔關鍵詞抽取的無監督算法分別為:

1) TI1:基于詞頻?逆文檔頻率TFIDF的關鍵詞抽取,文檔集的詞匯頻率信息;

2)TR:基于TextRank的關鍵詞抽取,單文檔的局部詞匯鏈關系;

3) ER:基于ExpandRank的關鍵詞抽取,擴展鄰近文檔的局部詞匯鏈關系;

4) TI2:基于詞頻?逆主題頻率TFITF的關鍵詞抽取,訓練集的全局詞匯關系;

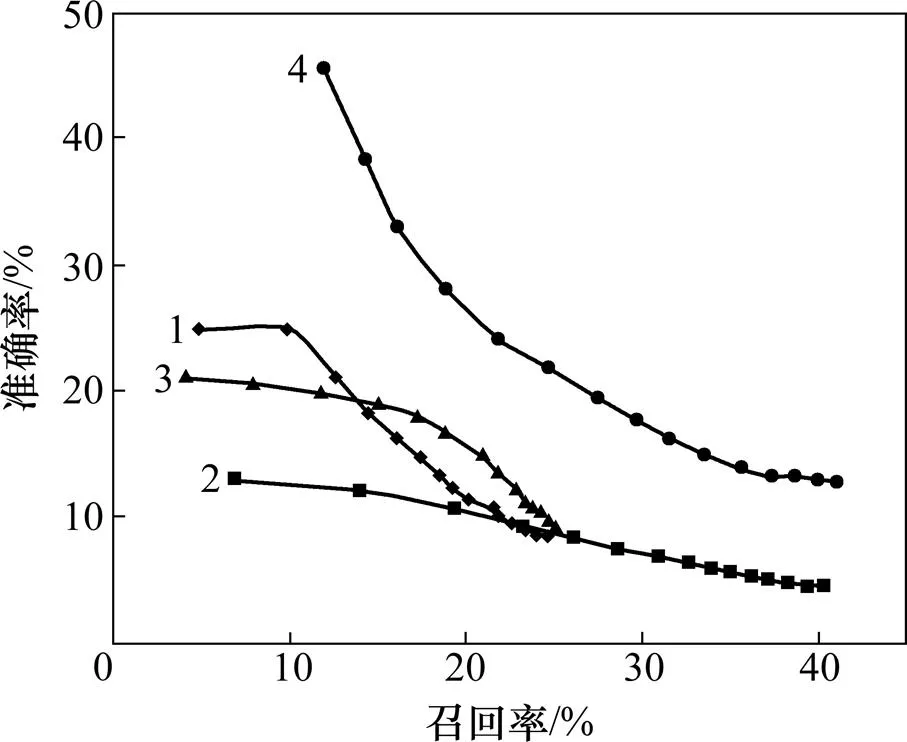

上述各算法對文檔的關鍵詞抽取的準確率?召回率曲線如圖3所示。在每條準確率?召回率曲線上,每個點代表推薦不同的關鍵詞數目時的評價結果,從左上=1至右下=15,曲線越靠近右上方,說明算法的效果總體越優。每一算法都為參數調整后的最優結果,對于TR設置窗口為6,ER設置近鄰文檔數為1,TI2設置隱含主題數為200。

1—TI1;2—IR;3—ER;4—TI2

由圖3可知:算法TI1雖在幾種無監督算法中最易實現,但在抽取文檔中少量的關鍵詞時TI1的準確率優于算法TR和ER;隨著關鍵詞數量的增長,算法的準確率迅速下降,同時召回率增長緩慢,反映了TI1在抽取的關鍵詞數量增多時正確抽取的關鍵詞數量增幅較小。TI1通過統計文檔集中詞匯出現的頻率信息抽關鍵詞,對部分高頻的關鍵詞反應敏感。

算法TR抽取關鍵詞的召回率同TI1基本一致,準確率在抽取的關鍵詞數量增加時略優于TI1。TR通過詞匯在文檔中出現的連續性建立詞匯鏈,詞匯的關聯信息局限于單個文檔,無外部知識進行補充和修正,且僅僅從詞匯的層面分析重要性,制約了文檔抽取關鍵詞的效率。

算法ER擴展于TR,然而ER抽取關鍵詞的準確率最低,ER采取的策略是在文檔層面引入外部資源,供詞匯共現信息來進行分析。然而文檔集中相關性較弱會導致大量無關的噪音產生;召回率在抽取的關鍵詞數量增加時有較快的增長。

算法TI2抽取關鍵詞的準確率和召回率都明顯優于其他無監督算法。TI2通過大量的數據集產生主題信息,并強化詞匯對不同主題的區分性,進一步結合待抽取關鍵詞文檔的詞匯共現信息和詞匯間相關性信息。該方法綜合了文檔隱含主題信息和文檔詞匯信息實現了關鍵詞抽取,一方面使關鍵詞對文檔主題具有良好的覆蓋度,另一方面避免了被抽取的關鍵詞趨向主題的常用詞。

3.2.2 參數選擇

分別考察了帶參數的單一無監督算法TR,ER和TI2中參數對關鍵詞抽取的影響,為3.2.1節中各組合方式中參數選擇提供依據。

圖4所示為TR模型中窗口大小取2,4,6和8情形時,關鍵詞數從1增長至15的過程中準確率?召回率曲線隨關鍵詞數目從左上漸變至右下。當窗口增長至8時,抽取的性能與為6時基本保持一致,卻增加了系統的時間消耗,因此確定最優為6。

w:1—2;2—4;3—6;4—8

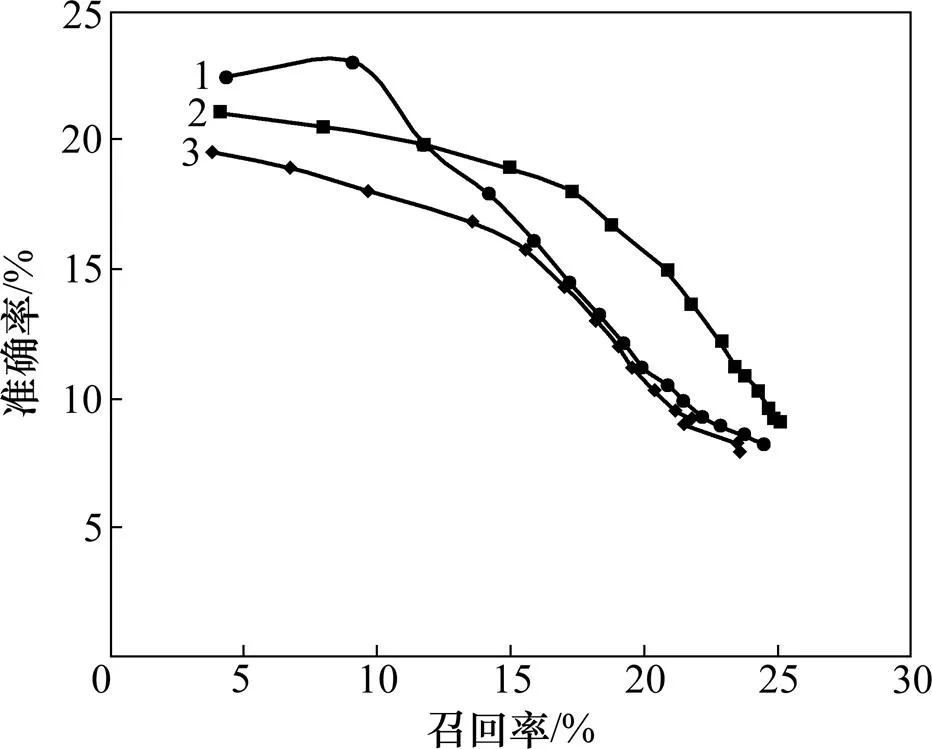

圖5所示為取6,ER的鄰近文檔數分別為0,1和2時,準確率?召回率曲線圖從左上遞漸變至右下,當為1時,算法獲得最佳的效果。當鄰近文檔數繼續增長時性能下降,主要因ER是在文檔層面引入外部知識,導致無關的噪聲引入,取決于文檔集中文檔間的相關程度。

h:1—0;2—1;3—2

Fig. 5 Precision?recall curves of ER adopting nearest neighbor documentsas 0, 1 or 2

圖6所示為隨隱含主題個數不同,TI2抽取關鍵詞的性能隨著主題個數變化波動較小,這表明TI2利用文檔和詞匯的主題分布進行關鍵詞抽取的魯棒性高,在達到200時模型的性能基本穩定,增至300時幾乎不再提高。

k:1—100;2—200;3—300

4 結論

針對傳統的無監督方法抽取關鍵詞未能很好地解決關鍵詞未能全面和準確地覆蓋文檔主旨信息,提出了一種基于LDA模型的TFITF算法抽取關鍵短語,該方法通過增強詞匯對不同主題的表征能力,避免推薦關鍵詞匯傾向于常用詞;再根據相鄰詞匯的共現率和權重合并產生候選關鍵短語,提高對關鍵詞的信息量和可讀性;最后利用不同短語描述不同的主題信息,排除關鍵詞組合的冗余性。通過同現有無監督關鍵詞抽取算法的對比測試,實驗顯示了很好的效果。

如何在詞匯層面引入更精準的外部信息,避免從文檔層面或主題層面導致主題漂移,是今后改進和完善關鍵短語提取方法的重點。

[1] CHEN Jilin, YAN Jun, ZHANG Benyu, et al. Diverse topic phrase extraction through latent semantic analysis[C]// Proceedings of the Sixth International Conference on Data Mining. IEEE, 2006: 834?838.

[2] LIU Zhiyuan, SUN Maosong. Domain-specific term rankings using topic models[M]. Berlin Heidelberg: Springer, 2010: 454?465.

[3] 李素建, 王厚峰, 俞士汶, 等. 關鍵詞自動標引的最大熵模型應用研究[J]. 計算機學報, 2004, 27(9): 92?97. LI Sujian, WANG Houfeng, YU Shiwen, et al. Research on maximum entropy model for keyword indexing[J]. Chinese Journal of Computers, 2004, 27(9): 92?97.

[4] Nguyen T D, Kan M Y. Keyphrase extraction in scientific publications[M]. Berlin Heidelberg: Springer, 2007: 317?326.

[5] Treeratpituk P, Teregowda P, Huang J, et al. Seerlab: A system for extracting key phrases from scholarly documents[C]//Proceedings of the 5th International Workshop on Semantic Evaluation. Association for Computational Linguistics, 2010: 182?185.

[6] Jiang X, Hu Y, Li H. A ranking approach to keyphrase extraction[C]//Proceedings of the 32nd International ACM SIGIR Conference on Research and Development in Information Retrieval. ACM, 2009: 756?757.

[7] LIU Zhiyuan, CHEN Xinxiong, ZHENG Yabin, et al. Automatic keyphrase extraction by bridging vocabulary gap[C]// Proceedings of the Fifteenth Conference on Computational Natural Language Learning. Association for Computational Linguistics, 2011: 135?144.

[8] Mihalcea R, Tarau P. TextRank: Bringing order into texts[C]//Proceedings of the Conference on Empirical Methods in Natural Language Processing. Association for Computational Linguistics, 2004.

[9] WAN Xiaojun, XIAO Jianguo. Single document keyphrase extraction using neighborhood knowledge[C]//Proceedings of the 23rd National Conference on Artificial Intelligence. American Association for Artificial Intelligence, 2008: 855?860.

[10] Litvak M, Last M. Graph-based keyword extraction for single-document summarization[C]//Proceedings of the Workshop on Multi-source Multilingual Information Extraction and Summarization. Association for Computational Linguistics, 2008: 17?24.

[11] 李鵬, 王斌, 石志偉, 等. Tag-TextRank: 一種基于Tag的網頁關鍵詞抽取方法[J]. 計算機研究與發展, 2012, 49(11): 2344?2351. LI Peng, WANG Bin, SHI Zhiwei, et al. Tag-TextRank Extraction Method Based on Tags[J]. Journal of Computer Research and Development, 2012, 49(11): 2344?2351.

[12] Bougouin A, Boudin F, Daille B. TopicRank: Graph-Based Topic Ranking for Keyphrase Extraction[C]//Proceedings of the International Joint Conference on Natural Language Processing (IJCNLP). Nagoya, 2013: 543?551.

[13] 胡學鋼, 李星華, 謝飛, 等. 基于詞匯鏈的中文新聞網頁關鍵詞抽取方法[J]. 模式識別與人工智能, 2010(1): 45?51. HU Xuegang, LI Xinghua, XIE Fei, et al. Keyword extraction based on lexical chains for Chinese news web pages[J]. Recognition and Artificial Intelligence, 2010(1): 45?51.

[14] 石晶, 胡明, 石鑫, 等. 基于 LDA 模型的文本分割[J]. 計算機學報, 2008, 31(10): 1865?1873. SHI Jing, HU Ming, SHI Xin, et al. Text Segmentation Based on Model LDA[J]. Chinese Journal of Computers, 2008, 31(10): 1865?1873.

[15] Hoffman M, Bach F R, Blei D M. Online learning for latent dirichlet allocation[C]//Advances in Neural Information Processing Systems, 2010: 856?864.

[16] Blei D M, Ng A Y, Jordan M I. Latent dirichlet allocation[J]. Journal of Machine Learning Research, 2003, 3: 993?1022.

[17] Griffiths T L, Steyvers M. Finding scientific topics[C]// Proceedings of the National Academy of Sciences of the United States of America. The National Academy of Sciences, 2004, 101(Suppl 1): 5228?5235.

(編輯 陳愛華)

A LDA-based approach to keyphrase extraction

ZHU Zede1, 2, LI Miao2, ZHANG Jian2, ZENG Weihui2, ZENG Xinhua2

(1. Department of Automation, University of Science and Technology of China, Hefei 230026, China;2. Institute of Intelligent Machines, Chinese Academy of Sciences, Hefei 230031, China)

Due to the shortage of the comprehensive analysis of the coverage of document topics, the readability and difference of keyphrases, a new algorithm of keyphrase extraction TFITF based on the implicit topic model was put forward. The algorithm adopted the large-scale corpus and producted latent topic model to calculate the TFITF weight of vocabulary on the topic and further generate the weight of vocabulary on the document. And adjacent lexical was ranked and picked out as candidate keyphrases based on co-occurrence information. Then according to the similarity of vocabulary topics, redundant phrases were eliminated. In addition, the comparative experiments of candidate keyphrases were executed by document statistical information, vocabulary chain and topic information. The experimental results, which were carried out on an evaluation dataset including 1 040 Chinese documents and 5 408 standard keyphrases, demonstrate that the method can effectively improve the precision and recall of keyphrase extraction.

information extraction; keyphrase extraction; LDA model; topic similarity

10.11817/j.issn.1672-7207.2015.06.023

TP391

A

1672?7207(2015)06?2142?07

2014?06?13;

2014?08?20

模式識別國家重點實驗室開放課題基金資助項目(201306320);中國科學院信息化專項(XXH12504-1-10);國家自然科學基金資助項目(61070099)(Project (201306320) supported bythe Open Projects Program of National Laboratory of Pattern Recognition; Project (XXH12504-1-10) supported by the Informationization Special Projects of Chinese Academy of Science; Project (61070099) supported by the National Natural Science Foundation of China)

李淼,研究員,博士生導師,從事人工智能與知識工程研究;E-mail:mli@iim.ac.cn