骨架關(guān)節(jié)點(diǎn)跟蹤的人體行為識別方法

陳 曦,孟慶虎

(1.河南科技大學(xué) 電子信息工程學(xué)院,河南 洛陽 471023;2.香港中文大學(xué) 電子工程學(xué)系,香港 999077)

骨架關(guān)節(jié)點(diǎn)跟蹤的人體行為識別方法

陳曦1,孟慶虎2

(1.河南科技大學(xué) 電子信息工程學(xué)院,河南 洛陽 471023;2.香港中文大學(xué) 電子工程學(xué)系,香港 999077)

摘要:基于彩色圖像的運(yùn)動檢測和分割方法難以獲取完整的人體骨架,并且只能提取關(guān)節(jié)點(diǎn)的二維坐標(biāo)信息,而Kinect傳感器能通過捕獲深度圖像來重建完整的人體骨架關(guān)節(jié)點(diǎn)三維模型,提高了骨架關(guān)節(jié)點(diǎn)模型的表示精度。本文通過Kinect的骨架跟蹤模塊對人體的骨架關(guān)節(jié)點(diǎn)模型進(jìn)行提取;然后,提出一種坐標(biāo)轉(zhuǎn)換方法得到人體骨架關(guān)節(jié)點(diǎn)的三維坐標(biāo)表示,利用k均值聚類將關(guān)節(jié)點(diǎn)坐標(biāo)量化為符號序列;最后,建立離散隱馬爾可夫模型來進(jìn)行人體行為識別。通過自建的數(shù)據(jù)集進(jìn)行實(shí)驗(yàn),實(shí)驗(yàn)結(jié)果表明:本方法能取得94%的識別率。

關(guān)鍵詞:人體行為識別;骨架關(guān)節(jié)點(diǎn);離散隱馬爾可夫模型

基金項目:國家“863”計劃基金項目(2011AA041001)

作者簡介:陳曦(1987-),男,河南洛陽人,碩士生;孟慶虎(1962-),男,山東濟(jì)南人,教授,博士,博士生導(dǎo)師,主要從事醫(yī)用機(jī)器人、機(jī)器視覺、智能控制及系統(tǒng)方面的研究.

收稿日期:2014-12-07

文章編號:1672-6871(2015)02-0043-06

中圖分類號:TP391.4

文獻(xiàn)標(biāo)志碼:志碼:A

0引言

人體行為識別廣泛應(yīng)用于運(yùn)動分析、人機(jī)自然交互、智能監(jiān)控等諸多領(lǐng)域,研究內(nèi)容主要有運(yùn)動檢測與跟蹤、特征表示與提取和行為識別[1-3]。其中,骨架關(guān)節(jié)點(diǎn)模型是一種基于形態(tài)學(xué)特征的人體表示方法,早在1973年,文獻(xiàn)[4]就證明了人體運(yùn)動行為模式可以通過若干個人體關(guān)節(jié)亮點(diǎn)來表示,奠定了其理論基礎(chǔ)。近些年來,隨著傳感器技術(shù)的發(fā)展,使得對人體骨架關(guān)節(jié)點(diǎn)模型的研究得到了廣泛的關(guān)注。

骨架關(guān)節(jié)點(diǎn)提取方法主要分為兩類:一類是通過人體穿戴上傳感器,來捕獲人體骨架關(guān)節(jié)點(diǎn)的運(yùn)動信息,該方法成本較高難以廣泛應(yīng)用。另一類是基于圖像的運(yùn)動檢測方法(如背景減除法[5]、幀間差分法[6]、光流法[7]等)來獲取人體運(yùn)動剪影圖像;然后使用拓?fù)浼?xì)化法[8]、距離變換法[9]、Voronoi圖等方法[10]進(jìn)行骨架提取;最后通過標(biāo)記得到人體的骨架關(guān)節(jié)點(diǎn)模型。這些方法成本較低,但其性能依賴于運(yùn)動檢測算法,對環(huán)境干擾的魯棒性較差并且不能提供關(guān)節(jié)點(diǎn)三維信息表示。

隨著Kinect深度圖像傳感器的出現(xiàn),文獻(xiàn)[11]提出了一種基于單幅深度圖像的人體關(guān)節(jié)位置提取方法來重建了人體骨架模型,該方法由于具有較強(qiáng)的魯棒性并且能提供骨架關(guān)節(jié)點(diǎn)的三維坐標(biāo)信息,已被應(yīng)用于Kinect的骨架跟蹤模塊中。由于基于背景差分法所提取的人體骨架會受到背景影響,即當(dāng)背景和運(yùn)動前景的灰度或顏色相近時,就難以提取完整的人體剪影,從而破壞了獲取的骨架結(jié)構(gòu)。另外,陰影和衣服也會使得提取骨架過程中形成“假骨骼”,從而給建立骨架關(guān)節(jié)點(diǎn)模型造成了干擾。由于使用大量多樣化的訓(xùn)練數(shù)據(jù),通過Kinect獲取的骨架模型對不同的姿勢、身體形狀和衣服具有很強(qiáng)的魯棒性,而且由于提供骨架關(guān)節(jié)點(diǎn)的三維位置信息,使得Kinect提取的人體骨架關(guān)節(jié)點(diǎn)模型能有效處理“自遮擋”問題。

本文通過采用Kinect的骨架跟蹤模塊來獲取人體的骨架關(guān)節(jié)點(diǎn)模型,通過提出一種人體關(guān)節(jié)點(diǎn)坐標(biāo)的表示方法,得到人體骨架關(guān)節(jié)點(diǎn)三維坐標(biāo);然后,將跟蹤得到的骨架關(guān)節(jié)點(diǎn)運(yùn)動坐標(biāo)序列進(jìn)行量化編碼為符號序列,通過建立相應(yīng)無跨越從左到右的離散隱馬爾可夫模型來進(jìn)行對人體行為的識別;最后,通過自建的數(shù)據(jù)集對模型進(jìn)行訓(xùn)練和測試。圖1是本文所采用的骨架關(guān)節(jié)點(diǎn)跟蹤的人體行為識別方法的流程圖。

圖1 人體行為識別方法流程圖

1骨架關(guān)節(jié)點(diǎn)三維坐標(biāo)提取與轉(zhuǎn)換

人體可被認(rèn)為是由若干個關(guān)節(jié)點(diǎn)所鏈接的一個剛性段鉸接系統(tǒng),因此,人體的行為可以由關(guān)節(jié)點(diǎn)運(yùn)動的位置狀態(tài)來表示。Kinect的骨架跟蹤模塊最多支持6個人體的跟蹤,能主動跟蹤2個人體骨架三維坐標(biāo)。圖2為被跟蹤人體20個骨架關(guān)節(jié)點(diǎn)的平面圖。

被跟蹤的人體的骨架關(guān)節(jié)點(diǎn)位置由一個X、Y、Z的三維直角坐標(biāo)系表示出。Z軸表示紅外攝像頭光軸,與RGB圖像平面垂直,光軸與圖像平面的交點(diǎn)為坐標(biāo)系原點(diǎn)。由于骨架跟蹤模塊所跟蹤獲取的骨架關(guān)節(jié)點(diǎn)坐標(biāo)是以Kinect的世界坐標(biāo)系作為參照系,因此,為了使提取到的關(guān)節(jié)點(diǎn)坐標(biāo)歸一化到統(tǒng)一的參考系下,需要對關(guān)節(jié)點(diǎn)坐標(biāo)進(jìn)行轉(zhuǎn)換。

圖2 人體20個骨架關(guān)節(jié)點(diǎn)的平面圖

本文根據(jù)空間直角坐標(biāo)系的轉(zhuǎn)換方式對提取的關(guān)節(jié)點(diǎn)坐標(biāo)進(jìn)行轉(zhuǎn)換,建立人體關(guān)節(jié)點(diǎn)坐標(biāo)。通過選取髖關(guān)節(jié)中心作為參考坐標(biāo)系的原點(diǎn)進(jìn)行坐標(biāo)轉(zhuǎn)換,使獲取的骨架關(guān)節(jié)點(diǎn)坐標(biāo)對平移具有不變性。獲得靜態(tài)的20個關(guān)節(jié)點(diǎn)的Kinect世界坐標(biāo)分別為:

D1(x1,y1,z1),D2(x2,y2,z2),…,D20(x20,y20,z20),

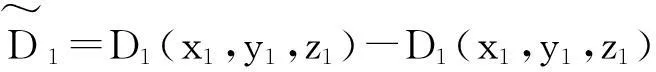

其中,D1(x1,y1,z1)為髖關(guān)節(jié)中心。通過如下坐標(biāo)變換將20個關(guān)節(jié)點(diǎn)以髖關(guān)節(jié)中心作為原點(diǎn)表示出來:

···

2k均值聚類與矢量量化

圖3為人體右手做“畫圓圈”行為時留下的關(guān)節(jié)點(diǎn)的時空坐標(biāo)分布。由于人體的行為可以表示為關(guān)節(jié)點(diǎn)的坐標(biāo)分布,所以需要將每一幀圖像的關(guān)節(jié)點(diǎn)坐標(biāo)轉(zhuǎn)化為對應(yīng)的觀測符號,使得每個行為可以被表示為一個具有有限符號數(shù)的觀測序列。為了減少觀測符號的數(shù)量,在利用離散隱馬爾可夫模型(DHMM)進(jìn)行人體行為識別前,需要通過矢量量化將提取的特征向量進(jìn)行聚類。

k均值聚類是一種常用的聚類方法,能將表示人體行為的骨架關(guān)節(jié)點(diǎn)的三維坐標(biāo)分布聚類到有限的狀態(tài)集,使得每個行為被編碼成一個有限的符號序列。通過設(shè)置類別個數(shù),k均值聚類能迅速收斂并找到數(shù)據(jù)的類別中心,圖4為做“畫圓圈”時,右手關(guān)節(jié)點(diǎn)的坐標(biāo)時空分布經(jīng)過k均值聚類為8個群集的結(jié)果,其中每一個群集對應(yīng)于一個聚類中心。

圖3 人體做“畫圓圈”時右手關(guān)節(jié)點(diǎn)的坐標(biāo)時空分布 圖4 坐標(biāo)時空分布經(jīng)過k均值聚類為8個群集的結(jié)果

3基于離散隱馬爾可夫模型的人體行為識別

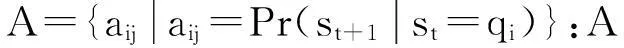

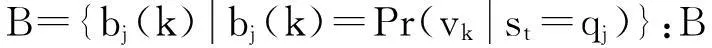

隱馬爾可夫模型(HMM)是一種生成模型,廣泛應(yīng)用于識別、鑒定和預(yù)測[12]。1992年,文獻(xiàn)[13]首次將隱馬爾可夫模型應(yīng)用到行為識別并取得了良好效果。目前,各種改進(jìn)的隱馬爾可夫模型已經(jīng)廣泛應(yīng)用于人體行為識別領(lǐng)域并取得良好的識別效果[14-16]。無跨越從左到右型離散隱馬爾可夫模型(DHMM)的結(jié)構(gòu)見圖5。

3.1 離散隱馬爾可夫模型的定義

DHMM是具有離散的狀態(tài)數(shù)和輸出符號的隱馬爾可夫模型。無跨越從左到右型DHMM結(jié)構(gòu)見圖5。如圖5所示,本文采用的無跨越從左到右型的DHMM是一種非遍歷型的隱馬爾可夫模型,即隨著時間的增加,狀態(tài)只能轉(zhuǎn)移到自身或鄰近下標(biāo)較大的狀態(tài)。由于其狀態(tài)轉(zhuǎn)移路徑可以由自身轉(zhuǎn)移到自身,從而確保了DHMM的時間尺度不變性。

圖5 無跨越從左到右型DHMM的結(jié)構(gòu)

為了描述一個DHMM,定義以下符號:

Q={q1,q2,…,qN}:Q為狀態(tài)集。

N:模型的隱藏狀態(tài)的數(shù)量。

V={v1,v2,…,vM}:V為輸出符號集。

M:狀態(tài)輸出符號數(shù)量。

O=O1,O2,…,OT:O為長度為T的觀測符號序列。

S={st},t=1,2,…,T:st為第t觀測符號所對應(yīng)的隱藏狀態(tài)。

λ={A,B,π}:λ構(gòu)成DHMM的完整參數(shù)集。

3.2 DHMM的評估

(1)

α1=πibi(O1),t=1;

(2)

(3)

(4)

(5)

βt(i)=1,t=T;

(6)

(7)

(8)

3.3 DHMM的訓(xùn)練

定義一個后驗(yàn)概率變量γt(i),表示對于給定觀察序列O和參數(shù)集λ,當(dāng)?shù)趖時刻狀態(tài)為qi的概率,如式(9)所示。

(9)

(10)

定義一個變量ξt(i,j),表示對于觀察序列O和參數(shù)集λ,當(dāng)?shù)趖時刻的狀態(tài)為qi,并且當(dāng)t+1時刻的狀態(tài)為qj的概率,如式(11)所示。

(11)

(12)

(13)

(14)

(15)

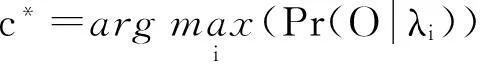

3.4 DHMM的識別

(16)

而對于等概率參考模型,式(16)等價于:

(17)

4實(shí)驗(yàn)

4.1 實(shí)驗(yàn)平臺

實(shí)驗(yàn)的硬件平臺由1臺CPU主頻為3.4 GHz、內(nèi)存為4 GB的個人計算機(jī)(PC),1臺Kinect傳感器構(gòu)成。軟件平臺由32位的Windows 7操作系統(tǒng)搭建。本文采用Matlab 2013a作為實(shí)驗(yàn)測試平臺。Matlab 2013a版本已經(jīng)完善了對Kinect SDK的支持,通過使用內(nèi)置Image Acquisition Toolbox工具箱,可以直接提取出RGB圖像、深度數(shù)據(jù)以及跟蹤骨架的關(guān)節(jié)點(diǎn)信息,簡化了數(shù)據(jù)采集的工作。

4.2 實(shí)驗(yàn)數(shù)據(jù)庫

圖6 DHMM的收斂曲線

為驗(yàn)證所提出方法的有效性,本文采用自建的行為數(shù)據(jù)庫來進(jìn)行測試,實(shí)驗(yàn)所采用的行為是參考公共的MSR Action3D數(shù)據(jù)庫[17]進(jìn)行建立的。其中,MSR Action3D數(shù)據(jù)庫包含20種行為。本文選取其中的5種行為作為實(shí)驗(yàn)的測試集,這5種行為分別為:“垂直擺臂”、“水平擺臂”、“畫圓圈”、“鼓掌”、“前踢”。其中,每個行為由兩個人各完成10次,以30幀每秒的速度對骨架關(guān)節(jié)點(diǎn)的坐標(biāo)進(jìn)行記錄,每個記錄的長度為100幀。

4.3 實(shí)驗(yàn)設(shè)置與結(jié)果

實(shí)驗(yàn)選取一個具有明顯運(yùn)動特征的骨架關(guān)節(jié)點(diǎn)作為觀測對象,設(shè)置DHMM的狀態(tài)數(shù)N為8,輸出的符號數(shù)M為12。隨機(jī)選取每個行為的10組數(shù)據(jù)用于模型的訓(xùn)練,如圖6所示。得到的5個行為所對應(yīng)的DHMM分別經(jīng)過接近50次循環(huán)后,收斂曲線在不同的對數(shù)似然比達(dá)到穩(wěn)定狀態(tài)。

識別階段選取另外10組數(shù)據(jù)用于測試,并進(jìn)行一次交叉驗(yàn)證,得出的識別結(jié)果如表1所示。使用本方法測試5種行為的平均正確識別率能達(dá)到94%。

表1 測試5種行為的識別結(jié)果(識別率) %

5結(jié)論

本文基于骨架關(guān)節(jié)點(diǎn)的人體行為識別方法簡化人體骨架模型的建模過程,利用骨架關(guān)節(jié)點(diǎn)的三維坐標(biāo)信息作為行為特征表示,并且通過隱馬爾可夫模型進(jìn)行識別,能取得較高的識別率。但由于本文所采用自建的數(shù)據(jù)集的大小有限,還不能充分證明算法的完備性。另外,如何優(yōu)化DHMM參數(shù)設(shè)置,如隱藏狀態(tài)數(shù)和輸出符號數(shù)也是需要繼續(xù)研究的內(nèi)容。由于本識別方法是基于Kinect的硬件環(huán)境和相應(yīng)的軟件開發(fā)環(huán)境所設(shè)計的,所以目前只能適用于PC系統(tǒng),應(yīng)用范圍還較為有限。不過相信隨著深度視頻傳感器的發(fā)展,本方法能得到進(jìn)一步的擴(kuò)展與應(yīng)用。

參考文獻(xiàn):

[1]黎洪松,李達(dá).人體運(yùn)動分析研究的若干新進(jìn)展[J].模式識別與人工智能,2009,22(1):70-78.

[2]萇道方,鐘悅.考慮行為和眼動跟蹤的用戶興趣模型[J].河南科技大學(xué)學(xué)報:自然科學(xué)版,2014,35(1):49-52.

[3]陳戰(zhàn)勝,王輝,賀萍,等.增強(qiáng)現(xiàn)實(shí)中跟蹤預(yù)測方法的研究[J].河南科技大學(xué)學(xué)報:自然科學(xué)版,2013,34(2):57-60.

[4]Johansson G.Visual Perception of Biological Motion and a Model for Its Analysis[J].Perception Psychophysics,1973,14(2):201-211.

[5]王亮,胡衛(wèi)明,譚鐵牛,等.基于步態(tài)的身份識別[J].計算機(jī)學(xué)報,2003,26(3):353-360.

[6]何衛(wèi)華,李平,文玉梅,等.復(fù)雜背景下基于圖像融合的運(yùn)動目標(biāo)輪廓提取算法[J].計算機(jī)應(yīng)用,2006,26(1):123-126.

[7]么鍵,劉冀偉,韓旭,等.基于光流的運(yùn)動人體提取[J].北京郵電大學(xué)學(xué)報,2006,29(z2):148-150,173.

[8]車武軍,楊勛年,汪國昭,等.動態(tài)骨架算法[J].軟件學(xué)報,2003,14(4):818-823.

[9]徐超,肖瀟,駱燕,等.基于距離變換的新型骨架提取方法[J].儀器儀表學(xué)報,2012,33(12):2851-2856.

[10]王會英,張有會,張靜,等.一種基于離散Voronoi圖的手寫體文字細(xì)化方法[J].計算機(jī)工程與應(yīng)用,2008,44(15):179-181,184.

[11]Shotton J,Fitzgibbon A,Cook M,et al.Real-time Human Pose Recognition in Parts from Single Depth Images[C]//Computer Vision and Pattern Recognition (CVPR),2011 IEEE Conference.2011:1297-1304.

[12]常軍林,吳笑偉,吳芬芬,等.基于特征和隱馬爾可夫模型的文本信息抽取[J].河南科技大學(xué)學(xué)報:自然科學(xué)版,2008,29(2):55-57,70.

[13]Yamato J,Jun O,Ishii K.Recognizing Human Action in Time-sequential Images Using Hidden Markov Model[C]//IEEE Computer Society Conference.1992:379-385.

[14]Weng E J,Fu L C.On-line Human Action Recognition by Combining Joint Tracking and Key Pose Recognition[C]//Intelligent Robots and Systems (IROS),2012 IEEE/RSJ International Conference.2012:4112-4117.

[15]黃靜,孔令富,李海濤,等.基于傅里葉-隱馬爾科夫模型的人體行為識別[J].計算機(jī)仿真,2011,28(7):245-248.

[16]趙瓊,葉豪盛,周學(xué)海,等.基于空間時序隱馬爾科夫模型的人體三維動作捕捉數(shù)據(jù)行為識別[C]//第八屆中國計算機(jī)圖形學(xué)大會論文集.2010:34-41.

[17]Li W Q,Zhang Z Y,Liu Z C.Action Recognition Based on a Bag of 3D Points[C]//Computer Vision and Pattern Recognition Workshops(CVPRW),2010 IEEE Computer Society Conference.2010:9-14.