基于多特征融合的變尺度目標跟蹤方法

李 凱, 劉 穎, 李 娜, 王瑋婧

(西安郵電大學 通信與信息工程學院, 陜西 西安 710121)

?

基于多特征融合的變尺度目標跟蹤方法

李 凱, 劉 穎, 李 娜, 王瑋婧

(西安郵電大學 通信與信息工程學院, 陜西 西安 710121)

給出一種基于多特征融合的核相關濾波器變尺度估計方法,以求解決視覺跟蹤目標尺度變化問題。先提取目標所在區域的方向梯度直方圖、顏色名和均勻局部二值模式,將此三種特征進行融合,構造訓練樣本,對目標外觀建模;再求解線性嶺回歸函數,獲得位置和尺度核相關濾波模板,對待檢測幀的候選區域進行相似性度量,確定跟蹤目標位置及尺度;實時更新位置模型和尺度模型的學習因子。實驗結果表明,所給方法在不同挑戰因素下,滿足精確跟蹤的要求,且在目標尺度變化、遮擋等復雜場景下,有較強魯棒性。

目標跟蹤;多特征融合;變尺度;遮擋

目標跟蹤是計算機視覺研究的熱點方向之一,在視頻安防監控、智能人機交互、運動分析等領域都具有非常廣泛的應用[1]。雖然,近年來有許多跟蹤算法[2-4]被提出,但為處理目標尺度變化問題,仍有必要設計一個魯棒精確的目標跟蹤方法。

將核相關濾波器運用到目標跟蹤框架中,可取得較好的跟蹤效果[5]。核相關濾波器跟蹤算法(Kernelized Correlation Filters, KCF)[6]將文[7]跟蹤算法的灰度特征改進為多通道方向梯度直方圖(Histogram of Oriented Gradient,HOG)[8]特征,使得訓練所得的分類器對待檢測目標的判別能力更強,但KCF跟蹤算法采取固定大小的訓練樣本來訓練分類器模型,難以對目標運動過程中出現的尺度變化進行相應的處理,最終導致分類器模型誤差累積,跟蹤目標漂移,且KCF無法對目標遮擋進行有效處理。針對KCF跟蹤算法的改進算法中[9-10],基于尺度自適應多特征融合(Scale Adaptive with Multiple Features, SAMF)的KCF跟蹤算法[10],采用尺度空間變化的7個訓練樣本來訓練分類器模型,解決了KCF跟蹤算法模板固定的問題,但對于目標發生較大尺度變化時,跟蹤效果明顯變差。

針對KCF算法跟蹤過程中出現的目標尺度變化問題,本文結合高斯核相關濾波器和尺度金字塔理論,構建尺度核相關濾波器,對KCF跟蹤算法進行改進,即將HOG特征、顏色名(Color Name, CN)特征和均勻局部二值模式(Uniform Local Binary Pattern, ULBP)紋理特征這三種特征相融合,以構造訓練樣本對目標外觀建模。并且,結合核相關濾波器設計目標多尺度估計方法,以實現目標尺度自適應的跟蹤。然后,實時更新位置學習因子和尺度學習因子,提高跟蹤算法的準確度和穩定性。

1 KCF跟蹤算法

KCF跟蹤算法將跟蹤目標區域特征樣本進行循環移位,從而構建核相關位置濾波模板,利用核函數計算候選區域與跟蹤目標的響應值大小,確定新的跟蹤目標,并在頻域內進行濾波模板的構建和目標檢測過程。

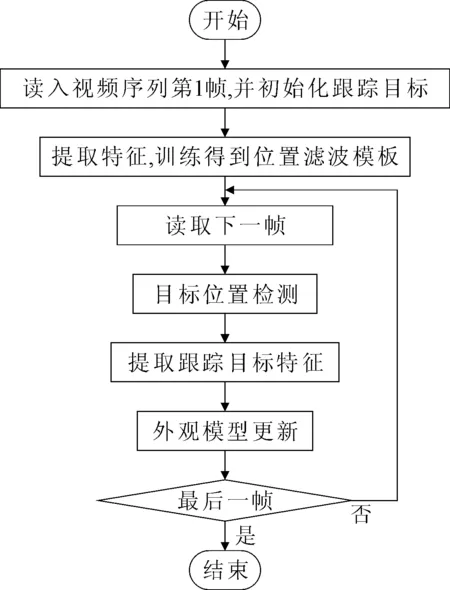

KCF跟蹤算法的流程如圖1所示。

圖1 KCF跟蹤算法流程

1.1 分類器訓練

KCF跟蹤算法在進行分類器訓練時,須通過樣本xi找到函數

f(x)=wTx,

使正則化風險泛函最小,即求解線性嶺回歸函數,用數學公式描述為[6]

其中yi為樣本xi的期望輸出,假設yi服從高斯分布,λ為正則化參數,‖·‖為范數運算。KCF算法用多通道HOG特征構成訓練樣本,即找到最優的w,使得目標函數取值最小。上式的解可表示為輸入的線性組合[7]

(1)

其中,bi為對應樣本xi的系數,φ(xi)是將樣本xi映射到高維度特征空間的映射函數。

假設有兩個都具有C個通道的特征向量

則其在高維度特征空間的相關性或相似度為

φT(x)φ(x′)=κ(x,x′)。

其中κ為高斯核函數,表示為[8]

(2)

由文[7]可得式(1)的解為

b=(k+λI)-1y。

其中,I為單位矩陣,y為分類器的期望輸出,服從高斯分布,其元素為yi,向量

b=(b1,b2,…,bi),

k為核矩陣,其元素

由此可得位置濾波模板[6]

B=F(b)=[F(k)+λI]-1F(y)。

其中,F(b)為系數b的傅里葉變換,F(y)是標簽的傅里葉變換。由此,尋找最優w可轉化為尋找b來進行分類器的訓練。

1.2 目標位置檢測

訓練位置核相關濾波器,進行目標位置檢測,具體過程可描述如下。

步驟1 初始化第一幀(t=1),確定目標搜索區域和目標的中心位置。提取搜索區域的特征x,以式(2)計算

kp=κ(x,xi),

其中

xi=Pix(i=0,1,…,n-1)

為循環移位樣本[6],P是置換矩陣[7]。轉換到頻域,即F(kp),在搜索區域內計算樣本標簽

其中,pi為搜索區域內目標位置,p*為目標的中心位置,σp為標準差。轉化到頻域,即F(yp),計算位置濾波模板

Bp=[F(kp)+λI]-1F(y)。

其中F(kp)表示融合特征的高斯核函數矩陣kp的傅里葉變換。

步驟2 在步驟1確定t-1幀的目標搜索圖像特征x,第t(t≥2)幀時,獲取候選圖像特征zp,以式(2)計算κ(x,zp),并變換到頻域,即Hp。

步驟3 在第t幀中找到使得

(3)

1.3 外觀模型更新

在位置檢測后,更新位置濾波模板和目標特征

2 改進算法

針對KCF算法無法處理目標尺度變化和目標被遮擋后會導致跟蹤失敗的問題,進行兩點改進:

(1) 提取區域的HOG特征、CN特征和ULBP紋理特征,融合這3種特征,增強描述目標外觀的能力;

(2) 結合高斯核相關濾波器和尺度金字塔理論,構建尺度核相關濾波器,以自適應目標尺度變化。

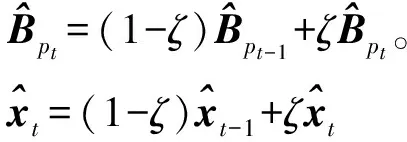

由此得出一種基于多特征融合的變尺度目標跟蹤方法,其流程圖如圖2所示。

圖2 改進算法流程

2.1 特征提取與融合

在目標跟蹤中利用單一特征信息,會因外界干擾造成跟蹤失敗,故考慮提取區域的HOG特征、CN特征和ULBP紋理特征,將其融合,以增強描述目標外觀的能力。

2.1.1 HOG特征

HOG特征對圖像的幾何和光學形變都具有不變性。按照改進的PCA-HOG特征的提取方法,先將目標區域分成若干個4×4的細胞單元(cell),采用9個bin的直方圖來統計這4×4個像素的梯度信息,即將cell的梯度方向分成9個方向塊;然后,采集細胞單元中各像素點的梯度,或邊緣的方向直方圖,并利用PCA方法,對提取出的HOG特征進行降維;最后,把這些直方圖組合,構成31維特征向量特征描述器。

2.1.2 CN特征

CN特征在目標跟蹤[5]、檢測[11]與識別[12]和行為識別[13]中有較好應用,其優點在于計算簡單,且對圖像本身的尺寸、方向和視角的依賴性較小。CN特征包含黑、藍、棕、灰、綠、橙、粉紅、紫、紅、白和黃11個基本顏色詞,11維CN特征可表示為概率值為1的RGB值映射,但11維顏色特征計算量大,故利用PCA降維方法將其降至2維。2維CN特征包含著目標重要的顏色信息。

2.1.3 ULBP紋理特征

LBP紋理特征表示圖像灰度等級變化,并與空間統計有關,具有計算簡單和對全局變化不敏感的優點,且對噪聲有較強抵抗能力。

以鄰域中心像素點灰度值為閾值,將相鄰像素點與之比較,可用所得二進制編碼表示局部紋理特征。LBP均勻模式(ULBP),即在圓形的二值編碼中,最多有兩次0到1或者1到0的變化,不僅可以描述絕大部分紋理信息,而且能夠明顯減少特征數量,同時保持較強的分類能力。提取跟蹤目標的LBP均勻模式,可使紋理特征模式從原來的256種降為59種,提高處理速度。

2.1.4 多特征融合

將3種特征級聯,組成圖像塊的特征集。多通道高斯核函數具有循環移位結構[7],故以式(2)進行多特征融合,并用于訓練分類器。

2.2 目標尺度檢測

使用訓練尺度核相關濾波器進行目標尺度檢測。假設在位置檢測后,獲取的目標區域大小為M×N,訓練尺度濾波器大小為S×1,則在目標周圍提取不同大小m×n的圖像塊xSi,m和n滿足

其中r為尺度因子,a是選擇的尺度取值范圍。

尺度檢測過程可描述如下。

步驟1 初始化第一幀(t=1),提取目標區域圖像特征xs,用式(2)計算κ(xs,xsi),轉換到頻域F(ks),在搜索區域內計算尺度樣本標簽

其中si為目標可取的所有可能尺度,1≤si≤S,S為尺度濾波器的維度,s*取[S/2],σs為標準差,轉化到頻域F(ys)。尺度濾波模板

Bs=[F(ks)+λI]-1F(ys)。

其中F(ks)表示融合特征的高斯核函數矩陣ks的傅里葉變換。

步驟2 在步驟1確定t-1幀的目標特征xs,第t(t≥2)幀時,在檢測到目標位置處獲取候選圖像特征zsi,通過線性插值變化到第一幀目標塊相同大小,以式(2)計算目標區域與候選區域κ(xs,zsi)的核互相關,并變換到頻域,即Hs。

步驟3 在第t幀中檢測尺度響應

(4)

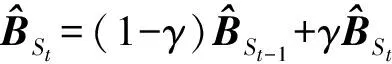

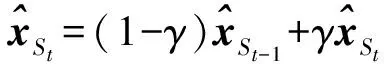

2.3 模型更新

在目標位置檢測和尺度檢測后,更新相應參數

(5)

(6)

(7)

(8)

2.4 算法框架

(1) 初始化: 選擇第一幀視頻的跟蹤目標,確定目標參數[x,y,w,h],其中(x,y)為目標左上角坐標,w為目標的寬度,h為目標的高度。

(6) 輸出: 檢測出當前幀目標的位置pt以及尺度st。

3 實驗及結果分析

在benchmark-2013視頻數據集[14]中選取不同復雜情況下的12個視頻集,測試所給改進算法,并與CSK算法[7]、KCF算法[6]、CN算法[9]和SAMF算法[10]進行對比,就實驗結果作出定量和定性分析。

3.1 實驗參數及評價標準

為了定量評估分析跟蹤方法的性能,實驗選用中心位置誤差(Center Location Error, CLE)、視覺對象類率(Pascal Visual Object Classes Rate, VOR)和每秒運行幀數(Frames Per Second,FPS)3個指標[15]作為評價標準。CLE是指跟蹤目標結果的中心坐標與真實目標中心的歐氏距離。視覺對象類率則可定義為[15]

式中RVOR表示跟蹤目標與真實目標區域重合率,BT是跟蹤目標結果的區域,BG是真實人工標注的目標區域,一般選擇重合率閾值大于50%的VOR值來計算跟蹤成功率。

3.2 定量分析

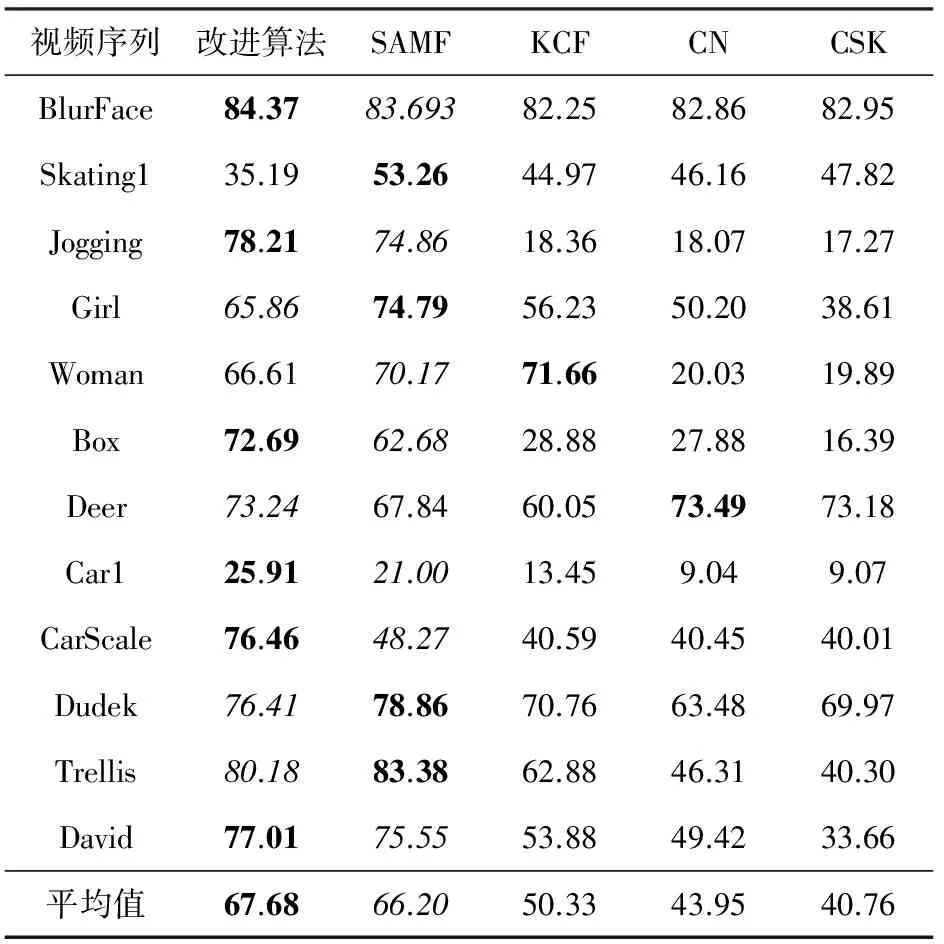

各跟蹤方法對12組視頻序列進行測試,獲得的平均中心位置誤差(Median Center Location Error, MCLE)、平均重疊率(Median Visual Classes Rate,MRVOR)及平均每秒運行幀數(Average Frames Per Second,AFPS)分別如表1、表2和表3所示。其中,加粗字體表示最優結果,斜體字體表示次優結果。

表1 各算法平均中心位置誤差對比/Pixel

由表1可見,改進算法在12個測試視頻集跟蹤的MCLE值為9.54 pixel,相比其他4種算法的MCLE值取得最小,較SAMF算法的MCLE值提高1.37 pixel。在視頻集BlurFace,Jogging,Box,Car1,CarScale和Dudek上都存在目標尺度變化、全部遮擋或部分遮擋等復雜情況,改進算法較其他4種算法的CLE值明顯較小。

表2 各算法重疊率對比/%

由表2可見,改進算法在12個測試視頻集跟蹤的平均重疊率為67.68%,較SAMF算法平均重疊率提高1.48%,在一半以上的測試視頻集中,改進算法的RVOR值都達到最大,在視頻集BlurFace,Jogging,Box,Car1和CarScale中重疊率與其他4種算法相比較有明顯提高。

表3 各算法平均每秒運行幀數對比/ 幀·s-1

由表3可見,KCF算法和CN算法采用單一的特征來描述目標外觀,處理速度分別為62.94 幀/s和46.27 幀/s,CSK跟蹤算法采用原始像素并進行稠密采樣,故處理速度最快,達到102.02 幀/s。改進算法采用HOG特征、CN特征和ULBP紋理特征增強目標外觀描述,利用高斯核函數進行多通道特征融合,并進行尺度檢測,處理速度最慢,為5.75 幀/s。所以,改進算法取得較好的跟蹤效果,是以犧牲時間為代價的。

3.3 定性分析

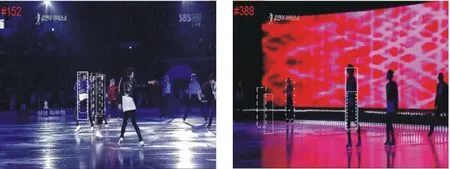

選取包含光照變化、尺度變化、遮擋、形變和運動模糊等復雜情形的視頻序列,進行定性評估,各算法的跟蹤結果如圖3所示。

(a) Jogging

(b) Woman

(c) Box

(d) CarScale

(e) David

(f) Skating1

由圖3可見,各算法在測試視頻Jogging、Woman、Box、CarScale、David和Skating1上的運行效果有所不同,而改進算法在不同的復雜情況下都能取得較好的跟蹤結果。

通過定量分析和定性分析可知,相對于其他4種算法,改進算法在跟蹤性能上有很大提高。改進算法在大部分視頻集上MCLE值取得最小,跟蹤目標的RVOR值達到最高,跟蹤效果達到最佳,雖然以犧牲時間來獲取較高的魯棒性和準確度,但在尺度變化和遮擋等復雜情況的場景中,跟蹤效果優于其他算法。

4 結語

結合高斯核相關濾波器和尺度金字塔理論,構建尺度核相關濾波器,給出一種基于HOG、CN和LBP紋理特征融合的多尺度估計方法,實現目標多尺度自適應地目標跟蹤,實時更新位置模型和尺度模型的學習因子,可提高對目標位置估計和尺度估計的穩定性。

實驗結果表明,提取的HOG、CN和ULBP紋理特征能增強目標外觀的描述能力;融合三種特征,構建位置和尺度高斯核相關濾波器,具有較好效果,能緩解目標尺度變化問題;多特征描述也能增強目標的抗遮擋能力。改進算法在復雜場景下具有較高的魯棒性和跟蹤精度,適用于在跟蹤要求精度高,對實時性要求不高的復雜場景下。

[1] 高文,朱明,賀柏根,等.目標跟蹤技術綜述[J/OL].中國光學,2014,7(3):365-373[2016-05-20]. http://dx.chinadoi.cn/10.3788%2fCO.20140703.0365.

[2] 李娜,李大湘,劉穎.基于多示例學習的目標跟蹤算法[J/OL].西安郵電大學學報,2014,19(2):43-48[2016-05-20]. http://dx.chinadoi.cn/10.13682%2fj.issn.2095-6533.2014.02.007.

[3] GALOOGAHI H K, SIM T, LUCEY S. Multi-channel correlation filters[C/OL]//Proceedings of the 2013 IEEE International Conference on Computer Vision. Piscataway:IEEE,2013:3072-3079[2016-05-20].http://dx.doi.org/10.1109/ICCV.2013.381.

[4] HARE S, SAFFARI A, TORR P H S. Struck: Structured output tracking with kernels[C/OL]//Proceedings of the 2011 IEEE International Conference on Computer Vision. Piscataway:IEEE,2011:263-270[2016-05-20].http://dx.doi.org/10.1109/ICCV.2011.6126251.

[5] BOLME D S, BEVERIDGE J R, DPAPERB A, et al. Visual object tracking using adaptive correlation filters[C/OL]//Proceedings of the 2010 IEEE Conference on Computer Vision and Pattern Recognition. Washington,DC:IEEE Computer Society,2010:2544-2550[2016-05-20].http://dx.doi.org/10.1109/CVPR.2010.5539960.

[6] HENRIQUES J, CASEIRO R, MARTINS P, et al. High-speed tracking with kernelized correlation filters[J/OL].IEEE Transactions on Pattern Analysis and Machine Intelligence,2015,37(3):583-596[2016-05-20]. http://dx.doi.org/10.1109/TPAMI.2014.2345390.

[7] HENRIQUES J, CASEIRO R, MARTINS P, et al. Exploiting the circulant structure of tracking-by-detection with kernels[C/OL]//Proceedings of the 12th European Conference on Computer Vision, LNCS 7575. Berlin: Springer,2012,702-715[2016-05-20].http://dx.doi.org/10.1007/978-3-642-33765-9_50.

[8] FELZENSZWALB P F, GIRSHICK R B, MCALLESTER D, et al. Object detection with discriminatively trained part-based models[J/OL].IEEE Transactions on Pattern Analysis and Machine Intelligence,2010,32(9):1627-1645[2016-05-20].http://dx.doi.org/10.1109/TPAMI.2009.167.

[9] DANELLJAN M, KHAN F S, FELSBERG M, et al. Adaptive color attributes for real-time visual tracking[C/OL]//Proceedings of the 2014 IEEE Conference on Computer Vision and Pattern Recognition. Washington, DC: IEEE Computer Society,2014:1090-1097[2016-05-20].http://dx.doi.org/10.1109/CVPR.2014.143.

[10] LI Y, ZHU J K. A scale adaptive kernel correlation filters tracker with feature integration[C/OL]//Proceedings of the 2014 European Conference on Computer Vision-ECCV 2014 Workshops, LNCS 8926.Berlin: Springer,2014:254-265[2016-05-20].http://dx.doi.org/10.1007/978-3-319-16181-5_18.

[11] KHAN F S, ANWER R M, WEIJER J, et al. Color attributes for object detection[C/OL]//Proceedings of the 2012 IEEE Conference on Computer Vision and Pattern Recognition.Washington,DC:IEEE Computer Society,2012:3306-3313[2016-05-20].http://dx.doi.org/10.1109/CVPR.2012.6248068.

[12] KHAN F S, WEIJER J, VANRELL M, et al. Modulating shape features by color atention for object recognition[J/OL].International Journal of Computer vision,2012,98(1):49-64[2016-05-20].http://dx.doi.org/10.1007/s11263-011-0495-2.

[13] KHAN F S, ANWER R M, WEIJER J, et al. Coloring action recognition in still images[J/OL]. International Journal of Computer Vision,2013,105(3):205-221[2016-05-20].http://dx.doi.org/10.1007/s11263-013-0633-0.

[14] WU Y, LIM J, YANG M H. Online object tracking: a benchmark[C/OL]//Proceedings of the 2013 IEEE Conference on Computer Vision and Pattern Recognition. Washington,DC:IEEE Computer Society,2013:2411-2418[2016-05-20].http://dx.doi.org/10.1109/CVPR.2013.312.

[15] EVERINGHAM M, VAN G L, CHRISTOPHER K, et al. The pascal visual object classes (VOC) challenge[J/OL].International Journal of Computer Vision,2010,88(2):303-338[2016-05-20].http://dx.doi.org/10.1007/s11263-009-0275-4.

[責任編輯:陳文學]

Scale adaptive object tracking based on multiple features integration

LI Kai, LIU Ying, LI Na, WANG Weijing

(School of Communication and Information Engineering, Xi’an University of Posts and Telecommunications, Xi’an 710121, China)

A multi-scale estimation method based on kernelized correlation filter with multi-features integration is proposed to solve the scale change problem of object tracking. Firstly, histogram of oriented gradient, color name and uniform local binary pattern features of object area are extracted to construct training samples. Then, by solving the linear ridge regression function, the position and scale kernelized correlation filter models are obtained to measure similarity of detection frames candidate area which decides tracking area. Finally, the learning factor of the position and scale model are updated in real-time. Experimental results show that, the proposed method can accurately track the object in complex scenes under different challenge factors, and it is of high robust at complex scenes such as the object scale changes and occlusion.

object tracking, multiple features integration, scale adaptive, occlusion

10.13682/j.issn.2095-6533.2016.06.009

2016-08-10

公安部科技強警基礎專項資助項目(2015GABJC51);陜西省國際科技合作計劃資助項目(2015KW-014);陜西省教育廳專項科研計劃資助項目(15JK1661);西安市碑林區應用技術研發項目(GX1502);西安郵電大學研究生創新基金資助項目(CXL2015-22)

李凱(1992-),男,碩士研究生,研究方向為通信與信息系統。E-mail: likai_0325@163.com 劉穎(1972-),女,博士,高級工程師,從事圖像和視頻處理研究。E-mail: ly_yolanda@sina.com

TP391.41

A

2095-6533(2016)06-0044-07