基于UR-LDA的微博主題挖掘

陳 陽(yáng),邵 曦,趙海博

(1.南京郵電大學(xué) 通信與信息工程學(xué)院,江蘇 南京 210003; 2.軟通動(dòng)力信息技術(shù)有限公司,浙江 杭州 310000)

基于UR-LDA的微博主題挖掘

陳 陽(yáng)1,邵 曦1,趙海博2

(1.南京郵電大學(xué) 通信與信息工程學(xué)院,江蘇 南京 210003; 2.軟通動(dòng)力信息技術(shù)有限公司,浙江 杭州 310000)

以微博為代表的社交網(wǎng)絡(luò)已經(jīng)成為用戶(hù)發(fā)布和獲取實(shí)時(shí)信息的重要手段,然而這些實(shí)時(shí)信息中很大一部分都是垃圾或者是冗余的信息。通過(guò)有效的手段,精準(zhǔn)地發(fā)現(xiàn)、組織和利用社交網(wǎng)絡(luò)海量短文本背后隱藏的有價(jià)值的信息,對(duì)微博中隱含主題的挖掘,具有較高的輿情監(jiān)控和商業(yè)推廣價(jià)值。盡管概率生成主題模型LDA(Latent Dirichlet Allocation)在主題挖掘方面已經(jīng)得到了廣泛的應(yīng)用,但由于微博短文本消息語(yǔ)義稀疏以及文本之間相互關(guān)聯(lián)等特點(diǎn),傳統(tǒng)的LDA模型并不能很好地對(duì)它進(jìn)行建模。為此,基于LDA模型,綜合考慮微博的文本關(guān)聯(lián)關(guān)系和聯(lián)系人關(guān)聯(lián)關(guān)系,提出了適用于處理微博用戶(hù)關(guān)系數(shù)據(jù)的UR-LDA模型,并采用吉布斯抽樣對(duì)模型進(jìn)行推導(dǎo)。真實(shí)數(shù)據(jù)集上的實(shí)驗(yàn)結(jié)果表明,UR-LDA模型能有效地對(duì)微博進(jìn)行主題挖掘。

微博;主題挖掘;UR-LDA;吉布斯抽樣

1 概 述

微博,微型博客(Micro Blog)的簡(jiǎn)稱(chēng),是Web2.0時(shí)代興起的一種新型社交網(wǎng)絡(luò)形式,以其開(kāi)放性、交互性、自由性和及時(shí)性而風(fēng)靡全球。微博基于用戶(hù)之間的關(guān)聯(lián)關(guān)系,構(gòu)建了一個(gè)海量信息分享、傳播和獲取的平臺(tái)。用戶(hù)可以通過(guò)網(wǎng)絡(luò),移動(dòng)設(shè)備和其他客戶(hù)端軟件登錄微博,進(jìn)行短文本信息的實(shí)時(shí)獲取或更新。據(jù)新浪微博財(cái)報(bào)顯示,新浪微博日活躍用戶(hù)數(shù)(DAU)達(dá)到1.06億,在2016年第一分鐘發(fā)出去的微博信息高達(dá)883 536條。

用戶(hù)通過(guò)微博網(wǎng)站構(gòu)建的平臺(tái)可以發(fā)布海量信息。但微博用戶(hù)人群構(gòu)成多樣,文本內(nèi)容口語(yǔ)化,主題隨意性強(qiáng),語(yǔ)法缺少規(guī)范。據(jù)統(tǒng)計(jì)發(fā)現(xiàn),超過(guò)50%的微博內(nèi)容為情感語(yǔ)錄、個(gè)人心情等,因此,微博文本噪聲占比高。在信息爆炸的時(shí)代,通過(guò)有效的手段從海量的短文本中挖掘出有效的主題信息就顯得尤為重要。優(yōu)質(zhì)的主題挖掘?qū)η楦蟹治鱿到y(tǒng)、輿情監(jiān)控系統(tǒng)以及大數(shù)據(jù)預(yù)警系統(tǒng)的發(fā)展具有極大的推動(dòng)作用。

傳統(tǒng)的微博主題挖掘算法按照其輸入數(shù)據(jù)的種類(lèi),主要分為以下三類(lèi):基于網(wǎng)絡(luò)關(guān)系的微博主題挖掘、基于用戶(hù)標(biāo)簽或文本內(nèi)容的微博主題挖掘、結(jié)合用戶(hù)文本內(nèi)容、網(wǎng)絡(luò)關(guān)系的微博主題挖掘。

M.E.J.Newman等[1]提出的算法是基于網(wǎng)絡(luò)關(guān)系的社交網(wǎng)絡(luò)主題挖掘方法的典型代表。該算法認(rèn)為移除不同主題之間的連接邊就能較好地將社交網(wǎng)絡(luò)分割成不同的主題[1]。

文獻(xiàn)[2]提取用戶(hù)標(biāo)簽,將各個(gè)用戶(hù)興趣特征向量化,最后對(duì)用戶(hù)興趣特征向量聚類(lèi)進(jìn)行主題挖掘。在該算法中,用戶(hù)標(biāo)簽不完整及口語(yǔ)化會(huì)嚴(yán)重影響最終的聚類(lèi)效果。

文獻(xiàn)[3]利用一種正規(guī)化框架,結(jié)合用戶(hù)關(guān)系和用戶(hù)文本內(nèi)容進(jìn)行社交網(wǎng)絡(luò)主題挖掘。

Blei等[4]提出了概率主題模型LDA,即“文檔—主題—詞”三層貝葉斯模型,為社交網(wǎng)絡(luò)主題挖掘提供了新的思路。

汪進(jìn)祥[5]利用LDA主題模型與中文標(biāo)注相結(jié)合進(jìn)行微博話題挖掘。

但是未經(jīng)修改,LDA主題模型一般適用于新聞等經(jīng)過(guò)初次加工的語(yǔ)料,而微博是短文本(字?jǐn)?shù)通常小于140),語(yǔ)義信息稀疏,噪聲大,文本語(yǔ)言口語(yǔ)化,極大地增加了對(duì)其主題挖掘的難度[6];另一方面,轉(zhuǎn)發(fā)型微博文本和對(duì)話型微博文本從形式上說(shuō)明微博文本之間是相互關(guān)聯(lián)的,與傳統(tǒng)LDA模型假設(shè)文本之間相互獨(dú)立是矛盾的。以上特性說(shuō)明微博主題挖掘不能簡(jiǎn)單套用傳統(tǒng)的LDA模型。基于LDA,結(jié)合微博文本的特性,提出了一種適合中文微博主題挖掘模型UR-LDA。

2 文本生成模型LDA

2.1 LDA模型

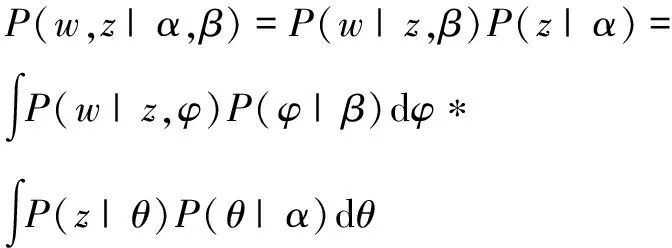

LDA主題模型繼承自LSA[7]和PLSA[8]方法,在文檔—單詞引入“主題”的概念,形成了“文檔—主題—詞”的三層貝葉斯模型[9]。在LDA模型中,文本m可以表示成多個(gè)主題的聯(lián)合分布,記為P(z),每個(gè)主題又是詞匯表中所有單詞上的概率分布,記為P(w|z)。因此,文本中每個(gè)單詞的概率分布為:

(1)

其中,K為主題個(gè)數(shù);i∈[1,Nm],Nm為數(shù)據(jù)集中所有單詞的個(gè)數(shù)。

同時(shí),LDA模型是一個(gè)完備的主題模型,詞語(yǔ)符合“詞袋模式”,即在文檔的生成過(guò)程中,不同詞語(yǔ)之間相互獨(dú)立,順序無(wú)關(guān),模型引入Dirichlet分布,只需要分別設(shè)置超參數(shù)α和β就可以表示文檔m與主題的關(guān)系θm以及主題k與詞語(yǔ)的關(guān)系φk,實(shí)現(xiàn)文檔—主題和主題—詞語(yǔ)之間參數(shù)的精簡(jiǎn)。LDA模型的文本生成模型如圖1所示。

(1)根據(jù)先驗(yàn)參數(shù)為α的Dirichlet分布,隨機(jī)抽取每篇文檔的混合主題概率θm。

(2)根據(jù)先驗(yàn)參數(shù)為β的Dirichlet分布,隨機(jī)抽取各個(gè)詞語(yǔ)在主題k下出現(xiàn)的概率φk。

(3)針對(duì)每篇文檔m中的每一個(gè)待生成的詞wm,n:

①根據(jù)θm抽取當(dāng)前單詞所代表的主題zm,n。

②根據(jù)p(wm,n|φk,zm,n)抽取具體的單詞wm,n。

一個(gè)文本中所有單詞與其所屬主題的聯(lián)合概率分布,如式(2)所示:

(2)

2.2 吉布斯抽樣法

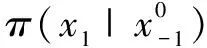

吉布斯抽樣法是一種簡(jiǎn)單的蒙特卡洛算法實(shí)現(xiàn),經(jīng)常用來(lái)進(jìn)行LDA模型概率推導(dǎo)。該方法的思想是[10]:對(duì)于已知概率分布π(x),x=(x1,x2,…,xn)(通常稱(chēng)為目標(biāo)分布),如果π太過(guò)復(fù)雜以致不能直接從它抽樣,可以通過(guò)構(gòu)造一個(gè)非周期且不可約的馬爾可夫鏈來(lái)間接獲取樣本。由于模擬的數(shù)值可以被視作是來(lái)自目標(biāo)分布的獨(dú)立樣本,當(dāng)馬爾可夫鏈足夠長(zhǎng)時(shí),就可以用其穩(wěn)態(tài)分布來(lái)推斷π的重要特征。具體過(guò)程如下:

3 微博主題挖掘

3.1 微博生成模型UR-LDA

從微博消息的發(fā)布形式可以看出,微博不同于一般文本,本身帶有表征文本之間關(guān)聯(lián)關(guān)系的信息,如:轉(zhuǎn)發(fā)型微博中含有“//@”,對(duì)話型微博含有“@”。其中,轉(zhuǎn)發(fā)型微博的文本內(nèi)容由當(dāng)前用戶(hù)和其他用戶(hù)發(fā)布原創(chuàng)微博共同組成,往往用于當(dāng)前用戶(hù)對(duì)轉(zhuǎn)發(fā)部分的評(píng)論,可以通過(guò)“//@”把原創(chuàng)部分和轉(zhuǎn)發(fā)部分隔離開(kāi)來(lái)。例如,“好樣的!//@陳陽(yáng):林說(shuō)會(huì)以馬努為榜樣,說(shuō)會(huì)無(wú)視交易流言,已經(jīng)習(xí)慣了”。其中“//@”之前的是原創(chuàng)內(nèi)容,“//@”之后的轉(zhuǎn)發(fā)內(nèi)容,“@陳陽(yáng)”表示轉(zhuǎn)發(fā)部分的作者是陳陽(yáng)。轉(zhuǎn)發(fā)型微博的主題主要取決轉(zhuǎn)發(fā)部分而不取決于微博發(fā)布者,而且當(dāng)微博發(fā)布者原創(chuàng)部分的內(nèi)容不包含能夠表征任何有意義主題的詞時(shí),可以將其忽略。對(duì)話型微博含有特定的提醒或者發(fā)送對(duì)象,如“@JeremyLin林書(shū)豪一直被你的精神鼓舞著,前進(jìn)著!”,“@JeremyLin林書(shū)豪”表示該條微博所要發(fā)送的對(duì)象是JeremyLin林書(shū)豪。這種類(lèi)型的微博體現(xiàn)了微博文本聯(lián)系人之間的關(guān)聯(lián)關(guān)系。

UR-LDA是在研究LDA的基礎(chǔ)上,綜合考慮微博文本關(guān)聯(lián)關(guān)系和聯(lián)系人關(guān)聯(lián)關(guān)系以及微博短文本特性,形成適合中文微博主題挖掘的模型。在UR-LDA模型中,一條微博如果是轉(zhuǎn)發(fā)微博,其主題由當(dāng)前用戶(hù)原創(chuàng)部分和轉(zhuǎn)發(fā)部分共同確定;如果是對(duì)話型微博,其主題由該條微博發(fā)送對(duì)象中所有與當(dāng)前微博相關(guān)的微博共同確定。其中發(fā)送對(duì)象中的相關(guān)微博是指,發(fā)送對(duì)象發(fā)布的,含有當(dāng)前微博關(guān)鍵字的微博。

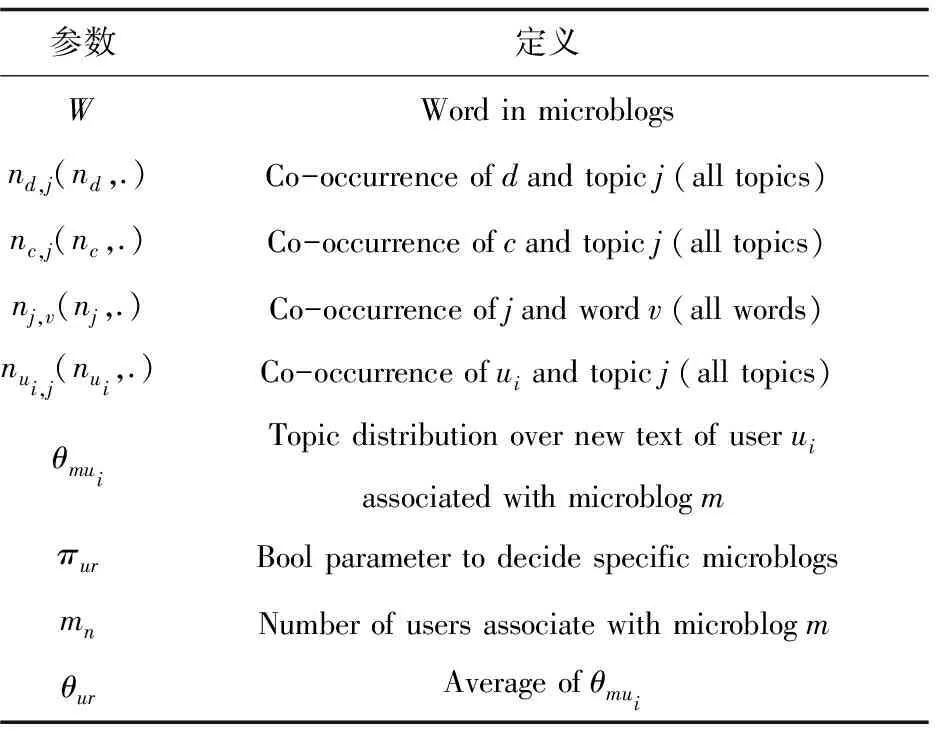

UR-LDA模型的參數(shù)介紹見(jiàn)表1。

表1 模型符號(hào)定義說(shuō)明

續(xù)表1

UR-LDA模型的貝葉斯網(wǎng)絡(luò)圖如圖2所示。

圖2 UR-LDA模型

(1)UR-LDA從參數(shù)為β的Dirichlet分布中抽取主題k與單詞的關(guān)系φk。

(2)通過(guò)正則表達(dá)式[//\s*?@.*?:]過(guò)濾掉微博文本中與轉(zhuǎn)發(fā)相關(guān)的特殊字符,僅保留用戶(hù)原創(chuàng)部分和轉(zhuǎn)發(fā)部分。

(3)針對(duì)包含“@”文本:

①通過(guò)正則表達(dá)式[@(.+?)\s+]找出該文本所有與“@對(duì)話對(duì)象名”相匹配的字符串,提取相應(yīng)的對(duì)話對(duì)象名并利用中科院的ICTCLAS提取當(dāng)前文本的關(guān)鍵字。

②遍歷①中所有的對(duì)話對(duì)象,找出每個(gè)對(duì)象發(fā)布的含有①中提取的關(guān)鍵字的微博。為降低微博短文本語(yǔ)義稀疏對(duì)主題挖掘效果的影響,將同一會(huì)話對(duì)象中找到的相關(guān)微博存入到一個(gè)文件中,作為一個(gè)新的文本。

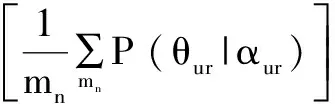

③利用傳統(tǒng)的LDA模型,根據(jù)先驗(yàn)參數(shù)為αur的Dirichlet分布,隨機(jī)抽取②中各個(gè)會(huì)話對(duì)象的新文本的混合主題概率θmui,并對(duì)其求均值,記為θur,置πur為1(πur初始值為0)。θur的計(jì)算公式為:

(3)

其中,N為①中得到對(duì)話對(duì)象的總數(shù);θur為每個(gè)會(huì)話對(duì)象生成的新文本在各個(gè)主題上的概率分布。

(4)判斷πur的取值,若πur=1,則將求得的θur賦給微博m與各個(gè)主題之間的關(guān)系θm;否則直接從參數(shù)為α的Dirichlet分布中抽取該微博m與各個(gè)主題之間的關(guān)系θm。整個(gè)微博集中,θm的概率分布為:

(4)

一條微博中,所有單詞與其所屬主題的聯(lián)合概率分布為:

P(w,z|θm,β)=P(z|θm)P(w|z,β)

(5)

3.2 模型推導(dǎo)

用Gibbs Sampling對(duì)UR-LDA模型進(jìn)行推導(dǎo),其過(guò)程如下:

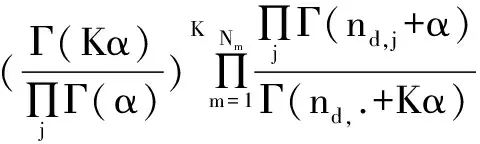

(1)利用歐拉公式對(duì)式(2)進(jìn)行展開(kāi):

(6)

(7)

(2)對(duì)式(7)反復(fù)迭代,并對(duì)所有主題進(jìn)行抽樣,最終達(dá)到抽樣結(jié)果穩(wěn)定。由于抽取單詞和抽取主題都滿足多項(xiàng)式分布,θm和φk的結(jié)果分別如下:

(8)

(9)

類(lèi)似的,可以得到θmui:

(10)

對(duì)θmui求均值,得到θur:

(11)

至此,UR-LDA模型通過(guò)吉布斯抽樣求解出微博文本在各個(gè)主題上的概率分布θm以及每個(gè)主題在單詞上的概率分布φk。對(duì)整個(gè)微博集進(jìn)行分析,通過(guò)概率計(jì)算,就可以挖掘出單個(gè)微博文本最有可能屬于哪個(gè)主題,每個(gè)主題最具代表性的單詞。

4 主題挖掘?qū)嶒?yàn)

4.1 數(shù)據(jù)準(zhǔn)備

4.1.1 新浪微博數(shù)據(jù)采集

微博數(shù)據(jù)采集是微博主題挖掘的基礎(chǔ)。目前微博數(shù)據(jù)的獲取主要有兩種方式,即網(wǎng)絡(luò)爬蟲(chóng)技術(shù)和新浪微博提供API接口獲取數(shù)據(jù),但這兩種方式都存在一定的問(wèn)題。

目前許多網(wǎng)頁(yè)都采用了Ajax[11]技術(shù),利用JavaScript動(dòng)態(tài)生成網(wǎng)頁(yè),爬蟲(chóng)技術(shù)很難爬取到完整的網(wǎng)頁(yè)數(shù)據(jù)。由于微博平臺(tái)的不開(kāi)放性,新浪對(duì)API的調(diào)用有諸多限制,使用微博開(kāi)放的API接口的方式并不能滿足大規(guī)模數(shù)據(jù)需求的情況。因此,在實(shí)驗(yàn)過(guò)程中,可以將兩者結(jié)合,在多臺(tái)機(jī)器上進(jìn)行采集,獲取大量完整的微博數(shù)據(jù)。最后將獲取到的微博數(shù)據(jù)進(jìn)行格式化,保存為json格式或者保存到關(guān)系型數(shù)據(jù)庫(kù)中。

將網(wǎng)絡(luò)爬蟲(chóng)技術(shù)和新浪微博API接口獲取數(shù)據(jù)方式進(jìn)行結(jié)合,共獲取1 894個(gè)新浪微博用戶(hù)214 870條微博數(shù)據(jù),將這些數(shù)據(jù)存入MySQL數(shù)據(jù)庫(kù)作為實(shí)驗(yàn)數(shù)據(jù),利用UR-LDA模型對(duì)其建模。

4.1.2 數(shù)據(jù)預(yù)處理

在獲得原始數(shù)據(jù)后,通常需要進(jìn)行數(shù)據(jù)預(yù)處理,提高數(shù)據(jù)的可靠性。實(shí)驗(yàn)室針對(duì)中文微博的主題挖掘,通過(guò)以下步驟優(yōu)化數(shù)據(jù)源。

(1)去掉微博文本中不能體現(xiàn)任何有意義主題的文本,如不包含任何漢字的文本。

(2)通過(guò)正則表達(dá)式[//\s*?@.*?:]過(guò)濾掉微博文本中與轉(zhuǎn)發(fā)相關(guān)的特殊字符。

(3)對(duì)微博文本長(zhǎng)度小于10的微博進(jìn)行刪除。

(4)通過(guò)正則表達(dá)式[@(.+?)\s+]取出微博文本所有會(huì)話聯(lián)系人,以“@[會(huì)話聯(lián)系人1,會(huì)話聯(lián)系人2,…,會(huì)話聯(lián)系人n]”的形式寫(xiě)在當(dāng)前微博文本的前面,并以空格將兩者隔開(kāi)。

(5)設(shè)置白名單詞典、用戶(hù)詞典及停用詞表。

白名單詞典[12]是為了防止一些有意義的詞被當(dāng)成噪聲而設(shè)置的,如:KTV。

用戶(hù)詞典是為了防止一些人名和固定詞被無(wú)意義分割而設(shè)計(jì)的,如“成龍”。

停用詞是指沒(méi)有實(shí)際主題含義的詞,如“十分”、“非常”、“特別”等。設(shè)計(jì)停用詞表,主要是為了去除微博文本中的停用詞。

(6)通過(guò)ICTCLAS[13]進(jìn)行分詞處理,過(guò)濾掉微博中不屬于白名單詞典的所有單個(gè)漢字,非漢字詞語(yǔ),停用詞,地點(diǎn)以及特殊字符等影響主題挖掘?qū)嶒?yàn)的詞。

4.1.3 實(shí)驗(yàn)環(huán)境

實(shí)驗(yàn)環(huán)境為Intel(R) Pentium(R)4 3.00 GHz 的CPU,4 G內(nèi)存,160 GB硬盤(pán)的PC機(jī),操作系統(tǒng)為Win8,實(shí)驗(yàn)工具為JetBrains PyCharm 2016.1.2。

4.2 UR-LDA模型參數(shù)

模型參數(shù)參考文獻(xiàn)[14]中的方法進(jìn)行設(shè)置。取經(jīng)驗(yàn)值α=αur=50/K,β=0.01,K=60,其中K是整個(gè)數(shù)據(jù)集上的主題總數(shù)。

4.3 實(shí)驗(yàn)結(jié)果

4.3.1 整體效果

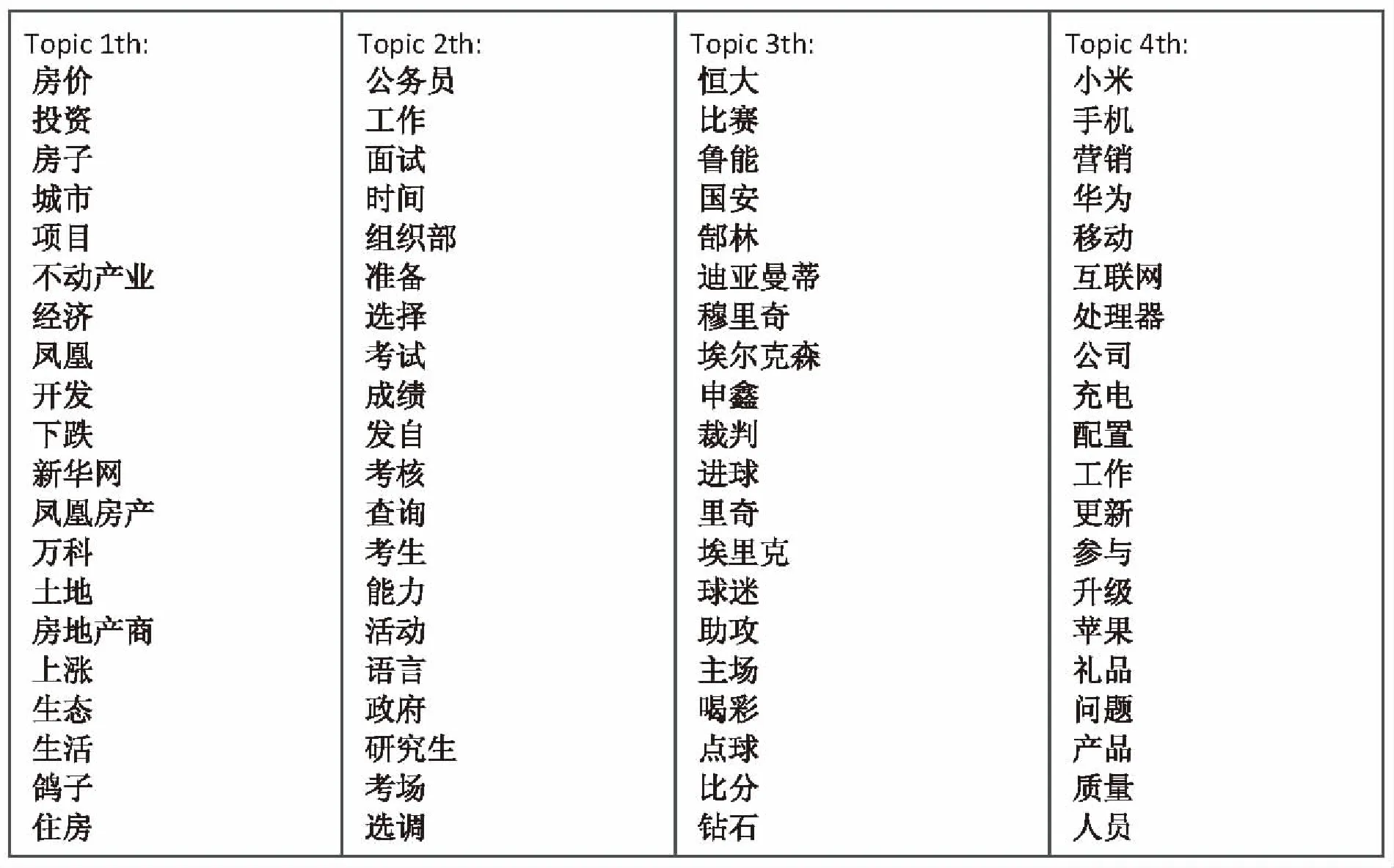

選取UR-LDA模型的主題挖掘前4個(gè)主題社區(qū)的結(jié)果,如圖3所示。

圖3 UR-LDA模型部分效果圖

圖中,每個(gè)主題選擇了20個(gè)關(guān)鍵詞進(jìn)行表征,關(guān)鍵詞是按照其在主題下的分布概率由高到低顯示。

根據(jù)各個(gè)主題相對(duì)應(yīng)的關(guān)鍵詞可以發(fā)現(xiàn)Topic 1是與房?jī)r(jià)相關(guān)的主題,Topic 2是與公務(wù)員相關(guān)的主題,Topic 3是與足球相關(guān)的主題,Topic 4是與手機(jī)產(chǎn)品相關(guān)的主題。不同主題的關(guān)鍵詞都能有效表征當(dāng)前主題,說(shuō)明主題的關(guān)鍵詞分類(lèi)合理,主題之間的獨(dú)立性比較高。

4.3.2 對(duì)比實(shí)驗(yàn)

在研究主題模型時(shí),可以使用困惑度(perplexity)指標(biāo)對(duì)模型進(jìn)行評(píng)估。perplexity是度量概率圖模型性能的常用指標(biāo)[14],它表示了預(yù)測(cè)數(shù)據(jù)時(shí)的不確定度,該值越小,模型建模效果越好[15]。計(jì)算公式[16-17]如下:

(12)

其中,w為微博數(shù)據(jù)集;wm為在數(shù)據(jù)集中出現(xiàn)的單詞;Nm為測(cè)試集中出現(xiàn)的詞語(yǔ)總數(shù)。

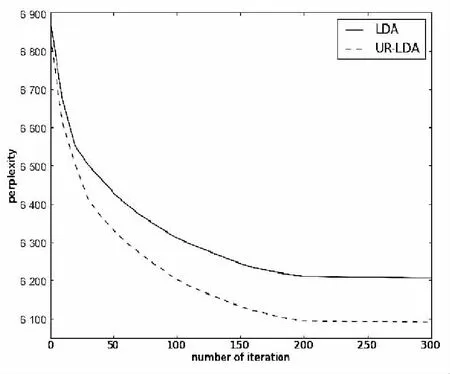

在相同參數(shù)下,分別計(jì)算傳統(tǒng)LDA模型和UR-LDA模型的perplexity,結(jié)果如圖4所示。

從圖中可以看出,隨著迭代次數(shù)的增加,直到模型趨于收斂,UR-LDA模型的perplexity都要小于傳統(tǒng)的LDA模型,說(shuō)明UR-LDA模型在測(cè)試數(shù)據(jù)上具有更好的建模效果。

5 結(jié)束語(yǔ)

圖4 模型困惑度對(duì)比圖

針對(duì)新浪微博短文本語(yǔ)義稀疏以及文本之間相互關(guān)聯(lián)的特點(diǎn),提出了一種適合處理微博用戶(hù)關(guān)系數(shù)據(jù)的UR-LDA模型,并采用吉布斯抽樣對(duì)模型進(jìn)行推導(dǎo)。在真實(shí)的數(shù)據(jù)集上進(jìn)行實(shí)驗(yàn),結(jié)果證明UR-LDA較傳統(tǒng)的LDA主題模型有更好的主題挖掘效果。

雖然UR-LDA模型能夠較有效地對(duì)微博進(jìn)行主題挖掘,但也有一定的局限性[18]。通過(guò)新浪微博,也可以發(fā)布音樂(lè)、視頻、圖片等多媒體信息,而不再是單純的文字信息。今后的研究工作主要集中在處理微博中的多媒體數(shù)據(jù),增強(qiáng)主題模型挖掘能力等方面。

[1] Girvan M,Newman M E J.Community structure in social and biological networks[J].PNAS,2002,99(12):7821-7826.

[2] Li Xin,Guo Lei,Zhao Yihong.Tag-based social interest discovery[C]//Proceedings of the 17th international conference on world wide web.[s.l.]:[s.n.],2008:675-684.

[3] Mei Qiaozhu,Cai Deng,Zhang Duo,et al.Topic modeling with network regularization[C]//Proceedings of the 17th international conference on world wide web.[s.l.]:[s.n.],2008:101-110.

[4] Blei D M,Ng A Y,Jordan M I.Latent Dirichlet allocation[J].Journal of Machine Learning Research,2003,3:993-1022.

[5] 汪進(jìn)祥.基于主題模型的微博話題挖掘[D].北京:北京郵電大學(xué),2015.

[6] Kang J H,Lerman K,Plangprasopchok A.Analyzing Microblogs with affinity propagation[C]//Proceedings of the KDD workshop on social media analytics.New York:ACM,2010:67-70.

[7] Deerwester S,Dumais S,Landauer T,et al.Indexing by latent semantic analysis[J].Journal of the American Society of Information Science,1990,41(6):391-407.

[8] Hofmann T.Probabilistic latent semantic indexing[C]//Proceedings of the 22nd annual international ACM SIGIR conference on research and development in information retrieval.New York:ACM,1999:50-57.

[9] Nallapati R M, Ahmed A, Xing E P,et al.Joint latent topicmodels for text and critations[C]//Proceedings of the 14th ACM SIGKDD international conference on knowledge discovery and data mining.[s.l.]:ACM,2008:542-550.

[10] 李 明,王占宏,魯 明.基于J2EE框架的混合模式治安管理信息系統(tǒng)研究與應(yīng)用[J].計(jì)算機(jī)工程,2003,29(1):252-252.

[11] Garrett J J.Ajax:a new approach to web applications[EB/OL].(2005-02-18)[2011-02-18].http://www.adaptivepath.com/publications/essays/archives/000385.php.

[12] 郭劍飛.基于LDA多模型中文短文本主題分類(lèi)體系構(gòu)建與分類(lèi)[D].哈爾濱:哈爾濱工業(yè)大學(xué),2014.

[13] Thomas H.Probabilistic latent semantic indexing[C]//Proceedings of SIGIR.Berkeley,CA,USA:[s.n.],1999:50-57.

[14] Griffiths T,Steyvers M.Probabilistic topic models[M]//Latent semantic analysis:a road to meaning.Hillsdale,NJ:Laurence Erlbaum,2006.

[15] Philp R,Eric H.Gibbs sampling for the uninitiated[R].[s.l.]:[s.n.],2010.

[16] 張晨逸,孫建伶,丁軼群.基于MB-LDA模型的微博主題挖掘[J].計(jì)算機(jī)研究與發(fā)展,2011,48(10):1795-1802.

[17] 胡吉明,陳 果.基于動(dòng)態(tài)LDA主題模型的內(nèi)容主題挖掘與演化[J].圖書(shū)情報(bào)工作,2014,58(2):138-142.

[18] Ma D,Rao Lan,Wang Ting.An empirical study of SLDA for information retrieval[J].Information Retrieval Technology,2011(1):84-92.

Microblog Topic Mining Based on UR-LDA

CHEN Yang1,SHAO Xi1,ZHAO Hai-bo2

(1.College of Communication & Information Engineering,Nanjing University of Posts and Telecommunications,Nanjing 210003,China; 2.Isoftstone Information Technology (Group) Co.,Ltd.,Hangzhou 310000,China)

Social network in particular microblog has become a significant way for users to propagate and retrieve information.However,a large proportion of the real time information is junk or redundant.So the discovery of latent topics in social networks through finding,organizing and using valuable information behind the mass passage with effective ways carries high value in public option monitoring and commercial promotion.Although probabilistic generative topic model (Latent Dirichlet Allocation,LDA) has been widely applied in the field of topics mining,it cannot work well on microblog,which contains little information and has connection with others.A novel probabilistic generative model based on LDA,called UR-LDA,has been proposed which is suitable for modeling the micro-blog data and taking the document relation and user relation into consideration to help mining in micro-blog.A Gibbs sampling implementation for inference the UR-LDA model has been also presented.Experimental results used with actual dataset show that UR-LDA can offer an effective solution to topic mining for microblog.

microblog;topic mining;UR-LDA;Gibbs sampling

2016-05-23

2016-09-14 網(wǎng)絡(luò)出版時(shí)間:2017-03-13

國(guó)家自然科學(xué)基金青年基金(60902065)

陳 陽(yáng)(1992-),女,碩士研究生,研究方向?yàn)樯缃痪W(wǎng)絡(luò)主題挖掘;邵 曦,博士,副教授,研究生導(dǎo)師,研究方向?yàn)槎嗝襟w信息處理系統(tǒng)。

http://kns.cnki.net/kcms/detail/61.1450.TP.20170313.1545.016.html

TP31

A

1673-629X(2017)06-0173-05

10.3969/j.issn.1673-629X.2017.06.036