大數據環境下情報分析方法與情報分析軟件探討

李超+周瑛+周煥+潘瑋

[摘要]大數據時代的到來,給情報分析帶來了新的機遇和挑戰。文章概述了大數據的時代背景及情報分析的發展趨勢,在現有研究的基礎上,對情報分析方法相關研究進行系統梳理,從中歸納出基于知識、文獻、組織、專家、認知心理學等10類傳統情報分析方法并指出其局限性,對7類大數據背景下的情報分析方法及常用情報分析軟件進行了分類探討。

[關鍵詞]大數據;情報分析;分析方法;分析軟件

情報分析是利用技術手段和軟科學研究方法,對信息資源進行收集、整理、綜合并形成有價值情報的方法。大數據環境下情報分析面臨著前所未有的機遇和挑戰。首先,大數據能夠為情報分析提供有力的數據處理分析方法和工具,并能提升情報分析的應用價值,更好地為政府、企業、圖書情報機構提供決策支持。其次,大數據環境下,情報分析過程面臨數據量越來越大、數據類型更加復雜、處理和分析難度增大、精準化的用戶需求及有針對性的結果呈現等問題。傳統的情報分析方法已到了一個突破瓶頸的時期。而大數據分析和情報分析都是以數據為基礎進行研究,通過分析數據和信息,為用戶提供相關服務。并且都以多源數據融合、信息的定量分析、相關關系的探討為研究重點。因此,優化和改進傳統的情報研究方法,引進和創新適用于情報分析的大數據分析方法、思路、新工具和新手段,解決大數據為情報分析帶來的新問題,充分挖掘大數據中蘊含的情報價值,使研究結果更加科學,就很有必要性。本文在對國內外情報分析方法進行研究的基礎上,結合大數據的背景對傳統的情報分析方法進行了歸類并分析其局限性,對大數據背景下的情報分析方法和情報分析軟件進行了探討。

1大數據的時代背景及情報分析的趨勢

隨著科技的迅猛發展,在科學研究、互聯網應用、電子商務、社交網絡、物聯網、移動互聯、生物醫藥、醫療衛生、地理信息、影視娛樂等領域不斷產生海量的數據信息,這就是所謂的大數據。大數據的基礎在于數據,其特點主要是:數據類型復雜,數據體量巨大,數據價值密度較低,處理速度較快。百度公司每天處理的數據量約幾十PB,共響應60億次請求;據互聯網中心和麥肯錫全球研究院預計,到2020年全球和中國的數據總量將達到35ZB和8.5ZB;關于大數據,維基百科給出的定義是:所涉及的資料量規模巨大到無法透過目前主流軟件工具,在合理時間內達到擷取、管理、處理,并整理成為幫助企業經營決策更積極目的的資訊。而隨著情報領域的知識劃分逐漸細化、內容更加專深、數據量也日趨增大。我國每年新增的科技文獻和專利數量分別達到了150萬篇和200萬條。海量的技術標準、科研文獻、會議論文增長的速度已經超過了人工處理所能承受的極限,情報分析已經更多地依靠智能化、標準化、高效率的信息技術來輔助完成數據處理的工作。目前,情報分析的趨勢主要是:研究領域從單一領域逐漸擴大轉到全領域分析、對各種采集方式獲取的不同結構數據進行綜合利用、注重新媒體形式異構信息的分析、對情報分析智能化的要求不斷提高。

2大數據環境下的情報分析方法

2.1傳統的情報分析方法

傳統的情報分析方法宏觀上,根據研究手段分為:定性分析方法、半定量分析方法及定量分析方法;微觀上,根據對象類型分為:基于知識的情報分析方法(知識地圖法、知識基因法、空白點分析法、循證決策法等)、基于文獻的情報分析方法(文獻計量法、內容分析等)、基于組織的情報分析方法(SWOT分析法、產品生命周期分析法、PEST分析、定標比超法等)、基于專家的情報分析方法(訪談法、頭腦風暴法、Delphi法、交叉概率法等)、基于認識的情報分析方法(哲學方法、理性思維方法、形象思維方法等)、基于認知心理學的情報分析方法(境況邏輯法、理論應用方法等)、面向軍事情報的分析方法(基于物理、事理、人理的分析方法等)、面向公安情報的分析方法(哲學方法、中介方法等)、面向犯罪情報的分析方法(文件檢驗法、地圖分析法等)、面向專利的情報分析方法(定性分析、定量分析、擬定量分析法等)。如表1。

傳統情報分析方法的數據基本都是結構化、標準化、樣本化的,而大數據格式明顯具有異構性、多源性的特點,使傳統分析方法在數據數量、類型上受到很大局限。同時,傳統情報分析方法,更多地關注于文獻分析,通過趨勢外推進行預測;而文獻數據本身存在信息不完全、表現形式單一、分類和編碼困難、代表性可能不足等固有缺陷,加之大數據環境下海量數據易造成認識偏差,導致分析結果的科學性會受到很大影響。對于大數據環境下社會網絡結構分析、批量與流式分析、可視化分析、空間信息分析等需求,傳統分析方法也難以滿足。因此,在應用中須對傳統情報方法進行優化、改進、繼承和創新,同時引進新思路、新工具和新手段,使研究結果更科學、高效、準確。

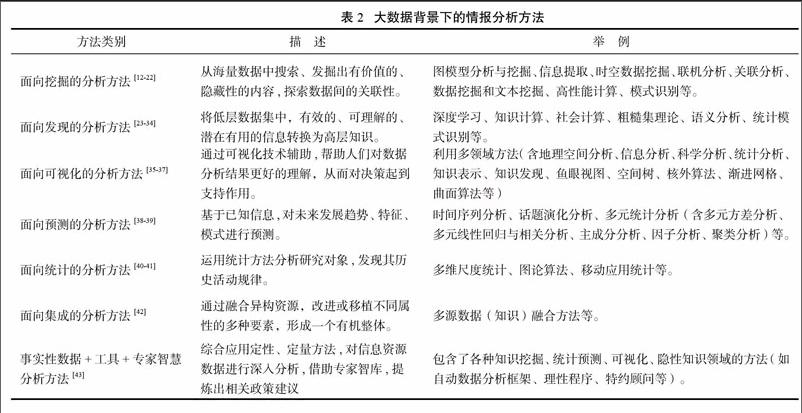

2.2大數據背景下的情報分析方法

海量的異源異構數據,對情報分析造成了巨大的沖擊,而大數據分析方法與情報分析方法在本質上有很多共同之處,并且在數據處理方面更加優越。首先,大數據分析方法能夠對數據進行深度分析,充分挖掘數據問的關聯性,提升數據價值;其次,大數據分析能夠有效進行多源數據融合,兼容多種結構和媒體形態的數據;最后,大數據分析基于更先進的平臺和開發技術,具有更高的處理效率。因此,引進情報分析領域適用的大數據分析方法并進行創新,充分挖掘大數據中蘊含的情報價值是當前情報分析領域的研究熱點。綜合考慮方法本身的可操作性、可移植性、完整性等因素,本文從微觀層面對18種大數據背景下的情報分析方法進行歸類和分析。如表2。

2.2.1面向挖掘的分析方法

圖模型分析與挖掘:圖模型挖掘是文本數據挖掘方法的一種重要應用。趙斌等,通過一種基于“詞項一消息一用戶”的TWU圖模型,來對微博中群體觀點進行挖掘,把時戳作為邊的屬性來處理,提出了時間敏感性隨機游走算法TSRW,通過對詞項的相關性進行度量來挖掘群體觀點。姜春濤等,提出用圖示法定義專利文本單元語法及相似性關系,利用語義技術提高專利智能分析的準確性和性能。

信息提取:是把文本里包含的信息進行結構化處理,然后以統一的形式集成在一起,以便進行比較分析的一種方法。張敏,劉建華等,通過開源工具PDFBox和Tika對不同類型的富文檔元數據及正文內容進行提取。首先,通過解析Content-Type來獲取MIME類型名稱,識別文檔的類型;再通過對富文檔進行分析,提取文檔的創建時間、修改時間、文檔標題、文本內容等重要信息,拓展了文本知識內容的識別方法。

時空數據挖掘:隨著移動終端定位信息服務的發展和網絡中描述時空范圍的信息不斷增加,挖掘時空信息并提升其價值,成為了數據挖掘領域的前沿課題。時間信息通常可從網頁內容、用戶數據或超鏈接中提取,Allen首次提出用代數的區間來表示時間。概率模型法、粗糙集、自動注解等方法都適用于時間的識別。空間信息分為源位置和目標位置,分析主機位置就可以定位到源位置,通過地理文本分析和地理信息標識可以找到目標位置。Lauw、Pham、Crandall等人提出了基于時空事件模型的社交網絡發現方法,通過分析用戶的地點信息、用戶在時間和空間上的共現,預測用戶之間的社交聯系和強度。時空挖掘方法針對輿情研究、社交網絡分析、研究主題周期等情報分析問題有很好的幫助。

聯機分析:是對大量數據進行快速、靈活地分析和處理,為決策人員提供信息支持的一種快速軟件技術,能夠支持復雜查詢處理。隨著大數據時代信息化程度的提高,數據量不斷增大、數據維度不斷增多,聯機分析技術正向著高效查詢的方向發展。高雅卓,倪志偉等提出了基于關聯規則挖掘的數據立方體物化方法及立方體增量更新算法。并進行了基于變量選擇的OLAP查詢流程模擬實驗,證明算法提高了查詢推薦的效率。于非,張嵐,張柏秋,對美國ProQuest公司的ProQuest Dialog國際聯機檢索平臺的指令算符、索引字段做了詳細比對與分析,指導用戶合理組配構建邏輯關系緊密的檢索策略,提高查全率和查準率。

關聯分析:是一種從海量數據或其他信息載體中發現項目或對象集合之間相關性、相關關系或因果結構的分析方法,常用的算法是Apriori算法和FP-growth算法。何超,張玉峰設計了商務情報語義關聯分析算法,自頂而下進行多層知識挖掘,對用網絡圖結構表示的文本中的關聯模式進行探索。楊建林對同一作者在其發表的所有期刊論文中列出的所有關鍵詞進行關聯分析挖掘,挖掘過程包括:業務理解、數據準備、數據預處理、數據挖掘和結果分析5個步驟。以發現學術個體在研究方向選擇方面的行為特點,揭示不同研究方向兩兩之間的關聯強度。

數據挖掘和文本挖掘:通過對結構化的數據進行挖掘,發現潛在的關聯規律和模式的方法。數據挖掘偏重于圖書館信息檢索服務方面,而文本挖掘屬于計算機領域的研究內容,主要用來揭示文本中的詞與句法特征。李信,李旭暉等采用數據挖掘方法,以Web of Science為數據源,借助SATI和SPSS軟件分析了大數據驅動下圖書情報學科研究的現狀和進展。

2.2.2面向發現的分析方法

深度學習:是利用層次化的架構,對大數據進行有效學習、解釋和表達的方法,相對傳統的模型和方法,更為復雜和深入。該方法通常和人工神經網絡方法相結合使用。隨著科技發展大規模神經網絡分析技術提升了深層感知的效果,與大數據形成相互促進的關系。體量浩大的大數據解決了人工神經網絡訓練樣本不足的問題,而神經網絡能夠對異構數據、多源數據進行整合、提取特征和抽象,捕捉變化動態,實現大數據價值轉化。Bengio等利用自動編碼器,實現了非概率無監督深度學習;斯坦福大學Socher等,在解決情感分析問題時采用了遞歸神經網絡,將識別率提高了5個百分點。國內,科大訊飛和百度的IDL對深度學習技術進行了深入研究,獲得了良好效果。

知識計算:大數據知識計算是學術界的研究熱點之一,是通過對數據進行抽取并構建成知識庫(支持查詢、分析、計算),從而進行高端分析,提升知識的價值。世界各國都發布了知識搜索平臺,如wolframalpha知識計算平臺、TrueKnowledge知識搜索平臺、knowledge graph搜索服務、維基百科知識庫等;國內有多所高校和研究所也參與了知識庫建設工作,如上海交通大學建立的zhishi.me平臺,復旦大學GDM推出的知識圖譜平臺,中科院數學研究院發布的知件等。知識庫的構建工作包括:手動或自動構建知識庫、對多源知識進行融合并更新知識庫。手動構建知識庫,需要專業人員并花費大量人力物力,如:知網(Hownet)、同義詞詞林、概念層次網絡(HNC)和中文概念詞典(CCD),OpenCyc;自動構建方法分為有監督的構建方法和半監督的構建方法,如Probase 和YAGO知識庫。

社會計算:隨著大數據時代社交網絡的興起微博、Twitter等在線應用使人與人之間的關系網絡更加緊密,人的互聯逐漸成為信息互聯的載體和信息傳播的媒介。因此,社會計算成為了學術界較為重視的研究內容。目前,社會計算的熱點主要集中在社會網絡結構分析、信息傳播模型分析、信息內容分析、社會媒體中信息檢索與數據挖掘等方面。社區結構是在線社會網絡結構分析領域的研究方向之一,主要針對社區的定義、度量、結構演化等問題進行分析。在線社會網絡信息傳播模型研究方面,影響力較大的是傳染病模型和隨機游走模型;隨后,不同領域專家從網絡動力學、消息可信度、消息新穎度、消息的流行度等不同角度對進行了建模和實證分析。社會網絡信息檢索和挖掘,在大數據環境下需要處理:信息碎片化、自媒體現象、人的互聯取代信息互聯等一系列問題。國外專家Yang提出了時間序列聚類算法,Bollen通過情感分析提出情緒時間序列的方法。國內包括:清華大學、北京大學、上海交通大學、中國科學院等機構已經對社會媒體檢索和挖掘進行了深入研究。

粗糙集理論是一種能夠定量分析處理不精確、不一致、不完整信息與知識的數學工具,在情報學領域多用于專利分析、知識庫構建、多指標綜合評價、影響力評估等問題。大數據環境下粗糙集理論通過增量式學習和海量數據集進行合理分割的方法來解決數據量過大的問題。通過基于對等價關系的泛化,比如限制容差關系、相似關系、容差關系、模糊聚類等方法來處理不完備信息。周磊分析了粗糙集與模糊集、證據理論、神經網絡進行融合形成的三種方法在競爭情報分析中的應用及基本工作流程。袁潤,錢過利用粗糙集理論分析專利數據,并按照核心專利綜合指數將特定領域專利進行分類。

語義分析:是指將人類的自然語言轉化為反映其意義的某種形式化表示,使計算機能夠理解。當前在概念、關系層次上的語義分析主要包括:基于統計的特征向量抽取和基于語義詞典的相似度計算方法。ICTCLAS(Institute ofComputing Technology,Chinese Lexical Analysis System),是中國科學院技術研究所開發出的漢語詞法分析系統,主要功能包括中文分詞;詞性標注;命名實體識別;新詞識別;同時支持用戶詞典。ICTCLAS3.0具有分詞精度高、查詢速度快、內存占用小等多種優點。北京理工大學張華平博士開發的NLPIR漢語分詞系統也是國內用戶較多的基于大數據語義挖掘平臺,能夠實現分詞、關鍵詞、聚類、分類、摘要、去重、情感分析、特定人物情感分析、精準搜索等功能。美國State Street金融服務公司,在公司首席科學家David Saul的領導下,采用語義技術來整合公司各種數據庫,使得大數據真正變成了“智慧數據”。語義分析技術目前在圖情領域多用于學科知識服務、個性化推薦、查詢擴展、智能檢索、數字資源網絡聚合、微博主題挖掘、元數據描述、網絡輿情分析等。

統計模式識別:統計模式識別是結合統計概率論的貝葉斯決策系統進行模式識別的技術,又稱為決策理論識別方法。該方法在圖書情報領域主要應用于文檔分類、文檔圖像分析、多媒體數據庫檢索等方面。

2.2.3面向可視化的分析方法

隨著大量信息的產生,圖書情報學領域研究人員需要對海量數據進行處理和利用,探索數據之間的關系、隱藏的規律,從而對事物發展的趨勢進行預測,為決策者提供實時、準確的信息支持。可視化分析融合了多個領域的方法包括:地理空間分析、信息分析、科學分析、統計分析、知識表示、知識發現等。可視化分析流程主要包含5個步驟:根據研究主題,選取數據源并抽取數據;確定需要分析的元素,如期刊、學科、作者、學位論文等;再確定數據元素的關系,獲取關系矩陣;最后繪圖并通過分析獲得相應關系信息。如何應對高維度、大規模、多類型、來源復雜、動態演化的大數據信息,提高信息的可用性,更好地提供決策支持,是情報可視化領域需解決的問題。目前主流的方法是數據轉換和視覺轉換。通過刪除節點的方式簡化網格,解決了曲面可視化的問題;Hoppe提出了漸進網格表達方法;Cignoni提出提高信息解析度、多尺度、多層次展示的方法,利用四叉樹紋理層次和三角片面二叉樹對幾何和紋理進行展示;此外,還有將數據放置在外存的核外算法;采用細節強調的方式,簡化非重要數據的方法,如魚眼視圖、空間樹等。

2.2.4面向預測的分析方法

時間序列分析與多元統計分析:兩種方法共同點是能夠基于歷史數據的變化,評價事物現狀或預測事物未來的發展。前者主要通過調查或統計抽樣獲得系統的時間序列動態數據,然后進行相關分析和模型曲線擬合,預測發展趨勢;后者是對多個觀察對象和指標之間關聯規律進行研究的方法,是從統計學中發展的一種綜合分析方法,包含了:多元方差分析、多元線性回歸與相關分析、主成分分析、因子分析、聚類分析等。

話題演化分析:話題演化分析方法是近年來文本挖掘領域的研究熱點,主要采用LDA模型、LSI模型等,將對文本中詞語表示為話題集合,模擬話題隨時間推移表現出的變化。陳福集,馬梅蘭以成都女司機為研究對象,進行話題識別和演化過程分析,并研究了特征詞分布特點,建立了關聯度判別函數,改進了single-pass聚類算法,證明全生命周期模型分析話題演化方法能夠對一般輿情發展進行分析。廖君華,孫克迎,鐘麗霞采用LDA模型提取熱點話題,利用時間標簽發現熱點話題,以“釣魚島事件”實驗證明模型能預測話題演化趨勢。

2.2.5面向統計的分析方法

多維尺度分析統計,是在保留原數據幾何關系的前提下,應用降維技術,通過非線性變換,把高維度空間的數據轉換成低維度空間的數據,并進行統計分析的技術。目前較為流行的算法有:隨機尋徑網絡算法,對時變性和隨機性海量數據進行分析,目標是生成一個節點數目不變、只保留有效鏈接的精簡網絡即最小值網絡;最小生成樹算法,該方法曾被用來計算文獻的共被引距離進行可視化分析和構造演化網絡;潛在語義索引,通過海量文獻進行詞匯之間關系的分析,通過自然語言理解,能在一定程度上提高檢索結果的相關性,多用于圖書館文獻分析;突發檢測算法,主要通過對學科領域內焦點詞的發展,增長勢頭進行比較,研究學科領域內研究熱點的變化、發展情況。

圖論方法,是通過圖形的角度對網絡進行研究,反映網絡數據之間的關聯,能夠進一步提高對數據的理解和分析能力。Andrei Broder等人通過搜索引擎收集了大量網頁和鏈接,通過繪制網絡拓撲,利用圖論方法對本地及全球互聯網的圖形特征進行了研究。Google通過分析網頁之間的鏈接圖,來分析網頁之間的關系,提高搜索的質量。PageRank算法基于對網頁權威性的判斷,使Google能比競爭對手更快地獲取相關信息。

移動應用統計方法。隨著移動互聯網的發展,各種移動圖書館、微信圖書館等應用不斷出現。在為科研工作者及時、便捷地提供信息推送、在線文獻閱讀、電子圖書預覽等功能的同時,每天產生大量的用戶行為和服務日志。通過對大量的用戶數據進行收集和統計分析,能夠有效對服務進行完善和改進,在用戶行為分析、輿情信息移動推送、競爭情報移動推送、書目信息推送、文獻移動推送、信息定制、信息關聯標引等方面都有很好的應用。

2.2.6面向集成的分析方法

多源數據(知識)融合方法:多源數據融合方法,是針對大數據環境下多源異構數據分析處理而提出的方法,通過對多源數據進行挖掘和融合,有利于提升信息分析的作用、減少信息錯誤與疏漏、防止決策失誤。R.R.Yager提出一種多源數據融合的框架,并通過投票方式有效解決數據之間沖突。K.Chopra建立了一個多源信息融合的軟件工具模型,并對情報分析的不確定性評價進行了探討;陳科文等人則從系統設計、數據處理、融合模型與方法等方面對當前多源信息融合的關鍵問題與應用進展進行了綜述。多源知識融合方法,是以提高知識的復用和共享為目的,對多來源的知識進行融合的方法。需要對不同來源的知識進行清理、消除冗余、解決實例、概念、屬性和關系的沖突。通常利用人工智能、本體、機器學習技術的自動融合方式可擴展性較好。

2.2.7事實性數據+工具+專家智慧分析法

中國科學技術研究所,針對大數據環境提出了基于“事實型數據+工具方法+專家智慧”的情報分析方法。通過定性定量的系統結合方法,對信息資源數據進行深入分析,借助專家智庫,提煉出相關政策建議。美國著名的戰略情報研究所一蘭德公司,利用自主研發的自動數據分析框架、理性程序并借助社會知名人士、政府離職官員作為顧問,對戰略情報進行綜合分析,取得了良好的效果。山東省科技情報研究所和廣東省科技圖書館,分別將該方法應用于海水淡化和情報服務工作中。

3大數據環境下情報分析常用軟件

情報研究人員在對海量異構數據的分析處理過程中,通常需要借助專業的情報分析軟件,以縮短分析周期、提高分析的效率和準確性。以下對大數據環境下常用的情報分析軟件進行概括分析,見表3。

3.1可視化分析軟件

可視化技術旨在利用圖形圖像領域的技術和方法,研究大規模信息資源的視覺呈現,幫助情報工作人員理解和分析數據。該技術是知識計量學、科學計量學等領域重要的研究方法和手段。信息可視化工具包括:CiteSpace、RefViz、HistCite、Vosviewer、Leydesdorff等。Citespace由陳超美教授開發,能夠通過對某學科領域的文獻數據進行挖掘、繪制可視化圖譜,展示學科發展趨勢和動向。目前CiteSpace5.0為軟件最新版本.新版本具有四大核心功能:快速定位本領域核心文獻、快捷梳理領域的文獻關聯、探究研究前沿和知識基礎和探測學科主題分布與主題趨勢。Refviz是一款對參考文獻進行管理并發現文獻之間關聯性的軟件,由OmniViz和Thomson ISI Research公司共同推出。該軟件能夠將文獻按照內容和關聯度進行分組,以詞語加權方式對詞語的重要性進行分類,對熱點詞語權值的干預。HistCite是用來分析領域內文獻關系,并繪制引文圖譜的軟件,能夠通過可視化方式對最新、重要的文獻進行展示的軟件。Vosviewer是荷蘭萊頓大學CWTS科學技術研究中心開發的集成文本挖掘、分散視圖、標簽視圖、聚類密度視圖的文獻計量和可視化分析的工具。最新開發的1.6.5版本,對可視化效果進行了提升,提供了新的命令。允許用戶對網絡和數據密度可視化疊加效果進行自定義,并能夠以自動化的方式創建VOSViewer地圖。Leydesdofff是針對多種數據源分析的系列軟件,由荷蘭阿姆斯特丹大學研發,能夠實現共詞、合作、耦合、共引等分析。

3.2專利分析軟件

目前國內外專利分析工具分為:專利采集和加工工具、專利檢索分析工具及計算機輔助創新工具。專利采集加工工具通過爬蟲對專利進行采集、清洗為專利分析提供數據,主要有臺灣連穎科技公司開發的PatentGuider、北京彼速軟件公司開發的BizSolution、保定大為軟件公司開發的PatentEx專利分析系統、漢之光華專利情報分析系統等;專利檢索分析工具具有先進的數據檢索、文本挖掘功能,主要有美國Lexis Nexis公司的Total Patent、Aureka、Delphion、Innovaton等。計算機輔助創新工具包括:美國Invention Machine公司開發的Goldfire Innovator9.0,以TRIZ/ARIZ為工具,與全球超過70個專利庫進行連接,包含了超過9000條來自各個領域的科學原理。主要作用是通過對典型技術問題專利進行技工,提出解決問題的方法。Pro/Innovator由億維訊公司開發,支持隱性知識挖掘利用,對知識的產生、表達、組織、更新、檢索、共享等過程進行全程管理。

3.3統計分析軟件

大數據環境下數據可分為:結構化數據、半結構化數據及非結構化數據。在進行情報分析時:對于半結構化數據和非結構化數據的挖掘和分析,宜采用傳統分析工具Excel、SAS、SPSS、Stata、Matlab等進行處理。而半結構化數據和非結構化數據處理相對較復雜,R語言、Python和Flurry則具有絕對優勢。

R語言是由Nuckland大學Robert Gentleman和Rosslhaka編制,用于處理大數據環境下海量數據的統計軟件包。R的優勢在于有包羅萬象的統計函數可以調用,提供了包括廣義回歸分析、風險分析、矩陣計算、抽樣檢驗等功能,并且能讀取由SAS、SPSS、Stata、Matlab等軟件處理的數據。

Python語言具有非常清晰易讀的語法特點,支持目前主流的操作系統,能夠支持移動應用,擁有良好的學習支持資源并不斷對庫進行改良。Python的網絡爬蟲及R的RCurl包、Rweibo包等都可以進行網絡數據和文本挖掘,對非結構性數據亦能進行分析處理。常用作文本挖掘、日志統計分析、社交網絡分析等。

Flurry是專門為統計移動應用用戶數據而開發的統計工具,能夠支持包括iPhone、iPad、Android、WindowsPhone、Java ME和BlackBerry終端平臺的數據分析,支持超過36萬個移動應用。Flurry能夠支持移動應用的構建、用戶偏好的分析和數據智能分析推送等功能,在移動應用數據統計方面處于領先地位。此外國內外的移動應用統計分析工具/平臺還有:Talking Data、Cobub Razo、FLURRY等。

3.4犯罪情報分析軟件

面對大數據產生海量的犯罪情報信息,犯罪情報分析軟件在公安情報分析中起到很大作用。Analysts Notebook是海灣戰爭中為美國開發的情報軟件,為情報分析工作提供了強有力的支持。軟件能夠通過關聯對比,將事先錄入的雜亂數據形成關系網和分析圖,為行動決策提供犯罪情報支持。為了提供數據存儲功能,IBase和Ibridge軟件應運而生。ATAC是BSRC公司開發的綜合犯罪情報分析工具,具有學習分析的功能,能夠進行統計分析、復雜查詢、時間序列分析等功能。ESRI公司研發的地理犯罪情報分析軟件ArcGIS,能夠支持戶外移動平臺使用。

3.5競爭情報分析軟件

瑞典Comintelli公司研發的企業競爭情報平臺軟件Knowledge XChanger,獲得了美國和歐盟組織的認可,使用范圍相當廣泛,能夠實現部分競爭情報流程自動化。此外還有Coemergence公司的ACIS、Traction Software公司的TeamPage、Comintell公司的Knowledge Xchanger、Cipher公司的Knowledge Works、Strategy Software Inc.公司的STRATEGY!,ClearForest公司的ClearResearch Suite等。

3.6威脅情報分析軟件

威脅情報分析,是迅速出現在信息安全領域的方法,Solutionary公司的白皮書對“威脅情報”分析的定義是:通過對安全相關的信息進行搜集、分析、快速和清晰的評估、仔細判斷后形成產品,作為決策和行動的先導。Open Threat Exchange系統能夠訪問威脅研究專家的全球社區,通過威脅指標分析多個來源的威脅數據,為研究人員提供安全設施更新的建議。Threatcrowd是一個威脅搜索系統,能自動從malwr.com獲取信息,能夠協助情報人員對關聯數據進行分析。IBM X-Force是世界上最知名的商業安全研究軟件之一,軟件能幫助客戶、研究人員和公眾更深入地了解最新的安全風險,提前預知新興威脅。公共安全威脅信息的分析和度量可以通過一系列軟件的組合來實現,美國情報機構利用包括:Visible,Socializing the Enterprise,Geofeedia(社交媒體分析)、Open Source Indicators(利用公開信息預測政治動亂、經濟危機,傳染病爆發等)、Information Volume and Velocity(互聯網信息收集系統由美國國防部支持),對公共安全信息進行分析。用于商業公開情報分析的軟件主要包括:Recorded Future,Palantir,Aggregative Contingent Estimation(ACE)(通過篩選各種博客、推特、衛星圖像等提供社會動亂的預警)等。

4結語

大數據時代情報分析和處理是獲取知識的重要手段,也是情報研究的熱點內容。隨著數字化技術和網絡的飛速發展,海量、非結構化、快速增長的數據不斷涌現,對情報研究造成了很大沖擊,情報學將不可避免的面對一場技術革命。本文在對國內外情報分析和大數據分析方法進行研究的基礎上,總結了10類傳統情報分析方法和7類基于大數據背景的情報分析方法,對傳統分析方法的不足和大數據分析方法的優勢進行了研究,并對常用情報分析軟件進行了探討,以期為情報研究人員和情報分析工作提供有價值的參考。