云計算數據中心節能關鍵技術分析

李 棒

(深圳綠色云圖科技有限公司,廣東深圳,518106)

云計算數據中心節能關鍵技術分析

李 棒

(深圳綠色云圖科技有限公司,廣東深圳,518106)

隨著經濟的快速發展,各行各業對于信息化的運用越來越普遍,云計算作為信息化技術發展中的一部分,對云計算數據中心節能進行定量指標方面的分析和研究,并且針對云計算數據中心節能的一些關鍵性技術,即機房選址、IT設備選型、電源系統優化、制冷系統設計和應用場景的選擇等進行詳細的分析和研究。

云計算;數據中心;節能;技術

0 引言

信息化的發展為數據中心的發展奠定了堅實的基礎,從而也推進了全球數據中心規模化、虛擬化、綠色化、智能化的發展,并且就當前中國建立的一些大型數據中心,均已經將云計算技術運用其中,并且最新型的SaaS、laaS類的業務作為當前數據中心節能發展的重要方向[1]。云計算數據中心節能主要是在云計算結構的基礎上,不僅保持了云計算業務的靈活性特征,而且也具備了節能性的特征,進而使得整個云計算的過程都能夠保障一個較為合理的運算成本,并獲取巨大的利潤。

1 云計算數據中心節能定量方面的分析

1.1 云計算數據中心運營成本的組成部分

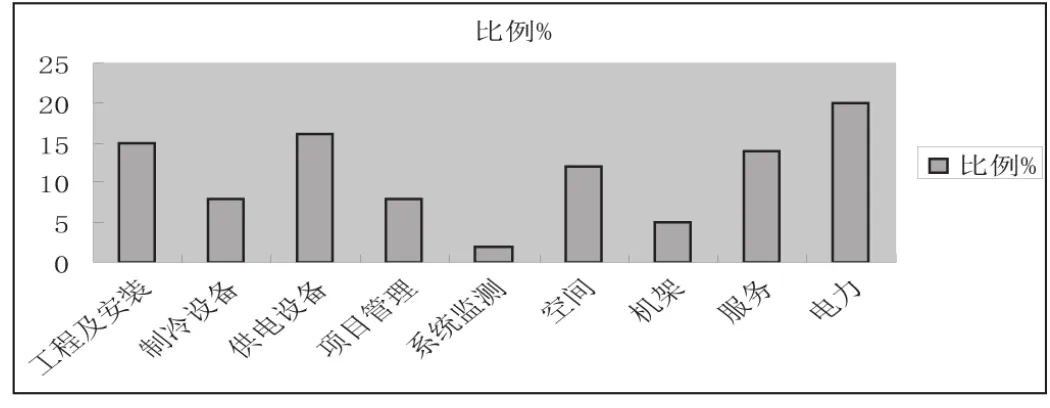

在云計算技術應用的過程中,施耐德公司主要就是采用一種數據中心,并且可以作為成本核算的工具,對傳統的數據中心的總成本進行有效的測算。如圖1成本測算,數據中心耗能最大的地方就是要進行成本控制的主要部分,并且其比例占據總成本的1/5,所以,數據中心運營成本控制的主要部分就是電力。在整個測算的過程中,其額定的功率是100KW,功率密度是500W/m2,每個機器的額定功率是1500W,冗余方式依據2N來進行核算,生命周期保障是10年。

1.2 云計算數據中心電力能耗的組成部分

就當前中國的數據中心的能耗發展情況來看,電力能耗分布的情況如下,即IT設備占據48%,UPS占據7%,制冷系統占據35%,照明占據5%,其它占據著5%,由此可見,數據中心的能耗最主要的構成部分就是IT設備、制冷系統和UPS。然而,從能耗這個角度來看問題,其中最重要的數據就是PUE值。而能耗與IT使用的能耗比公式如下。

圖1 成本測算

PUE=數據中心總設備能耗/IT設備能耗

=(IT設備能耗+空調能耗+供配電系統能耗+其它能耗)/ IT設備能耗

=1+空調設備能耗+供配電系統能耗/ IT設備能耗+其它能耗/ IT設備能耗

=1+CLF+PLF+其它能耗因子綜上可以看出,PUE值自身就是一個基準,且基準為2,當其PUE值接近為1時,其節能水平越高。

2 云計算數據中心節能的關鍵性技術

2.1 機房選址

就中國當前的數據中心在能耗、電力、功率方面的消耗處在全球較高的水平范圍內,尤其是在十二五規劃中,工業的數據中心PUE值要降低到8%的范圍內,通信業是不能高于1.5%。因此,為了節能目標的實現和經濟效益方面的考慮,對數據中心選址方面的考慮一般除了考慮經濟、交通、安全、政策、人力、網絡等方面的因素,還應該就制冷方面的問題進行全面性的考慮。就這些因素的限制下,我國北方地區地區,地域遼闊、冬季較夏季時間長,電力資源豐富、溫度低、空氣清新,為制冷奠定了一定的獨有優勢,其優勢性非常顯著,同樣,也為能耗的降低提供了先天性的優勢條件[2]。

2.2 IT設備選型

IT設備節能改造方面的發展向著聚合微服務器、虛擬切分X86服務器和新型Atom芯片方向發展。尤其是Atom芯片的使用,采用的就是將能耗降到最小的技術,不僅能夠運用于智能手機,而且還能夠運用于平板電腦之類的服務器,同傳統的服務器對比,其耗能量實現了質的降低,云計算的過程中不僅資金的投入量少、電量少,而且其計算能力大大的增強。

2.3 電源系統優化

電源系統的優化設計主要就是高頻UPS的使用,因為UPS的電源轉化功率和負載率呈現出正相關的關系。如當前我國電信運營商的發展過程中,其電源轉化效率提高了4%~5%,其可靠性和安全性也大大的提升。其次,還消除了中心式的UPS,谷歌在發展的過程中,在每個服務期內都設置了一個電池,這些電池自身就可以提供電源,而且其轉化率達到了99.9%。

2.4 制冷系統設計

2.4.1 數據中心高溫化

在信息化發展的過程中,谷歌作為數據中心高溫化發展的典型,其數據中心的PUE值達到了1.2的范圍,領先于世界水平。在運行過程中,其數據中心服務器自身的運行溫度達到了27℃,普通的也保證在了21℃,在這個技術性要求較高的系統中,最為關鍵性的就是服務器的崩潰點和溫度的精準性控制。然而,中央處理器最難的一點就是對溫度的控制,但是,控制其溫度并不是核心的關鍵點,而是要解決內存和硬盤方面的問題。只有運行空間擴大了,溫度即使升高也不會影響機器運行。

2.4.2 控制冷熱通道

在這個技術得設計中,采用了冷熱雙通道的設計理念,主要就是將服務器背靠背的進行排列,由服務器開始從前面將冷風吸入,在后排地區將熱風排出去。服務器都合理的布置在機器的柜臺里,機柜和服務器前面的部分都必須要保持一致性,形成一個機柜前門和服務器設備之間的專用性通道,相向布置,形成一個密封性的通道,這就是我們所說的“冷熱通道”布局,同時,這種布局在應用的過程中,完全的將熱通道密閉,并且大大的將能耗降低[3]。

2.4.3 自然冷卻和水冷空調

(1)自然冷卻。在長期的發展中,在冬天這個季節里,一些云計算數據中心會將室外的冷空氣抽入機房內部,通過過濾之后,實現了設備上的降溫,在夏天這個季節里,實現能量的轉換,盡量將空調使用的時間降低,減少空調的工作負荷量。(2)水冷空調。水冷空調就是室外環境的溫度處在一個低溫的狀態時,就可以關閉制冷機,使用換熱器進行熱量之間的轉換,實現自然冷卻。

2.4.4 液體冷卻技術

上述制冷系統空氣作為散熱介質,難以適應數據中心高熱密度芯片的散熱需求。而隨著數據中心朝大規模、高集成和高熱密度的趨勢快速發展,單機架功率密度越來越高,傳統風冷散熱方式將會達到散熱能力的瓶頸。高效節能且能解決高熱密度難題的液體冷卻技術是未來數據中心的冷卻散熱方式的發展趨勢。尤其是在數據中心液冷技術的應用之后,數據中心的運行溫度可以保持在40℃以上,并且根據有關數據得出,這是當前中國數據中心發展最節能的制冷技術。

2.4.5 溫度控制智能化

在云計算數據中心運行的過程中,首先,主要就是借助了傳感器的作用,計算出所需要的實時的制冷量大小;其次,利用溫度和地板下風壓傳感器的參數來控制該空調自動調整的制冷量和風量的多少,進而滿足大眾的需求;最后,借助動態性的效率調節技術,空調將制冷的需求量輸出給冷凍水機組,再由冷凍水機組根據制冷的需求量進行自動式的設置和調節。

2.5 應用場景的選擇

隨著綠色化生活、工作等的理念的提出,推動著我國各大產業轉變發展方式,進行優化性發展,尤其是當前信息化發展的時代,云計算數據中心節能理念的提出,帶動著我國云計算數據中心的運營商為了能夠獲取更大的利益,紛紛針對不同的應用的場景進行實質性的模擬、優化和運用,最終設計出最優化的方案實現發展,并在發展中取得了一定的成就。

3 總結

綜上所述,在云計算技術應用的過程中,對于電信運營商而言,在建設云計算數據中心的過程中,其優勢性是最為顯著的,主要的表現就是經驗豐富、技術設施完善和資源廣泛且豐富,并且以實現低能耗為目標,著力于機房選址、IT設備選型、電源系統優化、制冷系統設計和應用場景的選擇方面的關鍵性技術的研究,進而實現統籌性的發展,為實現良好的成本控制和利潤增長奠定堅實的技術基礎。

[1]劉航.WMSNs在云計算中心節能減排中的關鍵技術研究[J].大連理工大學,2011-06-10.

[2]敬思遠.面向綠色虛擬數據中心資源管理的若干關鍵技術研究[J].電子科技大學,2012-09-01.

[3]王德文.基于云計算的電力數據中心基礎架構及其關鍵技術[J].電力系統自動化,2012-06-10.

Key Technology Analysis of Energy Saving in Cloud Computing Data Center

Li Bang

(Shenzhen Eco-otlos Technology Co., Ltd.,Shenzhen Guangdong,518106)

With the rapid development of economy, the application of information technology in all walks of life is becoming more and more common. Cloud computing, as part of the development of information technology, analyzes and studies the quantitative indexes of energy saving in cloud computing data center, Cloud computing data center energy conservation of some key technologies, namely, room selection, IT equipment selection, power system optimization, refrigeration system design and application scenarios such as the selection of a detailed analysis and research.

cloud computing; data center; energy saving; technology