基于背景原型對比度的顯著性物體檢測

, ,,

(1.湖北大學 計算機與信息工程學院, 武漢 430062; 2.烽火通信科技股份有限公司,武漢 430073)

基于背景原型對比度的顯著性物體檢測

羅辰輝1,張偉1,沈瓊霞2,葉波1

(1.湖北大學計算機與信息工程學院,武漢430062; 2.烽火通信科技股份有限公司,武漢430073)

針對傳統顯著性模型在自然圖像的顯著性物體檢測中存在的缺陷,提出了一種利用背景原型(background prototypes)進行對比的視覺關注模型,以實現顯著性物體的檢測與提取;傳統顯著性模型主要通過計算區域中心與四周區域差異性實現顯著性檢測,而自然場景中顯著性區域和背景區域往往都存在較大差異,導致在復雜圖像中難以獲得理想檢測效果;基于背景原型對比度的顯著性物體檢測方法在圖像分割生成的超像素圖基礎上,選擇距離圖像中心較遠的圖像區域作為背景原型區域,通過計算圖像中任意區域與這些背景原型區域的顏色對比度準確檢測和提取圖像中的顯著性物體;實驗結果表明,基于背景原型對比度的顯著性模型可以更好地濾除雜亂背景,產生更穩定、準確的顯著圖,在準確率、召回率和F-measure等關鍵性能和直觀視覺效果上均優于目前最先進的顯著性模型,計算復雜度低,利于應用推廣。

視覺關注;背景原型;視覺顯著度

0 引言

人類注意力系統(human attention system, HAS)具備從一個既定場景中迅速定位興趣目標的能力,這也是人類的生物視覺注意力相對普通光學設備的主要優勢之一。因此,如何在現有光學設備控制系統中模擬實現HAS,使光學鏡頭能夠自動聚焦并捕獲目標對象,成為一個重要的研究課題。由于這些光學設備主要為基于嵌入式系統設計的便攜式設備,系統集成的計算資源有限(一般所用的處理器為嵌入式處理器,性能不高,并且內存容量也有限),難以進行大量高速運算,這就要求所設計的顯著性模型必須在保證準確度和可靠性的同時,也要具有較低的復雜度,易于實現。性能需求與計算復雜度的矛盾,是圖像顯著區域檢測的主要困難,近年來眾多研究人員在此問題上付出了巨大的努力,取得了一些有效成果[1-7]。

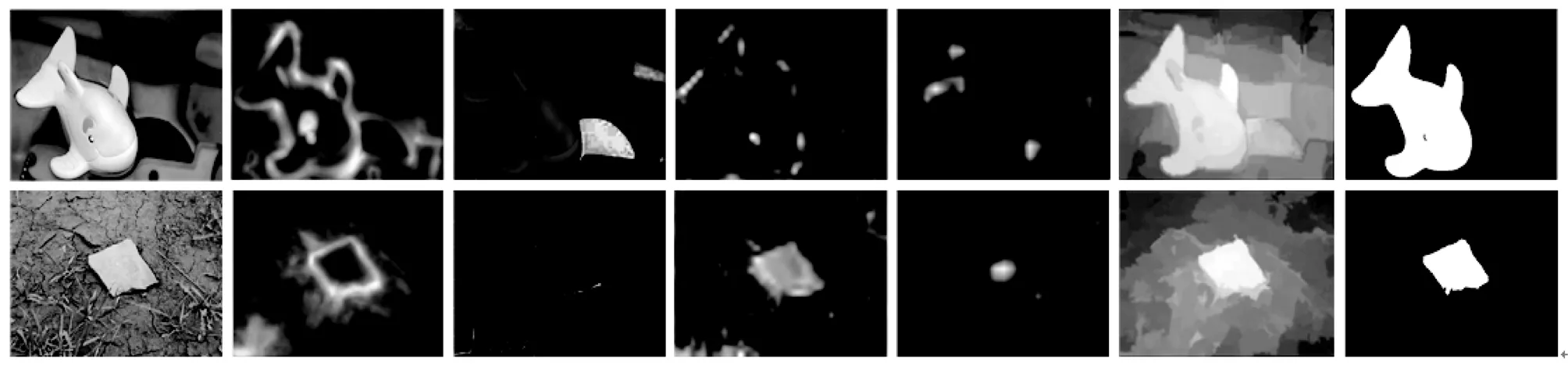

目前顯著性模型主要分為兩類:自頂向下模型[8-9]和自底向上模型[10-14]。自頂向下的顯著性模型一般通過學習得到的高層語義信息(如人臉檢測)來輔助進行顯著性物體檢測。由于這類方法在學習過程中需要耗費大量的計算資源,因此很難應用到光學設備中。而自底向上的顯著性模型主要利用簡單的圖像特征信息(例如亮度、顏色、方向等)來計算前景顯著度。這類方法復雜度較低,更適于移植到光學設備中。Itti等[10]率先進行了相關研究,提出基于中心-四周對比度的顯著性模型。文獻[11-12]基于馬爾可夫隨機理論提出了基于圖模型的顯著性度量算法。還有一些研究人員通過檢測頻域的不規則性來判斷視覺顯著性[1,13-14]。這些方法在圖像顯著性物體檢測問題上獲得了一定成效。然而,自然場景中顯著性區域和背景區域往往都具有很大的差異性,傳統的顯著性模型很難在復雜的自然圖像中獲得較好的檢測效果。圖1對傳統顯著性模型(包括CA[9]、FT[14]、GB[12]、IT[11]、MS[13]模型等)檢測效果進行了對比。可以看出,現有方法都受到了背景雜亂或對象形狀信息丟失的影響,在顯著性物體檢測中存在明顯缺陷:CA模型可以較好地檢測到顯著性區域的邊界,但對于顯著性物體的形狀信息則損失嚴重;FT模型除了檢測到圖像的顯著區域,還將部分復雜背景也誤檢為顯著物體;GB模型和IT模型未能將顯著物體與圖像背景進行準確區分,導致檢測結果出現明顯失真;MS模型在復雜背景下,也將部分背景圖案檢測為顯著性物體,降低了檢測準確性。可見,在較低的計算復雜度下實現圖像顯著性物體的精準提取,具有重要的理論研究價值和應用前景。

圖1 現有顯著性模型缺點圖示說明。 從左到右分別為: 原始圖像,通過CA、FT、GB、IT、 MS和本文模型獲得的顯著圖。

傳統的顯著性模型一般基于一個生物學研究結果,即人類視覺關注力會集中于圖像的中心區域[15]。因此,以往的模型往往通過計算圖像區域中心與四周區域的差異性來進行顯著性物體檢測[10-15]。因此,當實際圖像中顯著性物體偏離圖像中心時,就可能造成與背景圖案的混淆,難以得到理想的檢測結果。與傳統的顯著性檢測模型不同,本文提出了一種基于背景原型對比度的自底向上顯著性模型。這里,“背景原型”指的是通過預分割算法[16]獲得的超像素圖像區域。顯著性建模的另一個重要問題是如何定量測量視覺顯著度。在本文的模型中,由于顯著區域與背景存在較大的外觀差異,因此可以通過計算與背景原型的顏色對比差異判斷顯著區域。圖1同時給出了本文模型獲得的顯著圖結果。如圖1所示,相對傳統顯著性模型的檢測結果,本文提出的模型可以更好地濾除雜亂背景,產生更穩定、準確的顯著圖。此外,該模型計算復雜度低,適合應用于光學器件中。

1 原理與方法

顯著性物體檢測的關鍵問題是如何準確區分背景區域和顯著性目標。傳統的顯著性模型基于區域中心與四周的差異度計算,在顯著性物體偏離中心區域或背景圖案復雜時區分效果不佳,造成檢測精度降低。為了更精確地檢測目標與背景,本文基于背景原型對比度建立顯著性模型:先分析圖像計算產生背景原型,再通過比較原始圖像與背景原型的特征信息比對確定顯著性目標物體。由于鄰近區域的像素存在較大冗余性,基于像素分析背景原型計算量大并且欠缺必要性,因此本文基于超像素進行背景原型圖的分析計算。同時,由于背景原型與顯著目標存在較大顏色差異,選擇顏色作為比對的特征信息。

基于背景原型對比度的顯著性物體檢測方法實施可以分為3個步驟:

1) 圖像分割,通過分割算法被分解成為一些同質的超像素;

2) 選擇背景原型,參考在整幅圖像中的相對位置,遠離圖像中心的區域被選擇為背景原型;

3) 顯著性度量,通過與背景模型的顏色對比來判斷出視覺顯著性區域。

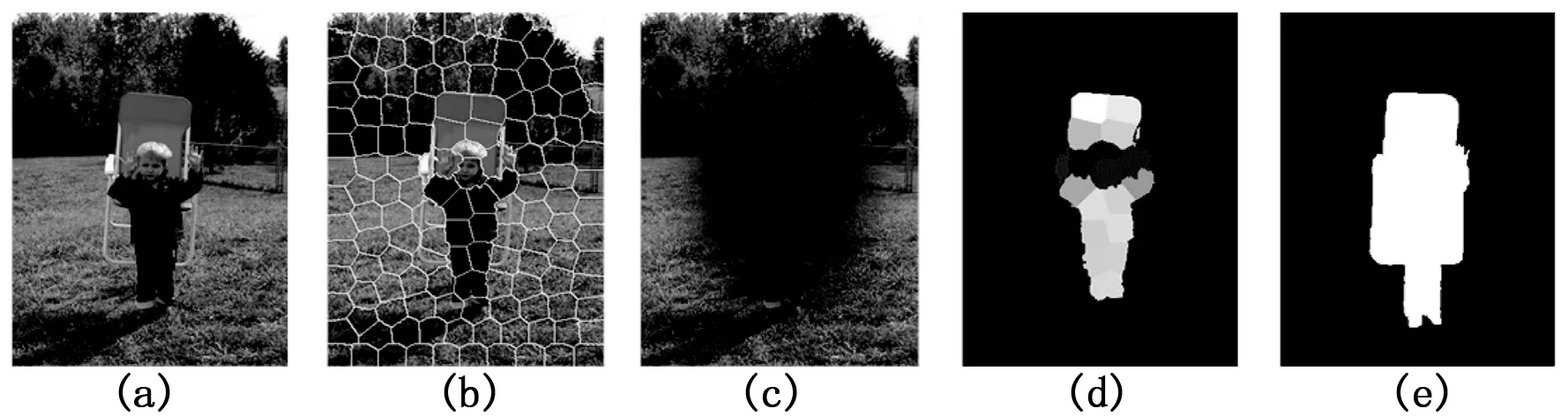

圖2是對本文方法實施過程的例子。首先,對原始圖像(a)進行超像素分割,得到超像素分割圖(b);再計算超像素位置值確定背景原型圖(c);最后,通過與背景模型的顏色對比得到顯著圖(d);(e)為對顯著物體人工標注結果。可以看出,基于背景原型對比度的顯著性物體檢測方法得到的顯著圖與人工標注結果接近度高,效果理想。下面,對顯著性對象檢測模型進行詳細分析說明。

(a)原始圖像; (b)超像素分割圖(超像素以白色邊界線區分); (c)視為背景的圖像邊緣區域; (d)顯著圖; (e) 人工標注結果 圖2 方法過程概述

1.1 圖像分割

基于背景原型對比度的顯著性物體檢測方法第一步是對原始圖像進行超像素分割。超像素分割將圖像分析過程由基于像素轉換為基于區域,可以顯著降低圖像分析復雜度,提升算法速度。本文使用文獻[16]中的方法把輸入圖像分割成超像素。這個分割算法有兩個重要參數,即rgnSize和regularizer,分別表示分割圖像的超像素數和空間規律的平衡表。使用超像素分割技術可以將相似區域融合起來的同時避免破壞目標物體的邊界特性。由于顏色直方圖是一個魯棒的全局外觀特征描述子,因此本文選用顏色直方圖作為超像素的表示特征。為了保證感知精度,直方圖在CIELab顏色空間進行計算。在此基礎上,第i個超像素Ri則可由一個K維顏色直方圖hi來描述,其中第k維分量記作hi(k)。

1.2 選擇背景原型

在超像素分割圖基礎上,選擇準確的背景原型。根據文獻[15],在像素x到圖像中心c的歐式距離d(x,c)基礎上利用逆高斯分布計算生成一個預處理圖(即圖3的中間圖):

p(x)=1-exp{-d(x,c)/σ2}

(1)

(2)

θ一般取經驗值0.8。靠近圖像邊界的區域往往會被優先選擇,這樣處理有利于囊括不同特點的背景區域。

1.3 基于背景原型的顯著性度量

(3)

盡管顯著性區域有時也會具有多樣性(如圖2、圖3、圖4所示),但這些區域的顏色依然和背景原型有著較大區別。此外,背景區域常常與背景原型的有著類似的顏色分布。因此,Ri的顯著圖應為所有背景原型的最小值:

(4)

圖3 背景原型的產生圖示

圖4 本文方法與已有方法的視覺效果對比。 從左到右分別為: 原始圖像、IT、GB、FT、CA、RC、MS、 本文方法和人工標注的顯著圖

2 實驗及性能比較

本節通過對比實驗證明基于背景原型對比度的顯著性物體檢測方法的有效性。為了增強實驗結果的說服力,本節實驗均在文獻[13,17]給出的數據集上進行,同時選擇以下六個具有代表性的顯著性模型作為比較的對象,即視覺關注測量模型(visual attention measure, IT[10])、基于圖的顯著性模型 (graph-based saliency, GB[11])、頻譜調諧顯著性模型(frequency-tuned saliency, FT[13])、上下文感知模型 (context-aware saliency, CA[8])、整體對比顯著性模型 (global-contrast saliency, RC[17])和中層視覺顯著性模型 (midlevel saliency, MS[12])。實驗通過在相同數據集上運行本方法及各對比方法獲得顯著圖,采集數據進行定量性能對比分析及定性效果對比分析。

實驗中本文方法進行超像素分割的參數(rgnSize, regularizer)設為(30,1.0),每個顏色直方圖中的超像素為K = 60維的向量。對于IT[10],GB[11],FT[13]和RC[17]模型,本文通過實現其算法運行獲得最終的顯著性圖,從而得到相關比較數據,對于CA[8]和MS[12]模型,本文直接利用作者公布的顯著性圖做性能比較。

2.1 性能定量分析

實驗對各個顯著性模型復雜度、準確率、返回率和F-measure等性能參數進行測量比較。

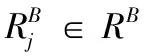

通過對在相同硬件平臺上,對相同圖像的算法運行時間的比較,可以直觀反映出計算復雜度高低。表1是這幾種方法平均運行時間的對比結果。

表1 平均運行時間的對比

通過表1可以看出,FT模型平均運行時間最短,復雜度最低;除了FT模型,本文方法平均運行時間均少于其它方法,說明其為計算復雜度較低的模型之一。結合后面的效果對比實驗結果,本文方法獲取的顯著圖明顯優于FT模型,綜合而言,本文方法具備較低的復雜度,較高的計算效率。

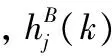

本文采用文獻[13,17]中的方法對以上算法準確率、返回率和F-measure等性能參數進行量化比較,結果如圖5所示。實驗中,歸一化顯著圖分割閾值變化范圍為0~255。圖5(a)為各顯著性模型精度-召回曲線。可以看出,本文提出的模型性能明顯優于其它模型。本文方法中第一步對圖像進行超像素分割是非常關鍵的,而分割參數對于分割結果乃至最終顯著物體檢測結果有較大影響。圖5(b)為采用不同分割參數獲得的結果,表明本文采用的參數設置是性能最佳的。在最佳分割參數下,本文對通過自適應閥值得到的顯著圖進行二元分割[13],然后計算準確率和召回率性能,最后通過公式:

F=((1+β2)×P×R)/(β2×P+R)

(5)

圖5 MSRA 1000數據集的定量比較

計算F-measure,公式中P表示準確率,R表示召回率,β2=0.3[13,17]。各模型方法計算的平均準確率、返回率和F-measure等實驗結果如圖5(c)所示。可以看到,本文提出的方法無論在準確率、返回率還是F-measure,均達到最好的性能。相比于其他方法,本文方法對返回率性能的提升效果最為顯著,這表明本文方法可以準確地檢測出更多的顯著區域。

2.2 效果定性對比

通過對各種方法產生的顯著圖結果進行二元分割后,可以對其視覺效果進行直接對比,判斷方法的準確度。圖5展示了用不同方法獲得的視覺顯著圖,以便進行定性的效果比較。由圖中結果可以看出,本文的模型能夠產生高分辨率的顯著圖,是各個方法中最接近于人工標注顯著圖的。相比之下,其他方法產生的顯著圖均存在明顯不足之處:有的方法提取的顯著對象形狀出現失真,如IT和GB;有的過分強調顯著對象的邊緣輪廓,如CA;有的在不適于從雜亂復雜的背景中難以達到滿意的效果,如FT、RC和MS。

定量性能對比及定性效果對比實驗結果說明基于背景原型對比度的顯著性物體檢測方法在較低的計算復雜度下獲得了高效、準確的顯著圖,具有較強的應用價值。

3 結論

本文在背景原型對比的基礎上提出了一個新的顯著性模型。實驗結果表明,它在準確率、召回率和F-measure等關鍵性能和直觀視覺效果上均優于目前最先進的顯著性模型。此外,本方法計算復雜度低,對硬件資源要求不高,非常適于移植到軟硬件資源有限的光學設備(如數碼相機)上。

[1]Xu Y, Zhao Y, Jin C, et al.Salient target detection based on pseudo-wigner-ville distribution and renyi entropy[J].2010, 35:475-477.

[2]Gao C, Sang N, Huang R.Instance-based attention: where could humans look first when searching for an object instance[J].2012, 37:76-78.

[3]Vazquez E, Gevers T, Lucassen M, et al.Saliency of color image derivatives: a comparison between computational models and human perception[J]. J. Opt. Soc. Am.,2010:613-621.

[4]張永梅,吳 攀,李 煒. 一種圖像敏感對象的識別方法[J]. 計算機測量與控制,2014,22(7):2167-2169.

[5]Ko B, Nam J.Object-of-interest image segmentation based on human attention and semantic region clustering[J]. J. Opt. Soc. Am. ,2006,23:2462-2470 (2006).

[6]Kim W, Kim C.Saliency detection via textural contrast[J]. Opt. Lett. ,2012,37:1550-1552.

[7]Itti L, Gold C, Koch C.Visual attention and target detection in cluttered natural scenes[J]. Opt. Eng. 2001,40:1784-1793.

[8]Goferman S, Zelnik-Manor L, Tal A.Context aware saliency detection[J]. IEEE Trans. Pattern Anal. Machine Intell.,2012,34:1915-1926.

[9]Torralba A.Modeling global scene factors in attention[J].J.Opt.Soc.Am. ,20, 2003,20:1407-1418.

[10]Itti L, Koch C, Niebur E.A model of saliency- based visual attention for rapid scene analysis[J]. IEEE Trans. Pattern Anal. Machine Intell.,1998,20: 1254-1259.

[11] Harel, J,Koch C, Perona P.Graph-based visual saliency[D]. Proceedings of the Advances in Neural Information Processing Systems, MIT, 2006.

[12]Yu J, Tian J. Saliency detection using midlevel visual cues[J]. Opt.lett.,2012,37: 4994-4996.

[13]Achanta R, Hemami S, Estrada F, et al.Frequency-tuned salient region detection[A].Proceedings of the IEEE conference on Computer Vision and Pattern Recognition[C]. IEEE, 2009:1597-1604.

[14]Li C, Xue J, Tian Z, et al.Saliency detection based on biological plausibility of hyper- complex fourier spectrum contrast[J]. Opt. lett.,2012,37:3609-3611.

[15]Tatler B.The central fixation bias in scene viewing: Selecting an optimal viewing position independently of motor biases and image feature distributions[J]. J. of Vis.,2007, 7:1-17.

[16]Achanta R, Shaji A, Smith K,et al.Slic superpixels[R]. EPEL, Tech. Rep, 149300,2010.

[17]Cheng M, Zhang G, Mitra N,et al.Global contrast based salient region detection[A]. Proceedings of the IEEE conference on Computer Vision and Pattern Recognition[C].IEEE, 2011: 409- 416.

SaliencyDetectionviaBackgroundPrototypesContrast

Luo Chenhui1,Zhang Wei1,Shen Qiongxia2,Ye Bo1

(1.School of Computer Science and Information Engineering, Hubei University, Wuhan 430062, China;2.Service and CPE Business Unit, Fiberhome Telecommunication Technologies Co.Ltd., Wuhan 430073, China)

To overcome the disadvantages of existing saliency models in saliency detection, a novel object-based attention model is presented to predict visual saliency using the contrast against the background prototypes. Traditional saliency models mainly detect salient regions by comparing the differences between center and surround regions, which makes hard to get desired results in complex scenes for significant differences often appear both in salient and background regions in real images. Saliency detection via background prototypes contrast firstly over-segment the input image into perceptually homogeneous superpixels, and automatically identifies a series of regions far away from image center as background prototypes. The visual saliency is then accurately calculated using the color contrast with respect to the selected background prototypes. Promising experimental results demonstrate that the proposed model, which outperforms the compared state-of-the-art saliency models in average precision, recall, F-measure and visual effect, can better exclude the cluttered backgrounds, and thus produces more robust and accurate saliency maps. Moreover, due to its computational efficiency, our model is easy to be widely applied.

visual attention; background prototype; visual saliency

2017-06-19;

2017-07-07。

國家自然科學基金(61301144,61601175)。

羅辰輝(1991-),男,湖北黃岡人,研究生,主要從事圖像處理、物聯網、無線通信方向的研究。

張 偉(1979-),男,湖北武漢人,博士,講師,碩士研究生導師,主要從事圖像處理、無線通信方向的研究。

1671-4598(2017)10-0259-04

10.16526/j.cnki.11-4762/tp.2017.10.066

:TP391.413

A