融合前景判別和圓形搜索的目標跟蹤算法

林玲鵬,黃添強,林 晶

(1.福建師范大學 軟件學院,福州 350007; 2.福建省公共服務大數據挖掘與應用工程技術研究中心,福州 350007;3.福建師范大學 數學與計算機科學學院,福州 350007)

融合前景判別和圓形搜索的目標跟蹤算法

林玲鵬1,2,黃添強1,2*,林 晶3

(1.福建師范大學 軟件學院,福州 350007; 2.福建省公共服務大數據挖掘與應用工程技術研究中心,福州 350007;3.福建師范大學 數學與計算機科學學院,福州 350007)

針對運動目標在發生遮擋、形變、旋轉和光照等變化時會導致跟蹤誤差大甚至丟失目標以及傳統跟蹤算法實時性差的問題,提出了一種融合前景判別和圓形搜索(CS)的目標跟蹤算法。該算法采用了圖像感知哈希技術來描述與匹配跟蹤目標,跟蹤過程使用了兩種跟蹤策略相結合的方法,能夠有效地解決上述問題。首先,根據目標運動方向的不確定性和幀間目標運動的緩慢性,通過CS算法搜索當前幀局部(目標周圍)最佳匹配位置;然后,采用前景判別PBAS算法搜索當前幀全局最優目標前景;最終,選取兩者與目標模板相似度更高者為跟蹤結果,并根據匹配閾值判斷是否更新目標模板。實驗結果表明,所提算法在精度、準確率和實時性上都比MeanShift算法更好,在目標非快速運動時有較好的跟蹤優勢。

目標跟蹤;圓形搜索算法;前景判別;感知哈希;跟蹤策略

0 引言

視頻目標跟蹤[1]是計算機視覺領域研究的核心內容之一,同時也是圖像處理的主要分支之一。在對運動目標進行檢測和跟蹤過程中,應用了多個研究領域的內容,比如圖像處理、模式識別、人工智能和機器學習等。視頻目標跟蹤在智能視頻監控、人機交互、機器人視覺導航、虛擬現實、醫學圖像分析和視頻壓縮等領域中有很大的理論意義和應用價值[2]。

簡而言之,視頻目標跟蹤是一個只知道目標的初始位置去估計它在一個圖像序列中軌跡的問題。對目標的跟蹤方法則成為各種跟蹤算法中的重要組成部分。由于有限的目標先驗知識,解決這個問題是特別具有挑戰性的;而且,跟蹤算法必須是靈活的,以應對快速的目標外觀的變化,同時對發生遮擋和背景干擾應該是魯棒的。

在最近幾年,學者們運用tracking-by-detection的方法[3-6],使上述問題得到了一定的解決。在這類算法中,跟蹤方法采用機器學習技術來訓練目標樣本的外觀模型和背景模型。比如,監督學習方法中的支持向量機(Support Vector Machine, SVM)[7]和嶺回歸[8]方法通常構建一個有區分能力的分類器或回歸量。在常用的目標跟蹤算法中,基于均值漂移的MeanShift目標跟蹤算法[9-10]通過顏色直方圖分別描述目標模型和候選模型,然后利用Bhattacharyya相似函數度量候選模板的相似性,選擇使相似函數最大的候選模型并通過不斷迭代計算MeanShift向量,實現對目標的跟蹤。該算法實時性較好,并在目標發生形變、旋轉時仍能有效跟蹤目標,受到廣泛的應用[11]。

同時,此類跟蹤模型的質量很大程度上依賴于它的訓練集[12]。當訓練集不能正確表達目標時,標準的tracking-by-detection跟蹤算法的結果會受到很大的影響。這些不正確的訓練樣本通常是因為目標發生了形變、旋轉、遮擋和尺度變換,跟蹤的不準確也會帶來不正確的訓練樣本,從而導致分類器的退化。當訓練集出錯時,跟蹤模型會出現目標漂移,最終導致目標跟蹤失敗。

因此,一個正確的訓練集對此類算法至關重要,可避免發生目標漂移和跟蹤失敗。為了避免此類瓶頸的出現,本文算法在tracking-by-detection的基礎上,采用了匹配跟蹤和搜索跟蹤,通過兩種跟蹤策略的結合,一定程度上防止了在跟蹤過程中訓練集出錯,從而防止了在跟蹤過程中出現目標漂移,提高了算法的準確性和魯棒性。

本文提出了一種融合前景判別和圓形搜索(Foreground Discrimination and Circle Search, FDCS)的目標跟蹤算法,該算法利用本文提出的圓形搜索(Circle Search, CS)算法對目標進行搜索跟蹤,同時結合PBAS(Pixel-Based Adaptive Segmenter)前景判別算法進行匹配跟蹤。其中,CS算法在應對目標移動時具有良好的跟蹤效率; PBAS在跟蹤過程中應對目標發生形變、部分遮擋、尺度變化和外部光照變化有較好的魯棒性。

1 系統概述

本文在融合前景判別和CS的跟蹤算法框架下,使用了圖像感知哈希特征描述子,所提出的FDCS跟蹤算法框架如圖1所示。其中,為了能夠準確提取目標圖像摘要,所采取的圖像感知哈希算法使用了離散余弦變換(Discrete Cosine Transform, DCT)[13]提取圖像的低頻信息來近似表示圖像。DCT對圖像的處理效果如圖2所示,DCT會將圖片的低頻信息集中在左上角,低頻信息所對應的DCT系數會相對較大,而靠近右下角的高頻信息對應的DCT系數較小。同時,FDCS采用搜索跟蹤策略和匹配跟蹤策略對視頻運動目標進行跟蹤,兩種跟蹤策略如下所述。

圖1 算法框架Fig. 1 Algorithm framework

搜索跟蹤策略 采用本文提出的CS算法,其思想是根據目標運動方向的不確定性和幀間目標運動的緩慢性,對跟蹤目標周邊區域(以目標為中心、半徑為2的圓)的13個跟蹤點進行判斷搜索。

匹配跟蹤策略 使用的是PBAS前景檢測算法,它引入了控制論的思想和背景復雜程度的度量方法,使得前景判斷閾值和背景模型更新率可以根據背景復雜程度自適應調整,保證了前景提取的正確率和魯棒性。

圖2 DCT結果Fig. 2 Results of DCT

2 圖像感知哈希技術

本文算法使用了圖像感知哈希(Image Perceptual Hashing)技術來描述圖像特征,由于哈希的二值特性使得算法在特征描述與匹配的效率上得到了提高。

2.1 圖像感知哈希性質

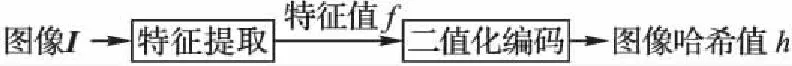

圖像感知哈希又稱為圖像指紋(Image Fingerprinting),是近幾年新發展的一個圖像特征描述算子[14]。它用一個二進制比特串來近似表示圖像,通過對圖像數據的二值化提高了匹配算法的效率,增強了實用性。圖像感知哈希技術的總體框架如圖3所示。

圖3 圖像哈希基本框架

Fig. 3 Basic framework of image Hash

圖像感知哈希技術要求所使用的哈希算法應當滿足以下4個性質:

1)摘要性(Compactness)。經過哈希算法生成的Hash值應遠小于原圖像的大小。

2)唯一性(Uniqueness)。一幅圖像經過同一哈希算法生成的Hash值是相同的。

3)差異性(Otherness)。差異明顯的圖像經過同一哈希算法生成的Hash值是不相近的。

4)魯棒性(Robustness)。相似的圖像經過同一哈希算法生成的Hash值是相同或相近的。

2.2 哈希特征值的生成

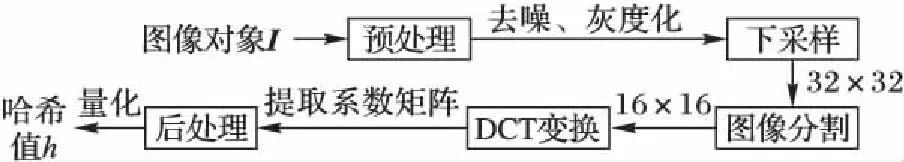

目前,比較流行的對圖像構造Hash值的算法有均值哈希算法、感知哈希算法和差異哈希算法。由于均值哈希不能很好地以人類的視覺角度表達圖像信息,更適合搜索縮略圖;差異哈希側重于局部差異,忽略了圖像總體信息;為了模擬人類視覺對低頻信息比較敏感的特點,并獲得更精確的結果,本文選擇感知哈希算法,它采用DCT算法,通過提取的DCT低頻系數近似表示圖像信息的方法,量化此低頻信息生成圖像感知Hash值。本文構造圖像感知Hash值的流程如圖4所示。

圖4 圖像哈希生成流程Fig. 4 Flow chart of image Hash generation

本文圖像感知Hash值生成定義為如下單向函數[15]:

h=PHGen(I)

(1)

其中:h表示由圖像I生成的感知摘要,PHGen代表感知哈希的生成算法,PHGen的主要步驟如下:

1)去噪。將圖像進行灰度處理,轉化為256階的灰度圖,并采用中值濾波法去除圖像噪聲。

2)采樣。通過采樣處理,將圖像分辨率置為32×32,有利于DCT的計算。

3)分塊。將得到的32×32圖片分成4個16×16小塊。

4)提取DCT系數。計算4個小塊經過DCT得到的DCT系數,分別選擇各個系數矩陣的左上角4×4的低頻系數,組成8×8的矩陣。

5)量化。計算8×8系數矩陣的均值,將大于或等于均值的矩陣元素置為1,否則置為0,得到量化后的8×8二維二進制矩陣。

6)生成Hash值。逐行讀取8×8二維矩陣,得到長度為64的哈希二進制比特串。

2.3 哈希特征值的匹配

基于圖像感知哈希算法的匹配,是通過其感知摘要的距離大小來表達兩幅圖像的相似程度。圖像間的感知距離是通過Hash值的匹配算法完成的,用式(2)[15]來表示:

pd=PHMatch(hi,hj)

(2)

在本文中,PHMatch表示所使用的感知哈希匹配算法,輸入參數hi和hj是兩幅圖像通過PHGen(感知哈希生成算法)生成的二進制感知摘要,輸出參數pd表示兩幅圖像的感知距離,pd越大表示兩幅圖像越不相似,pd越小表示其相似度越高。因輸入的Hash值為二進制數,所以本文使用漢明距離(Hamming Distance)[16]計算Hash值的差異性,即兩個二進制數對應位置的不同字符的個數,如式(3)所示,dis表示兩個哈希字符串hi和hj的漢明距離。dis越小,hi和hj的差異性越小,即相似度越高。

dis=HamDis(hi,hj)

(3)

3 FDCS跟蹤算法

為了清晰描述FDCS算法及其跟蹤步驟,將其中涉及到的一些新概念和相關定義給出如下。

3.1 CS算法

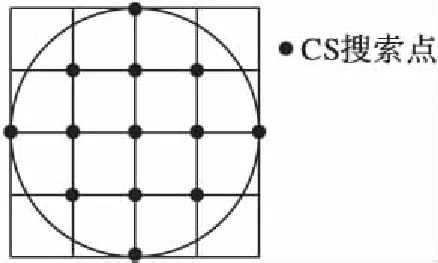

在實際生活中,運動目標在視頻相鄰兩幀中的移動是緩慢的,根據FS(Full Search)算法(全局搜索算法)實驗數據表明,50%~90%的運動目標在原目標中心旁的2個像素點移動。由于拍攝角度的不確定性和運動目標方向的不規則性,運動目標可能在原中心位置360°范圍進行移動。所以,如圖5所示,在以原目標中心為圓心、半徑為2的圓中的13個像素點,認為是具有最高匹配概率的搜索點。基于上述理論,本文提出了一種新的運動估計方法——圓形搜索(CS)算法。以下將先介紹算法中搜索點的分類,并描述算法的基本思想,再通過算法步驟具體介紹所提出的圓形搜索算法。

3.1.1 搜索點分類

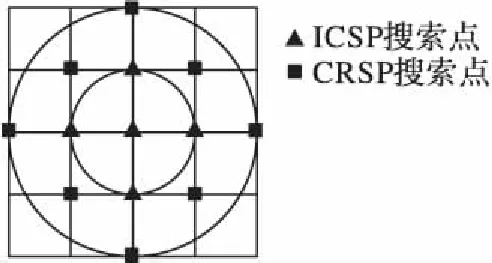

CS算法對13個搜索點進行歸類:圓環搜索點(Circle Ring Search Point, CRSP)和內圓搜索點(Inner Circle Search Point, ICSP),如圖6所示。在目標跟蹤算法中,搜索點表示與當前目標模板同大的矩形框的中心;同時,它們具備以下兩個性質:

性質1 CRSP的四連通區域上的搜索點不全在大圓內。

性質2 ICSP的四連通區域上的搜索點全在大圓內。

圖5 圓形搜索13個搜索點Fig. 5 13 search points of circle search

圖6 CRSP和ICSP搜索點Fig. 6 Search points of CRSP and ICSP

3.1.2 算法基本思想

根據目標運動的緩慢性,CS算法先以上次目標中心為圓心、兩個像素點為半徑作圓,計算以圓內13個搜索點為中心的目標矩形框與目標模板的相似度,得到最大相似度搜索點(Max Similar Point, MSP)。若得到的MSP屬于ICSP,則停止搜索,因為ICSP的四連通區域全部在圓內,則認為此時得到的MSP可靠性較強,達到局部最優,可作為此次的搜索結果;若得到的MSP屬于CRSP,則將此MSP作為新的圓心,循環CS,直到得到的MSP屬于ICSP為止。

3.1.3 算法步驟

步驟1 以上一次目標中心為圓心、半徑為2作圓,分別計算圓內13個搜索點代表的矩形框與目標模板的相似度,若MSP屬于ICSP,則進行步驟3;若MSP屬于CRSP,進行步驟2。

步驟2 以當前找到的MSP所在位置作為新的圓心,得到新的搜索區域的13個搜索點,分別計算它們與目標模板的相似度,若MSP屬于ICSP,則進行步驟3;若MSP屬于CRSP,重復步驟2。

步驟3 以找到的MSP所在位置作為此次跟蹤結果,即MSP所在位置為當前目標中心。

3.2 PBAS前景判別算法

PBAS前景檢測算法是基于像素的無參數模型[17],該算法結合了經典的SACON(SAmple CONsensus)[18]和ViBE(Visual Background Extractor)[19]兩個算法在計算速度和判斷結果上的優勢,并在這兩個算法的基礎上改進而來。其基本框架如圖7所示。

圖7中,R(xi)為自適應的閾值,T(xi)為自適應的更新率,dmin(xi)為背景復雜度的度量。

主要步驟如下:

1)建立背景模型。

PBAS算法采用類似SACON算法背景建模方法,收集前N幀像素以及梯度幅值作為背景模型,構建方法如下:

B(xi)={B1(xi),B2(xi),…,Bk(xi),…,BN(xi)}

(4)

其中:B(xi)表示像素點xi的背景模型,是由像素點xi的一系列過去被觀察的背景像素值所構成;Bk(xi)表示像素點xi的背景模型中的第k個像素值。

2)前景檢測。

PBAS前景檢測過程與ViBE算法類似,計算樣本集合中滿足匹配條件的樣本個數,若小于閾值Tmin,則認為是前景,不同之處在于不同像素的判斷閾值R(xi)不同;

(5)

式(5)中:F(xi)存儲像素點xi的判斷結果,1表示為前景,0表示為背景;R(xi)為距離閾值,該參數取決于像素位置并可以動態變化;閾值Tmin是一個固定的全局參數。

圖7 PBAS基本框架[17]Fig. 7 Basic framework of PBAS[17]

3)背景模型的更新。

由于被判定為前景的區域是不會被用來進行更新的,因此,只有像素被判為背景點F(xi)=0,才能進行背景模板更新。其更新過程與ViBE算法類似,被判斷為背景的像素只有p=1/T(xi)的概率來進行更新,同樣,也有p=1/T(xi)的概率去隨機選擇目標像素的相鄰像素yi∈N(xi)來進行更新。不同之處在于更新率不同,ViBE是固定的更新率,而PBAS的更新率是自適應的,并且更新使用的像素值是鄰域樣本集合中yi的新像素值,而不是用xi本身的新像素值。

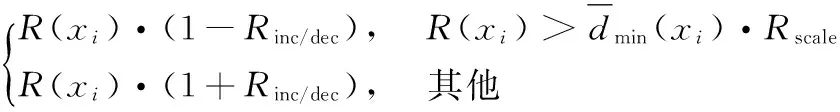

4)判決閾值R(xi)的更新。

R(xi)=

(6)

式(6)中:Rinc/dec是閾值的變化量,Rscale用于控制背景復雜度對判斷閾值的調整。

5)學習參數T(xi)的更新。

當視頻幀中的背景越復雜,其出現判斷錯誤的概率越大,對應的背景更新的頻率應該越低,為了減少判斷錯誤對背景模型的影響,學習參數T(xi)的更新策略如下:

(7)

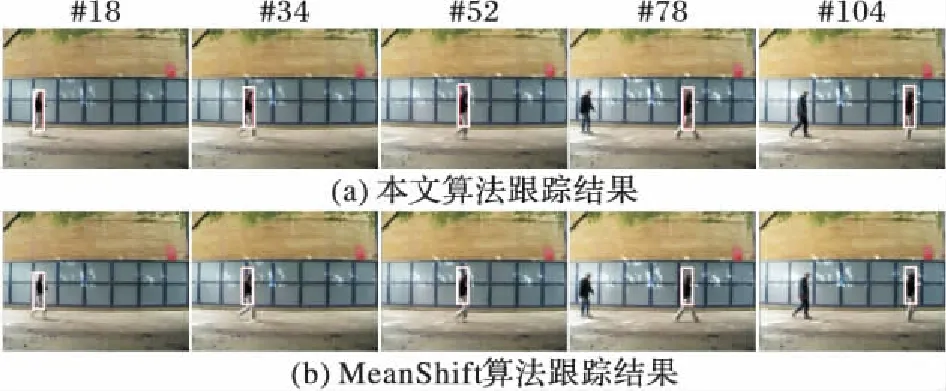

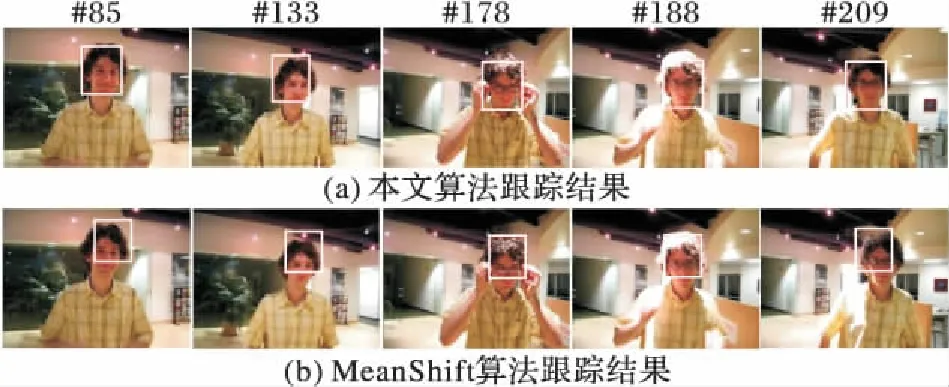

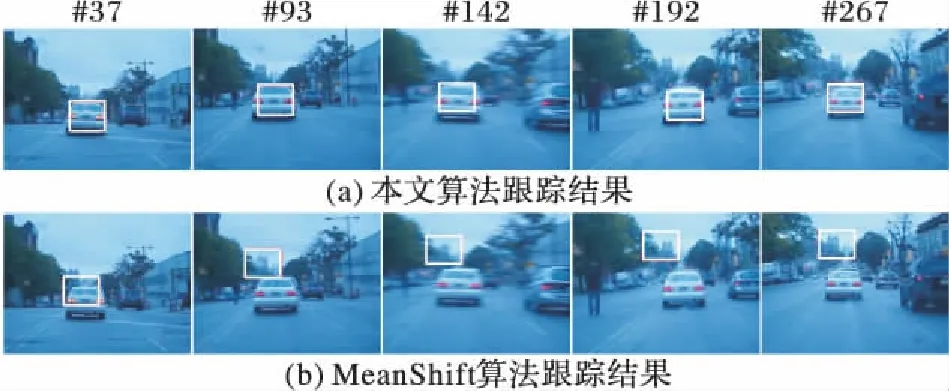

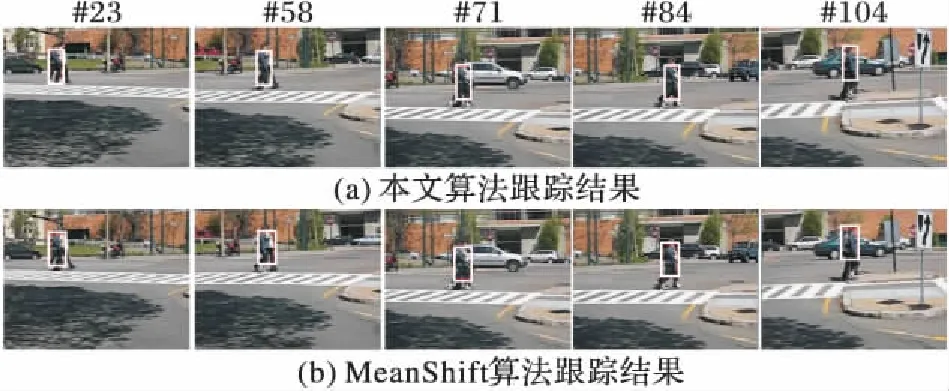

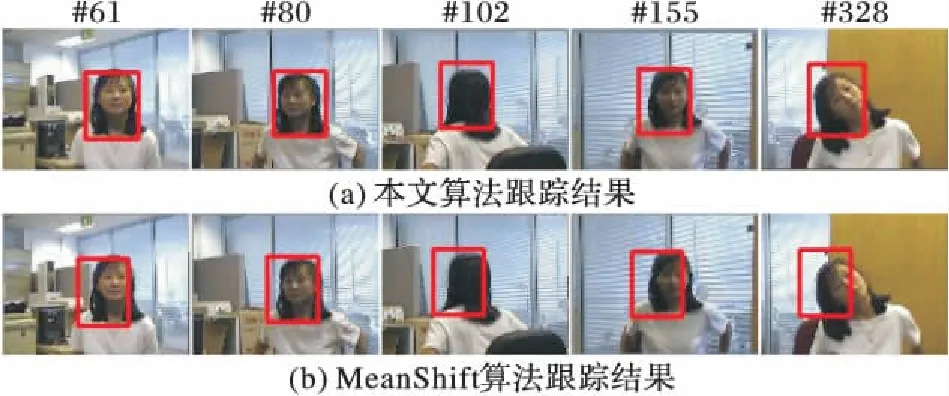

式(7)中:F(xi)表示前景檢測結果,Tinc和Tdec分別表示更新率增加、減小的幅度。此外,本文還為學習參數T(xi)定義了上限和下限Tlower 根據以上敘述,下面給出FDCS跟蹤算法的流程思想:首先,本文算法根據用戶手動劃定的跟蹤目標區域建立目標模板的哈希特征描述算子;其次,使用CS算法作為搜索跟蹤算法,得到當前幀目標的搜索跟蹤結果,并計算跟蹤得到的目標Hash值與目標模板Hash值的相似度;再次,使用前景判別PBAS算法作為匹配跟蹤算法,獲取當前幀目標的匹配跟蹤結果,并計算跟蹤得到的目標Hash值與目標模板Hash值的相似度;然后,將匹配跟蹤結果和搜索跟蹤結果進行比較,取其與目標模板相似度更高者為當前幀目標位置;最后,計算包含匹配跟蹤與搜索跟蹤結果最小矩形框的重疊率,并結合跟蹤得到的目標與目標模板的相似度,根據閾值判斷條件更新目標模板。下面給出在線目標跟蹤算法: 1)讀入視頻幀序列,在初始幀手動選擇目標跟蹤區域robj(x0,y0,w0,h0),令frame=1。 2)在新的一幀中,以上次目標中心(xi,yi)為起點,進行如下循環: ①以(xi,yi)為圓心、半徑為2作圓,分別計算以圓內13個搜索點為中心的目標的Hash值,并使用漢明距離計算其與目標模板的哈希距離search1,search2, …,search13; ②若min(search1,search2, …,search13)對應的搜索點屬于ICSP,則將此搜索點作為當前幀搜索跟蹤得到的目標的中心,break; ③若min(search1,search2, …,search13)對應的搜索點屬于CRSP,則將此搜索點作為新圓形搜索的圓心,返回①。 3)對當前幀使用PBAS前景提取算法,得到包含前景的最小矩形框的集合fg1,fg2,…,fgk,計算這k個前景的Hash值,并使用漢明距離計算其與目標模板的哈希距離match1,match2,…,matchk,取min(match1,match2,…,matchk)對應的前景為當前幀匹配跟蹤得到的結果。 4)若min(search1,search2, …,search13) ≤min(match1,match2, …,matchk),則將搜索跟蹤得到的結果作為當前幀的跟蹤結果; 否則將匹配跟蹤得到的結果作為當前幀的跟蹤結果。 5)計算跟蹤結果與目標模板的匹配相似度σframe,這里使用漢明距離表示相似度,漢明距離越小,即圖像的相似度越高。 6)根據式(8)計算當前幀搜索跟蹤結果Rsearch與匹配跟蹤結果Rmatch的重疊率: (8) 7)若(δ>Tδ)∩(σframe 8)frame++,若frame≤N(N為總幀數),返回2);否則跟蹤結束。 為了驗證新算法的效果,本文使用了標準攝像機拍攝的Walker視頻和目標跟蹤視頻庫Visual Tracker Benchmark[20]中的4個具有代表性的測試視頻序列進行實驗,并與MeanShift 算法在運行精度、準確率和實時性等3個方面進行了比較。同時,由于兩個算法對目標跟蹤過程中都存在隨機的因素,為了提高實驗數據的準確性,在提取每組實驗數據時分別對兩個算法進行了5次實驗,取5次實驗結果的平均值作為該組最終的實驗數據結果。本實驗的計算機配置為: Intel Core i5- 4590 3.30 GHz處理器,8 GB內存,實驗平臺為Visual Studio 2012。 表1分別列出了兩個算法在精度、準確率和實時性的對比結果。兩個算法精度的對比,即對比兩個算法實驗結果中跟蹤得到的目標位置與實際目標位置的誤差,誤差單位為像素點(pixel),計算所有幀的跟蹤誤差,取其平均值作為最終的精度對比結果;當該幀目標的跟蹤位置與實際位置的跟蹤誤差超過20像素,則認為該幀跟蹤錯誤,計算每個視頻幀序列中非跟蹤錯誤的幀數占總幀數的比例,作為兩個算法準確率的對比結果;兩個算法的實時性對比用每幀所需的處理時間(單位s·frame-1) 來表示。 表1 兩個算法實驗結果對比Tab. 1 Experimental results comparison of two algorithms David視頻(320×240)目標在移動的過程中,發生了明顯的形變和光照變化。從圖8(a)中可以看出本文跟蹤算法表現出色,跟蹤誤差較小,在目標受到干擾(如178幀左右目標戴眼鏡動作)時能夠保持持續跟蹤,在目標光照強度變化之下(188幀左右)也能保持穩定的跟蹤;而MeanShift跟蹤算法在跟蹤過程中發生了明顯的偏移,跟蹤效果較差,如圖8(b)所示。 圖8 兩個算法跟蹤David的部分結果Fig. 8 Partial results of tracking David by two algorithms 在BlurCar2視頻(640×480)中,由于是在行車過程中拍攝,視頻中的目標不間斷地發生劇烈抖動(如142幀所示),抖動造成了視頻幀模糊,使得算法容易跟丟目標。如圖9(a)所示,可見本文算法在目標發生抖動的過程中仍能跟蹤目標;而MeanShift跟蹤結果發生嚴重偏移,導致跟蹤失敗,如 圖9(b)所示。 圖9 兩個算法跟蹤BlurCar2的部分結果Fig. 9 Partial results of tracking BlurCar2 by two algorithms 在Couple視頻(320×240中,目標的背景比較復雜,移動的過程中有車輛駛過目標,同時目標在移動的過程中發生了形變和尺度變化,兩個跟蹤算法均能跟蹤到目標,但本文算法跟蹤結果偏移量更小,如圖10所示。 圖10 兩個算法跟蹤Couple的部分結果Fig. 10 Partial results of tracking Couple by two algorithm Girl視頻(128 Pixel×96 Pixel)中,視頻的分辨率較低,且目標在移動的過程中發生了旋轉、遮擋和尺度變化等,對目標的跟蹤產生較大的影響。如圖11(a)所示,本文跟蹤結果較為穩定,只發生輕微偏移;但MeanShift算法在跟蹤過程中發生了較明顯的偏移,如圖11(b)所示。 圖11 兩個算法跟蹤Girl的部分結果Fig. 11 Partial results of tracking Girl by two algorithms 為了對比兩種算法的實際跟蹤效果,不僅使用了上述4個目標跟蹤視頻庫中的測試視頻,還使用了標準攝像機拍攝的視頻進行實驗。如圖12中的Walker(320×240)視頻中,目標與背景較為相近,且目標的尺度較小,不利于對目標進行特征描述,并在行走的過程中目標發生了形變,在視頻后半部分出現了類似的行人,容易導致目標跟蹤錯誤。通過實驗表明,本文算法仍能準確跟蹤目標,而MeanShift算法發生了輕微偏移,跟蹤結果如圖12所示。 為了能在目標在發生遮擋、形變、旋轉和光照等變化時仍能保持準確的跟蹤,本文提出了一種融合前景判別和CS的目標跟蹤算法。該算法通過搜索策略與跟蹤策略的結合,并利用圖像感知哈希技術表達目標,使其能夠有效解決以上問題。其中,圖像感知哈希技術的引入使算法具有了較好的實時性,前景判別PBAS算法通過全局搜索提高了跟蹤的魯棒性,CS算法能夠快速地定位到局部最優,并有效進行實時跟蹤。實驗結果表明,本文算法在應對目標發生遮擋、形變、旋轉和光照等變化下仍能保持準確跟蹤,且在精度、準確率和實時性上都優于MeanShift算法。但當目標在動態的背景下發生快速移動時,會丟失目標。在未來的工作中,將針對快速移動的目標跟蹤作進一步的研究。 圖12 兩個算法跟蹤Walker的部分結果Fig. 12 Partial results of tracking Walker by two algorithms References) [1] 陳晨樹,張駿,謝昭,等. 隨機場中運動一致性的多線索目標跟蹤[J]. 中國圖象圖形學報, 2015, 20(1): 59-71.(CHEN C S, ZHANG J, XIE Z, et al. Multi-cues object tracking based on motion consistence in random field[J]. Journal of Image & Graphics, 2015, 20(1): 59-71.) [2] YILMAZ A, JAVED O, SHAH M. Object tracking: a survey[J]. ACM Computing Surveys, 2006, 38(4):81-93. [3] HARE S, SAFFARI A, TORR P H S. Struck: structured output tracking with kernels[C]// Proceedings of the 2011 International Conference on Computer Vision. Washington, DC: IEEE Computer Society, 2011:263-270. [4] DANELLJAN M, HAGER G, KHAN F S, et al. Accurate scale estimation for robust visual tracking[EB/OL].[2016- 11- 20]. http://www.diva-portal.org/smash/get/diva2:785778/FULLTEXT01.pdf. [5] HENRIQUES J F, RUI C, MARTINS P, et al. High-speed tracking with kernelized correlation filters[J]. IEEE Transactions on Pattern Analysis & Machine Intelligence, 2015, 37(3):583-596. [6] ZHANG J, MA S, SCLAROFF S. MEEM: robust tracking via multiple experts using entropy minimization[C]// Proceedings of the 13th European Conference on Computer Vision. Berlin: Springer, 2014:188-203. [7] TIAN M, ZHANG W, LIU F. On-line ensemble SVM for robust object tracking[C]// Proceedings of the 8th Asian Conference on Computer Vision. Berlin: Springer-Verlag, 2007:355-364. [8] RIFKIN R, YEO G, POGGIO T. Regularized least-squares classification[EB/OL].[2016- 11- 20].http://yeolab.github.io/papers/2003/10.1.1.7.3463.pdf. [9] COMANICIU D, RAMESH V, MEER P. Real-time tracking of non-rigid objects using mean shift[C]// Proceedings of the 2010 IEEE Conference on Computer Vision and Pattern Recognition. Piscataway, NJ: IEEE, 2000: 2142. [10] COMANICIU D, RAMESH V, MEER P. Kernel-based object tracking[J]. IEEE Transactions on Pattern Analysis & Machine Intelligence, 2003, 25(5):564-575. [11] 白蕾. 基于meanshift的目標跟蹤系統設計與實現[J]. 電子測量技術, 2016, 39(4):1-3.(BAI L. Design and realization of the tracking system based on meanshift algorithm[J]. Electronic Measurement Technology, 2016, 39(4):1-3.) [12] DANELLJAN M, HAGER G, KHAN F S, et al. Adaptive decontamination of the training set: a unified formulation for discriminative visual tracking[C]// Proceedings of the 2016 IEEE Conference on Computer Vision and Pattern Recognition. Washington, DC: IEEE Computer Society, 2016:1430-1438. [13] AHMED N, NATARAJAN T, RAO K R. Discrete cosine transform[J]. IEEE Transactions on Computers, 1974, c-23(1):90-93. [14] 劉兆慶. 圖像感知哈希若干關鍵技術研究[D]. 哈爾濱: 哈爾濱工業大學, 2013.(LIU Z Q. Research on key techniques of image[D]. Harbin: Harbin Institute of Technology, 2013.) [15] 牛夏牧, 焦玉華. 感知哈希綜述[J]. 電子學報, 2008, 36(7):1405-1411. (NIU X M, JIAO Y H. An overview of perceptual hashing[J]. Acta Electronica Sinica, 2008, 36(7):1405-1411.) [16] 朱雪龍.應用信息論基礎[M]. 北京: 清華大學出版社, 2001: 173-183. (ZHU X L. Fundamentals of Applied Information Theory[M]. Beijing: Tsinghua University Press, 2001: 173-183.) [17] HOFMANN M, TIEFENBACHER P, RIGOLL G. Background segmentation with feedback: the pixel-based adaptive segmenter[C]// Proceedings of the 2012 IEEE Computer Society Conference on Computer Vision and Pattern Recognition Workshops. Piscataway, NJ: IEEE, 2012: 38-43. [18] WANG H, SUTER D. Background subtraction based on a robust consensus method[C]// Proceedings of the 18th International Conference on Pattern Recognition. Washington, DC: IEEE Computer Society, 2006:223-226. [19] BAMICH O, VAN DROOGENBROECK M. ViBE: a powerful random technique to estimate the background in video sequences[C]// Proceedings of the 2009 IEEE International Conference on Acoustics, Speech and Signal Processing. Washington, DC: IEEE Computer Society, 2009:945-948. [20] WU Y, LIM J, YANG M H. Online object tracking: a benchmark[C]// Proceedings of the 2013 IEEE Conference on Computer Vision and Pattern Recognition. Washington, DC: IEEE Computer Society, 2013:2411-2418. This work is partially supported by the National Natural Science Foundation of China (61070062, 61502103), the Industry-University Cooperation Major Project in Fujian Province (2015H6007), the Program for New Century Excellent Talents in Universities of Fujian Province (JAI1038), the K-Class Foundation Project of Science and Technology Department of Fujian Province (2011007), the A-Class Foundation Project of Education Department of Fujian Province (JA10064), the Science and Technology Program of Fuzhou (2014-G- 76). LINLingpeng, born in 1993, M. S. candidate. His research interests include machine learning, video target tracking. HUANGTianqiang, born in 1971, Ph. D., professor. His research interests include machine learning, data mining, multimedia tampering detection. LINJing, born in 1992, M. S. candidate. Her research interests include data mining, video tampering detection. Objecttrackingbasedonforegrounddiscriminationandcirclesearch LIN Lingpeng1,2, HUANG Tianqiang1,2*, LIN Jing3 (1.FacultyofSoftware,FujianNormalUniversity,FuzhouFujian350007,China;2.FujianEngineeringResearchCenterofPublicServiceBigDataMiningandApplication,FuzhouFujian350007,China;3.SchoolofMathematicsandComputerScience,FujianNormalUniversity,FuzhouFujian350007,China) Aiming at the problems of low accuracy and even object lost in moving object tracking under occlusion, deformation, rotation, and illumination changes and poor real-time performance of the traditional tracking algorithm, a target tracking algorithm based on foreground discrimination and Circle Search (CS) was proposed. The image perceptual hashing technique was used to describe and match tracked object, and the tracking process was based on the combination of the above was tracking strategies, which could effectively solve the above problems. Firstly, because the direction of motion uncertain and the inter-frame motion was slow, CS algorithm was used to search the local best matching position (around the tracked object) in the current frame. Then, the foreground discrimination PBAS (Pixel-Based Adaptive Segmenter) algorithm was adopted to search for the global optimal object foreground in the current frame. Finally, the one with higher similarity with the object template was selected as the tracking result, and whether to update the target template was determined according to the matching threshold. The experimental results show that the proposed algorithm is better than the MeanShift algorithm in precision, accuracy, and has a better tracking advantage when the target is not moving fast. object tracking; Circle Search (CS) algorithm; foreground discrimination; perceptual hashing; tracking strategy 2017- 05- 16; 2017- 06- 01。 國家自然科學基金資助項目(61070062,61502103);福建省高校產學合作科技重大項目(2015H6007);福建省高等學校新世紀優秀人才支持計劃項目(JAI1038);福建省科學廳K類基金資助項目(2011007);福建省教育廳A類基金資助項目(JA10064);福州市科技計劃項目(2014-G- 76)。 林玲鵬(1993—),男,福建莆田人,碩士研究生,主要研究方向:機器學習、視頻目標跟蹤; 黃添強(1971—),男,福建莆田人,教授,博士,主要研究方向:機器學習、數據挖掘、多媒體篡改檢測; 林晶( 1992—),女,福建莆田人,碩士研究生,主要研究方向: 數據挖掘、視頻篡改檢測。 1001- 9081(2017)11- 3128- 06 10.11772/j.issn.1001- 9081.2017.11.3128 (*通信作者電子郵箱fjnu510@163.com) TP391.41 A3.3 算法實現

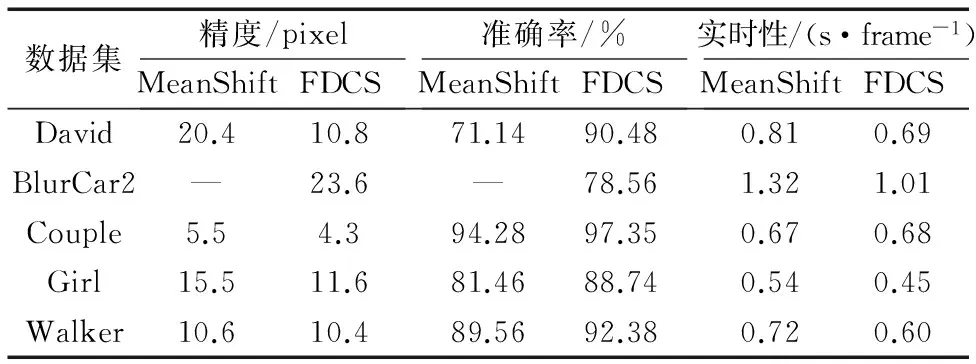

4 實驗結果與分析

5 結語