基于PReLU的DNN-LSTM混合神經網絡在語音識別中的研究

李 明,徐海青,吳立剛,浦正國

(1.國網安徽省電力有限公司信息通信分公司,安徽合肥 230000;2.安徽繼遠軟件有限公司,安徽 合肥 230000)

1 引言

傳統的語音識別技術是基于混合高斯模型和隱馬爾科夫模型(GMM-HMM),隨著深度學習的興起,一些深度學習神經網絡開始被應用到語音識別中,在聲學模型和語言模型的訓練中不斷地引入DNN、CNN、RNN不同網絡結構以及不同的激活函數,2015年DNN-HMM研究中發現將DNN神經網絡中的激活函數換成修正的線性單元(ReLU)函數可以獲得更好的效果[1-2]。隨后,2015年基于ReLU函數的DNN神經網絡研究中發現,可以通過合理的參數設置,采用大批量的隨機梯度下降算法,然后利用多GPU同時訓練,大大縮減了訓練的時間[3-4]。

除了DNN和CNN神經網絡外,人們還引入了循環神經網絡(RNN)來解決長時時序相關性的建模問題,同時研究報道基于雙向LSTM語音聲學模型系統可以獲得比基于DNN系統超過20%的性能提高[5]。

本文提出一種將基于PReLU激活函數的DNN神經網絡和LSTM神經網絡結合的混合神經網絡,并通過訓練和識別的實驗證明新型的混合神經網絡不僅在訓練時間上表現的很好,在識別準確率方面也有很大的提升。

2 基于PReLU的DNN-LSTM混合神經網絡

針對DNN神經網絡和LSTM神經網絡的特性,設計一種基于DNN神經網絡和LSTM神經網絡的混合神經網絡,并將該混合神經網絡應用在語音識別方向上。通過混合神經網絡和單一DNN神經網絡以及LSTM神經網絡在訓練時間和識別準確率方面的對比來驗證改進的混合神經網絡的性能。

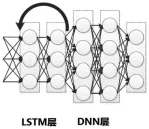

圖1 混合神經網絡結構

如圖1所示,混合神經網絡是由3層的LSTM神經網絡做底層,每層神經網絡包含512個節點;在高層上用了包含3層的DNN神經網絡,每層的神經網絡都包含1024個節點。對于DNN神經網絡,可以選取多種激活函數,但是對于LSTM神經網絡,激活函數只能選擇tanh函數和Sigmoid函數,因為LSTM中存在邏輯門,所以ReLU系列函數不能滿足要求。這里設計的LSTM神經網絡用的激活函數為Sigmoid函數,DNN神經網絡中的激活函數取PReLU函數,與之對比的是用了Sigmoid函數的DNN和LSTM混合神經網絡以及單獨用了3層深度神經網絡的DNNHMM模型和單獨用了3層的LSTM神經網絡。LSTM神經網絡中有記憶單元,可以記錄很長的歷史信息;而DNN神經網絡可以很有效提取數據中的高層次信息的特征,從而提高分類精度。

3 實驗

本文基于THCHS30數據庫進行測試,THCHS30數據庫是2015年清華大學語音語言技術中心發布的,數據庫中有超過1000條句錄音文本,包括50個說話人的35小時的語音數據,數據庫內容大部分來自新聞語料,涵蓋了各種語音。實驗采用的操作系統是Windows7專業版,CPU為Intel i7-6700,主頻為 3.4GHz,內存為 16GB。

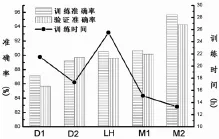

圖2 五種神經網絡的訓練時間和準確率

圖中D1表示基于Sigmoid激活函數的DNN神經網絡,D2表示基于PReLU激活函數的DNN神經網絡,LH表示的是LSTM神經網絡。M1表示基于Sigmoid激活函數的DNN和LSTM混合神經網絡,M2表示基于PReLU激活函數的DNN和LSTM混合神經網絡。發現采用的混合型神經網絡結合并發揚了兩種神經網絡的優點,擁有更快的訓練速度和更高的準確率,兩種混合神經網絡都比單一的神經網絡有更好的訓練效果,其中效果最好的DNN(PReLU)-LSTM神經網絡訓練速度比單一的LSTM神經網絡快47.8%,同時準確率比單一的LSTM神經網絡高8.6%。

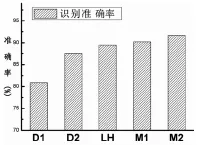

圖3 五種神經網絡的識別準確率

圖3是識別的結果,可以看出識別準確率最高的是兩種混合神經網絡,混合神經網絡中DNN神經網絡用的PReLU激活函數的要比DNN神經網絡用Sigmoid激活函數的準確率高,和兩種單一的DNN神經網絡對比結果類似。五種混合神經網絡中基于PReLU激活函數的DNN和LSTM混合神經網絡DNN(PReLU)-LSTM識別準確率較單一基于Sig-moid激活函數的DNN神經網絡提高10.8%。

具體的實驗數據見表1。

表1 五種神經網絡實驗的結果

4 結論

本文通過對DNN、LSTM等神經網絡和激活函數的研究,提出一種基于PReLU激活函數的DNN-LSTM混合神經網絡。語音識別的訓練和識別實驗表明混合神經網絡繼承并發揚了兩種神經網絡的優點,具有更快的訓練速度和更高的識別準確率,這為以后語音識別的研究提供了一種新思路。