基于Keras框架下的網絡電影數據分析

摘要:情感分析的商業價值在于可以通過文字分析可提早得知用戶對公司或產品的觀感,以調整銷售策略的方向。為了實現對電影數據的情感分析,本文基于Keras框架設計并建立了多層感知器模型(Multi-Layer Perceptron,MLP)、遞歸神經網絡(Recursive Neural Network,RNN)和長短時記憶(Long Short Term Memory,LSTM)三種深度學習模型并進行訓練評估和預測,通過對lMDb數據集的影評文字進行分析,最終可以較好地預測出影評文字褒貶的情感傾向。

關鍵詞:神經網絡;Keras框架;網絡電影數據集lMDb;情感分析

中圖分類號:TP393 文獻標識碼:A

文章編號:1009-3044(2019)34-0014-03

開放科學(資源服務)標識碼(OSID):

情感分析是近年來自然語言處理和文本挖掘領域的熱門話題,尤其以文本形式的互聯網信息的情感分析已經引起了學術界的廣泛關注[1]。情感分析(sentiment analysis)[2]c3]又稱評論挖掘或意見挖掘(opinion mining),是使用自然語言處理、文字分析等方法找出人們對某些話題或產品的觀點、態度、喜好或評價,經過自動判別可以挖掘出用戶的情感傾向分布。情感分析的商業價值在于,可提早得知顧客對公司或產品的觀感,進而調整銷售策略的方向,最大程度提高營銷成功率贏得競爭優勢。

近年來,隨著深度學習的快速發展已經在多個應用領域得到了廣泛的應用[4],尤其在利用神經網絡進行語言模型建立、文本特征學習和文本情感分析方面得到了重大進展[4],已經成為自然語言處理領域研究的熱點之一。

本文主要采用Keras框架建立神經網絡模型來實現電影數據的情感分析。Kerasc5]是一個開放源碼的高級深度學習程序庫,是由python編寫而成的高級神經網絡API,能夠更加高效快捷的建立深度學習模型并進行訓練評估和預測。通過Keras框架設計并建立了基于tensorflow的神經網絡模型,并用建立的神經網絡模型來實現對電影數據IMDb的情感分析。

1 模型介紹

1.1 多層感知機原理

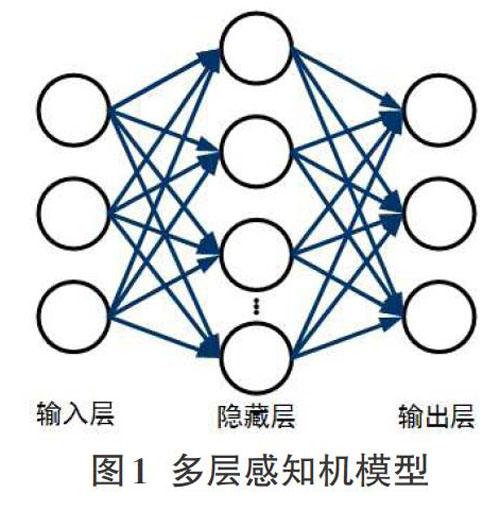

多層感知機[7](Multi_Layer Perceptron,MLP)通常也稱為人工神經網絡,是一種誤差反向傳播的多層前饋神經網絡算法,主要用來解決多類別非線性數據分類問題。通過對樣本進行訓練,MLP能夠使自身網絡學習目標模型輸入與輸出之間的映射能力,并具有較好的泛化能力。

多層感知機層與層之間是全連接的,包括輸入層、隱藏層和輸出層。圖1為一個最常用的三層MLP模型,只含有一個隱藏層也稱為單隱層網絡。

MLP算法的核心是依據梯度下降法,計算輸出層誤差并通過反向傳播來不斷調整輸入層和隱含層,隱含層和輸出層之間的權值和閾值,使網絡的均方根誤差收斂到最小。

1.2 RNN模型原理

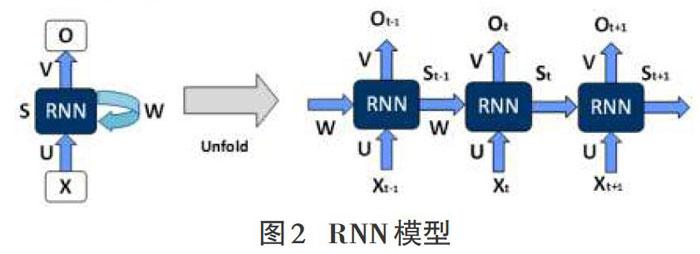

遞歸神經網絡(Recursive Neural Network)是具有樹狀階層結構且網絡節點按其連接順序對輸入信息進行遞歸的人工神經網絡,已經廣泛地應用于語音識別和手寫字體識別等領域。RNN模式的原理是將神經元的輸出再傳回神經元的輸入,這樣循環的設計使神經網絡具備保存信息的能力,以時間點展開RNN網絡結構如圖2所示。

圖2共有三個時間點,在t時間點處,X是t時間點的輸入;0.是t時間點的輸出;(U,V,W)都是神經網絡的參數,W參數是t—1時間點的輸出,但是作為t時間點的輸入。St是隱藏狀態,代表著神經網絡的“記憶”,是經過當前時間點的輸入Xt,再加上前一個時間點的狀態St-1,和U、W的參數共同評估的結果,其公式為:其中,函數是非線性函數。

RNN的關鍵點之一就是隱含層每個時刻的輸出都依賴于以往時刻的信息,但當時間間隔不斷增大時,RNN在訓練時會存在長期依賴的問題,這是由于RNN模型在訓練時會遇到梯度消失或爆炸的問題,從而導致RNN難以保存較長時間的記憶[6]。

1.3 LSTM模型原理

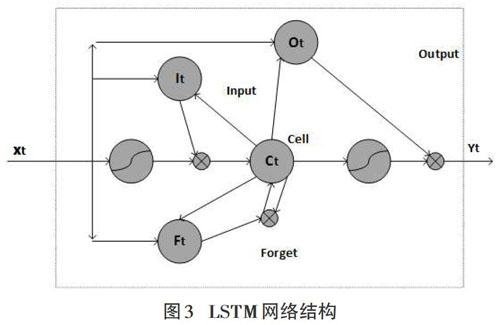

長短期記憶(Long Short Term Memory,LSTM)是一種時間遞歸神經網絡,已廣泛地應用在語音識別、圖像識別、數據分析等領域。LSTM是由深度學習專家Hochreiter&Schmidhuber (1997)[6]提出,專門設計用來解決RNN的長期依賴問題,能夠對任意長度的序列進行建模從而具有學習遠距離信息的能力,因此LSTM模型能夠更好地應用于文本情感分析。LSTM模型的網絡結構如圖3所示。

圖3中,Xt為輸入向量;Yt輸出向量;Ct:cell是LSTM的記憶細胞狀態;LSTM神經網絡包含“三種門”機制,分別為“輸入門”(It:InputGate)、“遺忘門”(Ft:Forget Gate)和“輸入門”(It:Input-Gate),LSTM利用這種“門”機制來控制記憶細胞的狀態,刪減或增加其中的信息從而使LSTM擁有長期記憶的功能。

2 實驗

2.1 實驗環境、數據集和評估指標

本文實驗的環境為Windows1064bit的操作系統,主要參數CPU:InterICorel i5-5200U CPU@ 2.20GHZ 2.20。內存為8GB,編程語言是python3.7.3。深度學習框架Keras。

本文實驗采用了網絡電影數據庫( Internet Movie Database,IMDb),IMDb[6]是一個與電影相關的在線數據庫,始于1990年并于1998年起成為亞馬遜旗下的網站,至今共收錄了400多萬部電影作品數據。IMDb數據集共有50000項“影評文字”,其中訓練數據與測試數據各占50%,每一項“影評文字”都被標記為“正面評價(pos)”或“負面評價(neg)”。

在機器學習、自然語言處理中評估是一個重要的環節,本文評估模型主要是通過分析訓練的準確率、測試集準確率和運行效率來評價模型。

2.2基于Keras框架的程序設計流程圖

用Keras建立模型一般包括數據預處理、建立模型、訓練模型評估模型準確率和進行預測和使用模型這幾個階段。Keras自然語言處理IMDb影評文字的設計流程如圖4所示。

圖4是程序設計總流程圖,首先是對IMDb影評文字進行預處理,讀取IMDb數據集;然后建立token(2000個字的字典),并使用已經建立的token將“影評文字”轉換為“數字列表”;由于每一條“影評文字”的字數不一致需要進行截長補短的處理,將“數字列表”的長度設置為100。經過數據預處理可以產生訓練數據和測試數據。第二步是加入Embedding層可以將“數字列表”轉換為“向量列表”,為了避免過度擬合加入了Dropout算法的比率D。第三步是建立深度學習模型,模型的主要參數為:詞向量的維度設為32,MPL模型“平坦層”(200個神經元)和“隱藏層”(256個神經元),RNN模型中神經元unit為16,LSTM建立了32個神經元。經過對模型進行訓練和預測,可以看到以0(負面)或1(正面)作為輸出預測結果。

2 實驗結果分析

綜上研究論述后,共執行10個訓練周期,通過對比“Acc訓練集準確率”和“vaLacc驗證集準確率”來分析模型的準確率。神經網絡模型由于參數數量較多在訓練時很容易產生過擬合現象,為了更好地解決過度擬合問題,模型引入擬合參數Drop-out,圖5為Dropout=0.2時的運行結果。

從圖5可以看出,經過10個訓練周期之后,訓練和驗證的準確率都越來越高。在模型訓練后期,“訓練的準確率(acc)”和“驗證的準確率(val_acc)”之間差距變小,過度擬合程度已經減輕。誤差越來越小,準確率越來越高。運行結果顯示MPL的驗證準確率約為0.83,RNN約為0.84,LSTM約為0.86。

通過圖6可以看出,經過10個訓練周期,三種模型中運行時間最快的是MPL,RNN和LSTM次之。結合圖5可知,在Dropout=0.2時,LSTM驗證準確率最高但運行時間較長,RNN準確率和運行效率居中,MPL驗證準確率相對較低但運行效率最高。

為了更好地觀察過度擬合參數對模型的影響,可以通過調節擬合參數來分析其對模型準確率的影響。實驗結果如圖7所示。

從圖7可以得到,當過擬合參數在0.1-0.5之間變化時,三種算法的驗證準確率在0.83-0.86之間變化。其中MPL算法在Dropout=0.2時驗證精度最低,此時VaLacc= (0.83),在Dropout=0.4時,具有最高驗證精度vaLacc=(0.86);RNN算法在Dropout=0.1時驗證精度最低,此時val_acc= (0.83),在Dropout=0.3時,驗證精度最高為0.85;LSTM算法在Dropout=0.2時驗證精度最低,此時val_acc=(0.85),在Dropout=0.5時,驗證精度最高為0.86。

因此選擇不同的過擬合參數對模型的驗證準確率(val_acc)有較大的影響。在實際的應用當中,應根據具體情況選取合適的過擬合參數,增強網絡的泛化能力。

4 結論

本文主要對IMDb數據集使用詞嵌入(Word Embedding)自然語言處理的方法進行預處理,基于Keras框架設計并建立了MLP、RNN和LSTM三種深度學習模型,通過對模型進行訓練、預測,最終可以預測出影評文字是正面的還是負面的。

實驗結果表明使用MPL模型準確率較低但運行時間最短;使用RNN模型準確率高于MPL但運行時間相對較長;由于LSTM模型解決了RNN模型中的長期依賴問題驗證準確率最高可以達到86%,但消耗時間最長。隨著GPU的快速發展可大大縮短深度學習模型的訓練時間,使LSTM等神經網絡模型得到更加廣泛的應用。

參考文獻:

[1]楊立公,朱儉,湯世平.文本情感分析綜述[J].計算機應用,2013,33(6):1574-1578.

[2]梁軍,柴玉梅,原慧斌,等.基于極性轉移和LSTM遞歸網絡的情感分析[J].中文信息學報,2015,29(5):152-159.

[3]王文凱,王黎明,柴玉梅.基于卷積神經網絡和Tree-LSTM的微博情感分析[J].計算機應用研究,2019,36(5):1371-1375.

[4]張紫瓊,葉強,李一軍.互聯網商品評論情感分析研究綜述[J].管理科學學報,2010,13(6):84-96.

[5]劉毅銘.深度學習研究與應用綜述[J].綠色科技,2019(11):281-283.

[6]林大貴.TensorFlow+Keras深度學習人工智能實踐應用[M].清華大學出版社,2018,162-200.

[7]何平,劉紫燕.基于改進多層感知機的手寫數字識別[J].通信技術,2018,51(9):2075-2080.

【通聯編輯:唐一東】

收稿日期:2019-08-15

作者簡介:方碧云(1994-),女,河南平頂山人,碩士,主要研究方向為信號與信息處理。