基于深度學習的障礙物檢測研究

張舜 郝泳濤

摘要:避障導航是自動導引小車領域的重要課題,障礙物檢測則是其中的重要環節。隨著計算機視覺的發展,基于深度學習的圖像目標檢測算法已日趨成熟,針對自動導引小車避障檢測對精準性和實時性要求都較高的情況,本文搭建深度學習模型,使用端到端的物體目標檢測網絡,對室內環境下自動導引小車可能的工作場景進行訓練,在速度較快的情況下得到了很高的精準度。

關鍵詞:避障檢測;深度學習;自動導引小車;圖像檢測

中圖分類號:TP311 文獻標識碼:A

文章編號:1009-3044(2019)34-0185-03

無人智能車一直是科研領域的熱門話題,不論在無人駕駛領域,還是在AGV小車領域,避障一直是一個關鍵的課題。在無人駕駛的領域研究中,主要有雷達和攝像頭兩種傳感器,雷達主要有超聲波雷達和激光雷達。雷達傳感器只能判斷障礙的存在,而不能判別障礙的種類,而且隨著一系列深度學習檢測算法的提出,基于計算機視覺的識別和檢測的算法的視覺傳感器已經逐漸能夠代替雷達傳感器,基本滿足AGV小車避障檢測的需求。

傳統的機器學習檢測方法由以下步驟組成:1)輸入待檢測圖像,并進行相關的預處理;2)使用滑動窗口方法獲取候選框;3)對每個候選框取特征信息;4)使用分類器進行判定。這些滑動窗口和特征提取相結合的傳統機器學習算法,在早期取得了比較好的效果,但是其過高的計算復雜度、較差的實時性都成為限制其發展的阻礙,并且傳統機器學習算法在應對復雜情形下的表現差強人意。但自從2012年開始,AlexNet[1]的出現打破了這一現狀,標志基于深度學習的圖像檢測算法開始發展。基于深度學習的圖像物體檢測算法目前有兩條分支。第一條分支的基本原理是先生成候選區,再對候選區提取特征。自R_CNN[2]模型開始,這條分支在精準度上取得了十足的進展;2015年提出的fast R_CNN[3]貝1J結合了R-CNN和SPP-NETf空間金字塔池化層)[4]的優點;2015年提出的faster R-CNNc5]結合了RPN候選框提取,相比于fast R-CNN進一步提高了效率;2017年提出的FPN(Feature Pyramid Network)[6]則解決了高層中無法檢測細小物體的問題;2017年提出的Mask R_CNN[7]則基于faster R-CNN新增了基于掩碼層的分割分支。另一條分支則通過直接檢測出物體的種類和位置來實現端到端的檢測,相應,這種檢測手段也極大地提高了檢測的速度。2016年,Red-mon等人發表了一篇名為:vou look onlv once[8]的文章,標志著端到端的目標檢測分支的誕生,相比于faster R-CNN.YOLO具備更快的檢測速度;隨后在2017年,又提出了一種速度更快、精度更高,并且可以識別9000種物體的模型YOL09000[9];在2018年,再次提出了基于Darknet-53和多尺度特征的YOLOv3[10],在精準度相當的情況下,YOLOv3的速度是其他模型的至少3-4倍。

綜合上文的分析,我們可以看出,在基于AGV小車對障礙物檢測實時性要求較高的前提下,YOLOv3在相同精準度下,具備最快的檢測速度,故本文擬采用YOLOv3框架來實現對AGV小車在室內場景下的障礙物檢測方法的研究。

1 YOLO v3

YOLO是一種端到端的圖像檢測框架,其核心過程就是將整張圖片作為網絡的輸入,可以在輸出層直接得到物體的檢測邊界框,并標注其檢測到得所屬類別。YOLO使用了網格而非傳統的滑動窗口,首先將一幅圖片分成S * S個網格,每個網格需要預測一個中心點落在這個網格當中的物體;每個網格需要預測B個邊界框(boundingbox),每個邊界框都要回歸一個位置信息,包括x,y,w,h,分別代表坐標信息和尺寸信息,同時還要再輸出一個置信度值(confidencescore),其計算的方式如(1)式所示.

如果有物體在一個單元格(gridcell)中,則Pre(Object)取1,否則取0;第二項則是預測的邊界框和實際的標記之間的IOU值。

除了返回位置和置信度信息,每個網格還需要返回對每一個類別的預測信息,分別代表對每個類別預測的概率。如果有C個類別,則需要輸出C個相應的概率值。也就是說,在一個劃分為S*S個網格的網絡中,每個網格需要預測B個邊界框,每個邊界框輸出(x,v,w,h,confidence)五個維度的信息,并且每個網格要輸出 C個類別的預測信息,故整個網絡最后的輸出為S*S*(5*B+C)的一個張量。

在測試的時候,類別信息與置信度相乘,就可以得到每個邊界框的類別預測的置信度得分如(2)式所示。

得到每一個邊框的預測置信度得分后,過濾掉低于閾值的邊框,對保留的邊框進行非極大值抑制(NMS)處理,就得到了最終的檢測結果。

YOLO采用了均方差損失函數,但是不同的部分要賦予不同的權重,8維(B=2的情況下)位置信息要賦予比20維(C= 20的情況下)的類別信息更大的權重。每個網格都只預測一個物體,選擇IOC最大的邊界框,其他邊界框則認為不存在物體。損失函數如(3)式所示。

在YOLO的基礎上,YOLO v2使用了一個新的類似于VGG的分類模型,并使用3* 3的過濾器,每次池化后都增加一倍的通道數量,通過使用全局平均池化、批量標準化來讓訓練更加穩定,加速收斂,使模型規范化。而YOL0 9000則利用同時優化檢測和分類功能來支持實時地檢測9000種物體分類。

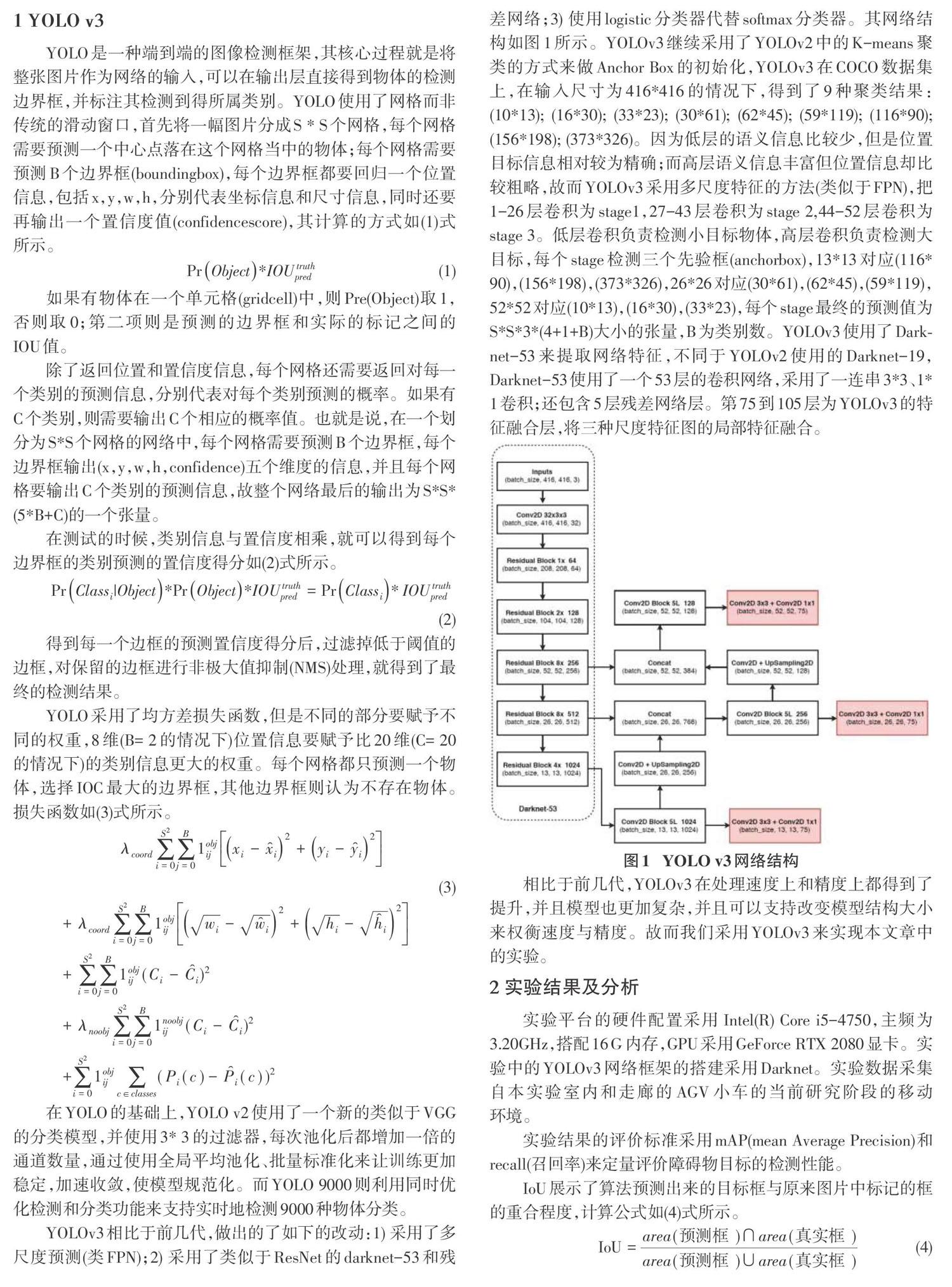

YOLOv3相比于前幾代,做出的了如下的改動:1)采用了多尺度預測(類FPN);2)采用了類似于ResNet的darknet-53和殘差網絡;3)使用logistic分類器代替softmax分類器。其網絡結構如圖1所示。YOLOv3繼續采用了YOLOv2中的K-means聚類的方式來做Anchor Box的初始化,YOLOv3在COCO數據集上,在輸入尺寸為416*416的情況下,得到了9種聚類結果:(10*13); (16*30); (33*23); (30*61); (62*45); (59*119); (116*90);(156*198); (373*326)。因為低層的語義信息比較少,但是位置目標信息相對較為精確;而高層語義信息豐富但位置信息卻比較粗略,故而YOLOv3采用多尺度特征的方法(類似于FPN),把1-26層卷積為stagel,27-43層卷積為stage 2,44-52層卷積為stage 3。低層卷積負責檢測小目標物體,高層卷積負責檢測大目標,每個stage檢測三個先驗框(anchorbox),13*13對應(116*90), (156*198), (373*326),26*26對應(30*61), (62*45),(59*119),52*52對應(10*13),(16*30),(33*23),每個stage最終的預測值為S*S83*(4+1+B)大小的張量,B為類別數。YOLOv3使用了Dark-net-53來提取網絡特征,不同于YOLOv2使用的Darknet-19.Darknet-53使用了一個53層的卷積網絡,采用了一連串3*3、l{1卷積;還包含5層殘差網絡層。第75到105層為YOLOv3的特征融合層,將三種尺度特征圖的局部特征融合。

相比于前幾代,YOLOv3在處理速度上和精度上都得到了提升,并且模型也更加復雜,并且可以支持改變模型結構大小來權衡速度與精度。故而我們采用YOLOv3來實現本文章中的實驗。

2 實驗結果及分析

實驗平臺的硬件配置采用InteI(R) Core i5-4750,主頻為3.20GHz,搭配16G內存,GPU采用GeForce RTX 2080顯卡。實驗中的YOLOv3網絡框架的搭建采用Darknet。實驗數據采集白本實驗室內和走廊的AGV小車的當前研究階段的移動環境。

實驗結果的評價標準采用mAP(mean Average Precision)和recall(召回率)來定量評價障礙物目標的檢測性能。

IoU展示了算法預測出來的目標框與原來圖片中標記的框的重合程度,計算公式如(4)式所示。

使用IoU判斷目標檢測是否被正確檢測,需要設置一個閾值。通常將這個閾值設為0.5或0.75,如果IoU大于閾值,可以認為檢測是正確的,反之則是錯誤的。根據IoU與閾值比較,可計算出每個類的正確檢測次數,計算公式如(5)式所示。

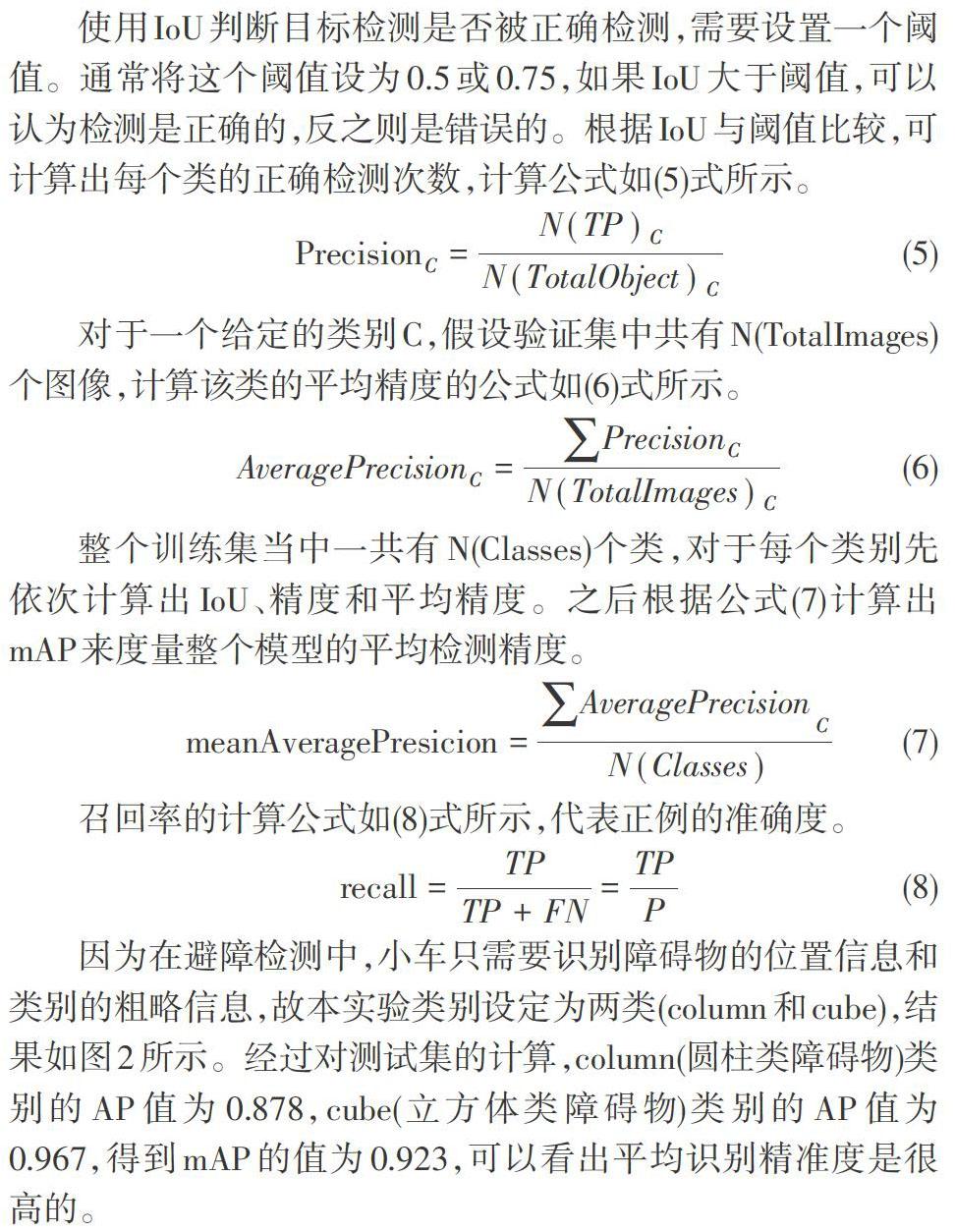

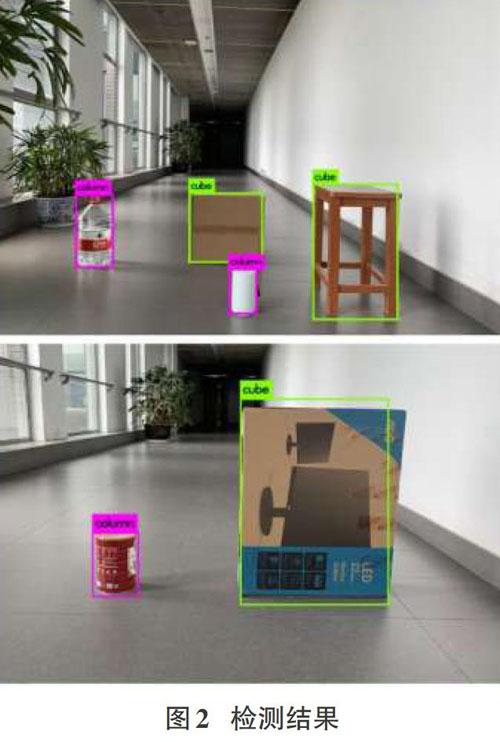

因為在避障檢測中,小車只需要識別障礙物的位置信息和類別的粗略信息,故本實驗類別設定為兩類(column和cube),結果如圖2所示。經過對測試集的計算,column(圓柱類障礙物)類別的AP值為0.878,cube(立方體類障礙物)類別的AP值為0.967,得到mAP的值為0.923,可以看出平均識別精準度是很高的。

圖3表示Region分別為94(中型物體)和106(大型物體)的Loss、IoU、Recall(IoU閾值為0.75)曲線,可以看出模型的平均損失在隨著訓練集數據的增加逐漸減小,并且在IoU=0.75、Region=94/106的情況下,Recall值均能達到1,說明YOLO v3對于在室內AGV小車的障礙物檢測上能夠達到很好的檢測效果。

3 結束語

本文我們使用了YOLO v3來實現室內AGV小車的障礙物檢測。實驗表明YOLO v3模型對于室內ACV小車的障礙物檢測是有效的,這會有助于我們在AGV小車避障導航領域的進一步研究。未來我們將嘗試更復雜的室內環境和更多類型物體的檢測,進一步提高檢測精度和檢測速度,實現能夠充分滿足AGV小車工作環境的避障系統。

參考文獻:

[1] Krizhevsky A,Sutskever I.Hinton G.ImageNet Classifica-tion with Deep Convolutional Neural Networks[C]/ NIPS. Cur-ran Associates Inc. 2012.

[2] Girshick R,Donahue J,Darrelland T,et al.Rich feature hi-erarchies for object detection and semantic segmentation[C]/2014 lEEE Conference on Computer Vision and Pattern Rec-ognition. IEEE, 2014.

[3] Girshick R.Fast R-CNN[C]/ 2015 lEEE International Confer-ence on Computer Vision (lCCV). lEEE, 2016.

[4] He K,Zhang X,Ren S,et al.Spatial Pyramid Pooling inDeep Convolutional Networks for Visual Recognition[J]. IEEETransactions on Pattern Analysis and Machine Intelligence,2015, 37(9):1.

[5] Ren S,He K,Girshick R.et al.Faster R-CNN: TowardsReal-Time Object Detection with Region Proposal Networks[J]. IEEE Transactions on Pattern Analysis&Machine Intelli-gence, 2015, 39(6):1137-1149.

[6] Li H,Xiong P,An J,et al.Pyramid Attention Network forSemantic Segmentation[J]. 2018.

[7] He K,Gkioxari G,Dollar P,et al.Mask R-CNN[C]// 2017lEEE International Conference on Computer Vision (ICCV).IEEE Computer Society, 2017.

[8] Redmon J , Diwala s . Cirshick R , et al. You Only LookOnce: Unified, Real-Time Object Detection[C]/ 2016 IEEEConference on Computer Vision and Pattem Recognition(CVPR). lEEE Computer Society, 2016.

[9] Redmon J , Farhadi A. [IEEE 2017 IEEE Conference on Com-puter Vision and Pattem Recognition (CVPR) - Honolulu, Hl(2017.7.21-2017.7.26)] 2017 lEEE Conference on ComputerVision and Pattern Recognition (CVPR) - YOL09000: Better,Faster, Stronger[J]. 2017:6517-6525.

[10] Redmon J , Farhadi A. YOLOv3: An Incremental Improve-ment[J]. 2018.

收稿日期:2019-08-20

作者簡介:張舜(1992-),男,遼寧盤錦人,碩士,主要研究方向為計算機圖形學,圖像處理等;郝泳濤(1973-),男,山東威海人,教授,博士生導師,研究方向為企業信息集成系統,知識處理與挖掘,智能設計,分布式智能系統和虛擬現實技術等。