基于小波域的深度殘差網絡圖像超分辨率算法*

段立娟,武春麗,恩 擎,喬元華,張韻東,陳軍成

1(北京工業大學 信息學部,北京 100124)

2(可信計算北京市重點實驗室,北京 100124)

3(信息安全等級保護關鍵技術國家工程實驗室,北京 100124)

4(北京工業大學 應用數理學院,北京 100124)

5(數字多媒體芯片技術國家重點實驗室(北京中星微電子有限公司),北京 100191)

1 引 言

在圖像處理領域,為了獲得更高分辨率的圖像,通常采用超分辨率方法來重建低分辨率圖像的細節信息.一般來講,超分辨技術(super-resolution,簡稱 SR)是指從一副或者多幅低分辨圖像重建出高分辨圖像的數字圖像處理技術.單幅圖像超分辨率(single image super-resolution,簡稱SISR)的重點在于如何從一張低分辨率圖像重建出高分辨率圖像的局部細節.該問題已經發展成為圖像處理領域一個重要的研究方向[1].因其可以恢復一些高頻細節,該技術被廣泛應用于需要大量細節信息的圖像處理領域,如醫學成像[2]、衛星成像[3]、人臉認證[4-8]以及公關安全監控領域等等.

基于實例的 SR方法通過使用大型圖像數據集學習從低分辨率(low resolution,簡稱 LR)圖像到高分辨率(high resolution,簡稱HR)圖像的映射,已經證明能夠達到較好的效果.許多機器學習算法,包括字典學習[9]、局部線性回歸[10]和隨機森林[11]等都被應用到這個領域中.近些年來,基于卷積神經網絡(convolutional neural network,簡稱 CNN)的方法,憑其強大的學習能力被廣泛應用于計算機視覺任務之中,在目標識別、分割、光流和超分辨率領域,均取得了卓越的進步.盡管基于卷積神經網絡的圖像超分辨率方法較傳統方法取得了較大的突破,但仍存在許多問題.大部分現有的 SISR方法[12-19]的訓練過程是在圖像空間中依靠逐像素均方誤差的方式使網絡輸出盡可能地接近HR圖像,但這種方式趨向于產生模糊和過平滑的輸出,缺乏細節信息.而且,目前的工作只適合一些小且特定的縮放系數(如x2或者x4).因此,SISR問題仍然有待進一步的探究和發展.

小波變換已被證明是一種高效的特征提取算法,常被用來重現和存儲多分辨率圖像[20].如圖1所示,它可以表示一張圖像在不同水平上的上下文和紋理信息.空間小波系數本身是稀疏的,因此,它能夠使網絡學習更加容易.

Fig.1 The example of Haar wavelet transform圖1 Haar小波變換示例

DWSR[21]利用小波變換的方式將重建HR圖像轉變為推斷HR圖像一系列相關的小波系數.該方法在與當前最優算法超深度超分辨率網絡(VDSR)效果相當的情況下,實現了更簡單的運算量和更快的速度.本文提出的方法在此方法的基礎上加以改進.在輸入方面,為減少計算量從而實現LR到HR的實時處理,本文直接將LR圖像作為網絡的輸入.在網絡架構方面,本文設計的框架分為3部分.特征提取網絡、推理網絡和重建網絡.為了更好地捕捉上下文之間的信息,以及更好地推斷出缺失的細節,特征提取網絡采用殘差塊相連的方式[22],同時將每個殘差塊的輸出進行跨連,作為推理網絡的輸入.此外,網絡最終輸出的小波系數個數(即網絡最終輸出的通道數)不再是固定值,而會隨尺度而發生改變.在損失函數方面,本文不僅只考慮小波系數之間的殘差損失,同時考慮最終經過小波逆變換后的SR圖像與HR圖像之間的殘差損失,進行雙重約束,實現更優的效果.

本文第1節對解決單幅圖像的超分辨率問題的方法進行概述和總結,并簡單概述本文方法的基本思想.第2節對已有的基于卷積神經網絡的超分辨率方法進行總結.第 3節具體描述本文方法的框架和損失函數的設計.第 4節展示本文方法與其他相關方法在不同數據集上的結果對比,總結本文方法的優勢和不足.第 5節對本文進行總結,并對未來值得關注的研究方向進行初步探討.

2 相關工作

從觀察到的低分辨率圖像推測合成的高分辨率圖像是典型的病態逆問題.現有的算法可以根據技術手段分為兩類:基于重建的方法和基于學習的方法[23].傳統學習模型的特征提取和表達能力有限,很大程度上限制了圖像超分辨率重建效果的大幅度提升.而近年來基于深度學習的方法因其具有從大規模數據中學習知識的強大能力被引入到解決SR的問題中.

隨著基于深度卷積神經網絡在高視覺水平任務上的迅速發展,大量基于CNN的方法也被應用到計算機低視覺水平的任務中,如圖像超分辨率、圖像去噪等.SRCNN[12]是首個將卷積神經網絡引入到圖像超分辨率重建領域的神經網絡模型.其網絡結構由 3個卷積層組成,分別代表圖像塊的特征提取、表示和重構.通過引入卷積神經網絡,該方法顯著提高了傳統方法的重構進度.雖然 SRCNN運作良好,但仍存在缺乏語境信息、單一尺度放大以及收斂速度慢等問題.為了解決這一問題,有研究者提出具有深層次網絡的 VDSR[14](超深度超分辨率網絡).該方法基于用于圖像分類的VGG[24]網絡結構設計,通過訓練HR和LR圖像之間的殘差,并使用更高的學習速率來加速收斂.同時,通過權重共享,實現網絡參數較少且重構性能較好的圖像多尺度放大.此外,DRCN[15]在VDSR的基礎上增加遞歸連接,實現圖像層之間的信息反饋以及上下文信息關聯,進一步提升效果.同時,將模型壓縮成5層,降低訓練難度.

上述方法均利用卷積神經網絡學習MR圖像(middle resolution image)到HR圖像的映射,其中,MR圖像是通過對LR圖像利用雙三次插值的方法進行上采樣獲取的.為了實現從LR到HR的直接映射,FSRCNN[14]利用反卷積層替代 SRCNN模型中雙三次插值的操作.在移除上采樣的操作之后,該模型可以學習從低分率圖像到高分辨率圖像的直接映射,同時實現超過 40倍速度的提升.FSRCNN模型僅包括卷積層和反卷積層,其中卷積層對于不同的放大倍數共享卷積層的權重,因此,FSRCNN能夠利用一個單獨的模型處理不同的尺度.ESPCN[17]是在FSRCNN的基礎上設計sub-pixel卷積層實現上采樣的操作,該方法有效地減少了總計算復雜度,能夠合成一個沒有棋盤偽像的干凈圖像.LapSRN[19]是最近提出的單幅圖像超分辨率方法之一,該模型包括一個基于拉普拉斯金字塔的特征提取和圖像重建部分的級聯框架,并且使用Charbonnier損失函數代替L2范數損失函數,取得了較好的超分辨率重構效果.

上述基于卷積神經網絡的超分辨方法針對圖像的空間域進行處理,目的是將像素值直接作為網絡輸出進行重構,這通常會使結果趨向于模糊和過平滑.為了解決這一問題,PLSR[25]將感知損失代替逐像素差損失,進而優化超分辨率網絡,以保證獲取更多的語義信息.該策略雖然未能在 PSNR指標上取得較好的效果,但在視覺上更加逼真,能夠帶來更多好的細節和邊緣.SRGAN[26]在PLSR的基礎上,將感知損失和GAN模型相結合,生成更真實和銳利的圖像.該方法利用GAN中的Generator網絡生成高分辨圖像,再由Discriminator網絡進行判斷,最終得到滿足條件的高分辨率圖像.但是該方法提出的基于VGG分類網絡的感知損失不能夠精確地捕捉超分辨率任務中必要的細節信息.于是,SRPGAN[27]提出一種基于GAN模型中Discrimination網絡的感知損失,并且使用Charbonnier損失函數.該方法重建的超分辨率圖像更加鋒利和逼真.

綜上所述,目前解決該問題主要有 3種思路:第一,設計不同的網絡架構去重建高分辨率圖像;第二,利用感知損失和 GAN生成模型生成更真實和銳利的圖像;第三,考慮在變換域的情況下處理該問題.小波變換將提供的圖像內容“過程”和“細節”分離的特性,與輸入 LR圖像恢復圖像細節的超分辨率問題具有一定相似性.因此,本方法考慮變換到小波域進行超分辨率重構.目前已有一些基于小波的方法解決超分辨率問題.但其中大部分集中在多幅圖像的超分辨問題,這些方法[28-31]利用多幀低分辨率圖像推斷出高分辨率圖像缺失的細節.針對單幅圖像超分辨問題,雖然也有一些小波域的插值方法被研究,但其訓練有限和預測程序簡單,不足以處理普通輸入圖像,其SR結果也遠差于基于深度學習的超分辨率方法.

DWSR[21]是首個在小波域下利用深度卷積神經網絡結合低頻和高頻信息子帶之間的互補信息的方法.該方法把重建高分辨率圖像的問題轉換為推理一系列小波變換系數,這樣產生的圖像邊緣具有更少的偽像.該方法采用的網絡是由一系列相同大小的卷積層直接連接而成,缺乏層與層之間的信息融合,而且沒有考慮尺度與小波分解級數之間的對應關系,所有尺度經過最終網絡訓練后的結果都是盡可能地接近HR圖像與MR圖像一級小波分解系數之間的殘差.為了更好地捕捉上下文之間的信息,并推斷出更多缺失的細節,本方法在DWSR[21]的基礎上作了進一步的改進,直接將 LR圖像作為網絡的輸入,并且設計更為合理的網絡結構.此外,本文提出的網絡結構輸出的小波系數個數不再是固定值,而是隨著尺度的變化而發生改變.

3 基于小波域的深度殘差網絡模型

本文提出的基于小波域的深度殘差網絡,將小波變換的思想與深度殘差網絡相結合,并結合圖像空間損失和小波系數損失,對網絡訓練加強約束.該模型應用于圖像超分辨率重構問題,能夠將圖像各個層次的特征分隔開來進行訓練,捕捉更多缺失的細節信息.

3.1 小波變換

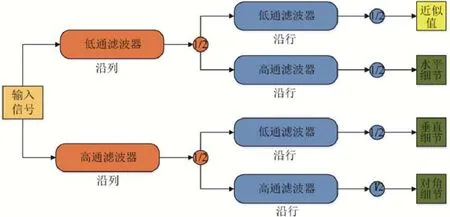

圖1顯示二維小波變換的結果,可以直觀地看出,如果把變換后第1個小波圖像表示為LR圖像,那么其他的小波圖像就是想要得到的缺失的細節.因此,本文將小波變換引入到 SISR問題當中.本文方法的重點在于強調小波變換對于超分辨率重建問題的有效性,因此,選擇最簡單的哈爾小波即可滿足實現描述不同頻帶信息的要求,當然也可以使用其他的小波.將 HR圖像利用哈爾小波變換為一系列尺寸相同的小波圖像作為神經網絡的訓練目標.如圖2所示,更高水平的變換就是循環地進行低通濾波和高通濾波以及下采樣的操作.

Fig.2 The procedure of 1-level 2D DWT圖2 1級二維小波變換過程

3.2 網絡架構

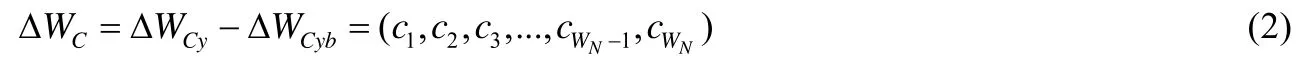

本文提出的方法基于空域到小波域的變換來實現超分辨率圖像的重建.為了更加有效地提取特征并降低運算的復雜度,本文直接將LR圖像作為網絡的輸入,最終映射到HR圖像的小波域下.從LR到最終重建HR的整個過程其實是多個網絡,但是我們把這多個網絡當作一個網絡進行統一、有效的學習.整個網絡的學習屬于多階段,利用推理網絡輸出的一系列小波圖像屬于第1階段,第2階段是根據第1個階段的結果進行小波逆變換,得到最終的超分辨率圖像(SR).最后將小波系數的損失和圖像空間像素的損失一起以梯度的形式反傳回整個網絡進行更新.如圖3所示,本文提出的神經網絡結構包括特征提取網絡、推理網絡和重建網絡3部分.其中,特征提取網絡從低分辨率圖像中提取特征,推理網絡則將提取的特征表示為一系列HR圖像與對應MR圖像小波系數的差異,重建網絡利用小波逆變換重建 SR圖像.為了捕捉更多缺失的細節,本文利用小波系數和圖像空間像素的兩種損失構建一個魯棒的損失函數來計算SR與HR的相似度,從而優化本文提出的神經網絡.在第3節中將會詳細闡述損失函數.

Fig. 3 Overall framework. The two parts corresponding to the two-way arrow are used to calculate the loss during network training圖3 總體框架.其中雙向箭頭對應的兩部分在網絡訓練時進行損失計算

3.2.1 特征提取網絡

特征提取網絡將 LR圖像作為輸入,通過神經網絡前向傳播表示為一系列特征圖.特征提取網絡由多個殘差塊級聯構成.其中,殘差塊由兩個具有相同核大小以及過濾器數目的卷積構成,其輸出是由輸入和經過連續兩個卷積之后的結果相加構成.每個殘差塊作為一個單元,每個單元的輸出都被傳遞到下一個單元,并同時進行跨連作為推理網絡的輸入.所有的卷積層共享相同的核大小:3×3.而為了保持特征圖的大小與輸入一致,將步長(stride)和邊緣填充(pad)都設置為 1.同時,為了獲取更多、更豐富的信息,卷積層過濾器的數目隨著網絡的深入不斷增長.

3.2.2 推理網絡

推理網絡將特征提取網絡的輸出作為輸入,但因其維度比較大,所以使用 1×1的卷積實現減少特征維度的目的.同時,為了保證推理出的小波圖像與 LR圖像具有相同尺寸,對推理網絡中所有卷積層參數的設置與特征提取網絡保持一致,即卷積核大小設置為 3×3,步長和邊緣填充設置為 1.因為小波分解系數的高度獨立性,所以無需考慮通道之間的關系.不同尺度網絡最終輸出通道的個數是縮放倍數的平方,每個通道表示一一對應的小波圖像.如圖3所示,將網絡最終的輸出與MR圖像的小波分解系數相加,然后通過小波逆變換轉換到原始圖像空間.正如典型的殘差學習網絡一樣,本文提出的模型也致力于學習殘差輸出.因為不同尺度的小波變換圖像尺寸是不同的,其對應網絡最終輸出的通道數也是不同的,所以需要學習多個網絡.但是,不同尺度圖像的訓練只有最后一層卷積的參數設置有所不同,其他卷積層對于不同尺度共享權重,因此只對一個尺度的網絡從頭開始訓練,其他尺度在已訓練好的模型上進行微調即可.

3.2.3 重建網絡

重建網絡是將推理網絡的輸出與 LR經上采樣和小波變換后的結果相加作為輸入,利用小波逆變換,將一系列小波圖像生成對應的一張超分辨率圖像,得到最終的結果.依據中間結果(一系列的小波系數)和最終SR圖像,本文提出一種靈活且約束能力更強的損失函數去優化網絡,它由小波系數損失和圖像空間像素損失兩部分組成,總的損失函數被定義為

其中,λ和1-λ分別代表小波系數損失和圖像空間損失的權重,具體細節會在第4節加以詳細說明.

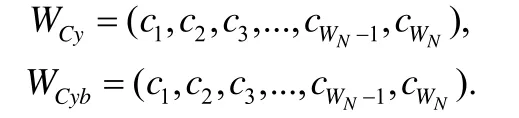

小波系數損失.本文設定輸入LR圖像為x,標簽高分辨圖像為y,輸入LR經雙三次插值上采樣后的MR圖像為yb,θ是待優化的一系列網絡參數.通用單幅圖像超分辨率網絡旨在學習給定低分辨率輸入x與高分辨率圖像y之間的映射關系.而本文方法提出的網絡結構是學習低分辨率輸入x與高分辨率圖像y小波變換后系數之間的關系,網絡的輸出盡可能地與對應高分辨率圖像小波分解后的系數接近.本文定義縮放系數{r,r≥2}、小波變換的級數為m以及變換后小波系數的個數為WN,它們之間的映射關系為.

同時,將圖像y和yb進行小波分解后的系數分別表示為

兩者分解后系數的差異(即殘差)可計算為

式(2)的結果為神經網絡致力于學習的目標,即fθ(x)~.在圖像空間里最常用的損失函數是對 HR圖像和 SR圖像逐像素進行均方誤差操作.本文同樣采用這種方式,不同之處是對圖像對應的小波系數進行這一操作.即:

其中,n為batchsize的大小,i代表批處理圖像中的第i張圖像,j為小波系數序列中的第j個系數.

圖像空間損失.本文提出的神經網絡結構學習到的是MR圖像與HR圖像小波變換后系數之間的差異,將輸出的結果經過小波逆變換即可得到學習到的殘差圖像IΔSR,即:

在得到殘差圖像后,與原始輸入圖像經過雙三次插值上采樣后的 MR圖像yb相加即可得到最終的超分辨圖像ISR:

考慮到之前圖像空間的損失計算,為獲取紋理與平滑之間的一個平衡,在小波系數損失的基礎上,添加原始圖像空間的損失,計算圖像空間的殘差損失.

其中,n和i的含義參考公式(3).

4 實驗結果及分析

本文使用D2VIK數據集中的800張圖像作為訓練集,其所有圖像至少有一個軸上存在2K像素(垂直或水平).本文采用 64的步長將數據集切割成大小為 128×128的圖像塊,獲得大約 50萬左右的切塊用于網絡訓練.在批訓練中,每次隨機選擇 256個高分辨圖像塊作為標簽,利用雙三次內核插值法進行下采樣獲取低分辨率圖像塊,作為網絡的輸入.

對于測試集,本文對 5個公共基準數據集進行了實驗:SET5[32]、SET14[33]、BSD100[34]、URBAN100[35]和MANGA109[36].SET5、SET14和BSD100數據集中的圖像由自然場景組成,URBAN100數據集包含具有挑戰性的城市場景圖像以及不同頻段的細節,MANGA109是日本漫畫的數據集.

4.1 訓練細節

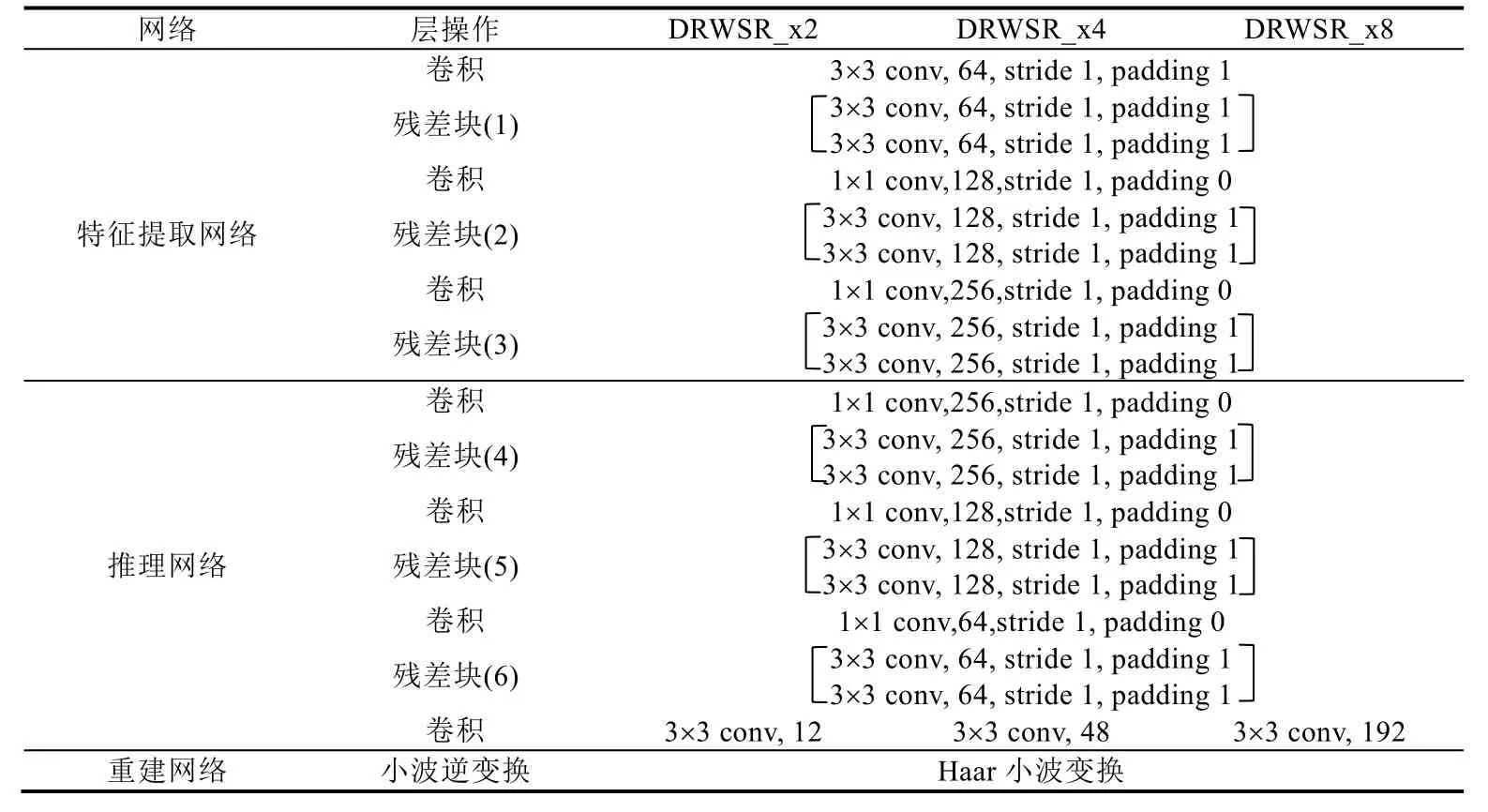

在訓練時,本文將 HR圖像對應的小波系數作為訓練標準,其中小波分解級數通過與縮放系數的映射關系來獲取.然后對每一次迭代后的結果利用公式(1)進行損失計算.同時采用ADAM的優化器(參數設置:β1=0.9,β2=0.999)更新權重和偏置.學習率lr初始化為2e-4,并將學習率衰減因子設置為0.005.網絡的輸入可以是單通道的灰度圖或3通道的彩色圖像,本文網絡的訓練選擇后者.如表1所示,特征提取網絡由3個殘差塊組成,其中過濾器數目從64~256依次呈二倍增多.特征提取網絡融合的特征經過1×1卷積實現降維,作為推理網絡的輸入.推理網絡同樣由3個殘差塊組成,與特征提取部分相反的是,過濾器數目從256~64依次呈2倍減少,最后再經過一個卷積獲取指定的通道數3×r2(r是縮放倍數).

同時,開始時先利用單個的損失函數進行訓練,即(λ=0)和(λ=1),通過訓練好的結果來設定權重,獲取最優的參數選擇.最終,設定參數為λ=0.99.

Table 1 The specific settings of the network parameters proposed by this method表1 本文方法提出的網絡參數的具體設置

4.2 損失函數分析

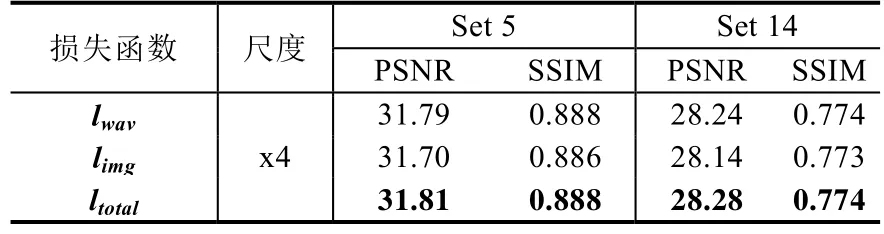

為證明所使用損失函數的優越性,本文針對不同的損失函數做了一系列對比實驗.在表 2中展示了分別利用小波系數損失函數、圖像空間損失函數以及結合兩者的損失函數訓練后的結果(縮放系數為x4,數據集Set 5和 Set 14).實驗結果表明,無論是峰值信噪比還是結構相似性,采用結合方式產生的效果都是最優的,進一步證明兩者結合這一策略是可行且有效的.

Table 2 Quality evaluation of different loss functions表2 不同損失函數的質量評價

4.3 質量評價

本文采用廣泛被用于評價圖像質量的兩個指標來判斷 SR結果的好壞:峰值信噪比(PSNR)和結構相似性(SSIM).將本文提出的方法與相關優異的方法進行比較分析.對于縮放尺度,采用2x、4x和8x測試模型.

表3中總結了本文方法與其他方法在不同數據集(Set 5,Set 14,BSD100,Urban100,Manga109)以及不同尺度上(x2,x4和 x8)結果的(峰值信噪比和結構相似性)比較.最好的3個結果分別以加粗、下劃線和陰影表示.可以直觀地看出,本文提出的方法在結果上并沒有超過EDSR[37].究其原因,在網絡結構上,兩者都采用殘差塊作為網絡的基本組成單元.所不同的是,本文提出的方法僅使用了6個殘差塊,EDSR[37]使用了32個.而之前的相關工作已經可以證明,結構很深的網絡使得能夠根據更多的像素即更大的區域來預測目標像素信息,超分辨率重建的效果也更好.但在其他方面,本文提出的方法也具有一定的優勢,如訓練速度和運行速度更快、硬件要求低等.而與其他方法相比,本文方法對于縮放尺度x4和x8,實驗結果最優.

Table 3 Quality evaluation of different algorithms表3 不同方法的質量評價

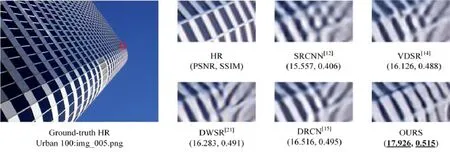

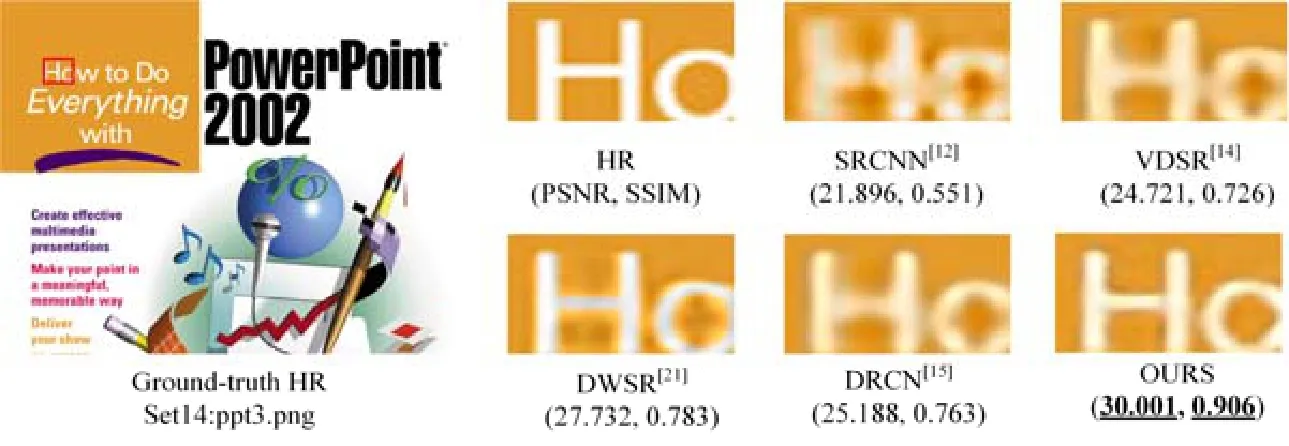

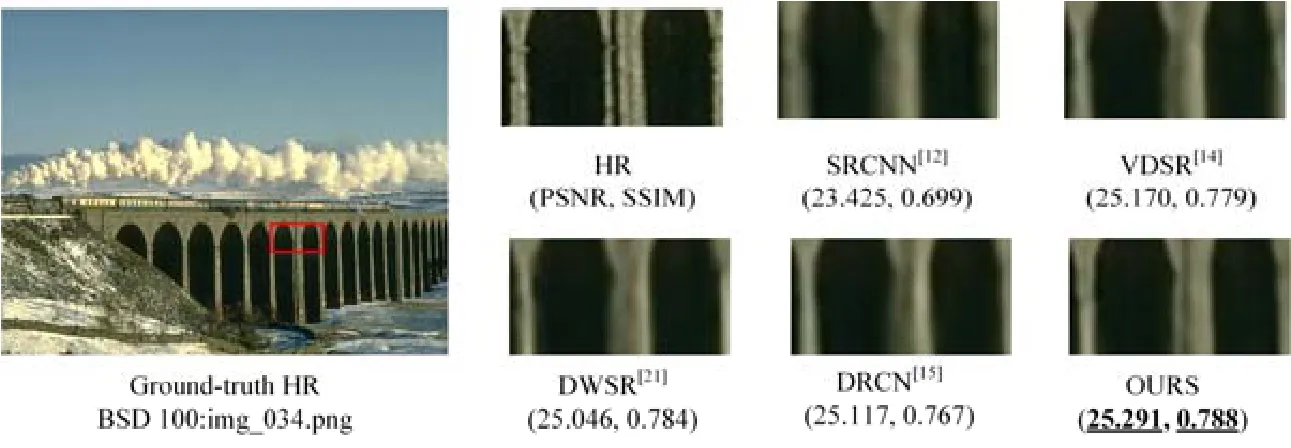

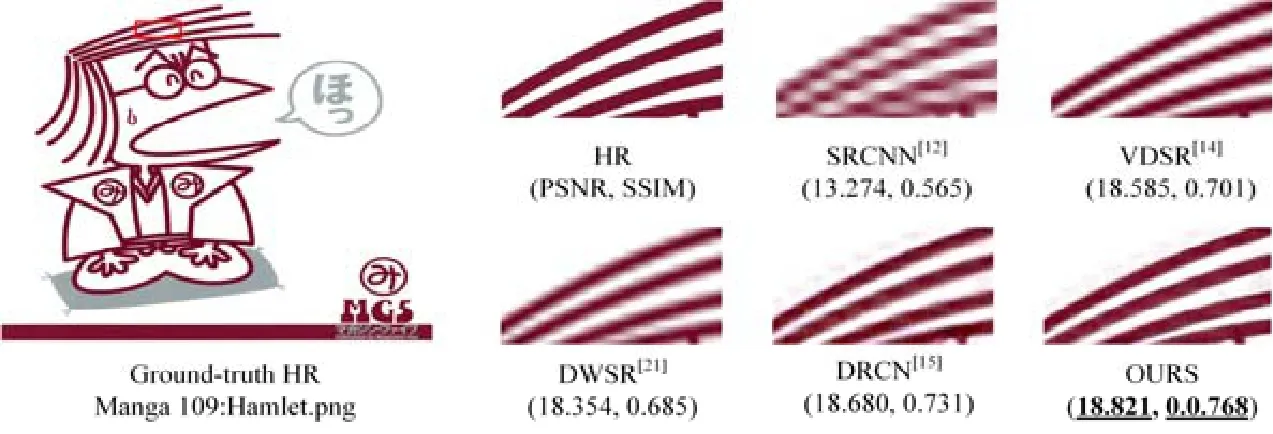

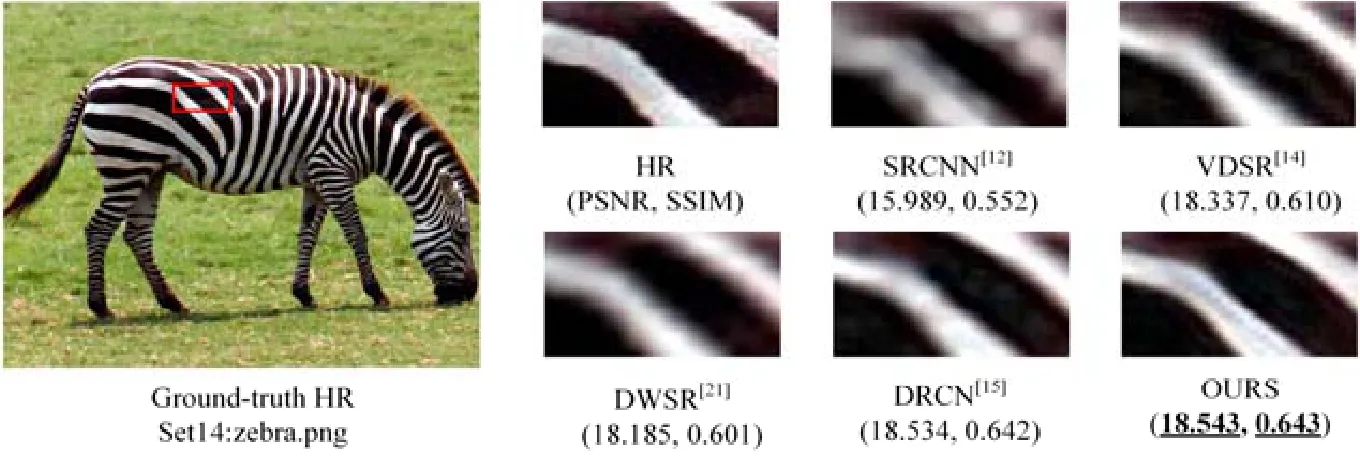

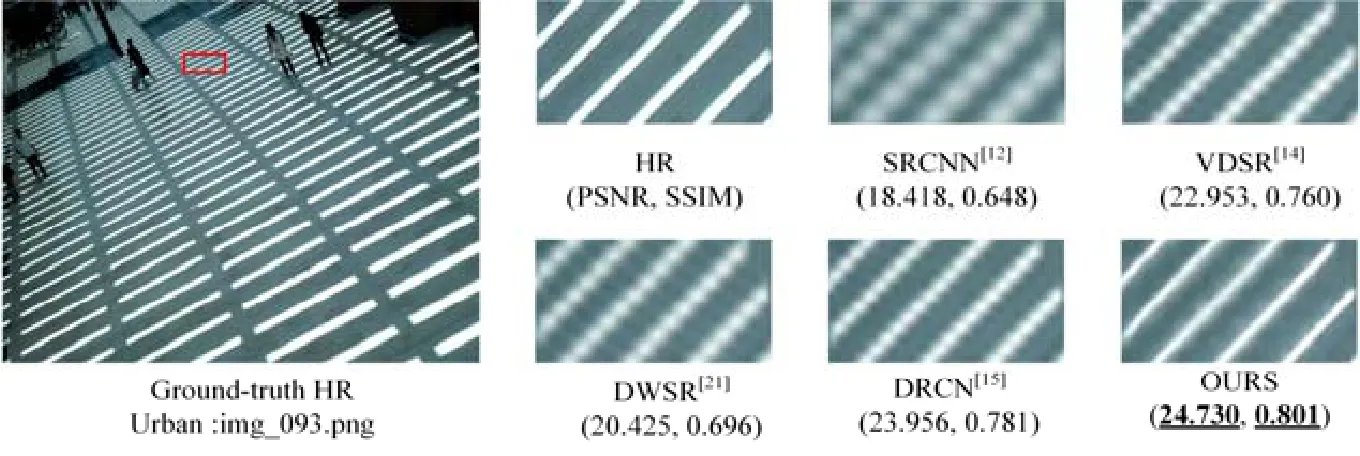

圖4~圖9展示了從上述幾種數據集挑選的例子圖像在不同方法重建后視覺效果的比較情況.如圖4和圖7所示,本文方法生成的圖像線條不僅沒有扭曲,而且更加清晰和銳利,而其他結果中線條邊緣比較模糊,有的甚至還有重影的現象.圖 5所示本文方法產生的結果比較好地保留了字母的邊緣信息,視覺上看起來更加完整和規范.從圖 6中可以看出,本文的結果較好地保留了兩個橋洞之間的石縫,而其他方法顯示的結果并不能很好地體現這一細節信息.如圖8所示,本文的結果將斑馬身上的紋路更加清晰地恢復出來,而其他的結果則較為模糊.在圖 9中,能夠明顯地看出來,本文方法產生的結果將人行道上白色線條筆直且清晰地恢復出來,邊緣的部分也更加銳利.而其他結果則比較模糊,線條邊緣呈鋸齒狀.

總的來說,由示例圖可以很明顯地看出,無論是縮放系數為 x4還是 x8,相較除EDSR[37]以外的其他方法,本文采用的方法能夠更好地保留細節信息,同時使邊緣部分更加銳利和清晰,擁有更好的重建效果.

Fig.4 Super-resolution results of “img_005.png (Urban 100)” with scale factor x4圖4 縮放因子為x4的圖像img_005.png(Urban100)的超分辨率結果

Fig.5 Super-resolution results of “ppt3.png (Set14)” with scale factor x4圖5 縮放因子為x4的圖像ppt3.png(Set14)的超分辨率結果

Fig.6 Super-resolution results of “img_034.png (BSD100)” with scale factor x4圖6 縮放因子為x4的圖像img_034.png(BSD100)的超分辨率結果

Fig.7 Super-resolution results of “Hamlet.png (Manga 109)” with scale factor x8圖7 縮放因子為x8的圖像Hamlet.png(Manga 109)的超分辨率結果

Fig.8 Super-resolution results of “zebra.png (Set14)” with scale factor x8圖8 縮放因子為x8的圖像zebra.png(Set14)的超分辨率結果

Fig.9 Super-resolution results of “img_93.png (Urban 100)” with scale factor x8圖9 縮放因子為x8的圖像img_93.png(Urban 100)的超分辨率結果

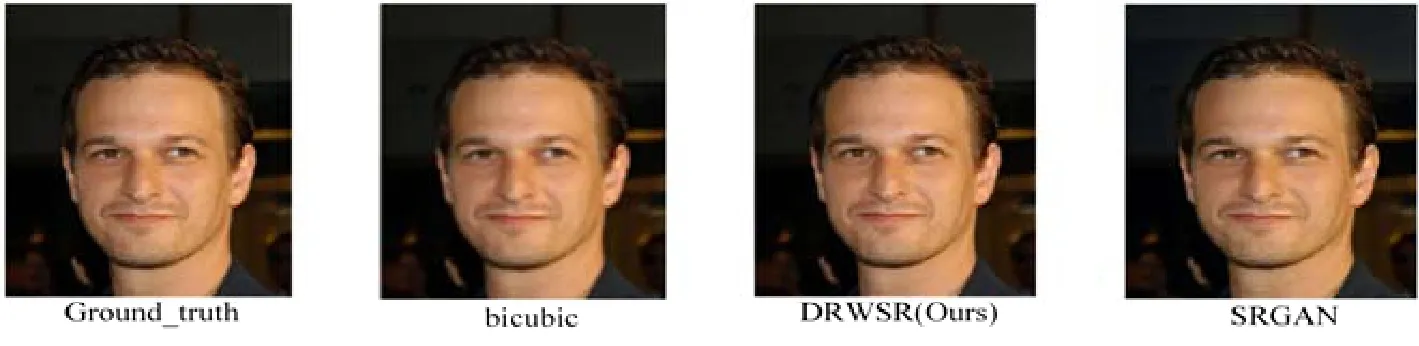

4.3.1 與SRGAN對比

對于利用對抗網絡生成的SR圖像,單從PSNR和SSIM指標上來看,效果并不好.但從圖10所示的視覺效果上來看,重建后的 SR圖像更加逼真和銳利.但是如圖 11所示,對細節部分進行放大操作后可以看出,SRGAN生成的圖像多了一些偽像,合成了很多奇怪的紋路.這一結果不利于后續高水平計算機視覺任務的進行.

Fig.10 Super-resolution results of “00016.png (CelebA)” with scale factor x2圖10 縮放因子為x2的圖像00016.png(CelebA)的超分辨率結果

Fig.11 Result of zooming in the details of image generated by SRGAN圖11 對SRGAN生成圖像細節放大的結果

4.4 局限性

從結果可以看出,本文提出的網絡在縮放系數x4和x8的情況下,效果會有大幅度的提升.對于小的縮放倍數 x2,效果也不錯.但是并沒有超越其他最優的方法.通過分析小波變換的特性可以發現,隨著縮放因子的增大,小波變換的水平也在提高,圖像的細節信息進一步被細化,可以通過網絡更好地去推理圖像缺失的細節,從而實現更好的效果.實驗結果也進一步說明,利用小波分解的方式更適合于較大的縮放系數.同時,考慮到縮放倍數與最終輸出的小波系數個數的映射關系,本文的方法只能處理特定的 2n的縮放倍數,無法處理一般方法中采用的x3的情況.

5 結 論

本文提出一種基于小波域的深度殘差網絡的圖像超分辨率算法.在網絡設計方面,不僅結構簡單,并且與其他神經網絡結構相比,能夠更加有效地捕捉圖像細節信息.同時,使用跨連和殘差學習的方式來減少訓練模型的難度.在損失函數方面,本文同時使用原始圖像空間域和小波域下產生的損失,加強網絡訓練的約束.實驗結果表明,本文提出的算法在視覺效果和峰值信噪比(PNSR)方面都取得了更好的效果.