單目視覺和二維激光雷達的配準與融合

(浙江省杭州第二中學 浙江 杭州 310052)

一、引言

單目視覺可以實現實時跟蹤檢測和跟蹤精度,確定相對于人體信道的橫向位置,但由于透視變換的影響,在縱向距離測量中準確,存在一定的缺點。

與此相反,激光雷達能夠準確地估計距離、抵抗環境變化的能力,并能提供圖像無法獲得的附加信息。因此,無人機應用的自適應巡航控制系統主要是利用激光雷達傳感器實現的。在卡內基梅隆大學博士學位論文中,詳細介紹了一種基于激光雷達的無人機探測系統。然而,這種傳感器使用窄波束寬度檢測在Langer面前無人機。更重要的是,激光雷達的橫向分辨率低,不能直接增強對信道場景的感知,如不識別信道結構、識別障礙物、無法識別無人機是否處于當前信道等。

根據本文的背景,我們設計的融合方案是:單目視覺傳感器獲取信道信息,無人機單目視覺障礙信息和激光雷達傳感器同時檢測,信息和提取分別進行,然后綜合結果,提高系統的魯棒性。一個完美的跟蹤系統應該能夠回答兩個問題:是否有無人機和無人機前方的障礙物。融合的目的是減少誤報和泄漏報警,并提供示蹤劑的距離。

本文分為兩部分:融合算法的研究與仿真。在該算法中的一部分,分別研究了單目視覺傳感器和激光雷達傳感器信息融合算法的決策水平和決策水平的D-S證據理論的特征級信息用于確定是否有融合,目標跟蹤;采用自適應加權平均法的特征級融合,目的是用示蹤劑估計無人機的距離。在仿真實驗部分,利用虛擬實驗技術設計了虛擬實驗環境,對單眼觀察器和激光雷達傳感器進行了仿真,并對所得自適應加權平均融合算法進行了仿真。創建虛擬實驗環境克服了實驗工具的客觀困難,并顯著降低了開發實驗室算法的成本。取得了良好的效果。

二、本文算法概述

(一)傳感器選擇

現有的無人機實時跟蹤系統主要采用有源傳感器作為環境監測傳感器。利用有源傳感器探測無人機障礙物的基本思想是無人機的存在導致距離映射的不連續性,其優點是直接獲得目標距離。

由于硬件成本的急劇下降和處理器速度的迅速提高,被動傳感器在實時飛機監控領域的應用成為一個新的研究熱點。本文研究了一種單目視覺傳感器無源傳感器,用于獲取目標前方的目標圖像,研究了利用圖像處理技術測量距離的算法。

基于單目視覺傳感器與距離傳感器相結合的多傳感器聯合算法是一種非常有效的算法。考慮到傳感器的性能,選擇單目視覺和激光雷達傳感器信息并融合它們是非常有意義的。也是國內外無人機技術研究的一個重要發展方向。考慮到設備成本,提出了一種毫米波激光雷達與單攝像機融合的障礙物檢測方法。這是最經濟的方案,因為至少需要一臺照相機來檢測信道標記。由于無人機在其他信道中,僅需要一個激光雷達跟蹤無人機前方的無人機。

(二)兩級融合算法

我們設計的融合方案是:單目視覺傳感器獲取信道信息,單目視覺和激光雷達傳感器同時檢測無人機障礙物信息。分別對信息進行了豐富和細化,并對結果進行綜合,提高了系統的魯棒性。

根據該方案,分別研究了單目視覺傳感器和激光雷達傳感器信息在決策層和特征層上的信息融合算法。決策層融合的目的是選擇合適的決策規則,結合激光雷達和單目視覺系統的檢測結果,更可靠地判斷無人機前方是否存在障礙物。

一般來說,融合是一個從低到高的多源信息集成過程。然而,在該文檔的應用中,必須使用決策級融合結果反饋屬性層信息的融合控制。

三、決策級融合—判斷是否存在追蹤物

單目視覺傳感器和激光雷達傳感器分別在各自的數據處理后跟蹤目標。然后將相應的本地決策輸入到決策層中融合和生產的全局考慮中。冗余數據處理可顯著減少一個傳感器檢測到的誤報和泄漏。

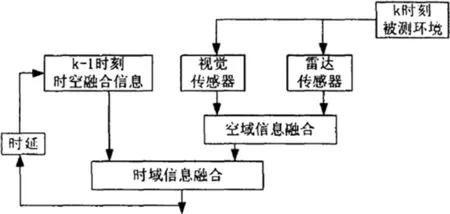

因為只有一個鏡頭的結果可能會造成誤報警或誤報警,本文采用時空融合方法:首先根據同時傳感器空間局部決策融合;然后,融合結果下一拍的時域連續融合,3拍攝示蹤最終確定的存在后融合。提高算法的可靠性。決策層融合是基于D-S證據理論的。時空融合策略如圖1所示。

圖1 決策級時空信息融合框圖

四、特征級融合—判斷追蹤物距離

單目視覺傳感器價格低廉,能提供大量的場景細節信息。本文采用兩種傳感器同時對同一目標進行距離數據的反射,并通過自適應加權計算計算距離的最終值。基本加權平均算法簡單。在處理過程中,沒有必要考慮傳感器陣列測量矩陣和參數狀態轉移矩陣信息,但是在處理過程中會丟棄大量有用信息,這會影響算法的可靠性。因此,自適應加權用于確定融合權重,提高了算法的性能。

融合方法采用無反饋的圖像融合和激光雷達數據的同步融合,即首先利用激光雷達數據和圖像檢測建立各自的目標航跡,然后融合激光雷達和圖像檢測。

五、建立虛擬實驗環境

由于激光雷達設備不到位,現場試驗暫時無法進行。但是單目視覺和其他傳感器很難用數學模型來模擬。基于雙傳感器融合的實時跟蹤任務,很難通過單傳感器仿真實現算法測試和研究。理想的仿真系統可以模擬單目視覺與激光雷達傳感器的融合,產生真實的動態實時傳感器反饋。算法處于開發階段,通過計算機仿真可以大大降低實驗室開發的成本。

許多研究機構已經認識到虛擬實驗環境在無人機技術研究和發展中的重要作用,并開始做相關研究。卡內基夏威夷大學梅隆大學機器人系高速公路仿真系統和智能實時監控系統。目前,國內虛擬現實技術在無人機鄰域的研究中還沒有得到廣泛的發展。昆明理工大學開發了一個模擬真實路段和交通評價的模擬器,重型蒸汽技術中心也進行了類似的研究。

(一)單目視覺傳感器的模擬

首先利用OpenGL的紋理貼圖技術實現航道、白色短劃線和風景:繪制一個通道到GL_QUADS廣場并將通道結構,草,樹木,建筑物和其他模式粘貼到一個正方形以獲得真實的通道視圖,在通道的兩側均勻地繪制一個,稱為GlColorQ,是白色,可以產生白線。

然后3ds模型無人機看作為示蹤劑,采用OpenGL作為無人機的觀點(視覺傳感器),根據無人機輛運動模型,對汽無人機實時計算當前位置,叫gluperspective()函數建立虛擬場景在OpenGL窗口可見,實現三維場景圖掛在一個二維圖像前打電話給gltranslate()函數;移動無人機的位置,glulookatq功能設置的單目視覺傳感器的位置跟蹤,以及無人機的相對位移將引起一個國王轉化領域的OpenGL窗口,導致運動的影響。

最后,調用glReadPixels()函數來記錄當前OpenGL視圖窗口的實時顯示,并且將單目視覺傳感器檢測圖像發送到下一圖像處理模塊,以檢測和跟蹤信道和無人機。

(二)激光雷達傳感器的模擬

激光雷達傳感器模型模擬前視碰撞預警激光雷達的輸出,計算激光雷達返回的場景中目標的距離、速度、方位角。

仿真時,分別建立本無人機和目標物體的運動模型。激光雷達的檢測概率指定為Pd,激光雷達雜波個數服從均值為λ的泊松分布P(λ)。雜波在激光雷達傳感器探測范圍內均勻分布,設雜波密度為f(個/米2)探測區域而積為S(米2),則λ=f·s。

仿真時,設第k次量測的雜波個數為N(k),則由泊松分布P(幻可以確定當前的N(k),將這N(k)個雜波均勻分布在探測區域就可以實現雜波的模擬,激光雷達量測噪聲通常為服從N(0,σ2)的高斯噪聲。

則由卡爾曼濾波可以得到激光雷達關于目標物體各個時刻的狀態估計。

六、仿真實驗方案及結果

(一)實驗方案

在第五章設計的無人機防偏防撞的單目視覺輔助實時追蹤系統平臺基礎土,擴展了一個虛擬仿真模塊。

在虛擬仿真模塊中,對基于自適應加權平均的自適應融合算法進行了仿真,比較了單目視覺的遠程測量結果,激光雷達的實際數據和融合方法,并評估了融合算法的性能。在實驗中,無人機保持恒定速度,根據示蹤劑的不同驅動條件設計了五個主要場景。對于每一個場景,計算單目視覺的均方根誤差、激光雷達和融合方法以及實際距離值,以此作為判斷某一時刻檢測方法性能的依據。5個測試場景如下:

1.追蹤物以定速度運動,速度與本無人機相同

2.追蹤物以定速度運動,速度比本無人機速度大

3.追蹤物以定速度運動,速度比本無人機速度小

4.追蹤物做加速運動

5.追蹤物做減速運動

(二)實驗結果

以第二個測試場景為例,跟蹤器以72km/h的恒定速度運行。本無人機以58公里/小時的時速緊跟其后,實驗采樣率為10幀/秒。

對測距公式中的攝像機參數進行定標。根據追蹤物和本無人機的運動方程,可以精確計算當前的實際距離,選取30組實際距離和對應追蹤物檢測結果,用最小二乘算法離線計算出當前實驗環境下的參數ay和v0。

表1 追蹤物檢測結果與實際距離對照

計算經過添加隨機噪聲和雜波模擬的激光雷達量測信號。

采用的激光雷達量測噪聲均值和方差為muX=0,sigmaX=0.1,muY=0,sigmaY=2,激光雷達檢測概率為Pd=0.9。

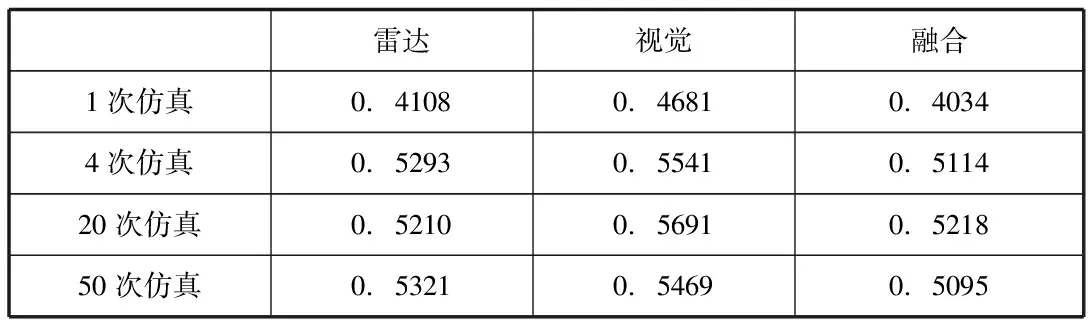

首先,模擬圖像測量和激光雷達信號是卡爾曼濾波,在實驗中,兩個傳感器的初始估計誤差為0.4,模型的噪聲方差為0.1。然后,使用所提出的用于融合兩個濾波信息的自適應加權平均方法來獲得新的范圍值。下表為1次,4次,20次,50次仿真模擬結果的均方根誤差。

表2 100拍內的測距均方根誤差

總結

本文的主要工作是進一步研究單目視覺/激光雷達融合實時跟蹤算法和基于單目視覺實時跟蹤關鍵技術的仿真。首先介紹了本文提出的決策級和特征級融合方法,并基于Opengl的二維圖形系統開發技術,設計了虛擬實驗環境,多傳感器融合系統仿真平臺和仿真實驗中的融合方法。在本文中,所提出的融合跟蹤方法的自定義加權平均值是虛擬實驗發現該方法獲得的距離測量結果比單傳感器獲得的距離測量結果更精確。