多標記學習算法的簡要概述

李星星

摘要:在如今的機器學習領域內,不再是簡單的單標記算法,其對象(樣本)具有多個語義(多個類標)。像這樣的樣本數據可看作為多標記數據樣本,所對應的學習方法稱之為多標記學習(Multi-label learning)法。

關鍵詞:機器學習;單標記學習;多標記學習

一、多標記學習概述

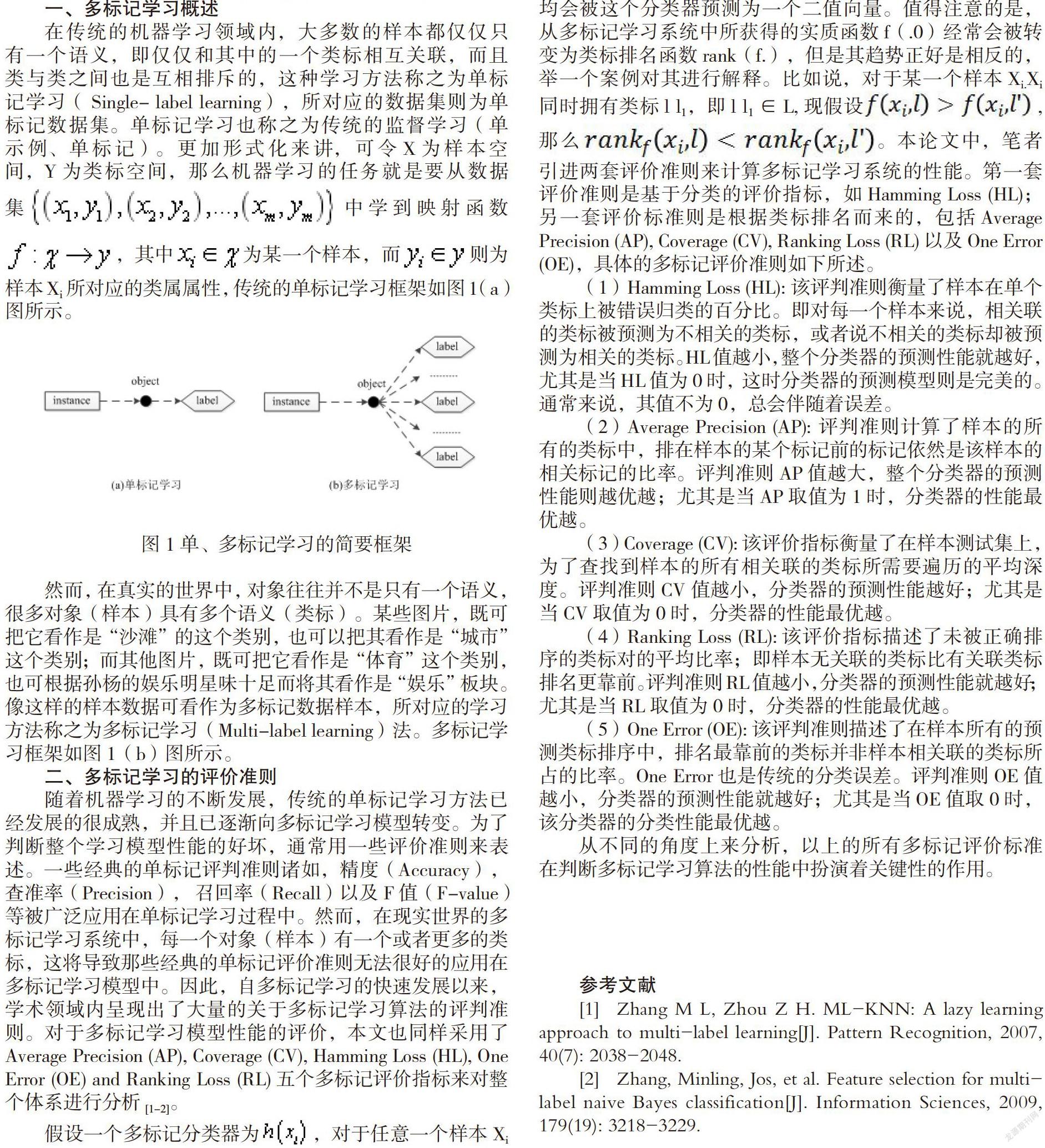

在傳統的機器學習領域內,大多數的樣本都僅僅只有一個語義,即僅僅和其中的一個類標相互關聯,而且類與類之間也是互相排斥的,這種學習方法稱之為單標記學習( Single- label learning),所對應的數據集則為單標記數據集。單標記學習也稱之為傳統的監督學習(單示例、單標記)。更加形式化來講,可令X為樣本空間,Y為類標空間,那么機器學習的任務就是要從數據集中學到映射函數,其中為某一個樣本,而則為樣本Xi所對應的類屬屬性,傳統的單標記學習框架如圖1(a)圖所示。

二、多標記學習的評價準則

隨著機器學習的不斷發展,傳統的單標記學習方法已經發展的很成熟,并且已逐漸向多標記學習模型轉變。為了判斷整個學習模型性能的好壞,通常用一些評價準則來表述。一些經典的單標記評判準則諸如,精度(Accuracy), 查準率(Precision), 召回率(Recall)以及F值(F-value)等被廣泛應用在單標記學習過程中。然而,在現實世界的多標記學習系統中,每一個對象(樣本)有一個或者更多的類標,這將導致那些經典的單標記評價準則無法很好的應用在多標記學習模型中。因此,自多標記學習的快速發展以來,學術領域內呈現出了大量的關于多標記學習算法的評判準則。對于多標記學習模型性能的評價,本文也同樣采用了Average Precision (AP), Coverage (CV), Hamming Loss (HL), One Error (OE) and Ranking Loss (RL)五個多標記評價指標來對整個體系進行分析[1-2]。

假設一個多標記分類器為,對于任意一個樣本Xi均會被這個分類器預測為一個二值向量。值得注意的是,從多標記學習系統中所獲得的實質函數f(.0)經常會被轉變為類標排名函數rank(f.),但是其趨勢正好是相反的,舉一個案例對其進行解釋。比如說,對于某一個樣本Xi.Xi同時擁有類標l l1,即l l1∈L,現假設, 那么。本論文中,筆者引進兩套評價準則來計算多標記學習系統的性能。第一套評價準則是基于分類的評價指標,如Hamming Loss (HL);另一套評價標準則是根據類標排名而來的,包括Average Precision (AP), Coverage (CV), Ranking Loss (RL) 以及One Error (OE),具體的多標記評價準則如下所述。

(1)Hamming Loss (HL): 該評判準則衡量了樣本在單個類標上被錯誤歸類的百分比。即對每一個樣本來說,相關聯的類標被預測為不相關的類標,或者說不相關的類標卻被預測為相關的類標。HL值越小,整個分類器的預測性能就越好,尤其是當HL值為0時,這時分類器的預測模型則是完美的。通常來說,其值不為0,總會伴隨著誤差。

(2)Average Precision (AP): 評判準則計算了樣本的所有的類標中,排在樣本的某個標記前的標記依然是該樣本的相關標記的比率。評判準則AP值越大,整個分類器的預測性能則越優越;尤其是當AP取值為1時,分類器的性能最優越。

(3)Coverage (CV):該評價指標衡量了在樣本測試集上,為了查找到樣本的所有相關聯的類標所需要遍歷的平均深度。評判準則CV值越小,分類器的預測性能越好;尤其是當CV取值為0時,分類器的性能最優越。

(4)Ranking Loss (RL):該評價指標描述了未被正確排序的類標對的平均比率;即樣本無關聯的類標比有關聯類標排名更靠前。評判準則RL值越小,分類器的預測性能就越好;尤其是當RL取值為0時,分類器的性能最優越。

(5)One Error (OE): 該評判準則描述了在樣本所有的預測類標排序中,排名最靠前的類標并非樣本相關聯的類標所占的比率。One Error也是傳統的分類誤差。評判準則OE值越小,分類器的預測性能就越好;尤其是當OE值取0時,該分類器的分類性能最優越。

從不同的角度上來分析,以上的所有多標記評價標準在判斷多標記學習算法的性能中扮演著關鍵性的作用。

參考文獻

[1] Zhang M L, Zhou Z H. ML-KNN: A lazy learning approach to multi-label learning[J]. Pattern Recognition, 2007, 40(7): 2038-2048.

[2] Zhang, Minling, Jos, et al. Feature selection for multi-label naive Bayes classification[J]. Information Sciences, 2009, 179(19): 3218-3229.