基于對(duì)抗網(wǎng)絡(luò)的車牌數(shù)據(jù)生成與識(shí)別

黃錦濤

摘 要 為提高深度學(xué)習(xí)技術(shù)在不同環(huán)境中的識(shí)別率,本文利用四種生成式對(duì)抗網(wǎng)絡(luò)生成不同環(huán)境的數(shù)據(jù),包括模糊和拍攝角度不理想等情形,最后采用卷積神經(jīng)網(wǎng)絡(luò)識(shí)別生成數(shù)據(jù)。實(shí)驗(yàn)表明:四種網(wǎng)絡(luò)中循環(huán)生成對(duì)抗網(wǎng)絡(luò)生成的數(shù)據(jù)效果最好,并且平均識(shí)別率達(dá)到85%,表明生成對(duì)抗網(wǎng)絡(luò)模型生成的數(shù)據(jù)可以用于訓(xùn)練識(shí)別復(fù)雜環(huán)境下的深度模型,達(dá)到了擴(kuò)充數(shù)據(jù)的目的。

關(guān)鍵詞 生成式對(duì)抗網(wǎng)絡(luò);數(shù)據(jù)增強(qiáng);車牌識(shí)別

前言

車牌識(shí)別技術(shù)已經(jīng)在日常環(huán)境中的應(yīng)用日益成熟,但是當(dāng)天災(zāi)人禍來(lái)臨國(guó)家搶險(xiǎn)救災(zāi)時(shí),需要在惡劣復(fù)雜的環(huán)境下識(shí)別救援車輛,根據(jù)救援內(nèi)容對(duì)人員和車輛進(jìn)行調(diào)度。所以快速識(shí)別車牌對(duì)于時(shí)間就是生命的救援現(xiàn)場(chǎng)有著重要意義。由于環(huán)境的復(fù)雜與惡劣性,傳統(tǒng)的識(shí)別方法無(wú)法有效應(yīng)用于救災(zāi)現(xiàn)場(chǎng)的車輛識(shí)別,所以如何實(shí)現(xiàn)復(fù)雜環(huán)境下的車牌識(shí)別成為一個(gè)亟待解決的問(wèn)題。

傳統(tǒng)車牌識(shí)別方法采用特征提取的方法,對(duì)圖像先預(yù)處理后再經(jīng)神經(jīng)網(wǎng)絡(luò)進(jìn)行識(shí)別。Li提出了一種無(wú)須分割使用深度卷積神經(jīng)網(wǎng)絡(luò)和LSTM進(jìn)行車牌識(shí)別的級(jí)聯(lián)框架[1]。Gao運(yùn)用深度神經(jīng)網(wǎng)絡(luò)用于特征提取[2]。為滿足深度學(xué)習(xí)所需的復(fù)雜環(huán)境數(shù)據(jù)集,傳統(tǒng)的擴(kuò)充數(shù)據(jù)方法除了人工收集外,還有向原始圖像中添加噪聲、畸變和模糊處理,但是圖像的生成質(zhì)量卻無(wú)法達(dá)到深度學(xué)習(xí)訓(xùn)練所需的要求,所以本文采用生成對(duì)抗網(wǎng)絡(luò)擴(kuò)充數(shù)據(jù)。

1方法

生成對(duì)抗網(wǎng)絡(luò)(GAN)通過(guò)對(duì)抗訓(xùn)練得到生成模型與判別模型,它可以通過(guò)以類標(biāo)簽為條件生成對(duì)應(yīng)的圖像[3]。GAN主要是由生成器網(wǎng)絡(luò)和判別器網(wǎng)絡(luò)兩部分網(wǎng)絡(luò)構(gòu)成,通過(guò)兩個(gè)網(wǎng)絡(luò)的博弈,讓生成器網(wǎng)絡(luò)最終能夠?qū)W習(xí)到輸入數(shù)據(jù)的分布然后輸出數(shù)據(jù)。生成器網(wǎng)絡(luò)接受一個(gè)隨機(jī)噪聲并生成數(shù)據(jù),判別器網(wǎng)絡(luò)通過(guò)對(duì)輸入的真實(shí)數(shù)據(jù)和由生成的假數(shù)據(jù)進(jìn)行判斷。通過(guò)兩個(gè)網(wǎng)絡(luò)的互相博弈,最終使整個(gè)網(wǎng)絡(luò)達(dá)到納什均衡。當(dāng)判別器無(wú)法判別真假數(shù)據(jù)時(shí),此時(shí)生成器的輸出接近真實(shí)數(shù)據(jù)。

2實(shí)驗(yàn)結(jié)果

2.1 實(shí)驗(yàn)環(huán)境與數(shù)據(jù)

本文的實(shí)驗(yàn)環(huán)境為:CPU-2.21GHz,RAM-16GB,顯卡GTX-1070,Tensorflow框架,版本1,12.0和Pycharm編譯環(huán)境。將不同的環(huán)境下10,000張車牌數(shù)據(jù)處理成150 * 150像素的RGB圖像,然后數(shù)據(jù)進(jìn)行裁剪,最終將其轉(zhuǎn)換為TF記錄格式,劃分為30個(gè)TF記錄文件。

2.2 生成圖像實(shí)驗(yàn)細(xì)節(jié)

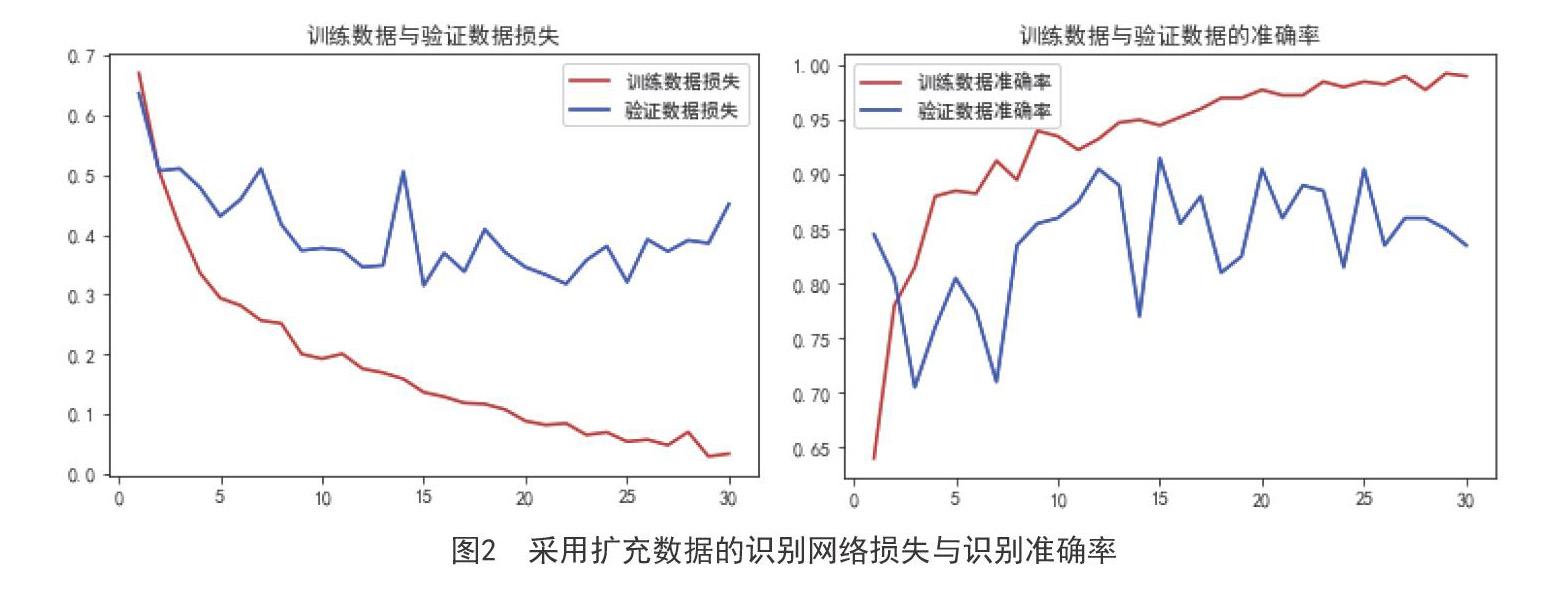

在10000張車牌上訓(xùn)練GAN,DCGAB、WGAN和CycleGAN模型。原始GAN模型的學(xué)習(xí)率設(shè)為0.0001,每個(gè)輪次結(jié)束后保存模型,并在200個(gè)輪次后停止訓(xùn)練。訓(xùn)練DCGAN模型時(shí)設(shè)置學(xué)習(xí)率為0.0001,betel為0.5,批量大小為256,保存每個(gè)輪次結(jié)束后的模型,并在30輪次后停止訓(xùn)練。輸出尺寸設(shè)置為64,生成器的每層網(wǎng)絡(luò)結(jié)構(gòu)的輸出分別為:64*64, 32*32, 16*16, 8*8,4*4,判別器中的卷積層的輸出分別為:32*32, 16*16, 8*8, 4*4。訓(xùn)練WGAN的模型時(shí),dieter設(shè)置為0.7,每次梯度更新之后將判別器的參數(shù)調(diào)整到[-0.01,0.01]。WGAN的學(xué)習(xí)率為0.0005,批量大小為256。生成器中每層網(wǎng)絡(luò)的輸出特征數(shù)量為512,256,128,32,判別器中每層網(wǎng)絡(luò)特征數(shù)量分別為64,128,256,512。設(shè)置CycleGAN模型的基礎(chǔ)學(xué)習(xí)率為0.0002,設(shè)置為10.0,betel設(shè)置為0.6,設(shè)置輪次為300,在每100步后保存訓(xùn)練模型與訓(xùn)練日志。實(shí)驗(yàn)最后獲得20000張車牌數(shù)據(jù)。

圖1展示部分實(shí)驗(yàn)結(jié)果,可直觀看出CycleGAN網(wǎng)絡(luò)模型生成的數(shù)據(jù)更接近真實(shí)數(shù)據(jù),WGAN模型和DCGAN模型產(chǎn)生的效果次之,原始GAN模型經(jīng)常遇到模型崩潰導(dǎo)致難以訓(xùn)練的問(wèn)題,難以生成理想圖像。

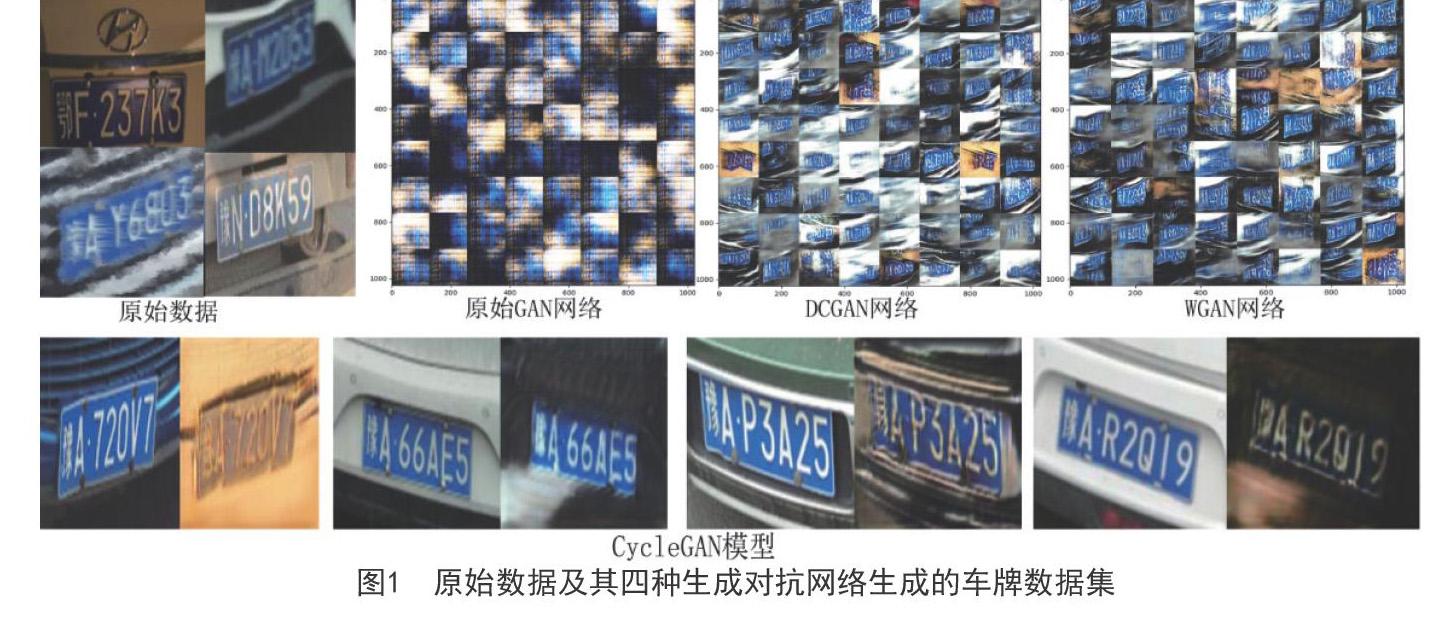

2.3 生成圖像識(shí)別

將通過(guò)CycleGAN網(wǎng)絡(luò)模型生成的20000張車牌數(shù)據(jù)按其70%劃分為訓(xùn)練集,30%作為測(cè)試集。本文利用可以識(shí)別車牌的卷積神經(jīng)網(wǎng)絡(luò)模型識(shí)別數(shù)據(jù),測(cè)試生成圖像數(shù)據(jù)的識(shí)別準(zhǔn)確率。

從圖2結(jié)果可以看出識(shí)別網(wǎng)絡(luò)在訓(xùn)練集和驗(yàn)證集上隨著迭代次數(shù)增加識(shí)別錯(cuò)誤率降級(jí),識(shí)別的正確率逐漸上升,平均識(shí)別率達(dá)到85%,這表明生成對(duì)抗網(wǎng)絡(luò)模型生成的數(shù)據(jù)可以用于深度卷積神經(jīng)網(wǎng)絡(luò)的測(cè)試集,用于訓(xùn)練識(shí)別復(fù)雜環(huán)境下的深度模型,達(dá)到了擴(kuò)充數(shù)據(jù)的目的。

3結(jié)束語(yǔ)

本文對(duì)復(fù)雜環(huán)境下的車牌擴(kuò)充數(shù)據(jù)方法和可行性進(jìn)行了分析研究,針對(duì)深度學(xué)習(xí)識(shí)別車牌缺乏復(fù)雜環(huán)境下車牌數(shù)據(jù)的問(wèn)題,利用GAN,DCGAN,WGAN和CycleGAN網(wǎng)絡(luò)進(jìn)行車牌數(shù)據(jù)增強(qiáng),驗(yàn)證了幾種對(duì)抗生成網(wǎng)絡(luò)的性能并測(cè)試了生成數(shù)據(jù)的識(shí)別準(zhǔn)確率。通過(guò)實(shí)驗(yàn)發(fā)現(xiàn)CycleGAN擴(kuò)充數(shù)據(jù)效果最好,WGAN模型產(chǎn)生的效果次之,DCGAN模型和原始GAN模型經(jīng)常遇到模型難以訓(xùn)練和崩潰的問(wèn)題,無(wú)法生成理想圖像。而且擴(kuò)充數(shù)據(jù)的平均識(shí)別率都能達(dá)到85%,這表明生成對(duì)抗網(wǎng)絡(luò)模型生成的數(shù)據(jù)可以用于深度卷積神經(jīng)網(wǎng)絡(luò)的測(cè)試集,用于訓(xùn)練識(shí)別復(fù)雜環(huán)境下的深度模型,達(dá)到了擴(kuò)充數(shù)據(jù)的目的。本文尚存一些改進(jìn)的地方,如沒(méi)有嘗試更多復(fù)雜優(yōu)化的對(duì)抗網(wǎng)絡(luò)模型的數(shù)據(jù)增強(qiáng)方法和模型評(píng)價(jià)標(biāo)準(zhǔn),接下來(lái)將在這方面做更深入研究并考慮將文本表示和圖像樣式之間的映射應(yīng)用于車牌數(shù)據(jù)的生成問(wèn)題。

參考文獻(xiàn)

[1] H. Li.C. Shen. Reading car license plates using deep convolutional neural networks and lstms [J]. arXiv preprint arXiv.2016:1601.

[2] Gao Q.Wang X.Xie G. License Plate Recognition Based On Prior Knowledge[C].Automation and Logistics, 2007 IEEE International Conference on. IEEE, 2007:2964-2968.

[3] Reed S.Akata Z.Yan X.et al. Generative Adversarial Text to Image Synthesis[J]. In Proceedings of International Conference on Machine Learning.2016.(3):177.

[4] Radford A.Metz L.Chintala S. Unsupervised representation learning with deep convolutional generative adversarial networks[J].Computer Science.2015.1(1):1-19 .

[5] T. Salimans.I. Goodfellow.W. Zaremba.et al.Improved techniques for training gans[J].In Advances in Neural Information Processing Systems.2016.(1):2226-2234.