面向行為識別的人體空間協同運動結構特征表示與融合

莫宇劍,侯振杰,*,常興治,梁久禎,陳宸,宦娟

(1.常州大學 信息科學與工程學院,常州213164; 2.常州信息職業技術學院 智能制造工業云開放實驗室,常州213164;3.北卡羅來納大學夏洛特分校 電氣與計算機工程系,夏洛特市28223)

行為識別實現了計算機對人體行為的理解與描述,是視頻監控[1]、智能看護、人機交互[2]等領域的關鍵技術。人體行為識別的研究具有廣泛的應用前景以及可觀的經濟價值[3]。執行不同動作時,不同身體部位的協同運動結構特征是行為識別的難題。現今行為識別的方法大致分為3類:①利用單一模態的行為數據進行人體行為識別;②利用多個不同模態的行為數據進行人體行為識別;③利用單一模態內的不同人體部位間的協同運動結構特征進行行為識別。

利用單一模態的行為數據進行人體行為識別,學者們已經提出了許多成熟的算法。按行為識別算法使用的數據類型大致分為:①基于深度圖像的人體行為識別,如DMM-LBP-FF(Depth Motion Maps-based Local Binary Patterns-Feature Fusion)[4]、HOJ3D(Histograms of 3D Joint locations)[5]等;②基于骨骼數據的人體行為識別,如協方差描述符[6]等;③基于慣性傳感器數據的人體行為識別,如函數擬合[7]等。

利用多個不同模態的行為數據進行人體行為識別,也有很多的學者進行了研究。多模態行為數據的融合大致可以分為2類:特征級融合和決策級融合[8]。常見的特征級融合方法有CRC(Collaborative Representation Classifier)[9]、SRC(Sparse Representation Classifier)[10]、CCA(Canonical Correlation Analysis)[11]、DCA(Discriminant Correlation Analysis)[12]等。決 策 級 融 合 方 法 如DS(Dempster-Shafer)證據理論[10]、多學習器協同訓練[13]。

利用單一模態內的不同人體部位間的協同運動結構特征進行行為識別,目前已有少量的研究。Si等[14]提出空間推理網絡,其利用Kinect采集的人體關節點位置數據來捕捉每個幀內的高級空間結構特征。首先將身體每個部位的連接轉換成具有線性層的單獨空間特征,然后將身體部位的個體空間特征輸入到殘差圖神經網絡(Residual Graph Neutral Network,RGNN)以捕獲不同身體部位之間的高級結構特征。Liu等[15]提出動態姿態圖像描述人體行為,其利用姿態估計方法得到人體14個聯合估計圖,每一個聯合估計圖表示一個關節的運動,然后使用神經網絡融合不同關節的運動。鄧詩卓等[16]利用人體不同部位的三軸向傳感器(三軸加速度、三軸陀螺儀等)的相同軸向數據間隱藏的空間依賴性并結合卷積神經網絡(Convolutional Neural Networks,CNN)進 行 動 作識別。

基于單模態、多模態的行為識別方法雖然可以識別不同的行為,但是忽略了人體在執行動作時不同身體部位的空間協同運動結構特征。動作的完成需要多塊肌肉共同協調配合,例如走路不僅需要雙腿,同時也需要擺動手臂以協調身體平衡[14]。現有計算不同身體部位結構特征的方法大都使用了神經網絡,其訓練時間復雜度高、計算資源消耗高、可解釋性差等。

本文針對使用神經網絡計算結構特征的復雜性高等問題,提出利用人體不同部位的三軸加速度數據構建人體空間協同運動的結構特征模型,并無監督、自適應地對不同身體部位的運動特征進行約束。首先對執行不同動作時的人體不同部位的三軸加速度曲線進行曲線特征分析,確定不同身體部位對不同動作的完成具有不同的貢獻度;其次對執行某一動作時人體全身三軸加速度曲線進行曲線特征分析,并提出利用曲線的多個統計值度量人體不同部位的貢獻度;然后由于多個統計量對構建結構特征模型具有不同的權重,需要進行權重的確定;再使用協同運動結構特征模型對人體不同部位的運動特征進行無監督、自適應地約束;最后使用多模態特征選擇與特征融合算法將不同模態的特征進行融合并分類識別。

1 總體框架

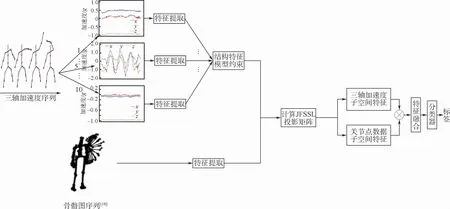

本文提出利用人體空間協同運動的結構特征模型,對不同人體部位的運動特征進行約束,然后對多模態特征進行特征選擇與特征融合,總體框架如圖1所示。對骨骼圖序列按Chen等[17]方法進行特征提取,圖1中的“骨骼圖序列”引自文獻[18]。首先,對人體不同部位的三軸加速度數據分別提取特征;然后使用結構特征模型約束特征;最后使用多模態特征選擇與特征融合方法訓練多模態特征投影矩陣用于融合三軸加速度數據特征與關節點位置數據特征,使用分類器對融合后的特征進行分類識別,得到類別標簽。

圖1 總體框架Fig.1 Overall framework

2 協同運動結構特征表示

設γk={ax,ay,az}為人體第k個慣性傳感器采集的三軸加速度數據,人體執行動作時全身的三軸加速度數據為γ={γ1,…,γk,…,γK},其中K為人體慣性傳感器的總數。對人體不同部位的三軸加速度數據進行特征提取,得到人體全身的運動特征FK=[fxk,fyk,fzk],k=1,2,…,K,其中fxk為人體第k個部位x軸的特征,fyk為人體第k個部位y軸的特征,fzk為人體第k個部位z軸的特征。然后使用協同運動結構特征模型對特征進行約束從而使得樣本具有更好的分類能力。

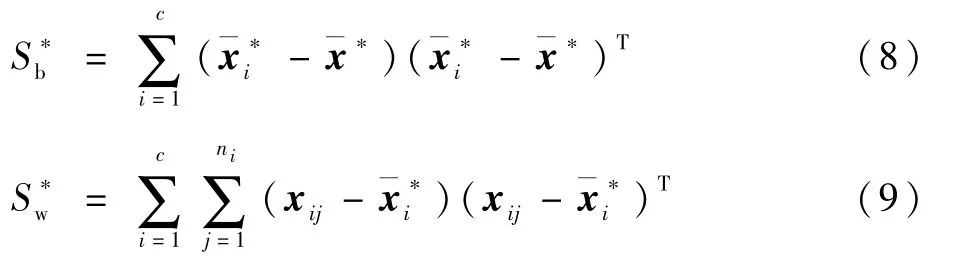

分別計算類間距離Sb與類內距離Sw:

然后計算類間距離Sb與類內距離Sw的比值Jw。為了使得樣本具有更好的可分離性,需要增大比值Jw:

本文利用人體空間協同運動的結構特征模型對特征進行約束,約束后的第i類樣本均值、所有c類樣本均值的計算式分別為

式中:Wij=[wxk,wyk,wzk],k=1,2,…,K為第i類第j個樣本對應的結構特征,并用于約束人體全身的運動特征,得到約束后的特征(FK)*=[,,],k=1,2,…,K。以計算為例=wykfyk。計算約束后的類間距離與類內距離:

以左高揮手、右高揮手動作為例,左高揮手動作的主運動結點為左手肘、左手腕;右高揮手動作的主運動結點為右手肘、右手腕,其他的身體部位為附加運動結點。本文分別對比左高揮手與右高揮手動作的主運動結點以及附加運動結點的三軸加速度曲線。主運動結點曲線的對比如圖2所示,附加運動結點曲線的對比如圖3所示。圖2(a)為執行左高揮手動作時左手肘、左手腕、右手肘、右手腕部位對應的三軸加速度曲線圖。類似地,圖2(b)為執行右高揮手動作時左手肘、左手腕、右手肘、右手腕部位對應的三軸加速度曲線圖。圖3(a)為左高揮手動作附加運動結點的三軸加速度曲線圖,圖3(b)為右高揮手動作附加運動結點的三軸加速度曲線圖。

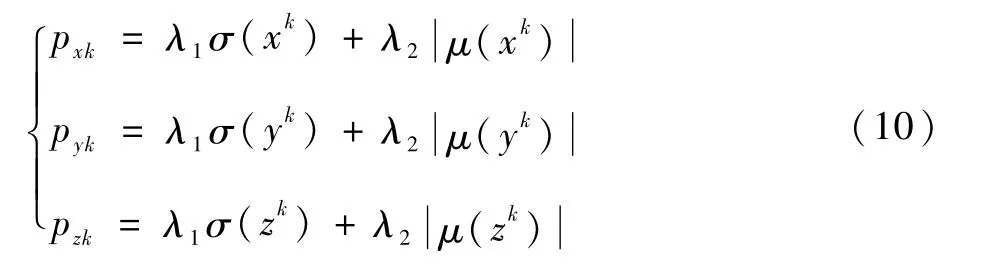

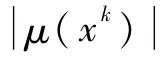

首先對比左高揮手、右高揮手動作附加運動結點的三軸加速度曲線,可以發現這2個動作附加結點的三軸加速度曲線形狀相同均保持平穩即方差差異性小,此外曲線的均值也接近,即這2個動作附加結點的類間距離小,分類能力差。然后比對左高揮手、右高揮手動作主運動結點的三軸加速度曲線,對于區分左高揮手與右高揮手動作主要是根據左手肘、左手腕、右手肘、右手腕處三軸加速度曲線的統計特征。為了使樣本更好地分離,需要強化每個動作主運動結點的特征、削弱附加運動結點的特征,基于此本文使用基于人體空間協同運動的結構特征模型對不同身體部位的特征進行約束。以右高揮手動作為例,從圖2(b)、圖3(b)中可以觀察到,對于動作的完成不同身體部位的貢獻度是不同的,其主運動結點為右手肘、右手腕,即右手肘、右手腕對動作的完成具有高的貢獻度,附加運動結點的貢獻度相對較小。本文使用執行動作時不同身體部位的貢獻度構建協同運動的結構特征模型。為了度量不同部位對完成動作的貢獻,本文通過式(10)度量人體第k個部位x、y、z軸的貢獻,其他結點貢獻度的度量與此類似:

圖2 左高揮手、右高揮手動作主運動結點的三軸加速度曲線Fig.2 Triaxial acceleration curves of main motion nodes of left high wave and right high wave

圖3 左高揮手、右高揮手動作附加運動結點的三軸加速度曲線Fig.3 Triaxial acceleration curves of additional motion nodes of left high wave and right high wave

為了說明本文提出的結構特征模型的有效性,分別計算類間距離為2 175、類內距離為10383以及Jw為0.209 5。然后再計算使用結構特征模型約束后的特征的類間距離為575、類內距離為2 046以及為0.281 0。從計算結果可知>Jw,即使用結構特征模型約束后的特征具有更佳的分離能力。

3 多模態特征選擇與特征融合

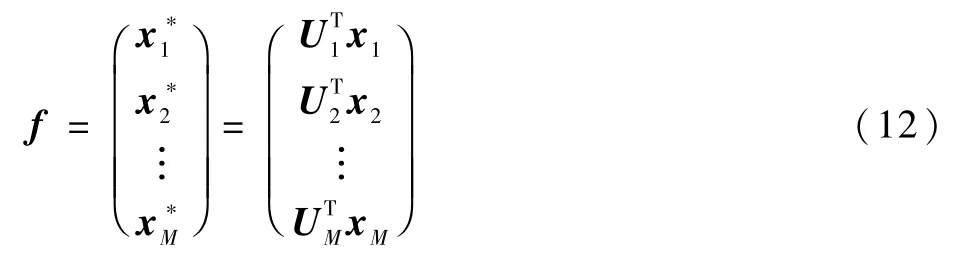

在采集人體的行為數據時一般會采集多個模態的數據。為了利用不同模態的數據進行行為識別,需要融合多模態特征。此外每個模態內包含了大量的冗余特征,需要對特征進行選擇。設Γ={,,…,}表示N個動作樣本,其中每個樣本包含M個不同模態的特征。雖然第i個樣本Γi={,,…,}包含了M個不同模態的特征,但類別標簽相同,,…,→yi。本文為每個模態的特征分別學習投影矩陣。用于將不同模態的特征投影到子空間。并在投影的過程中完成對特征的選擇。最后按式(12)進行多模態特征的融合:

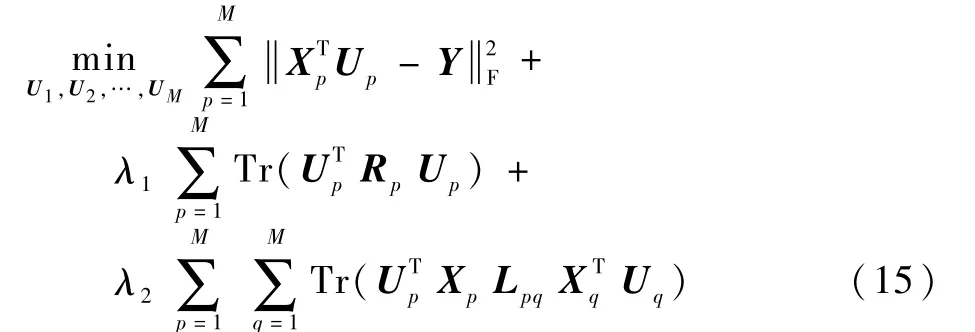

式中:f為融合后的特征;xp為第p個模態的特征,p=1,2,…,M;Up為第p個模態的投影矩陣,p=1,2,…,M;為第p個模態投影后的特征,p=1,2,…,M。將融合后的特征稱之為多模態融合特征(multi-modal fusion features)并用于分類識別。本文借鑒聯合特征選擇與子空間學習JFSSL方法[19]學習多模態投影矩陣,用于將不同模態的特征投影到子空間,并使用?2,1范數來實現特征選擇[20],其最小化問題如下:

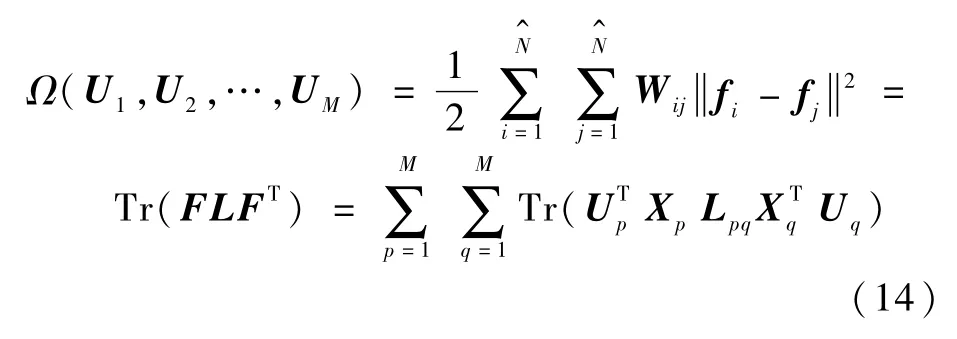

式中:Xp為第p個模態的特征矩陣,p=1,2,…,M;Y 為JFSSL方 法 構 造 的 子 空 間,Y∈RN×c。式(13)的第1項用于學習投影矩陣,第2項用于特征選擇,第3項用于保持模態內和模態間的相似關系。式(13)的第3項的推導為

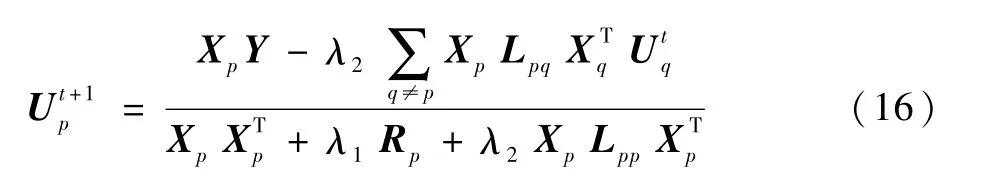

本文使用式(16)迭代計算得到不同模態的投影矩陣,將不同模態的特征投影到子空間,再將子空間的特征按式(12)進行融合用于行為識別。

4 數據采集

本節介紹自建的數據采集系統,并將其用于全身運動數據的獲取。

4.1 采樣系統搭建

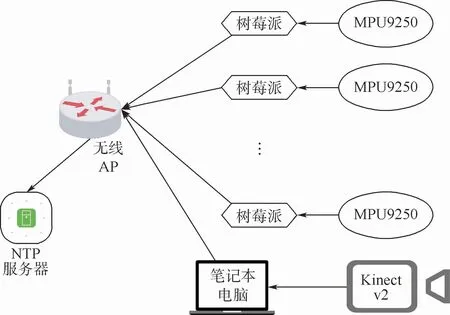

Kinect v2傳感器可以采集RGB-D圖像以及人體25個關節點的位置數據。MPU9250慣性傳感器是一種體積小、功耗小的傳感器,采樣率為500 Hz,可同時捕獲三軸加速度、三軸角速度和三軸磁場強度數據并輸出四元數等。

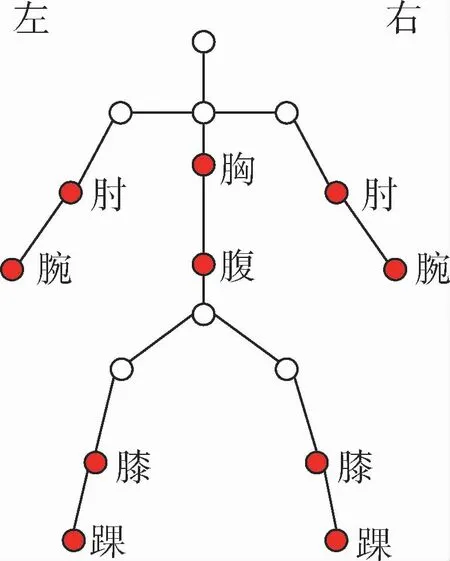

本文利用Kinect采集深度圖像和關節點位置數據,利用MPU9250采集三軸加速度數據。為了采集人體全身部位的三軸加速度數據,本文搭建了包含10個慣性傳感器的運動數據采集系統,采樣系統架構如圖4所示,其中NTP(Network Time Protocol)服務器用于提供標準時間,無線AP(wireless Access Point)用于組建無線局域網絡。利用卡片式計算機樹莓派控制MPU9250傳感器,利用筆記本電腦控制Kinect v2,每次采集數據時都與NTP服務器進行時間同步。本文綜合考慮了MHAD[22]、UTD-MHAD[23]等行為數據庫的采樣方案后,確定慣性傳感器的位置如圖5所示,圖中紅色標記點為慣性傳感器的位置,“左”為人體的左側,“右”為人體的右側。圖6為本文的真實采樣場景。

圖4 采樣系統架構Fig.4 Sampling system architecture

圖5 可穿戴傳感器位置示意圖Fig.5 Position schematic diagram of wearable sensor

圖6 真實采樣場景Fig.6 Real sampling scene

4.2 數據庫描述

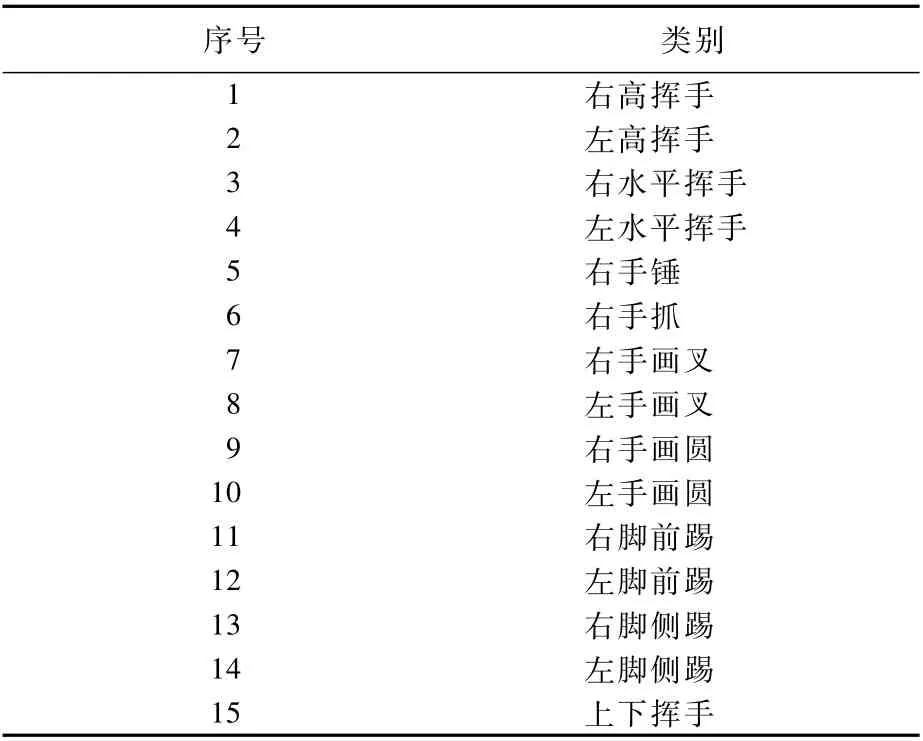

本文自建的行為數據庫包含7位男性受試者,年齡分布為20~26歲,其中包括一個肥胖型受試者、一個瘦弱型受試者。7個男性受試者分別執行15個動作,每個動作重復執行10次。15個動作類別如表1所示。

表1 自建的行為數據庫中的15個動作Table 1 Fifteen actions in self-built behavior database

5 實驗結果與分析

5.1 特征提取

本文在自建的數據庫上進行實驗,實驗選取了5位受試者執行的15個行為動作,其中每個動作由每位受試者重復執行8次,實驗用的行為數據庫一共包含600個樣本。對三軸加速度數據提取經典的時域特征:均值、方差、標準差、峰度、偏度。

5.2 實驗設置

1)設置1。與Chen等[4]類似,在第1組實驗中將3/8樣本作為訓練,剩下數據作為測試;在第2組實驗中將4/8樣本作為訓練;在第3組實驗中將5/8樣本作為訓練;在第4組實驗中將6/8樣本作為訓練。本文使用T1~T4代表上述4組實驗。

2)設置2。與Chen等[24]類似,在第1組實驗中將標記為1、2對象的數據作為訓練樣本;在第2組實驗中將標記為1、2、5對象的數據作為訓練樣本;在第3組實驗中將標記為1、2、3、5對象的數據作為訓練樣本。本文使用T5~T7代表上述3組實驗。

5.3 參數設置

本文的實驗需要對分類器參數、超參數等進行選擇,所需參數都通過CV(Cross Validation)校驗的方法進行確定。

1)分類器參數設置。本文中使用的分類器如CRC(Collaborative Respresentation Classifier)、KNN (K-Nearest Neighbor)、RandomF(Random Forest)等需要確定最佳參數。最終確定的分類器最優參數為:KNN的參數設置為1;RandomF的參數設置為65;CRC的參數設置為0.000 1。

2)超參數設置。聯合特征選擇與子空間學習的參數λ1、λ2分別設置為0.001和0.001;本文提出的結構特征模型中的超參數λ1、λ2分別設置為5和0.05。

5.4 三軸加速度數據特征分類識別

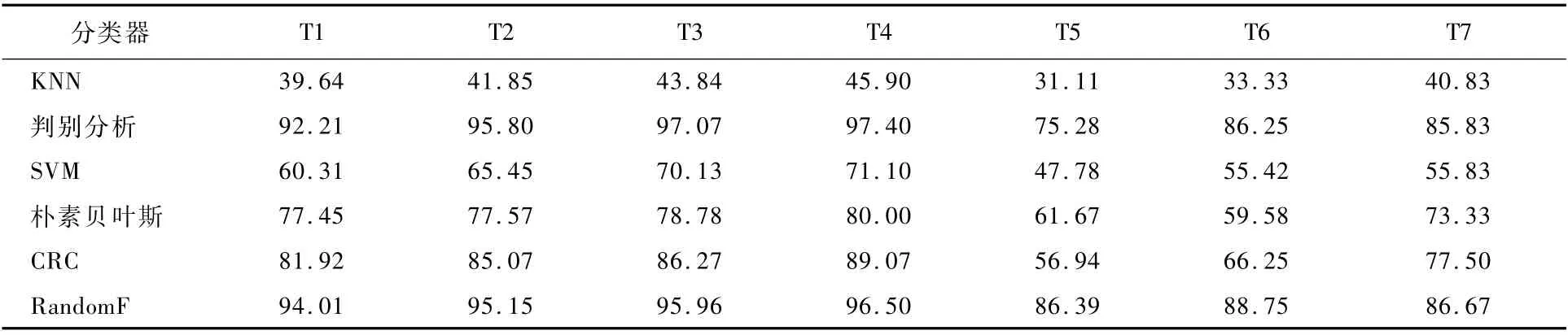

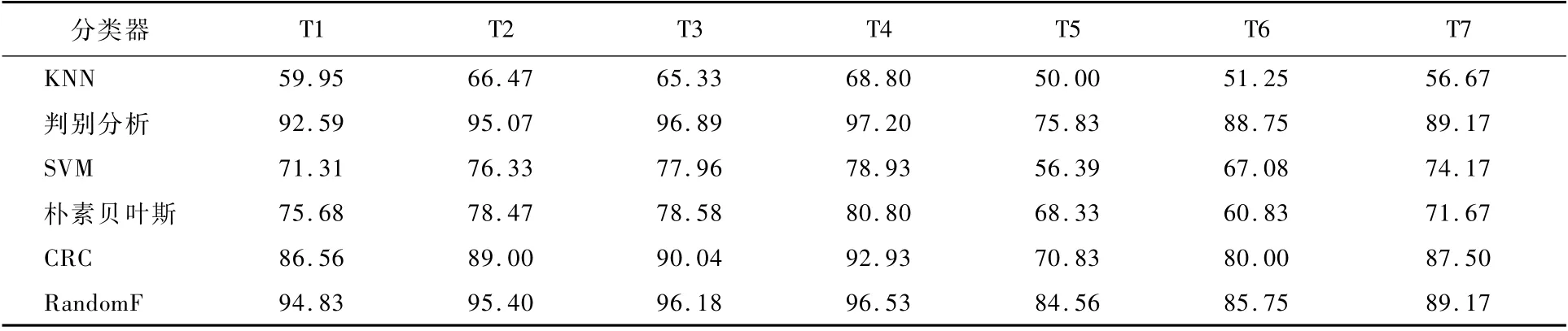

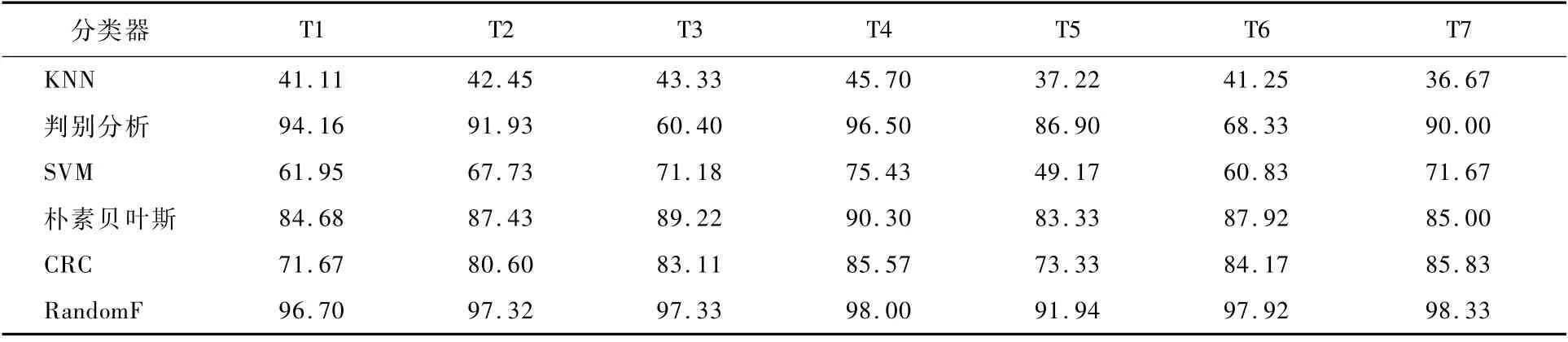

本節對全身三軸加速度數據的特征以及使用結構特征模型約束后的特征進行分類識別。表2為使用人體全身的三軸加速度數據特征的識別率(即本節的基線實驗),表3為使用結構特征模型約束后的特征的識別率。

從表2可知,封閉測試T1~T4在使用判別分析、RandomF分類器的情況下識別率很高,如表2中的T4實驗使用判別分析分類器的識別率可高達到97.40%。然而表2中的開放測試T5~T7的識別率均低于T1~T4的識別率。因此本文的目的是提高開放測試T5~T7的識別率。為此,將表3中的T5~T7與表2中的T5~T7的識別率進行對比,對比的結果如圖7所示。

圖7中每個分類器后的數字為特征約束后的識別率減去基線識別率的結果。從圖7中可以直觀看出,特征約束后T5~T7的識別率明顯高于基線識別率。說明本文利用基于人體空間協同運動的結構特征模型約束的特征具有更佳的分類能力。

表2 三軸加速度識別率Table 2 Recognition rate of triaxial acceleration %

表3 三軸加速度約束后的識別率Table 3 Recognition rate of constrained triaxial acceleration %

圖7 約束后的識別率與基線識別率的對比Fig.7 Comparison of recognition rate after constraints with baseline recognition rate

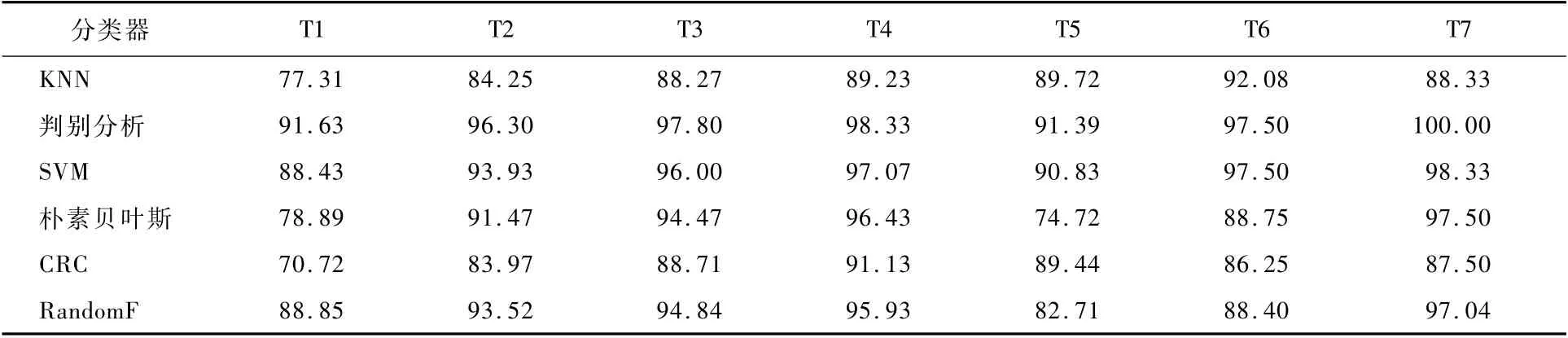

5.5 關節點位置數據的識別率

表4為關節點位置數據的識別率。由于5.6節實驗為多模態特征的融合,故本節先計算關節點位置數據的識別率作為多模態特征融合的基線識別率。

5.6 多模態特征選擇與特征融合的識別率

本節使用多模態特征選擇與特征融合方法對三軸加速度數據特征、關節點位置數據特征進行融合并使用多個分類器進行分類識別,其識別結果如表5所示,并且將表5作為本節的基線實驗,將表5與表4、表3的T1~T7識別率進行對比可知,多模態特征融合的識別率均優于單個模態特征的識別率。將本文結構特征模型約束后的特征與關節點位置數據特征進行融合,結果如表6所示。

表6與表5的T1~T4相比,融合約束后的特征與關節點位置數據特征的識別率均顯著高于基線實驗。由于本文的重點是提高開放測試的識別率,因此將表6與表5的T5~T7進行對比,對比結果如圖8所示。

表4 關節點位置識別率Table 4 Recognition rate of joint point position %

表5 多模態特征選擇與特征融合的識別率Table 5 Recognition rate of multi-modal feature selection and feature fusion %

表6 融合約束后的三軸加速度數據特征與關節點位置數據特征識別率Table 6 Recognition rate of triaxial acceleration featur e and joint point position data feature after fusion constraints %

從圖8中可以直觀看出,在T6、T7實驗中本文方法明顯優于基線實驗,在T5測試中本文方法略低于基線實驗。這是由于T5測試選取2/5受試者的樣本作為訓練,選取的受試者數量少,從側面說明本文提出的算法還可以進一步改良。此外表6中T7實驗的識別率在5個分類器中高達100.00%。上述的對比結果說明本文提出的基于人體空間協同運動的結構特征模型的有效性。

6 結 論

本文提出了利用人體不同部位三軸加速度數據的多個統計值用于度量不同部位對完成動作的貢獻度,利用不同部位的貢獻度構建面向行為識別的人體空間協同運動結構特征模型,并無監督、自適應地對人體不同部位的特征進行約束。在此基礎上,借鑒JFSSL方法融合多模態的行為特征,并在融合過程中完成了對特征的篩選。實驗結果表明:

1)該模型適用于具有全身三軸加速度數據的行為識別,模型的構建不需要復雜的算法計算,具有較好的實時性。

2)在自建的行為數據庫的封閉測試(T1~T4)、開放測試(T5~T7)中均有優異的效果。

3)通過實驗證明了人體在執行動作時不同部位之間存在協同性。這為進一步探索人體空間協同運動的結構特征提供了實驗依據。