基于模糊聚類的“憤怒”表情細(xì)分方法研究

林巧民,潘 敏

(1.南京郵電大學(xué) 計(jì)算機(jī)學(xué)院,江蘇 南京 210023;2.南京郵電大學(xué) 教育科學(xué)與技術(shù)學(xué)院,江蘇 南京 210003)

0 引 言

情感是伴隨著認(rèn)知和意識過程的生理以及心理狀態(tài)[1],在人際交往中起著非常重要的作用。近年來國內(nèi)外許多研究人員針對情緒識別已經(jīng)做出了很多的研究,從單一模態(tài)情緒識別[2]到多模態(tài)情緒識別[3],這些研究大多都是區(qū)分六種基本的面部表情。王蓓等[4]提出了一種基于決策層融合機(jī)制的人臉表情和語音多模態(tài)方法,取得了一定的融合效果。Zeng等[5]提出了一種基于多流隱馬爾可夫模型(multistream hidden Markov,HMM)的人臉表情和語音多模態(tài)方法,融合后取得了72.42%的識別率。Wang等[6]采用核交叉模型因子分析方法對語音模態(tài)和人臉表情模態(tài)進(jìn)行特征降維和特征融合。然而對于相同的面部表情,表情強(qiáng)烈程度不同,表現(xiàn)出的情感狀態(tài)也會不一樣。如憤怒的表情程度可分為生氣和到憤怒之間的不同等級。生氣表示一種略微憤怒,程度較輕;憤怒則表示人處于一種非常生氣的狀態(tài)。面部表情強(qiáng)度估計(jì)是情緒識別的一種延伸,對其進(jìn)行相關(guān)研究的人員相對較少。Mahoor等[7]使用二元分類器的6級分類來進(jìn)行層次劃分,他們從嬰兒面部圖像的幾個代表性行動單元評估了AU強(qiáng)度。但是,無法避免類之間的類重疊,這使得這些方法的魯棒性較差。在Delannoy等[8]的研究中,他們使用基于圖像的分類方法用于三個級別(低,中和高)的強(qiáng)度估計(jì)。從以上研究中能夠觀察到表情的層劃分都是預(yù)先設(shè)置的,于是文中提出了一種基于模糊聚類的表情層次細(xì)分方法,該方法采用了一種聚類融合算法,可以不用提前設(shè)定強(qiáng)度等級就可以自動獲得強(qiáng)度等級。

隨著互聯(lián)網(wǎng)相關(guān)汽車行業(yè)的快速發(fā)展,行業(yè)中的缺陷也逐漸暴露出來。如乘客的安全問題,尤其是女性乘客的安全問題。夜晚打車出行的顧客,一旦出現(xiàn)問題,人身安全將無法得到保證,因此對于司機(jī)的情緒監(jiān)控就尤為重要。除此之外,也可應(yīng)用于公交司機(jī)的情緒檢測。公交是人們?nèi)粘I钪斜夭豢缮俚慕煌üぞ撸绻凰緳C(jī)的情緒處于一種極端情緒中,將會對眾多乘客的生命安全造成極大的威脅。反之,乘客如果情緒失控影響司機(jī)駕駛也會帶來嚴(yán)重的交通事故。為了解決這一問題,網(wǎng)約車公司和公交公司可以在合法的車輛上裝載攝像,將情緒分析技術(shù)與系統(tǒng)設(shè)備相結(jié)合,應(yīng)用于檢測駕駛途中司機(jī)的情緒變化或者司機(jī)的“憤怒”情緒。情緒分析技術(shù)能夠從獲取的視頻中自動分析情緒類別,再此基礎(chǔ)上將情緒強(qiáng)度解析出來。當(dāng)粗粒度的情緒類別獲取之后,如果確定是“憤怒”情緒也不會立刻就提醒后臺,而是當(dāng)“憤怒”情緒強(qiáng)度超過設(shè)定的情緒強(qiáng)度閾值時,才會提醒后臺關(guān)注此車輛的相關(guān)信息,提高后臺工作人員的工作效率,保障乘客的人生安全[9]。

1 面部表情特征提取和分類識別

情感信息的提取能夠通過“生理信號”進(jìn)行分析、判別,這種方式應(yīng)用在非醫(yī)學(xué)領(lǐng)域?qū)O大地增加了實(shí)驗(yàn)的難度。反之,通過對人臉的檢測和分析,極大地提高了實(shí)驗(yàn)的可行性。目前流行的人臉檢測技術(shù)為卷積神經(jīng)網(wǎng)絡(luò)(convolutional neural networks,CNN)和VJ(viola-jones,VJ)算法,文中采用的傳統(tǒng)的VJ算法[10]已經(jīng)可以滿足需求。VJ算法主要用于人臉的檢測和定位,在預(yù)處理階段將圖像中與面部無關(guān)的背景刪除。

特征提取技術(shù)中有兩種比較常用的技術(shù)是PCA(主成分分析)和LDA(線性判別分析),這兩種方法常用于人臉識別的研究。PCA和LDA的不同之處在于前者主要的任務(wù)是降維,而后者是加強(qiáng)區(qū)分從不同類別中獲得特征。雙向主成分分析(bi-directional principal component analysis,BDPCA)[11]和最小平方線性判別分析(least-square linear discriminant analysis,LSLDA)[12]是對PCA和LDA的一種改進(jìn),算法性能得到了提升,對于人臉識別的準(zhǔn)確率也有所提升。PCA可以把可能具有相關(guān)性的高維變量合成線性無關(guān)的低維變量,稱為主成分(principal components)。新的低維數(shù)據(jù)集會盡可能保留原始數(shù)據(jù)的變量,但是計(jì)算比較復(fù)雜。BDPCA優(yōu)于PCA在于它可以在圖像的行和列方向上找到最優(yōu)投影子空間,而無需矩陣進(jìn)行矢量變換,也不會產(chǎn)生協(xié)方差矩陣,減少了處理時間。將BDPCA算法和LSLDA算法進(jìn)行融合,先以BDPCA算法對預(yù)處理后的圖像進(jìn)行降維處理,然后將BDPCA的輸出作為LSLDA的輸入,得出投影子空間。

從LSLDA階段得到的面部特征傳送到高斯核映射,并通過核映射形成核矩陣。核矩陣中存儲了一些在高維空間中數(shù)據(jù)的相似信息。面部特征同樣也傳送到拉普拉斯圖映射中,并通過拉普拉斯映射形成了拉普拉斯矩陣。拉普拉斯矩陣中存儲了在低維空間中數(shù)據(jù)的關(guān)系信息。OKLC模塊表示一種優(yōu)化的k-均值拉普拉斯聚類[13],為了獲得VOKLC(最優(yōu)的核拉普拉斯聚類),需要OKLC模塊找到核函數(shù)和拉普拉斯矩陣的最優(yōu)系數(shù)。在測試階段,為了獲得用于測試數(shù)據(jù)的核矩陣和拉普拉斯矩陣,在LSLDA階段提取到的測試特征進(jìn)行映射。測試數(shù)據(jù)的兩個矩陣訓(xùn)練階段使用加性模型[14]和從OKLC模塊的最優(yōu)系數(shù)進(jìn)行合并。最后通過RBF分類器對特征進(jìn)行分類識別。表情識別系統(tǒng)框圖如圖1所示。

2 表情強(qiáng)度層次劃分

對于同一種面部表情來說,強(qiáng)烈程度不同,反映出的情感狀態(tài)也會不同。當(dāng)粗粒度情緒被識別之后,從RBF情緒識別分類器末端選擇了200幀被標(biāo)記為“憤怒”的連續(xù)圖像樣本,這200幀包含了不同強(qiáng)度等級的“憤怒”。人的憤怒情緒雖然是在很短的時間內(nèi)產(chǎn)生的,但是也是有過程的,因此該采樣樣本體現(xiàn)了憤怒情緒的發(fā)展以及生成過程。文中將對這200幀連續(xù)圖像進(jìn)行強(qiáng)度等級劃分。

圖1 表情識別系統(tǒng)框圖

聚類分析是很多分類的基礎(chǔ),目的是從樣本數(shù)據(jù)中找出本質(zhì)聯(lián)系,從而鑒別出這些樣本從屬于不同的聚類。在數(shù)據(jù)處理方面將模糊均值聚類和減法聚類進(jìn)行融合對數(shù)據(jù)進(jìn)行處理,解決模糊C聚類對于初始值設(shè)定敏感并且容易陷入局部最優(yōu)解的問題。所以文中提出了一種模糊聚類的表情層次細(xì)分方法來對已識別的情緒進(jìn)行細(xì)分以對應(yīng)不同強(qiáng)度的情感狀態(tài)。首先用融合聚類算法對樣本進(jìn)行聚類,得到不同的聚類中心。接著把聚類后的數(shù)據(jù)由MATLAB中的ANIFS(自適應(yīng)神經(jīng)模糊推理系統(tǒng))進(jìn)行訓(xùn)練,最后將“憤怒”進(jìn)行層次上的劃分[15-16]。

2.1 模糊C均值(FCM)聚類算法

FCM算法[17-18]也是一種聚類算法,它是基于劃分的。其核心算法是將被劃分為不同聚類的對象之間的相似度減為最小,而相同聚類之間的相似度增加到最大。對普通C均值聚類算法的改進(jìn)方法之一有模糊C均值。C均值的算法思想是將提供的數(shù)據(jù)進(jìn)行硬性劃分,一個樣本將會精確地歸屬某一個聚類,F(xiàn)CM將模糊地對數(shù)據(jù)進(jìn)行劃分,樣本屬于某一類聚類的程度由隸屬度來表示,一般記為μA(x),其自變量的取值范圍是可能歸屬于集合A的全部對象(也就是說,集合A在所有空間),取值區(qū)間為[0,1]。其中μA(x)=1表示x全部屬于集合A(x∈A)。在空間X={x}定義的隸屬度函數(shù)定義了一個模糊集合A,或定義在域X={x}上的模糊子集。對于有限個對象(x1,x2,…,xn),模糊集合可以表示為:

A={μA(xi),xi∈X}

(1)

以上描述了模糊集這一概念,可以了解到一個元素歸屬于某個模糊集不再像C均值一樣是硬性分類。可以假設(shè)由聚類形成的簇為模糊集,那么屬于聚類的每一個樣本點(diǎn)的隸屬度在區(qū)間[0,1]中。在對數(shù)據(jù)集的隸屬度進(jìn)行歸一化處理后,總和為1:

其中,c表示聚類個數(shù);uij表示隸屬于聚類ci的第j個樣本的隸屬度。

那么,F(xiàn)CM的目標(biāo)函數(shù)為:

(2)

其中,0≤uij≤1;ci為模糊組i的聚類中心;dij=‖ci-xj‖為第i個簇中心ci與數(shù)據(jù)點(diǎn)xj之間的距離;m>1為權(quán)重指數(shù)。

聚類中心ci的計(jì)算公式如下:

(3)

用式4更新隸屬度:

(4)

算法步驟描述如下:

(1)m為指定參數(shù),C為聚類中心數(shù),ε為最大迭代次數(shù)以及迭代停止誤差;

(2)對聚類中心C進(jìn)行初始化;

(3)計(jì)算初始距離矩陣D,由dij組成;

(4)根據(jù)式4來更新隸屬度,得到隸屬度矩陣U,如果距離為0,則將該點(diǎn)和對應(yīng)類的隸屬度設(shè)置為1,其余的設(shè)置為0;

(5)按式3更新聚類中心;

(6)重新計(jì)算距離矩陣,并根據(jù)式2計(jì)算目標(biāo)函數(shù);

(7)如果與上一級的目標(biāo)函數(shù)的絕對差小于迭代停止誤差或迭代次數(shù)達(dá)到最大,那么就立刻停止,否則轉(zhuǎn)步驟4,同樣也可以判斷用前后兩個隸屬度矩陣差;

(8)對應(yīng)聚類的隸屬度哪一個最大,則將樣本點(diǎn)劃分到哪一個聚類。

2.2 FCM與減法聚類融合的模糊聚類

FCM在對數(shù)據(jù)進(jìn)行模糊聚類時,它對初始值的設(shè)定十分敏感,初始值的設(shè)置不佳將會使最終結(jié)果處于局部最優(yōu)解狀況,針對這一問題引入了減法聚類。在FCM進(jìn)行聚類之前,引入減法聚類來設(shè)定FCM的初始值,不僅能獲得一開始的聚類個數(shù),而且能提高聚類速度,從而解決局部最優(yōu)解的問題[19]。

基于密度的聚類算法的一種方式有減法聚類,其算法原理是把每個數(shù)據(jù)點(diǎn)都當(dāng)作一個聚類中心,計(jì)算每個數(shù)據(jù)點(diǎn)成為聚類中心的概率的方法是按照每一個數(shù)據(jù)點(diǎn)周邊的數(shù)據(jù)點(diǎn)密度來計(jì)算。被選做聚類中心的數(shù)據(jù)點(diǎn)的特征是其在周圍的數(shù)據(jù)點(diǎn)中具備最高的數(shù)據(jù)點(diǎn)密度,并且排除那些離該數(shù)據(jù)點(diǎn)相近的數(shù)據(jù)點(diǎn)成為聚類中心的可能[20];當(dāng)選擇了第一個數(shù)據(jù)中心以后,采用與上述一致的方法,從可能成為聚類中心的其他數(shù)據(jù)點(diǎn)中選擇出下一個聚類中心。直到全部剩下的數(shù)據(jù)點(diǎn)成為聚類中心的概率低于設(shè)置的閾值。融合基本過程如下:

(1)假定所有的數(shù)據(jù)點(diǎn)都在一個單位超立方體內(nèi),即各維的坐標(biāo)都在0~1之間,定義數(shù)據(jù)點(diǎn)xi的密度指標(biāo)為:

(5)

這個數(shù)據(jù)點(diǎn)的密度范圍由半徑ra決定,在這個數(shù)據(jù)點(diǎn)密度范圍內(nèi)的點(diǎn)對密度影響較大;反之在此數(shù)據(jù)點(diǎn)密度范圍外的點(diǎn)對密度影響較小。算出每個數(shù)據(jù)點(diǎn)的密度之后,第一個聚類中心為密度最高的那個數(shù)據(jù)點(diǎn),將這個數(shù)據(jù)點(diǎn)記作xi。

(2)把Dxi設(shè)為它的密度時,其他數(shù)據(jù)點(diǎn)密度根據(jù)Dxi依次由式6修正為:

(6)

其中,rb是一個常數(shù),它定義的密度范圍顯著減小,一般情況下大于ra。之后繼續(xù)重復(fù)上面的步驟,直到剩下的可能作為聚類中心的數(shù)據(jù)點(diǎn)的概率小于設(shè)定的某個閾值。

(3)初始化模糊隸屬度矩陣U(0)。

(4)對每一步用式3算出c個聚類中心ci。

(5)在第t步更新隸屬度矩陣U(t):如果對任意的k,j存在dkj(b)>0,那么得:

(6)‖u(b+1)-u(b)‖≤ε,則停止;否則令t=t+1并返回步驟4。

3 實(shí)驗(yàn)結(jié)果與分析

前面已經(jīng)用eNTERFACE’05數(shù)據(jù)庫作為第一部分情緒識別階段的訓(xùn)練集和測試集,這節(jié)繼續(xù)用該數(shù)據(jù)庫對情緒強(qiáng)度層次劃分的性能進(jìn)行評估。該數(shù)據(jù)庫共記錄了1 293個成人的人臉表情樣本,包含了最常見的6種情緒:高興、悲傷、厭惡、生氣、恐懼、驚訝。接著在擴(kuò)展的Cohn-Kanade數(shù)據(jù)集(Ck+)上對強(qiáng)度劃分性能進(jìn)行評估。最后,文中招募了10名志愿者分別采樣了20秒的視頻,讓志愿者通過觀看視頻的方式產(chǎn)生憤怒的情緒,情緒由平緩到極端憤怒。

3.1 在eNTERFACE’05數(shù)據(jù)庫的評估

eNTERFACE’05數(shù)據(jù)庫是一個同時記錄人臉表情模態(tài)和語音模態(tài)的雙模態(tài)情感數(shù)據(jù)庫。該數(shù)據(jù)庫共記錄了1 293個成人的人臉表情和語音數(shù)據(jù)樣本。圖2為eNTERFACE’05數(shù)據(jù)庫各種人臉表情樣本。

圖2 eNTERFACE’05數(shù)據(jù)庫各種人臉表情樣本

從第2節(jié)中的RBF神經(jīng)網(wǎng)絡(luò)分類器末端選擇75%被標(biāo)記為“憤怒”的表情作為訓(xùn)練樣本,這多幀圖像包含了不同強(qiáng)度等級的“憤怒”。首先用融合聚類算法對樣本進(jìn)行聚類,之后再將訓(xùn)練樣本進(jìn)行分類處理。接著將聚類后的數(shù)據(jù)由MATLAB中提供的自適應(yīng)推理系統(tǒng)來進(jìn)行訓(xùn)練,對面部表情“憤怒”進(jìn)行層次劃分。在實(shí)驗(yàn)過程中還可以得到每一個樣本點(diǎn)到聚類中心的距離,當(dāng)聚類中心最終確定以后,就可以對‘憤怒’表情進(jìn)行層次劃分。d1表示樣本點(diǎn)到第一個聚類中心的距離,d2表示樣本點(diǎn)到第二個聚類中心的距離,依此類推,dn表示樣本點(diǎn)到第n個聚類中心的距離。將L=d1/(d1+d2+…+dn)表示為憤怒的等級。憤怒等級劃分流程如圖3所示。

圖3 “憤怒”等級劃分系統(tǒng)框圖

訓(xùn)練結(jié)果和擬合圖如圖4和圖5所示,訓(xùn)練誤差為0.002 339 2。

圖4 “憤怒”表情訓(xùn)練誤差

圖5 “憤怒”表情訓(xùn)練擬合

將數(shù)據(jù)庫剩余的25%被標(biāo)記“憤怒”的圖像輸入到ANFIS系統(tǒng)中進(jìn)行檢驗(yàn)。訓(xùn)練樣本受到檢驗(yàn)樣本的擬合,由圖可知,兩者基本是相互符合的,*在圓圈內(nèi)表示沒有出現(xiàn)過擬合的現(xiàn)象,準(zhǔn)確率達(dá)到81%。

3.2 在Ck+情緒數(shù)據(jù)庫上的評估

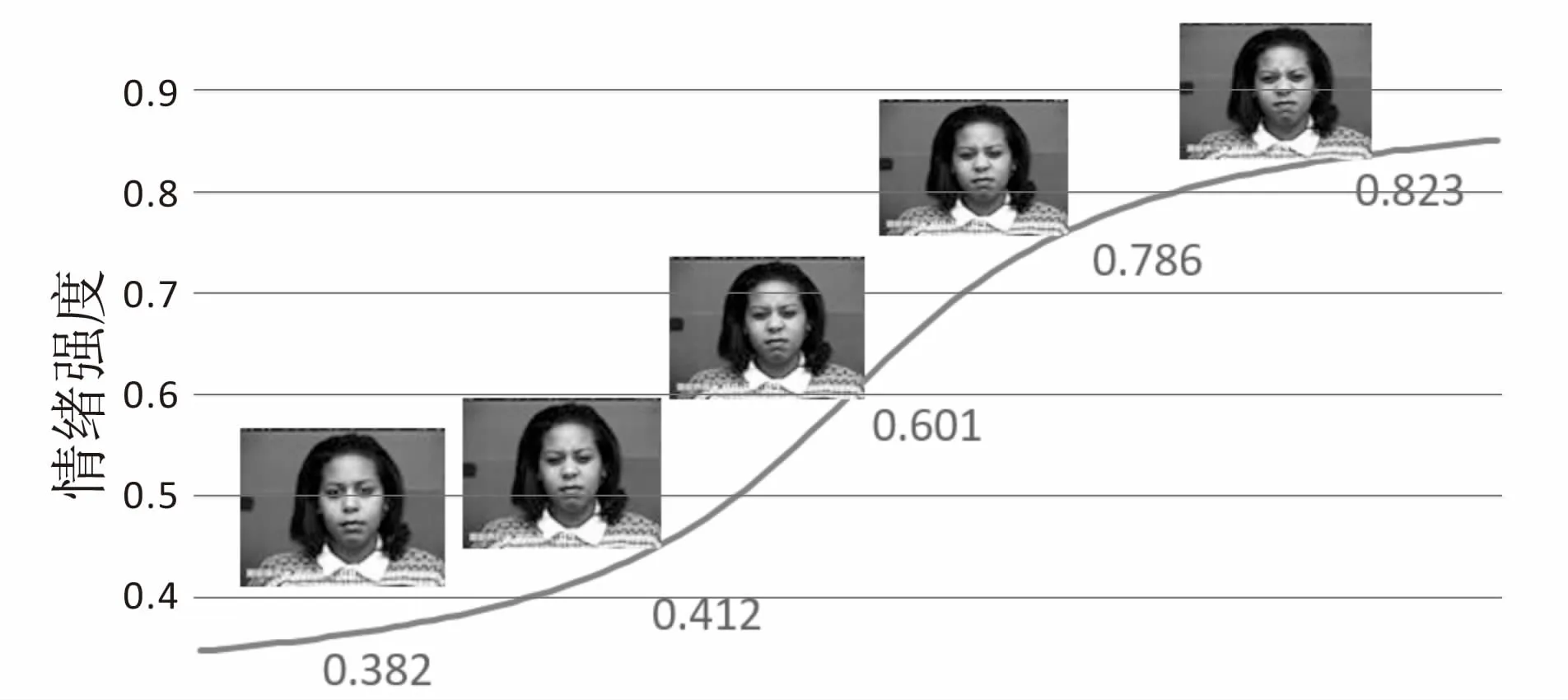

文中采用Ck+人臉表情識別數(shù)據(jù)庫作為測試集,這個數(shù)據(jù)庫包括123個主題和593個圖像序列。在這593個圖像序列中,有327個圖像序列有情緒標(biāo)簽。選取其中75%的憤怒情緒作為訓(xùn)練集,剩下的25%作為測試集。這個數(shù)據(jù)庫比較適合本次實(shí)驗(yàn),因?yàn)樗羞B續(xù)的“憤怒”表情,并且已經(jīng)標(biāo)注了情緒,為本次實(shí)驗(yàn)提供了便利。圖6為Ck+數(shù)據(jù)庫中一位受試者“憤怒”表情的部分連續(xù)圖。

由圖6可以觀察到受試者的憤怒情緒程度越來越高,對應(yīng)的憤怒強(qiáng)度指數(shù)也越來越大。這符合人體情緒的生成過程。Ck+數(shù)據(jù)庫中的數(shù)據(jù)分為不同的主題,規(guī)律性較好,通過測評準(zhǔn)確率可達(dá)83%。

圖6 CK+數(shù)據(jù)庫上的情緒強(qiáng)度走勢

3.3 隨機(jī)采樣對情緒層次劃分的評估

對于測試集,選擇招募10個年齡和性別都不相同的志愿者錄制了10段視頻。視頻的前半部分是“生氣”的表情,后半部分是“憤怒”的表情。前半部分是提供的“憤怒”程度較低的測試圖像幀數(shù),后半部分是“憤怒”程度較明顯的測試圖像幀數(shù)。其中二位志愿者的測試結(jié)果如圖7所示。

圖7 憤怒的測試結(jié)果

從志愿者錄制的“憤怒”視頻中截取三幀圖片測試,結(jié)果如圖7所示,較準(zhǔn)確地描述出了被測試者的憤怒程度。表1顯示了在三個不同的數(shù)據(jù)集上的準(zhǔn)確率,其中Ck+數(shù)據(jù)集上的準(zhǔn)確率最高。

表1 三種數(shù)據(jù)庫識別結(jié)果

4 結(jié)束語

面部表情細(xì)分方法的研究對于解決交通安全隱患問題具有重要的研究價值,此方法可以應(yīng)用于網(wǎng)約車行業(yè)的乘客的安全問題,尤其針對夜間打車乘客的安全問題和公交乘客的安全問題,通過監(jiān)測駕駛員的情緒程度,能夠?qū)Τ丝推鸬揭欢ǖ谋Wo(hù)效果。文中提出了一種基于模糊聚類的表情層次方法,首先通過BDPCA+LSLDB提取視頻中的圖片特征,用RBF神經(jīng)網(wǎng)絡(luò)識別出情緒。在此基礎(chǔ)上,將模糊聚類中的減法聚類和模糊C-均值聚類相結(jié)合,這樣開始的聚類個數(shù)不僅可以自動獲得,聚類的速度還能夠得到提高,解決局部最優(yōu)解這個問題。再通過ANFIS系統(tǒng)對識別出的情緒類型進(jìn)行進(jìn)一步的細(xì)分。接著通過兩個標(biāo)準(zhǔn)數(shù)據(jù)集檢測該方法的可行性。實(shí)驗(yàn)結(jié)果表明,在兩個標(biāo)準(zhǔn)數(shù)據(jù)集上,該方法能夠較好地劃分情緒層次和估計(jì)情緒強(qiáng)度,采集得到的數(shù)據(jù)庫在準(zhǔn)確率上比標(biāo)準(zhǔn)數(shù)據(jù)庫略低。