一種利用遷移學習訓練卷積神經網絡的聲吶圖像識別方法

朱兆彤, 付學志, 胡友峰

一種利用遷移學習訓練卷積神經網絡的聲吶圖像識別方法

朱兆彤1, 付學志2, 胡友峰1

(1. 中國船舶重工集團公司 第705研究所, 陜西 西安, 710077, 2. 中國人民解放軍92228部隊, 北京, 102249)

針對利用傳統訓練方法進行聲吶圖像識別時缺乏數據的問題, 文中提出一種利用遷移學習訓練卷積神經網絡(CNN)實現聲吶圖像識別的方法。基于遷移學習的原理, 通過對已有的預訓練網絡進行微調與重新訓練, 以減小對訓練數據量的需求。隨后利用縮比模型水池試驗驗證了該方法的有效性。試驗結果表明, 基于AlexNet預訓練網絡, 相比傳統的學習方法, 遷移學習方法可以利用較少的訓練數據, 在較短的時間內通過訓練達到95.81%的識別率。試驗還對比了基于6種預訓練網絡進行遷移學習后的網絡性能, 結果表明基于VGG16的遷移網絡識別率最高, 可達到99.48%。最后, 試驗結果驗證了CNN具有一定的噪聲容忍能力, 在較強噪聲背景下, 能保證較高的識別率。

聲吶成像; 目標自動識別; 卷積神經網絡; 遷移學習

0 引言

聲吶成像技術包括實孔徑側掃成像、實孔徑多波束成像、合成孔徑成像和逆合成孔徑成像等技術, 目前已經可以在幾百米距離上獲取水中或水底目標的高分辨率二維圖像。隨著聲吶成像技術的逐步成熟, 如何快速高效地處理獲取的大量聲吶成像數據就成為目前亟待解決的問題。為了解決這一問題, 水下目標自動識別(underwater automatic target recognition, UATR)成為了水下目標識別領域研究的熱點方向。

傳統的聲吶圖像自動識別方法可分為2類: 一類是基于實測數據的識別方法, 另一類是基于物理模型仿真獲得數據的識別方法。2類方法通過實驗或仿真手段獲取聲吶圖像中目標的先驗知識, 提取響應特征, 然后設計分類器進行分類。對于傳統的識別方法, 為了達到較高的識別成功率, 通常需要精心選擇提取的特征組合形式和各項特征的權重, 并調整分類器的參數[1], 因此限制了這些方法的泛化能力, 即當應用場景變化時, 這些方法的性能通常有較大幅度的下降。

隨著人工智能技術在大數據時代的發展, 深度學習在圖像分類、目標檢測和自然語言處理等模式識別領域得到廣泛應用。目前常見的深度學習方法包括深度置信網絡(deep belief network, DBN)、卷積神經網絡(convolutional neural net- work, CNN)及循環神經網絡(recurrent neural net- work, RNN)等, 其中CNN是在計算機視覺領域應用最廣泛的一種算法, 與聲吶圖像識別類似, 傳統的光學圖像識別方法通常也可分為特征提取和特征識別兩步。在傳統方法中, 特征提取方法通常都是基于研究目標的物理或統計特性手動設計的。然而在最新的計算機視覺研究中, 這些傳統的識別模式已被CNN等全新算法所替代。CNN可以自動學習圖像中豐富的分層特征[2-3], 近年來在光學圖像識別領域取得了巨大的成功。Kri- zhevsky等[2]采用深度CNN算法在ImageNet大規模視覺識別挑戰(Imagenet large scale visual re- cognition challenge, ILSVRC)競賽中取得了top5錯誤率15.3%的成績, 遠遠超過了以前最好的成績。Szegedy等[4]提出了包含22個卷積層的Goo- gleNet, 成功地將ILSVRC top5錯誤率降低至6.67%。在ILSVRC競賽中, 基于CNN的各種改進算法性能一直在提升, 目前錯誤率最低的算法由Hu等[5]提出, 已將top5錯誤率降低至2.25%。

隨著CNN在光學圖像識別領域的廣泛應用, 這類方法也被嘗試引入聲吶圖像處理領域。例如Mckay等[6]利用CNN實現了在聲吶圖像中對水雷目標的檢測。但由于CNN的訓練需要大量標注的圖像數據, 而在聲吶圖像識別領域并沒有一個這樣的數據庫, 因此CNN在聲吶圖像識別領域通常面臨缺乏訓練數據的問題。

針對這一問題, 文中在CNN的訓練過程中引入遷移學習的方法, 可將神經網絡從源領域學習到的知識遷移至目標領域。遷移學習方法已經在圖像識別相關領域(例如雷達圖像識別[7]及醫學影像識別[8]等領域)獲得了應用, 并成功地解決了訓練數據缺乏的問題。通常, 源領域的知識是從一個較大的通用數據集學習到的, 而目標領域的知識則基于一個相對較小并聚焦于具體識別任務的數據集。通過引入利用大量光學圖片訓練得到的預訓練網絡作為基礎, 遷移后的網絡繼承了原網絡的結構和大部分參數, 只需要對原網絡的最后幾層進行調整, 遷移后的網絡就能獲得對特定領域數據的識別能力。這樣的方法也被稱為微調(fine-tuning), 微調不但可減小網絡訓練階段的計算復雜度, 也可減少訓練網絡所需的數據量。

針對CNN在聲吶圖像識別領域獲得應用的潛力, 文中首先簡述了CNN的基本算法與利用遷移學習訓練特定神經網絡的方法; 隨后通過試驗對5類縮比模型目標進行聲吶成像, 利用試驗獲取的聲吶成像數據, 對比了基于CNN和傳統非深度神經網絡之間, 傳統訓練方法和基于遷移學習的訓練方法之間, 基于6種預訓練網絡進行遷移學習后得到的網絡之間的性能差異, 以及不同峰值信噪比條件下CNN的性能變化; 最后給出初步結論。

1 深度CNN與遷移學習

1.1 深度CNN

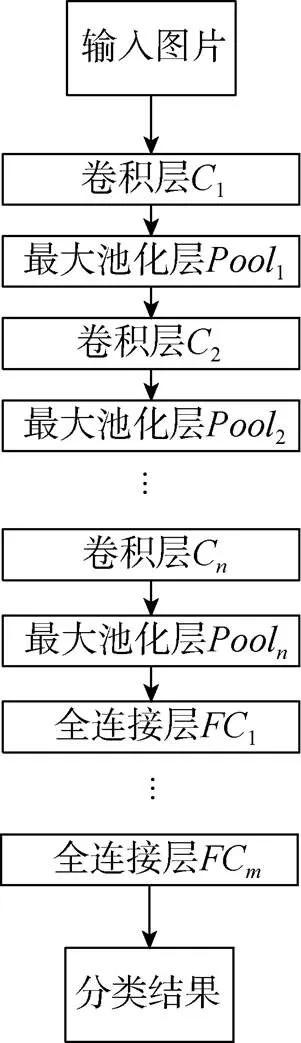

深度CNN是一類具有特殊結構的神經網絡, “深度”則表明其層數較多, 通常超過15層, 整個網絡的開始幾層由卷積層(convolution layer)與池化層(pooling layer)交替構成, 之后若干層是全連接層。其基本原理是: 先由卷積層學習不同的特征, 再由池化層將空域形狀匯聚到高維特征空間, 多層交替的卷積加池化可以學習到層次化的特征表征。最后由全連接層在高維特征空間中學習得到1個分類器。

如圖1所示, 深度CNN中卷積層和池化層的所有節點都排列成一系列2維數組, 稱為“特征圖”。在卷積層中, 每個隱層節點的輸入僅包含前1層中1個局部鄰域內的節點。前1層處于局部鄰域內的節點乘以1個權值矩陣, 再通過1個非線性激活函數“正則化線性單元”ReLU[9], 運算結果作為卷積層的節點輸出值。每個隱層節點都可以被看作是1個特征檢測器, 因為當其輸入中出現它所代表的某種特征時, 該節點便有1個較大的響應值。同一個特征圖上的全部節點被限制為共享相同的連接權值, 所以每個特征圖在圖像的不同位置檢測同一種特征。由于局部連接和權值共享, 深度CNN中需要從數據中學習的獨立參數個數大為減少。在接下來的池化層中, 每個池化層特征圖對應于1個卷積層特征圖。池化層的每個節點以相鄰的前1個卷積層中1個局部鄰域內的節點為輸入, 然后進行下采樣。通常進行下采樣的方法是只保留1個局部鄰域內所有節點的最大值, 而忽略其余的節點值。1個深度CNN包含許多對卷積層與池化層的組合。通過交替的卷積層和池化層獲得圖像從全局到細節的各種特征后, 深度CNN通過全連接層實現最后的分類結果輸出。

深度CNN在業界所取得的巨大成功得益于: 1) 算法的改進; 2) 海量數據的獲得; 3) 圖形處理單元等高性能計算資源的普及, 而其中算法的改進是深度CNN出現飛躍式發展的關鍵因素。

1.2 基于遷移學習的聲吶圖像識別方法

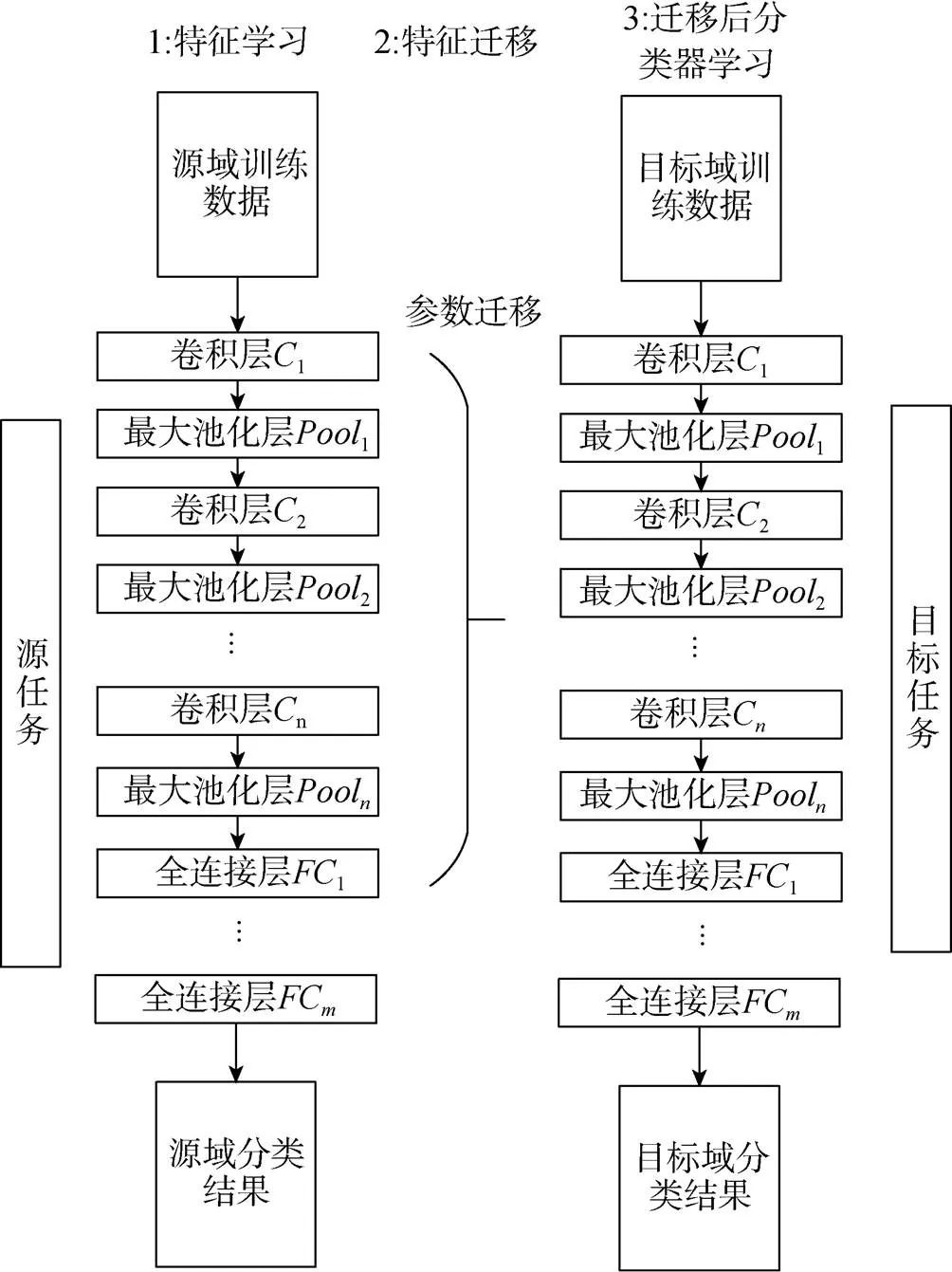

1個CNN通常包含超過百萬級別的參數, 而在聲吶圖像識別領域, 由于試驗難度較大, 通常可供訓練的圖片總量只有幾百到幾千幅。利用這樣少量的訓練樣本去訓練巨大數量的參數容易造成網絡的過擬合。如圖2所示, 首先將CNN看作通用的圖像特征提取器, 在某個數據集(如Ima- geNet)上進行預訓練, 然后在目標數據集(如聲吶圖像試驗數據)上進行復用。采用大量數據訓練完成的CNN具備強大的、可泛化的圖像特征提取能力, 可用于聲吶圖像的特征提取。

圖1 深度卷積神經網絡典型結構

圖2 遷移學習過程

利用遷移學習進行聲吶圖像識別的步驟包括: 1) 選擇1個預訓練網絡, 通常該預訓練網絡是利用大量有標簽的數據集訓練得到的; 2) 將預訓練網絡中部分層的參數遷移至目標網絡中; 3) 移除原網絡中最后1個全連接層, 在遷移后的網絡最后部分添加全連接層, 構成新的網絡; 4) 利用目標域中有標簽的數據訓練新的網絡, 完成整個網絡的遷移。

2 聲吶成像試驗設計與成像結果

2.1 聲吶成像試驗設計

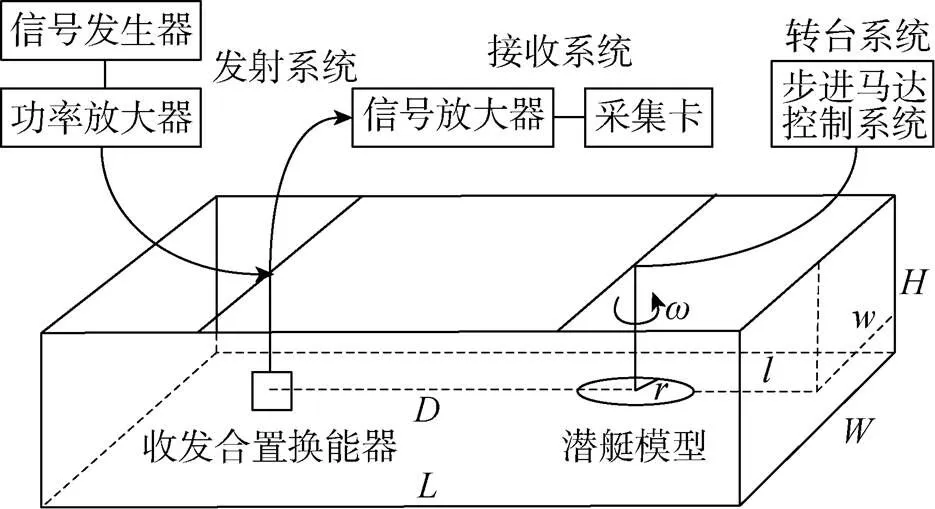

為驗證文中提出的識別方法, 設計了水池試驗進行驗證。試驗針對5類仿真潛艇模型利用水聲轉臺成像方法分別進行成像。考慮到實際水下目標尺度較大, 故文中基于縮比模型的原理進行試驗設計[10], 即將實際的水下目標最大長度縮小100倍至1 m左右。為了保持波長與目標尺寸之間的相對關系, 將換能器工作頻率由成像聲吶常用的20 kHz提升100倍至2 MHz, 帶寬也相應提升至75 kHz, 此時, 試驗聲吶成像系統的分辨率可達到1 cm×1 cm(距離×方位, 下同), 相當于在實際系統中達到1 m×1 m的分辨率。為保證換能器波束完全覆蓋模型, 成像距離依據模型實際尺度設置為9 m(模型尺度小于1 m)或12 m(模型尺度大于1 m), 此時, 設定轉速為0.001 rad/s, 相當于潛艇以0.9 m/s(成像距離9 m)或1.2 m/s(成像距離12 m)的勻速低速巡航, 速度方向垂直于聲吶視線向量, 脈沖重復頻率為5 Hz。

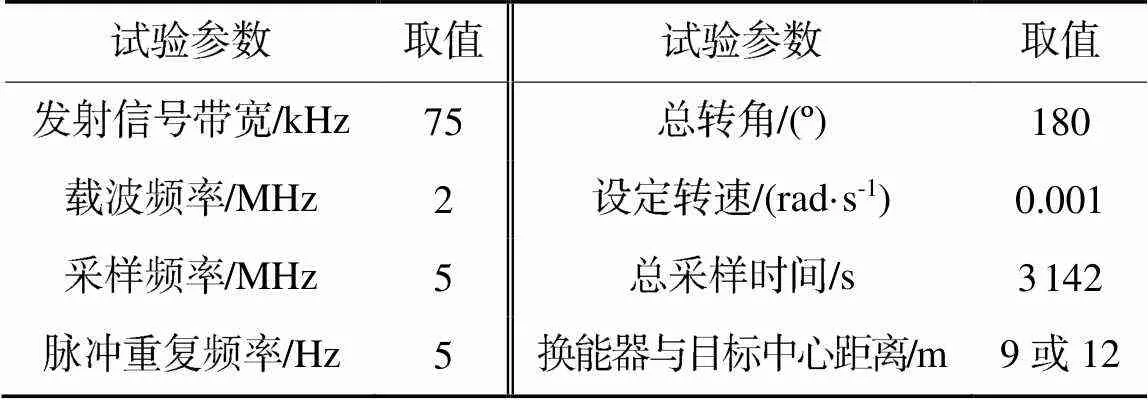

搭建如圖3所示的試驗平臺, 圖中:,和分別為水池長度、寬度和深度;為換能器到轉臺的距離;為轉軸到模型邊緣的最大距離;為轉臺旋轉角速度。模型通過金屬桿連接至步進馬達, 通過控制目標模型保持恒定轉速。每種目標成像時轉臺均相對收發合置換能器由迎頭方向轉至追尾方向, 每種目標均保證連續轉過180°。試驗參數見表1, 試驗詳細描述參見文獻[11]。

2.2 轉臺成像結果

圖3 試驗平臺設計

表1 試驗參數

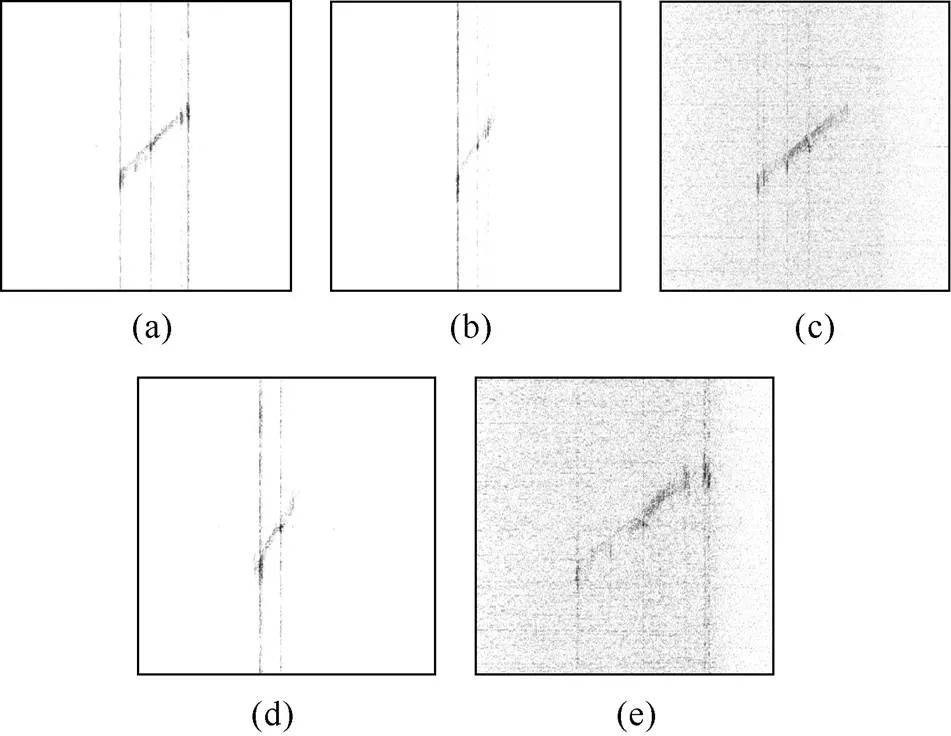

圖4 5類試驗模型典型成像結果

3 基于深度CNN的識別方法性能驗證

3.1 深度CNN與非深度分類器性能對比

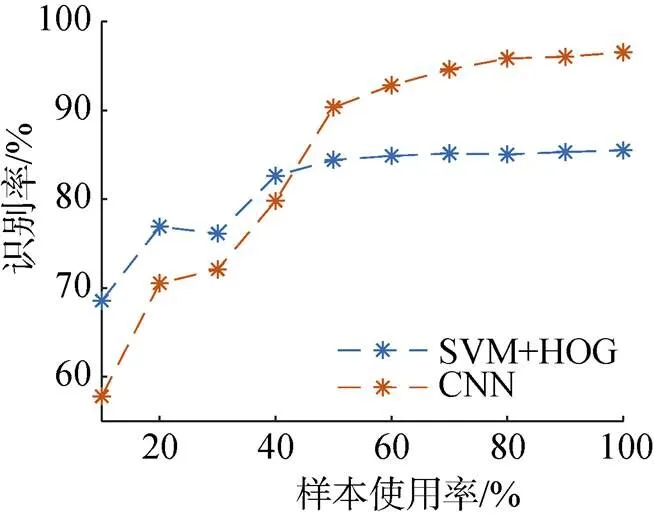

為了對比深度CNN與非深度網絡之間性能差異, 文中引入支持向量機(support vector ma- chine, SVM)結合方向梯度直方圖(histogram of oriented gradient, HOG)特征[12]的非深度分類方法。HOG是一種在計算機視覺和圖像處理中用來進行物體檢測的特征描述子, 它通過計算和統計圖像局部區域的梯度方向直方圖來構成特征。HOG特征結合SVM分類器已經被廣泛應用于圖像識別中。仿真試驗分別對比了采用10%~100%的試驗有效數據作為訓練數據時2種分類器的性能, 試驗結果如圖5所示。

圖5 不同訓練樣本條件下基于SVM+HOG與基于深度CNN的識別方法性能對比

相比于深度CNN, 基于SVM+HOG的方法可以在訓練樣本較少時有較好的識別性能, 然而當學習樣本增加時, 基于SVM+HOG的方法由于可調參數較少, 當使用了50%左右的有效試驗數據后, 分類器的性能就難以繼續改善, 而深度神經網絡的方法由于可調參數多, 因此采用的訓練數據越多, 其性能越好。

3.2 遷移學習方法與非遷移學習方法性能對比

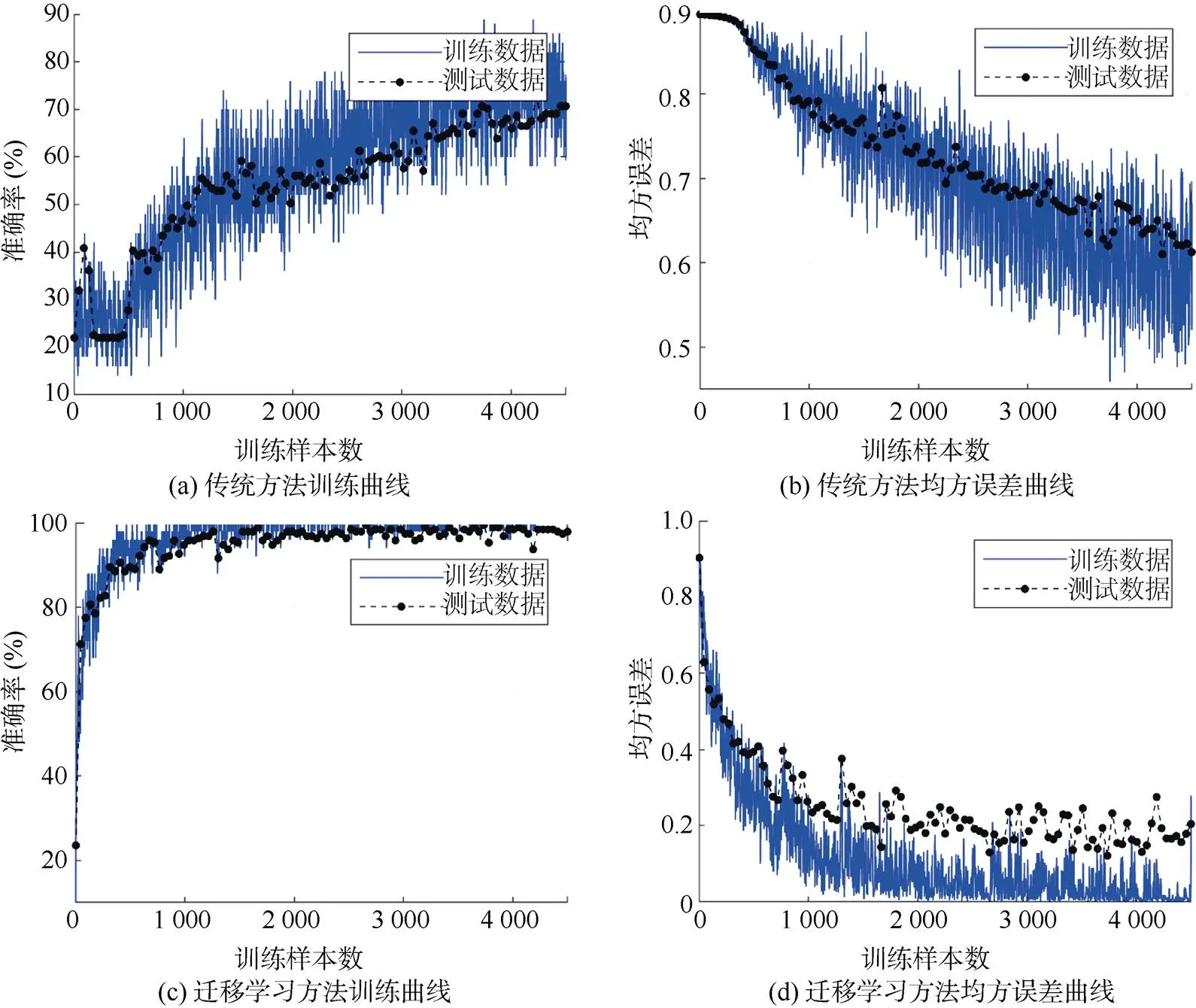

為了對比傳統從初始狀態開始訓練網絡的方法與基于遷移學習的訓練識別方法之間訓練速度與最終識別準確率的差異, 文中基于AlexNet預訓練網絡設計了對比試驗。首先, 參照AlexNet網絡結構設計了1個CNN, 其中僅將AlexNet最后1個全連接層的輸出數目由1 000調整為5, 并用隨機值初始化網絡中所有參數的值; 隨后用聲吶圖像數據訓練該網絡; 同時, 基于第2節中提出的遷移學習方法, 固定AlexNet預訓練網絡的權值, 僅對最后一個全連接層進行替換, 之后用聲吶圖像數據進行訓練。試驗結果如圖6所示。

圖6 傳統方法與遷移學習方法訓練過程對比

由圖6可知, 由于聲吶圖像試驗數據較少, 如果僅通過試驗數據從頭訓練CNN, 將導致網絡難以收斂, 經過4500個樣本的訓練后, 識別準確率僅能達到72.25%; 而如果采用遷移學習的方法, 在AlexNet的基礎上進行遷移學習, 則可以達到95.81%的識別準確率, 同時分析遷移后神經網絡收斂的過程, 可以發現在訓練完2 000個樣本后, 遷移后的網絡識別準確率可以達到95%以上, 網絡訓練的時間可以大幅減少。

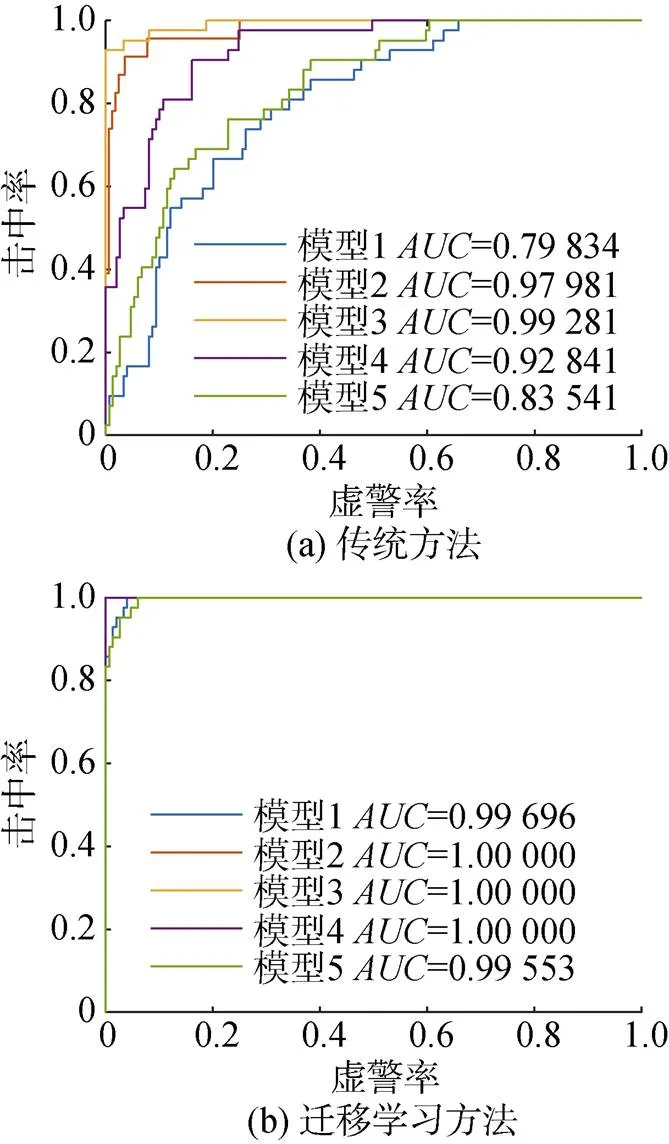

接受者操作特性(receiver operating character- ristic, ROC)曲線是一種反映分類器性能的指標, 可以反映分類器在對某一類目標進行區分時, 在給定的虛警率水平下能達到的正確識別率水平。通常, ROC曲線越靠近(0, 1)點, 說明分類器性能越好, 同時ROC曲線下面積(area under curve, AUC)則定量地說明了分類器對于每一類目標的識別性能。傳統方法與基于遷移學習方法ROC曲線對比如圖7所示。

圖7 傳統方法與遷移學習方法接受者操作特性對比曲線

3.3 不同預訓練網絡性能對比

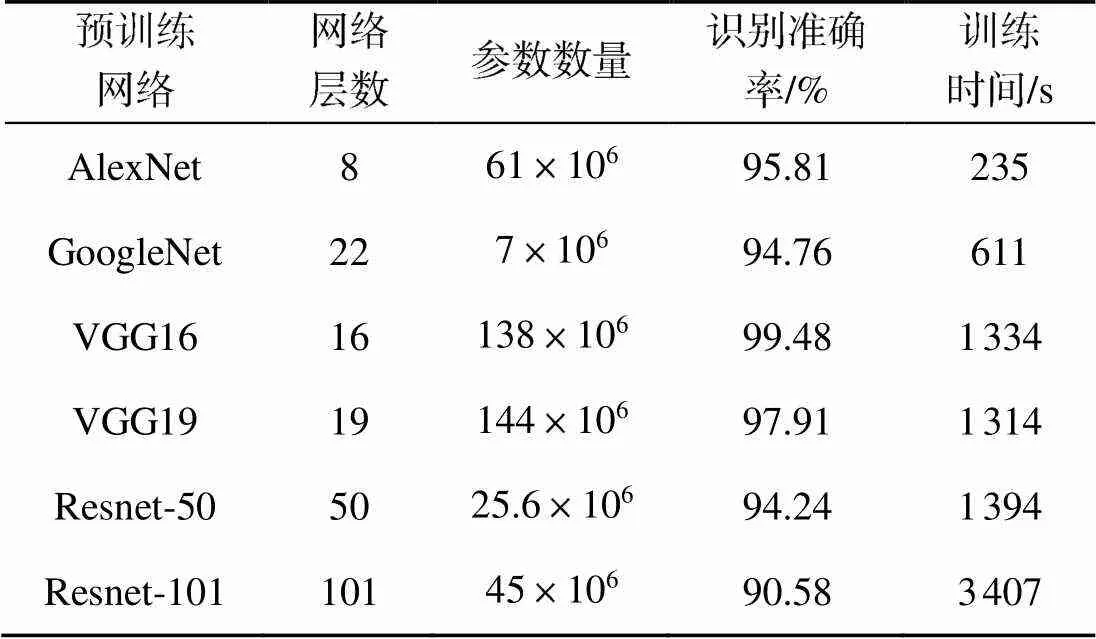

為了對比不同預訓練網絡的識別性能, 選取AlexNet、GoogleNet、VGG16、VGG19、Resnet50和Resnet101等預訓練網絡進行對比。基于以上預訓練網絡進行遷移學習的結果如表2所示。

表2 不同預訓練網絡識別性能對比

由表2可知, 所有選用的預訓練網絡, 其識別準確率都達到了90%以上。其中, 利用VGG16完成訓練的識別準確率最高, 達到99.48%, 完成訓練時間為1334 s; AlexNet完成訓練的時間最短, 為235 s, 同時也達到了95.81%的較高識別率。

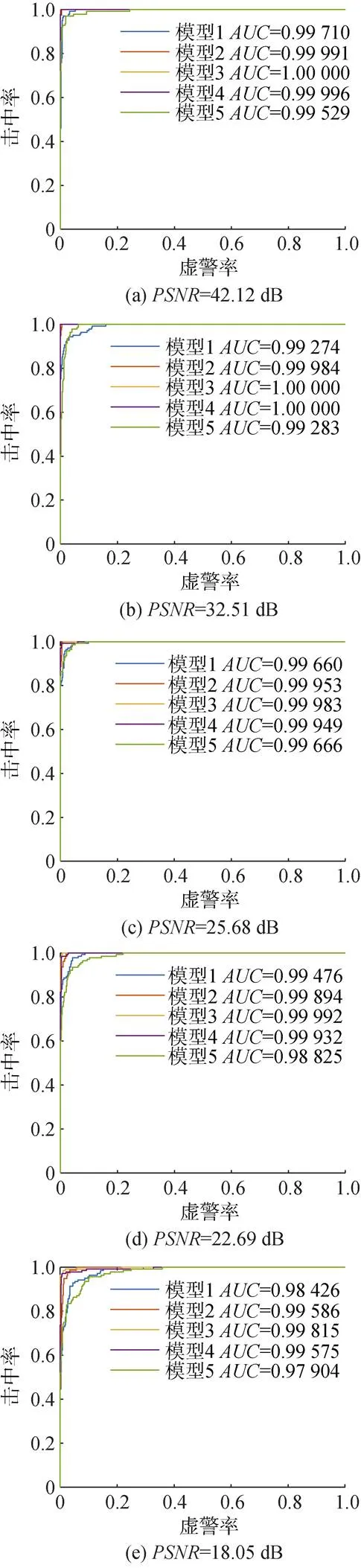

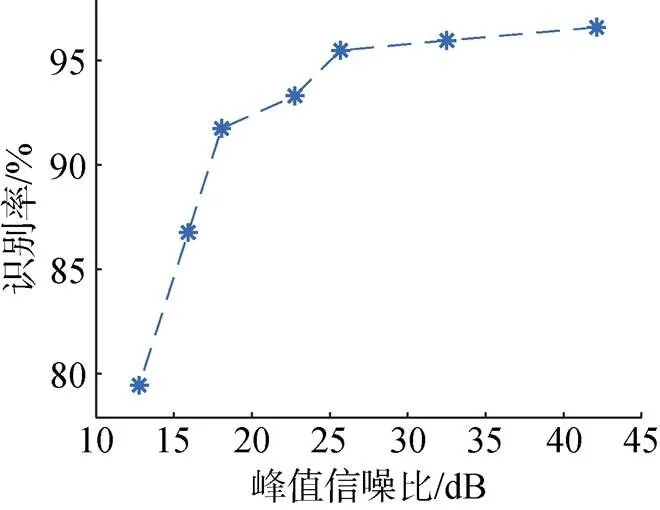

3.4 不同信噪比條件下CNN性能對比

為了說明CNN對于噪聲的容忍能力, 將訓練圖像和驗證圖像均疊加一定的加性高斯白噪聲(additive white Gaussian noise, AWGN), 計算加噪后圖像的峰值信噪比(peak signal-to-noise ratio, PSNR)并進行對比, 預訓練網絡采用AlexNet, 不同信噪比條件下分類器ROC曲線如圖8所示, 識別率相對PSNR變化趨勢如圖9所示。

試驗說明CNN具備較強的噪聲容忍能力, 通常認為PSNR低于20 dB時, 圖像質量已經很差, 然而在這樣的條件下, 基于CNN的識別方法仍能保持90%以上的識別率, 說明基于CNN的識別方法具有較強的穩健性, 即使應用于實際系統中, 圖像受到一定程度的干擾, CNN仍然具備較強的分類能力。

4 結束語

文中利用CNN和遷移學習技術, 提出了一種可用于聲吶圖像識別的新方法, 同時利用縮比模型轉臺成像的試驗方法獲得的聲吶成像數據, 驗證了所提方法的有效性。試驗表明, 當可以獲取一定量的試驗數據時, CNN的分類性能將超過傳統的SVM類方法。而利用遷移學習的方法, 相比傳統將網絡中所有權值進行隨機初始化后開始訓練的方法, 在訓練數據量較小的情況下, 可以獲得更高的識別率和更快的收斂速度, 在同樣訓練樣本量的條件下, 最終識別的準確率提升了23.56%。然后對比了不同預訓練網絡進行遷移學習的訓練時間與識別準確率的差別, 結果表明,利用VGG16作為預訓練網絡可獲得99.48%的識別準確率, 完成訓練時間為1334 s, 而AlexNet完成訓練的時間最短為235 s, 識別率達到了95.81%。最后對比了在不同PSNR下, 基于CNN的分類方法性能變化情況, 結果表明, CNN具備較強的噪聲容忍能力, 在PSNR低于20 dB的情況下, 識別率仍能保持90%以上。以上試驗說明,基于遷移學習訓練CNN的方法可以有效地對聲吶圖像進行分類識別, 并具備準確率高、訓練數據需求較小、噪聲容忍能力強的特點。

圖9 識別率隨PSNR變化曲線

[1] 朱兆彤, 彭石寶, 許稼, 等. 水下目標亮點拓撲特征提取及自動識別方法[J]. 聲學學報, 2018, 43(2): 154-162.Zhu Zhao-tong, Peng Shi-bao, Xu Jia, et al. Multiple Highlights Topology Vector Feature Extraction and Au- tomatic Recognition Method for Underwater Target[J]. Acta Acustica, 2018, 43(2): 154-162.

[2] Krizhevsky A, Sutskever I, Hinton G E. ImageNet Classification with Deep Convolutional Neural Networks[J]Commu- nications of the ACM, 2017, 60(6): 84-90.

[3] He K, Zhang X, Ren S, et al. Delving Deep into Rectifiers: Surpassing Human-Level Performance on ImageNet Classification[C]//2015 IEEE International Conference on Computer Vision(ICCV). Santiago, Chile: IEEE, 2015: 1026-1034.

[4] Szegedy C, Liu W, Jia Y, et al. Going Deeper with Convolutions[C]//2015 IEEE Conference on Computer Vision and Pattern Recognition(CVPR). Boston, Massachusetts, USA: IEEE, 2015: 1-9.

[5] Hu J, Shen L, Sun G. Squeeze-and-Excitation Networks[EB/OL]. (2017-09-05)[2018-09-18]. http://adsabs. harvard.edu/abs/2017arXiv170901507H.

[6] McKay J, Gerg I, Monga V, et al. What's Mine is Yours: Pretrained CNNs for Limited Training Sonar ATR[C]// Oceans 2017-Anchorage. Alaska, USA: Oceans, 2017: 1-7.

[7] Gao F, Huang T, Wang J, et al. Dual-Branch Deep Con-volution Neural Network for Polarimetric SAR Image Classification[J]. Applied Sciences, 2017, 7(5): 447-465.

[8] Huang Z, Pan Z, Lei B. Transfer Learning with Deep Convolutional Neural Network for SAR Target Classification with Limited Labeled Data[J]. Remote Sensing, 2017(9): 907-927.

[9] Glorot X, Bordes A, Bengio Y. Deep Sparse Rectifier Neural Networks[C]//International Conference on Artificial Intelligence and Statistics. Ft. Lauderdale, UK, 2011: 315-323.

[10] 盧建斌, 張云雷, 席澤敏, 等. 基于統計特征的水下目標一維距離像識別方法研究[J]. 聲學技術, 2015, 34(2): 121-126.Jianbin Lu, Yunlei Zhang, Zemin Xi et al., Research on underwater target recognition with statistical features of high resolution range profiles [J]. Technical Acoustics, 2015, 34(2): 121-126.

[11] 閆慧辰, 彭石寶, 許稼, 等. 水下旋轉目標縮比聲納成像方法及系統: CN104297756A[P]. 2014-10-09.

A Sonar Image Recognition Method Based on Convolutional Neural Network Trained through Transfer Learning

ZHU Zhao-tong, FU Xue-zhi,HU You-feng

(1. The 705 Research Institute, China Shipbuilding Industry Corporation, Xi’an 710077, China, 2. 92228thUnit, the People’s Liberation Army of China, Beijing, 102249)

A sonar image recognition method using convolutional neural network trained by transfer learning is proposed aiming at the data shortage problem in making use of conventional training method for sonar image recognition. Based on the principle of transfer learning, the existing pre-trained network is fine-tuned and retrained to reduce the demand for training data. Pool experiment of the scale model verifies the effectiveness of this method. Experimental results show that, on the basis of AlexNet pre-trained network, the transfer learning method uses less training data compared with the conventional learning method, and achieves a recognition rate of 95.81% in a short time. The experiment also compares the performance of the network after the transfer learning based on six kinds of pre-trained networks, and the result shows that the recognition rate of the transfer network based on VGG16 is the highest, which can reach 99.48%. It is verified that the deeply convolutional neural network has certain noise tolerance ability, and can ensure a high recognition rate in the background of strong noise.

sonar imaging; automatic target recognition; convolutional neural network; transfer learning

相關文章導航

1. 趙國貴, 梁紅, 陸禹, 等. 基于多參量聯合特征的水下小目標分類識別[J]. 水下無人系統學報, 2019, 27(6).

2. 杜雪, 廖泓舟, 張勛. 基于深度卷積特征的水下目標智能識別方法[J]. 水下無人系統學報, 2019, 27(3).

3. 李磊, 杜度, 陳科. 基于改進生物啟發模型的UUV在線避障方法[J]. 水下無人系統學報, 2019, 27(3).

4. 杜度. 基于RBF神經網絡參數自整定的AUV深度控制[J]. 水下無人系統學報, 2019, 27(3).

5. 王明亮, 李德隆, 林揚, 等. 基于能量優化的AUV舵角解耦方法[J]. 水下無人系統學報, 2019, 27(3).

6. 楊管金子, 李建辰, 黃海, 國琳娜. 基于主慣導參數特性的傳遞對準調平方法[J]. 水下無人系統學報, 2018, 26(6).

7. 段杰, 李輝, 陳自立, 等. 基于RBF與OS-ELM神經網絡的AUV傳感器在線故障診斷[J]. 水下無人系 統學報,2018, 26(2).

8. 何心怡, 高賀, 盧軍, 等. 逆合成孔徑成像在魚雷真假目標識別中的應用及展望[J]. 水下無人系統學報, 2017,25(4).

9. 溫志文, 楊春武, 蔡衛軍, 等. 復雜環境下UUV完全遍歷路徑規劃方法[J]. 魚雷技術, 2017, 25(1).

10. 吳亞軍, 毛昭勇. 小波神經網絡多傳感器信息融合在AUV深度測量中的應用[J]. 魚雷技術, 2016, 24(4).

11. 何心怡, 高賀, 陳菁, 等. 魚雷真假目標識別技術現狀與展望[J]. 魚雷技術, 2016, 24(1).

12. 張遠彪, 朱三文. 有缺陷的多接收陣合成孔徑聲吶成像技術[J]. 魚雷技術, 2015, 23(4).

13. 范若楠, 曾進, 任慶生, 等. 基于神經網絡響應面的魚雷總體性能參數仿真優化方法[J]. 魚雷技術, 2015, 23(5).

TB566; TN911.73

A

2096-3920(2020)01-0089-08

10.11993/j.issn.2096-3920.2020.01.013

朱兆彤, 付學志, 胡友峰. 一種利用遷移學習訓練卷積神經網絡的聲吶圖像識別方法[J]. 水下無人系統學報, 2020, 28(1): 89-96.

2019-01-16;

2019-05-26.

中國船舶重工集團公司第七〇五研究所博士后基金資助項目; 陜西省博士后科研項目資助(2017BSHQYXMZZ04).

朱兆彤(1988-), 男, 博士, 工程師, 主要研究方向為聲吶成像與目標識別.

(責任編輯: 陳 曦)