人機倫理的私法表述

徐 文

(西南科技大學法學院,四川綿陽621010)

一、問題的提出

我國對于機器人的需求正從彈性需求邁向剛性需求。在過去幾十年間,中國經濟發展依靠大量的資本、資源、勞動力投入,取得了輝煌成就,但隨著人口紅利的逐漸消失,勞動力成本開始急劇上漲,“機器換人”的需求愈顯迫切①據國際機器人聯合會統計,2017年在全球工業機器人市場中,中國、韓國、日本、美國、德國五個國家已成為主要國家,共同占據74%的市場份額。其中,中國占據30%的市場份額。[1]:一方面,第一產業與第二產業的生產方式開始向高端化、機械化、智能化、精細化轉變,無人工廠和無人農場充斥著機器人的身影;另一方面,醫療康復、助老助殘、救災救援、公共安全、企業管理、家庭服務、教育娛樂等領域也逐漸呈現出對機器人的青睞與依賴。習近平總書記在中國共產黨第十九次全國代表大會報告中強調,中國特色社會主義已經進入新時代,我國社會主要矛盾已經轉化成人民日益增長的美好生活需要和不平衡不充分的發展之間的矛盾。為了回應社會發展的需求和人民提高生活水平的需要,國務院、各部委陸續發布了一系列推進機器人產業發展的文件②例如在2016年國務院發布的《中華人民共和國國民經濟和社會發展第十三個五年規劃綱要》中,明確提到要大力發展工業機器人、服務機器人、手術機器人和軍用機器人;在2015年國務院發布的《中國制造2025》中,明確提到要圍繞汽車、機械、電子、危險品制造、醫療健康、家庭服務、教育娛樂等領域對機器人的需求,促進機器人的標準化、模塊化發展;在2017年工業和信息化部發布的文件《促進新一代人工智能產業發展三年行動計劃(2018-2020)》中,明確提到要在老年陪護、康復助殘、兒童教育、消防救援等領域著力研發機器人;在2016年工業和信息化部、發展改革委、財政部聯合印發的文件《機器人產業發展規劃(2016-2020)》中,明確提到要推進機器人的專業化、服務化、系列化、個人化、商品化。此外,北京、天津、河北、廣東、廣州、深圳、佛山、東莞、浙江、昆山、上海、青島、山東、長沙、武漢、洛陽、江西、黑龍江、遼寧、沈陽、撫順、重慶等省市也于2014年至2017年間陸續出臺了推進機器人產業發展的地方性文件。。但是,興盛與危機并存。繁榮發展背后,機器人的出現對人類生活所造成的影響是否可控、可預測?機器人的廣泛使用是否會對公序良俗和傳統倫理文化造成沖擊?我們是否應當通過機器人倫理規則的設計以保護人類在使用機器人過程中的尊嚴、隱私與自由?民法典是否應賦予機器人民事主體地位?若否,機器人致人損害的責任又應由誰承擔?本文希望通過對《歐洲機器人民法規則》的研究與借鑒,討論機器人的定義、評估機器人發展對人類社會的影響、提出保護人類免受傷害的機器人倫理規則、論證機器人致人損害民事責任的承擔,為我國民法典編撰提供有益思路。

《歐洲機器人民法規則》(European Civil Law Rules in Robotic)是歐盟法律事務委員會從民法視角對未來機器人所涉的倫理問題和法律問題所作的研究,所回應的是未來十年至十五年間社會治理中可能因機器人使用而出現的問題③因為就機器人和人工智能技術發展的迅猛程度來看,法律很容易體現出滯后性。不論是法律制度的更新還是倫理守則的制定都不僅應當考慮到其對機器人和人工智能的適用性,還應當考慮到學科間交叉發展(比如納米技術、生物技術、信息科技、認知科學的交叉發展)所可能帶來的挑戰,因此在更新法律制度和設計倫理守則時,不僅應具有預見性,還應根據科技發展的節奏和領域不斷檢視其適用性,而十年至十五年則是較為合理的預測期間。韓國在《智能機器人發展與推廣促進法案》第5條中也持有類似觀點,認為國家與地方政府應當每五年重新制定基本計劃,對機器人產業發展中長期戰略和機器人倫理審查規則等作出調整,以更好的適應社會需求、增進人類福祉。。在展開下文之前,需要說明四個問題:第一,本文引述了《歐洲機器人民法規則》的內容,但不是對其簡單翻譯,而是結合民法理論對其所提出觀點之剖析;第二,本文從民法的視角對機器人定義、機器人倫理、機器人的替代責任進行探討,機器人的制造規范、技術指標、刑事責任、合同責任等不在本文討論范圍之內;第三,就機器人倫理規則的構建而言,絕不是單一學科能夠解決的問題,需要從多學科的視角考察,包括但不限于:機器人科技、計算機科學、人工智能、哲學、倫理學、法學等學科[2],本文僅從民法視角進行分析論證;第四,本文雖是以《歐洲機器人民法規則》為主要參考,卻并未局限于該資料,而是在綜合歐盟于2017年發布的《機器人民法規則》(Civil Law Rules on Robotics)、中國國家標準化委員會于2017年發布的《中國機器人標準化白皮書》、韓國于2008年所發布的《智能機器人發展與推廣促進法案》(Intelligent Robots Development and Distribution Promotion Act)以及歐盟于2006年所發布的《機器人倫理路線圖》(EURON Roboethics Road?map)等資料基礎上的全面研究。

二、已知與未知:人類眼中的機器人

在展開論述之前,須澄清機器人的定義。它不僅體現著人類對機器人及人工智能產品之識別,還決定著“機器人”術語的影響力以及在未來所具有的生命力。在對機器人進行定義時,我們需要明確:機器人與機器、人類的區別是什么?自動機器人與智能機器人的區別是什么?在研究機器人的影響力時,我們需要探討:人類社會是否歡迎機器人的出現?人類是否恐懼機器人的發展?

(一)機器人的定義:基于已知的推斷

當前各國學者尚未對機器人的定義達成共識[3],這并不影響我們從民法的視角對機器人的定義進行探討:一方面,機器人的定義必須足夠具體,能夠將機器人與人類相區分,否則將引起民事主體制度的混亂;另一方面,機器人的定義必須足夠抽象,能夠涵蓋已出現的、將出現的機器人類別,否則將引起民事責任制度的混亂。因此,我們需要從機器人與機器、人類的區別中析出其基礎概念,再從機器人內部的分類中描繪不同機器人的個性,并從個性中提取共性。

1.人、機器與機器人

第一,機器人與人類的相同之處在于相似的物理外表與可匹敵的工作能力。不同之處則不勝枚舉:前者是依靠制造技術誕生的非生物,后者是通過有性繁殖誕生的生物;前者依靠傳感器感知環境,后者依靠感官感受世界;前者受目標驅動,能夠根據環境變化與用戶需求模擬不同情緒,后者受欲望驅動,有情感需求和感知痛苦的能力[4]。第二,機器人與機器的相同之處在于本質上都是機械裝置。前者雖在外延上為后者所囊括,但二者在功能上依舊有諸多不同:前者有類似于人的物理外表,具有一定程度的自動化功能,可以在無人監管的情況下獨立完成既定任務;后者是操作平臺,需要依賴用戶指令或外部控制才能完成任務[5]。例如,在明知前方有人的情況下,挖掘機器人會自動暫停作業,但機器卻不會停止前進。綜上,機器人兼具機器的特征與人的特征,其中:是否是生物、能否繁殖、如何感知環境是區別人類與機器人的關鍵;是否在整體上或部分上具有類似于人的物理外表、是否依賴外部指令完成與環境的交互是區分機器人與機器的關鍵[6]。

2.自動機器人與智能機器人

自動機器人(autonomous robot)是“能夠從環境中獲取信息,并在無人干預的情況下根據既定程序完成操作的機器人”④見國際標準化組織于2012年發布的EN ISO 8373技術標準詞匯表2.9-2.13.,包括:工業機器人、服務機器人(不包括在生產、檢查、打包、集裝等行業的機器人)、個人助理機器人(例如管家機器人、移動助理機器人、寵物鍛煉機器人)、職業機器人(例如環衛機器人,物流機器人,滅火機器人,復原機器人以及手術機器人)、移動機器人(在控制器干預和非干預情況下自主移動)⑤控制器是指以控制機器人抓取物體或移動物體為目的的裝置,由操作者通過編寫程序或輸入邏輯指令進行控制(不包括末端執行器)。關于控制器的定義,參見國際標準化組織于2012年發布的EN ISO 8373技術標準詞匯表2.1.。而智能機器人(smart robot)則是能夠通過感知周圍環境并且(或者)與外界交流而執行任務并調整行為的機器人,比如能夠準確拾起并擺放物件的工業機器人、能夠避免碰撞周圍物體的移動機器人、能夠在崎嶇不平的路面上行走的雙足機器人等[5]。智能機器人與自動機器人的不同之處在于前者不再是生產線上的固定型產品,而是具有判斷能力和適應能力的、能夠根據周圍環境變化調整任務動作的調整型產品。由此顯見,自動機器人與智能機器人的根本差異在于:是否有調適能力。其一,之所以采用“調適能力”而未采用“自治能力”的表述,是因為機器人的“自治”只是在無人干預的情況下基于對即時環境的感知和判斷完成既定任務的技能⑥參見國際標準化組織于2012年發布的EN ISO 8373技術標準詞匯表2.2.。該“自治”是技術性自治、而非自發性自治[6]:不僅是否具有“自治能力”取決于設計者是否置入了令其可以根據環境進行主動調適的代碼;而且“自治”的程度取決于設計者所置入的相關代碼的復雜程度[7]。其二,之所以采用“調適能力”而未采用“意識能力”的表述,一則因為“意識”的來源難以確定,它究竟是機器人自發產生的?是科學家設計的衍生物?還是用戶指令的結果?二則因為如果承認機器人“有意識”,人類就必須如同尊重人權一樣尊重機器人的基本權利,并設計相應的制度以保障其享有基本權利,這顯然與人類社會當前所持的人類中心主義價值觀相違背。雖然有學者認為可以用“阿西莫夫定律”對機器人的意識加以約束⑦“阿西莫夫定律”是作家埃塞克·阿西莫夫在其文學作品《我,機器人》中所創造的機器人法則,其目的是約束機器人、保護人類,由四條規則構成:第一,機器人不得傷害人類,或因不作為而使人類受到傷害;第二,除非違背第一定律,機器人必須服從人類的命令;第三,除非違背第一及第二定律,機器人必須保護自己;第零,機器人不得傷害人類整體,或因不作為而使人類整體受到傷害。參見Issac Assimov.I,Robot[M].New York:Rebound by Sagebrush,1991:50.,但該定律在用語上既不符合法律語言所特有的精確性,也不符合機器語言的可操作性、無法轉換成機器代碼置入程序[8]。例如,如何界定機器人對人類的“傷害”?如何界定機器人的“不作為”?

綜合上述分析,可以得出如下結論:機器人是具有類似于人的物理外表和調適能力的,在無外界干預下能夠通過傳感器完成環境交互、獨立判斷、決策執行的機械裝置。

(二)機器人的影響:基于未知的恐懼

從二十世紀中葉開始,機器人產業嶄露頭角[9]。從制造領域的機器人到工業領域的機器人、從軍用機器人到民用機器人、從商業機器人到生活機器人,機器人的類別不斷豐富、技能不斷拓展。不論是在娛樂領域、養護領域,是在搜救領域、家庭領域,還是在教育領域、文化領域,人類似乎已經很難離開來自機器人“無微不至”的幫助[12]。但是,在享受機器人所帶來便利的同時,人類卻似乎并未打算如同接納法人一樣將機器人接納為社會主體,甚至表現出了對機器人的恐懼[10]。究其原因:一則源于歷史,恐懼機器人將“鳩占鵲巢”的取代人類;二則源于文化,恐懼機器人將“反客為主”地控制人類。

1.來自歷史的恐懼:機器人將取代人類

雖然機器人產業有力地促進了歐洲經濟的發展[7],但西方社會對于“機器人將取代人類”的論斷依然有著根深蒂固的恐懼[11]。追根溯源,不難發現西方社會對機器人的恐懼非形成于一夕之間。十九世紀初期,隨著工業革命的發生,大量機器被制造出來用于取代人力,無數手工業者因此失業。英國的“織布工內德·盧德怒砸織布機”成為手工業者抵觸機械化大生產的標志事件。為了禁止更多“盧德分子”的出現,保護企業財產、防止社會動亂,英國于1812年出臺了《工業破壞限制法案》(Frame-Breaking Act)與《惡意破壞法案》(Malicious Damage Act of 1812),明確將破壞機器的行為定為嚴重罪行。可見,從“盧德運動”開始,西方社會就已形成了“機器廣泛使用將導致人類失業”的思維習慣,因此不難理解當機器人開始被廣泛使用時,他們對機器人的抵觸和恐懼。誠然,如果機器人產業的發展不受規制,受影響的將不只是技術含量低的從業人員,技術含量高的從業人員(如教師、程序員)也將面臨失業。如果國家不對機器人產業發展的方向進行引導和規范,不對機器人功能的研發進行限制和約束,二十一世紀的人類很有可能會成為“垮掉的一代”[7]。

2.來自文化的恐懼:機器人將毀滅人類

在希伯來魔像傳說的影響下,西方社會對機器人充滿恐懼,擔憂人類會有被其控制的一天[12]。2007年,美國科學家比爾·喬伊曾發表“智能機器人將會使人類瀕臨滅絕”的言論,并呼吁科學家停止研發智能機器人,并稱一旦智能機器人升級換代,人類對其的監管便可能出現滯后或根本無力監管[13];在2014年至2015年短短兩年時間內,比爾·蓋茨、史蒂芬·霍金、利隆·馬斯克就相繼發表了“人工智能可能毀滅人類”的言論[14]。在文學作品和社會輿論的警示下,公眾對已廣泛運用于社會各領域的機器人的恐懼逐漸彌漫開來:恐懼機器人會完全取代人類勞動力、恐懼機器人的技術能力不具有穩定性、恐懼服務機器人會使人類形成技術依賴、恐懼生活機器人會侵害人類隱私、恐懼機器人的自主學習能力會導致其行為的不可預測、恐懼機器人致人損害后責任無人承擔、恐懼戶外機器人會造成環境資源被過度開發、恐懼機器人的存在會擾亂生物圈、恐懼醫療護理機器人會危及人類健康與安全、恐懼軍事機器人無法應對敵方突發復雜情況、恐懼人機混合作戰中人類會出現心理疾病、恐懼教育娛樂機器人會逐漸消泯人類創造力等[2]。因此,就在公眾易于把機器人與人類毀滅聯系起來時,如果他們意識到政府正不遺余力地大力發展機器人產業,便可能會出現大面積恐慌,更可能會出現公眾自愿以犧牲生活便捷為代價要求科研人員停止研發機器人的情形。如若如此,科學研究將停滯,經濟發展的原有節奏會被擾亂,“智能”一詞也將永遠存在于文學作品中。為了緩釋人們對于機器人的恐懼,也許通過設置監管機構,從技術研發、生產流通、消費使用等環節進行規范效果更佳,更能在科學技術發展和社會秩序穩定之間實現平衡。有趣的是,與西方社會公眾對機器人“需要又恐懼”的矛盾心理相比,東方社會公眾似乎更平和包容。大多數人未將機器人視為危險的存在物,反而認為機器人是人類的朋友。例如,在二戰后,“鐵臂阿童木”成為日本家喻戶曉的卡通形象,作為仿生人的阿童木能辨善惡、保護人類,它正面陽光的人設為日本社會建立起來機器人的正面形象[7]。可見,民族文化的差異會影響不同國家對機器人的態度及立法。

三、約束與平衡:機器人倫理規則的構建

人類與機器人共存是未來社會發展之趨勢,人機共存將在倫理層面產生諸多問題。部分公眾已經開始呼吁政府叫停或嚴格控制機器人相關研究的發展,并提出了“機器人能夠分辨善惡嗎?”、“機器人會做壞事或者會被用于恐怖活動嗎?”、“機器人會對人類生存構成威脅嗎?”等疑問[2]。如何設計一個框架式的倫理規則,涵蓋機器人的設計、制造、流通、使用等過程,對于促進科技發展與保護人類福祉至關重要。

(一)何為機器人倫理規則?

根據《牛津哲學字典》,倫理學是指對人類行為進行評價的哲學分支[15]。倫理與道德的關系十分微妙:一方面,二者在詞根上都來源于“習慣”,倫理(ethic)來源于希臘文中的習慣(ethos),道德(morality)來源于拉丁文中的習慣(mos/moris);另一方面,二者側重點不同,倫理側重于約束個人與他人、個人與社會的關系,道德則側重于約束個人自身的行為。換言之,倫理更注重調整具有公共性質的社會關系,而道德更側重于約束具有私人性質的社會關系。因此,雖然在不同的宗教信仰、民族文化下,各國可能無法在道德準則上達成一致,但不同文化、地域、政體的國家可以在倫理規則上達成共識并相互借鑒[2]。

機器人倫理(roboethics)的概念最早由科學家Gianmarco Veruggio在2002年主持歐洲機器人研究網絡論壇時提出[16]。他認為機器人倫理規則是在設計、生產、使用機器人過程中人類應當遵守的倫理規則,該規則雖然是為約束機器人的行為而設,但作用對象卻應當是人類,包括機器人的設計者、生產者和使用者[17]⑧機器人倫理不同于機器倫理,后者是讓機器人自己遵守倫理規則。時至今日,機器倫理依然處于理論層面,因為即便是智能機器人也無法保證能夠做出符合道德的決定。例如,韓國在《智能機器人發展與推廣促進法案》第18條中便明確了機器人倫理憲章的作用對象是機器人的開發者、生產者、使用者。。其后,機器人倫理的概念開始被廣泛運用于各官方出版物和行業規范:2014年,第一屆“機器人的倫理、社會、人道主義和生態”機器人倫理國際論壇上(First International Symposium on Roboethics),主辦方正式采用了機器人倫理的概念[2];2006年,第一張機器人倫理路線圖發布,不僅對未來機器人設計、生產、使用過程中可能出現的倫理風險進行了評估,也對機器人倫理規則的構建提出了導向性原則,即尊重人類尊嚴原則、保護人權原則、平等原則、公平原則、公正原則、尊重文化多樣性原則、不歧視原則、不污名化原則、個人責任原則、知情同意原則、尊重隱私原則、保密原則、團結合作原則、社會責任原則、利益共享原則、尊重生物圈原則[2];2014年歐洲機器人法聯盟發布了世界上第一份《機器人規范指引》(The Guideline on Regulating Robotics),對無人駕駛機器人、手術機器人、假體機器人、護理機器人運用過程中的倫理問題進行了分析。

(二)機器人倫理規則框架的構建

在討論具體規則之前,需要明確相關術語的定義。所謂機器人的設計者,是指包括算法設計、程序設計等在內的參與機器人設計的人;所謂機器人的使用者,是指購入機器人自用或用于便利、服務他人的人;所謂機器人的服務對象,是指直接受惠于機器人技能的人,例如病人、殘疾人、兒童、老年人等;所謂機器人的監管者,是指對機器人科技以及機器人產業發展進行監督管理的機構。以下將從規則內容、約束對象、主要涉及的機器人類型三方面論述九條主要機器人倫理規則。其中,規則一、規則二基于人權保護價值構建;規則三至規則五基于自由價值構建;規則六、規則七基于安全價值構建;規則八、規則九基于平等與發展價值構建。

規則一:機器人不得傷害人類。該規則基于人權保護價值提出,約束對象是機器人的設計者和使用者。該規則為機器人倫理規則的基石。因為根據《歐盟基本權利憲章》第3條第1款和《歐洲人權公約》第2條第1款、第3條,人類尊嚴是人權的基礎,神圣不可侵犯、應受尊重與保護。例如,當技術人員操作醫療護理機器人時,若因為設計者在程序設定上的過錯或使用者疏于對機器人進行保養而致病人損害,則構成了對該規則的違反[7]。

表1 機器人主要倫理規則框架簡表

規則二:人類可拒絕機器人服務。該規則基于人權保護價值提出,約束對象是機器人的設計者和使用者,其實質是對規則一的延伸。例如,當機器人為老年人或殘疾人服務的時候,人類可以拒絕受其照料。這一規則中包含兩個子規則:其一,當機器人提供服務時,無須以產生具體損害事實為必要,只要人類覺得不適,可立刻拒絕被服務;其二,在機器人開展服務工作之前,應當首先取得服務對象的明確同意[6]。

規則三:人類在機器人面前有人身自由。該規則基于自由價值提出,約束對象是機器人的設計者,其實質是對價值位階的排序,即當保障自由與保護健康安全相沖突的時候,應優先保證人類自由。例如,安保機器人可能會對小偷的人身自由進行限制、可能會對試圖離家出走的孩童的人身自由進行限制、可能會對想要喝酒的病人的人身自由進行限制。即便在前述情況下,機器人也應當尊重人類的人身自由、服從人類指令,除非該指令有可能損害其自身或第三人的人身、財產安全。如果人類的指令確有傷害其自身的可能,機器人應根據所服務對象的智力水平、意識程度、理解能力明確預警;如果人類發出的指令可能損害第三人、社會公共安全,設計者則應賦予機器人否決權,以避免被人類用作武器[7]。

規則四:機器人不得控制人類。該規則基于自由價值提出,約束對象是機器人的設計者。例如,為了使人類更容易接受陪護機器人或家政機器人,設計者會有意識的令機器人具有“情緒”,使之能夠模仿人類的面部表情,進行互動,甚至會重現已逝親友的面容、聲音。而這樣的互動可能會使老年人、殘疾人、病人、兒童等弱勢群體產生幻覺,誤以為與其交流互動的是人類,從而在決策上形成依賴,最終被機器人控制[7]。因此,設計者應當避免在機器人中置入情緒模塊,避免使人類產生依賴機器人的可能。

規則五:機器人不得長時間與人類獨處。該規則基于自由價值提出,約束對象是機器人的設計者。例如,當人們發現一次性購置醫療護理機器人、陪護機器人、教育機器人的費用遠遠少于連續支付人類護工、支付學校教育的費用后,會產生寧愿在家安度晚年或在家自學的趨勢。該趨勢可能會使人類與機器人的交流成為常態,而使人類與人類的交流成為例外,從而產生主動或被動阻隔人類社會聯系的效果。因此,設計者應當遵循如下原則:當人類與機器人的完全獨處超過固定時限時,應令機器人暫停工作,以避免人類完全放棄社交,罹患心理疾病[7]。

規則六:機器人不得侵害人類隱私。該規則基于安全價值提出,約束對象是機器人的設計者和使用者。例如,生活助手機器人、辦公助手機器人、安保機器人、醫療護理機器人、家庭陪伴機器人基于其工作任務的特性,有機會接觸到大量與隱私相關的數據與信息。在此情形中,不僅機器人服務對象的隱私可能會遭到窺探、竊取、傳播,而且該服務對象親友的隱私也有可能會遭到侵害。因此,對人類隱私的保護不僅要考慮到對隱私的保護程度,對侵害隱私的懲罰程度,還要考慮到隱私權主體同意隱私暴露的程度(該“同意”應當直接來自于機器人服務對象本身,而不是機器人的使用者,否則很有可能出現第三方利用機器人獲取他人隱私的行為)[7]。

規則七:機器人不得擅自處理人類數據。該規則基于安全價值提出,約束對象是機器人的設計者和使用者。例如自動駕駛汽車、無人機、私人助理機器人以及安保機器人會基于其傳感器進行數據處理和數據交流,而這種交流是難以察覺或追蹤的。因此,機器人不得擅自處理人類數據的規則必須從機器人的設計階段就開始遵守,并且機器人對數據的收集、分析、處理、交換、傳播必須直接得到服務對象的同意(此處的“數據同意”與規則六中的“隱私同意”原理類似,不再贅述)[7]。

規則八:人類有使用機器人的平等權利。該規則基于平等價值提出,約束對象是監管者。監管者應在社會保障、稅收等方面建立配套制度,以保證科技的福利平等惠及每一個人。在這一點上可參考韓國《智能機器人發展與推廣促進法案》,其中規定國家有責任開發、推廣機器人,并有義務向公眾介紹使用機器人應遵守的法律規范、公共政策、倫理規則[7]。

規則九:限制人類提高機器人科技。該規則基于發展價值提出,約束對象是監管者。監管者主要應從如下三方面進行限制:其一,從設計目的上進行限制,應規定機器人科技的發展只能著眼于彌補人類工作能力上的缺陷或不足,而不能試圖讓機器人取代人類⑨例如在醫療機器人的設計中,應秉持的原則是:令醫生可以在機器人的幫助下更準確的診斷疾病,更有效的實施手術,以達到減少失誤和風險的可能;而不是試圖讓機器人取代醫生在診療活動中的角色和作用。,例如,應限制后人類主義科學家對人類和機器人混合體(電子人cyborg)的研發[8];其二,從機器人的自治程度上進行限制,確保人類隨時對機器人享有絕對控制權,并規定機器人應當配備“黑匣子”,以記錄其決策過程(決策時間、決策原因、決策邏輯、決策執行)[8];其三,從機器人的情緒設計上進行限制,確保機器人不會與人類(尤其是兒童、老年人、殘疾人等弱勢群體)產生情感聯系[8]。

四、責任主體與責任承擔:機器人致人損害的民事責任

機器人在給社會發展、人類生活帶來便利的同時,也可能對人類的人身、財產安全造成損害:物流機器人在運送貨物過程中可能發生交通事故,造成物品毀損;陪護機器人在看管孩童的過程中可能發生疏忽,造成孩童的傷亡;個人助手機器人在處理數據的過程中可能發生數據泄露,侵害人類隱私;工業機器人在生產過程中可能發生流程錯誤,造成產品缺陷從而致人傷殘;手術機器人在工作過程中可能發生意外,損害人類的身體健康和生命安全;建筑機器人在修建過程中可能發生堆放錯誤,造成物件倒塌致人損害;寫作機器人在創作過程中可能發生抄襲,侵犯他人著作權……類似情況中,機器人是否應當承擔民事責任?如何承擔民事責任?

(一)機器人的法律地位

在討論機器人致人損害民事責任承擔之前,需要明確機器人的法律地位。它是否可以類推適用法人制度、被賦予法律人格?人格一詞衍生于拉丁文中的“面具”[18],法律人格是指享有權利、承擔義務的主體[19]。從身為人類的奴隸、女性不具有法律人格到作為擬制人的法人被賦予法律人格,民事主體制度經歷了從“人可非人”到“非人可人”的演變。與自然人、法人不同,如果因為需要規范機器人的行為、為機器人行為的法律后果找到責任主體就賦予機器人法律人格,將造成現行法律體系之紊亂。第一,法律確實可以強令某物成為法律主體,使其承擔對他人的義務并享有自己的合法權利。但這一切都建立在“法律對某物的行為有約束機制,某物能夠基于對自己行為后果的預測趨利避害”的基礎之上[20]。機器人雖有類似于人的物理外表,也能夠通過傳感器感知環境、獨立思考、做出決策,但其實質是機械裝置,法律對其行為無約束機制,機器人也無法對其行為后果進行預測。第二,法人之所以獲得法律人格,實則是立法者為了從實體法上保護其身后人類的利益(股東、債權人、利益相關者),并從程序法上為其身后的人類維護權益提供便利[19]。該情況不能類推適用于機器人,雖然機器人也廣泛參與經濟生活,但其身后并無人類利益。如果如部分學者所提議,賦予機器人法律人格,再令自然人作為其代理人,這顯然和賦予機器人法律人格的初衷相違背[7]。實際上,如果只是要解決機器人行為致人損害法律責任的問題,完全可以借助保險制度或賠償基金來解決,無須上升到賦予法律人格的地步[7]。第三,正如離開財產談所有權無意義一般,離開法律關系討論法律人格亦無意義[19]。賦予機器人法律人格將對整個法律體系造成連鎖反應。就權利層面而言,我們應認可機器人的什么權利?生命權?健康權?與人類平等的權利?退休的權利?工業機器人是否有權拒絕在危險環境中工作以避免受傷?農業機器人是否有權請假休息?護理機器人是否有權請求薪金?如果答案是肯定的,我們購置機器人的目的何在[7]?此外,賦予機器人法律人格將會模糊人類與機器人的界限、模糊人與非人的界限,加深人類對于科技的恐懼[7]。因此,在當前社會狀態下,即便賦予機器人法律人格,也無異于一紙空文,無實際意義。

(二)機器人致人損害的責任主體

在確定機器人不應被賦予法律人格后,需要解決的問題便是:在發生機器人致人損害的情形中,侵權責任應當由誰承擔?隨著科技的迅猛發展,機器人已經從只能協助人類完成任務演進為可以替代人類完成任務,已經從只能協助人類執行決策演進為可以替代人類獨立決策。所謂機器人的獨立決策能力,即機器人在不受外部控制或影響下所具有的做出決定并將該決定付諸實踐的能力。該決策能力的強弱取決于人類在設計機器人時所設定的機器人與周圍環境的交流能力的強弱。機器人的決策能力越高,生產者、使用者、所有者對其的控制力就越低。因此,當機器人致人損害的時候,便會產生“該侵害行為所造成的損害究竟應當由誰來承擔的責任”的問題[8]。

首先需要明確的是:“機器人的責任”(robots’lia?bility)的表述是不規范的,因為該術語暗含的邏輯是機器人已經是一個可以承擔責任的主體了。規范的表述應當是“對機器人的替代責任”(vicarious liabili?ty for robots)[7]。其次,在分析機器人致人損害責任時,應當盡量利用現有的民事責任體系進行認定。自動機器人致人損害的民事責任問題較為簡單,可以適用產品責任予以解決:包括生產者沒有向消費者履行告知義務;生產者沒有向消費者履行提醒義務(提醒機器人使用過程中所可能產生的危險);機器人的安全系統存在可能致人損害的缺陷等情形。但是智能機器人致人損害的民事責任問題則較為復雜,因為其所具有的自主學習能力直接影響到對損害發生原因的認定(例如,在機器人有自主學習能力的情況下,需要證明該損害的發生究竟是生產者的過錯還是用戶的過錯)。對于此問題,學者們提出了一些觀點:有學者認為應當認可機器人的法律人格,令其對自己的行為獨立承擔責任[21];有學者認為應當適用嚴格責任,只要用戶能夠證明損害已經發生并且在機器人的行為和損害發生之間有因果關系,則應令機器人承擔民事責任[21];有學者認為可根據機器人的自主學習能力強弱和獲取知識的來源進行認定,即機器人的自主學習能力越強,其他當事人的責任就越輕,機器人受到的教育時間越長,其“老師”的責任就越重[21]。但以上提議的實質均是在傳統侵權責任體系之外的新架構。暫且不論諸上提議在邏輯上是否能與傳統侵權責任體系形成銜接,就如上新架構本身而言,在司法實踐中也存在適用問題:例如當損害發生時,案涉當事人可能會根據自己的情況主張適用對自己最有利的歸責原則;又如法官在審理案件時不得不承擔較重的分析責任(對每一個案件中機器人的類別歸屬進行判斷,對每一個判斷尋求專家意見)。這無疑會增加司法成本、浪費司法資源、拖慢訴訟進程。因此,應當盡量在現行法律框架內利用替代責任解決機器人致人損害民事責任承擔的問題。

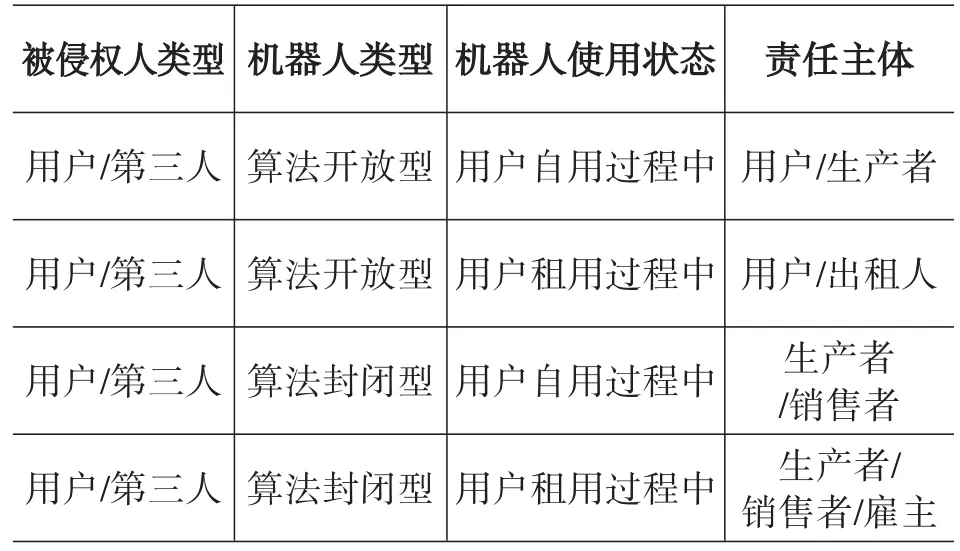

1.路徑一:根據算法類型認定責任主體

表2 機器人致人損害替代責任分析

根據表2,簡要分析如下:

情形一:如果機器人屬于算法開放型,即用戶在購入機器人后可自行編寫算法并寫入機器人,則應當適用一般侵權責任的歸責原則,令致人損害的算法寫入者(機器人生產者或修改算法的用戶)承擔民事責任(對自己造成損害的時候,自負其責;對他人造成損害的時候,承擔替代責任)。在認定算法寫入者身份時,可根據機器人代碼的修改記錄予以辨明。

情形二:如果機器人屬于算法開放型,用戶是在租用他人機器人的過程中產生損害,若其不能證明自己在使用機器人過程中未修改算法,則須自行承擔損害;若其能夠證明自己未修改算法,則宜令其出租人承擔責任。鑒于機器人技能儲備的累積性,機器人與周圍環境的交互的微弱預見性和難以追蹤性,在未修改代碼的情況下,很難確定在一系列承租人中究竟是哪一個當事人發出的指令或傳授的技能致人損害,此時若令某個承租人獨立承擔責任或者令多個承租人承擔連帶責任顯然有違公平原則,令出租人承擔民事責任既可敦促其謹慎選擇承租人,也方便被侵害人維權[7]。

情形三:如果機器人屬于算法封閉型,用戶若在使用機器人過程中遭受損害,則鑒于機器人內置算法的不可修改性,應當在此處適用產品責任,令機器人的生產者與銷售者承擔連帶責任。但在此類情況中還需根據被侵害人類型分情況討論:如被侵害人是用戶,則發生合同責任與侵權責任的競合;如被侵害人是第三人,則應當適用侵權責任。

情形四:如果機器人屬于算法封閉型,用戶是在使用他人機器人過程中遭受損害,此處應分情況討論:若該用戶是消費者,應適用產品責任,令機器人的生產者與銷售者承擔連帶責任;若該用戶是勞動者(機器人產業工作人員),則應適用勞動法,令其雇主承擔責任。

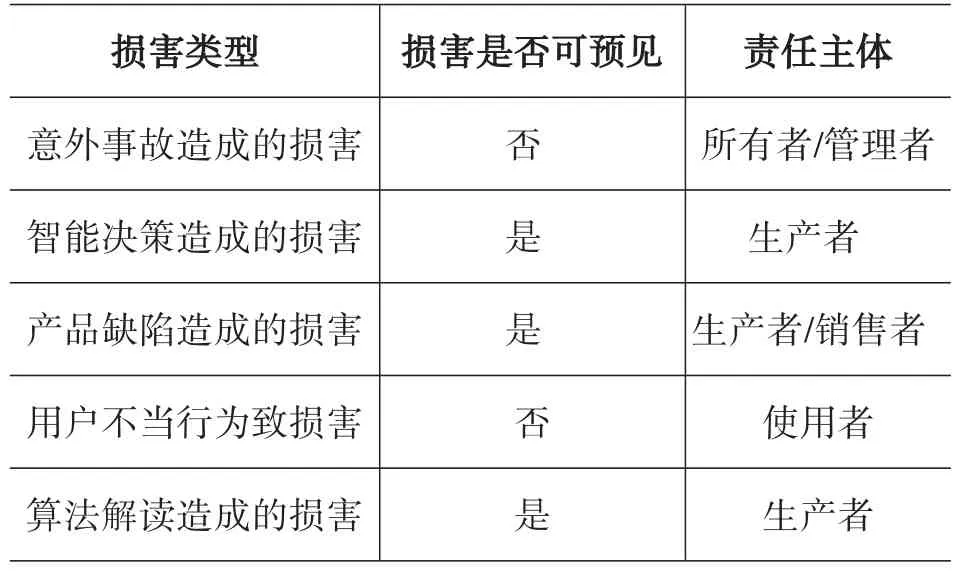

2.路徑二:根據損害類型認定責任主體

表3 機器人致人損害類型分析

根據表3,簡要分析如下:

情形一:因意外事故造成的損害。一方面,機器人在使用的過程中,可能會對其所有者的人身、財產造成損害(例如自動駕駛過程中造成的車輛損壞或人員傷亡),另一方面,機器人在使用過程中,可能會對他人的人身、財產造成損害(例如快遞機器人在搬運物品時丟失他人包裹等情況)。在性質上,此類損害是不可預見也不可避免的,可被視為正常工作中不可避免的意外損害,因此,在責任主體的分配上,根據過錯責任原則,宜將機器人的所有者或管理者認定為責任主體,畢竟風險與收益同在。

情形二:因機器人智能決策造成的損害。此類損害的發生主要源于算法價值排序,因為在損害可能發生時,機器人會根據算法價值做出決策。例如,手術機器人的算法價值排序首位是手術的成功率(機器人會在必要時為提高手術成功率而忽略可能對病人造成的副作用);又如,自動駕駛機器人的算法價值排序首位是最短時間抵達目的地(機器人會在必要時忽視交通規則以提高通行效率)。因此,在責任主體的分配上,根據過錯責任原則,宜將機器人的生產者認定為責任主體。

情形三:因機器人設計缺陷造成的損害。此類損害的發生主要源于產品的設計缺陷。根據媒體報道,曾經發生機器人越過生產區進入辦公區,將辦公人員當成產品予以組裝的事件[22],也發生過自動駕駛機器人未對突發情況作出反映,導致行人死亡事件[23]。在此類情況下,宜適用產品責任,令機器人的生產者與銷售者承擔連帶責任。

情形四:因用戶不當使用行為造成的損害。此類損害的發生主要源于機器人的深度學習能力。例如,2016年微軟設計出了一款聊天機器人Tay。在短短投入使用10余小時后,因用戶故意對Tay發送不當言論而使Tay出口成臟、損及他人名譽[24]。在此類情形中,宜適用過錯責任原則,令具體的使用者承擔責任。

情形五:因機器人讀取能力的有限性而造成的損害。此類損害的發生主要源于算法的不明確或不準確。例如,當算法告知機器人在自動駕駛過程中不能跨越雙實線且未提供除外條件時,可能會出現如下情況:有小孩突然跑出,只有跨越雙實線做臨時躲避駕駛才能避免小孩傷亡,機器人仍執行不能跨越雙實線指令,導致小孩傷亡。在此類情形中,宜適用過錯責任,令生產者承擔民事責任。

(三)機器人致人損害責任的承擔方式

民事責任制度之所以有效,是利用了人們的認知理性和規避風險的天性。例如,當某人被責令承擔賠償責任之后,他便不會再為類似行為以避免再次承擔賠償的后果。但是,目前的責任形式明顯難以對機器人的行為形成有效約束或威懾:即便責任主體的明確能夠及時地在機器人的生產者、銷售者、所有人、使用人之間分配民事責任的承擔,也無法從根本上遏制機器人致人損害的行為[25];即便往上推一層,讓算法設計者在機器人出廠時植入勿傷害人類的代碼,也難以保障我們能夠實現自己所想。原因之一:算法的僵硬性有時會使機器人的行為超出人類的預期[26]。比如,當算法設計者為了使機器人不傷害人類,對機器人植入以下代碼:如果一個運動的存在物有一個頭部且直立行走,它是人類(when_it_has_a_head AND walk_up?right=human_beings)。但如果某人因為先天殘疾或后天事故而無法直立行走,此時機器人可能會出現誤判,從而做出對人類的傷害行為,算法的僵硬性由此可見一斑;原因之二:機器人在做出決策時所依據的算法大部分是以經濟效益為先,少有以法律后果為先。對于機器人而言,每種損害都有“價格”,即便能夠通過算法來明確損害,機器人依然會在經濟學原理的驅動下做出“最優選擇”。因此,除非機器人生產者將常用法律條款翻譯成代碼植入算法,否則機器人致人損害的行為難以避免。因此,在對機器人致人損害行為的遏制上,難以依靠事前的預測,而要依靠事后的有效救濟,即,如何結合機器人的特點靈活運用既有的民事責任承擔方式來真正實現對未來機器人致人損害行為的預防。

根據《中華人民共和國侵權責任法》第15條,侵權責任的承擔方式有停止侵害、排除妨礙、消除危險、返還財產、恢復原狀、賠償損失、消除影響、恢復名譽、賠禮道歉。根據責任承擔方式的特點,可大致將以上方式分為三類:其一,以預防未來可能發生的損害或停止正在進行的侵害為目標的禁止類,所含責任形式有停止侵害、排除妨礙、消除危險;其二,以剝奪所獲得非法利益為目標的剝奪類,所含責任形式有返還財產、恢復原狀、賠償損失;其三,以撫慰受侵害人精神創傷的撫慰類,所含形式有消除影響、恢復名譽、賠禮道歉。其中,剝奪類與撫慰類是可以通過前文所確定的承擔替代責任的民事主體就能夠實現的,而禁止類卻難以僅通過人類行為,而只能依靠對機器人植入含法律屬性的禁止性代碼來實現的。

禁止性代碼在遏制機器人致人損害行為的發生上具有可行性。它不僅在效果上等同于法律的禁止性條款,而且對于機器人而言兼具可讀性與執行性。在計算機語言中,禁止性規定的可用代碼是IF THEN語句。例如,機器人生產者可植入“如果遇見紅燈,就不要通行,否則系統自動關閉”的IF THEN語句。

if light is red:

then stop driving

else:

shut down

end if

如此一來,機器人不僅會因為禁令的內容遵循該規定,還會因為避免自身系統被關閉而遵循交通法規。而之所以要讓禁止性代碼的植入成為責任主體承擔“停止侵害、排除妨礙、消除危險”的內容,是因為若無法律規定,算法設計者不會在自愿的情況下將此類句式大量的嵌入整套算法中。原因有二:其一,不經濟。算法設計者更加希望的是機器人在遇到紅燈的時候能夠通過概率計算來做出最優選擇,即,當其判斷此時穿過紅燈不會撞到行人或車輛,并且能夠快速完成駕駛任務的時候,就穿過紅燈;其二,不自主。算法設計者可能會認為禁止性代碼的植入會影響智能機器人的深度學習能力以及交互能力[25]。

結語

法律具有“應激性”[27]。當科技發展到一定階段時,當每家每戶都使用機器人時,當每一個社會成員都有與機器人共事、交流、合作、生活,甚至共赴愛河的可能時,當機器人在能力上與壽命上可能遠遠超過人類時,當機器人的出現對社會生活所造成的沖擊是無法以任何已知高科技為參照物進行預測時,我們應當意識到社會即將面臨變革,而倫理秩序與法律制度也面臨挑戰。從倫理層面觀察,隨著機器人與人類交流的逐漸深入,人類在人身自由、隱私數據、情感交流、社會交往等方面將可能失去主動性,或受到限制、或受到侵害、或形成依賴[4],而如果有一個框架性的倫理規則能夠覆蓋機器人的設計、生產、使用階段,約束機器人的設計者、使用者、監管者,我們至少能夠保證技術革新始終是為了人類福祉[8],至少能保障人類不會在使用機器人的過程中受到身體與精神上的傷害。從法律層面觀察,機器人在人類社會的廣泛使用將面臨對其法律地位、行為能力、責任承擔的界定,部分法律制度可按兵不動,視具體案情進行微調,但部分法律制度卻已顯示出極大的不適應性、亟待更新,例如侵權責任制度。因此,各國是否能通過倫理規則平衡機器人發展與人類文明之間的關系,是否能對機器人的法律地位達成共識,是否能對機器人的行為進行約束,是回應機器人科技發展對全球治理提出的倫理與法律挑戰中必須直面的問題。“他山之石,可以攻玉”,但“他山之石”不能“徹底攻玉”。在借鑒《歐洲機器人民法規則》等他國經驗的基礎上,我國還應當根據社會經濟發展的節奏、科技文化發展的階段,以及傳統民族文化的底蘊,構建適于我國國情的《機器人倫理規則》,更應當在民法典分則的編撰中考慮到機器人致人損害責任的承擔,以減少司法實踐中的不確定性、正視并回應新時代提出的挑戰。