基于Q-learning及其改進(jìn)算法的信道決策方法

馬海波 俞力 周新 馮熳

摘? 要:信道決策是智能抗干擾通信系統(tǒng)的重要組成部分。針對(duì)信道決策問題,文章提出一種基于Q-learning及其改進(jìn)算法的決策方法,在干擾類型及信道模型未知的情況下,通過和信道交互完成信道決策;針對(duì)固定模式干擾情況下收斂速度慢的問題,進(jìn)一步提出一種改進(jìn)的Q-learning算法。實(shí)驗(yàn)結(jié)果表明,與傳統(tǒng)頻率自適應(yīng)系統(tǒng)相比,通過學(xué)習(xí)干擾系統(tǒng)的信道切換策略直接切換到未被干擾的信道,可有效減少信道反饋時(shí)間,提高工作效率。

關(guān)鍵詞:信道決策;智能通信;抗干擾通信

中圖分類號(hào):TN925;TN972? ? ? 文獻(xiàn)標(biāo)識(shí)碼:A 文章編號(hào):2096-4706(2020)20-0081-04

Channel Selection Strategy Method Based on Q-learning and Its Improved Algorithm

MA Haibo1,YU Li1,ZHOU Xin2,F(xiàn)ENG Man2

(1.Purple Mountain Laboratories,Nanjing? 211111,China;

2.School of Information Science and Engineering,Southeast University,Nanjing? 211096,China)

Abstract:Channel selection strategy (CSS) plays an important role in intelligent anti-jamming communication systems. Aiming at the problem of CSS,this paper proposes a selection strategy method based on Q-learning and its improved algorithm. When the interference type and channel model are unknown,the CSS is completed by interacting with the channel. Aiming at the problem of slow convergence speed under fixed mode interference,an improved Q-learning algorithm is further proposed. The experimental results show that compared with the traditional frequency adaptive system,the channel feedback time can be effectively reduced and the efficiency can be improved by learning the channel switching strategy of the interference system directly switch to the undisturbed channel.

Keywords:channel selection strategy;intelligent communication;anti-jamming communication

0? 引? 言

面向移動(dòng)通信5G和6G發(fā)展需求,開展具有全覆蓋、全頻譜、全應(yīng)用和強(qiáng)安全特征的6G先期研究,突破天地融合大規(guī)模無線傳輸技術(shù),發(fā)展融合大數(shù)據(jù)與人工智能的智能通信技術(shù),在移動(dòng)通信領(lǐng)域重大基礎(chǔ)理論創(chuàng)新和關(guān)鍵核心技術(shù)等方面取得突破是紫金山實(shí)驗(yàn)室普適通信方向的主要聚焦點(diǎn)。在這樣的背景下,作者在從事無線移動(dòng)通信領(lǐng)域系統(tǒng)架構(gòu)設(shè)計(jì)、5G通信物理層研究的相關(guān)工作過程中認(rèn)識(shí)到,要實(shí)現(xiàn)智能、安全通信,信道決策是重要的環(huán)節(jié),也是高頻譜利用率和通信質(zhì)量的關(guān)鍵。所謂信道決策,即,通過頻譜感知技術(shù),利用信道反饋信息更新調(diào)頻頻點(diǎn),以達(dá)到規(guī)避干擾的目的。然而,傳統(tǒng)的信道決策方法在每次發(fā)射信號(hào)前都要對(duì)信道進(jìn)行檢測(cè)和反饋,工作效率低下,不能滿足實(shí)時(shí)、高效的抗干擾通信要求[1,2]。

隨著人工智能技術(shù)的不斷進(jìn)步,機(jī)器學(xué)習(xí)等智能算法在信道決策領(lǐng)域有了大量的研究與應(yīng)用。其中,強(qiáng)化學(xué)習(xí)作為一種自學(xué)習(xí)系統(tǒng),能夠解決分布式參數(shù)優(yōu)化的問題[3-5],因此,Tao Liang團(tuán)隊(duì)將強(qiáng)化學(xué)習(xí)應(yīng)用于信道決策中,通過引入預(yù)分配和基于權(quán)重的兩種機(jī)制來提高學(xué)習(xí)效率,得到優(yōu)于傳統(tǒng)強(qiáng)化學(xué)習(xí)的信道選擇性能[6];在干擾和信道模型未知的情況下,Liang Xiao等人設(shè)計(jì)了一種基于Q-learning的功率控制算法,網(wǎng)絡(luò)中的次級(jí)用戶通過和無線網(wǎng)絡(luò)不斷交互,進(jìn)而利用反饋更新功率參數(shù)[7]。Youngjune Gwon等通過采用Q-learning算法學(xué)習(xí)信道質(zhì)量,得到最佳介入信道以主動(dòng)躲避干擾信道[8]。Chen Han等人則是對(duì)信道和功率聯(lián)合控制,其中干擾機(jī)可以調(diào)整干擾策略,獲得最大干擾效果,通信方通過在物理層和MAC層選擇傳輸節(jié)點(diǎn)和信道,通過跨層Q-learning獲得最優(yōu)信道及功率的組合[9]。綜上,目前強(qiáng)化學(xué)習(xí)算法在智能信道決策領(lǐng)域已有了廣泛應(yīng)用[10-15]。

基于以上描述,本文旨在基于強(qiáng)化學(xué)習(xí)算法進(jìn)行干擾信道選擇策略,從而實(shí)現(xiàn)對(duì)干擾的有效回避。然而,在實(shí)際的干擾與抗干擾問題中,通信信道的切換都需要一定時(shí)間的觀察才能夠確定對(duì)方下一時(shí)刻的通信信道,這就錯(cuò)過了最佳的時(shí)機(jī)。因此,本文在Q-learning算法的基礎(chǔ)上,提出一種改進(jìn)算法,以實(shí)現(xiàn)實(shí)時(shí)、高效的抗干擾通信。

1? 信道決策模型

考慮一個(gè)典型的抗干擾通信系統(tǒng),其中包括發(fā)射機(jī)、干擾機(jī)、接收機(jī)以及無線信道,系統(tǒng)信道按時(shí)隙劃分,在通信過程中不考慮干擾類型并且頻譜感知結(jié)果正確。假設(shè)系統(tǒng)的傳輸頻段被均勻劃分為M個(gè)帶寬相等的信道,即,信道的集合可以記為{0,1,2,3,…,M-1}。由于發(fā)射機(jī)和干擾機(jī)的發(fā)射功率有限,每次切換信道時(shí)默認(rèn)只選擇其中一個(gè)信道進(jìn)行通信或干擾。用戶通過頻譜感知技術(shù)獲得信道的狀態(tài),進(jìn)而利用強(qiáng)化學(xué)習(xí)算法學(xué)習(xí)干擾方的信道切換模式,通過避開干擾信道,最終實(shí)現(xiàn)抗干擾效果。

假設(shè)用戶和干擾方每隔時(shí)間T更換一次信道,用戶和干擾的時(shí)隙結(jié)構(gòu)如圖1所示,用戶在τ1時(shí)間內(nèi)進(jìn)行信道決策并發(fā)射信號(hào),τ2時(shí)間內(nèi)用戶通過頻譜感知獲取干擾信號(hào)的信道信息,τ3時(shí)間內(nèi)根據(jù)所獲取的干擾信道信息進(jìn)行Q表更新。

若當(dāng)前時(shí)刻用戶的通信信道為Ci,由用戶通過頻譜感知得到的干擾信道為Cj,則當(dāng)前的狀態(tài)s可記為

(1)

若干擾未成功,則獎(jiǎng)勵(lì)為1;否則,獎(jiǎng)勵(lì)為-1。

2? 基于Q-learning的信道決策算法

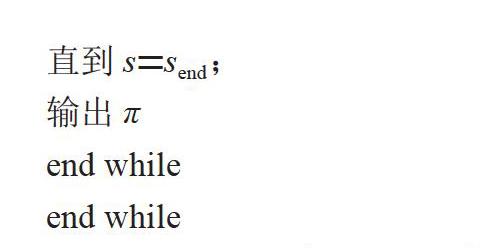

在強(qiáng)化學(xué)習(xí)中,Q-learning是一種離線算法,該算法中存在兩個(gè)控制策略,一個(gè)策略用于選擇新的動(dòng)作,另一個(gè)策略用于更新價(jià)值函數(shù)。簡單來說,Q-learning會(huì)觀察狀態(tài)s下獲得最大獎(jiǎng)勵(lì)的動(dòng)作,但不一定會(huì)執(zhí)行該動(dòng)作,仿真參數(shù)如表1所示,Q-learning用于信道決策的流程算法如下:

對(duì)于環(huán)境中所涉及的狀態(tài)s∈S以及可能采取的動(dòng)作a∈A,令Q(s,a)=0,π(s,a)=,其中s=

while

通信方感知信道的狀態(tài)s=s0;

while

從[0,1]中產(chǎn)生一個(gè)隨機(jī)數(shù)rand,若rand<ε,則通信方從動(dòng)作空間內(nèi)隨機(jī)產(chǎn)生一個(gè)頻點(diǎn)a,否則令a=π(s),ε為探索率;

當(dāng)通信方執(zhí)行結(jié)束這個(gè)動(dòng)作后,通過頻譜感知技術(shù)得到信道反饋,給出即時(shí)獎(jiǎng)勵(lì)? ,此時(shí)信道狀態(tài)變?yōu)閟*;

令a*=π(s*),表示在狀態(tài)s*時(shí)策略π給出的動(dòng)作;

更新值函數(shù),令

Q(s,a)=(1-α)Q(s,a)+α(+γQ(s*,a*));

更新當(dāng)前策略,令

π(s)=;

更新信道信息,令s=s*;

直到s=send;

輸出π

end while

end while

2.1? 固定模式干擾

干擾方會(huì)按固定的順序選擇下一時(shí)刻的干擾信道,其信道切換策略表達(dá)式為:

Cj=(Cj+2)mod 10? ? ? ? ? ? ? ? ? ? ? ? ? (2)

固定模式干擾下系統(tǒng)的仿真結(jié)果如圖2和圖3所示。

由仿真結(jié)果可以看出,基于Q-learning的信道決策算法可以通過和環(huán)境的交互實(shí)現(xiàn)干擾規(guī)避。并且,干擾方具備頻譜感知能力,其信道切換是以未成功干擾為前提,因此需要較長的時(shí)間才可以完成所有狀態(tài)值的更新,由圖3所示的收斂結(jié)果也可以看出,大約訓(xùn)練220次達(dá)到規(guī)避干擾的效果。

2.2? 隨機(jī)模式干擾

即干擾方每個(gè)時(shí)隙都生成一個(gè)隨機(jī)數(shù)rand∈[0,1],再根據(jù)rand值選擇下一個(gè)信道。式(3)給出了隨機(jī)模式干擾下的信道更新策略,圖4為該模式下學(xué)習(xí)前后的時(shí)頻圖。圖5給出了收斂結(jié)果,可以看出,學(xué)習(xí)大約200次左右可以完全規(guī)避干擾。

3? 改進(jìn)的Q-learning算法

上述算法雖然均可取得滿意的信道決策效果,但收斂速度較慢,在實(shí)際中很難應(yīng)用。針對(duì)該問題,本節(jié)針對(duì)固定模式干擾,提出一種改進(jìn)的Q-learning算法。假設(shè)系統(tǒng)中干擾方僅選擇一個(gè)信道發(fā)射干擾信號(hào),在判斷是否干擾成功時(shí),不僅可以對(duì)當(dāng)前的信道進(jìn)行判斷,也可對(duì)其他信道進(jìn)行判斷,即根據(jù)信道反饋的結(jié)果給出的獎(jiǎng)勵(lì)不僅僅是當(dāng)前信道的獎(jiǎng)勵(lì),而是所有信道的獎(jiǎng)勵(lì)rt,t={0,1,2,3,…,M-1},然后利用獎(jiǎng)勵(lì)值對(duì)Q函數(shù)進(jìn)行更新,有效提高了系統(tǒng)的運(yùn)行速度。所提出的改進(jìn)Q-learning算法流程具體算法如下:

對(duì)于環(huán)境中所涉及的狀態(tài)s∈S以及可能采取的動(dòng)作a∈A,令Q(s,a)=0,π(s,a)=,其中s=

while

通信方感知信道的狀態(tài)s=s0;

while

從[0,1]中產(chǎn)生一個(gè)隨機(jī)數(shù)rand,若rand<ε,則通信方從動(dòng)作空間內(nèi)隨機(jī)產(chǎn)生一個(gè)頻點(diǎn)a,否則令a=π(s);

當(dāng)通信方執(zhí)行結(jié)束這個(gè)動(dòng)作后,通過頻譜感知技術(shù)得到干擾頻點(diǎn)Cj,此時(shí)信道狀態(tài)變?yōu)閟*;

令a*=π(s*),表示在狀態(tài)s*時(shí)策略π給出的動(dòng)作;

for t=0:m-1

if Ct=Cj

rt=-1

else rt=1

s′=

更新值函數(shù),令

Q(s,a)=(1-α)Q(s,a)+α(rt+γQ(s′,a*));

end if

end for

更新當(dāng)前策略,令

π(s)=;

更新信道信息,令s=s*;

直到s=send;

輸出π;

end while

end while

圖6給出了Q-learning與改進(jìn)Q-learning算法的收斂曲線對(duì)比,可以看出,改進(jìn)后的Q-learning算法大約僅迭代50次即可收斂,比Q-learning算法的收斂速度提高了4倍左右。

4? 結(jié)? 論

本文重點(diǎn)研究了智能抗干擾通信系統(tǒng)中的信道決策算法,通過將強(qiáng)化學(xué)習(xí)引入到信道決策中,采用Q-learning算法與無線信道進(jìn)行交互,獲取信道信息以完成信道決策。針對(duì)固定模式干擾和隨機(jī)模式干擾這兩種情況進(jìn)行仿真驗(yàn)證,結(jié)果有力驗(yàn)證了Q-learning算法在信道決策中的有效性。為解決Q-learning算法收斂速度較慢的問題,針對(duì)固定模式干擾,本文進(jìn)一步提出一種改進(jìn)的Q-learning算法,仿真結(jié)果表明,所提出的改進(jìn)算法可大大提高收斂速度,并具有良好的有效性和可靠性,能夠保證高質(zhì)量通信系統(tǒng)的實(shí)現(xiàn)。

參考文獻(xiàn):

[1] 趙星宇,丁世飛.深度強(qiáng)化學(xué)習(xí)研究綜述 [J].計(jì)算機(jī)科學(xué),2018,45(7):1-6.

[2] 薛蒙蒙.抗干擾通信中的認(rèn)知引擎關(guān)鍵技術(shù)研究 [D].天津:天津大學(xué),2016.

[3] 郭憲,方勇純.深入淺出強(qiáng)化學(xué)習(xí):原理入門 [M].北京:電子工業(yè)出版社,2018.

[4] 趙彪,李鷗,欒紅志.Q學(xué)習(xí)算法在機(jī)會(huì)頻譜接入信道選擇中的應(yīng)用 [J].信號(hào)處理,2014,30(3):298-305.

[5] 衡玉龍.認(rèn)知無線電網(wǎng)絡(luò)頻譜共享性能分析與信道選擇策略研究 [D].重慶:重慶大學(xué),2013.

[6] JIANG T,GRACE D,MITCHELL P D. Efficient exploration in reinforcement learning-based cognitive radio spectrum sharing [J]. IET Communications,2011,5(10):1309-1317.

[7] XIAO L,LI Y,LIU J L,et al. Power control with reinforcement learning in cooperative cognitive radio networks against jamming [J]. The Journal of Supercomputing,2015,71(9):3237-3257.

[8] GWON Y J,DASTANGOO S,F(xiàn)OSSA C,et al. Competing Mobile Network Game:Embracing antijamming and jamming strategies with reinforcement learning[C]// 2013 IEEE Conference on Communications and Network Security (CNS). IEEE,2014.

[9] HAN C,NIU Y T. Cross-Layer Anti-Jamming Scheme:A Hierarchical Learning Approach [J]. IEEE Access,2018(6):34874-34883.

[10] 楊鴻杰,張君毅.基于強(qiáng)化學(xué)習(xí)的智能干擾算法研究 [J].電子測(cè)量技術(shù),2018,41(20):49-54.

[11] 劉召.基于強(qiáng)化學(xué)習(xí)的衛(wèi)星通信資源分配算法研究 [D].西安:西安電子科技大學(xué),2019.

[12] 劉猛.基于深度學(xué)習(xí)的抗干擾決策技術(shù)研究 [D].北京:中國電子科技集團(tuán)公司電子科學(xué)研究院,2019.

[13] 朱芮,馬永濤,南亞飛,等.融合改進(jìn)強(qiáng)化學(xué)習(xí)的認(rèn)知無線電抗干擾決策算法 [J].計(jì)算機(jī)科學(xué)與探索,2019,13(4):693-701.

[14] XIAO L,JIANG D H,WAN X Y,et al. Anti-Jamming Underwater Transmission With Mobility and Learning [J]. IEEE Communications Letters,2018,22(3):542-545.

[15] JIA L L,YAO F Q,SUN Y M,et al. Bayesian Stackelberg Game for Antijamming Transmission With Incomplete Information [J]. IEEE Communications Letters,2016,20(10):1991-1994.

作者簡介:馬海波(1976—),男,漢族,黑龍江大慶人,高級(jí)項(xiàng)目經(jīng)理,工程師,碩士,研究方向:5G通信系統(tǒng)架構(gòu)。