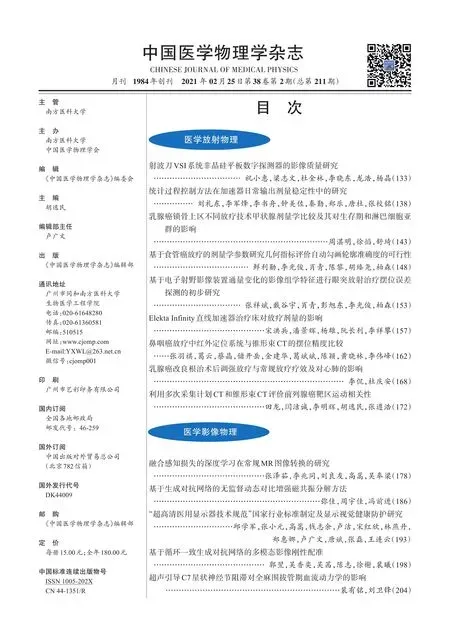

基于循環一致生成對抗網絡的多模態影像剛性配準

郭翌,吳香奕,吳茜,陳志,徐榭,裴曦

1.中國科學技術大學物理學院工程與應用物理系,安徽合肥230026;2.安徽醫科大學,安徽合肥230032

前言

圖像配準是大多數醫學影像分析問題的一個基本步驟,廣泛應用于醫學診斷、手術放射治療規劃、圖譜構建、增強現實、療效分析評價和醫學圖像分割等[1-3]。醫學影像配準分為剛性配準與非剛性配準,其中剛性配準方法通過尋找固定圖像(Fixed Image)和浮動圖像(Moving Image)之間的旋轉平移變換矩陣對齊兩幅圖像[4]。剛性配準不僅為進一步的非剛性配準提供前提基礎、節省圖像優化迭代的計算時間,同時能直觀地顯示不同模態之間圖像的解剖結構差異,輔助醫生進行準確勾畫。傳統的配準方法包括基于表面的方法、基于點的方法(通常基于解剖標記物)和基于體素的方法[5]。盡管基于表面的方法和基于點的方法在圖像配準中仍占有一席之地,但基于體素的方法借助于計算機技術快速發展的優勢而得到了廣泛應用[5]。基于體素的方法的目標是通過計算兩個輸入圖像之間的相似性獲得幾何變換參數,而不需要預先提取特征[6]。但是這些傳統的配準方法往往需要迭代計算相似性度量如均方誤差、互信息與歸一化互信息(NMI)等,由于相似性度量在參數空間上的非凸性等問題,使得配準過程較為耗時且魯棒性較差[1-2]。除此之外,其他方法如基于強度的特征選擇算法通過提取出與強度對應的圖像特征進行圖像配準,然而提取出的特征在解剖學方面難以很好地對應[7-9]。

近年來,深度學習方法在圖像分割、圖像變換、圖像分類和高分辨率圖像重建等許多領域取得了巨大成功。已有文獻報道深度學習方法在圖像配準中的應用,證實該方法的可行性。Miao等[10]使用卷積回歸神經網絡(CNN)進行實時的數字重建放射影像和X-ray影像的剛性配準。Liao等[11]采用CNN和強化學習方法對計算機斷層掃描影像(CT)和錐形束CT影像進行迭代剛性配準。Jaderberg等[12]提出空間變換網絡進行輸入圖像的空間對齊。為了改進CNN網絡魯棒性不足的問題,Miao等[13]利用全卷積神經網絡(FCN)代替CNN進行脊柱的2D/3D剛性配準。另外,Gutierrez-Becker等[14]采用有監督式的回歸網絡模型進行腦部核磁共振圖像(MRI)的剛性配準。盡管上述網絡模型比傳統迭代計算配準方法提升了配準速度,但是這些網絡模型大多是有監督網絡(即需要預先配準好的真實結果)或者需要使用相似性度量參數,這從數據獲取與配準結果精確度的角度上阻礙了網絡模型的訓練。

生成對抗網絡(Generative Adversarial Networks,GANs)是一種深度學習網絡模型,它至少由兩個部分組成:生成器和判別器,使得生成的數據具有與真實數據相同的分布[15]。為了克服在某些應用中獲取圖像對的困難,Zhu等[16]和Isola[17]等提出了循環一致生成對抗網絡(Cycle-consistent Generative Adversarial Networks, CycleGAN),該網絡能夠在沒有成對訓練數據的情況下,學習從輸入到輸出圖像的映射。近年來,一些基于GANs的醫學圖像配準研究已經被報道。Tanner 等[18]通過結合兩種多模態圖像相似性測量NMI 和模態獨立鄰域描述符(Modality Independent Neighborhood Descriptor,MIND)研究GANs在多模態醫學圖像配準中的應用,但是該研究僅將GANs用于生成中間圖像,而非直接用于圖像配準。Fan 等[19]提出了一種對抗性相似網絡自動學習相似性度量,用于訓練腦部MRI 配準。Mahapatra 等[1]在成本函數中采用了新的約束條件,將GANs用于多模態醫學圖像配準,確保訓練后的網絡能夠輕松生成真實、具有合理變形場的圖像。盡管上述工作在一定程度上驗證了GANs 在圖像配準方面應用的可行性,這些方法在神經網絡訓練過程中仍需要有真實配準結果對判別器進行訓練,因此這些網絡容易受到配準結果質量的影響。

本文提出一種基于CycleGAN 的CT 與MR 圖像3D 剛性配準網絡,該網絡與其他圖像配準神經網絡相比,具有如下特點:(1)完全無監督性,即不需要預先配準的真實結果;(2)端對端網絡,即不產生中間圖像,只需輸入待配準的圖像即可得到配準結果;(3)不需使用傳統的相似性度量參數。

1 材料與方法

1.1 數據預處理

神經網絡訓練前需要對圖像數據進行預處理。良好的數據預處理能夠幫助神經網絡加速收斂,同時得到更精確的結果。本研究采用75例腹部病例作為訓練與測試數據集,每個病例包含1幅CT圖像與1幅MR圖像。所有圖像數據(包括CT與MR數據)均進行圖像標準化處理,同時將所有病例進行圖像重采樣并進行圖像剪裁。重采樣后的圖像分辨率為1 mm×1 mm×5 mm,圖像剪裁后大小為400 mm×400 mm,去除多余的空氣部分。為使圖像細節更為突出,設置CT圖像像素值的窗寬窗位分別為350和40,即將圖像原本的CT值范圍限制在(-135,215)范圍內,MR圖像不變。完成以上步驟后,對圖像數據進行歸一化,將所有圖像像素值映射到(-1,1)范圍內。所有圖像數據分為訓練數據集與測試數據集,其中65例病例作為訓練數據集,10例病例作為測試數據集,并與Elastix軟件配準結果進行比較。

1.2 網絡訓練流程

本研究的神經網絡結構基于CycleGAN 網絡模型[16-17],網絡主要分為4 個部分:兩個生成器GAB、GBA和兩個判別器DAB、DBA,其中A 為浮動圖像,B 為固定圖像。剛性變換參數為F,則GAB產生由A 到B 的變換FAB,GBA產生由B到A的變換FBA,DAB和DBA分別用于評價配準后兩幅圖像的配準程度。整體網絡訓練流程如圖1所示。

圖1 網絡訓練流程示意圖Fig.1 The flow chart of training process

1.3 生成器網絡

生成器的目的是根據輸入的圖像對得到剛性變換參數,具體結構如圖2 所示。網絡輸入為多模態3D 圖像對,輸出為剛性變換參數與配準后的圖像。GAB與GBA的網絡結構一致,區別在于GAB中的固定圖像為GBA中的浮動圖像,GAB中的浮動圖像為GBA中的固定圖像。生成器網絡的輸出結果作為判別器網絡的輸入之一。

圖2 生成器網絡結構Fig.2 The structure of the generator network

1.4 判別器網絡

判別器網絡的目的是根據輸入的圖像對判斷兩幅圖像的配準程度,具體結構如圖3所示。網絡的輸入為配準后的圖像對,輸出為圖像對的配準程度。圖像配準程度用0 至1 區間的數表示,輸出結果越接近1,表示圖像配準程度越高,輸出結果越接近0,表示圖像配準程度越低。DAB與DBA的網絡結構一致,區別在于DAB中的輸入圖像對為固定圖像與配準后的浮動圖像,DBA中的輸入圖像對為浮動圖像與配準后的固定圖像。

圖3 判別器網絡結構Fig.3 The structure of the discriminator network

1.5 損失函數

神經網絡訓練涉及到損失函數的選擇,不同的損失函數對網絡訓練結果具有較大影響。本研究在CycleGAN 網絡損失函數的基礎上進行了改進,添加了新的損失項,能夠對網絡進行約束,使得網絡更容易收斂。生成器網絡的損失函數主要由3 個部分組成:(1)判斷損失項L1。該損失項與判別器相關,其作用是使由生成器產生的配準圖像對能夠“瞞過”判別器,令判別器判定配準結果準確可靠。該損失項的具體公式如公式(1)所示,其中DAB為判別器,A 表示固定圖像,B 表示配準后的浮動圖像。(2)輪廓損失項L2。為使網絡更易收斂,引入待配準圖像的輪廓信息作為約束條件,使配準過程朝輪廓重疊的方向進行。其中輪廓信息為圖像的外輪廓,損失項為配準圖像輪廓之間的Dice 系數,如公式(2)所示,ContourA和ContourB分別為固定圖像與配準后浮動圖像的外輪廓信息。(3)循環損失項L3。大部分關于圖像配準的神經網絡只考慮前向傳播過程而忽略反向過程,即只訓練從浮動圖像配準到固定圖像,而忽略從固定圖像配準到浮動圖像,因此這樣的網絡不具備循環一致性,網絡訓練的結果不夠可靠。為了克服這一缺點,CycleGAN 加入了循環損失項,保證了結果的一致性。如公式(3)所示,其中B'表示浮動圖像,A表示固定圖像。總的生成器網絡損失函數LG如公式(4)所示。除了生成器網絡具有損失函數之外,判別器網絡的損失函數如公式(5)所示,其中D代表判別器,公式的第1項表示由生成器產生的圖像經判別器判斷為假,公式第2項表示對于配準好的圖像經判別器判斷為真。

在判別器訓練過程中,需要為判別器提供判斷依據,即輸入參考結果。大部分基于GANs網絡的配準工作均采用了預先配準好的醫學圖像對參考結果進行訓練[1,19]。這些方法的缺點在于:(1)需要采用其他傳統迭代方法對圖像對進行預先配準,無法保證配準結果的準確性與穩定性。(2)網絡訓練的精度隨預先配準結果的精度而變,且不能超過預先配準方法的配準精度。為了避免采用傳統迭代方法進行預先配準的缺點,考慮在圖像配準過程中影響配準結果的主要因素為圖像對之間的像素分布情況和輪廓形狀等,次要因素為圖像對之間對應位置像素值之間的差異,因此構造出與固定圖像具有相同像素分布的圖像代替采用傳統迭代方法得到的配準結果圖像。公式(5)中A'表示與固定圖像具有相同的像素分布,同時像素值不同的構造圖像。

1.6 硬件平臺

本研究中所采用的硬件設備參數如下:操作系統為64位Windows10操作系統,CPU為Intel i7-8700K,主頻 為3.70 GHz,內 存 為16 GB,GPU 為NVIDIA GeForceGTX 1070 Ti,顯存為8 GB。由于計算機顯存限制,在網絡訓練過程中需要限制輸入圖像大小。本研究對原始輸入圖像進行了重采樣與剪裁,生成器與判別器的輸入圖像尺寸為128×128×24。

2 結果

本研究共應用75 例腹部病例作為訓練與測試數據集,其中65例病例作為訓練數據集,10例病例作為測試數據集。采用Python與Pytorch作為神經網絡搭建語言與框架,使用Adam 作為網絡的優化器[20]。我們將提出的方法與Elastix[21-22]配準結果進行對比,詳細比較了傳統迭代配準方法與本方法之間的配準精度與配準時間。

2.1 網絡訓練結果

網絡訓練的學習率前400次循環為0.000 1,400~600次循環為0.000 05,600~1 000次循環為0.000 01,總循環次數為1 000。神經網絡訓練總共耗時3 h。圖4為網絡訓練結束后生成器損失函數曲線圖,其中黃線代表輪廓損失項,綠線代表判斷損失項,紅線代表循環損失項,藍線代表生成器總損失項。曲線圖的橫坐標表示訓練迭代次數,縱坐標表示損失值。所有損失項均取對數。

圖4 神經網絡生成器損失函數曲線圖Fig.4 Loss function curve of the network

可以看出,網絡訓練在前20 次循環訓練時損失項下降較為迅速,20~600 次循環訓練之間下降速度變緩,600 次循環訓練后損失函數趨于平緩。其中,輪廓損失項下降梯度較小,循環損失項對生成器總損失函數下降的貢獻率較大,保證了網絡訓練結果是循環一致的。

2.2 結果對比

分別采用本研究提出的方法與Elastix 對測試集圖像數據進行3D 剛性配準,分別計算未配準前與配準后圖像對之間的Dice系數進行比較。10例測試病例的配準前CT與MR圖像之間外輪廓Dice系數與采用不同方法配準后的圖像對Dice 系數:配準前10 例測試病例的Dice 系數為0.858,Elastix 配準結果平均Dice 系數為0.926,本研究方法配準結果平均Dice 系數為0.925。可以看出采用Elastix配準軟件與本研究方法進行剛性配準后圖像對的Dice 系數均比配準前有所提高,同時本研究方法的配準精度與Elastix 配準結果相當。在配準耗時上,Elastix軟件配準平均耗時12.1 s,而本方法為0.04 s,平均加速比達到了302。由于醫學影像往往在剛性配準后還需要進行形變配準,因此快速有效的剛性配準方法能夠縮短圖像配準流程的時間,提高效率。

圖5 顯示配準前圖像對以及采用不同方法配準后圖像對之間的差異。其中差異圖像中紅色部分代表浮動圖像,綠色部分代表固定圖像。對比不同剛性配準方法得到的結果,可以看出Elastix 配準結果與本研究方法配準結果基本一致。

2.3 結果分析

上述結果表明采用CycleGAN 方法進行腹部3D多模態影像剛性配準具有良好的應用性,既保證了配準結果精度,又極大縮短了配準時間。由于網絡訓練完全無監督,不要求真實配準結果,該網絡易于擴展到其他部位多模態影像配準(如頭頸部病例),同時本研究將在剛性配準基礎上進一步將網絡拓展至多模態影像彈性配準。

3 討論

傳統的醫學圖像配準大多采用迭代計算方法,相對耗時。同時迭代計算的相似性測度在參數空間上可能存在有非凸性問題,因此在配準過程中往往需要根據不同情況選擇合適的相似性度量以及優化方法才能達到滿意的配準需求。本文提出了一種基于CycleGAN 的3D 多模態影像剛性配準方法,相比較于其他已有的圖像配準網絡,該網絡是端對端的無監督網絡,不需要預先配準的真實結果,同時在網絡訓練過程中不需采用任何的相似性測量。在原有CycleGAN 損失函數基礎上,本研究提出了新的函數損失項,有助于神經網絡朝預定方向訓練,同時增強了網絡的收斂性。測試結果表明,與傳統迭代配準方法相比,本研究提出的方法極大降低了圖像配準時間,保持了圖像配準精度。