基于YOLOv4的蛇類圖像識別

王博鑫 李丹

摘 ?要:文章基于YOLOv4進行了蛇類檢測。在谷歌的Open Image數據集中下載已標注蛇類圖片,使用谷歌的Colab平臺進行實驗,在Darknet框架下對網絡模型進行訓練。經對比,YOLOv4的最終性能高于常見的onestage檢測算法,相近準確度下速度快于twostage檢測算法。最終結果顯示,YOLOv4在識別蛇類圖像時準確度達95.55%,平均檢測時間為37 ms,幀處理速率達27FPS(幀/秒)。該檢測速度和檢測精度滿足大部分背景下蛇類檢測的需求,使蛇類檢測與識別具備了可行性。

關鍵詞:深度學習;卷積神經網絡;蛇類;YOLOv4;目標檢測

中圖分類號:TP391.4 ? ? ? ?文獻標識碼:A文章編號:2096-4706(2021)13-0034-03

Snake Image Recognition Based on YOLOv4

WANG Boxin, LI Dan

(School of Computer and Software, Jincheng College of Sichuan University, Chengdu ?611731, China)

Abstract: In this paper, snake detection is carried out based on YOLOv4. Download the marked snake pictures in Google,s Open Image dataset, conduct experiments using Google,s Colab platform, and train the network model under the Darknet framework. After comparison, the final performance of YOLOv4 is higher than the common onestage detection algorithm, and the speed of it is faster than the twotage detection algorithm in the context of similar accuracy. The final results show that the accuracy of YOLOv4 in identifying snake images reaches 95.55%, the average detection time is 37 ms, and the frame processing rate reaches 27 FPS (frames/second).The detection speed and accuracy meet the needs of snake detection in most backgrounds, which makes snake detection and recognition feasible.

Keywords: deep learning; convolutional neural network; snake; YOLOv4; object detection

0 ?引 ?言

蛇是生物種群中常見的爬行動物。我國的蛇類具備高度的種類豐富性和資源豐富性,是蛇類最多的國家之一。但蛇類傷人事件時常發生,尤其是在野外,所以需要有效的辦法檢測蛇類并預警。現在,蛇類的檢測判別基本上依賴于人工來完成,但蛇的棲息環境并非固定,會因為各種原因變化,且蛇類喜陰涼潮濕,活動地點往往有雜物遮擋,因而檢測判別蛇需要花費許多時間成本以及人工成本,且有一定可能誤判漏判。近年來,深度學習作為機器學習領域的一個研究方向,進步非常迅速。基于深度學習的目標檢測在諸多領域中都展現出非常好的效果,得到了廣泛應用。截至目前,有關蛇類檢測識別的研究寥寥可數,而深度學習中的目標檢測是當下非常熱門的計算機視覺應用,利用它來進行蛇類檢測研究非常有前景。

目標檢測試圖找到圖像中需要檢測的目標并給出它們的類別和位置,由于受到諸多干擾因素(例如不同類目標整體外形上的差異、又或者是圖像拍攝時光線、物體覆蓋等要素)的影響,目標檢測當仁不讓地成為CV領域最有難度的問題之一。目標檢測方法大致有兩類:一階檢測算法(onestage)和二階檢測算法(twostage)。twostage目標檢測算法首先生成許多候選區域(即可能包含目標的區域)當作樣本,然后再對生成的各個候選區進行檢測劃分,twostage的典型算法有R-CNN[1]、SPP-Net[2]等算法;其次是onestage算法,該類算法直接通過網絡進行特征提取從而預測目標的類別概率和位置坐標值,但準確度相對較低,速度相對更快。

YOLOv4是近年目標檢測領域里綜合較好的算法。作為一個onestage算法,它能夠以很快的速度完成檢測同時保持一定的準確度。簡而言之就是,速度快的沒它準,準的又沒它快,因此它一出世便引人矚目,因為它能夠在實時檢測中大放異彩。它在原有的目標檢測架構的基礎上,使用近年來卷積神經網絡領域中最好的優化策略,在輸入端、骨干網絡、激活函數、損失函數等諸多方面都有了一定程度的改進,從而使得其在速度和精度上比起上一代的YOLOv3都獲得了一定程度的提升。

1 ?YOLOv4算法在蛇類檢測中的應用

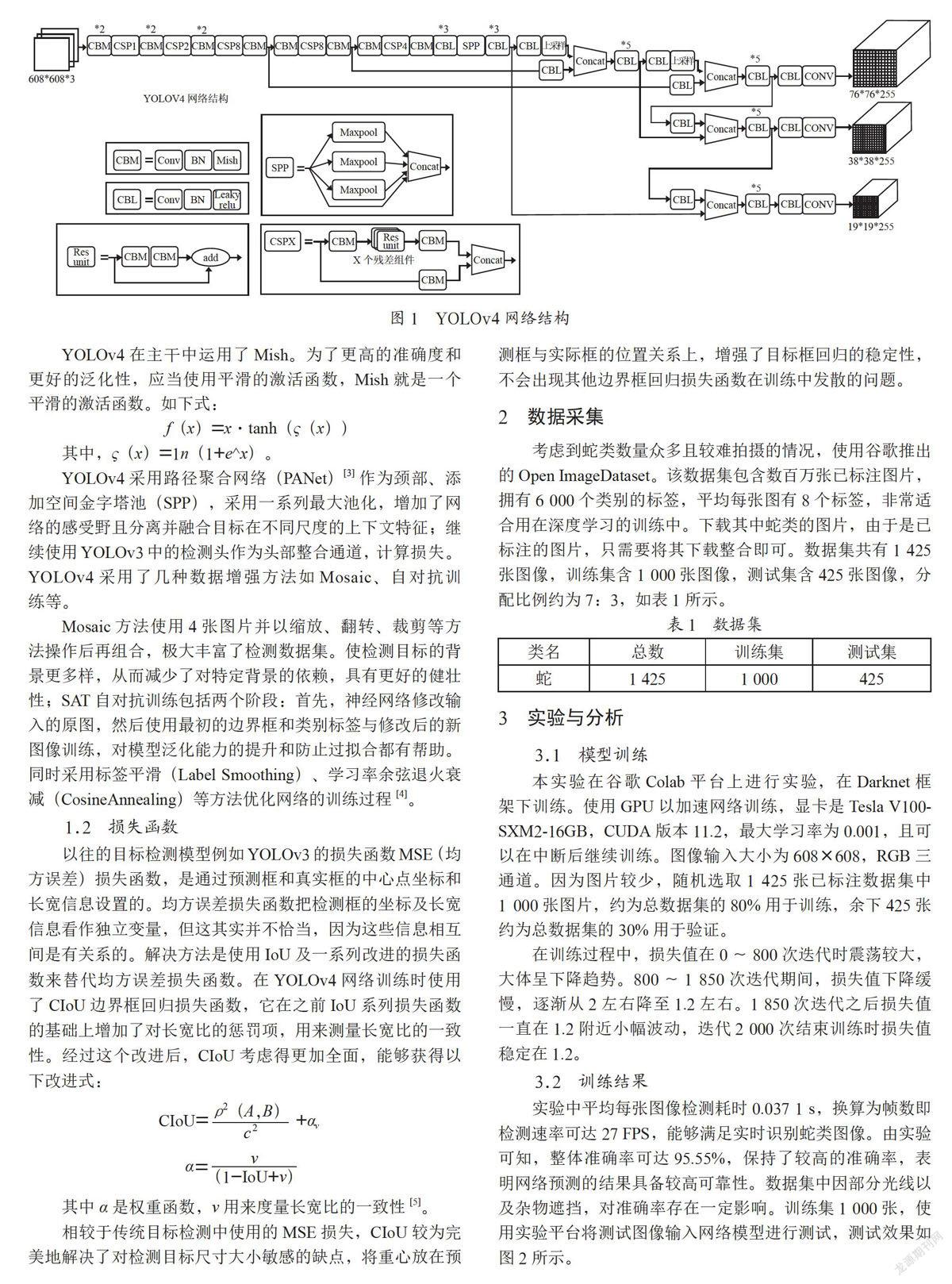

1.1 ?yolov4網絡框架

YOLOv4以CSPDarknet53特征提取網絡為主干,網絡結構如圖1所示。骨干網絡即主干特征提取網絡CSPDarknet53包含一個Darknet卷積塊和5個CSP(Cross Stage Partial)模塊,在各個CSP模塊前有3×3的卷積核,可以加強網絡的學習能力。使用CSPDarknet53結構,減少了很多參數,提升了卷積神經網絡的學習能力,既易于訓練又保證了準確性。

YOLOv4在主干中運用了Mish。為了更高的準確度和更好的泛化性,應當使用平滑的激活函數,Mish就是一個平滑的激活函數。如下式:

f(x)=x·tanh(?(x))

其中,?(x)=1n(1+e^x)。

YOLOv4采用路徑聚合網絡(PANet)[3]作為頸部、添加空間金字塔池(SPP),采用一系列最大池化,增加了網絡的感受野且分離并融合目標在不同尺度的上下文特征;繼續使用YOLOv3中的檢測頭作為頭部整合通道,計算損失。YOLOv4采用了幾種數據增強方法如Mosaic、自對抗訓練等。

Mosaic方法使用4張圖片并以縮放、翻轉、裁剪等方法操作后再組合,極大豐富了檢測數據集。使檢測目標的背景更多樣,從而減少了對特定背景的依賴,具有更好的健壯性;SAT自對抗訓練包括兩個階段:首先,神經網絡修改輸入的原圖,然后使用最初的邊界框和類別標簽與修改后的新圖像訓練,對模型泛化能力的提升和防止過擬合都有幫助。同時采用標簽平滑(Label Smoothing)、學習率余弦退火衰減(CosineAnnealing)等方法優化網絡的訓練過程[4]。

1.2 ?損失函數

以往的目標檢測模型例如YOLOv3的損失函數MSE(均方誤差)損失函數,是通過預測框和真實框的中心點坐標和長寬信息設置的。均方誤差損失函數把檢測框的坐標及長寬信息看作獨立變量,但這其實并不恰當,因為這些信息相互間是有關系的。解決方法是使用IoU及一系列改進的損失函數來替代均方誤差損失函數。在YOLOv4網絡訓練時使用了CIoU邊界框回歸損失函數,它在之前IoU系列損失函數的基礎上增加了對長寬比的懲罰項,用來測量長寬比的一致性。經過這個改進后,CIoU考慮得更加全面,能夠獲得以下改進式:

其中α是權重函數,v用來度量長寬比的一致性[5]。

相較于傳統目標檢測中使用的MSE損失,CIoU較為完美地解決了對檢測目標尺寸大小敏感的缺點,將重心放在預測框與實際框的位置關系上,增強了目標框回歸的穩定性,不會出現其他邊界框回歸損失函數在訓練中發散的問題。

2 ?數據采集

考慮到蛇類數量眾多且較難拍攝的情況,使用谷歌推出的Open ImageDataset。該數據集包含數百萬張已標注圖片,擁有6 000個類別的標簽,平均每張圖有8個標簽,非常適合用在深度學習的訓練中。下載其中蛇類的圖片,由于是已標注的圖片,只需要將其下載整合即可。數據集共有1 425張圖像,訓練集含1 000張圖像,測試集含425張圖像,分配比例約為7:3,如表1所示。

3 ?實驗與分析

3.1 ?模型訓練

本實驗在谷歌Colab平臺上進行實驗,在Darknet框架下訓練。使用GPU以加速網絡訓練,顯卡是Tesla V100-SXM2-16GB,CUDA版本11.2,最大學習率為0.001,且可以在中斷后繼續訓練。圖像輸入大小為608×608,RGB三通道。因為圖片較少,隨機選取1 425張已標注數據集中1 000張圖片,約為總數據集的80%用于訓練,余下425張約為總數據集的30%用于驗證。

在訓練過程中,損失值在0~800次迭代時震蕩較大,大體呈下降趨勢。800~1 850次迭代期間,損失值下降緩慢,逐漸從2左右降至1.2左右。1 850次迭代之后損失值一直在1.2附近小幅波動,迭代2 000次結束訓練時損失值穩定在1.2。

3.2 ?訓練結果

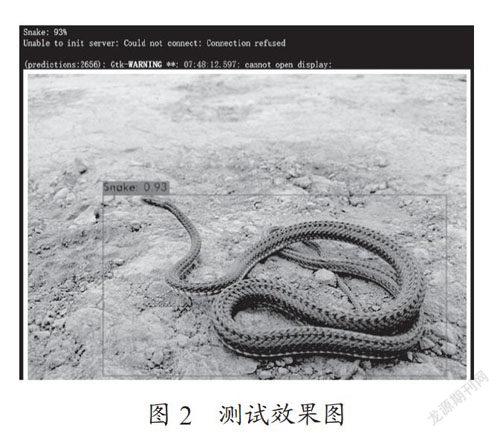

實驗中平均每張圖像檢測耗時0.037 1 s,換算為幀數即檢測速率可達27 FPS,能夠滿足實時識別蛇類圖像。由實驗可知,整體準確率可達95.55%,保持了較高的準確率,表明網絡預測的結果具備較高可靠性。數據集中因部分光線以及雜物遮擋,對準確率存在一定影響。訓練集1 000張,使用實驗平臺將測試圖像輸入網絡模型進行測試,測試效果如圖2所示。

在同樣的數據集、設備和同樣參數設定的條件下,與采用YOLOv3[6]和Faster R-CNN[7]網絡檢測算法對比,如表2所示。

YOLOv4檢測算法的準確度與二階(twostage)算法Faster R-CNN接近,卻相比其FPS快了11幀/秒。相比于同為一階(onestage)算法的YOLOv3,準確度提高了2.14%,FPS提升了4幀/ 秒。

4 ?應用——蛇類檢測預警系統

蛇類的檢測識別與預警對人類群居地區的安全至關重要,特別是在部分蛇類常出沒的地區。近年來,隨著科考人員野外考查的進一步開展,我國蛇的種類和數量不斷增多,在部分地區經常發生蛇類攻擊人類甚至咬人事件。出于以人為本的理念,不論是毒蛇還是非毒蛇,都建議在蛇類常出沒的高危地區配置蛇類檢測預警系統。蛇類喜陰涼、潮濕,行動軌跡難以預測,容易對人民生命財產安全造成威脅。鑒于由專業人員進行人工檢測的難度大、成本高,且無法安排專業人員在各個蛇類易出沒的人類居住地區隨時隨地進行人工檢測,故設計該蛇類檢測模型以應用于蛇類檢測識別預警系統。此模型能夠很好地應對復雜的場景,并且相較于人工檢測,成本大幅降低且可行性大幅提高。如上圖2,在色系相近的背景下也能較好地檢測識別出蛇類。不過被遮擋目標的檢測準確度還有待提升,由于數據集較小,數據豐富程度也有待增強。

5 ?結 ?論

本文針對國內蛇類檢測識別缺失的問題進行研究,提出了基于YOLOv4算法的輕量級蛇類圖像檢測識別模型,模型適用范圍囊括了大部分常見蛇類,能夠很好地解決許多場景下蛇類圖像的檢測識別問題。基于YOLOv4目標檢測網絡進行目標檢測,建立數據集并增強數據,訓練模型,提高了模型的準確度。本文方法比傳統圖像處理方法和過去的蛇類深度學習目標檢測算法性能更佳,能夠做到實時檢測。但因為已標注蛇類圖像數據集較少,有一定的局限性。希望后續能夠增加數據集的數量,相信經過更多的訓練后,模型的各方面都會有提升。后續也會繼續收集數據集,對模型進行優化和完善。

參考文獻:

[1] GIRSHICK R,DONAHUE J,DARRELL T,et al. Rich Feature Hierarchies for Accurate Object Detection and Semantic Segmentation [C]//2014 IEEE Conference on Computer Vision and Pattern Recognition.Columbus:IEEE,2014:580-587.

[2] HE K,ZHANG X Y,REN S Q ,et al. Spatial Pyramid Pooling in Deep Convolutional Networks for Visual Recognition [J].IEEE Transactions on Pattern Analysis and Machine Intelligence,2015,37(9):1904-1916.

[3] MEI Y Q,FAN Y C,ZHANG Y L,et al. Pyramid Attention Networks for Image Restoration [EB/OL].[2020-04-28].https://www. researchgate.net/publication/341040607.

[4] BOCHKOVSKIY A,WANG C Y,LIAO H Y M. YOLOv4:Optimal Speed and Accuracy of Object Detection [J/OL].(2020-04-23).arXiv:2004.10934 [cs.CV].https://arxiv.org/abs/2004.10934.

[5] ZHENG Z,WANG P,LIU W,et.al. DongweiRen.Distance-IoULoss:Faster and Better Learning for Bounding Box Regression [C]//Proceedings of the AAAI Conference on Artificial Intelligence.2020,34(7):12993-13000.

[6] REDMON J,FARHADI A. YOLOv3: An Incremental Improvement [J/OL].(2018-04-08).arXiv:1804.02767 [cs.CV].https://arxiv.org/abs/1804.02767.

[7] REN S,HE K,GIRSHICK R,et al. Faster R-CNN:Towards Real-Time Object Detection with Region Proposal Networks [J].IEEE Transactions on Pattern Analysis and Machine Intelligence,2017,39(6):1137-1149.

作者簡介:王博鑫(2000.04—),男,漢族,四川西昌人,本科在讀,研究方向:軟件工程。