圖卷積網(wǎng)絡(luò)的行為識(shí)別技術(shù)在空手道技戰(zhàn)術(shù)分析中的應(yīng)用

郭建平,李 希,劉俊明,徐大宏,謝 健

(湖南師范大學(xué) a.體育學(xué)院,b.信息科學(xué)與工程學(xué)院,中國 長沙 410081)

空手道組手運(yùn)動(dòng)與跆拳道、散打等運(yùn)動(dòng)項(xiàng)目同屬于格斗對(duì)抗類項(xiàng)目,該項(xiàng)目在世界范圍內(nèi)特別是在日本及歐洲等國家和地區(qū)經(jīng)過長期的發(fā)展,已達(dá)到很高的水平。2016年8月3日,國際奧委會(huì)宣布空手道成為東京奧運(yùn)會(huì)的正式比賽項(xiàng)目,我國空手道隊(duì)正面臨世界空手道強(qiáng)國的挑戰(zhàn)。因此,通過對(duì)國內(nèi)外優(yōu)秀空手道運(yùn)動(dòng)員技戰(zhàn)術(shù)的跟蹤分析與研究,發(fā)現(xiàn)空手道組手比賽的技戰(zhàn)術(shù)運(yùn)用特點(diǎn),探索空手道競賽的制勝規(guī)律,可以為運(yùn)動(dòng)員的訓(xùn)練及比賽提供科學(xué)指導(dǎo)。

技戰(zhàn)術(shù)分析是體育競技比賽中十分重要的一個(gè)環(huán)節(jié)。傳統(tǒng)的技戰(zhàn)術(shù)分析,通過觀看訓(xùn)練及比賽視頻,分析運(yùn)動(dòng)員的技術(shù)動(dòng)作特點(diǎn),比賽過程中的移動(dòng)習(xí)慣等信息。在訓(xùn)練中利用這些信息提升運(yùn)動(dòng)員的訓(xùn)練效率與效果。在比賽中則可利用這些信息,針對(duì)對(duì)手的技術(shù)特點(diǎn)和運(yùn)動(dòng)習(xí)慣制定相應(yīng)的戰(zhàn)術(shù)。但是,傳統(tǒng)技戰(zhàn)術(shù)分析方法是通過人工觀看大量訓(xùn)練及比賽視頻的方式獲取的,存在著人力成本高、數(shù)據(jù)丟失嚴(yán)重、延時(shí)長、精度低等問題,從而也制約了技戰(zhàn)術(shù)情報(bào)分析工作的效率。

我們建立一種新的圖卷積模型,以運(yùn)動(dòng)員關(guān)節(jié)點(diǎn)信息作為輸入數(shù)據(jù),實(shí)現(xiàn)對(duì)空手道運(yùn)動(dòng)員的技術(shù)動(dòng)作識(shí)別,在此基礎(chǔ)上可以完成技戰(zhàn)術(shù)分析中的運(yùn)動(dòng)員動(dòng)作頻度統(tǒng)計(jì)及其軌跡跟蹤的自動(dòng)智能分析。在傳統(tǒng)方法中融入人工智能技術(shù),實(shí)現(xiàn)高效的技戰(zhàn)術(shù)分析方法,從而解決傳統(tǒng)技戰(zhàn)術(shù)分析中的一些問題,使后續(xù)的訓(xùn)練以及賽前的準(zhǔn)備及技戰(zhàn)術(shù)運(yùn)用更加精準(zhǔn)有效。

1 文獻(xiàn)回顧

對(duì)體育訓(xùn)練和比賽中的技戰(zhàn)術(shù)進(jìn)行分析和研究是體育科研工作的重要內(nèi)容,近年來越拉越多的專家學(xué)者對(duì)空手道比賽和訓(xùn)練的技戰(zhàn)術(shù)作了研究。周永盛等人[1]通過對(duì)空手道競技方式的演變進(jìn)行研究與總結(jié),得出空手道競技方式的演化體現(xiàn)現(xiàn)代競技體育的趨勢;文獻(xiàn)[2]中提出空手道已成為我國大學(xué)生生活的組成部分,通過采樣上海理工大學(xué)和湖州師范學(xué)院,采用問卷調(diào)查法及文獻(xiàn)資料法等方法對(duì)空手道訓(xùn)練后大學(xué)生的認(rèn)知情況進(jìn)行研究,有利于更好地推廣空手道項(xiàng)目;還有學(xué)者運(yùn)用對(duì)比分析的研究方法對(duì)空手道運(yùn)動(dòng)進(jìn)行分析,如文獻(xiàn)[3]中趙桃杰等使用對(duì)比法及邏輯分析法等方法,參考跆拳道、散打、空手道和拳擊等項(xiàng)目的無氧供能能力測定,從空手道無氧耐力訓(xùn)練的重要性方面著手,闡述了空手道運(yùn)動(dòng)中組手和型的訓(xùn)練對(duì)機(jī)體無氧糖酵解供能能力的影響;文獻(xiàn)[4]中將2017年全國競技空手道錦標(biāo)賽作為研究對(duì)象,使用文獻(xiàn)資料法及數(shù)理統(tǒng)計(jì)法等研究方法,得出在此比賽中參賽選手相比于往屆技術(shù)水平更高;任潔[5]為研究空手道中運(yùn)動(dòng)損傷發(fā)生的規(guī)律,將河南省空手道運(yùn)動(dòng)員作為樣本,對(duì)運(yùn)動(dòng)員的運(yùn)動(dòng)損傷狀況進(jìn)行研究得出空手道運(yùn)動(dòng)員損傷率、損傷部位、損傷時(shí)間以及損傷的原因;文獻(xiàn)[6]通過使用邏輯分析法、數(shù)理統(tǒng)計(jì)法及專家訪談法等研究方法,將2016年全國空手道錦標(biāo)賽男子組手運(yùn)動(dòng)員比賽視頻作為研究對(duì)象,發(fā)現(xiàn)全國男子組手運(yùn)動(dòng)員常用技術(shù)以及總結(jié)出戰(zhàn)術(shù)使用的規(guī)律和特點(diǎn);謝勁文等人[7]使用文獻(xiàn)綜述等方法梳理了日本空手道入奧的經(jīng)歷,總結(jié)了日本空手道備奧的模式與體系,分析運(yùn)動(dòng)員的技術(shù)戰(zhàn)況,為中國空手道奧運(yùn)備戰(zhàn)提供依據(jù)與指導(dǎo);馮亞杰等[8]對(duì)2018年全國空手道冠軍總決賽采用文獻(xiàn)資料法等研究方法,分析了空手道項(xiàng)目目前在國內(nèi)的競爭格局,提出了理論性的建議,為我國2020年東京奧運(yùn)會(huì)上的空手道項(xiàng)目助力。

隨著攝像頭技術(shù)的不斷發(fā)展,訓(xùn)練行為分類模型的數(shù)據(jù)集對(duì)數(shù)據(jù)的處理也更加精準(zhǔn)。視頻中人體骨架信息與常規(guī)視頻數(shù)據(jù)相比,背景的干擾小。隨著骨架數(shù)據(jù)的出現(xiàn),多位學(xué)者試著將圖卷積神經(jīng)網(wǎng)絡(luò)(Graph Convolutional Network,GCN)應(yīng)用到基于人體骨骼的行為分類中,GCN與CNN性質(zhì)相同,都是特征提取器,但是CNN處理的是有規(guī)則的網(wǎng)格結(jié)構(gòu),而GCN可以將人體骨架的拓?fù)鋱D作為輸入。2018年以來,基于GCN的研究取得了不錯(cuò)的進(jìn)展。文獻(xiàn)[9]提出新的動(dòng)態(tài)骨架模型即時(shí)空圖卷積網(wǎng)絡(luò)(Spatial-Temporal Graph Convolutional Networks,ST-GCN),能夠自動(dòng)從骨架數(shù)據(jù)中學(xué)習(xí)到空間和時(shí)間的模式;文獻(xiàn)[10]提出一種新的雙流自適應(yīng)圖卷積網(wǎng)絡(luò)(Two-stream Adaptive Graph Convolutional Network,2s-AGCN)用于基于骨架的行為分類。文獻(xiàn)[11]提出了行為-結(jié)構(gòu)圖卷積網(wǎng)絡(luò)(Actional-Structural Graph Convolution Network,AS-GCN),其中引入了一個(gè)編碼-解碼結(jié)構(gòu)來獲取特定行為潛在的依賴性,即行為鏈接,使用現(xiàn)存在的骨架圖來表征高階依賴性,即結(jié)構(gòu)鏈接,通過疊加行為-結(jié)構(gòu)圖卷積和時(shí)間卷積來學(xué)習(xí)行為中空間和時(shí)間特征;Si等[12]提出了一種新的注意增強(qiáng)圖卷積LSTM(Attention Enhanced Graph Convolutional LSTM Network,AGC-LSTM),其不僅能夠捕獲空間和時(shí)間的顯著特征,而且能夠探索時(shí)空域的共現(xiàn)關(guān)系。目前的方法沒有充分利用骨架圖的拓?fù)浣Y(jié)構(gòu),僅是對(duì)輸入樣本的骨架節(jié)點(diǎn)或者鄰接矩陣進(jìn)行人工的設(shè)置和固定,未能解決這一問題,文獻(xiàn)[13]設(shè)計(jì)一個(gè)由節(jié)點(diǎn)推理網(wǎng)絡(luò)(Joints Relation Inference Network,JRIN)和骨架圖卷積網(wǎng)絡(luò)(Skeleton Graph Convolutional Network,SGCN)組成的端到端的體系結(jié)構(gòu),JRIN可以全局的聚合每個(gè)關(guān)節(jié)的時(shí)空特征,然后推斷每個(gè)關(guān)節(jié)的最優(yōu)關(guān)系,SGCN使用最優(yōu)矩陣進(jìn)行行為識(shí)別。

2 圖卷積模型

圖卷積模型大量應(yīng)用于基于骨架關(guān)節(jié)點(diǎn)的序列數(shù)據(jù)中,其中構(gòu)建圖模型是圖卷積算法中的關(guān)鍵環(huán)節(jié)。現(xiàn)有的圖卷積模型如ST-GCN,AS-GCN存在著圖結(jié)構(gòu)單一、關(guān)節(jié)點(diǎn)之間關(guān)聯(lián)性不強(qiáng)、對(duì)于不同行為區(qū)分度不夠等問題。本文設(shè)計(jì)使用Delaunay三角剖分方法來構(gòu)建圖模型,從而可以獲得更豐富的特征信息,提高了行為的區(qū)分度。

2.1 基于骨架節(jié)點(diǎn)的圖的構(gòu)建

2.1.1 Delaunay算法原理 在Delaunay三角剖分過程中,對(duì)每一個(gè)插入點(diǎn)集中的點(diǎn),都需要經(jīng)過局部優(yōu)化處理,對(duì)插入的點(diǎn)進(jìn)行判斷,以便確定局部剖分圖。

局部優(yōu)化處理具體實(shí)現(xiàn)過程為:

(1)相鄰兩個(gè)三角形組成一個(gè)四邊形;

(2)對(duì)兩個(gè)三角形做外接圓,查看點(diǎn)集中其它點(diǎn)是否在外接圓內(nèi);

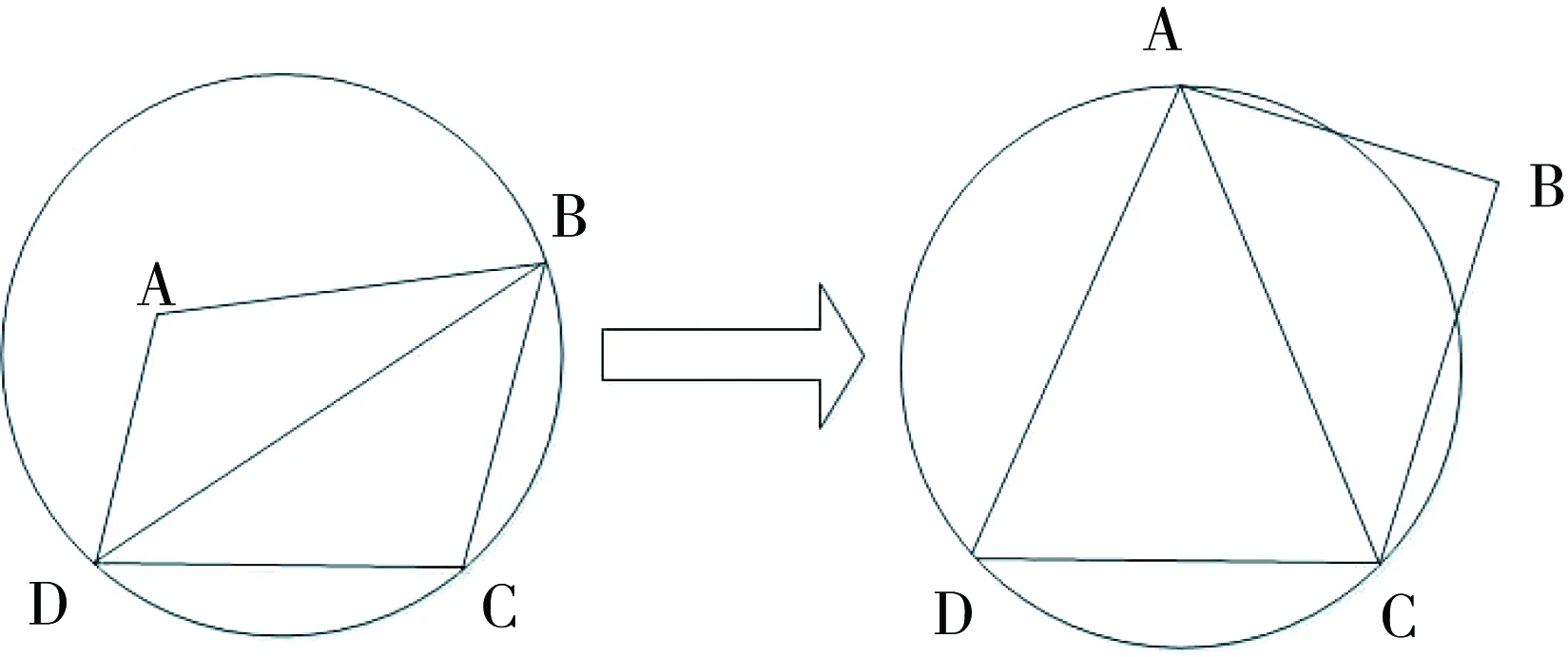

(3)若點(diǎn)集中的某點(diǎn)在任一三角形的外接圓內(nèi),對(duì)角線進(jìn)行對(duì)調(diào),完成局部優(yōu)化處理。如圖1所示。

圖中點(diǎn)A,B,C和D表示點(diǎn)集中的四個(gè)點(diǎn),三角形ABD與三角形BCD是相鄰的兩個(gè)三角形,兩個(gè)三角形形成一個(gè)四邊形ABCD,點(diǎn)A在三角形BCD的外接圓內(nèi),使用對(duì)角線對(duì)調(diào)規(guī)則,將四邊形ABCD中的對(duì)角線BD換成對(duì)角線AC,使外接圓內(nèi)不包含點(diǎn)集中任意一點(diǎn)。

2.1.2 人體骨架關(guān)節(jié)點(diǎn)序列圖模型 把從視頻序列中得到的人體骨架關(guān)鍵點(diǎn)時(shí)空序列,當(dāng)做三維點(diǎn)陣實(shí)施Delaunay立體三角剖分,將每個(gè)三角面片的3個(gè)頂點(diǎn)作為鄰接點(diǎn)而構(gòu)成圖。因相鄰三角面片具有公共邊,因此依據(jù)每個(gè)三角面片構(gòu)建的子圖都具有公共頂點(diǎn),從而形成了一個(gè)穩(wěn)定的圖結(jié)構(gòu)。能夠更好的描述一個(gè)關(guān)鍵點(diǎn)序列的立體空間結(jié)構(gòu)信息,提高了行為識(shí)別模型的辨識(shí)度。

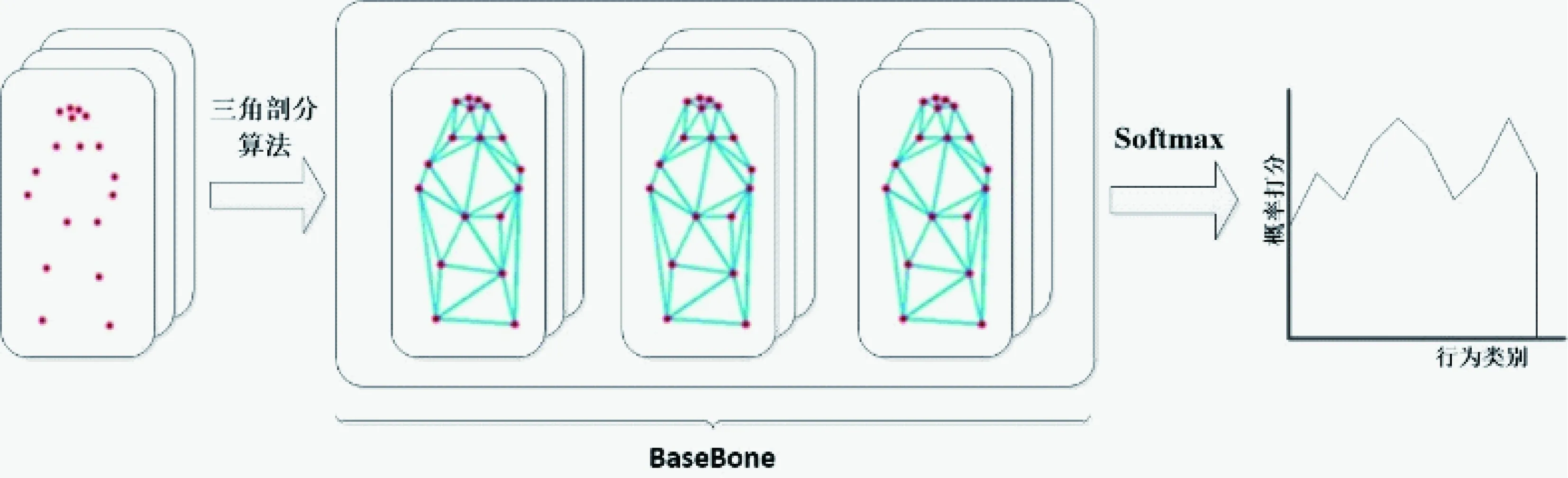

構(gòu)建的結(jié)果圖模型如圖2所示。

圖1 局部優(yōu)化處理過程Fig. 1 Locally optimized the process

圖2 空手道比賽視頻中生成的Delaunay三角剖分圖Fig. 2 Delaunay triangulation generated from karate competition video

2.2 行為識(shí)別算法

圖3 時(shí)空圖結(jié)構(gòu)示意圖 Fig. 3 A structural sketch of the space-time diagram

基于圖卷積行為識(shí)別算法中的拓?fù)鋱D是一個(gè)時(shí)空圖。其中的空間圖是利用每一幀圖像中的關(guān)節(jié)節(jié)點(diǎn),通過Delaunay三角剖分三角面片的頂點(diǎn)連接得到的,即Es={vtivtj|(i,j)∈H},如圖3(a)所示。時(shí)間圖是通過把不同幀中同一個(gè)關(guān)節(jié)點(diǎn)連接生成的,即El={vtiv(t+1)i},如圖3(b)中黃色線條所表示的邊。

在深度網(wǎng)絡(luò)中,通過對(duì)該拓?fù)鋱D結(jié)構(gòu)進(jìn)行圖卷積得到行為的特征,并使用標(biāo)準(zhǔn)的SoftMax層對(duì)得到的高層特征進(jìn)行分類,如圖4所示。圖卷積的網(wǎng)絡(luò)結(jié)構(gòu)base bone主要有9個(gè)時(shí)空塊組成,如圖5所示。

圖5中9個(gè)塊的前3層輸出的通道數(shù)為64,接下來輸出的通道數(shù)為128,剩下的3層輸出的通道數(shù)為256。

對(duì)于每一層,又由對(duì)應(yīng)的空間圖卷積和時(shí)間卷積和其它一些操作組成,如RELU和歸一化操作,如圖6所示。

圖4 網(wǎng)絡(luò)模型結(jié)構(gòu)圖Fig. 4 Network model structure diagram

dout=64 dout=128 dout=256stride=1,1,1 stride=2,1,1 stride=2,1,1圖5 base bone的組成Fig. 5 The composition of base bone

圖6 每層中所包含操作Fig. 6 The operations contained in each layer

算法具體訓(xùn)練與測試的過程見表1。

表1 實(shí)驗(yàn)算法描述

3 空手道比賽視頻技戰(zhàn)術(shù)智能分析及實(shí)驗(yàn)

空手道比賽視頻技戰(zhàn)術(shù)分析通常需要得到技術(shù)動(dòng)作使用頻次、技術(shù)使用成功率、技術(shù)動(dòng)作習(xí)慣、戰(zhàn)術(shù)類型及使用、移動(dòng)軌跡等方面的信息。利用新設(shè)計(jì)的行為識(shí)別算法完成了運(yùn)動(dòng)員技術(shù)動(dòng)作使用頻次的統(tǒng)計(jì),以及移動(dòng)軌跡的記錄及分析。為此,測試了新的拓?fù)鋱D在圖卷積的行為識(shí)別算法中的性能。并在自制數(shù)據(jù)集的基礎(chǔ)上通過統(tǒng)計(jì)技術(shù)動(dòng)作頻次,驗(yàn)證了所設(shè)計(jì)算法的有效性。同時(shí),也實(shí)現(xiàn)了運(yùn)動(dòng)員移動(dòng)軌跡的智能分析。

3.1 空手道訓(xùn)練及比賽數(shù)據(jù)集

本研究跟蹤湖南省空手道隊(duì)并拍攝隊(duì)內(nèi)共10位運(yùn)動(dòng)員的訓(xùn)練及模擬比賽視頻,自制成為訓(xùn)練及測試數(shù)據(jù)集。本數(shù)據(jù)集中采集踢腿、移動(dòng)和揮拳這3類動(dòng)作視頻片段。將“踢腿”、“揮拳”和“移動(dòng)”分別標(biāo)識(shí)為kicking,Hook Punch和moving。視頻采集角度分8個(gè)方位。數(shù)據(jù)集中共有1 847個(gè)視頻片段,其中包含696個(gè)踢腿片段,625個(gè)揮拳片段,526個(gè)移動(dòng)片段,每個(gè)片段持續(xù)了大約10秒。

本數(shù)據(jù)集中,使用1 786個(gè)視頻片段作為訓(xùn)練集,其中包括679個(gè)踢腿片段,608個(gè)揮拳片段,499個(gè)移動(dòng)片段。使用另外61個(gè)視頻片段作為測試集,其中包括17個(gè)踢腿片段,17個(gè)揮拳片段,27個(gè)移動(dòng)片段。

圖7中例舉踢腿,揮拳和移動(dòng)視頻中對(duì)應(yīng)的視頻幀,圖8中例舉測試視頻中隨意3個(gè)角度的視頻幀。

圖7 數(shù)據(jù)集中3類行為對(duì)應(yīng)的某幀圖像Fig. 7 A frame of image corresponding to three types of behavior in the data set

圖8 測試視頻任意3幀的截圖Fig. 8 Test screenshots of any three frames of the video

3.2 拓?fù)鋱D性能對(duì)比分析

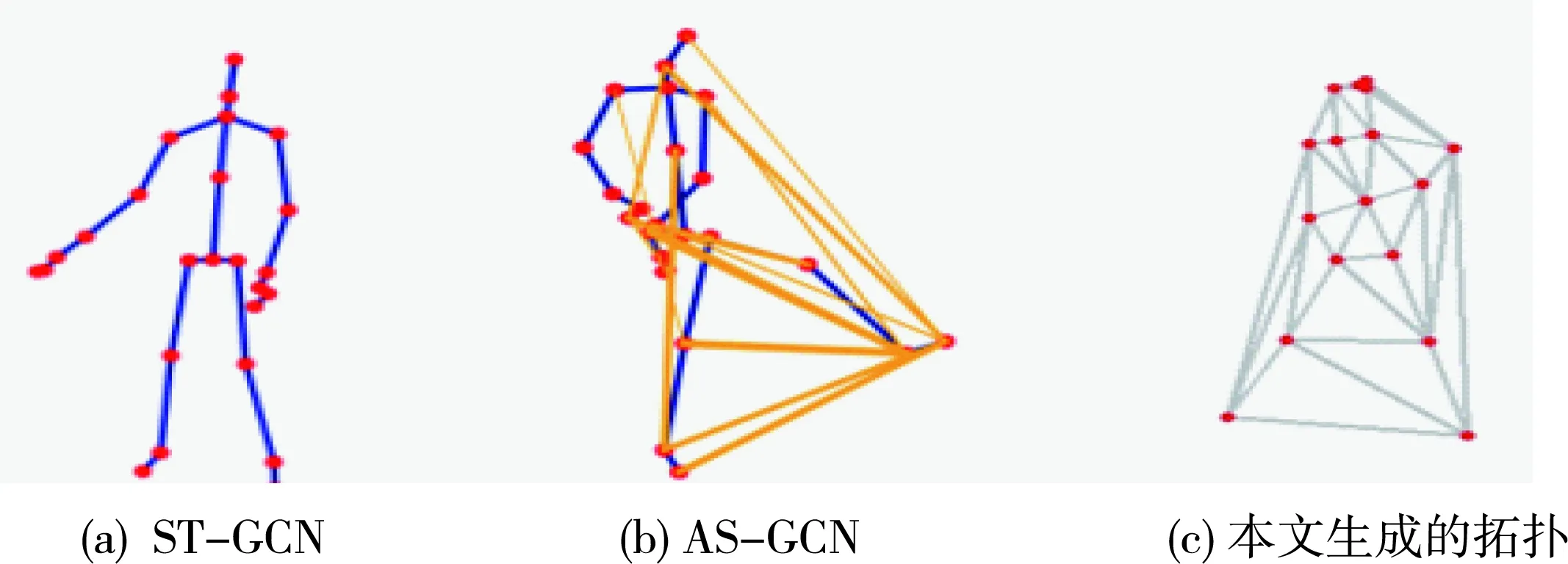

基于文獻(xiàn)[9]與[11]的基本框架進(jìn)行改進(jìn),采用基于Delaunay三角剖分的方式構(gòu)建拓?fù)鋱D。ST-GCN[9],如圖9(a)所示,只是簡單的關(guān)節(jié)點(diǎn)自身連接。AS-GCN[11],如圖9(b)所示,它能夠把特定行為中潛在相關(guān)的關(guān)節(jié)點(diǎn)關(guān)聯(lián)并進(jìn)行連接。本文提出了圖的構(gòu)建方法,如圖9(c)所示,針對(duì)不同的行為通過Delaunay三角剖分算法得到視頻幀的拓?fù)鋱D。

圖9 ST-GCN,AS-GCN和本文生成的拓?fù)鋱D Fig. 9 ST-GCN,AS-GCN and the topology generated in this paper

3.2.1 拓?fù)鋱D信息容量對(duì)比分析 基于骨架點(diǎn)提高視頻中人體行為分類準(zhǔn)確率,主要在于得到豐富及有用的特征信息。在網(wǎng)絡(luò)的學(xué)習(xí)過程中,通過特征多層卷積之后會(huì)使特征減少或表示行為的信息丟失。因此在研究的過程中,其目的是豐富更多有用的行為信息。

圖10所示,為ST-GCN中對(duì)于特征表示與本文中特征對(duì)比。

圖10 ST-GCN與本文拓?fù)鋱D的信息容量對(duì)比Fig. 10 Comparison of ST-GCN's information capacity with the topology diagram in this paper

白色的圓圈表示特征的關(guān)聯(lián)度。圓圈越大,表示某一關(guān)節(jié)點(diǎn)對(duì)于某一行為的特征表征關(guān)聯(lián)度越強(qiáng);圓圈越多,表示某個(gè)動(dòng)作中提取出來有關(guān)聯(lián)的特征點(diǎn)越多。從圖10(c)所示,構(gòu)建的拓?fù)鋱D,能夠獲得更多有關(guān)聯(lián)性的關(guān)節(jié)點(diǎn),從而獲得更豐富的行為特征。

如圖10(b)和(c)所示,在 “踢腿”行為過程中,ST-GCN中右手臂的特征已明顯減弱,而本文中的特征響應(yīng)度仍存在。在“踢腿”動(dòng)作,相對(duì)于ST-GCN,從對(duì)應(yīng)特征響應(yīng)度來講,關(guān)聯(lián)的關(guān)節(jié)點(diǎn)較多,對(duì)于行為提供更豐富的特征。

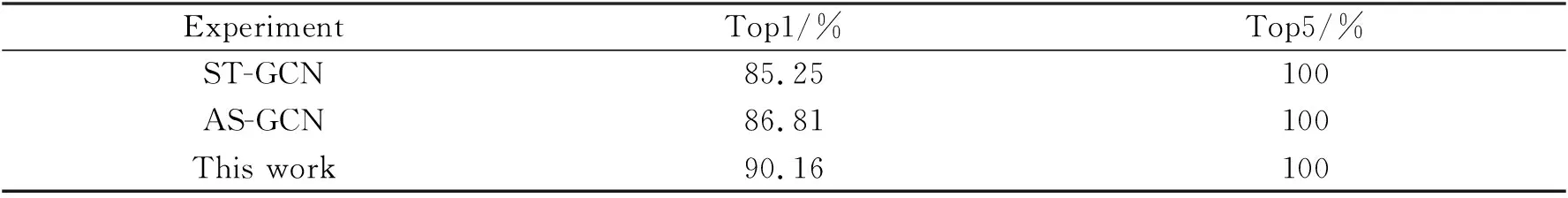

3.2.2 行為識(shí)別準(zhǔn)確率對(duì)比 通過1 786個(gè)視頻片段進(jìn)行訓(xùn)練,并在61個(gè)測試視頻片段上進(jìn)行測試,本文中提出方法得到較高的準(zhǔn)確率,如表2所示。

表2 實(shí)驗(yàn)對(duì)比

3.3 動(dòng)作頻次統(tǒng)計(jì)及實(shí)驗(yàn)分析

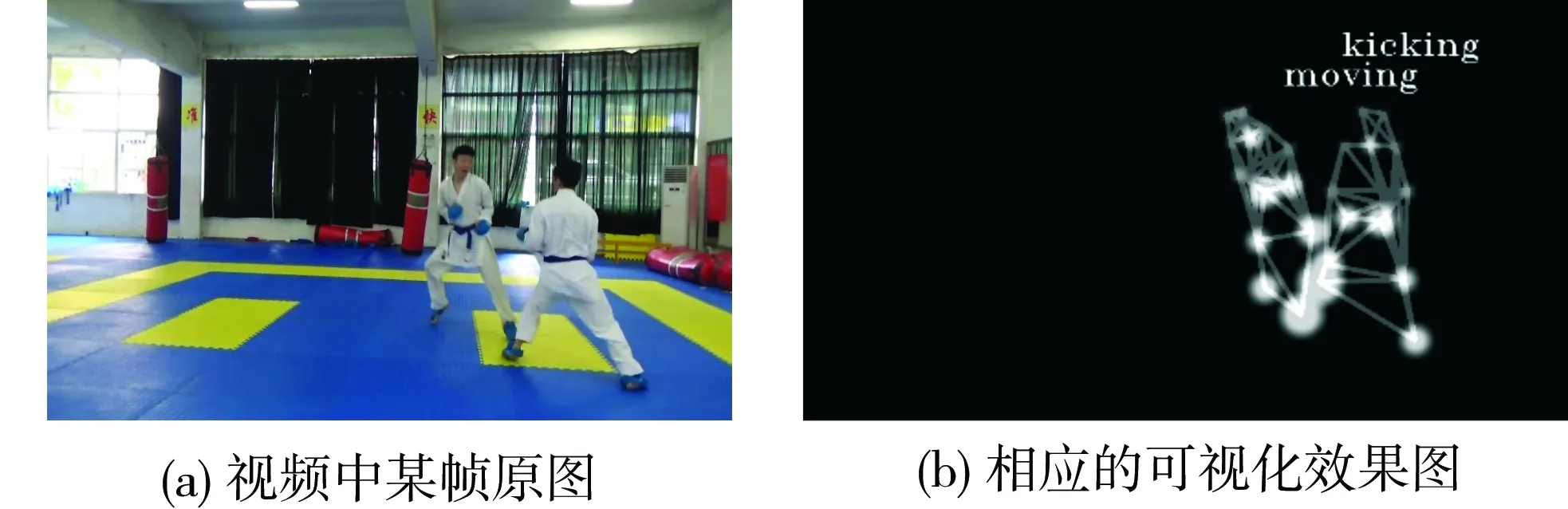

針對(duì)比賽視頻中特定運(yùn)動(dòng)員的技術(shù)動(dòng)作進(jìn)行識(shí)別,并分類統(tǒng)計(jì)出各自的使用頻次,從而分析出該運(yùn)動(dòng)員的戰(zhàn)術(shù)習(xí)慣和特點(diǎn)。根據(jù)訓(xùn)練模型得到的行為標(biāo)簽序列,對(duì)于有T幀的可視化視頻序列,在每幀t中,使t整除4對(duì)應(yīng)模型得到的標(biāo)簽序列并顯示相應(yīng)的類別。如圖11所示,是測試視頻的可視化效果圖。

圖12是依據(jù)3.1節(jié)的算法對(duì)視頻中運(yùn)動(dòng)員的踢腿和揮拳的動(dòng)作頻率進(jìn)行統(tǒng)計(jì)。當(dāng)運(yùn)動(dòng)員出現(xiàn)“踢腿”行為或者“揮拳”行為,逐漸累加,統(tǒng)計(jì)測試視頻中“踢腿”和“揮拳”行為的次數(shù),在對(duì)運(yùn)動(dòng)員“踢腿”和“揮拳”進(jìn)行統(tǒng)計(jì)后,得到運(yùn)動(dòng)員對(duì)應(yīng)的運(yùn)動(dòng)規(guī)律,能夠在訓(xùn)練過程中不斷的調(diào)整,給出相應(yīng)的訓(xùn)練規(guī)則。(a)和(b)分別是統(tǒng)計(jì)踢腿和揮拳的次數(shù)。

圖11 行為可視化效果圖Fig. 11 Behavior visualization renderings

圖12 統(tǒng)計(jì)技術(shù)動(dòng)作頻次Fig. 12 Statistics of technical action frequency

在測試集的視頻中,對(duì)17個(gè)踢腿視頻和17個(gè)揮拳視頻進(jìn)行統(tǒng)計(jì),正確率達(dá)到95%。我們的系統(tǒng)通過在海量視頻中統(tǒng)計(jì)特定運(yùn)動(dòng)員的各類技術(shù)動(dòng)作的使用頻次,分析出該運(yùn)動(dòng)員的技術(shù)動(dòng)作的優(yōu)缺點(diǎn)。

3.4 運(yùn)動(dòng)員移動(dòng)軌跡分析

為了方便觀察,根據(jù)相機(jī)三維坐標(biāo)和地面右下角三維坐標(biāo),把地面右下角坐標(biāo)轉(zhuǎn)換成坐標(biāo)原點(diǎn),得到新的三維空間坐標(biāo),其中需要提取關(guān)節(jié)點(diǎn)(黑色的關(guān)節(jié)點(diǎn))的三維信息坐標(biāo)如圖13。圖14是針對(duì)某一場空手道比賽繪制得到的軌跡圖(黑色為坐標(biāo)系)。

系統(tǒng)能把比賽中雙方運(yùn)動(dòng)員的運(yùn)動(dòng)軌跡進(jìn)行統(tǒng)計(jì),并通過紅點(diǎn)的綠點(diǎn)在戰(zhàn)術(shù)圖中進(jìn)行標(biāo)識(shí)區(qū)分并展示,如圖14所示。通過海量視頻中提取特定運(yùn)動(dòng)員的移動(dòng)軌跡,分析出該運(yùn)動(dòng)員在競賽中進(jìn)攻和防守的移動(dòng)習(xí)慣,真正達(dá)到技戰(zhàn)術(shù)分析的效果。

圖13 關(guān)節(jié)點(diǎn)軌跡跟蹤Fig. 13 Node trajectory tracking

圖14 視頻中的軌跡圖Fig. 14 Track from the video

4 總結(jié)

本文設(shè)計(jì)使用Delaunay三角剖分來構(gòu)建圖卷模型中的拓?fù)鋱D,并提出基于新的圖卷積模型的行為識(shí)別算法。同時(shí)利用該算法實(shí)現(xiàn)了空手道競賽視頻技戰(zhàn)術(shù)分析系統(tǒng)。通過大量的實(shí)驗(yàn)分析證明:

(1)新的構(gòu)建圖的方法信息容量更大,更有利于行為識(shí)別效果的精確度,

(2)新的行為識(shí)別算法提高了技戰(zhàn)術(shù)分析的智能化程度和精度。

但在軌跡分析環(huán)節(jié)中,缺少移動(dòng)序列信息,降低了軌跡分析的實(shí)用性,還需要在后續(xù)的研究中加以解決。