基于分數階微分和Frangi的夜間車道線檢測

陳衛衛, 王衛星, 閆 迪

(1.長安大學信息工程學院, 西安 710064; 2. 西安航空職業技術學院, 西安 710089)

1 引 言

隨著智能交通系統的不斷發展和應用,安全駕駛輔助系統(Safety Driving Assist,SDA)逐漸受到人們的關注,并在人們的生活中廣受歡迎.在正常駕駛過程中,一旦發生突發事故,智能輔助駕駛系統可以立即提供緊急制動,輔助駕駛決策或緊急警告等服務,以最大限度地提高駕駛員和自動化駕駛的穩定性和安全性.盡量減少交通事故造成的經濟損失和人員傷亡.智能輔助駕駛系統中有一個子功能系統引起了越來越多的關注,即車道偏離預警系統(Lane Departure Warning System,LDWS),也就是車道線的檢測和跟蹤[1].

當前,車道線跟蹤,車道線識別或車道線偏離警告已成為基于機器視覺和圖像處理的駕駛員輔助系統的最早組成部分.自20世紀90年代以來,已經針對良好的天氣條件和道路上清晰的車道標志所定義的情況進行了研究和實施.此后,針對特定情況的檢測準確性,針對各種情況的檢測魯棒性,檢測時間效率以及與高階任務的集成,可視車道檢測和跟蹤定義為持續的研究主題.

LDWS基本上可分為兩類:基于道路基礎設施和基于車輛的系統[2].前者與道路結構建設有關,但大部分道路沒有路面下布控傳感器的結構,因此,后者被廣泛研究和應用.基于車輛的LDWS可分為側視系統和前視系統[3].與側視系統相比,前視系統有大量的道路信息可供使用,即使在沒有明確車道標志的道路上也能正常使用.前視系統的關鍵是否能準確地檢測車道線,因此,大量的車道線檢測算法和方法被研究者所研究.

目前,這種基于機器視覺和圖像處理的車道線檢測算法可分為兩類:第一類算法基于傳統圖像處理,類似于其他線性目標檢測[4-6];第二類算法基于語義分割[7], 也就是深度學習和神經網路等.基于傳統圖像處理的算法主要是利用圖像中車道線的形狀特征、像素梯度和顏色特征來檢測車道線[8].這類算法可分為基于相似性的算法和基于不連續性的算法.

在相似性算法中,閾值算法[9]或其他區域相似性算法[10-11]可能適合某些特殊情況.例如,顏色可以作為車道線提取的線索[12];隨機有限集可以用于車道線檢測[13];距離變換用于尋找車道線[14];模糊數學應用于模糊圖像分割[15]等.Ajaykumar等人提出了一種基于K均值聚類的自動車道線檢測方法,其效果取決于道路和天氣情況,不適合于復雜的環境和條件,即使情況不太復雜,該算法也要與其他算法相結合[16].對于更深入的基于相似性的算法研究,文獻較多,如:Ma等人研究了一種基于優化稠密視差圖估計的多車道檢測算法[17]等.

基于不連續性的算法更多,一般是在圖像增強后,使用不同的邊緣檢測器,如Canny算子、分數階微分算子、Gabor算子、Sobel算子和Laplacian算子等.這種算法計算速度快,場景適應性強,但容易受到光照和障礙物的干擾,導致檢測結果偏差較大.在邊緣檢測之后,為了使車道線邊緣更清晰,增加了一些圖像增強算法,如Yoo等人對不均勻光照圖像進行梯度增強,使車道線檢測更加穩健[18].圖像二值化后,由于車道線是不連續的,除常用的Hough直線算法外,研究者還根據車道線的特征研究了各種直線和曲線的擬合算法.例如,Ozgunalp等人研究了一種基于消失點估計的車道線跟蹤算法[19],Niu等人利用曲線擬合進行了兩階段特征提取算法[20].

近幾年來,語義分割在車道線檢測中是一個研究熱點.語義分割網絡是一種基于神經網絡和深卷積網絡的模型,其最基本的任務是對圖像中不同種類的像素點進行分類,并將同一類像素點聚合起來,以區分圖像中不同的目標對象[21-22].在后來出現的U-net模型結構中引入了擴張卷積運算,可以在不降低維數的前提下,進一步增大局部感受野,收集多尺度信息.在Deeplabv1網絡中,進一步增加了展開卷積的比例,并在相鄰像素關系推理中加入了條件隨機場(Conditional Random Field,CRF)模型.之后,Deeplab系列網絡不斷發展,有許多改進版本,骨干網也得到了應用,如Deeplab V3+network[23].

雖然車道線提取的研究取得了良好的進展,但仍有一些困難需要克服.主要問題之一是低質量光照的影響,如夜間道路上的光照等.據統計分析,白天的交通事故一般少于夜間,白天的交通事故是指由于交通流量大而產生的車輛擦傷的事故[24].而夜間發生交通事故不限于此,其發生的概率是白天的1.5倍,一項數據表明有60%的重大交通事故是發生在夜間的[25].在夜間行車時,經常打開大燈,這會使駕駛員在兩車相遇時完全處于盲區,看不到前方的路況,嚴重影響行車安全,因此車輛保持在兩車道線內對減少此類交通事故非常重要.目前,研究能夠適應不同光照條件、克服光照變化影響的各種魯棒性車道偏離檢測算法,是所有基于視覺的LDWS的發展趨勢.

本文主要研究夜間視頻圖像中的車道線檢測算法.首先提取圖像中有效的車道線檢測區域,然后將交通視頻中多幅圖像合并,利用Frangi及Hessian算法對融合后的圖像進行平滑增強,基于新的分數階微分模板檢測車道線上的特征點,最后應用遞歸Hough直線變換得到車道線.為了證實新算法的有效性,將該算法與幾種傳統圖像算法和深度學習方法進行了比較.

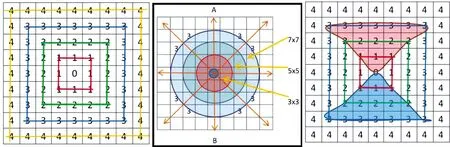

2 車道有效區域檢測及圖像合并

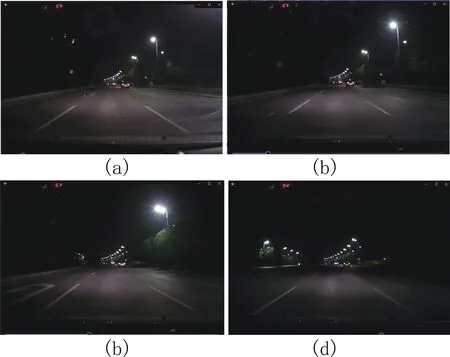

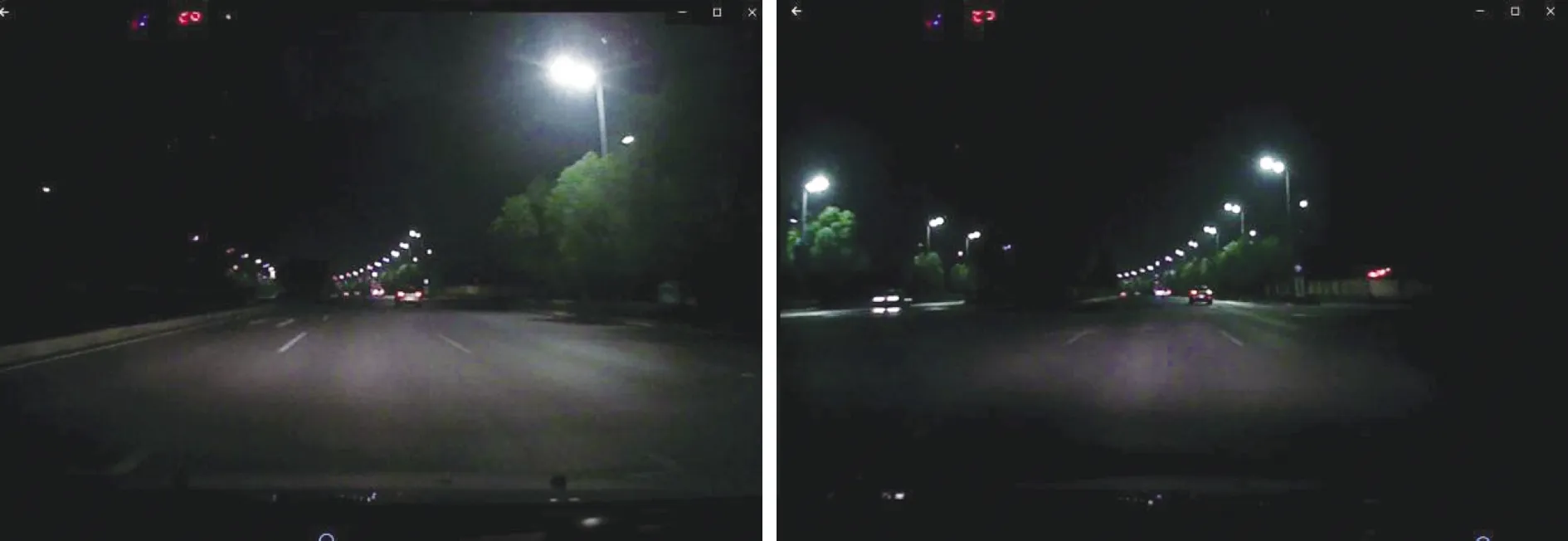

在白天,當攝像機固定在車輛前部時,車道線圖像可以分為三個固定的區域:天空區域,有效檢測區域和下部無效區域.但在夜間,在路燈及其附近范圍內,感興趣區域的對比度將比白天低得多,視覺信息混亂,而兩側的信息尤其遠離燈光的區域會變弱(如圖1).黑夜道路圖像的特征為:(1)與白天不同,黑夜圖像中車道線有著較弱的標識信息.受燈光的影響,白色的車道線往往是灰暗色,與路面的其它部分相比,車道線的色彩和反光度都比白天要弱得多,也就是說車道線的像素值與其兩側路面像素值的差異比較小;(2) 由于受樹木和建筑物等陰影、車道本身磨損、剎車痕跡線、強光、雨雪和霧霾等影響,圖像中的噪聲和干擾非常大;(3) 在圖像的下方區域(距離車輛較近的區域),有時也稱作近視場區域,和白天相比,這個區域的路面信息比較模糊,會降低檢測車道線的準確度;圖像天空區域(距離車輛較遠的區域),有時也叫遠視場區域,由于較強路燈反射的原因,這部分反應路面信息比較混亂;(4) 當前后或對面有車輛時,由于車燈的直射或反射等會致使車道線檢測區域圖像信息更加復雜.

所以在夜晚,有效檢測區域的對比度會很低,在車燈范圍內及離路燈近一些的地方,可視信息會豐富一些,而道路兩側的信息,尤其是離路燈較遠處,信息會弱一些,具體如圖1所示.

在圖1(a)中,由于車距離右側的路燈較遠,而且左側又無路燈,所以左側的車道線較暗,無效區域中只有部分車頭信息.但由于車燈的光線強,可視距離較長,所以有效檢測區域對比度較好;在圖1(b)中,左側也是沒有路燈,右側的路燈稍微近一些,所以靠近右側路燈的區域信息豐富一些,但車燈光強不大,所以興趣區域信息也不豐富;在圖1(c)中,車離右側的路燈更近了一些,興趣區域的細節更清晰了一些,但由于車燈較暗,可視距離也就短了些;在圖1(d)中,雖然路的兩側都有路燈,但車離路燈太遠,整個圖像都比較暗,車道線很不清楚,可視距離更短.所以,夜晚的路面圖像的三區域不是固定的而是變動的,為此利用一種方法自動將每幅圖像分成有效檢測區和非檢測區.

圖1 有明顯車道線的黑夜交通圖像Fig.1 Traffic images at nighttime with obvious lane lines

為了清除或減少燈光及路邊目標的相互作用而產生的噪聲,先用基于區域合并的思想[26]將圖像分成幾個大小不同的區域.區域分裂合并算法的基本思想是先確定一個分裂合并的準則,即區域特征一致性的測度,當圖像中某個區域的特征不一致時就將該區域分裂成4個相等的子區域,當相鄰的子區域滿足一致性特征時則將它們合成一個大區域,直至所有區域不再滿足分裂合并的條件為止.為了消除或減少由燈光和路邊目標之間的相互作用引起的噪聲,基于區域合并,將圖像劃分為幾個不同的區域,如圖2所示.

(a)原始圖像 (b)區域合并 (c)檢測區域(中部)

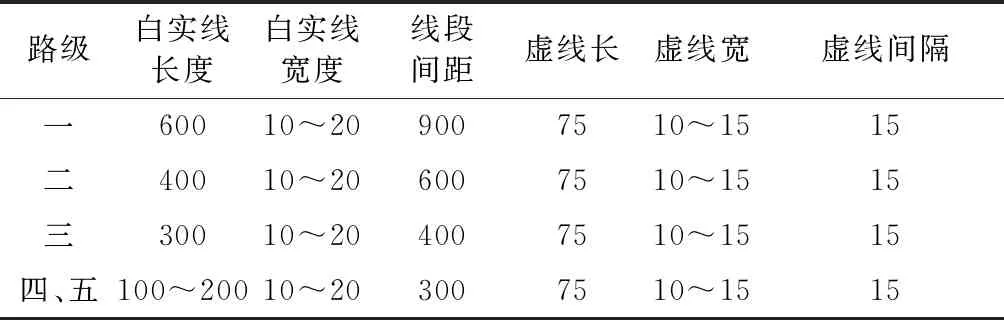

不同的高速公路等級有不同的車道線長和寬及車道線段間距的標準.即使車道線沒有被磨損,視頻很難保證每幅圖像都有車道線,圖像中含有車道線的概率和車行速度有關.當攝像機是PAL(Phase Alternating Line)制式時,每秒鐘可以采集25幅圖像,而當攝像機的制式是NTSC(National Television Systems Committee)制式時,每秒鐘可以采集30幅圖像.根據表2可知,在車道線沒有被磨損的情況下,當車速為 60 km/h 時,在一級公路上,可能半秒鐘內獲取的12幅圖像都沒有車道線;而在二級公路上,可能連續10幅圖像里都沒有車道線.但若車道線已經被磨損或其它噪聲的影響,在幾十幅連續獲取的圖像里,看不到車道線是可能的.或者某些圖像里只有車道線的一小部分:長度可能是正常長度的10%左右,甚至車道線寬度也只有原寬度的1/3左右,無論用何種圖像檢測算法,僅僅利用這些微弱的信息很難檢測出車道線.在這種情況下,最好的辦法是結合多幅圖像的車道線信息來檢測當前圖像中的車道線.

表1 車道線的基本尺寸(cm)

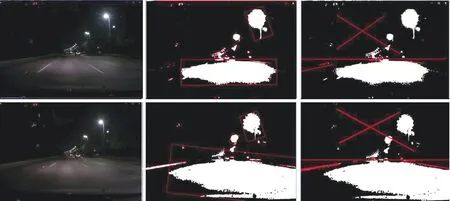

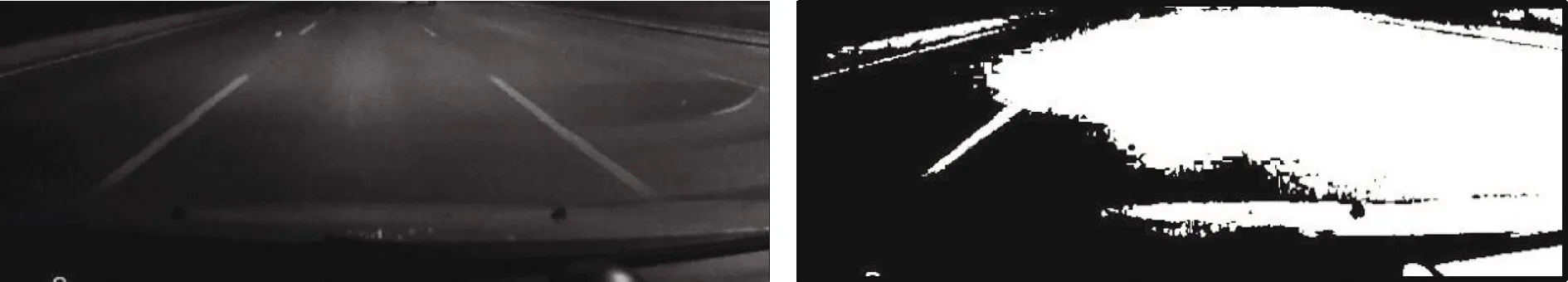

以二級公路上車速為80 km/h 為例,白實線長度4 m加上間隔距離6 m,總計10 m,利用PAL制式攝像機連續獲取11幅連續的圖像才能覆蓋整個10 m長的道路,所以可以每隔3幅圖像選1幅圖像融合到當前圖像中,然后再進行檢測,這期間車行距離約10 m,也就是小轎車長度的2倍多,24 m大掛車長度的1/3強,這期間的車行偏離車道線不會太大,很難跑出車道線.圖3中有4幅黑夜模糊不清的圖像,車道線在每幅圖像中的長度很短,或是一側或是兩側沒有車道線,這對于車道線的檢測很困難,甚至不可能.圖4中的4幅圖像對應圖3中的4幅圖像,圖4中每一對圖像的間隔在十幅圖像之內,所以當把每一對圖像合并后,就可以得到圖4的結果,圖4中的每幅圖像中的車道線長于圖3中的車道線,所以合并的結果明顯更好.

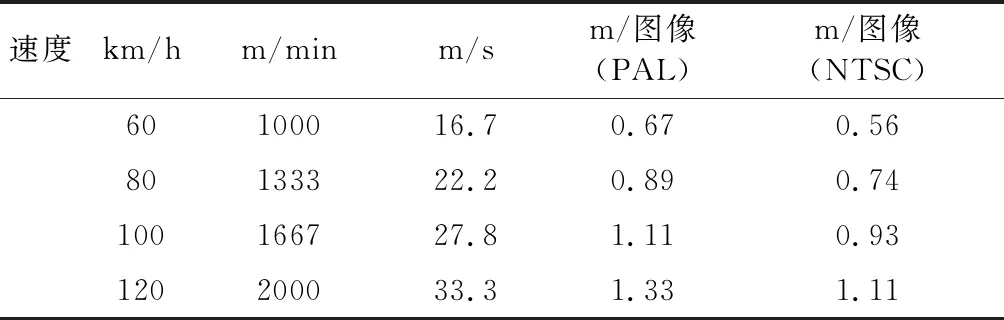

表2 車速與單位時間及單幅圖像經過距離的關系

(a) 模糊短車道線 (b) 模糊短左車道線

(c)左一條模糊短車道線 (d) 無車道線信息

(a) (b)

(c) (d)

3 基于Frangi和Hessian的圖像處理

因為夜間圖像的對比度很差并且噪聲很多,在提取車道線之前,應進行圖像預處理.該算法應包括3個基本點:圖像平滑去噪[27-28],對比度拉伸和車道線增強.為此,將采用以下基于Frangi和Hessian矩陣的算法,具體過程如下[29].

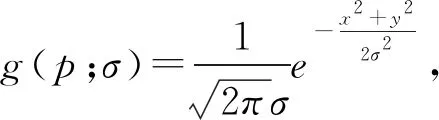

(1)

相應的車道線定義如下.

Td(p,θ;σ)=td(p,θ;σ)*I(p)

(2)

其中,td(p,θ;σ)=gxxcos2θ+gyysin2θ+gxysin2θ.

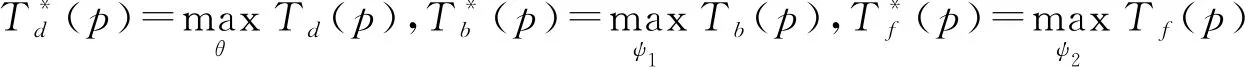

算法包括一套方向濾波器:包括前向過濾器tf(p;σ,ψ1)和后向過濾器tb(p;σ,ψ2), 其定義如下.

tf(p;σ,ψ1)=td(x+dcos(θ+ψ1),y+dsin(θ+ψ1))

(3)

tb(p;σ,ψ2)=td(x-dcos(θ+ψ2),y-dsin(θ+ψ2))

(4)

這里采用角度ψ1,ψ2檢測相鄰像素的裂縫跡象.d是偏移量參數,需要將其設置為適當的值.當d值較低時,它的貢獻較少.否則,d會引起錯誤的圖像分割以至將非車道線的像素誤判為車道線像素.

(a)原始圖像

(b) 對數變換

(c) Frangi 增強

(d) 噪聲去除

圖像通過定向濾波器的響應分別為Tf(p;σ,ψ1)=tf(p;σ,ψ1)*I(p)和Tb(p;σ,ψ2)=tb(p;σ,ψ2)*I(p). 增強車道線的整體響應如式(5)所示.

(5)

4 車道線的特征點檢測及Hough 變換

在圖5中,給出了兩個典型的車道線圖像,它們的預處理結果(如直方圖變換,Frangi增強和噪聲消除)令人滿意.

先將圖像反值,讓車道線灰度為暗色,然后基于分數階微分進行車道線上的特征檢測,具體檢測思想如下.

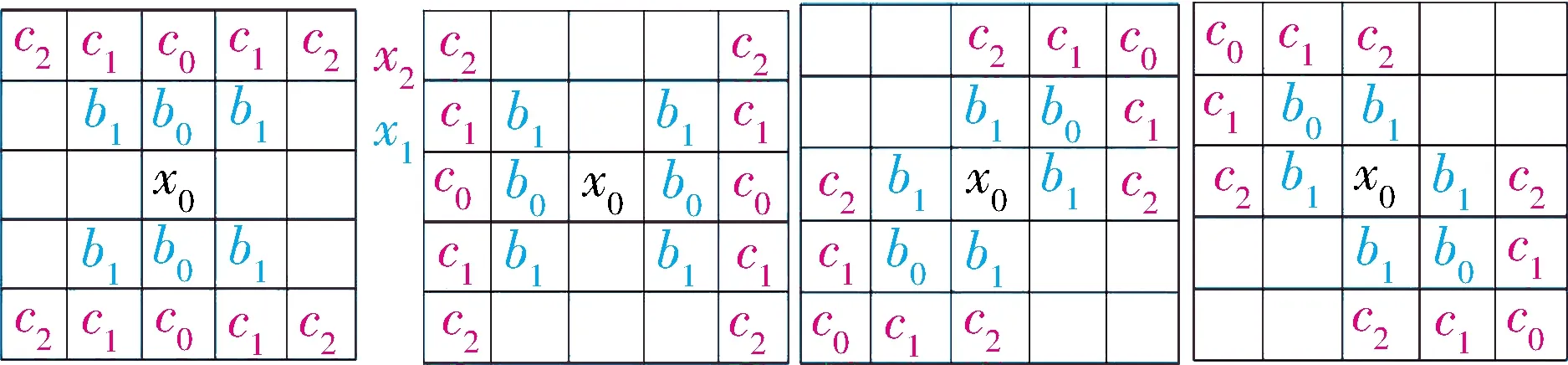

在圖6(a)中,它是9×9模板,其中,中心像素周圍有4個不同大小的正方形區域,該模板應足夠大以檢測中心像素是否為谷點候選點.對于谷點檢測,81像素的計算量可能太大,即使用了大量的信息,也不能準確地進行谷點檢測.相反,基于此,還測試了一個7×7模板,49個像素的檢查測還是有較大的計算量.為減少不必要的計算量,可以使用圓形區域進行檢測,如圖6(b)所示,該區域更適合于實際情況,并且可以使用比正方形區域更少的像素,其中有三個圓形區域(3×3,5×5和7×7)圍繞中心像素,由于谷點有其方向,因此檢測應分別在不同的方向,因此在圖6(b)中標記了4個方向.作為圖6(c)中的一個例子,標記兩個梯形區域,可用于垂直方向的谷點檢測(AB線in(b)),因為在頂部梯形區域和底部區域標記了“1”“2”和“3”的三條線,如果檢測像素“0”是最低點,則其灰度值應低于“1”行的灰度值,“1”行的灰度值應低于“2”行的灰度值,“2”行的灰度值應低于“3”行的灰度值.問題是如何計算每一行的灰度加權平均值,下面給出了一個5×5模板的例子.

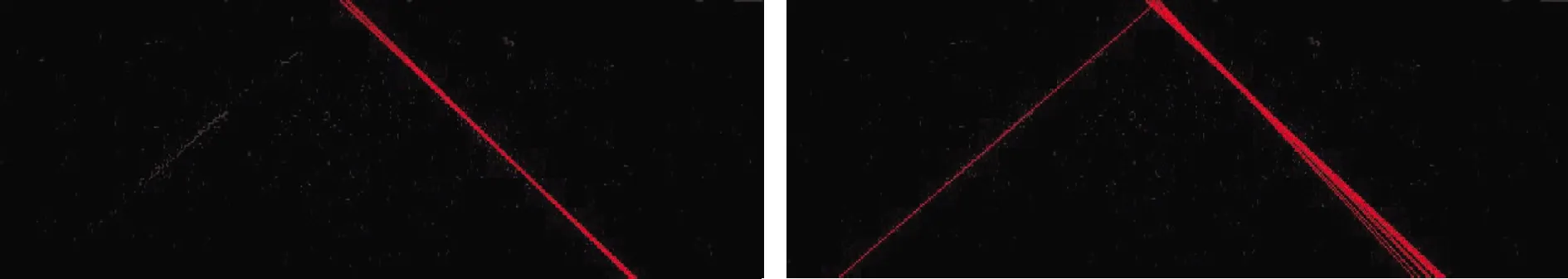

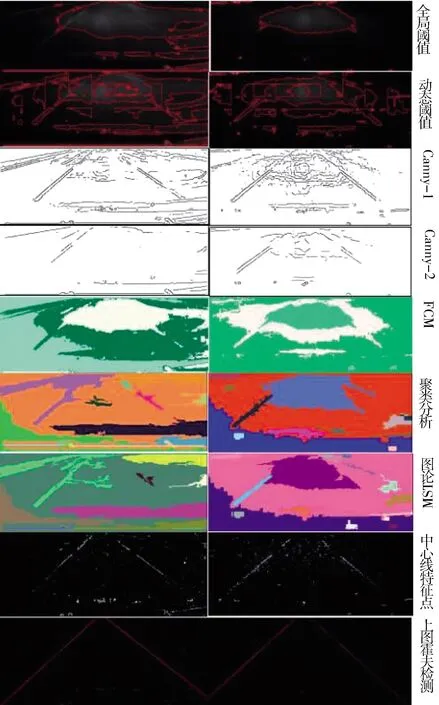

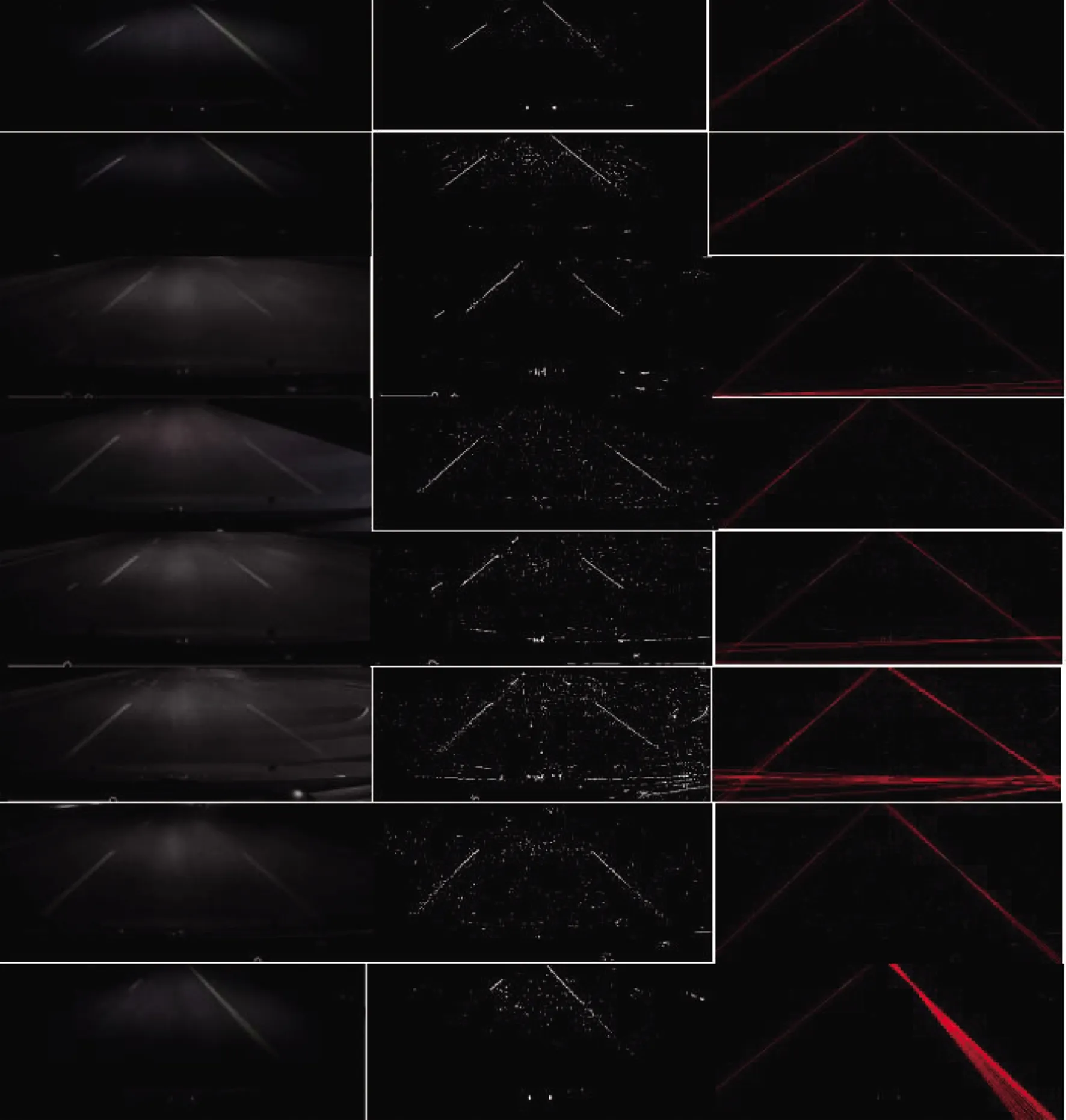

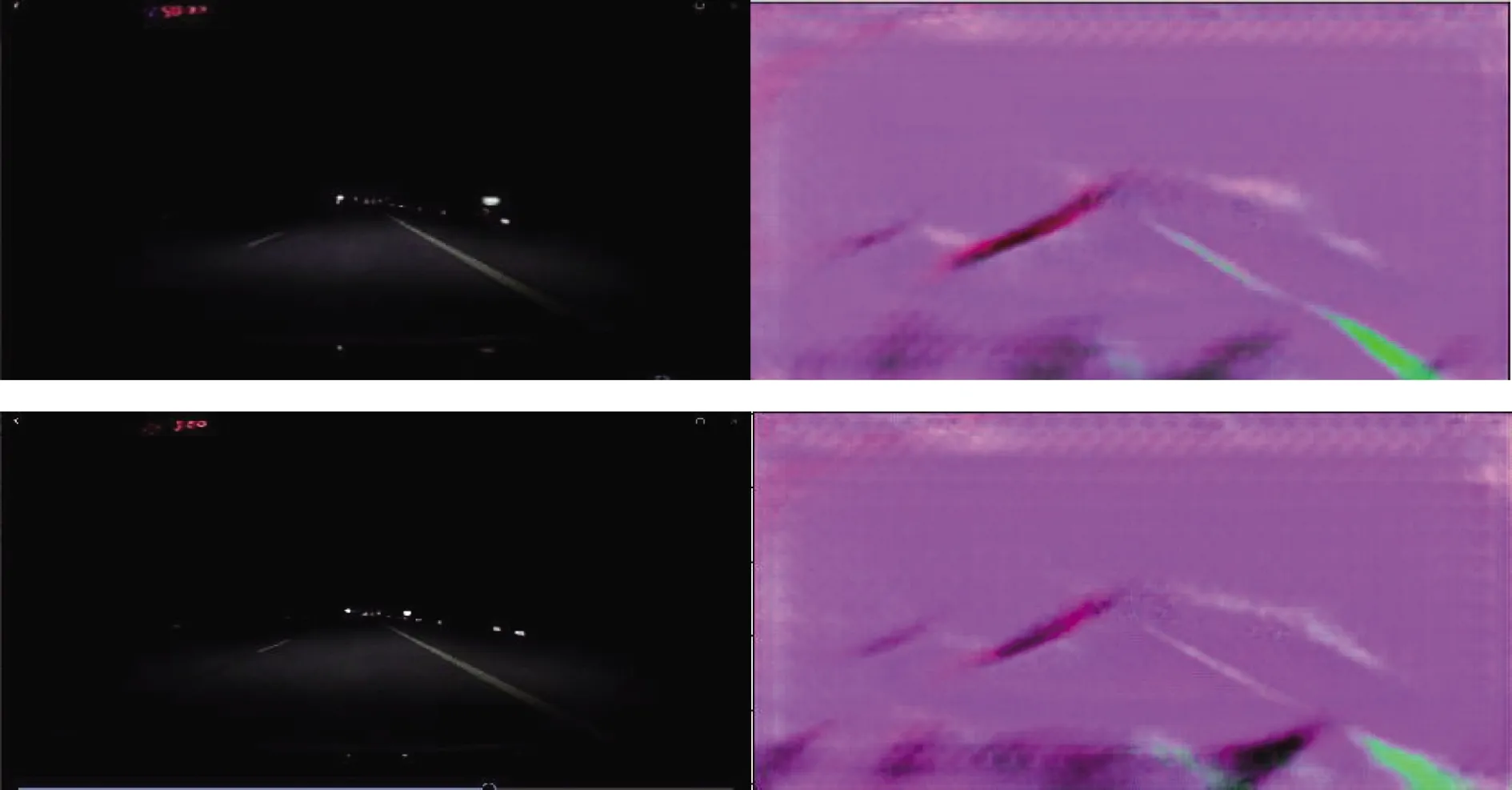

假設在圖6(c)的垂直方向上有一個車道線中心點p,有三條檢測線,它們是對應于圖7(c)的線“1”“2”和“3”的ab、cd和ef,如圖7所示.在圖7中,有正交線ap、cp和ep,它們滿足圖7中ap (a) 4個方形區域(b) 4個圓形區域 (c) AB線檢測區域圖6 特征點檢測區域和方向[30-31]Fig.6 Characteristic point detection areas and directions [30-31] 圖7 車道線邊緣檢測算法示意圖Fig.7 Schematic diagram of lane line detection algorithm (6) 如果s(t)持續時間為t∈[a,t],則信號持續時間[a,t]可在單位等間隔內等分h=1. (7) 這樣,一維信號s(t)中微分表達式的v階分數階可被推導為 a1s(t-1)+a2s(t-2)+a2s(t-3)+…, ans(t-n) (8) 這些n+1非零系數值的順序如下. (9) 取絕對值:a0=1,a1=|-v|,a2=|(v2-v)/2|,當v=0.5,有a1=0.5,a2=0.125,去掉小數點后,對于第“1”行,可將所有數字放大2倍,然后,有b0=2a0=2,b1=2v=1;對于第“2”行,將所有數字放大8倍,然后,有c0=8a0=8,c1=8v=4,c2=8u=1. (a) 0° (b) 90° (c) 45° (d) 135°圖8 4個方向的線條標記模板Fig.8 Templates for line marking in four directions 如圖8所示,有4個方向的模板.其中,可以定義檢測點或中心像素為x0,線“1”為x1,線“2”為x2,在垂直方向(圖8(b)),以頂部(圖6(c)或紅色梯形區域)為例進行谷點檢測.下面是輸入的灰度圖像f(i,j),g(i,j)是輸出的二值圖像. x0=f(i,j) (10) x1=[b0f(i-1,j)+b1(f(i-1,j-1)+f(i- 1,j+1))]/(b0+2b1) (11) x2=[c0f(i-1,j)+c1(f(i-2,j-1)+f(i- 2,j+1))+c2(f(i-2,j-2)+f(i-2,j+ 2))]/(c0+2c1+2c2) (12) y=(x2+x1)/2-x0 (13) 在垂直方向上,有兩個值(在頂部區域和底部區域),可稱它們為y+90和y-90,如果y+90>0和y-90>0,有y90=y+90+y-90.同樣地,可以計算其他3個方向y值.然后可計算如下式. z=max(y0,y45,y90,y135) (14) 如果輸出梯度圖像,會有 g(i,j)=z,否則g(i,j)=0 (15) 如果直接輸出二值圖像,當設置閾值T時,可有:如果z>T,則g(i,j)=255,否則g(i,j)=0.在正常情況下,原始圖像中含有大量的噪聲,這些噪聲會影響山谷邊緣的檢測結果.降低噪聲的一個簡單方法是使用平滑濾波器,例如高斯平滑函數,它具有寬度參數sigma,通常稱為尺度空間參數.sigma的選擇取決于白點尺寸分布. 在圖9(a)中,原始圖像中有二條模糊的車道線,Otsu閾值法分割結果表明,圖像光照不均勻,左下角的灰度值較深,中間部分的灰度值較淺,如圖9(b)所示.在圖9(c)中,圖像是由Canny邊緣檢測器得到的二值圖像,對于Canny,當給出了較低的閾值時,車道線大部分區域的雙邊緣都顯示出來了,但是,生成的圖像中存在太多的噪聲,在后處理過程中很難去除.在圖9(d)中,用圖論最小生成樹進行了圖像分割,在分割結果圖像中,兩條車道線的部分線段可以被檢測出來(左側的綠線段,右側的紫線段),但噪聲的線段更粗更大,可能還要做進一步的后處理.在圖9(e)中,新算法檢測出了大部分車道線上的特征點,用霍夫變換可以很容易地檢測出兩條車道線. (a) 原始圖像 (b) Otsu (c) Canny (d) MST (e) 車道線特征點 (f) 霍夫檢測結果 根據車道線的特性,假定兩條線:25°≤θ≤65°,115°≤θ≤155°,若沒有任何線在此范圍內,設T=T-5, 再進行霍夫變換,若只有一條以上的線都在上述的一個角度范圍內,則T=T-5,繼續進行霍夫變換,直到兩個角度范圍內都有直線為止.若在一個角度范圍內有多條直線,取Min(|θ|)的直線為最終的車道線.圖10(c)是當T=70時得到的霍夫直線變換檢測結果,而圖10(d)是當T=60時得到的最終霍夫變換檢測結果. (a) 原始圖像 (b) 車道線特征點 (c) 第一次霍夫變換 (d) 第三次霍夫變換 如上所述,夜間車道線檢測比白天困難,因此本文研究了一種新的車道線提取方法,該方法的工作流程如圖11所示.該方法主要包括兩部分(見虛框),上面的虛框部分是提取有效的檢測區域,這可以減輕后續的計算負擔,并消除可能嚴重影響檢測結果的噪聲;下面的虛框部分是圖像的增強及車道線的檢測,分為3個步驟:車道線增強,車道線上特征點檢測及直線霍夫直線變換. 以夜間從高速公路拍攝4處共120 min的錄像為例.通過測試數百幅車道線圖像,新算法檢測結果好于一些常規的方法.典型示例和算法比較結果如圖12所示,圖像尺寸為640×480像素,第一行是兩幅預處理后的黑夜車道線圖像,下面對每一幅圖像處理結果分析如下. 最基本的基于相似性的分割算法是全局閾值和動態閾值,這里用的全局閾值算法是Otsu, 而動態閾值算法是將圖像分成9×6個窗口分別進行Otsu 閾值分割.從圖12的第1行看出,全局算法只能把靠上中部較亮的區域劃分出來,有部分車道檢測線段包含在目標中,而另一部分卻包含在背景中,沒有一完整的單個車道線被檢測出來,甚至沒有車道線的某一完整線段被檢測出來,所以這種方法完全無效.在圖12的第2行中,每幅圖像被檢測出的目標很多(紅線輪廓),均有部分車道線段被檢測出來.但由于周圍粘連的目標較多,很難將這些車道線段分離出來,而且即使分離出來這些線段,也難形成完整的車道線或是大半車道線.因此,這種算法也不適合這種類型的圖像. 圖11 車道線檢測的工作流程Fig.11 Workflow of lane line detection 圖12中的第3行和第4行是不同高低閾值的 Canny邊界掃描結果.從圖12中可以看出,對于這類圖像,基于不連續性的圖像分割算法優越于基于相似性的算法.但和其它圖像的處理情況類似,當 Canny的高低閾值選取較低時,雖然能夠檢測出目標的邊界,但圖像中的噪聲邊界較多,也就是過分割或是過檢測,這對于后處理工作很難甚至不可能.而當高低閾值選取較高時,雖然噪聲邊界少了許多,但部分目標的的邊界被漏檢了,也就是欠分割或是漏檢測,不足以提供完整的信息對車道線的識別. 第5行是FCM[33]的檢測結果,其與第1行的全局閾值檢測有類似的效果,也就是檢測出靠上中部灰度值高的區域為一個目標,沒有把車道線(或部分線段)單獨地提取出來,該算法雖然對復雜的多目標圖像分割有成效,但對此類細長目標且圖像對比度較低的圖像,達不到所期望的效果.第6行是另一種聚類分析[31]的檢測結果,與上述的FCM不同,其能夠分割出更多一些目標物體,因而其可以提取出部分車道線(或部分線段),但車道線提取不夠完整,要么車道線融合在其它目標中,要么只是局部的點(小面積)和線(線段)被檢測到.所以,雖然其檢測結果好于上述的FCM算法,但針對這類特殊的圖像,還要有針對性的改進,才能獲取較好的效果. 在圖12的第7行中,處理結果是用圖論中的最小生成樹算法[29]完成的,該算法是近年在圖像分割中用得較多的一種圖論分割算法,對許多圖像均有較好的分割效果.但對黑夜車道線圖像還是有許多欠缺的地方.盡管比上述的聚類分析算法對圖像分割效果有所提高,但車道線的提取還是不夠完整,即使后處理用霍夫變換來檢測車道線,但由于噪聲的影響,也很難達到所要求的效果,所以還有許多要改進的空間. 第8行是基于車道線上特征點的檢測結果,這種算法是本文專門針對黑夜車道線圖像的特點研究的.其中心思想是盡可能多地檢測出車道線上的特征點.雖然找出的點不一定是連續的,但大都集中在車道線上或是其附近,相比Canny或其它1~2階微分算子,該算法不會產生太多的噪聲和假邊界,為后續的霍夫變換奠定了較好的基礎.跟隨其的第九行是對應的遞歸霍夫直線檢測結果.檢測結果能夠完全滿足車道線檢測和識別的要求. 所以,基于車道線上特征點的檢測及其遞歸的霍夫直線變換檢測了幾百幅夜視車道線圖像,8個檢測示例展示在圖13中.由于圖像的差異,在遞歸霍夫檢測中,有的圖像先檢測出一條車道線,當繼續霍夫變換一次以上,就會檢測出兩條車道線(最終取最內側的線為車道線).從圖13中看出,有的車道線上會產生多條線,或是一次檢測的結果或是n次檢測的結果.另外,圖像的底部或上部可能由于噪聲的影響,會檢測出接近水平的紅線,但根據線段的角度可以判斷那不是車道線. 圖12 基于圖9(a)檢測的幾種車道線檢測算法比較Fig.12 Comparison of several lane line detection algorithms based onFig.9 (a) 圖13 車道線及其遞歸的霍夫檢測結果Fig.13 Lanes and their recursive Hough transform results Li[23]研究了一種新的語義方法(深度學習方法),稱為Deeplab V3+網絡,在其論文中并與其他類似的三種語義方法進行了比較,如表3所示.圖像數據來自Tusimple(https://github.com/TuSimple/TuSimple-benchmark/issues/3),其中,訓練集包含3 626幅圖像,測試集包含2 782幅圖像. 由表3可以看出,幾種語義分割方法的結果受夜間環境照明效果的影響較大,導致檢測精度的下降,分析結果表明,由于城市夜間環境中霓虹燈、路燈等各種光源的綜合影響,對表中所有的語義方法都造成了一定的影響,對車道線區域判斷錯誤,導致整體檢測成功率較低. 為了對本研究中的新算法進行驗證,我們將新算法與李的方法Deep+V3網絡進行了比較.選擇了兩個典型的夜間車道線圖像,如圖14和圖15所示. 表3 不同語義分割算法試驗結果對比[23] 原始圖像Deep+V3 network圖14 Deep+V3法夜間車道線檢測[23]Fig.14 Night lane line detection by Deep+V3 method 車道線特征點最終結果圖15 利用新算法提取圖14圖像中的車道線Fig.15 Extraction night lane line in images in Fig.14 by new algorithm 在圖15中,原始圖像來自圖14,給出了兩步圖像處理過程:車道線特征點和最終結果,結果比較令人滿意.與圖14中的結果相比,新算法明顯優于Deep+V3網絡法.Li 的方法[23]雖然對其采用的數據庫中的圖像檢測效果很理想,但對于這種黑夜車道線圖像的處理結果就不是很有效, 對圖14中的兩幅圖像,雖然其方法能夠檢測出部分車道線,但都不完整,并且伴有一些噪聲線段. 本文研究內容主要包括5個方面:(1) 根據車道線的長度,寬度,間隔距離,可能的車速,道路等級和視頻采頻率,將多幅視頻圖像融合作為一幅檢測圖像,基本上可以保證車道線出現在每幅檢測圖像中;(2) 研究了確定有效檢測區域的動態算法,這是一種改進的區域合并算法;(3) 基于Frangi和Hessian矩陣設計了圖像平滑和車道線增強算法;(4) 設計了一種新的分數階微分模板來檢測車道線上的特征點;(5) 在極坐標中進行遞歸霍夫直線變換,初始檢測角度為1,距離步長為1,檢測線的數目初始數為70. 在這項研究的過程中,使用上述方法(包括其他幾中典型的算法)測試了高速公路上夜間車道線的數百幅視頻圖像,并使用了全局閾值,動態閾值,不同的Canny邊緣檢測器,聚類分析,模糊聚類分析(FCM),MST及深度學習等算法/方法進行了比較.實驗和比較結果表明,提出的新方法可用于夜間高速公路和城區道路上的車道線自動檢測,一些子算法可以用于深度學習方法的改進,并可取得了其他算法難以獲得的良好效果.進一步的研究將自動確定不同長度車輛和不同公路等級的視頻圖像融合準則及車道線的跟蹤.

5 實驗及分析

5.1 新算法與傳統圖像處理算法的比較

5.2 新算法與深度學習等方法的比較

6 結 論