基于結構化特征的遙感影像道路智能提取方法

王文慶,胡若同,賀浩,楊東方,* 馬曉華

1. 西安郵電大學 自動化學院,西安 710121 2. 火箭軍工程大學 導彈工程學院,西安 710025 3. 火箭軍裝備部駐南京地區第二軍事代表室 南京 210023

遙感圖像數據通常包含道路空間分布信息,建筑物和其他人工特征等信息,道路的提取在交通導航、城市規劃、農林及飛行器自動駕駛等諸多領域發揮重要作用。人類觀測手段的更新和交通建設的日新月異對道路自動提取技術不斷提出更高的要求。在此情況下,如何利用海量的數據,快速且完備地提取道路信息以更新地理信息系統,成為該領域的研究熱點。

針對遙感圖像道路智能提取問題,在深度學習之前,相關研究絕大多數都采用“特征匹配+道路連接”的思路[1-7]。2010年,Mnih等[8]首次提出使用深度人工神經網絡從遙感影像中提取道路的方法,這也被認為是遙感圖像道路智能提取的開端。隨后,Wang等[9]訓練了一個深度卷積神經網絡,將道路類型分為直線,十字路口和街區,用于地表交通信息的智能提取。Saito[10],Zhong[11]等將FCN等深度網絡對道路和建筑物進行同時提取,進一步豐富了遙感圖像智能分割的功能。Wei等[12]基于FCN架構,設計了基于交叉熵損失函數的道路提取網絡優化指標。Panboonyuen[13]利用SegNet結構,并使用條件隨機場對提取結果進行后處理,提高了道路提取精度。Cheng[14],Zhang[15]等對道路提取網絡結構進行了改進,分別提出了級聯Encoder-Decoder網絡以及深度殘差網絡,得到了比典型分割網絡U-net更高的精度。除了對網絡模型的研究和應用外,還有一些針對網絡內部結構和針對目標特征的后處理方法的創新研究。Mosinska[16]提出了一種基于U-Net作為損失函數評估的VGG網絡的預訓練模型,并將提取結果的優化后處理集成到網絡的訓練過程中。Pan等[17]在同一層中考慮了線性目標的空間特征與空間卷積結構之間的相關性,從而提高了網絡表示微小線狀目標的能力。

事實上,道路通常是線狀的,有時具有網狀結構,細節信息豐富,但抽象語義信息則相對簡單,這些特征對網絡提取細節特征的能力提出了更高的要求。基于遙感圖像道路提取問題的實際特點,本文將淺層編解碼網絡和道路的結構化特征相結合,提出了一種新的遙感圖像道路智能提取方法,文中稱其為結構化特征輔助的道路智能提取方法。

1 結構化特征描述道路智能提取方法

首先設計了一種適合于道路高分辨率提取任務的淺層編解碼分割網絡(shallow encoder-decoder,SED),同時在損失函數中引入結構相似性(SSIM)損失,并提出道路結構描述算子對道路提取進行優化。通過對道路影像的多角度旋轉和鏡像映射來擴充訓練數據集,道路提取結果采用語義分割的評價方法,即準確率(accuracy)、召回率(recall)、F1-score。由于道路更加關注細節特征,而對感受野更大的高層抽象特征不敏感。因此,在課題組前期研究工作的基礎上[18],引入結構相似性損失和結構描述算子對道路提取結果進行優化。

1.1 SSIM損失函數

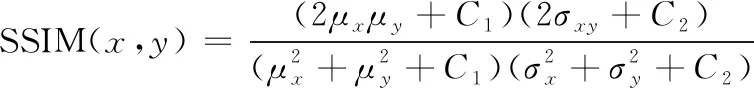

通常道路目標呈現出高度結構化,像素間表現出較強的依賴性,尤其是空間關系。但是,一般損失(例如交叉熵)為每個像素分配相等的權重,并在度量相似性時忽略兩圖空間信息。語義分割的交叉熵(BCE)損失函數如式(1),采用該損失函數作為基礎。

(1)

SSIM(x,y)=[l(x,y)α·c(x,y)β·

s(x,y)γ]

(2)

式中:權重α>0,β>0,γ>0;l、c、s分別為亮度比較函數、對比度函數、相似度函數[18]。將該參數設置為α=β=γ=1,C3=C2/2,因此相似性度量又可被定義為:

(3)

對于道路分割問題,最好在局部而不是在全局應用SSIM。這是因為圖像中的道路分布不均勻:某些區域包含很多局部細節,而其他則是空白。全局SSIM可能忽略有效的本地信息,并且可能降低相似性估計的效率。此外,道路提取的預測結果通常針對局部,因此應當首先使用局部結構統計數據來衡量相似性。

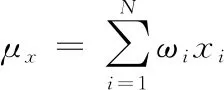

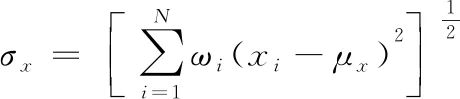

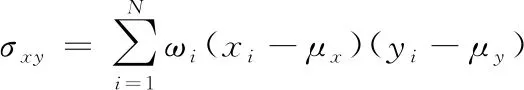

局部信息μx,σx和σxy可以通過滑動窗口進行計算,使用標準偏差為1.5的15×15單位圓對稱高斯加權矩陣ω,以使其表現出局部各向同性的特性。其中μx,σx和σxy定義為:

(4)

(5)

(6)

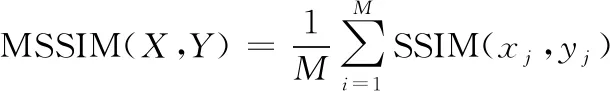

在訓練網絡時,有必要將度量標準壓縮為一個函數。因此,將平均SSIM(MSSIM)損耗用于評估整體圖像質量:

(7)

式中:X和Y為真實圖和預測圖;xj,yj為第j個窗口的內容;M為局部滑動窗口的總數量。要將SSIM損失與端到端的卷積網絡集成在一起,可以使用卷積層來計算所有局部統計信息:

μx=Conv(X,ω)

(8)

最終的SSIM損失為:

(9)

其中

(10)

σxy=Conv(X⊙Y,ω)-μx⊙μy

(11)

式中:Conv(X,ω)表示X與ω的卷積核;⊙表示兩個張量之間的Hadamard積。

顯然,SSIM損失函數中的所有數學運算都是可導的,所以可以直接應用于端到端卷積網絡,我們將SSIM損失與BCE損失相結合來訓練網絡,最終損失為:

Loss=LossBCE+LossSSIM

(12)

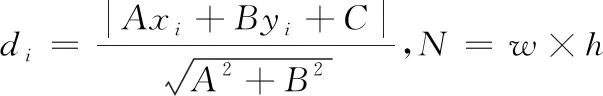

1.2 結構優化算子

道路提取過程中,由于存在陰影、遮擋等原因,使得像素特征和其他道路區域差異很大。此時網絡對于該區域的表達能力受到了限制,調整超參數以使網絡對這些點的預測也和真實道路去接近會增加網絡訓練的收斂難度。在進行道路提取預測時,利用更多的是道路網絡的結構特征,像素特征用于提取特別明確的道路區域,而被遮擋的區域可以通過結構描述算子,實現結構一致性,來彌補像素特征道路提取的缺陷。利用場景所描述的結構特征,能夠更好地提升道路提取精度。道路語義信息較為簡單,網絡在得到語義分割圖時沒有考慮到道路的方向這一結構信息,容易產生道路區域不連續、空洞和邊緣不平滑等問題。在道路二值分割圖的基礎上進行道路區域逐像素方向判斷,利用道路二值分割圖的方向信息對原圖進行修正以達到改善網絡輸出的目的。

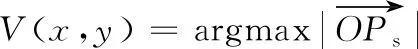

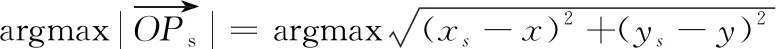

在圖像道路區域隨機生成初始點并生成所有的初始方向,以像素點為原點將2π分為2n份,則不同初始方向誤差為π/n。以像素點O(x,y)為原點在不同初始方向上分別進行延長操作,當延長到非道路目標區域時停止,此時停止點坐標為Ps(xs,ys)。記錄該方向的向量模長,則該像素點的主方向向量V(x,y)由該點出發的所有方向模長最大的方向確定:

(13)

(14)

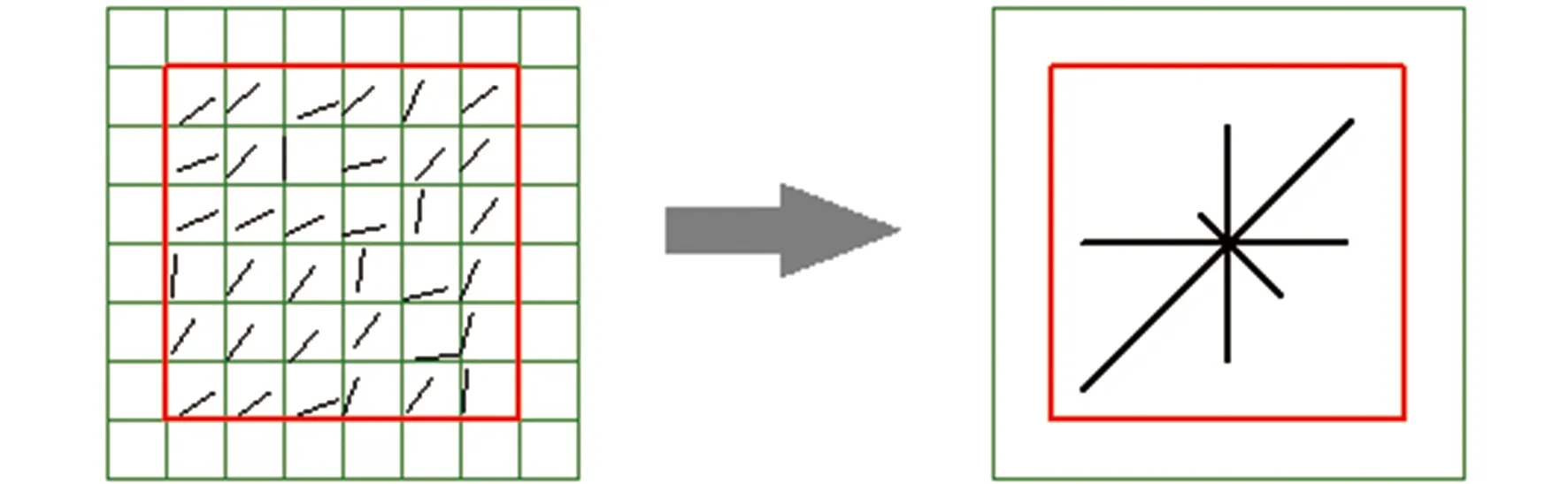

道路結構化描述算子如圖1所示。

圖1 結構算子示意Fig.1 Structural operator

在道路結構化描述算子的基礎上,本文采用滑動窗口的方法對道路區域進行道路提取結果的優化,其中滑動窗口所在區域的方向由所有像素最大模長的方向確定。滑動窗口操作過程如圖2所示。

圖2 滑動窗口道路提取結果的優化過程Fig.2 Sliding optimization of road extraction results

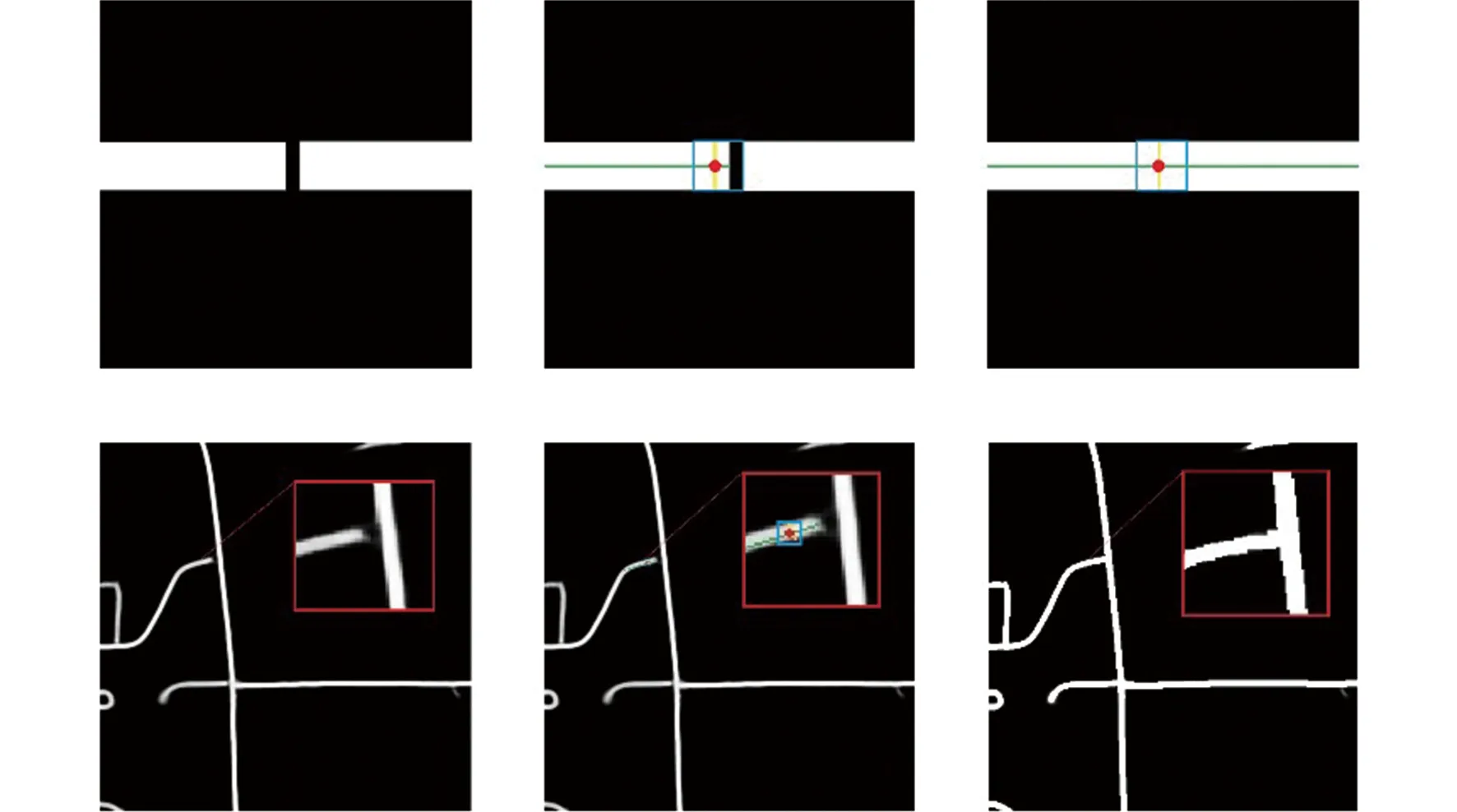

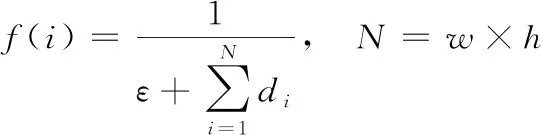

在一個窗口大小的范圍內進行道路區域修正,在語義分割二值化后的圖像上使用滑動窗口。該窗口以圖像像素點為中心,采用一個大小與道路目標路寬呈正相關的滑動窗口對斷連部分進行修正。道路目標路寬由道路主方向的法線方向到達非目標區域的方向向量模長確定,記錄落入該窗口的像素方向向量,分別計算該中心點到該窗口內所有像素方向向量的截斷距離。對每一個像素點與目標道路接近程度進行度量,f(i)描述第i個點(xi,yi)距離道路區域的接近程度:

(15)

(16)

其中

(17)

若f(i)達到某一閾值,則認為該點為道路目標,將該點Pixeli填充為白色,實現斷連道路目標的修正,生成一幅修正后的分割圖。

(18)

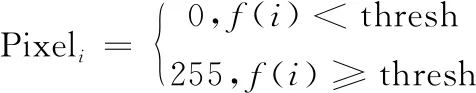

式中:Pixeli為第i個像素點的灰度值;thresh為道路目標相似性度量的閾值。結構描述算子優化結果對比如圖3所示,從左到右分別為真值圖,預測圖和優化圖,可以看到道路斷連問題得到了一定程度的解決與優化。

圖3 結構化特征優化對比示意Fig.3 Comparison between prediction and structural operator optimized image

不同的圖像分割任務,對特征的描述和提取過程存在較大的差異。針對道路目標結構性強、細節特征不明顯的特點,提出網絡分割與結構化特征優化相結合的方法,使用結構化特征描述子對道路提取的高分辨率細節圖像特征進行補充,對道路提取結果進行優化。

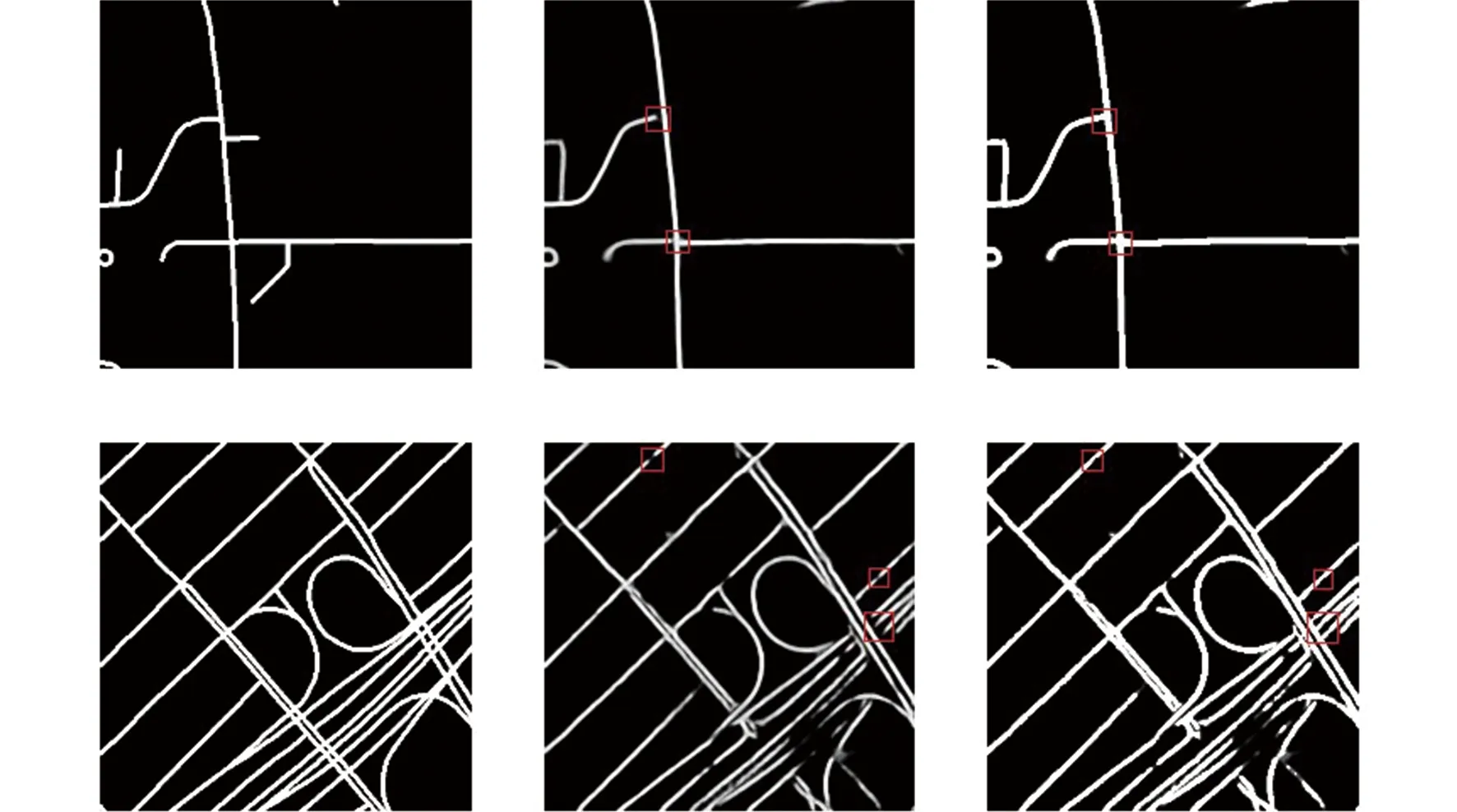

2 試驗驗證和性能分析

試驗以最大的衛星遙感影像道路數據集“馬薩諸塞州道路”作為數據集。該數據集覆蓋了美國馬薩諸塞州超過2 600 km2,每個都是1 500×1 500像素的RGB圖像,分辨率為1 m/像素。訓練集包含1 108幅衛星圖像,測試集包含49幅,驗證集包含14幅。由于深度學習的訓練過程需要大量數據,因此通過旋轉和翻轉(水平和垂直)來增加訓練數據,最終共有6 648張圖像。

圖4 訓練數據增廣過程示意Fig.4 Augmentation of training dataset

試驗使用Adam優化器來更新參數,參數采用了默認設置。學習率設置為0.001,指數衰減率設置為β1=0.9和β2=0.999,ε=10-9。所有試驗均使用PyTorch框架進行。試驗的硬件環境配置為:Intel Xeon E5-2630 v4,64 GB內存,NVIDIA GeForce RTX 1080Ti GPU。對于結構算子優化部分,使用了一個大小為5像素的滑動窗口,角度劃分為20,閾值設為0.01。

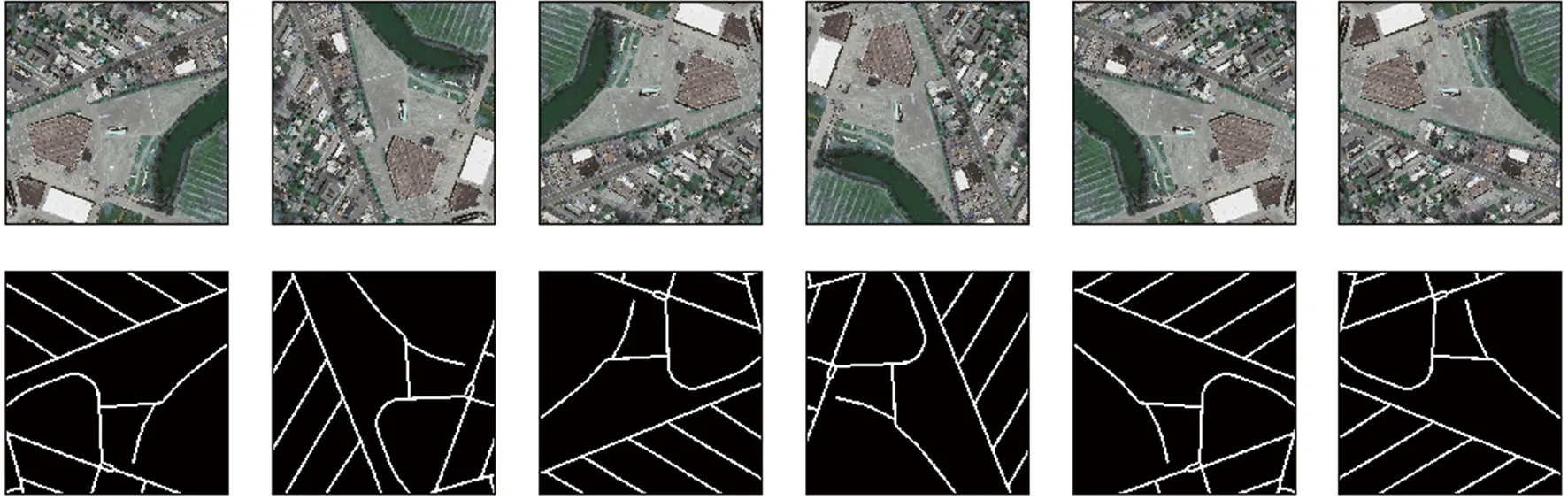

在馬薩諸塞州道路數據集上,對FCN,ELU-SegNet,Encoder-Decoder和SED等方法進行了比較,對應的預測可視化如圖5所示。

圖5 四種模型預測結果的可視化Fig.5 Visualization of prediction of four models

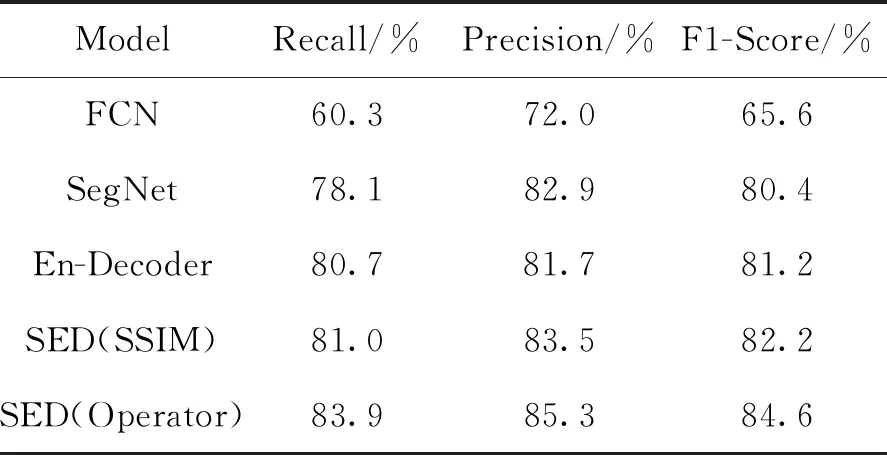

為了對試驗結果進行量化對比,試驗過程中根據該數據及上采用不同方法得到的實驗結果進行了指標量化,對應的指標結果對比如表1所示。

從表1可以看出,改進的淺層Encoder-Decoder方法(SSIM)將道路提取精度提高到了85.3%,F1-score為84.6%,經過結構算子優化后,與改進前相比其精度提高了3.6%,F1-score提高了3.4%。結構損失與結構優化操作使提取更加合理和完整,提出的方法不僅具有提取細節信息的能力,還具有對整個目標道路的結構信息描述的能力,此外結構優化對精度又進一步提升,試驗數據證明了改進的有效性。

表1 不同模型的量化指標

3 結束語

為了提高遙感圖像道路智能提取的精度,從結構相似性損失和結構化特征描述子兩個方面,在編解碼網絡中引入道路的結構特征,以獲得分辨率更高、道路局部特征更完整的道路提取結果。試驗結果證明了所提方法的有效性。基于以上研究,可以得到以下結論:

1)采用圖像分割網絡對遙感圖像進行道路智能提取在多個道路數據集上都取得了明顯的效果,能夠很大程度上緩解測繪遙感領域的道路標注任務復雜度,具有廣闊的應用前景。

2)在圖像分割網絡的基礎上,引入結構化特征描述子優化方法后,能夠將道路提取精度提升約7%。此外,該方法不受遙感成像區域的限制,具有很強的泛化能力。

3)遙感圖像道路提取任務相比于普通的圖像分割任務而言,對目標的結構描述要求更高。本文提出的方法充分利用道路結構化特征,實現了精度更高的道路提取。