基于注意力的毫米波-激光雷達融合目標檢測

李 朝,蘭 海,魏 憲

(1.中國科學院海西研究院泉州裝備制造研究所,福建泉州 362216;2.中北大學電氣與控制工程學院,太原 036005)

0 引言

車輛自動駕駛的安全性依賴于對周圍環境的準確感知。目前車輛采用的主要感知器有激光雷達、攝像頭和毫米波雷達。其中:激光雷達精度高,探測距離較遠,受天氣影響小,但數據較稀疏;攝像頭圖像則具有豐富的顏色信息,但受天氣和光照影響較大;毫米波雷達精度較低,但探測距離遠,受天氣影響極小,也存在數據稀疏的特點。目前有基于單個傳感器或多個傳感器融合的目標檢測,其中不同傳感器數據進行融合能提高無人駕駛系統的魯棒性和冗余性。

在光照條件不友好的環境下,攝像頭難以發揮作用,激光雷達和毫米波雷達是車輛感知環境的主要手段。激光雷達與毫米波雷達所產生的傳感數據均以三維點云數據為主,兩者在數據形式上有著很高的相似性。基于激光雷達點云數據的目標檢測基本上還是解決數據的無序性和稀疏性問題。文獻[1]中提出的PointNet 是具有開創性的工作,真正地實現了無序點云的端到端學習。PointNet 通過池化操作解決點的無序性問題,通過數據對齊操作保證旋轉不變性。除了直接將無序點云輸送進網絡,還可以通過將點云數據先離散化處理再輸入檢測網絡,例如文獻[2-3]中通過將無序的點云劃分到有序的空間體素的方法解決點云數據的無序性問題,之后再通過3D 卷積提取特征,但3D 卷積計算量太大。AVOD 網絡[4]、MV3D 網絡[5]使用2D 卷積對點云鳥瞰圖進行特征提取,提高了檢測速度。

毫米波雷達數據比激光雷達數據更稀疏,但信息比較豐富。文獻[6]中基于調頻連續波(Frequency Modulated Continuous Wave,FMCW)算法利用毫米波雷達檢測目標的方位角、速度、距離,但是誤差較大,且無法檢測出目標的屬性。文獻[7]中提出對毫米波雷達數據利用隨機森林分類器和長短期記憶(Long Short-Term Memory,LSTM)網絡對目標進行分類。文獻[8]中則將整個原始雷達數據作為輸入,采用PointNet++[9]的基礎架構,得到了每一次毫米波雷達反射的各個類概率,不需要進行聚類和人為地選擇特征。文獻[10]中認為雖然毫米波雷達數據比激光雷達數據更稀疏,但與激光雷達單一坐標和強度數據相比,還擁有多普勒速度和雷達截面積數據,能檢測到激光檢測不到的弱目標或遮擋目標,因此開創性地使用雷達數據的位置、速度和雷達截面積信息在PointNet框架上實現了車輛2D邊界框的檢測。

無論是基于激光雷達還是毫米波雷達的目標檢測方法,單一傳感器的感知能力都是有限的,因此傳感器融合已經成為目標檢測的主要方法。傳感器融合主要分為數據級融合、特征級融合和目標級融合。文獻[11-13]中結合激光雷達精度高、毫米波雷達能夠檢測車輛速度的優點進行車輛的檢測和跟蹤,提高了檢測范圍和跟蹤精度。文獻[14]中提出的RRPN(Radar Region Proposal Network)利用投影到圖像坐標系中的毫米波雷達點生成預設置大小的錨框作為目標感興趣區域,再通過檢測網絡進行檢測,減少了90%的錨框數量,提高了運算速度。文獻[15]中將毫米波雷達投影到圖像坐標系后變成二維圖像,使用卷積神經網絡提取毫米波雷達和攝像頭圖像特征圖,并對特征圖對應元素進行相加融合,再對融合后的特征圖使用SSD(Single Shot multibox Detector)[16]框架進行目標檢測。與采取投影方法不同,文獻[17]中將毫米波雷達的距離、橫向速度和縱向速度分別轉換為圖像R、G、B 通道的真實像素值,再將轉換后的毫米波雷達和圖像相乘融合。文獻[18]中則提出了毫米波雷達和圖像融合網絡RVNet,該網絡是基于YOLO[19]檢測框架的特征圖拼接融合網絡,并且為大目標和小目標分別設有兩個輸入分支和輸出分支以提高檢測精度。文獻[20]中提出了毫米波雷達和圖像融合的CRF-Net,在各個卷積網絡層進行特征圖拼接融合,以學習在哪個層的融合目標檢測效果更優,并提出了一種叫作BlackIn的訓練策略以確保融合網絡收斂。

除了傳感器融合方法以外,注意力機制也被應用到圖像領域并取得了巨大的進展。注意力機制最早從人類的視覺原理中獲取靈感,并在自然語言處理中取得了很好的效果[21-22]。注意力機制通過捕捉數據點之間的相互影響,獲取數據間的上下文信息并以此作為權重輸出結果,是對深度學習模型的有力補充。文獻[23]中提出的兩級注意力模型應用物體級和部位級兩種注意力,使用卷積網絡得到物體級信息,再使用聚類的方法得到重點局部區域,從而能更精確地利用多層次信息。文獻[24]中提出了通道注意力機制,認為特征圖的不同通道的重要程度不同,網絡通過全局平均池化獲取特征圖每個通道的數值分布情況,增大有效特征圖通道的權重,利用激勵操作來獲取通道之間的依賴性,并以此作為權重輸出結果。除了利用通道注意力機制判斷不同通道之間的權重關系,另外就是像素點之間的注意力機制。文獻[25]中認為卷積神經網絡神經只能關注卷積核感受野內的像素點信息,無法學習全局信息對當前區域的影響,因此通過特征圖之間矩陣相乘的方法確定每個像素和其他像素間的關系。

本文針對激光雷達進行目標檢測時對遮擋目標、遠距離目標和復雜天氣場景中的目標檢測能力弱的問題,提出基于注意力機制的毫米波-激光雷達數據融合的目標檢測方法。原因如下:1)毫米波雷達不受天氣光照影響,并且對車輛等金屬敏感,能夠穿透樹木草叢檢測出車輛,彌補激光雷達受到的干擾[10];2)激光雷達對遠處的物體探測結果較為稀疏,難以實現遠處物體的類別檢測,而毫米波雷達探測距離遠,原理上探測距離的四次方與雷達散射面積成正比,兼具多普勒效應,能夠檢測速度,極大地增強了遠處物體的檢測精度;3)注意力機制能夠有效提取數據間的上下文信息,利用數據點之間的權重關系輸出結果,十分適合毫米波-激光點云數據之間的融合,能夠充分發揮毫米波雷達和激光雷達各自的優點。本文通過點云柱快速編碼網絡PointPillar[26]提取經過空間對齊的激光雷達和毫米波雷達特征,然后將毫米波-激光雷達特征圖進行融合,彌補單一雷達傳感器檢測上存在的不足,提高了算法模型對物體目標的檢測精度,亦提高了惡劣天氣下算法表現的魯棒性。本文代碼公開在https://github.com/MVPRGroup/radar-lidar-fusion。

1 注意力融合方法

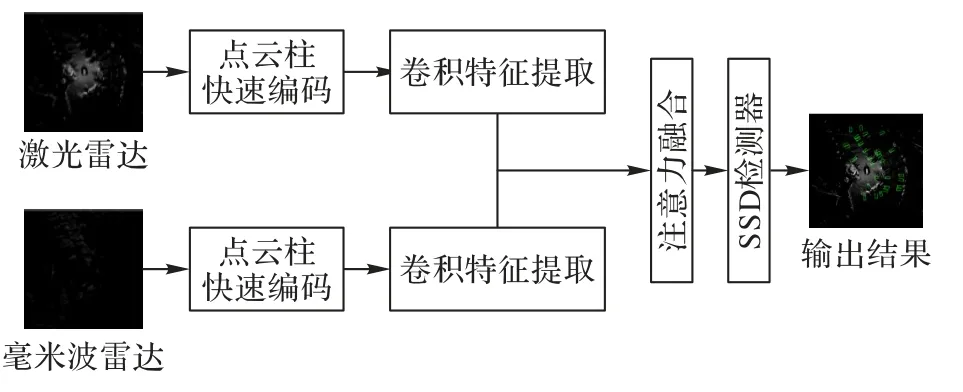

本章主要介紹激光雷達和毫米波雷達融合的方法,通過利用不同傳感器各自的優勢,彌補激光雷達存在的缺陷,提高網絡性能。文獻[10]的研究發現,激光雷達在探測目標時,目標距離越遠,返回的激光雷達點越少,強度越弱,易受雨霧、樹木遮擋;其次,毫米波雷達發送信號所使用波長遠大于激光雷達,能夠穿透塑料、墻板和衣服等特定的材料,并且不受雨、霧、灰塵和雪等環境條件的干擾;另外毫米波雷達數據相對于激光雷達數據更稀疏,但毫米波雷達數據在目標速度和雷達截面積(Radar Cross-Section,RCS)信息上具有很強的特征。例如,移動的車輛具有較高的相對速度以及車身能夠產生高RCS值。所有這些特征對于目標檢測都非常有用。本文設計了基于注意力機制的毫米波-激光雷達數據融合目標檢測網絡,如圖1 所示。該網絡包含四個模塊:點云柱快速編碼模塊、卷積特征提取模塊、注意力融合模塊和SSD檢測模塊。

圖1 傳感器注意力機制融合網絡框架Fig.1 Sensor attention mechanism fusion network framework

1.1 點云柱快速編碼

激光雷達和毫米波雷達都是無序的稀疏點云數據。為了使激光雷達和毫米波雷達能夠良好地融合,本文對激光雷達和毫米波雷達采取了點云柱快速編碼[26]方法。如圖2 所示,點云柱快速編碼方法首先以自身為中心,在100 m×100 m 的地平面范圍中均勻生成400×400 個立方柱體,即每個柱體的底面大小為0.25 m×0.25 m,高度限制為10 m;每個點云柱中的點數約束為N,多則采樣,少則補0,并對每個點進行維度擴展。將激光雷達點云原始數據的三維坐標.xl,yl,zl)和強度I加入.xc,yc,zc,xp,yp)5個額外維度。其中,.xc,yc,zc)為該點云柱中所有點的坐標平均值,即所有點的聚類中心;(xp,yp)為各點到點云柱中心的x-y坐標偏移量,此時點云柱中的每個點有9 個維度。考慮到點云數據的稀疏性,因此在單次訓練樣本中的非空點云柱數目約束為P,并根據實際數量隨機采樣或補0。整個點云數據被編碼為形狀(D,P,N)的張量,D是點云柱特征維度,P是非空點云柱數量,N為單個點云柱中數據點的個數。(D,P,N)利用1×1 卷積操作進行線性變換后得到張量(C,P,N),對每個點云柱中的所有點進行最大池化操作得到特征矩陣(C,P)。最后將P個非空點云柱內的點映射回檢測范圍內的原始位置得到大小為(C,W,H)的二維點云偽圖像。

圖2 點云柱快速編碼Fig.2 Fast encode for PointPillar

毫米波雷達點云數據共有18 維(具體見3.1 章),與激光雷達只利用位置信息和強度信息不同,為了彌補激光雷達數據的不足,毫米波雷達保留其中的坐標.xrl,yrl,zrl)、補償速度.Vx_comp,Vy_comp)及目標雷達截面積(IRCS)共6 個維度。相比激光雷達點的位置信息,毫米波雷達點的位置信息正樣本比例高,受距離因素、天氣因素影響小;相比激光雷達的反射強度信息,毫米波雷達RCS信息能夠直接反映出目標的體積大小,尤其卡車、汽車和行人RCS特征差別明顯,起到了信息互補作用。除此之外毫米波雷達還能檢測出目標的矢量速度信息來輔助檢測任務。

為更好地提取毫米波雷達的特征,本文對點云柱快速編碼方法做了改進。由于所有毫米波雷達點云數據中的zr都為0,在對毫米波雷達雷達特征點云柱快速編碼過程中,去除了激光點云數據.xc,yc,zc)中的zc項及(xp,yp)兩項。改進后的毫米波雷達點云柱快速編碼網絡提取8 個特征(xrl,yrl,zrl,Vx_comp,Vy_comp,xc,yc,IRCS)。編碼后的毫米波雷達為形狀.Dr,P,N)的張量,之后根據柱體坐標映射得到與激光雷達相同維度的二維點云偽圖像。

1.2 注意力融合

本文提出的基于注意力機制的毫米波-激光雷達數據融合方法如圖3 所示:首先采用注意力機制對卷積特征提取模塊輸出的毫米波與激光雷達特征圖進行融合,如式(1)所示,其中:Xl∈RC×N表示激光雷達特征圖,Xr∈RC×N表示毫米波雷達特征圖,O表示注意力融合后的激光雷達特征圖。

圖3 激光雷達和毫米波雷達注意力融合Fig.3 Attention fusion of lidar and millimeter wave radar

注意力融合過程中,定義式(2):

如圖3 所示:激光雷達特征圖經過1×1 卷積層和BatchNorm 層、RELU 激活層后得到Q和V;毫米波雷達特征圖經過1×1 卷積層和BatchNorm 層、整流線性單位函數(Rectified Linear Unit,ReLU)激活層后得到K。使用點乘作為Q與K的內積形式,并將結果利用Softmax 進行歸一化,可計算出激光雷達特征圖所對應的Q與毫米波雷達特征圖所對應的K之間的關系權重矩陣A,A中各項aij計算如式(3)所示。

在得到毫米波-激光雷達點云數據間的關系權重矩陣A后,如式(4)所示,將優化后的權重矩陣和激光雷達特征圖所對應的V相乘,即得到融合結果O。

另外,借鑒殘差模塊的概念[27],如式(5)所示,將融合結果O乘上比例系數λ并加上激光雷達特征圖Xl,得到最終輸出結果y。λ初始值設為0,通過訓練學習增大該權重系數。其物理含義可視為一開始注意力機制的影響為0,隨著訓練的進行逐漸增大注意力在輸出中的影響。

除了傳感器注意力融合方法,本文還與拼接融合、相乘融合和相加融合進行了對比,各個方法在網絡中的融合位置相同。文獻[20]中進行了傳感器特征圖拼接融合實驗。本文對激光雷達和毫米波雷達特征圖通道維度進行疊加,得到維度(2C×W×H)融合特征圖。融合后的特征圖通過1×1 卷積降維到原來的維度。

文獻[15]中進行了特征圖相加融合實驗。本文對激光雷達特征圖和毫米波雷達特征圖對應元素相加融合。

文獻[17]中采用了特征圖相乘的融合方式。由于毫米波雷達的稀疏性毫米波雷達特征圖Xr比激光雷達特征圖Xl有更多的元素為0,因此對毫米波雷達特征圖為0的元素進行加1 操作,如式(6)所示,得到毫米波特征圖;將毫米波-激光雷達特征圖相乘,如式(7)所示。加1 操作保證相乘融合時不會丟失激光雷達特征圖中包含的信息,但又能通過毫米波雷達強化相同位置激光雷達特征圖信息流。

2 融合檢測網絡結構

本文使用PointPillar 點云快速編碼網絡框架作為基礎網絡,并在此網絡模型上加入融合模塊進行改進。PointPillar 采用類似文獻[2]的主干網絡結構。輸入數據在經過點云柱快速編碼之后,生成點云偽圖像后進入主干網絡,主干網采用空間金字塔池化結構,包含兩個子網絡:一個是自上向下的下采樣卷積網絡產生空間分辨率越來越小的特征;另一個卷積網絡分支將前面3 個卷積塊的輸出卷積成相同大小的特征圖,如圖4所示。提取出毫米波-激光雷達點云數據的特征之后,將兩者送入融合模塊,最終將融合結果送入檢測模塊,輸出結果。

圖4 卷積特征提取主干網絡Fig.4 Convolutional feature extraction backbone network

在激光雷達和毫米波雷達的點云柱快速編碼模塊中,每個點云柱中包含點數量N設置為60,非空點云柱數量P設置為30 000。編碼后得到維度為(C,W,H)的偽圖像,其中W和H等于400,C等于64。

通過點云柱編碼得到維度(C,W,H)的偽圖像后,為了檢測不同尺寸的目標,在卷積特征提取層設置了兩個子網絡,它們的連接方式如圖4 所示。前子網絡的每個卷積塊第一層下采樣步長為2,每個卷積后面都接一個BacthNorm 層和ReLU層。前子網絡卷積塊輸出作為同子網絡卷積塊和后子網絡卷積塊的輸入。每個卷積后的特征圖經過1-1、2-1、3-1 子網絡卷積塊得到相同的維度為的特征圖,三個模塊拼接成維度的特征圖。

分別提取了激光雷達和毫米波雷達特征圖后,本文嘗試了注意力融合方法和另外三種融合方法:拼接融合、相加融合和相乘融合。通過上述的點云柱快速編碼模塊和卷積特征提取模塊后,激光雷達和毫米波雷達從無序的點云轉化為有序的偽圖像。兩者在空間上具有良好的對應性,這對傳感器融合十分重要。nuScenes[28]數據集標簽注釋的各類目標物框內的激光雷達點數量是毫米波雷達的4~10倍,這就意味著一個目標物上有很少的毫米波雷達點。例如,一輛車的長大約4.5 m,寬2 m,使用(0.25,0.25)的點云柱的條件下,車輛所占的激光雷達點云柱約有100 個,而毫米波雷達只有幾個。如圖1 所示,通過將融合模塊放置在卷積特征提取層后,利用卷積特征提取操作來擴大毫米波雷達感受野,增強網絡整體性能。將擴大了感受野的毫米波雷達特征圖使用上述介紹的注意力融合方法進行實驗,并在相同位置進行另外三種融合方法對比。

經過傳感器注意力后的特征圖使用SSD 檢測器進行3D檢測。通過匹配設置的先驗框和真實框的2D 平面重疊度交并比(Intersection over Union,IoU)進行篩選。框的高度和距離地面的高度作為額外的回歸目標。

本文通過3個1×1的卷積層實現分類、位置回歸和方向回歸。根據先驗知識設置9 種大小的3D 框,每個類都設置不同的匹配和非匹配IoU 閾值。每個框有7 個維度(x,y,z,w,h,l,θ),分別代表著框的長、寬、高、中心坐標和方向。使用文獻[26]的損失函數計算損失。真實框和生成框之間的位置回歸殘差定義為式(8),尺寸回歸殘差定義為式(9),方向回歸定義為式(10)。

其中:上標gt 表示真實值,上標為a 表示預測值。總位置損失函數的定義為式(11):

其中SmoothL1定義如下:

由于文獻[2]中定義的方向損失函數不能區分0°和180°旋轉的框,本文使用文獻[26]中的方向損失函數,定義如式(13):

分類函數Lcls使用的是Focal loss[29]損失函數,如式(14)所示。其中pa代表框的分類概率,α=0.25,γ=2。

總的損失函數定義為:

其中:Npos代表正樣本框的數量,即大于設定IoU 閾值的框的數量;設置λ1=2,λ2=1,λ3=0.2。

3 實驗與結果分析

3.1 數據預處理

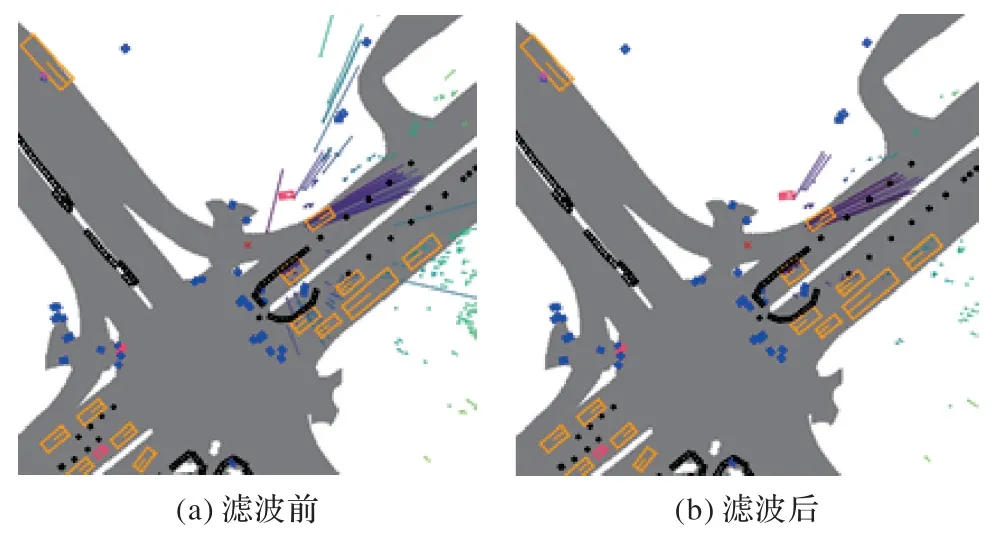

本文采用的是nuScenes 數據集,該數據集包含1 個32 線激光雷達、5 個毫米波雷達、5 個攝像頭的所有傳感數據。數據集提供的毫米波雷達數據是經過聚類處理的雷達點,每個雷達點有18 個維度,包含坐標、速度、雷達散射面積、雷達動態特性、多普勒迷糊解狀態、有效性狀態等,如表1 提供的部分信息所示。可以通過雷達狀態通道對雷達點進行篩選的方法來濾除不相關雷達點。本文實驗中對毫米波雷達濾波設置是保留多普勒模糊解:3 表示清楚的,以及點有效性狀態:0 表示有效的和所有雷達動態特性下的毫米波雷達點。濾波前和濾波后的毫米波圖像如圖5 所示,圖右上角為安裝在車頭處毫米波雷達數據,雷達點上的線條表示速度方向和大小。

圖5 毫米波雷達點濾波前后圖像對比Fig.5 Image comparison of millimeter wave radar points before and after filtering

表1 毫米波雷達數據各個通道及其說明Tab.1 Channels and channel descriptions of radar data

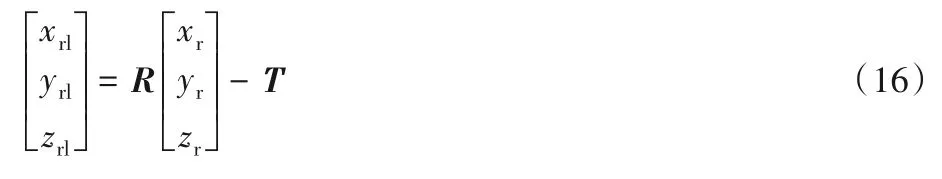

在本文中使用的是激光雷達的坐標和強度信息,毫米波雷達的坐標、RCS 和速度信息。激光雷達和毫米波雷達安裝在車輛的不同位置并使用不同坐標系。以車輛的慣性測量單元(Inertial Measurement Unit,IMU)作為參考點;激光雷達平移矩陣Tl,旋轉矩陣Rl,毫米波雷達雷達平移矩陣Tr,旋轉矩陣Rr,其中毫米波雷達轉換到激光雷達坐標系的旋轉矩陣R=Rl·Rr,轉換到激光雷達安裝位置的平移矩陣T=Tl-Tr。通過式(16)可將毫米波雷達點云數據中的坐標轉換到激光雷達空間,轉換后的毫米波雷達坐標記為.xrl,yrl,zrl)。如圖6 所示,毫米波雷達的速度方向并不能反映物體的絕對速度V,而是表示與自身車輛的相對徑向速度Vr。該速度在x-y方向上的分量為(Vx,Vy)=.Vr· cosα,Vr· sinα),車輛自身速度(Vex,Vey),補償速度.Vx_comp,Vy_comp)=(Vx,Vy)-(Vex,Vey),利用式(17)將毫米波雷達坐標系下的速度轉化為激光雷達坐標系的速度.Vx_comp_1,Vy_comp_l)。

圖6 毫米波雷達點速度示意圖Fig.6 Schematic diagram of radar point velocity

雖然毫米波雷達數據缺乏相對切向速度,不能完全反映出物體的真實運動速度,但是通過結合其他信息對物體的運動狀態進行粗略判斷也能夠在對障礙物檢測中發揮積極作用。

3.2 實驗設置

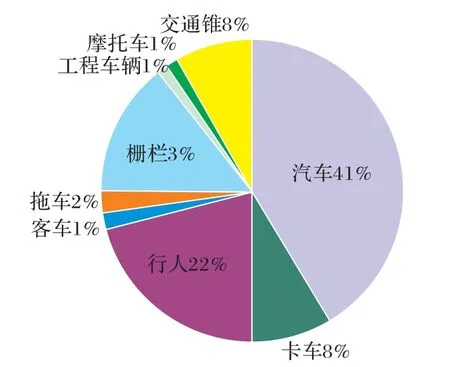

nuScenes 數據集包含了28 130 個訓練樣本和6 019 個測試樣本。數據集的激光雷達掃描頻率是20 幀/秒(Frame Per Second,FPS),32線束,探測距離100 m,精度±0.02 m,每幀大約3 萬個點。毫米波雷達是77 Hz 的調頻連續波(Frequency Modulated Continuous Wave,FMCW)雷達,掃描頻率13 FPS,探測距離250 m,近距離精度±0.1 m,遠距離精度±0.4 m,每幀掃描聚類后的點數最多125 個。因為標注樣本所占的比例是每秒2 幀,所以將全部掃描幀中連續10 幀激光雷達和連續5 幀毫米波雷達聚合到樣本幀進行數據增強。本文中目標檢測包含9 個目標分類:汽車、卡車、客車、拖車、工程車輛、行人、摩托車、交通錐和柵欄。各個類在整個數據集所占比例如圖7 所示,以下實驗均使用單個GPU 完成,由于數據集較大,訓練完整數據集進行耗時較長,所以使用1/2數據集即14 065個訓練樣本進行訓練,測試樣本6 019個。

圖7 數據集各類實例所占百分比Fig.7 Percentages of various classes of instances in dataset

與訓練一個網絡僅識別一類目標不同,訓練一個網絡同時進行9類目標的檢測。訓練時批量大小設置為3,測試時為1,訓練次數為30 個epoch(140 000 次迭代)。本文總共設置2 500個錨點,每個點上18個3D框,即每個點上每個類兩個框方向分別設置為0°和90°。

在實驗過程中進行了多組對比實驗。在毫米波-激光雷達融合方法上使用了注意力融合、拼接融合、相加融合和相乘融合,并和激光雷達單一傳感器的自注意力[25]進行對比。實驗平臺的操作系統為Centos7,并帶有型號為NVIDIA RTX Titan XP 的GPU和Intel Xeon Silver 4210的CPU。

3.3 毫米波-激光雷達數據融合實驗對比

首先,使用PointPillar點云快速編碼網絡框架作為基礎網絡,并在基礎網絡上加入基于注意力機制的毫米波-激光雷達點云數據融合模塊進行實驗比對,為證明實驗結果的提升并非因為網絡參數的增加而導致,額外加入了擁有相同參數量的激光雷達點云數據的自注意力模塊作為參考。實驗結果如表2所示,基于注意力機制的毫米波-激光雷達點云數據融合方法的目標檢測準確率與基礎網絡以及激光雷達的自注意力方法相比,取得了一定提升,基于注意力機制的數據融合方法的平均精度均值(mean Average Precision,mAP)高出基礎網絡0.62個百分點,證明了本文中所提算法的有效性。

表2 基準網絡、自注意網絡和注意力融合方法的AP與mAP對 單位:%Tab.2 AP and mAP comparison of baseline network,self-attention network and attention fusion method unit:%

另外,從實驗中可以看出,激光雷達自注意方法實驗準確率比基礎網絡性能要低,初步推測是由于在點云柱快速編碼過程中,其中的最大池化操作將點云柱內大量高相關性數據進行了簡化,之后的注意力機制僅能夠捕捉到點云柱間的上下文信息,因此,對于體積較大的目標,其所占點云柱數目較多,注意力機制能夠對其檢測性能加以提升,而體積較小的物體,所占點云柱數目較小,注意力機制無法捕捉該目標的上下文信息從而影響了該類目標的檢測結果。在未來的工作中,將考慮這一因素對點云柱的快速編碼模塊進行優化。

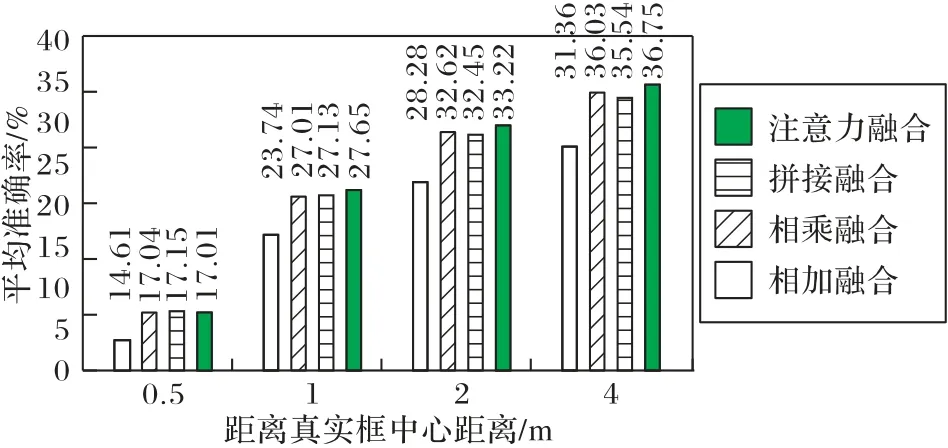

3.4 不同數據融合方法的對比實驗

本節將基于注意力機制的融合方法與拼接、相加、相乘三種常見融合方法進行相比,實驗結果如圖8 所示,可見基于注意力機制的融合方法的性能明顯優于其他方法。

圖8 注意力融合和拼接融合、相乘融合、相加融合的平均準確率對比Fig.8 Average accuracy comparison of attention fusion,concatenation fusion,multiply fusion and add fusion

根據實驗結果,基于注意力融合的目標檢測方法性能優于拼接、加和、相乘融合目標檢測方法。通過分析可知:一方面聚類后的毫米波雷達點位置誤差較大,Nusence數據集中使用的ARS408型號毫米波雷達數據30 m 外誤差為0.4 m,因此部分與目標關聯的毫米波雷達點并不在該目標上,而可能在目標周圍;另一方面一個目標可能與多個毫米波雷達點相關聯,使用拼接、加和、相乘融合只能融合對應的局部位置信息,而注意力融合能夠通過全圖的來學習毫米波雷達目標和激光雷達目標之間的關聯。

3.5 實驗結果可視化分析

本文對基礎網絡模型和注意力融合網絡模型的檢測效果進行鳥瞰圖可視化,可視化范圍為前后左右各50 m 的x-y平面。如圖9 所示,圖中框表示檢測的目標物,框的閉合方向表示目標的方向。通過對比第一行第三列左上角,第二行第三列左上角,第三行第三列圖片右下角可以發現,基礎網絡遺漏了部分的遠處目標,而融合了毫米波雷達數據的網絡模型能夠很好地將其檢測出來,說明融合網絡成功地將毫米波對遠處目標的感知優勢融入激光雷達特征圖中,彌補了激光雷達對遠處目標檢測點數稀疏而造成的漏檢。另外,在對比第一行和第二行圖片右下角可以發現,當目標被樹木遮擋后基礎網絡的檢測效果不佳,出現漏檢及方向檢測錯誤,而本文所提出的融合網絡能夠正確檢測被樹木遮擋的車輛,這是由于毫米波信號對樹木草叢等的穿透性增強了融合網絡對這類遮擋目標檢測的性能。如第四行圖片所示,基礎網絡在雨霧天氣下由于空氣水滴反射干擾更容易出現錯檢和漏檢,而由于毫米波雷達對極端天氣的魯棒性更強,融合網絡在雨霧天氣下比基礎網絡也更為穩定。通過實驗結果圖對比可以發現,傳感器注意力融合方法充分發揮了毫米波雷達可以穿透樹木草叢、不受天氣影響和探測距離遠等特點,能有效提高網絡檢測性能。

圖9 基礎網絡與毫米波-激光雷達注意力融合檢測結果對比Fig.9 Detection result comparison of basic network and millimeter wave radar-lidar attention fusion

3.6 與nuScenes上最先進方法的對比

本文在完整數據集下進行訓練后對大型車輛的檢測結果和目前數據集上公開的現有最先進算法SARPNET[30]、MonoDIS[31]進行比較。其中SARPNET 是基于激光雷達的目標檢測,MonoDIS 是基于攝像頭的目標檢測。通過實驗結果表3 可以發現,本文融合方法對車輛的檢測準確率高于其他兩種方法,在nuScenes數據集上取得了優異的表現。

表3 nuScenes數據集上本文融合方法和SARPNET、MonoDIS的mAP對 單位:%Tab.3 mAP comparison of the proposed fusion method,SARPNET and MonoDIS on nuScenes dataset unit:%

4 結語

本文在點云快速編碼網絡PointPillar的基礎上,提出了一種基于注意力機制的毫米波-激光雷達數據融合的目標檢測方法,充分利用了毫米波雷達探測距離遠、不受天氣影響、可穿透樹木和具有徑向速度探測等特點,彌補了激光雷達的不足。本文的實驗結果驗證了所提方法的有效性,而且該方法也優于其他融合方法和自注意力方法。

考慮到本文使用的nuScenes數據集目標類的分布極不均勻,使得在一些類的檢測結果準確率很低;另外本文毫米波雷達進行濾波只根據單通道數值進行過濾,而在毫米波雷達特征提取方法上借鑒的激光雷達特征提取方法,未充分考慮到毫米波雷達的稀疏性問題;以及點云柱快速編碼過程中造成的小體積目標上下文信息丟失等問題,在未來的工作中將考慮利用數據增強及半監督學習等方法解決類數量不平衡問題,重新設計端對端的點云數據編碼-特征提取-檢測網絡,從而進一步提升算法性能。