基于參考圖像的膝關節MRI超分辨率重建算法研究

何理文 遲潔茹 石涵瑜 李鎣楠

摘要:針對在膝關節MRI圖像重建中,傳統超分辨算法存在重建圖像紋理不清晰、參考圖像難以與低分辨率圖像紋理嚴格對齊等問題,提出了一種基于參考圖像的膝關節MRI超分辨率成像算法。該算法利用紋理相似性,將參考圖像的遷移紋理與低分辨率圖像紋理自適應地對齊,豐富低分辨率圖像的細節,實現膝關節MRI超分辨率成像。紋理遷移利用殘差網絡與跳躍鏈接構成的生成網絡實現。實驗結果表明,與傳統算法相比,該算法重建圖像分辨率更高、紋理更真實。

關鍵詞:MRI;圖像重建;深度學習

中圖分類號:TN011

文獻標志碼:A

文章編號:1006-1037(2021)01-0077-05

基金項目:山東省自然科學基金 (批準號:ZR2016FM11)資助

通信作者:遲潔茹,女,博士,副教授,主要研究方向為智能信息處理,醫學成像等。E-mail:qduchijieru@163.com

核磁共振成像(Magnetic Resonance Imaging, MRI)是一種非侵入式的活體成像技術,因具有無輻射、對比度高等特點而被廣泛應用于膝蓋MRI成像。MRI成像存在成像速度慢、運動偽影等缺點,難以在短時間內獲得高分辨圖像。超分辨率(Super-Resolution,SR)技術為低分辨率MRI圖像的高信噪比和高分辨率重建提供了可行性[1]。近年來,深度學習尤其是深度卷積神經網絡(Convolutional Neural Network,CNN)[2-5]在MRI重建領域得到了廣泛的應用。基于深度學習的MRI成像方法在保證圖像精度的同時提高重建速度。Dong[6]使用超分辨率卷積神經網絡(Super-Resolution Convolutional Neural Network, SRCNN)進行圖像重建,具有結構簡單、容易實現等優點。由于存在采用的卷積層數少、感受野小、泛化能力差等缺陷,使SRCNN因無法提取圖像深層次特征而導致重建圖像紋理不夠清晰。基于參考圖像的超分辨率重建(Reference-based Super-Resolution,RefSR)技術在圖像重建過程中,通過引入與低分辨率圖像具有相似紋理或內容結構的參考圖像,將參考圖像的高頻細節遷移到低分辨率圖像(low-resolution,LR)中,從而獲得高分辨率圖像。Yue等[7]對RefSR技術提出了結構感知匹配準則,提高了低分辨率與高分辨率補丁之間的映射精度,但這種方法要求參考圖像與低分辨率圖像的紋理良好對齊。Walls等[8]提出了基于流光法的RefSR深層模型,該模型將輸入圖像與參考圖像的紋理對齊。由于流光法無法匹配長距離對應關系,導致該方法無法處理明顯未對齊的參考圖像。本文在傳統RefSR算法基礎上提出了改進型的RefSR方法(IRefSR),根據紋理相似性自適應地遷移參考MRI圖像的紋理來豐富低分辨率MRI圖像的細節[9-10],克服傳統方法需要紋理嚴格對齊的缺點;在神經空間內進行多級匹配,有助于多尺度神經傳遞,使模型盡可能地從語義相同的參考圖像補丁中獲取紋理信息,從而克服傳統算法在像素空間特征匹配的不足。利用本文所提出算法,能夠減少掃描時間,提高圖像的分辨率;在提高患者安全性的同時,獲取更準確的診斷圖像。

1 網絡結構

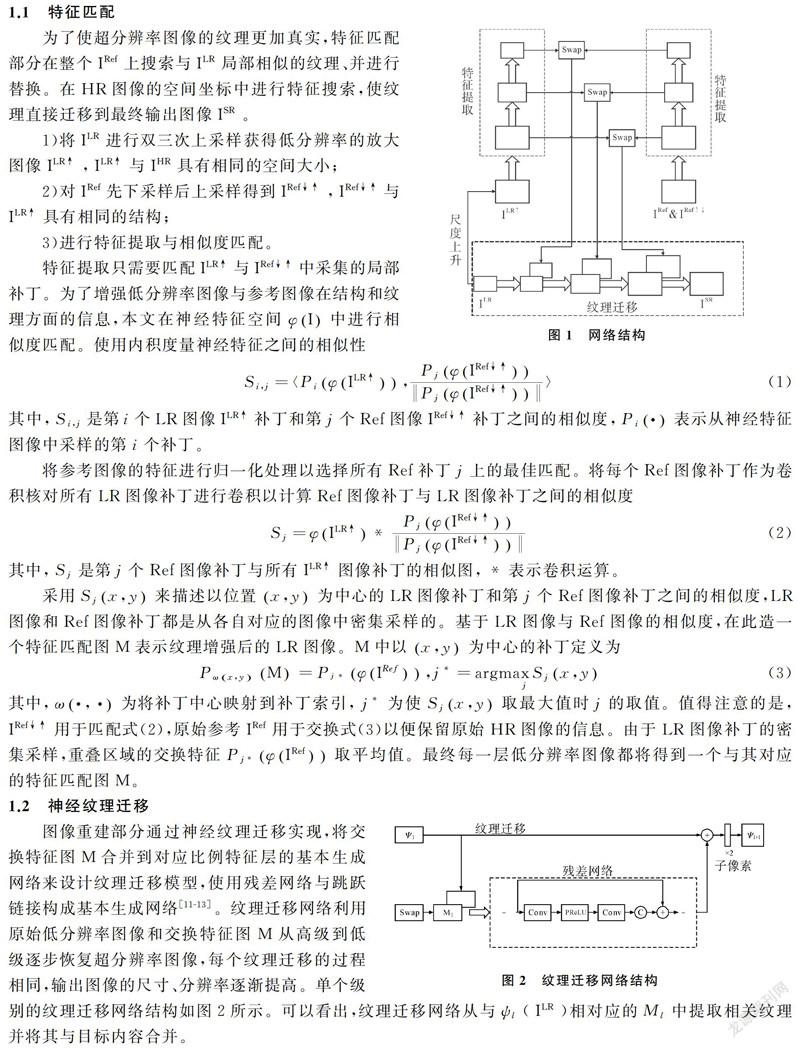

本文提出的基于參考圖像的超分辨率算法中神經網絡模型主要分為特征匹配與紋理遷移兩部分。特征匹配部分在特征空間中搜索參考圖像IRef的紋理特征,通過多層級方式與低分辨率圖像ILR的紋理特征進行對比,根據兩者之間的相似程度進行特征塊的替換,并將特征匹配部分得到的特征結果輸入到紋理遷移結構中。紋理遷移部分將得到的特征結果整合到LR圖像中,采用的LR圖像由高分辨率圖像(high-resolution,HR)經過雙三次插值下采樣(4×)獲得。網絡結構如圖1所示。

1.1 特征匹配

為了使超分辨率圖像的紋理更加真實,特征匹配部分在整個IRef上搜索與ILR局部相似的紋理、并進行替換。在HR圖像的空間坐標中進行特征搜索,使紋理直接遷移到最終輸出圖像ISR。

1)將ILR進行雙三次上采樣獲得低分辨率的放大圖像ILR↑,ILR↑與IHR具有相同的空間大小;

2)對IRef先下采樣后上采樣得到IRef↓↑,IRef↓↑與ILR↑具有相同的結構;

3)進行特征提取與相似度匹配。

特征提取只需要匹配ILR↑與IRef↓↑中采集的局部補丁。為了增強低分辨率圖像與參考圖像在結構和紋理方面的信息,本文在神經特征空間φI中進行相似度匹配。使用內積度量神經特征之間的相似性

其中,Si,j是第i個LR圖像ILR↑補丁和第j個Ref圖像IRef↓↑補丁之間的相似度,Pi·表示從神經特征圖像中采樣的第i個補丁。

將參考圖像的特征進行歸一化處理以選擇所有Ref補丁j上的最佳匹配。將每個Ref圖像補丁作為卷積核對所有LR圖像補丁進行卷積以計算Ref圖像補丁與LR圖像補丁之間的相似度

其中,Sj是第j個Ref圖像補丁與所有ILR↑圖像補丁的相似圖,表示卷積運算。

采用Sjx,y來描述以位置x,y為中心的LR圖像補丁和第j個Ref圖像補丁之間的相似度,LR圖像和Ref圖像補丁都是從各自對應的圖像中密集采樣的。基于LR圖像與Ref圖像的相似度,在此造一個特征匹配圖M表示紋理增強后的LR圖像。M中以x,y為中心的補丁定義為

其中,ω·,·為將補丁中心映射到補丁索引,j為使Sjx,y取最大值時j的取值。值得注意的是,IRef↓↑用于匹配式(2),原始參考IRef用于交換式(3)以便保留原始HR圖像的信息。由于LR圖像補丁的密集采樣,重疊區域的交換特征Pj*φIRef取平均值。最終每一層低分辨率圖像都將得到一個與其對應的特征匹配圖M。

1.2 神經紋理遷移

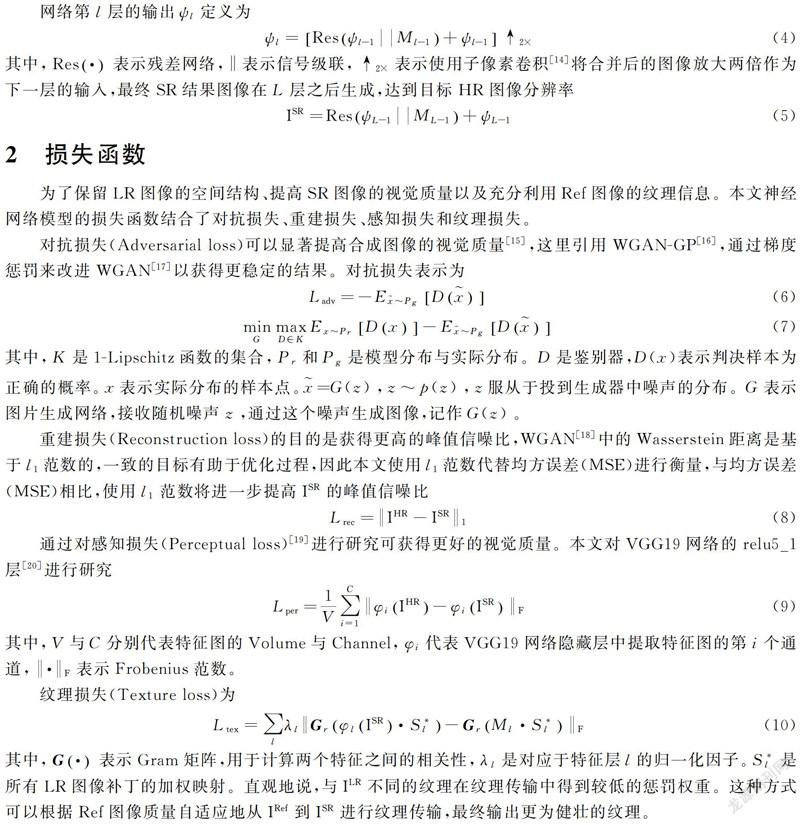

圖像重建部分通過神經紋理遷移實現,將交換特征圖M合并到對應比例特征層的基本生成網絡來設計紋理遷移模型,使用殘差網絡與跳躍鏈接構成基本生成網絡[11-13]。紋理遷移網絡利用原始低分辨率圖像和交換特征圖M從高級到低級逐步恢復超分辨率圖像,每個紋理遷移的過程相同,輸出圖像的尺寸、分辨率逐漸提高。單個級別的紋理遷移網絡結構如圖2所示。可以看出,紋理遷移網絡從與ψl (ILR)相對應的Ml中提取相關紋理并將其與目標內容合并。

網絡第l層的輸出ψl定義為

其中,Res·表示殘差網絡,‖表示信號級聯,↑2×表示使用子像素卷積[14]將合并后的圖像放大兩倍作為下一層的輸入,最終SR結果圖像在L層之后生成,達到目標HR圖像分辨率

2 損失函數

為了保留LR圖像的空間結構、提高SR圖像的視覺質量以及充分利用Ref圖像的紋理信息。本文神經網絡模型的損失函數結合了對抗損失、重建損失、感知損失和紋理損失。

對抗損失(Adversarial loss)可以顯著提高合成圖像的視覺質量[15],這里引用WGAN-GP[16],通過梯度懲罰來改進WGAN[17]以獲得更穩定的結果。對抗損失表示為

其中,K是1-Lipschitz函數的集合,Pr和Pg是模型分布與實際分布。D是鑒別器,D(x)表示判決樣本為正確的概率。x表示實際分布的樣本點。=G(z),z~p(z),z服從于投到生成器中噪聲的分布。G表示圖片生成網絡,接收隨機噪聲z,通過這個噪聲生成圖像,記作G(z)。

重建損失(Reconstruction loss)的目的是獲得更高的峰值信噪比,WGAN[18]中的Wasserstein距離是基于l1范數的,一致的目標有助于優化過程,因此本文使用l1范數代替均方誤差(MSE)進行衡量,與均方誤差(MSE)相比,使用l1范數將進一步提高ISR的峰值信噪比

通過對感知損失(Perceptual loss)[19]進行研究可獲得更好的視覺質量。本文對VGG19網絡的relu5_1層[20]進行研究

其中,V與C分別代表特征圖的Volume與Channel,φi代表VGG19網絡隱藏層中提取特征圖的第i個通道,·F表示Frobenius范數。

紋理損失(Texture loss)為

其中,G·表示Gram矩陣,用于計算兩個特征之間的相關性,λl是對應于特征層l的歸一化因子。Sl是所有LR圖像補丁的加權映射。直觀地說,與ILR不同的紋理在紋理傳輸中得到較低的懲罰權重。這種方式可以根據Ref圖像質量自適應地從IRef到ISR進行紋理傳輸,最終輸出更為健壯的紋理。

3 實驗結果與分析

3.1 數據集與實驗細節

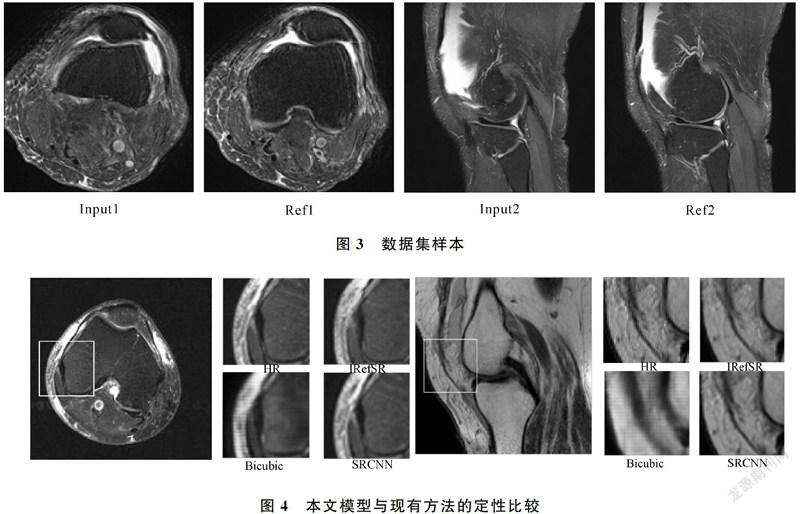

為了證實算法在膝關節MRI圖像超分辨率重建方面的有效性,從膝關節MRI圖像數據集中裁剪5 000對大小為160×160的圖像作為數據集,且輸入圖像與參考圖像具有不同程度相似度。圖3展示了其中兩組來自數據集的樣本。

訓練IRefSR時Adam優化器的學習率為1e-4,Lrec、Lper、Ladv和Ltex的權重分別為1、1e-4、1e-6、1e-4。先用重建損失訓練2輪再使用全部損失訓練20輪。計算機語言使用Python,框架為TensorFlow,GPU廠商為NVIDIA.

3.2 視覺效果比較

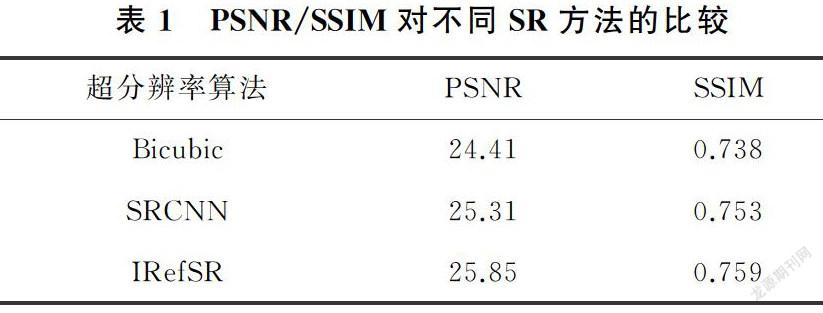

作為比較示例,本文從膝關節MRI數據集中選取2張圖像,將雙三次插值算法、基于深度學習的SRCNN算法與本文基于參考的超分辨率算法進行了比較,效果如圖4所示。可知,本文算法在細節與紋理上都有較好的表現,只有IRefSR可以正確重建膝關節上的紋理,對比其他算法圖像線條更加清晰,且與現有方法相比,在重建圖像細節上的表現更加精確。本文采用兩個常用的圖像質量指標來評估模型性能,分別是峰值信噪比(Peak Signal-to-Noise Ratio,PSNR)與結構相似度(Structural Similarity, SSIM)。選擇這兩種比較方法是為了對重建結果進行互補評估。PSNR是基于誤差敏感的圖像質量評價,強調整體重建精度,SSIM強調圖像質量的感知。

由表1可知,相較于Bicubic和SRCNN兩種算法,IRefSR在測試集上可得到更高的PSNR與SSIM值。證明IRefSR在膝關節MRI超分辨率圖像重建上具有更好的性能,適用于膝關節MRI超分辨率重建任務。

4 結論

本文提出了一種IRefSR算法,能夠根據紋理相似性自適應地從參考圖像遷移紋理來豐富低分辨率圖像的細節。在膝關節MRI數據集上進行訓練并與雙三次插值算法、SRCNN算法進行對比得到紋理細節更加豐富的重建圖像,證明了IRefSR算法在膝關節MRI重建方面的應用價值,患者的安全性也將隨著圖像質量的提高而提高。

參考文獻

[1]MAXIM Z, JULIAN M, MICHAEL H. Motion artifacts in MRI: A complex problem with many partial solutions[J]. Journal of Magnetic Resonance Imaging, 2015, 42(4):887-901.

[2]WANG Z, LIU D, YANG J, et al. Deep networks for image Super-Resolution with sparse prior[C]//2015 IEEE International Conference on Computer Vision (ICCV), Santiago, 2016: 370-378.

[3]WEI W, FENG G, ZHANG D, et al. Accurate single image super-resolution using cascading dense connections[J]. Electronics Letters, 2015, 55(13): 739-742.

[4]HONG X, ZAN Y, WANG W, et al. Enhancing the image quality via transferred deep residual learning of coarse PET sinograms[J]. IEEE Transactions on Medical Imaging, 2018, 37(10):2322-2332.

[5]劉世豪,李軍.基于改進的深度卷積神經網絡的單圖像超分辨率重建[J].青島大學學報(自然科學版),2019,32(1):106-111.

[6]DONG C, LOY C C, TANG X. Accelerating the Super-Resolution convolutional neural network[C]// 14th European Conference on Computer Vision. Amsterdam: Springer International Publishing. Amsterdam, 2016: 391-407.

[7]YUE H, SUN X, MEMBER S, et al. Landmark image Super-Resolution by retrieving Web images[J]. IEEE Transactions on Image Processing, 2013, 22(12):4865-4878.

[8]WALLS T J, LIKHAREY K K. Self-organization in autonomous, recurrent, firing-rate crossnets with quasi-hebbian plasticity[J]. IEEE Transactions on Neural Networks and Learning Systems, 2013, 25(4):819-824.

[9]LIU W, LIU X, JI J, et al. Sound texture generative model guided by a lossless Mel-frequency convolutional neural network[J]. IEEE Access, 2018, 6:48030-48041.

[10] SUN L B, HAYS J. Super-resolution from internet-scale scene matching[C]// 2012 IEEE International Conference on Computational Photography. Seattle, 2012:1-12.

[11] NARANJO J, PERES S, MARTIN I, et al. A comparative analysis of residual block alternatives for End-to-End audio classification[J]. IEEE Access, 2020, 8:188875-188882.

[12] CHEN W, LIU Y, YAN Y, et al. Guided dual networks for single image Super-Resolution[J]. IEEE Access, 2020, 8:93608-93620.

[13] SHI W, CABALLERO J, FERENC H, et al. Real-time single image and video Super-resolution using an efficient Sub-pixel convolutional neural network[C]// 2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Seattle, 2016: 1874-1883.

[14] HO S, QU Y, GAO L X, et al. Generative adversarial nets enhanced continual data release using differential privacy[C]// Algorithms and Architectures for Parallel Processing-19th International Conference. New York, 2019: 418-426.

[15] CHEN L, HU X, ZHANG Z. Face aging with boundary equilibrium conditional autoencoder[J]. IEEE Access, 2018, 6:54834-54843.

[16] ZHU H, LEUNG R, HONG M. Shadow compensation for synthetic aperture radar target classification by dual parallel generative adversarial network[J]. IEEE Sensors Letters. 2020, 4(8):1-4.

[17] 姜玉寧, 李勁華, 趙俊莉. 生成式對抗網絡模型研究[J]. 青島大學學報(自然科學版), 2019, 32(3):31-38,43.

[18] ISHAAN G, FARUK A, ARJOVSKY M, et al. Improved training of wasserstein GANs[C]// Advances in Neural Information Processing Systems 30-Proceedings of the 2017 Conference. New York, 2017: 5768-5778.

[19] FAN B. A performance evaluation of local features for image-based 3D reconstruction[J]. IEEE Transactions on Image Processing, 2019, 28(10):4774-4789.

[20] FAN J. HD-MTL: Hierarchical deep multi-task learning for large-scale visual recognition[J]. IEEE Transactions on Image Processing, 2017, 26(4):1923-1938.