基于自然語言處理的評教文本分類與分析

陳國心

(西安航空學院 理學院,西安 710077)

0 引言

教育的本質就是一個教與學的過程,是將前人的知識、經驗、思維與行為方式等進行傳承的過程。顯然,教育是一個巨大而復雜的系統,涉及到教學、管理、科研、服務等諸多行業[1]。教育與其他具有清晰、規范的業務流程的領域(如金融、制造業等)明顯不同之處在于不同地區、不同學校、不同家庭環境、甚至不同學生和老師都具有差異性。

伴隨著科技的發展,教育的方式呈現多樣化。除了傳統課堂的以教師為主導、統一教學進度和教學目標的面對面講授方式外,包括MOOC、EDX等在內的臺各式各樣的教育學習平臺也在不斷涌現。這些教育學習平臺的出現將接受教育的主體變為學習者,且學習者可以依據自身的理解力和興趣愛好選擇學習的內容,由被動式學習轉化為主動式學習。

由于線上教學方式可以部分彌補傳統教育的不足,很多高校都已建立自己的在線學習平臺,并將部分傳統教育環節轉移到了線上。而與線上平臺的建立應運而生的,是線上教學過程中所產生的海量教育數據,如何有效地利用這些數據改善教師教學質量是當下面對的挑戰之一。

在以美、英、法等國為代表的發達國家都將大數據作為新型戰略資源[2]。我國也在加速部署教育大數據戰略計劃[3-4]。教育大數據可將曾經不被重視或無法收集的數據進行收集、存儲和分析[5],這是實現教學方式改革的關鍵支撐,是實現教學過程量化的重要參考指標,也是實現個性化教育的有力保障,更是最終實現教學過程可量化、教學決策個性化、教學模式定制化、教學管理可視化的重大教學改革。

依靠大數據技術的發展和信息化技術的普及,達到通過量化教學過程來驅動教學的目的,一方面能夠緩解當前教育資源分配不均衡的問題,另一方面,分析教學過程中產生的數據,能夠不斷提升教師的教學質量,并使學生的學習更具個性化,為教學發展起到重要推進作用,數據驅動教學結構框架如圖1所示。

圖1 數據驅動教學結構框架

目前,無論是線上還是線下教育,普遍采用的是一對多的模式,即一個老師對應多個學生。在這種模式下,不同性別、不同學科背景的學生在學習習慣上普遍存在差異,教師有限的精力無法一對一地了解每個學生的學習習慣和學習偏好。不過,在這種情況下學生對教師的教學評價(以下簡稱評教)數據是學生對教師教學過程給予反饋的重要方式,因此評教是了解學生狀況、關注學生差異、獲得學生反饋信息、提升教學效果的重要途徑。

盡管如此,由于學生基數大,且水平參差不齊,因此學生評教內容存在主觀性和隨意性,導致對評教結果的判定多以統計評分為主而忽略了學生評教的文本內容。這會導致教師無法詳細客觀地了解學生的評教意見,無法及時改進教學方式,不利于提高教學質量。目前,國內對學生教學評價以評教系統設計或針對教學評價的情感分析為主,而對評教內容研究的還比較少。本文利用自然語言處理(NLP)的BERT模型,通過文本分類、機器學習、可視化分析等方法,對學生評教數據中的自然語言描述部分進行分類,分析學生學習過程中重點關注的教學環節,為教師改進教學過程提供參考依據。

1 自然語言處理

自然語言處理是計算機科學和人工智能的研究領域之一,通常將自然語言轉換成計算機能夠用于理解這個世界的數據或用于生成能夠體現這種理解的自然語言文本[6]。

1.1 Transformer模型

Transformer模型是Google于2017年提出的用于機器翻譯的經典NLP模型[7],該模型由編碼器(Encoder)和解碼器(Decoder)兩部分組成,每個編碼器和解碼器中都包含六個區塊。

首先,由句子中每個單詞的詞嵌入值和位置嵌入值共同構成單詞的表向量矩陣X(n×d),其中:n是句子中單詞個數;d表示向量維度。其次,將X傳入編碼器中,經過六個編碼塊得到句子所有單詞的編碼信息矩陣C。最后,編碼器將輸出的編碼矩陣傳遞到解碼器中,解碼器會在翻譯第i個單詞時,掩蓋住i+1之后的單詞,根據已翻譯的前i-1個單詞翻譯第i個單詞。

與傳統的機器翻譯模型不同,Transformer模型在構建編碼器和解碼器的時候使用了多頭自注意力機制,使得Transformer模型可以忽略兩個詞在句子中的距離關系,只進行常數計算即可[8],并且Transformer模型在實現速度性能最優的情況下,也是效果最佳的模型。由于Transformer模型具有上述優點,使得其在細節化的語義推理方面取得了不錯的成績[9],在情感分析方面任務上具備優勢。

1.2 BERT模型

Google在2018年推出基于Transfomer結構的深度雙向編碼表征BERT模型,它通過聯合調節所有層中的雙向Transformer模型來訓練預訓練深度雙向表示[10]。

由于NLP是以單個句子為輸入單位,可能出現相同詞語在不同語句表達不同含義的情況。BERT模型創新性地使用了標記語言模型(MLM)和后續內容預測(NSP)兩種無監督預測任務模型,其中:MLM從輸入中隨機掩蓋一些詞語,目標是基于其下文預測被掩蓋的單詞的原始詞匯;而NSP在MLM的基礎上,隨機將數據劃分為等大小的兩部分,分別是數據中上下文連續的語句對和上下文不連續的語句對,然后使用Transformer模型識別語句對是否連續。這可使BERT模型中的詞向量表征融入到前后左右的上下文語義中,因此BERT訓練后的詞向量效果更好,具有更強的通用性。

2 數據預處理與預訓練模型

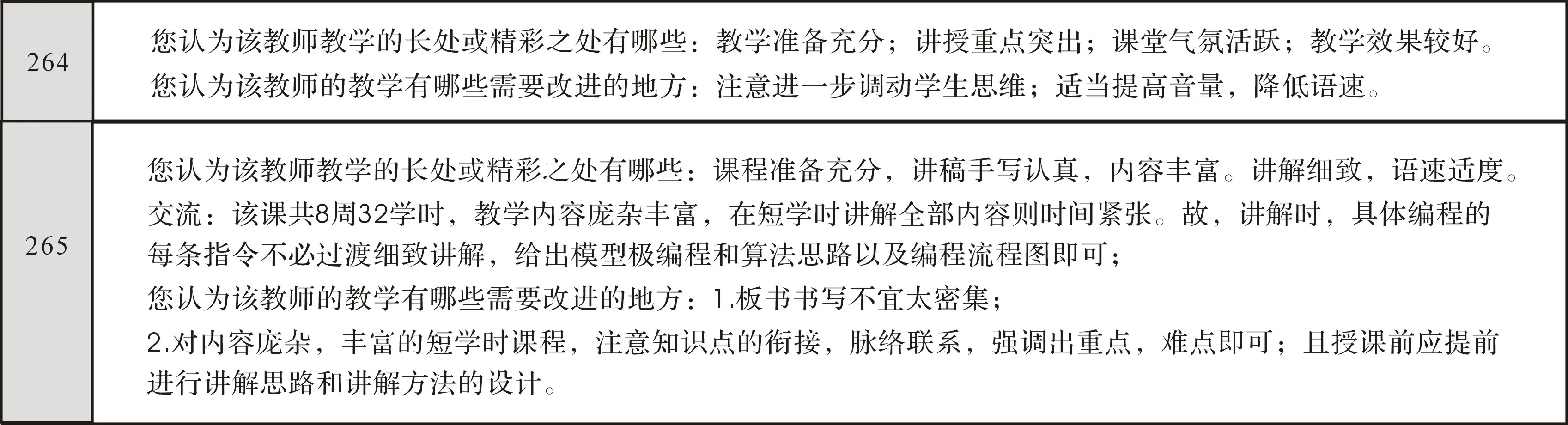

為了對數據進行預處理和預訓練模型,以某高校某門課程的學生評教文本數據為例進行分析。該文本數據共有評論數265條,主要針對教師教學過程中的優點及不足兩方面進行評價,其中部分文本內容如圖2所示。

圖2 學生評教部分文本數據

2.1 數據預處理

數據預處理之前要進行數據質量分析,其主要目的就是檢查原始數據中是否存在“臟數據”。“臟數據”主要包括缺失值、異常值、不一致的值和重復數據。由于數據分析的對象是文本數據,在數據質量分析方面的“臟數據”只有缺失值。經過數據質量分析后剩余246條無缺失值數據為有效數據。

由于評教文本數據完全由自然語言描述,格式比較隨意,不具備嚴格的語法規范,因此需要對評教數據按照預訓練模型的文本格式要求進行預處理。處理流程為:先將有效的評教數據以句為單位進行拆分,獲取評論描述764條;接下來對每條評論描述創建歸一化標簽。歸一化標簽是將評教相似內容聚合為5個維度,包括語言、備課、互動、作業評講、課堂管理,如表1所示。

表1 歸一化標簽及其對應的評教描述內容

通過上述處理所得部分最終數據預處理結果如圖3所示。

圖3 數據預處理效果圖

2.2 預訓練語言模型

預訓練屬于遷移學習的范疇,預訓練語言模型是在大規模文本中訓練出通用的語言表示[11]。此外,預訓練語言模型可以提供更好的模型初始化,帶來更好的泛化性并加快目標任務的收斂速度,避免對小數據的過度擬合[12]。

由于BERT的訓練本身需要大量GPU資源和高質量數據[13],因此可用第三方訓練至收斂的BERT預訓練模型。中文預訓練語言模型包括BERT-wwm-base-qa、bert-base-chinese、chinese-bert-wwm-ext等。本文預訓練語言模型利用的是HuggingFace項目中的bert-base-chinese預訓練模型,該模型有Pytorch與TensorFlow兩個版本,文中利用的是TensorFlow版。

2.3 模型微調

BERT訓練分為二段式,先使用大量無監督文本訓練基礎模型,而后只需要在下有任務的特定數據集上微調,即可獲得SOTA性能[14]。

設置隨機種子對數據進行隨機排列,將預處理后的評教數據集隨機分為訓練集與測試集,比例為8∶2。調用預訓練模型,模型主要參數包括max_length(文本最大長度)、batch_size(單詞訓練選取樣本數)、learning_rate(學習率)和樣本訓練次數(Epoch)。設置max_length=32,batch_size=46,learn_rate=5e-5及epochs=6,為避免單次預測中的隨機值,對模型循環運行6次,獲得每次運行的測試集分類正確率分布散點圖,結果如圖4所示。由圖4可見,隨著模型運行次數的增加,測試集正確率不斷提高,且提高的幅度逐漸減弱并趨于收斂。

圖4 測試集分類正確率分布散點圖

3 分析與結論

通過前述將訓練集與測試集分類正確率取均值可發現,測試集正確率會隨著訓練集正確率的提高而提高,最終二者都趨于收斂,如圖5所示。分析所得的評教數據分類模型最終平均損失值與分類正確率平均值分別為0.543和0.857。由此可見,分析結果基本達到五個維度分類評價效果,驗證了方法的有效性。

圖5 正確率均值折線圖

對五個維度分類評教結果生成統計直方圖和餅狀圖,分別如圖6和圖7所示。由圖6和圖7可見,學生對備課環節的評論數達到382條,占總評論數的50%;對課堂管理相關的評論數為145條,占總評論數的19.0%;對語言與互動的評論數基本持平,各占總評論數的14.3%與13.2%;對作業評講方面的評論數最少,只有27條占評論總數的3.5%。

圖6 學生評教分類統計柱狀圖

圖7 學生評教分類統計餅狀圖

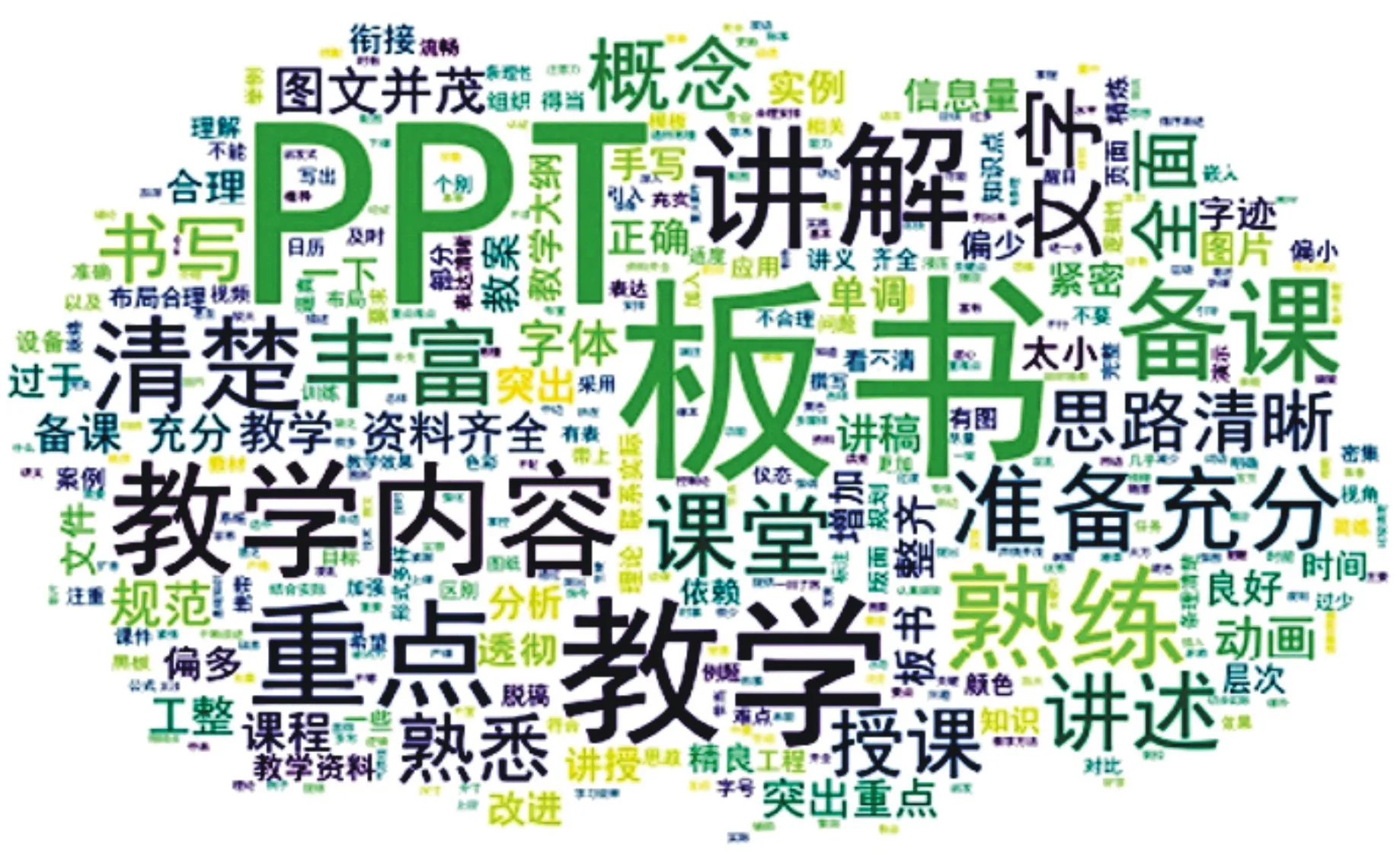

根據分析所得的備課相關的評論數據生成云圖,結果如圖8所示。由圖8可見,學生與備課相關的評教中對PPT、板書的評論最多,其次是對教學內容、重點內容的評論,再次是教學過程中講解是否清楚、思路是否清晰,而對于教學資料等項內容關注非常少。

圖8 備課評論云圖

4 結語

本文在教育現代化背景下,對BERT預訓練模型進行微調,實現某高校學生評教數據的分類。經過統計分析,判斷出學生在教師授課過程中的主要關注方向,為教師改善教學過程提供了理論依據,也為后續針對評教五個維度的情感正負性分析做好了研究基礎。具體分析結果表明:

(1)學生對本課程授課過程中的教師備課環節最為關注,而備課環節中,對PPT、板書類教學介質的關注度最高。因此,在后期教學過程中,教師應當更加重視本課程教學介質的使用,優化PPT,注重板書的排版與設計。

(2)學生對作業評講環節關注度最低,證明該環節存在感較低,學生對該環節的重視度不夠。教師應在授課過程中適當提高講評環節的時間占比,提高學生對作業講評的重視程度。