融合聚類算法與YOLO-v3 網絡在果蔬種植防蟲害中的應用研究

武 珊

(青海高等職業技術學院,青海 海東 810600)

在農業信息化技術不斷發展的當下,果蔬的蟲害防治依舊面臨害蟲檢測效率低下的問題,同時也導致了農藥智能噴灑精度低的狀況。果蔬種植的蟲害防治不僅要依靠田間實地調查,同時也需要依靠機器學習算法來提高效率、節約資源[1]。YOLO神經網絡檢測算法一經提出,便被國內外學者不斷地發展和完善,在目標檢測場景中,應用效果越發突出[2]。而ISODATA聚類分析方法增加了對聚類結果的“合并”和“分裂”操作,避免了K-means算法隨機K值的缺陷[3]。筆者將兩者融合,應用于果蔬種植的蟲害檢測識別中,旨在提高蟲害檢測的效率和精度,從而減少農業生產中的資源浪費。

1 文獻綜述

針對智能交通檢測圖像中小目標檢測率低的問題,楊飛等[4]提出了一種YOLO-v3的改進方法,并通過SPP模塊實現了局部特征和全局特征的融合提取,試驗結果表明:改進后的YOLO-v3算法能有效地檢測小目標,對小目標的平均準確率具有顯著的提升。同樣,基于智能交通圖像中小目標檢測問題,黃開啟等[5]則對YOLO-v3的Darknet-53網絡結構進行了優化調整,結果表明:改進算法在小目標檢測中的平均準確率為78.8%,取得了較好的小目標檢測效果。王霏等[6]則提出了基于改進YOLO-v3算法的文本檢測方法,用于改善深度學習中文本檢測算法存在的運行速度慢、模型體積大等問題,結果表明:該改進算法精度比YOLO-v3提高了7個百分點,檢測速度最高可達22幀/s,與同類算法相比,具有更快的檢測速度和更小的模型體積。于博文等[7]則將改進的YOLO-v3算法應用于軍事目標檢測中,在軍事目標圖像數據集中測試結果表明:該算法具有較好的檢測性能,可為戰場態勢生成、分析提供有效的輔助技術支持。在垃圾分類方面,王子鵬等[8]引入MobileNetv3網絡替代YOLO-v3的主干網絡Darknet53,試驗表明:該算法能夠滿足邊緣計算設備的要求,具備潛在的商業應用價值。屈文謙等[9]提出了基于YOLO-v3的電網作業現場安全帽佩戴檢測算法,有效檢測電網作業人員不規范佩戴安全帽行為,結果表明:算法在復雜作業場景下能夠實現有效的檢測,可為避免電網作業人員安全隱患提供技術參考。劉寅[10]融合K-means聚類算法和YOLO-v3網絡,用于教室內的人物目標識別場景,試驗表明:改進后的YOLO-v3網絡模型的識別精度提高了19.11%,但識別速度有所下降。在信息化控制領域,朱江等[11]提出了一種基于YOLO-v3的端到端的抓取檢測方法,應用于機器人抓取系統的檢測模塊,試驗表明:基于YOLO-v3的抓取檢測算法可以有效地提高檢測的精度和速度。陳耀祖等[12]使用模糊ISODATA動態聚類算法,對YOLO-v4網絡的先驗框數目進行優化,該方法應用于智能交通的行駛車輛的要素檢測時,訓練集中的類間平均準確率為98.56%,檢測幀頻為41.43幀/s。ISODATA聚類算法同樣被王磊等[13]應用于地理信息檢測領域,試驗表明:該模型滿足洪水變化監測的需求,可用于洪水易發區的洪澇災害災情分析。

在農業果蔬種植中的蟲害防治方面,張建[14]因地制宜地分析了不同區域的蘋果樹常見病蟲害,同時,分析了其對應的治理技術。國內學者薄曉華[15]分析了林業技術對治理林業病蟲害的作用,期望通過減少了林業病蟲害,達到保護生態環境的目的。類成敏等[16]提出了一種基于多尺度注意力殘差網絡的桃樹害蟲圖像識別模型,試驗表明:該模型識別準確率為93.27%,取得了較好的識別效果。姚青等[17]提出了基于雙線性注意力網絡的農業燈誘害蟲細粒度圖像識別模型,試驗表明:基于雙線性注意力網絡的農業燈誘害蟲細粒度圖像識別模型,可以自動識別6類相似的19種農業燈誘害蟲,提高了農業燈誘害蟲自動識別的準確率。劉迦南等[18]將LIBSVM工具應用于害蟲性別判別中,結果表明:利用該方法可以對害蟲性別作出有效判別。

綜上所述,國內學者在應對農業和林業領域的病蟲時,不僅通過地域信息與氣候信息的整合,也利用了深度學習、機器學習算法,如SVM和雙線性特征提取等前沿技術。本研究也從基于CNN網絡的位置回歸算法YOLO中探索了提高果蔬害蟲識別精度的模型。YOLO-v3網絡在國內學者的探索開發中已然趨于成熟,在智能角度、電氣工程和軍事檢測中均有應用。本研究也通過融合ISODATA聚類算法和YOLO網絡檢測技術識別果蔬害蟲,期望為果蔬的蟲害防治和檢測提供科學識別模型的支持。

2 果蔬種植防蟲害的YOLO-v3目標檢測模型的構建

2.1 YOLO-v3網絡的圖像數據提取

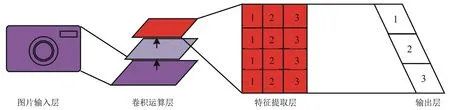

在計算機硬件條件落后的前幾十年,傳統的目標檢測算法通常利用圖像HOG特征提取與分類器算法決策完成。隨著計算機技術和算力資源的不斷發展,圖像特征提取的方法從人工經驗構建發展為了HOG算法提取,再發展到現在常用的卷積神經網絡(Convolutional Neural Network, CNN)識別[19]。在目標檢測算法更新的過程中,圖像識別的精度和計算效率也不斷提高。雷世威等[20]構建的YOLO-v3(You Only Look Once-v3)果蔬蟲害目標檢測原理是基于卷積神經網絡的深度學習回歸。單一的CNN網絡隨著圖像數據量的增加會出現梯度消失的問題,導致識別分類精度下降。因此,研究引入YOLO-v3方法主要是通過其殘差網絡結構避免CNN模型損失值居高不下的震蕩狀態。CNN網絡在圖像目標檢測中的應用結構如圖1所示。

由圖1可以看出,卷積神經網絡在圖像目標識別中的卷積層的運算為核心模塊,包括了卷積運算、池化運算以及激勵函數運算3個數據處理層。其余結構部分包括圖像數據預處理的圖片輸入層和結果輸出層。本次研究應用到的激勵函數計算表達公式如式(1)所示。

圖1 CNN網絡在圖像目標檢測中的應用結構

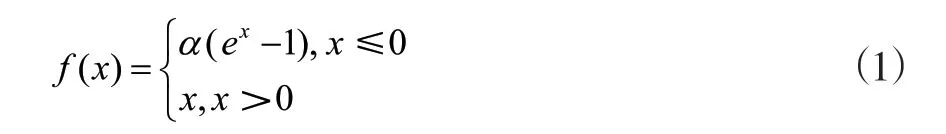

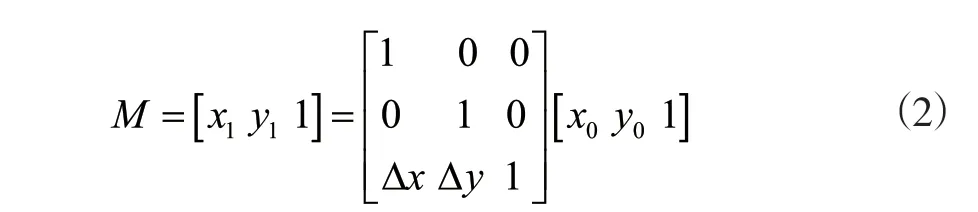

式(1)為卷積神經網絡的ELU激勵函數,其中α表示修正數據分布的常數。CNN網絡中的卷積運算首先需要對果蔬的病蟲害圖像進行預處理。研究針對果蔬蟲害構建圖像數據集,首先通過平移圖像擴充數據量,增加CNN模型的運算精度,其圖像在平移操作之后的矩陣表述如式(2)所示。

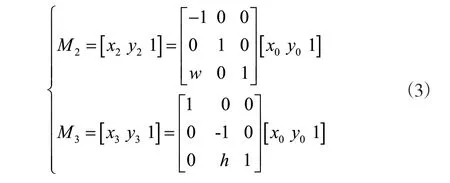

式(2)中,M表示平移后的圖像矩陣模型。(x0,y0)表示原圖像的像素位置,(x1,y1)表示平移后的圖像像素位置。△x和△y分別表示圖像在橫從坐標上的移動量。此外,通過對圖像的水平翻轉和垂直翻轉同樣可以擴充圖像數據量,其矩陣模型表述如式(3)所示。

式(3)中,M2和M3分別表示圖像水平翻轉和垂直翻轉之后的圖像矩陣模型。(x2,y2)和(x3,y3)分別表示圖像水平翻轉和垂直翻轉之后的像素點位置,w和h分別表示圖像的寬度和高度。針對網絡爬取的蟲害圖像數據集的缺點,為了準確地檢測果蔬害蟲,研究采用非整體標注方法平衡蟲害的整體像素,避免害蟲在圖像中像素點的分布不均而導致的農藥噴灑定位精度下降,其中,用于檢測圖像像素點比例的有效像素比(Effective Pixel Proportion, EPP)的計算公式如式(4)所示。

式(4)中,SO和SM分別表示有效像素數和圖像最大像素數。

2.2 基于聚類算法的YOLO-v3特征提取網絡識別優化方法

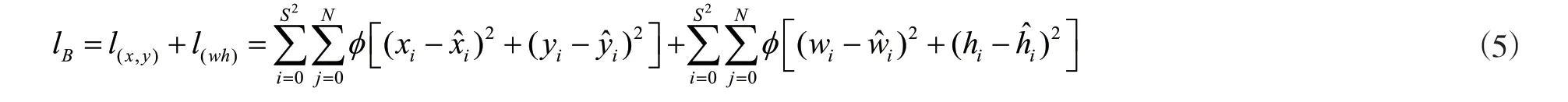

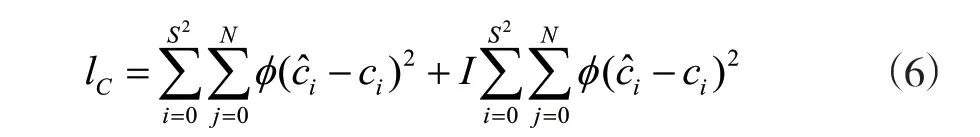

卷積神經網絡在應用于果蔬的蟲害識別時,輸出結果并非傳統分類的最大概率顯示,而是通過計算得出害蟲屬于哪種分類。作為在CNN網絡回歸中應用最廣泛的方法之一,Darknet-53是YOLO-v3模型的核心結構[21]。由于模型將要利用不同的特征提取尺度獲得圖像的特征信息,因此,首先需要對圖像進行柵格化處理。通過算法的位置回歸計算得出害蟲所在的柵格塊位置,并引入傳統RCNN網絡中的提取預選框方法(Region Proposal Network, RPN)分辨出檢測柵格塊的害蟲目標個數[22]。YOLO-v3模型的損失函數包括了像素點位置的損失、圖像高寬值的損失、置信度的損失以及分類類別的損失。模型的邊界框位置損失函數由像素點位置的損失、圖像高寬值的損失組成,其表述如式(5)所示。

式(5)中,lB為邊界框位置損失函數,l(x,y)為像素點位置的損失,l(wh)表示圖像高寬值的損失。i和j分別表示柵格預測的編號和預測網格邊界框的編號。S2表示圖像的柵格總數,N表示單個網格的預測邊界框數量。(xi,yi)為預測邊界框的中心點位置,(則表示實際的邊界框中心點位置。式中的 權重參數等于1時,表示待檢測網格中確有害蟲目標,否則權重為0.1。同時,模型的置信度損失數學表述如式(6)所示。

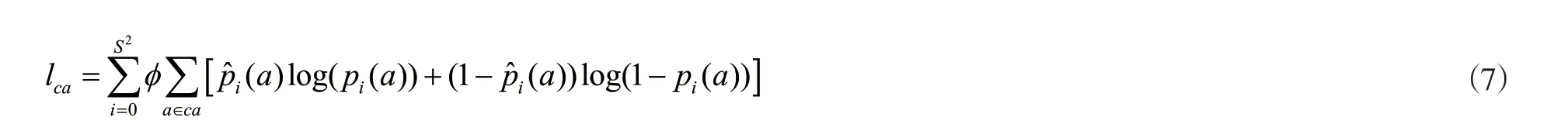

式(6)中,lC表示模型的置信度損失,^ic表示實際檢測目標的置信度,ci表示預測目標的置信度。I表示檢測單元格內沒有損失的參數,權重參數為1時,表示待檢測網格中沒有害蟲目標,否則權重為0。最后,模型的類別損失數學表述為式(7)。

式(7)中,lca表示模型的類別損失,a表示類別,pi(a)表示第i個柵格中的檢測目標屬于類別a的預測概率,^ ( )ip a則表示第i個柵格中的檢測目標屬于類別a的實際概率。研究采用啟發式的迭代自組織聚類算法(Iterative self-organizing clustering algorithm, ISODATA)獲取anchor boxs。設定K0個初始聚類中心,其合集表示為Z={z1,z2,…,zK0},設定初始聚類中心之后,計算樣本與各聚類中心的距離,距離最小時,表明樣本屬于該聚類,即:

式(8)中,Dx表示樣本x與初始聚類中心zi的距離值最小。樣本根據初始分類完成之后,判斷聚類的樣本數量,如果數量小于最小該聚類域的最小樣本數量,則取消該聚類,令K=K-1,并重新計算聚類中心距離進行分配。分配完成之后計算所用聚類樣本的中心點,修改聚類中心,其公式用式(9)表示。

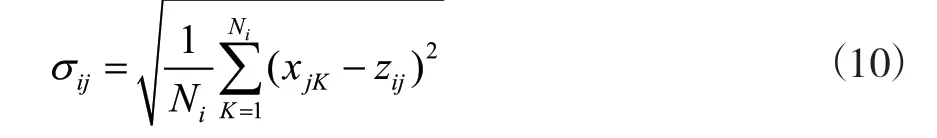

式(9)中,Ni表示聚類zi中的所用樣本數量。重新確定聚類中心之后,判斷分裂與合并操作,即K ≤K0/2時,進行分裂操作;K>K0/2時,進行合并操作。合并操作的思路為計算聚類中心的距離,將最小距離的2個聚類合并為1個聚類,并使K=K-1。分裂操作需要求得每個聚類中樣本距離的標準差向量,表示為σi=(σ1i,σ2i, …,σni)T,其中每個向量的分量計算公式如式(10)所示。

式(10)中,σij表示聚類zi內樣本到聚類中心的標準差向量分量,Ni表示聚類zi中的所用樣本數量,j表示樣本的特征向量的維數。求得標準差向量之后取最大值,當最大值大于聚類域中的樣本標準差時,則將聚類zi分裂為2個聚類,并令K=K+1。分裂完成之后,重新將聚類中心設定為初始聚類進行迭代,直到達到最大迭代次數。

由于研究的蟲害樣本數據集來源于網絡爬取,圖像的寬高和大小均不統一,影響CNN卷積網絡的圖像輸入。出于兼顧模型全局特征提取和局部特征提取的目的,研究在YOLO-v3的卷積層中加入空間金字塔池化(Space Pyramid Pooling, SPP)結構。空間金字塔池化可以有效提升特征的表達能力,同時產生固定的特征向量。空間金字塔池化結構如圖2所示。

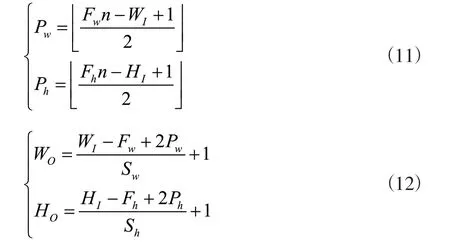

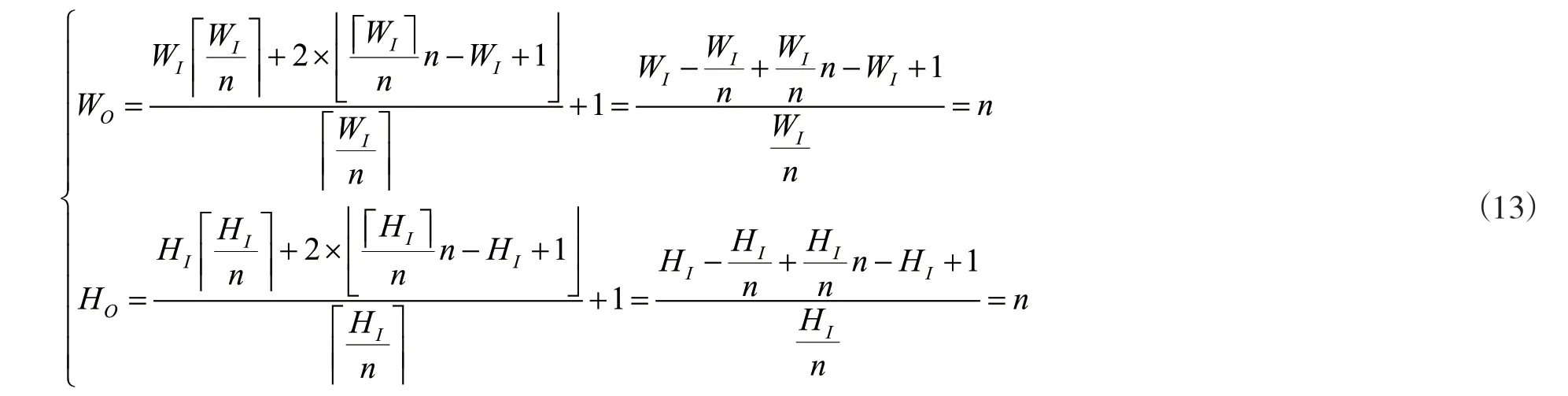

假設輸入圖像的大小為WI×HI×CI,分別表示圖像的寬、高以及通道數。輸出圖像大小為n×n× Co,分別表示池化數量和輸出通道數。根據以上參數,計算池化層核心大小為池化層步長為同時,池化層的Padding計算公式如式(11)所示。

得出卷積網絡池化層的參數則可以得出輸出圖像的大小,其寬、高表述如式(12)所示。

式(12)中,WO和HO表示輸出圖像的寬和高。最后,將輸入圖像的大小參數,分別代入輸出圖像

大小的計算公式,可以得出以下數學表述。

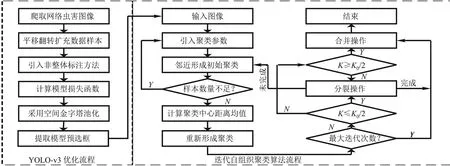

如式(13)所示,可以得出WO=n,HO=n,表明空間金字塔池化結構接受輸入圖像的不同大小。根據以上YOLO-v3融合迭代自組織聚類算法的果蔬蟲害圖像聚類識別,將模型的流程結構用圖3表示。

圖3 融合迭代自組織聚類與YOLO-v3網絡的蟲害圖像識別模型優化流程

如圖3所示,研究所構建的YOLO-v3蟲害識別模型在圖像預處理階段,通過平移翻轉圖像解決了數據集樣本數量較少的問題。在圖像特征提取階段采用了非整體標注方法,用于分辨檢測柵格塊的害蟲目標個數。在卷積層池化階段,引入了空間金字塔池化結構,解決了網絡爬取圖像大小尺寸不統一的問題。最后,在聚類階段選擇迭代自組織聚類算法,應對傳統K-Means算法的K值隨機性問題和對網絡爬取蟲害圖像數據樣本噪聲要求苛刻的問題。

3 改進YOLO-v3模型在果蔬蟲害檢測中的應用研究

3.1 YOLO-v3果蔬蟲害檢測模型的仿真訓練

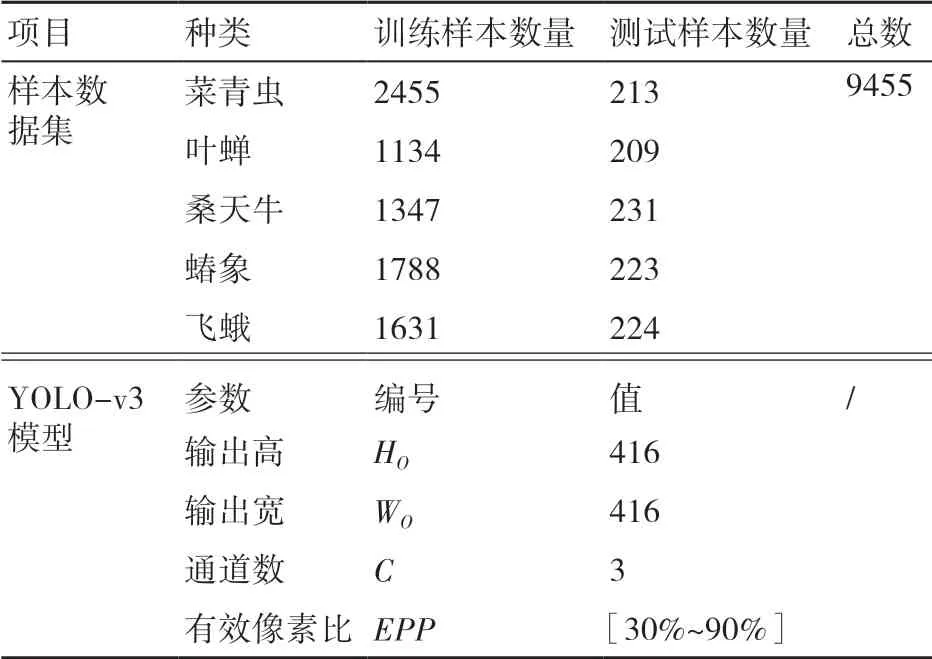

本次試驗的訓練數據集來源于網絡圖像爬取,圖像包括了夏、秋兩季常見的5種果蔬植物害蟲。害蟲圖像數據集共計9455個樣本,其中,1100個預留為測試樣本,其余8355個樣本劃分為訓練樣本。具體的果蔬害蟲圖像樣本見表1。

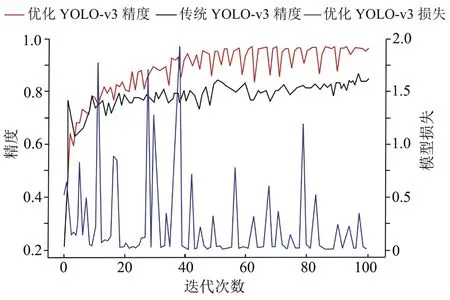

從表1中可以看出,本次用于仿真試驗的圖像數據集包括了菜青蟲、葉蟬、桑天牛、蝽象、飛蛾5種。仿真試驗主要應用的軟件平臺為PyCharm,設置仿真訓練的最大迭代次數為8000次,學習率為0.01,權重衰減為0.0005。將訓練完成的模型代入其余訓練樣本中,進行最大次數為100的仿真訓練,對比傳統YOLO-v3網絡模型與優化后YOLO-v3果蔬蟲害識別模型在訓練過程中的識別精度,具體如圖4所示。

圖4 傳統YOLO-v3網絡模型與優化YOLO-v3 的訓練結果

表1 圖像樣本數據集參數以及改進的YOLO-v3模型參數

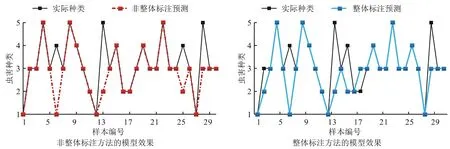

從圖4可以看出,優化后的YOLO-v3網絡模型與傳統模型在迭代次數超過40次之后,模型識別精度趨于平穩。優化后的模型的精度在0.8~0.9區間內浮動,而傳統的YOLO-v3則在0.7~0.8的精度值區間內變化。同時,本次試驗的優化模型的損失值在迭代次數超過40次后,大部分變化均在0.00~0.75之間。完成模型的訓練之后,試驗將優化模型中的圖像非整體標注方法與傳統的整體標注方法對比,在測試樣本中隨機選擇30份圖像樣本,對比不同標注方法對模型識別性能的影響,具體測試結果如圖5所示。

圖5 不同標注方法下YOLO-v3模型的害蟲識別性能

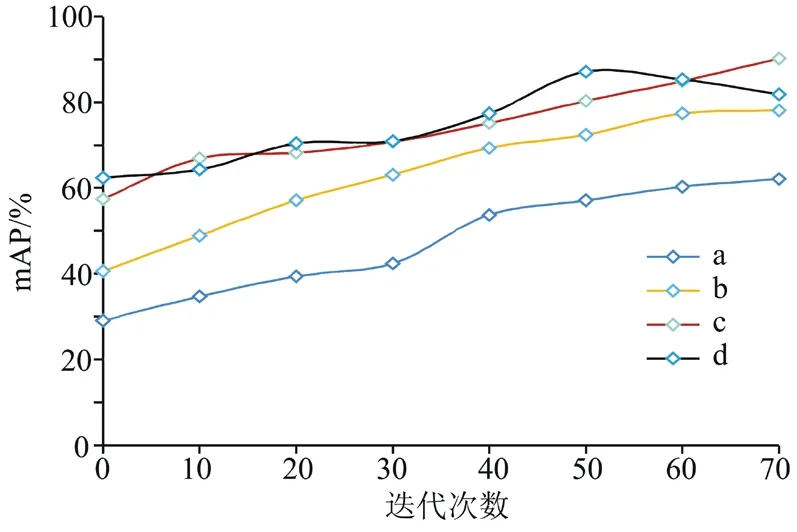

圖5 中縱軸的1~5分別表示菜青蟲、葉蟬、桑天牛、蝽象、飛蛾5種害蟲種類。從折線圖可以得知,本次30份樣本測試中,采用非整體標注方法優化YOLO-v3模型僅有3處識別錯誤,識別準確率為90%;而采用整體標注方法的YOLO-v3模型共出現了6處識別失誤,識別準確率為80%。試驗表明:YOLO-v3模型在處理圖像樣本時,采用非整體標注方法可以有效地保持模型的分類性能,非整體標注方法比整體標注方法更可靠。在確定了模型的圖像樣本處理方法之后,本次試驗將對有效像素比的數值選擇進行仿真測試,驗證有效像素比的取值對模型精度性能的影響。本次試驗的測試樣本從1100個樣本中隨機選取,有效像素比參數取值為30%、60%、80%、90%,分別在圖中以字母a、b、c、d表示,對比結果見圖6。

由圖6可以看出,在有效像素比值的不同取值情況下,模型的識別精度整體與迭代次數呈正相關。當測試樣本的迭代次數為70次時,模型的識別精度最高為采用80%比值的模型,其mAP為90.2%。其次為90% EPP值的YOLO-v3模型,模型的mAP為81.8%。而在60%和30%有效像素比值情況下,模型的最高精度分別為78.1%和62.1%,其值遠低于90%和80% EPP的情況,因此不作考慮。在圖6中,90% EPP的模型最高mAP出現在迭代次數為50次的時候,而在迭代次數大于50次時,模型的精度反而下降。表明在高像素比的情況下,模型的非整體標注圖像方法反而使模型損失了更多的圖像特征信息。本次試驗的最大訓練迭代次數超過了50次,因此研究的YOLO-v3模型的圖像有效像素比參數取值為80%。至此,模型的訓練和參數校對完成,以下試驗部分將對模型進行對比,參考不同信息的圖像,對模型的識別檢測性能進行全面分析。

圖6 不同有效像素比參數下YOLO-v3模型的害蟲識別性能

3.2 YOLO-v3果蔬蟲害檢測模型的性能測試

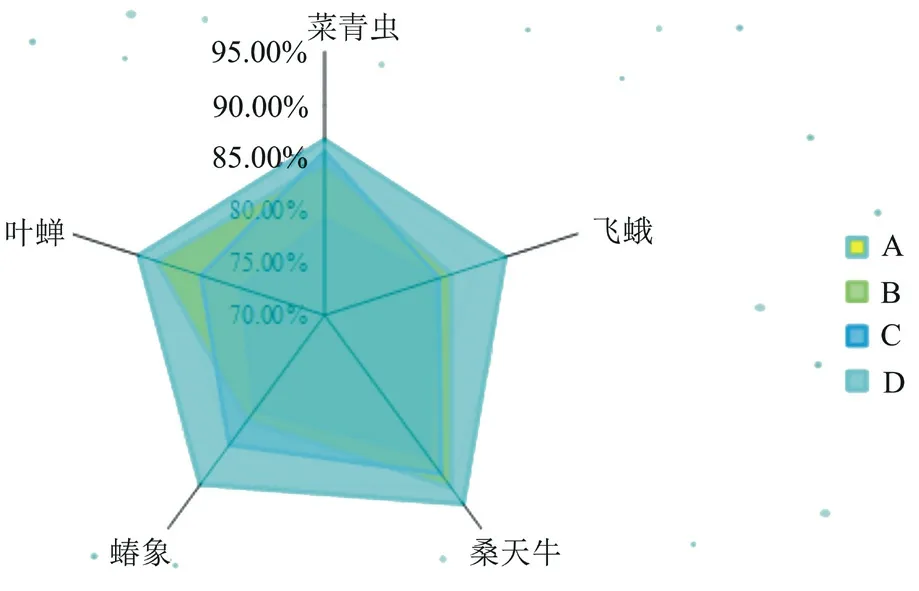

為了突出迭代自組織聚類算法和YOLO-v3網絡模型在果蔬害蟲識別檢測中的優越性能,試驗將1100份測試樣本數據全部代入Faster-RCNN、SSD-300、傳 統YOLO-v3和 優 化YOLO-v3模 型中,不同種類害蟲的識別精度情況如圖7所示。

圖7 不同種類害蟲的識別精度情況

從圖7可以看出,整體的識別精度上優化YOLO -v3優于其他算法。在菜青蟲的圖像識別中,優化YOLO-v3模型的識別率為86.6%,比Faster-RCNN模型高2.2個百分點,比SSD-300算法高7.5個百分點,比傳統YOLO-v3模型高1.1個百分點。而在飛蛾的識別中,優化YOLO-v3模型的識別率同樣最高,為87.8%。桑天牛圖像識別中,優化YOLO-v3模型的識別率為92.1%,比第2高的Faster-RCNN模型多出1.9個百分點。而在蝽象和葉蟬的圖像識別中,優化YOLO-v3模型的識別率為89.8%和88.3%。模型的蟲害綜合識別精度如表2所示。

表2 4種算法模型的綜合識別精度和識別速度情況

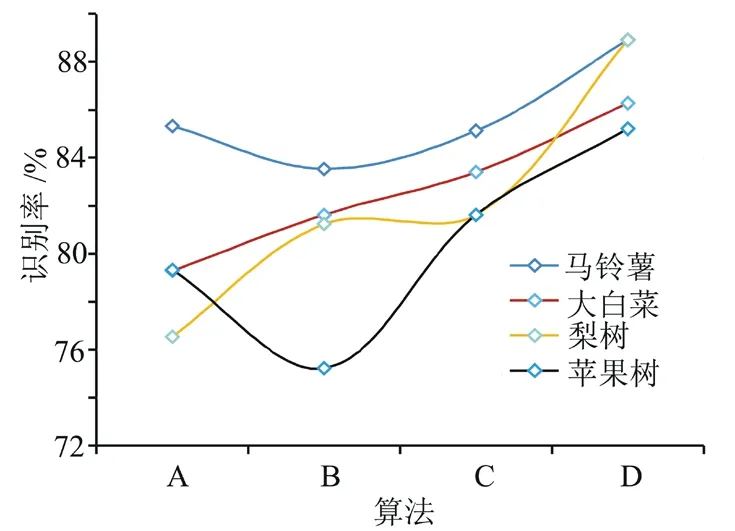

由表2可知,在綜合識別精度上,最高的算法模型為優化的YOLO-v3網絡,其mAP為88.92%,比Faster-RCNN高3.7個百分點。而在識別速度上,速度最快的為SSD-300,速度為41幀/s,其次為傳統YOLO-v3模型,速度為25幀/s。研究優化的YOLO-v3網絡在速度上僅比傳統YOLO-v3模型低4幀/s。試驗表明:模型在對比害蟲等小目標圖像內,精度性能優越。因此,試驗將對比不同模型在馬鈴薯、大白菜、梨樹以及蘋果樹圖像中的蟲害檢測效果,具體結果如圖8所示。

圖8 不同種類果蔬的蟲害識別精度情況

從圖8中可以看出,在馬鈴薯蟲害的圖像識別中,優化YOLO-v3模型的識別精度為88.91%。在大白菜蟲害的圖像識別中,優化YOLO-v3模型的識別精度為86.27%。在梨樹蟲害的圖像識別中,優化YOLO-v3模型的識別精度為88.91%。在蘋果樹蟲害的圖像識別中,優化YOLO-v3模型的識別精度為85.21%。在果蔬植物圖像背景的影響下,模型的綜合識別精度如表3所示。

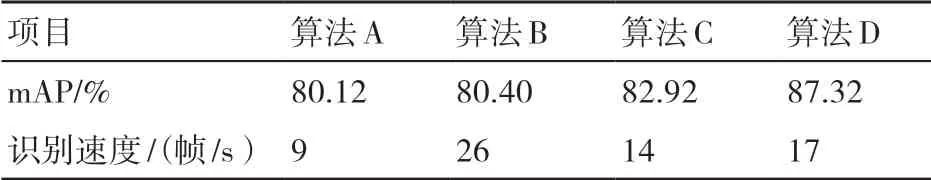

表3 4種算法模型的綜合識別精度和識別速度情況

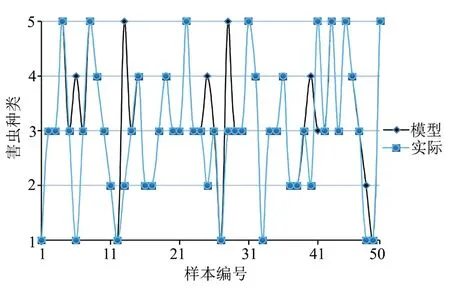

由表3可知,在綜合識別精度上,最高的算法模型為優化的YOLO-v3網絡,其mAP為87.32%,比傳統YOLO-v3模型高4.4個百分點。而在識別速度上,速度最快的為SSD-300,速度為26幀/s,其次為研究構建的優化YOLO-v3模型,速度為17幀/s。試驗表明:模型在對比果蔬植物背景的蟲害目標檢測中,精度、性能保持穩定。最后,試驗隨機從測試數據集中抽取50個樣本,測試模型的識別精度,具體見圖9。

圖9 優化YOLO-v3模型的識別測試

圖9中縱軸的1~5分別表示菜青蟲、葉蟬、桑天牛、蝽象、飛蛾5種害蟲種類。從折線圖可以得知,本次50份樣本測試中,識別正確的樣本共計45份,識別準確率為90%。

4 結論

出于確定模型參數并驗證模型性能的目的,研究在構建了蟲害圖像數據集后,經過仿真訓練和不同參數結果的測試試驗,確定了EPP參數為80%的同時,也驗證了非整體標注圖像處理方法的有效性。以害蟲種類和果蔬圖像背景為區分,研究進行了2次模型的識別精度和檢測速度對比。在害蟲種類識別的訓練中,優化的YOLO-v3網絡mAP為88.92%,比Faster-RCNN高3.7個百分點。而在果蔬圖像背景測試中,優化的YOLO-v3網絡mAP為87.32%,比傳統YOLO-v3模型高4.4個百分點。試驗表明:在不同的圖像目標分類中,研究構建的YOLO-v3模型比Faster-RCNN和傳統YOLO-v3網絡精度更高,測試性能更穩定。本次試驗的不足之處在于2次測試試驗的數據來源單一,缺乏實際數據樣本進行對比,模型的實際應用效果有待進一步確定。