VAE-Fuse:一種無監督的多聚焦融合模型

鄔開俊,梅 源

(蘭州交通大學 電子與信息工程學院,甘肅 蘭州 730070)

圖像融合是圖像處理的一個分支。其數據形式是包含有明暗、色彩、溫度、距離以及其他的景物特征的圖像[1]。多聚焦圖像融合作為多源圖像融合的一個重要分支,是解決成像系統聚焦范圍局限性問題的有效方法[2]。在諸如遙感、醫學影像、圖像去霧、顯微鏡等計算機視覺和計算機攝影領域具有重要的應用價值。

根據多聚焦圖像融合處理所處的階段,可將多聚焦圖像融合分為:像素級圖像融合、特征級圖像融合和決策級圖像融合3個層面[3]。其中,像素級圖像融合具有在融合過程中信息丟失少,能夠提供其他融合層次所不能提供的細節信息等優點,是當前圖像融合領域的熱門研究課題之一。在像素級圖像融合中,其融合方法可分為變換域、空間域以及變換域與空間域相結合和基于深度學習的融合方法[4]。其中,基于深度學習的圖像融合方法又可分為基于監督學習的圖像融合方法和基于無監督學習的圖像融合方法。文獻[5]將卷積神經網絡用于圖像融合,將多聚焦圖像融合問題視為一個基于監督學習的二分類問題,取得了突出效果。首先,采用高斯模糊對ILSVRC2012原始數據集進行堆疊模糊處理,形成不同模糊程度的圖像來模擬離焦圖像,并分別與原始圖像組成一組清晰-模糊圖像對。接著,隨機對每張原始圖像與模糊圖像組成的圖像對進行隨機選取圖像塊作為模型輸入,經過一個孿生卷積網絡和全連接層后進行圖像塊聚焦屬性的判斷,并生成初始權重圖。然后,通過數學形態學處理對初始權重圖進行優化處理并生成決策圖。最后,采用加權融合策略進行最終的圖像融合。該方法的提出引起了重視,陸續有許多同類融合方法被提出并取得了顯著成效。如采用VGG[6]和AlexNet[7]等預訓練模型替換孿生卷積網絡進行圖像融合。此類方法均是采用監督學習的方式進行圖像融合,但是采用監督學習策略卻有明顯的局限性。比如此類策略需要具有大量的圖像標注信息(在多聚焦圖像融合問題上即為具有全聚焦圖像作為參考圖像用于模型的梯度回傳),但是在實際問題中,往往缺乏標準的參考圖像,甚至缺乏用于特定問題的待融合圖像。考慮到基于監督學習進行圖像融合的局限性,文獻[8]提出了一種采用無監督學習策略進行圖像融合的方式——DeepFuse。DeepFuse采用端到端的方式進行圖像融合,且無需像其他圖像融合方法那樣需要手動設置復雜的融合策略,具有靈活、通用等特點[9]。但是由于DeepFuse是一種通用的圖像融合方法,所以在特定圖像融合問題上的效果欠佳。

為了在多聚焦圖像融合問題上取得更好的效果,文中結合變分自編碼器(Variational AutoEncoder,VAE)結構,設計出了一種新的多聚焦圖像融合框架,并與5種圖像融合算法(其中包括3種較新的且效果較好的基于無監督學習的圖像融合算法)相比,在多項評價指標上取得了最佳效果。

1 相關工作

采用無監督學習的方式進行圖像融合,DeepFuse具有舉足輕重的地位。DeepFuse是一種端到端的圖像融合框架,包括編碼、融合、解碼3個過程。在編碼部分延用了文獻[5]提出的基于CNN的圖像融合方法中的孿生卷積神經網絡結構;融合策略則采用簡單的Concat;解碼部分為普通的卷積神經網絡。有所不同的是,DeepFuse采用了更大卷積核去擴大感受野,并采用MEF SSIM作為損失函數進行無監督訓練。由于DeepFuse是一種通用圖像融合框架,所以在特定問題上的融合效果欠佳。在此之后,文獻[10]提出了DenseFuse。DenseFuse仍采用編碼器-解碼器結構,采用L2+SSIM作為損失函數進行模型訓練。在圖像融合時,仍先采用編碼器進行編碼,然后進行融合后再傳入解碼器進行輸出。與DeepFuse相比有所不同的是,DenseFuse編碼器采用DenseBlock結構進行構建,較好地保留了原始圖像信息,且在融合部分采用L1+norm策略進行特征圖的融合。此方法雖然在紅外線與可見光的融合上效果較好,但是由于多聚焦圖像與紅外線圖像具有顯著差異,故此方法在多聚焦圖像融合上的效果欠佳。文獻[11]提出了VIF-Net,用于紅外線與可見光的圖像融合方法,類似于DenseFuse結構。有所不同的是,VIF-Net在編碼時同時輸入紅外線圖像與可見光圖像,采用SSIM與TV損失相結合的方式作為損失函數進行訓練。但是此方法仍然不適用于多聚焦圖像融合,因為VIF-Net要求在訓練過程中具有全聚焦的參考圖像,然而目前并沒有標準的全聚焦參考圖像。文獻[12]提出了SESF-Fuse用于多聚焦圖像融合。SESF-Fuse也采用了DenseBlock模塊作為編碼器結構。與DenseFuse相比,較為不同的是,SESF-Fuse在圖像融合時首先采用空間頻率對編碼后的特征圖按通道進行清晰像素判別,生成初始決策圖,然后通過數學形態學處理和引導濾波優化后,直接根據決策圖進行加權圖像融合。在多聚焦圖像融合任務中,SESF-Fuse取得了先進的融合效果,但是并不能解決離焦擴散效應。此后,文獻[13]提出了FusionDN圖像融合統一模型。FusionDN是一種端到端的圖像融合模型,采用DenseBlock結構設計了更深的網絡結構。有所不同的是,FusionDN為了適用于不同的融合任務,引入了彈性權重損失。在損失函數設計方面,FusionDN引入了SSIM損失、感知損失、梯度損失及彈性權重損失。此外,FusionDN結合了原始圖像的質量及信息熵來設計每對原始圖像的權重參數。FusionDN相較于DeepFuse在多種圖像融合任務上取得了先進的融合性能。此后,文獻[14]對FusionDN進行了改進,并提出了U2Fusion。在U2Fusion中,仍采用了DenseBlock結構設計了一個深層的網絡結構,同時增加了對醫學圖像融合的考慮。相較于FusionDN,U2Fusion最大的不同就是在損失函數設計方面。U2Fusion采用了SSIM損失、MSE損失及彈性權重損失設計了損失函數。在圖像權重設計中,U2Fusion采用了VGG16網絡進行清晰像素判別,并使用梯度進行特征圖信息保留程度的評估過程。根據評估結果生成每對原始圖像的權重參數。實驗結果表明,U2Fusion在多項指標上取得了理想的融合效果。但是文中實驗發現,U2Fusion雖然在EI、CC、VIF和MG指標上的效果較好,但是卻在其他指標上的性能不夠好。觀察其差值圖也能發現其存在明顯缺陷。

為了進一步提升多聚焦圖像融合的質量,文中結合變分自編碼器(Variational AutoEncoder,VAE)結構,提出了一種輕量級的多聚焦圖像融合網絡;采用了更為淺層的網絡架構,對原始圖像進行編碼與解碼;結合圖像清晰度評價指標進行圖像聚焦屬性的區分。實驗結果表明,文中所提算法在多項指標上均優于所比較的5種具有代表性的圖像融合算法。

2 方 法

2.1 方法總覽

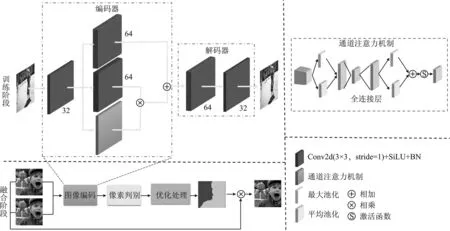

圖1展示了文中所提的整體融合架構。首先,在訓練階段采用編碼器-解碼器網絡結構來重建原始圖像信息;接著,當模型訓練結束后,采用編碼器部分的網絡生成待融合圖像的編碼后的特征圖;然后,在圖像融合階段采用改進的灰度方差乘積函數(SMD2)圖像清晰度評價函數,按通道對編碼后的特征圖進行圖像聚焦屬性的區分,并生成初始權重圖,通過數學形態學優化處理生成最終的決策圖;最后,根據決策圖采用加權融合策略生成最終的融合圖像,并對融合后的采用主觀和客觀評價方法進行融合效果分析。此外,還進行了算法比對和消融實驗,驗證了文中圖像融合方法的有效性。

圖1 圖像融合總體架構圖

2.2 模型架構

采用編碼器-解碼器網絡結構進行原始圖像的重建。編碼器部分結合了變分自編碼器結構,第1層進行普通卷積,第2層具有兩個不同的卷積層,它們之間不進行參數共享。在第2層中,采用經過通道注意力機制處理后的結果與一個卷積后的結果相乘,然后再與另外一個卷積后的結果相加。其中,通道注意力機制中采用了平均池化、最大池化和MLP處理。平均池化可以聚合空間信息,最大池化可以區別目標的特征信息。MLP則保證了在相同的語義嵌入空間中聚合通道特征[15]。文中編碼器結構的設計,通過自適應地校準通道響應或空間特征響應,可以有效地增強空間特征編碼。

此外,使用SiLU函數[16]作為網絡卷積層中的激活函數。通過實驗發現,采用SiLU函數作為激活函數的表現更佳。其計算方式為

SiLU(x)=xSigmoid(x) 。

(1)

2.3 損失函數

SSIM損失函數常用于基于無監督學習的圖像重構過程,考慮了亮度、對比度和結構指標。SSIM得到的結果會比L1、L2的結果更有細節。而MS-SSIM損失函數在SSIM的基礎上增加了多尺度信息,相當于考慮了分辨率。但是MS-SSIM損失函數容易導致亮度的改變和顏色的偏差,不過它能夠保留高頻信息(圖像的邊緣和細節)而LP損失函數能較好地保持亮度和顏色不變化[17]。此外,考慮到總偏差(Total Variation,TV)損失[11]能夠較好地實現梯度變換,且消除部分噪聲。最終確定的損失函數RLoss為

LLoss=1-(αLp+βLms-ssim+γLTV) ,

(2)

其中,Lms-ssim表示MS-SSIM損失;Lp表示Lp損失;LTV表示TV損失;α、β、γ表示各項損失函數的系數,α和β取值為1,γ取值為20。

Lp損失即為輸入與輸出之間的差值的L2范數,其計算公式為

Lp=‖O-I‖2。

(3)

MS-SSIM損失是一種對SSIM損失的多尺度改進版本,其計算公式如下:

(4)

(5)

(6)

TV損失的引入主要是為了實現梯度變換且減少噪聲的影響,其計算公式為

(7)

R(i,j)=Io(i,j)-IF(i,j) ,

(8)

其中,Io(x,y)和IF(x,y)分別表示原始圖像Io的第i行第j列的像素值和重建圖像IF的第i行第j列的像素值,R表示原始圖像與重建圖像的差值,‖‖2表示L2距離。

2.4 像素判別及優化處理

對原始圖像編碼后生成的特征圖進行圖像清晰度辨識,在生成決策圖的過程中,DeepFuse直接對特編碼后生成的特征圖進行Concat,然后傳入解碼器解碼[8]。DenseFuse則首先采用L1-norm策略對編碼后生成的特征圖進行結合,然后傳入解碼器解碼[10]。SESF-Fuse則有所不同,SESF-Fuse首先對編碼后生成的特征圖采用空間頻率并按通道進行卷積,生成初始決策圖;然后通過數學形態學及引導濾波等優化處理,生成最終決策圖,采用加權融合策略進行圖像融合。在SESF-Fuse中,使用空間頻率逐像素進行清晰像素的判別。生成初始決策圖的方式雖然效果顯著,但是實驗發現,采用此方法在部分數據集上的效果欠缺。為此,結合圖像清晰度評價指標中的灰度方差乘積函數(SMD2)[18],提出一種改進的SMD2方法進行特征的提取。具體公式如下:

(9)

(10)

(11)

(12)

首先對編碼后的特征圖通過上述處理后得到初始決策圖;然后采用數學形態學處理開閉運算(圓形的形態學算子,設置閾值為0.01×H×W用以消除獨立小區域),優化初始決策圖中像素判別出錯的像素點,得到最終語義連貫的區分聚焦清晰位置和模糊位置的決策圖。

2.5 融合策略

將通過像素判別和優化處理后生成的決策圖,采用加權融合的方式進行最終的圖像融合過程,其計算公式為

F(i,j)=D(i,j)A(i,j)+(1-D(i,j))B(i,j) ,

(13)

其中,F(i,j)表示融合后圖像的第i行第j列的像素值,A和B分別表示不同聚焦屬性的原始聚焦圖像。

2.6 融合評價指標

為了更好地評判融合后的圖像質量,將從主觀和客觀兩個方面進行評價。其中,主觀評價表示從圖像視覺感官上來看,融合圖像是否存在模糊等情況。客觀評價時,選取QMI、多尺度結構相似度(MSSSIM)、峰值信噪比(RPSNR)、空間頻率(RSF)和QAB/F這5項指標進行融合圖像質量的評價。

(1)QMI是對MI的一種改進,能夠更好地衡量原始圖像與融合圖像之間信息轉移的多少[19]。QMI越大,圖像融合效果越好。其定義如下:

(14)

其中,RENA、RENB和RENF代表源圖像A、源圖像B和融合后圖像F的信息熵;RMIAE和RMIBF代表圖像A、B和F之間的聯合信息熵所對應的互信息。

(2) SSIM常用以衡量融合圖像與源圖像的結構相似度。但是SSIM指標是單一尺度的,不符合人眼的視覺特性[19]。為此,文獻[20]提出了基于多尺度結構相似性客觀評價指標(RMSSSIM)。其定義如下:

(15)

其中,M為參考圖像所選取的最高尺度數。通過對輸入圖像連續使用低通濾波器進行下采樣處理,得到第i層的亮度、對比度、結構相似度的計算結果分別記為lM(x,y)、ci(x,y)和si(x,y)。在此設置αM、βi和γi分別為1。

(3) 峰值信噪比(RPSNR)[21],用于衡量圖像有效信息與噪聲之間的比率,能夠反映圖像是否失真。RPSNR越大,表示圖像質量越好。其定義如下:

(16)

(17)

其中,RMAXI表示圖像點顏色的最大數值,如果每個采樣點用 8 位表示,那么就是 255。

(4) 空間頻率(RSF)反映的是空間域內圖像的總體活躍程度[22],即圖像灰度的變化率,其定義如下:

RSF=(RRF2+RCF2)1/2,

(18)

(19)

(20)

其中,RRF和RCF分別為圖像H的行頻率和列頻率。

(5)QAB/F評價算子可以較好地反映源圖像中有多少邊緣信息被傳遞到了融合圖像中[23]。該評價指標首先采用Sobel邊緣檢測算子來獲取源圖像和融合圖像中每個像素點處的方向信息強度a(x,y)和邊緣信息強度g(x,y),即

(21)

(22)

(23)

(24)

(25)

QAB/F評價算子可以較好地反映源圖像中有多少邊緣信息被傳遞到了融合圖像中,其定義如下:

(26)

3 實 驗

3.1 實驗環境

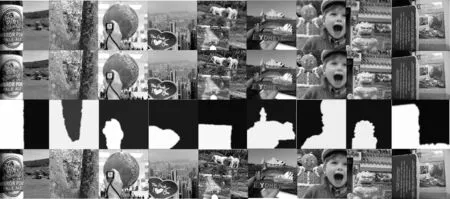

采用MS-COCO數據集[24]進行模型訓練,并選取了38對公開的多聚焦圖像數據集[25]進行圖像融合及對比實驗。

對于訓練的MS-COCO數據集,選取了10 000張圖像進行模型訓練。為了增強模型效果,提高訓練速率,降低內存開銷,在將數據傳入模型之前,首先對原始數據進行了圖像灰度變換、數據標準化處理及大小為256×256的圖像尺寸變換處理。其中,對于在測試數據集上進行圖像融合的過程中,不進行圖像尺寸變換處理。此外,在使用訓練好的編碼器進行實驗生成決策圖后,仍采用原始的彩色圖像進行加權圖像融合。

對于模型超參數的設定,對于初始學習率設置為10-3,并采用Warm up學習率策略進行動態調整。優化器采用AdamW,Batch_Size設置為16,迭代次數設置為50次。

本實驗采用Python語言,主要采用Pytorch、Skimage庫在PyCharm編譯器中進行實現,所采用的GPU平臺為NVIDIA 1060。

3.2 融合圖像評價

為了更好地體現本次實驗的效果,選取了經典傳統圖像融合算法DWT[26],將深度學習引入圖像融合的CNN[5]算法以及近幾年的幾種經典的基于無監督學習的圖像融合算法(DenseFuse[10]、SESF-Fuse[12]及U2Fusion[14]算法)進行實驗,并分別從主觀評價上和客觀評價上進行比較。

3.2.1 主觀評價

采用文中算法進行圖像融合實驗,得到的圖像融合的部分結果如圖2所示。

圖2 圖像融合效果圖

為了比較文中算法與其他融合算法的差別,在此分別展示各個算法在此測試集上的融合效果圖和差值圖(融合后圖像減去原始圖像),如圖3和圖4所示。

圖3 各種算法融合效果的對比圖

從圖2可以看出,文中所提出的融合算法進行圖像融合后,在主觀上取得了較好效果,融合后的圖像已經看不出明顯的瑕疵。從圖3文中算法與其他算法對比的融合效果可以看出,所比較的各種算法在主觀上看不出明顯區別,均能夠取得較好的融合效果。為了進一步探討融合后的圖像保留了多少原始圖像信息,又進行了差值圖比較。從圖4各種算法的差值圖可以看出,DWT、CNN、DenseFuse和U2Fusion的差值圖存在明顯瑕疵,融合后的圖像的聚焦部分的信息并未得到全部保留。SESF-Fuse算法和文中算法則能夠較好地保留原始圖像的聚焦部分的完整信息。

3.2.2 客觀評價

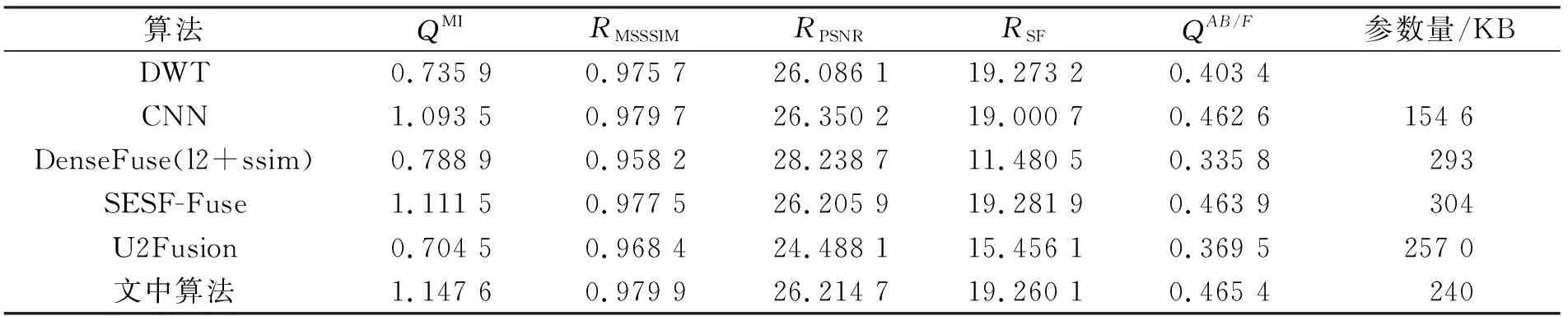

在主觀評價上,各項算法均能取得較好的融合效果,且SESF-Fuse和文中算法相對較好,能夠更好地保留原始圖像信息。為了對融合后的圖像進行具體量化,在此計算各種算法在38對公開的多聚焦圖像數據集上的5項評價指標的平均值。具體結果如表1所示。

表1 各種算法的圖像融合質量對比

從表1可以看出,文中所提算法與多種具有代表性的圖像融合算法相比,采用了更小的網絡模型,并在多項客觀評價指標上取得了較好的效果,具有更好的信息保留效果(QMI、QAB/F)。在5項評價指標的縱向比較中,取得了3項最優。在橫向比較中,相較于DWT、CNN、DenseFuse、SESF-Fuse和U2Fusion,分別有5、4、4、4和5項指標優于相應的比較算法。雖然SESF-Fuse和CNN算法采用了基于決策圖的方式進行多聚焦圖像融合任務且與文中算法在多項指標上相近,但是文中算法所使用的模型參數量更少,具有更高的融合速率并在多項指標上優于兩者。U2Fusion的設計則出于對融合任務通用性的考慮,導致其在特定任務上的融合性能欠佳。DenseFuse在融合過程中直接對編碼后的特征圖進行了相加,導致原始圖像的有效及無效信息得到了不同程度的綜合,因此在多聚焦融合任務上的性能略顯不足。基于頻域變換的DWT算法由于不具有平移不變性,導致融合圖像可能存在邊界存在不連續等問題,因為在多聚焦融合任務上的效果較差。綜合可得,與多種算法相比,文中算法取得了優先的融合性能。

3.3 消融實驗

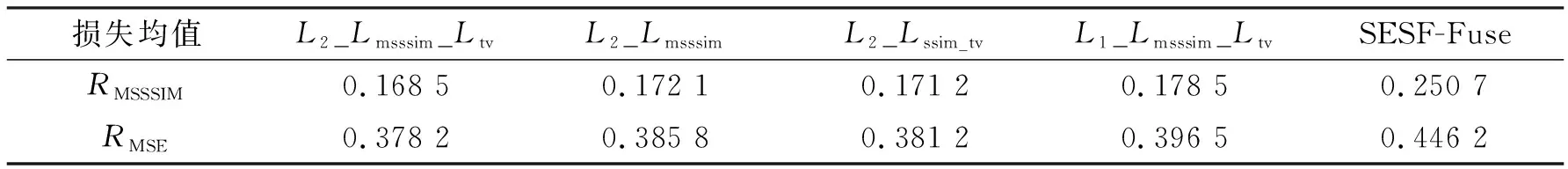

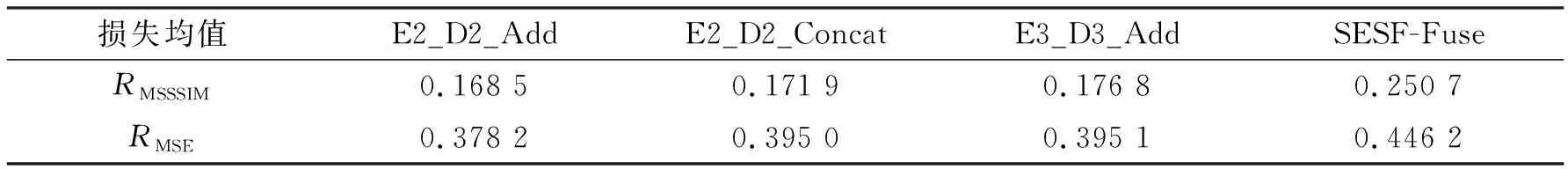

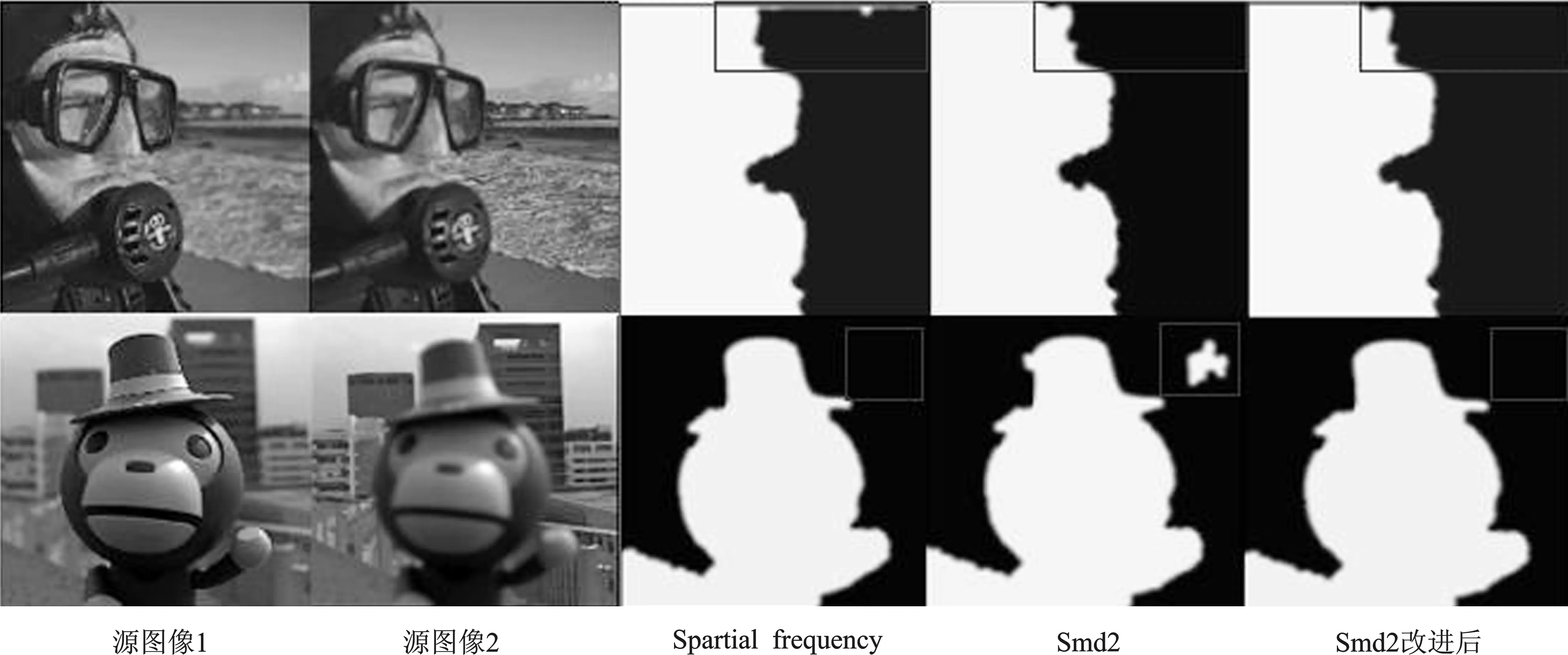

為了驗證文中各項策略的效果及文中算法的有效性,在此選取1 000張MS-COCO數據集中的圖像進行圖像重構任務的訓練,設置迭代次數為50次,在38對公開的多聚焦圖像數據集上計算其重構損失。此外,還分析了文中所提出的清晰像素判別策略的有效性。具體結果如表2、表3和圖5所示。

表2 各種損失函數對比

從表2采用各種損失函數進行圖像編碼和解碼的過程可以看出,由于TV損失能夠重點關注圖像的梯度信息,對噪聲具有抑制作用。因此,TV損失的引入能夠帶來一定程度的效果。多尺度結構相似度(MSSSIM)能夠捕獲圖像多個尺度的模糊,綜合考慮了采樣率、觀察距離等因素,更好地貼近了人眼視覺感知,故引入MSSSIM損失相較于SSIM損失能夠進一步降低模型在編碼解碼過程中的損失。L1損失在此次實驗中的表現則相對較差。值得注意的是,在SESF-Fuse中結合了L2與SSIM損失并賦予了SSIM損失較大的權重。其在圖像重構過程中的損失高于文中的L2損失、MSSSIM損失及TV損失的結合結果,這也體現了文中所采用的損失函數及權重設置的合理性。

表3 不同網絡結構對比

從表3采用各種網絡結構進行圖像編碼和解碼的過程可以看出,SESF-Fuse采用了DenseNet結構,采用卷積層直連加Attention跳躍連接的方式作為編碼器,解碼器也相對更深,但是在編碼解碼過程中的圖像重構損失也更多。E3_D3_Add采用了3層的VAE編碼解碼結果所造成的損失相較于SESF-Fuse更少,但差于E2_E2_Add的2層結構的損失,因此文中采用了基于VAE結構的兩層網絡結構較為合理性。E2_D2_Concat則采用了Concat連接的方式進行編碼結果的匯集,這雖然匯聚了更多來自編碼器的特征圖,但是同時也給解碼器帶來了負擔。因此在此問題中,在同等訓練輪數下效果略差于Add連接的方式。此外,Add連接更貼近于VAE網絡的原始結構。綜合來看,采用文中的融合架構具有一定的合理性。

圖5 各種清晰像素判別方法的性能對比

從圖5采用不同的清晰像素判別方式生成決策圖的過程可以看出,采用空間頻率(Spatial frequency)及灰度方差乘積函數(SMD2)進行像素判別的方式均存在一定的瑕疵,而采用改進后的SMD2進行像素判別的方式能夠兼顧兩者的優勢,取得了更好的效果,即文中提出采用改進后的SMD2進行像素判別的方式是有效的。

4 結束語

文中結合VAE結構設計出了一種新的多聚焦圖像融合的網絡架構。在訓練過程中,采用L2+MSSIM+TV損失函數進行無監督訓練,該網絡架構對原始圖像信息具有更高的保留度。在融合過程中,采用改進的SMD2方法進行清晰像素判別能夠更好地考慮原始圖像的特征梯度信息,是融合過程的關鍵。最終,相較于多種融合算法,文中方法取得了先進的融合性能。

此次實驗雖然取得了理論上的成功,但是同時也發現了一些問題:首先是諸如FusionDN[13]及U2Fusion[14]這種通用融合算法在具體問題上的融合性能仍然欠佳;其次是雖然SESF-Fuse[12]及文中算法這類基于決策圖的融合方法在多聚焦圖像融合任務上的效果較好,但是這會造成離焦擴散現象,在聚焦邊緣仍存在少許的殘缺。因此,如何更好地保留邊緣信息是未來的一個研究點。最后,像素判別的方式對于融合結果具有重要的影響。目前主要是采用特征梯度進行像素判別,但是采用此方式進行像素判別,在面對高曝光圖像及模糊圖像時的處理效果欠佳。如何根據具體問題自適應地選擇合適的像素判別方式,值得重點考慮。