改進級聯(lián)卷積神經(jīng)網(wǎng)絡的預標注方法

葉 葉

(泰州學院信息工程學院,泰州 225300)

0 引言

隨著智慧城市、智慧交通的迅速發(fā)展,目標檢測任務在智能監(jiān)控方面有著重要的作用[1]。而目標檢測任務需要通過監(jiān)督訓練的方式來獲取模型,快速地獲取到標注數(shù)據(jù)集對于目標檢測任務來說,具有重要的研究意義。

在目標檢測任務當中,采用深度學習進行訓練測試獲取到一個泛化性能比較好的深度學習檢測模型,需要對各種不同類型的模型訓練以及測試,以獲取到對于當前任務而言較好的適合模型,此時就需要采用大量的標注數(shù)據(jù)來進行監(jiān)督訓練,如果采用純?nèi)斯俗⑿枰馁M大量的人力物力以及相當長的時間,在標注圖片中還存在著曝光過高、低對比度、雨雪天氣等各種難以標注的圖片,導致人力物力以及時間上的消耗就會成倍地增加[2]。例如,imagenet的數(shù)據(jù)集通過亞馬遜眾包平臺,總共由來自167個國家的47000名工作者,耗時3年進行標注而成。imagenet比賽的數(shù)據(jù)集圖片總量超過1500萬張、共22000多類帶標簽的高分辨率圖像[3]。

當下的標注方式在以前的純手工基礎上進行了一定的改進,先使用已有的目標檢測預標注工具進行數(shù)據(jù)的預標注,這樣對于每張圖片可以獲取到相對粗糙的標注結果,然后再采用人工方法進行精確標注來提高效率,減少誤標漏標以及人力的投入。隨著深度學習技術的不斷發(fā)展以及應用,目標檢測算法的檢測準確度得到了很大的提升,主要體現(xiàn)在錯誤的檢測類別比例減小,正確的檢測類別比例增加。級聯(lián)卷積神經(jīng)網(wǎng)絡對網(wǎng)絡性能有進一步的提升。

本文使用改進的級聯(lián)卷積神經(jīng)網(wǎng)絡,用來對圖像進行預標注[4]。級聯(lián)卷積神經(jīng)網(wǎng)絡首先通過一個主干網(wǎng)絡提取輸入圖像三個尺度上的特征,并將深層的特征進行上采樣與淺層特征進行融合,在三個尺度上進行目標檢測,然后將檢測的結果輸入下一級檢測器進行二級目標檢測,二級目標檢測的結果輸入到三級檢測器進行檢測,對三級檢測結果進行融合,得到目標的位置以及分類信息。直接采用級聯(lián)卷積神經(jīng)網(wǎng)絡雖然也有較好的檢測精度以及準確度,但在精度上仍有提升空間。本文對級聯(lián)卷積網(wǎng)絡的網(wǎng)絡結構進行一定的改進,處理方案被優(yōu)化以提高算法的準確度以及定位問題。本文通過將輸入層修改為多尺度輸入、RPN層采用Anchor Free來減少模型計算量,并且提高模型的檢測性能。最后,在I oU為0.5,F(xiàn)P P I為0.3時,本文的網(wǎng)絡recall達到了64.52%,在預標注模型中具有較高的準確度。

1 級聯(lián)卷積神經(jīng)網(wǎng)絡介紹

級聯(lián)卷積神經(jīng)網(wǎng)絡是Cai等[5]發(fā)表在CVPR-2018上的高精度目標檢測方法,它采用端到端訓練方法,且其目標檢測的檢測框精度較高,即檢測框與實際物體的框IoU值較高。該模型將檢測框的邊界回歸分成三個階段來進行逐步優(yōu)化,同時對于檢測物體的識別也綜合三個階段的結果綜合考量[6]。

1.1 級聯(lián)卷積神經(jīng)網(wǎng)絡思想

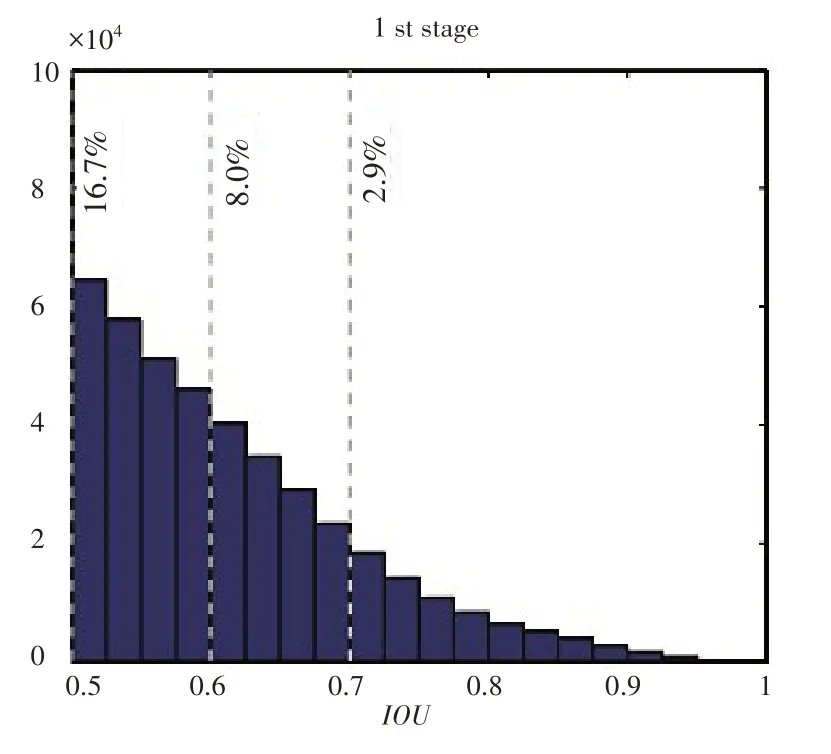

Faster R-CNN目標檢測網(wǎng)絡的特點在RPN訓練階段對于正負樣本是采用I oU閾值來進行區(qū)分的,一般采用I oU閾值為0.5,當檢測框和實際框的Io U閾值小于0.5為負樣本,大于等于0.5為正樣本[7]。但是在這里有個人為設定的IoU閾值來區(qū)分正負樣本,這樣訓練出來的網(wǎng)絡在預測階段對于proposal框和實際框的I oU值在0.5左右的檢測框的回歸效果最好,但是對于Io U值較高的proposal框,其回歸效果較差。同理,如果調(diào)整IoU閾值到0.6,則是對I oU值在0.6附近的檢測框的回歸效果最好。RPN網(wǎng)絡proposal框的分布如圖1所示。

圖1 檢測框Io U分布圖

采用單個回歸網(wǎng)絡可以提高其中一部分檢測框的檢測精度,但是采用級聯(lián)網(wǎng)絡可以將檢測框檢測精度逐步提升,提高最終輸出結果的檢測精度,圖2所示為經(jīng)過級聯(lián)網(wǎng)絡后的proposal框的分布圖,從左至右分別是一級proposal框Io U分布,二級proposal框Io U分布,三級proposal框IoU分布[8]。由此經(jīng)過級聯(lián)網(wǎng)絡最終輸出的檢測框精準度有極大的提高。

圖2 級聯(lián)后檢測框IoU分布圖

I oU是檢測框預測值和檢測框實際值的交集與檢測框預測值和檢測框實際值的并集之比,如下式所示:

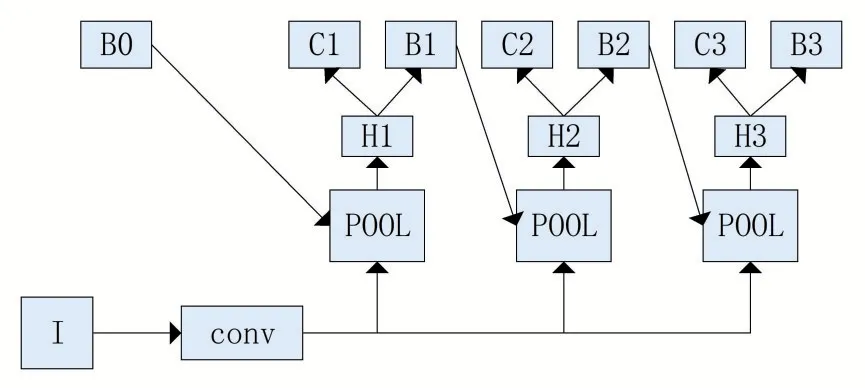

1.2 網(wǎng)絡結構

級聯(lián)卷積神經(jīng)網(wǎng)絡以Faster R-CNN為基本框架[9],如圖3所示,總共有三級檢測器,其中I為輸入的圖片,conv為用于提取特征的卷積層,采用FPN作為主干網(wǎng)絡;pool為池化層,一般采用RoI Pooling層或者RoI Align層;H1、H2、H3為分類回歸前的神經(jīng)網(wǎng)絡;B0是RPN輸出的proposal,B1、B2、B3分別為三級RCNN的輸出的檢測框參數(shù);C1、C2、C3分別是三級RCNN的分類結果。

圖3 Cascade RCNN模型結構圖

H1、B1、C1采用Io U閾值為0.5來進行訓練,H2、B2、C2采用I oU閾值為0.6來進行訓練,H3、B3、C3采用I oU閾值為0.7來進行訓練,逐級對檢測框進行檢測回歸以提高檢測準確度和精準度。

2 基于改進級聯(lián)卷積神經(jīng)網(wǎng)絡的預標注方法

本文主要利用級聯(lián)卷積神經(jīng)網(wǎng)絡研究預標注方法,通過修改級聯(lián)卷積神經(jīng)網(wǎng)絡結構,將級聯(lián)卷積神經(jīng)網(wǎng)絡結構較好地應用在預標注方法領域。

2.1 改進的級聯(lián)卷積神經(jīng)網(wǎng)絡算法

本文的級聯(lián)卷積神經(jīng)網(wǎng)絡算法的整體結構圖如圖4所示。首先對輸入圖片進行調(diào)整,長邊調(diào)整到1312,短邊按圖片的長寬比進行對應的縮放,然后將其輸入到訓練好的神經(jīng)網(wǎng)絡中進行識別,主干網(wǎng)絡通過卷積層操作獲取到8倍下采樣、16倍下采樣、32倍下采樣的特征圖,然后對各個特征圖進行目標的檢測和識別,獲取到定位、類別、置信度,經(jīng)過三級檢測識別操作獲取到結果。

圖4 改進級聯(lián)卷積神經(jīng)網(wǎng)絡結構

對于輸入層,將原級聯(lián)卷積神經(jīng)網(wǎng)絡單尺度輸入替換成多尺度輸入進行訓練,通過實驗得出多尺度能夠提升檢測的準確度與精準度。對于主干網(wǎng)絡,將RPN層替換為Anchor Free層,對于建議框來說,Anchor Free的建議框質(zhì)量相對于RPN更高,并且減少建議框的數(shù)量,提升檢測速度以及檢測召回率。

2.2 多尺度優(yōu)化

級聯(lián)網(wǎng)絡的輸入圖片的尺寸是單一固定的,級聯(lián)卷積神經(jīng)網(wǎng)絡的原始訓練測試數(shù)據(jù)的數(shù)據(jù)源較為統(tǒng)一,但是在實際使用過程中會遇到數(shù)據(jù)源來自不同的攝像頭的情況,圖片尺寸差別較大,因此需要對級聯(lián)卷積神經(jīng)網(wǎng)絡的輸入層進行修改,將圖片的長邊縮放到1312,短邊則按原圖長寬比等比例縮放,如果原始圖片長邊大于1312,則需要將圖片進行縮小,此時采用局部均值的方法來進行圖像縮小,濾波器的尺寸大小計算如下式所示。

當輸入圖片長邊小于1312時,需要將圖片進行放大,此時采用雙線性插值算法將圖片進行放大,短邊則按原圖長寬比等比例縮放,雙線性插值算法如下式所示[10]。

此時,對于輸入的圖片長邊固定成1312,短邊按原圖比例縮放。并且基于金字塔方法的思想,對于輸入圖片進行金字塔式采樣可以使得模型適應不同尺寸的圖片,提取到更合理的圖片特征[11]。訓練時采用多尺度方式預設多種尺度,并對各尺度進行編號,輸入層采用隨機方式獲取尺度進行訓練,獲取方式如下式所示。

2.3 Anchor Free優(yōu)化

在級聯(lián)卷積神經(jīng)網(wǎng)絡的RPN網(wǎng)絡階段,采用Anchor Base的方法來進行Anchor[12],采用Anchor Base的方法需要設定許多的超參,例如Anchor number,Anchor size,Anchor ratio等,這些超參的設置對于模型的訓練結果會產(chǎn)生極大的影響;為了保證算法的檢測效果,需要大量的Anchors來進行訓練,其中負樣本的比例較大,因此存在正負樣本不均衡的問題;在訓練過程中,需要計算Anchor box與ground truth box的IoU,總體計算量較大。

采用Anchor Free將RPN網(wǎng)絡中feature map對應的Anchor轉換成在feature map上的每一點進行回歸操作[13],首先將feature map中的每個點映射回原始的輸入圖片,如果這個映射回原始輸入的點在相應的ground truth的范圍之內(nèi),而且類別標簽對應,我們將其作為訓練的正樣本塊,否則將其作為負樣本塊,回歸的目標參數(shù)如圖5所示,為(l,t,r,b),即中心點離左邊界、上邊界、右邊界、下邊界的距離。

圖5 回歸目標參數(shù)

假設實際框的左上角和右下角坐標值為(x0,y0)、(x1,y1),那么回歸的目標數(shù)據(jù)為

通過這種方式可以獲取到對應的正樣本,然后對正樣本進行回歸操作。與Anchor Base方法相比,該方法的正負樣本數(shù)據(jù)較為平衡,并且無需設置超參,在計算量方面,該方法相對于需要進行Io U計算的Anchor Base方法計算量要減少許多。

由于對檢測方式進行了修改,相應地修改損失函數(shù),具體損失函數(shù)如下所示:

損失函數(shù)包含兩個部分,Lcls表示分類損失,在本設計中采用了FocalLoss;Lreg表示回歸損失,在本設計中采用IoULoss,F(xiàn)ocalLoss可以進一步對正負樣本不平衡有優(yōu)化作用[14],IoU Loss將位置信息作為整體來進行訓練檢測,其相對于四個坐標點分別回歸有更好的檢測效果。

3 實驗結果與分析

本文的仿真實驗環(huán)境:處理器為Intel core i7-7700,CPU為3.60 GHz*8,7.7 G內(nèi)存,GPU為GTX1080。操作系統(tǒng)為Ubuntu16.04[15]。

3.1 結果評價指標

為了對檢測結果進行評價分析,本設計采用如下指標:T P(True Positive)為檢測正確的非背景框,F(xiàn) P(False Positive)為誤報框,T N(True Negative)為檢測正確的背景框,F(xiàn) N(False Negative)為漏報。當檢測框I o U大于0.5時,且置信度大于設定閾值時,認為該檢測框為一個正檢。

平均每張圖誤報框數(shù)量F P PI:

召回率recall:

采用FPPI-recall作為本設計的評價指標,本設計作為預標注算法,刪除誤檢的檢測框需要人工操作時間,因此需要控制誤檢框的數(shù)量,同時需要提高召回率,保證預標注數(shù)據(jù)完整性。

3.2 不同網(wǎng)絡對比試驗

本文采用的目標檢測數(shù)據(jù)集為VOC2007和VOC2012,其包括了在角度、光照、形態(tài)等方面不同的檢測圖片[16]。VOC2007訓練集圖片量為5011張,測試集圖片量為4952張,對所有網(wǎng)絡進行了90k次迭代訓練。為了加速訓練并防止過擬合,初始學習率設置為0.001,學習率衰減系數(shù)設置為0.0001,權值衰減系數(shù)設置為0.0005。

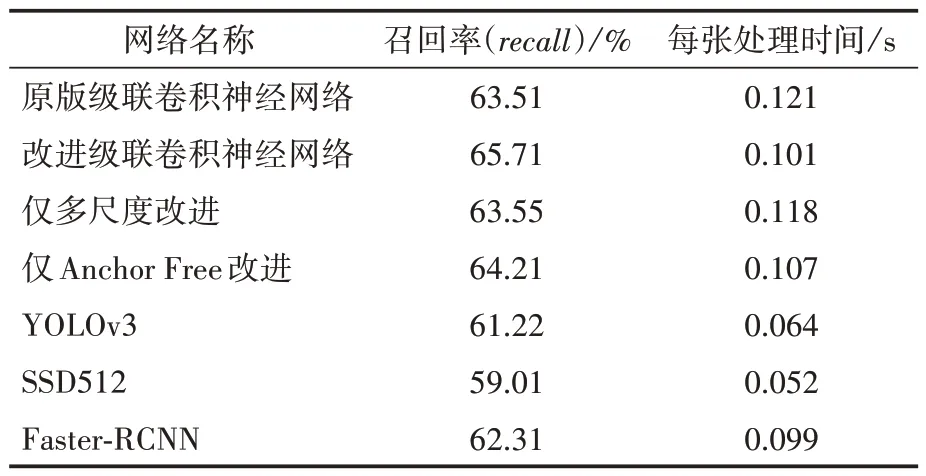

為了測試網(wǎng)絡檢測的準確度,本文對原級聯(lián)卷積神經(jīng)網(wǎng)絡、本文優(yōu)化后的級聯(lián)卷積神經(jīng)網(wǎng)絡以及其他的一些神經(jīng)網(wǎng)絡進行了測試實驗,并對實驗結果進行了比較。測試集選用VOC-2007的標準測試集,在F PP I為0.3時,其檢測效果如表1和圖6所示。

表1 在VOC2007上不同目標檢測算法測試對比

從表1和圖6可以看出,使用改進級聯(lián)卷積神經(jīng)網(wǎng)絡在F P PI為0.3、I oU閾值為0.5的情況下,其召回率最高,為64.52%。同時,本文的三個改進點對于級聯(lián)卷積神經(jīng)網(wǎng)絡的檢測結果具有優(yōu)化作用,Anchor Free對于級聯(lián)卷積神經(jīng)網(wǎng)絡的優(yōu)化作用相對于多尺度較好。SSD512由于輸入圖像較小,并且其多尺度的方法較為落后,因此,檢測結果相對較差。同時,在檢測速度上,由于標注算法對于實時性要求不高,檢測速度不是作為一個參考參數(shù),可以看到YOLOv3和SSD512由于其是單階段的檢測算法,檢測速度相對較快;而Faster-RCNN以及級聯(lián)卷積神經(jīng)網(wǎng)絡算法,F(xiàn)aster-RCNN的測試速度最快,因為Faster-RCNN的檢測回歸只有一級,而級聯(lián)卷積神經(jīng)網(wǎng)絡有三級檢測回歸網(wǎng)絡,Anchor Free改進對于速度有一定的提升,相對于RPN層,Anchor Free提出的建議框的數(shù)量少、質(zhì)量高,在本設計中具有極大的意義。

圖6 部分檢測結果

VOC2012訓練集圖片量為11540張,測試集圖片量為10991張,同樣對所有網(wǎng)絡進行了90k次迭代訓練。初始學習率設置為0.001,學習率衰減系數(shù)設置為0.0001,權值衰減系數(shù)設置為0.0005。

從表1及表2可知,在VOC2007以及VOC2012數(shù)據(jù)集上,經(jīng)過多尺度以及Anchor Free改進后的級聯(lián)卷積神經(jīng)網(wǎng)絡的檢測召回率相對于原級聯(lián)卷積神經(jīng)網(wǎng)絡有一定的提高,另外,Anchor Free對于網(wǎng)絡召回率的提升效果較多尺度更明顯。改進級聯(lián)卷積神經(jīng)網(wǎng)絡的檢測效果比原級聯(lián)神經(jīng)網(wǎng)絡、Faster-RCNN、SSD512、YOLOv3效果要好。

表2 在VOC2012上不同目標檢測算法測試對比

3.3 與已有改進級聯(lián)卷積網(wǎng)絡算法的比較

最后將本文改進的級聯(lián)卷積神經(jīng)網(wǎng)絡算法與近兩年提出的優(yōu)化的級聯(lián)卷積神經(jīng)網(wǎng)絡算法進行了對比,統(tǒng)一采用F PPI為0.3時,Io U閾值為0.5時的r ecal l值,數(shù)據(jù)集VOC2007和VOC2012,檢測結果如表3所示。

表3 不同優(yōu)化級聯(lián)卷積神經(jīng)網(wǎng)絡測試對比

文獻[17]提出了一個新的single-shot檢測器RefineDet,采用ARM(anchor refinement module)和ODM(object detection module),ARM過濾掉部分negative anchors,減少搜索空間,給ODM進一步的分類和回歸提供一個比較原始的信息;ODM用于對ARM輸出的結果進行回歸和分類,實現(xiàn)了相較于二階段檢測器(主要對比Faster-RCNN)有更高的準確率的同時,具有一階段檢測器的檢測效率(主要對比SSD系列)。文獻[18]設計應用場景主要是針對小尺寸的交通標志,在級聯(lián)卷積神經(jīng)網(wǎng)絡的基礎上提出了一種基于點積和softmax的多尺度特征加權關注方法,并對負樣本,特別是困難樣本進行擴充來進行訓練,其優(yōu)化思想和本文有一定的相似之處,都借鑒了金字塔式多尺度思想,本文的優(yōu)化方案從建議框的角度來對模型進行優(yōu)化,不僅可以優(yōu)化模型召回率,對于模型的檢測速度也有很大的提升,召回率以及檢測速度相較于文獻[18]都有優(yōu)勢。文獻[19]采用的檢測方法包含兩個分支,檢測分支和分割分支,檢測分支以VGG16作為backbone,在不同層的特征圖上進行檢測;分割分支主要用于增強低級特征的語義信息。它以低級特征作為輸入,通過bboxlevel segmentation gt作為監(jiān)督來學習語義分割的信息,然后利用該分支中的語義特征來增強低級特征。再通過全局激活模塊增強高級特征,全局激活塊能夠以一種自監(jiān)督的方式學習特征通道與目標類別之間的關系,從而增強高級特征的語義信息。

4 結語

本文提出一種優(yōu)化的級聯(lián)卷積神經(jīng)網(wǎng)絡,該網(wǎng)絡對輸入層進行多尺度設計,對于RPN階段,采用Anchor Free的方式來提出預檢測框,并在VOC2007及VOC2012數(shù)據(jù)集上進行訓練測試。實驗結果表明,在F PP I為0.3,I oU閾值為0.5的情況下,本設計在VOC2007數(shù)據(jù)集上召回率達到了64.52%,在VOC2012數(shù)據(jù)集上召回率達到了65.71%。與時下的不同模型以及其他優(yōu)化級聯(lián)卷積神經(jīng)網(wǎng)絡方案相比,本文網(wǎng)絡具有一流的檢測性能以及速度,對于預標注方法來說,這些特性使本文方法十分適用。