蘋果聯合學界提出“生成多平面圖像”方法 用最少修改讓2D生成對抗網絡實現3D感知

在生成高質量圖像方面,生成對抗網絡(GAN)在近幾年取得了令人印象深刻的進展。

這些進步大多集中在生成器的輸出空間和給定的數據集設置相同方面,這些輸出通常是圖像,有時也是3D卷形式。

而最新的研究主要體現在生成與現有的訓練數據不同的新輸出上。這包括為一類對象生成3D幾何圖形和相應的紋理的方法,給定的數據集只包含廣泛可用的單視圖圖像。沒有使用多視圖圖像或3D幾何圖形來監督3D感知生成對抗網絡的訓練。

為了從這種有限的監督形式中學習3D幾何圖形,之前的研究通常會結合三維感知歸納偏差,如三維體素網格或使用渲染引擎的隱式表示。

然而,提高這些方法的結果質量仍然具有挑戰性:3D感知的歸納偏差通常是內存密集型的顯式或隱式3D卷,并且渲染通常需要計算。此外,從2D生成對抗網絡中獲得的經驗教訓往往不能直接轉移,因為生成器的輸出甚至其整個結構都必須進行調整。

這就提出了一個問題:讓現有的2D生成對抗網絡3D感知,需要真正做些什么?

為了回答這個問題,本次蘋果聯合學界希望以最少方式修改現有的2D生成對抗網絡,并建立一個有效的推理和訓練程序。

3D感知生成多平面圖像的概述

近日,相關論文以《生成多平面圖像:制作一個2DGAN3D感知》為題提交在arXiv上。

首先對生成對抗網絡的概念做一簡單介紹。據維基百科了解,“生成對抗網絡 是一類機器學習框架,由生成器和鑒別器兩個神經網絡在游戲中相互競爭,鑒別器對生成器產生的欺騙樣本進行檢測,使用零和博弈的形式,其中一個代理的收益是另一個代理的損失。這一對抗性概念最初被認為是無監督學習生成模型的一種形式,但它也被證實對半監督學習、完全監督學習和強化學習有用。”

本次研究人員選擇了一種被廣泛使用的高清圖像合成方法StyleGANv2。對此,研究者在論文中表示:“StyleGANv2有一個額外的好處,即許多訓練檢查點都是公開可用的。”

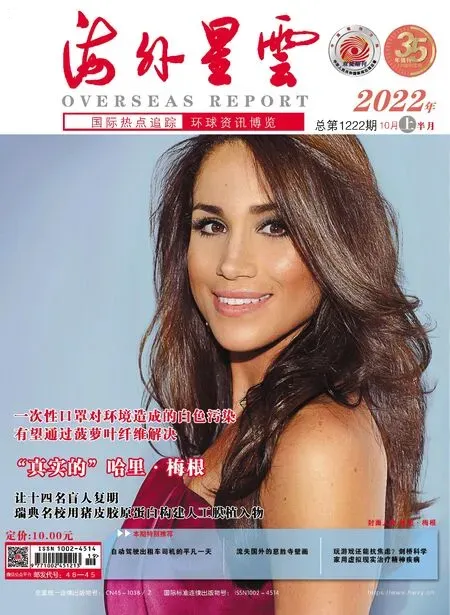

StyleGANv2發布于2020年,是StyleGAN(2018年12月推出)的升級版。StyleGAN主要體現人臉屬性,像臉型的表情、朝向、膚色、光照等多方面容貌姿態信息。

通過輸入不同參數,可以使StyleGAN生成精細程度不同的各種人臉“Style”。另外,該模型也可以生成動物、汽車等圖像。值得一提的是,由于StyleGAN可以對生成的圖像進行細致調整,從而更容易生成足夠真實的假圖像。該技術的一些潛在有害用途一直存在爭議。

在三個數據集(FFHQ、AFHQv2和MetFaces)上,使用最小的更改集進行2D Gan 3D感知

回到一開始提出的問題,讓現有的2D生成對抗網絡3D感知需要什么?

本次研究團隊在論文中表示:“只有兩個修改是絕對必要的:1.一個多平面圖像樣式生成器分支,它生成一組基于其深度的Alpha映射。2.一個姿勢調節的鑒別器。更具體地說,我們為StyleGANv2開發了一個新的生成器分支,它會產生一組類似于一個多平面圖像的正面平行的Alpha映射。這是第一個證明一個多平面圖像可以作為無條件的3D感知生成模型的場景表示的研究。”

據了解,區別于生成器和鑒別器一同調整的情況,新分支是從零進行訓練,并且,結合Alpha映射與一個多平面圖像渲染中的單一圖像輸出,還可得到多種視圖的3D感知生成。

雖然Alpha映射遮擋的解決還存在一定限制,但其地圖數量和渲染都比較有優勢,甚至在訓練和推理方便也有差別,可緩解記憶問題。

“我們將這種生成輸出的方法稱作‘生成多平面圖像’。”研究人員在論文中表示。他們還提到,雖然這兩種調整在事后看起來很直觀,但令人驚訝的是,一個具有基于其深度的平面和使用相機姿態信息的Alpha地圖,對3D感知的歸納偏差是足夠的。

最終的Alpha映射是通過累積所有由單個卷積層生成的中間結果來獲得的

另外,即便修改Alpha映射的另一個歸納偏差有效,但對獲得3D感知并不是必要的。

總的來說,本次研究團隊的貢獻主要體現在兩方面:1.使用標準單視圖2D圖像數據集,訓練類似一個多平面圖像的3D感知生成模型;2.在深度上的Alpha平面或一個可學習的令牌和相機姿態上的鑒別器,足以使2D生成對抗網絡轉向3D感知。

此外,團隊還研究了在三個高分辨率數據集(FFHQ、AFHQv2和MetFaces)上編碼3D感知歸納偏差的方法。同時也對其他信息提供了改進,但這些對3D感知并不是嚴格必要的。

最后,研究人員希望‘生成多平面圖像’的簡單性,能對解決遮擋推理等工作的限制提供幫助。