面向濱海生態監管的 多尺度目標語義分割研究

陳巖 楊曉彤 奚硯濤 徐立祥 李新路

摘 要|針對缺少濱海生態場景深度學習數據集,面向遙感影像分類的多尺度目標語義分割精度不高等問題,研究以紅樹林、浮筏養殖和圍塘養殖三類濱海典型生態監管多尺度目標為研究對象,構建了面向濱海生態監管的多目標語義分割數據集, 通過集成批歸一化和空間置棄算法,改進 UNet 特征融合策略,提出了一種多尺度深度卷積語義分割模型。模型在測試集上總體精度 92%,Kappa 系數 0.87, 平均交并比 82%。實驗結果表明批歸一化與特征融合空間置棄的耦合堆疊可有效抑制多尺度目標語義分割過擬合,提高模型精度和泛化性能。研究提出的模型及構建的面向濱海生態環境監管的多目標語義分割數據集可為濱海區域生態修復、測繪和綜合治理提供決策支持。

關鍵詞|濱海生態監管;人工智能;紅樹林;海水養殖;基準數據集;多尺度特征融合; 語義分割

Copyright ? 2022 by author (s) and SciScan Publishing Limited

This article is licensed under a Creative Commons Attribution-NonCommercial

4.0? International License. https://creativecommons.org/licenses/by-nc/4.0/

1???? 引言

隨著海產品需求的增長和利益驅使,無序、非法海水養殖活動日益頻繁, 不僅對紅樹林、泥炭沼澤和珊瑚礁等構成的濱海濕地生態環境造成了破壞,也給濱海區域規劃及其綜合治理帶來了極大挑戰[1]。遙感以其探測范圍廣、時效性強又經濟等特點,為濱海區域監測提供了強有力支持。借助遙感影像和分類算法自動、快速、準確地提取目標地物是遙感領域的重要課題之一,也是有效監管和保護濱海生態環境的重要手段。

傳統濱海區域遙感監測多采用中低空間分辨率光學影像[2-5]或雷達影像[6-8]。隨著傳感器和航空航天技術的發展,包含豐富空間信息的高分辨率遙感影像數 量增多,成本也在下降,受到國內外學者關注。為從高分辨率遙感影像中準確 提取濱海生態監管目標,研究人員嘗試了各種技術方法,例如基于光譜的圖像 分類[9]和面向對象的圖像分析[10]。然而,豐富的空間信息需要復雜的光譜分 布響應,而高分辨率遙感影像的低光譜分辨率導致目標地物在光譜域的可分性 不高;而面向對象的圖像分析方法需要首先基于紋理、形狀等特征對圖像進行 超像素分割。由于缺乏統一標準,容易引入新的誤差并傳遞至分類階段,影響 整體性能。

近年來, 以 AlexNet[11] 為代表的深度卷積神經網絡(deep convolutional neural network,DCNN)在計算機視覺領域取得了巨大成功,被看作是新一代人工智能技術爆發的起點。在遙感領域,基于 DCNN 的各種深度學習模型在土地利用覆蓋場景分類、船只與飛機檢測、建筑與道路提取等應用中取得了良好效果[12]。它們分別采用了計算機視覺中的圖像識別、目標檢測和語義分割方法。而術語“語義分割”與“遙感影像分類”或“提取”的目標一致,實現像素級分類。全卷積網絡(fully convolutional network,FCN)[13]是 DCNN 在圖像語義分割應用中的代表性模型。它將經典 DCNN 的卷積層保留作為特征提取器,將全連接層替換為卷積層,并引入插值方法恢復圖像空間信息。與面向中低分辨率遙感影像分類常用的基于圖塊(Patch-based)[14]的 DCNN 方法相比,FCN 實現了端到端語義分割。此后,以 FCN 為基礎設計的 U-Net[15]、PSPNet[16]、 RefineNet[17]和 DeepLab 系列[18]在更多遙感應用中發揮了優勢。然而,霍伊斯

(Hoeser)等人[12]指出,雖然 DCNN 在高分辨率遙感影像場景分類、目標檢測和語義分割應用中取得了一定成功,但多聚焦于城市場景。當前,由于缺少濱海生態場景深度學習基準數據集和復雜多尺度特征影響,面向濱海生態監管的研究仍以傳統遙感方法為主,而基于人工智能的濱海生態監管目標提取、分類精度和泛化性仍然有待改善[12]。

因此,研究以圍塘養殖、浮筏養殖和紅樹林三類濱海區域典型生態監管目標為研究對象,基于 QGIS 構建面向濱海區域監管的 DCNN 多尺度目標語義分割模型,集成批歸一化和空間置棄算法,改進 UNet 特征融合策略,嘗試改善模型精度和泛化性能,為濱海區域生態修復、測繪和綜合治理提供決策支持。

2???? 研究方法

2.1? 濱海生態監管多目標語義分割數據集構建

遙感影像具有多波段、大景幅、多時相等特征,使用面向數碼圖像的工具標注遙感影像捉襟見肘,例如讀存速度慢、不支持多波段顯示等。因此,研究基于 QGIS 軟件的矢量化和矢柵轉換工具對 3 類目標地物和背景進行標注。矢量化將遙感影像作為底圖,在創建的面狀 Shapefile 格式圖層上手動標繪目標對象。其中,圍塘養殖、紅樹林、浮筏養殖和背景的唯一標識字段分別定義為可區分整型數值。矢柵轉換指將標繪完成的 Shapefile 矢量圖層轉換為柵格圖像,主要采用 QGIS 面轉柵格工具完成。為保證矢柵轉換后圖像大小和像元位置一致,研究設置了圖像輸出范圍及柵格捕捉等環境變量。經矢柵轉換后的文件被保存為TIFF 格式柵格圖像。

研究使用的高分辨率遙感影像源于高分系列衛星產品,空間分辨率被重采樣至 1 米,像素位深為 8 位。通過提取可見光波段進行真彩色合成后無壓縮地保存為 TIFF 格式圖像,用于矢量化和模型訓練。由于遙感影像和輸出的柵格圖像尺寸較大,在模型訓練和預測過程中,如果直接將其輸入到網絡模型會造成內存或顯存溢出。因此,研究引入了支持多波段操作、面向 Python 語言的地理空間數據抽象庫(geospatial data abstraction library,GDAL),對 TIFF 格式的遙

感影像和標注的柵格圖像進行裁剪。裁剪圖塊大小取決于目標尺度和用于模型訓練的 CPU 或 GPU 性能。研究綜合考慮了目標地物尺度、圖像空間分辨率和硬件條件,采用 256×256 窗口對遙感影像和標注的柵格圖像進行裁剪,并最終獲得若干組 256×256 像素大小的 TIFF 格式樣本圖塊。一個樣本包含一幅輸入遙感影像圖塊和一幅標注柵格圖塊。圖塊的文件名保持相同,以便模型正確識別。研究根據機器學習樣本數據集劃分經驗對樣本進行隨機抽取劃分得到訓練集、驗證集和測試集。

2.2? 深度卷積神經網絡模型 UNet 改進與訓練

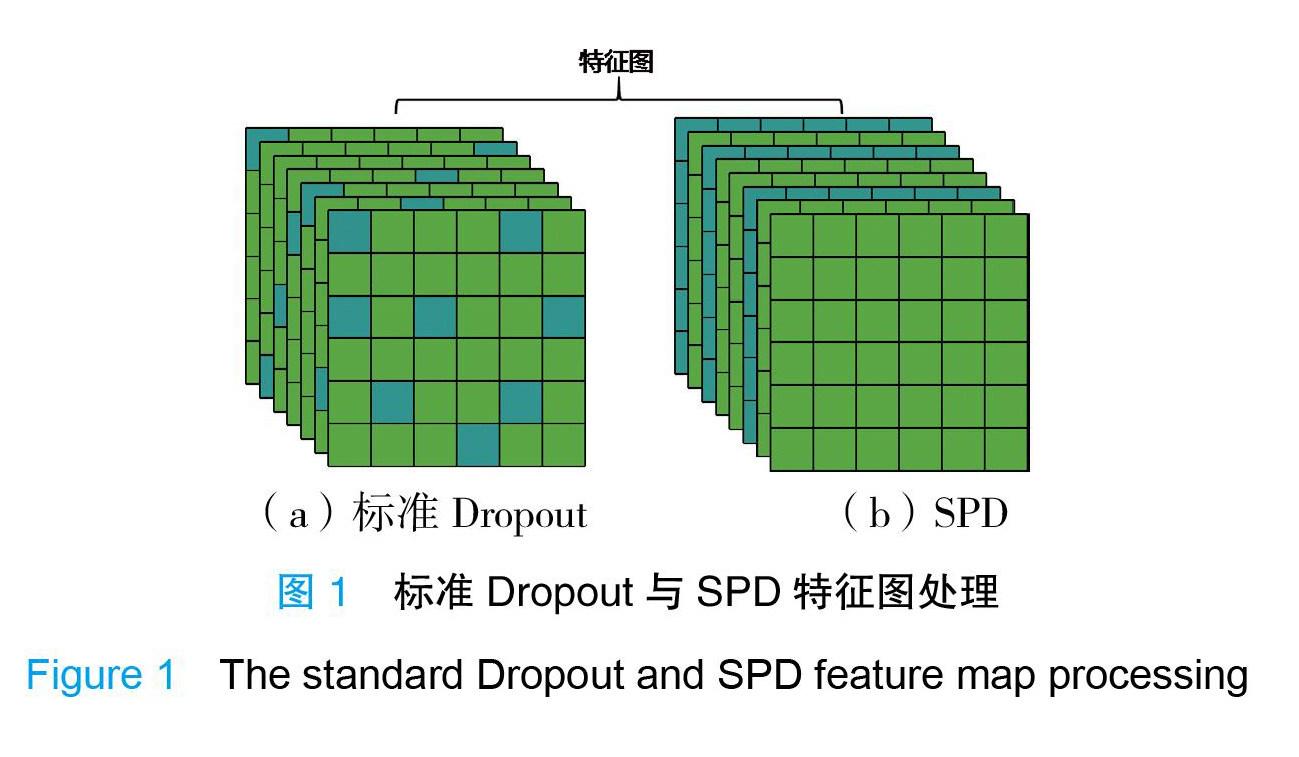

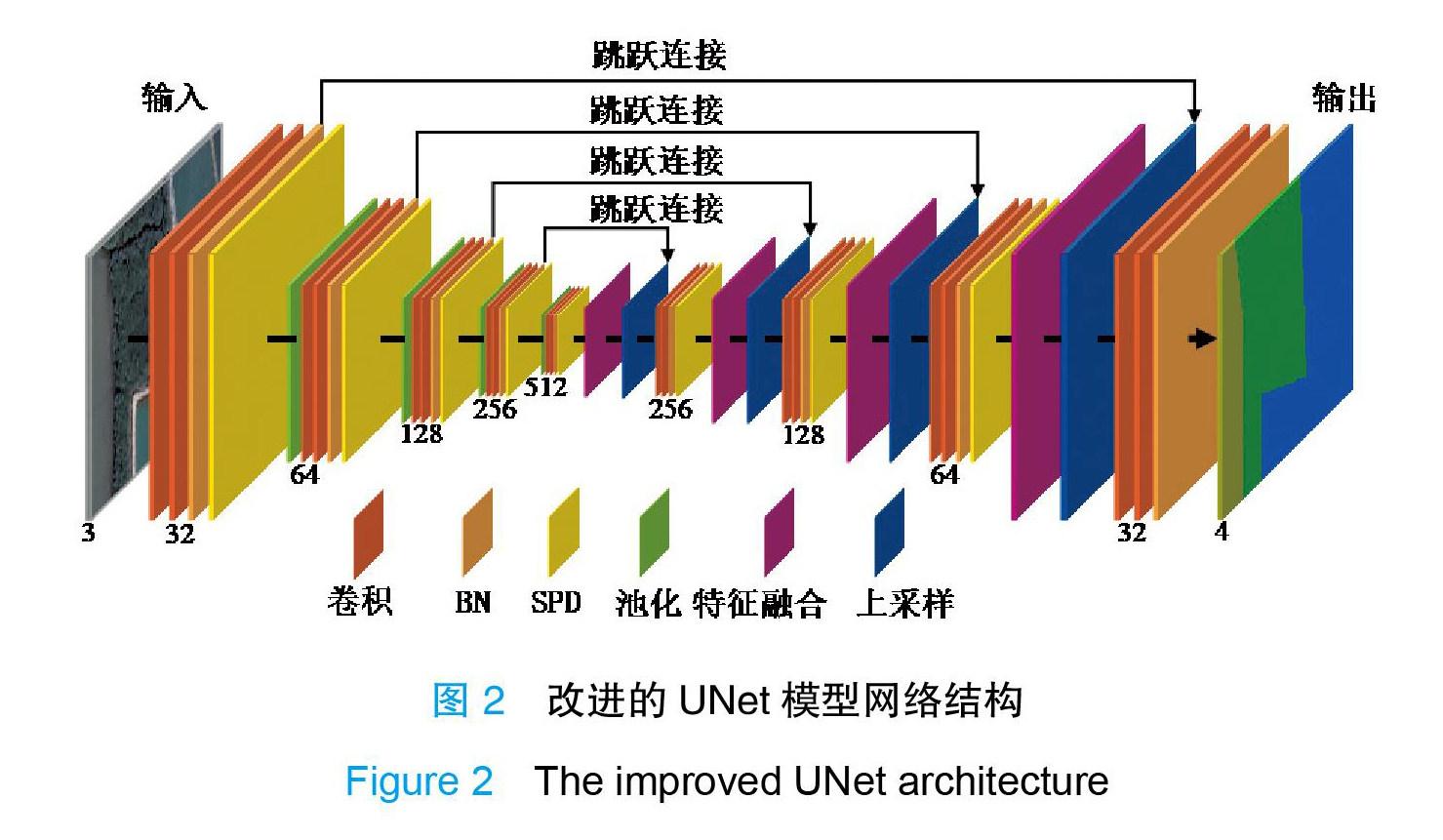

在除背景類別外的 3 類監管目標地物中,浮筏養殖相較于紅樹林和圍塘養殖的空間尺度較小。為充分利用低級特征圖細節信息提高小尺度目標分類精度,研究采用了基于跳躍連接尺度融合策略的 UNet 模型進行實驗,并對 UNet進行了改進: 將批歸一化(bach normalization,BN)[19] 和空間置棄(spatial dropout,SPD)[20]模塊引入多目標語義分割任務中,改善模型分類精度和泛化能力。SPD 與 Dropout 相比,隨機將若干特征圖層置棄,不僅實現降維,同時可以減少噪聲。Dropout 算法隨機地將特征圖中獨立神經元數值置零,如果相鄰特征之間存在較強的相關性,則 Dropout 無法對輸出進行歸一化處理,而 SPD 有助于提高特征之間的獨立性。圖1 展示了Dropout 和SPD 對特征圖處理的區別。另外, 雖然有研究已在UNet 中引入BN 層,但多將其置于單個卷積層之后、激活層之前, 而本研究將 BN 置于若干個卷積層(卷積塊)和激活層之后,如圖2 所示。

研究設計了 4 組實驗,實驗組分別命名為:MUNet、MUNet-BN、MUNet- BN-SPD 和 MUNet-BN-SPD-500。其中,MUNet 對標準 UNet 結構中卷積核數量和層數進行了修改;MUNet-BN 在 MUNet 結構基礎上增加了 BN 層,并將其設置于若干個卷積層和激活層之后;MUNet-BN-SPD 在 MUNet-BN 基礎上增加了SPD 層;MUNet-BN-SPD-500 表示訓練迭代次數為 500,而前 3 組設置為 200。圖2 以 MUNet-BN-SPD 為例展示了研究改進的 UNet 模型網絡結構。模型的輸入為 3 通道樣本圖塊。其中卷積核采用 3×3 像素大小;每個卷積塊中卷積核數量分別取值 32、64、128、256 和 512。基于填補處理后,每個卷積塊中的各特征圖層分辨率保持一致。所有經過最大池化操作的特征圖尺寸縮小為原始尺寸 的一半。每個卷積塊最后一個輸出層,如 MUNet 的卷積層,MUNet-BN 的 BN層和 MUNet-BN-SPD 的 SPD 層,采用雙線性插值法上采樣還原為與前一個卷積塊特征圖層一致空間分辨率的上采樣層。特征融合采用跳躍連接,將上采樣圖 層與低層卷積塊中相應的卷積層或BN 層做融合處理。融合方法采用特征圖堆砌, 即沿著圖層通道疊加。最后,使用 1×1 卷積操作與 Softmax 分類器獲得包含 4個類別(包含 3 類目標和 1 類背景)的輸出分類圖。

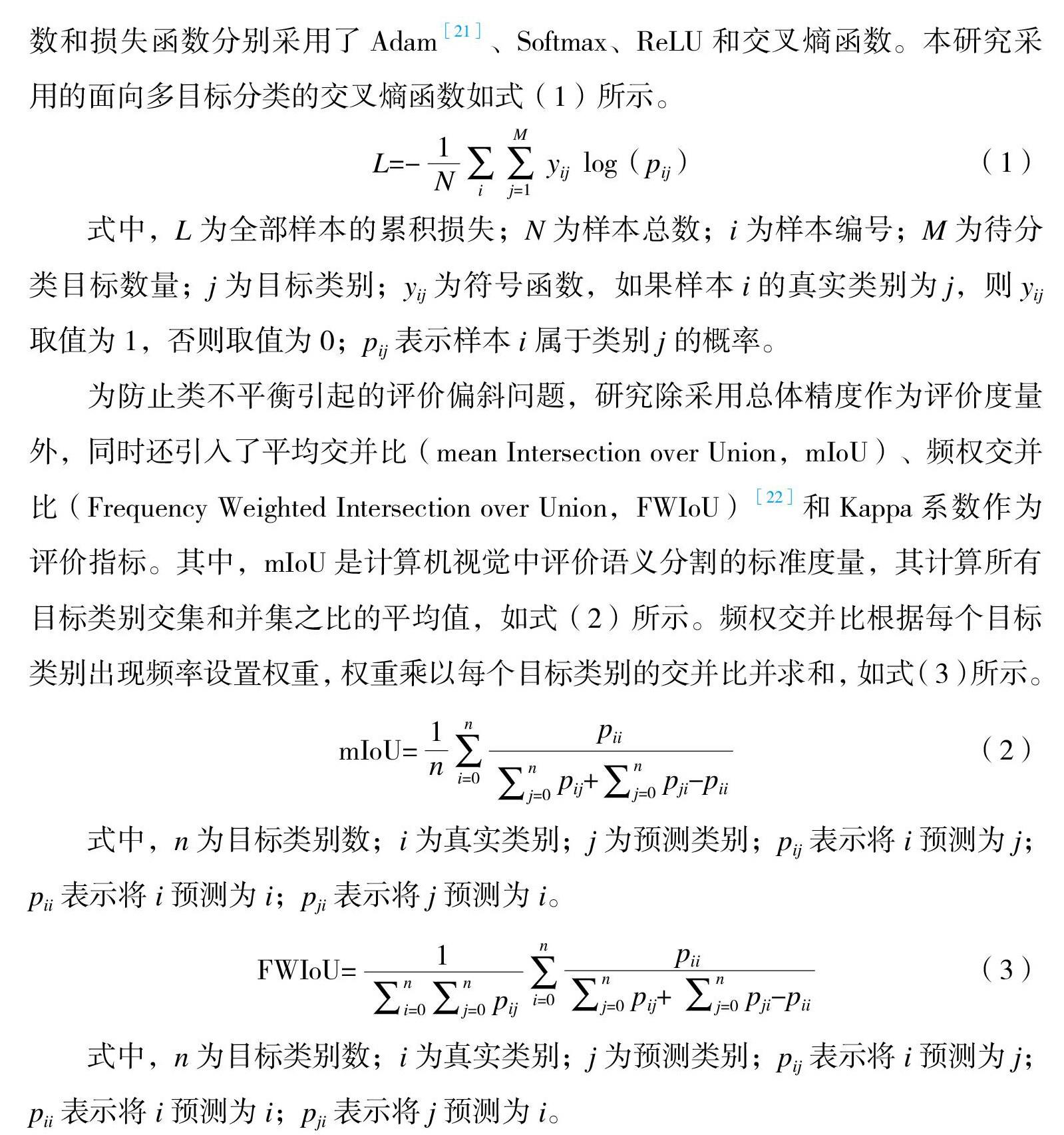

DCNN 模型超參數主要包括學習率、樣本分組大小和迭代次數,改進的UNet 模型分別采用 0.001、64 和 200 進行實驗。模型優化器、分類器、激活函數和損失函數分別采用了 Adam[21]、Softmax、ReLU 和交叉熵函數。本研究采用的面向多目標分類的交叉熵函數如式(1)所示。

1??? M

L=- N ∑∑ yij log(pij)??? (1)

i????? j=1

式中,L 為全部樣本的累積損失;N 為樣本總數;i 為樣本編號;M 為待分類目標數量;j 為目標類別;yij 為符號函數,如果樣本 i 的真實類別為 j,則 yij 取值為 1,否則取值為 0;pij 表示樣本 i 屬于類別 j 的概率。

為防止類不平衡引起的評價偏斜問題,研究除采用總體精度作為評價度量外,同時還引入了平均交并比(mean Intersection over Union,mIoU)、頻權交并比(Frequency Weighted Intersection over Union,FWIoU)[22]和 Kappa 系數作為評價指標。其中,mIoU 是計算機視覺中評價語義分割的標準度量,其計算所有目標類別交集和并集之比的平均值,如式(2)所示。頻權交并比根據每個目標

類別出現頻率設置權重,權重乘以每個目標類別的交并比并求和,如式(3)所示。

1 n? pii

mIoU= n ∑ n?????? n

(2)

i=0 ∑j=0 pij+∑j=0 pji-pii

式中,n 為目標類別數;i 為真實類別;j 為預測類別;pij 表示將 i 預測為 j; pii 表示將 i 預測為 i;pji 表示將 j 預測為 i。

FWIoU= 1???? n

pii

(3)

∑n??? ∑n

p? ∑∑n

p + ∑

p -p

式中,n 為目標類別數;i 為真實類別;j 為預測類別;pij 表示將 i 預測為 j; pii 表示將 i 預測為 i;pji 表示將 j 預測為 i。

另外,由于遙感影像尺寸較大,考慮到顯存或內存溢出問題,需要將大圖裁剪成較小的子圖塊輸入模型進行預測,最后將預測結果按照裁剪順序拼接成與原始影像對應大小和像素位置的分類圖像。如果采用常規的滑動窗口裁剪、預測和拼接,由于每個裁剪樣本邊緣區域的語義信息不完整,裁剪邊緣處的小尺度對象分類精度不高,并且容易得到具有明顯拼接痕跡的分類圖像。因此, 研究采用邊緣疊置方法,即有重疊地裁剪影像并在拼接時采取忽略邊緣的策略。如圖3 所示,假設實際裁剪圖像預測結果為 B,拼接結果為 s,如果 s 面積 B 占面積的百分比為 λ,則相鄰裁剪圖像的重疊比例將設置為 1-λ1/2。

3???? 結果與討論

3.1? 多目標濱海生態監管語義分割數據集

基于矢量化、矢柵轉換和子圖裁剪,研究構建了包含 10934 個樣本的多目標濱海生態監管語義分割數據集(multi-object coastal supervision semantic segmentation dataset,MO-CSSSD)。MO-CSSSD 中 每 個 樣 本 分 別 由 大 小 為256×256 像素的 TIFF 格式遙感圖塊和標注柵格圖塊組成。全部樣本被劃分為訓練集、驗證集和測試集,其分別包含的樣本數量為 8734、1100 和 1100。圖 4 展示了數據集樣本示例。圖中黃色區域表示浮筏養殖,藍色區域表示圍塘養殖, 綠色區域表示紅樹林,而灰色區域表示背景。背景主要涵蓋建筑區、海水、裸地和其他植被。需要說明的是,在 MO-CSSSD 中,相鄰區域的圍塘養殖被標注為整體,不單獨分離其岸埂。這些岸埂噪聲相較于目標像元較少,同時包含岸埂的圍塘養殖構成了獨特的模式,有助于識別分類。另外,該噪聲可作為基準, 用于驗證和判定不同模型的泛化能力。

3.2? 模型測試與評價

改進的 UNet 模型實驗結果如圖5 和表1 所示。從定量評價指標值可知,模型 MUNet-BN 整體表現最佳,其總體精度、mIoU、FWIoU 和 Kappa 系數值最高。而不包含 BN 和 SPD 模塊的 MUNet 在本數據集上表現較差,并在訓練過程中產生了嚴重過擬合。

盡管 MUNet-BN 在本數據集上獲得了綜合最優結果,但從圖5 訓練集和驗證集變化曲線可以看出,其在驗證集上的波動較大,Loss 損失值多高于 0.4,迭代后期有輕微過擬合。相比較而言,MUNet-BN-SPD 雖然在相同迭代次數內各評價指標值低于 MUNet-BN 結果,但差異較小,并且前者在訓練過程中的驗證集 Loss 損失值更低,與訓練集變化一致,擬合得更好。為量化這種差異,研究將實驗 1~3 組每輪迭代的訓練 Loss 損失值和驗證 Loss 損失值做均方誤差計算, 得到的結果分別是:0.75、0.29 和 0.02。MUNet-BN-SPD 表現出最好的過擬合抑制特性。因此,面對多目標語義分割或分類任務,BN 與 SPD 的聯合使用有助于緩解因噪聲或類不平衡導致的過擬合。

模型 MUNet-BN-SPD 訓練過程中,其精度仍然表現出上升趨勢。因此,研究基于原網絡結構和超參數設置,增加了迭代輪數,再次訓練,并計算了其各項評價指標。結果如表1 組號 4 所示。隨著迭代輪數的增加,MUNet-BN-SPD 的各項評價指標值逼近或等于 MUNet-BN 結果。

圖6? 展示了研究選取的具有代表性的測試樣本可視化預測結果。其中,影像 1 類別要素包含紅樹林、圍塘養殖及易與圍塘養殖混淆的海水背景類;影像 2包含紅樹林、圍塘養殖及易與紅樹林混淆的其他植被背景類;影像 3 包含多尺度浮筏養殖和海水背景類;影像 4 包含圍塘養殖和復雜背景類(同時包含海水、裸土和建筑)。另外,由于數據集中未有同時包含 4 類目標的樣本,為驗證模型處理所有多目標類別能力,研究從測試集中隨機選擇了 4 組樣本,經過裁剪、重采樣和圖像拼接后,構建了一組融合樣本,并將其輸入模型進行預測。在圖6 中,樣本從左至右依次為:輸入遙感圖像、真實標注柵格圖塊、MUNet 分類圖、MUNet-BN 分類圖、MUNet-BN-SPD 分類圖和 MUNet-BN-SPD-500 分類圖。

可視化結果更直觀地展示了模型對包含不同尺度目標和復雜輸入圖塊的響應細節。結果表明 MUNet 模型在本數據集上的預測誤差較大,而增加了 BN 和 SPD 結構的改進模型可以更好地提取分類出目標細節,例如影像 1 和影像 5 提

取了更完整的紅樹林。在影像 4 中,研究設置了噪聲,將部分圍塘養殖標注為

背景類別,用來驗證模型泛化能力。結果表明 4 個模型均可較好地辨別噪聲, 獲得正確分類結果。另外,值得注意的是,對于小尺度浮筏養殖預測分類,增加 SPD 模塊并進行特征融合的模型比僅采用 BN 結構的模型得到的結果更精細, 例如影像 3 和 5。在影像 4 中,MUNet-BN-SPD 將海水區域識別成圍塘養殖,表明上述組合也可能帶來冗余噪聲,需要進一步優化。

4???? 結論與展望

本研究以圍塘養殖、浮筏養殖和紅樹林 3 類典型濱海生態監管目標為研究對象,構建了面向濱海生態監管場景的多目標語義分割數據集 MO-CSSSD,并引入批歸一化和空間置棄模塊改進 UNet 模型,改善多目標語義分割任務精度和泛化性能。研究構建的深度學習數據集 MO-CSSSD 為基于人工智能的濱海生態監管目標提取和分類提供研究基礎;置于卷積塊和激活層后的批歸一化與空間置棄模塊組合對多目標語義分割過擬合有明顯抑制作用,促進模型精度和泛化性能的改善;空間置棄與特征融合組合策略可保存更多目標對象空間細節,改善目標分類精度,但也將引入冗余噪聲,需要進一步優化。在未來研究工作中, 作者將基于 MO-CSSSD 數據集,探索多尺度目標的提取與分類精度的改善,并進一步優化模型,減小特征融合引入的冗余噪聲影響。

參考文獻

[1]賀義雄,宋偉鳴,楊帆.長三角海洋資源環境一體化治理策略研究:基于海洋生態系統服務價值影響分析[J].海洋科學,2021,45(6):63- 78.

[2]晁明燦,趙強,楊鐵利,等.基于 Landsat8 影像的藍藻水華提取方法對比研究[J].大氣與環境光學學報,2021,16(6):520-528.

[3]周小成,汪小欽,向天梁,等.基于 ASTER 影像的近海水產養殖信息自動提取方法[J].濕地科學,2006,4(1):64-68.

[4]Kang J M,Sui L C,Yang X M,et al.Sea surface-visible aquaculture spatial- temporal distribution remote sensing:a case study in Liaoning province,China from 2000 to 2018[J].Sustainability,2019,11(24):71-86.

[5]徐福祥,高志強,鄭翔宇,等.基于 MODIS 數據的 2016 年黃海綠潮災害動態監測研究[J].海洋科學,2017,41(5):80-84.

[6]初佳蘭,趙冬至,張豐收,等.基于衛星遙感的浮筏養殖監測技術初探: 以長海縣為例[J].海洋環境科學,2008,27(S2):35-40.

[7]胡園園,范劍超,王鈞.廣義統計區域合并的 SAR 圖像浮筏養殖信息提取

[J].中國圖象圖形學報,2017,22(5):610-621.

[8]Andromachi C,Konstantions T.Impact of intense aquaculture on coastal environments seen by SAR[C]// IGARSS 2020-2020 IEEE International Geoscience and Remote Sensing Symposium.IEEE,2020.

[9]Wang M,Cui Q,Wang J,et al.Raft cultivation area extraction from high resolution remote sensing imagery by fusing multi-scale region-line primitive association features[J].ISPRS Journal of Photogrammetry and Remote Sensing,2017(123):104-113.

[10]Liu Y M,Wang Z H,Yang X M,et al.Satellite-based monitoring and statistics for raft and cage aquaculture in Chinas offshore waters[J]. International Journal of Applied Earth Observation and Geoinformation,2020

(91):102118.

[11]Krizhevsky A,Sutskever I,Hinton G E.Imagenet classification with deep convolutional neural networks[J].Advances in neural information processing systems,2012(25):1097-1105.

[12]Hoeser T,Bachofer F,Kuenzer C.Object detection and image segmentation with deep learning on Earth observation data:A review—Part II: Applications[J].Remote Sensing,2020,12(18):3053.

[13]Long J,Shelhamer E,Darrell T.Fully convolutional networks for semantic segmentation[C]//Proceedings of the IEEE conference on computer vision and pattern recognition.2015:3431-3440.

[14]Sharma A,Liu X W,Yang X J,et al.A patch-based convolutional neural network for remote sensing image classification[J].Neural Networks, 2017(95):19-28.

[15]Ronneberger O,Fischer P,Brox T.U-net:Convolutional networks for biomedical image segmentation[C]//International Conference on Medical image computing and computer-assisted intervention.Springer Cham,2015:

234-241.

[16]Zhao H S,Shi J P,Qi X J,et al.Pyramid scene parsing network[C]// Proceedings of the IEEE conference on computer vision and pattern recognition. 2017:2881-2890.

[17]Lin G S,Milan A,Shen C H,et al.RefineNet:multi-path refinement networks for high-resolution semantic segmentation[C]//In Proceedings of the 2017 IEEE Conference on Computer Vision and Pattern Recognition(CVPR). IEEE,2017.

[18]Chen L C,Papandreou G,Kokkinos I,et al.DeepLab:semantic image segmentation with deep convolutional nets,atrous convolution,and fully connected CRFs[J].IEEE Transactions on Pattern Analysis and Machine Intelligence,2016(40):834-848.

[19]Ioffe S,Szegedy C.Batch normalization:accelerating deep network training by reducing internal covariate shift[C]//International conference on machine learning.PMLR,2015:448-456.

[20]Tompson J,Goroshin R,Jain A,et al.Efficient object localization using convolutional networks[C]//Proceedings of the IEEE conference on computer vision and pattern recognition.2015:648-656.

[21]Kingma D P,Ba J.Adam:A method for stochastic optimization[J].arXiv e-prints,2014.

[22]Garcia G A,Orts S,Oprea S,et al.A review on deep learning techniques applied to semantic segmentation[J].arXiv e-prints,2017.

Multi-scale Objectives Semantic Segmentation for Coastal Ecological Supervision

Chen Yan1?? Yang Xiaotong2?? Xi Yantao3?? Xu Lixiang1? Li Xinlu1

1.??? School of Artificial Intelligence and Big Data, Hefei University, Hefei;

2.??? Department of Marine Mapping and Geographic Information, National Marine Data and Information Service, Tianjin;

3.??? School of Resources and Geosciences, China University of Mining and Technology, Xuzhou

Abstract: To improve the lack of deep learning dataset of coastal ecological scenes and low accuracy of multi-scale objectives semantic segmentation for remote sensing image classification, we take three types of coastal typical ecological supervision multi-scale objectives of mangrove, raft cultivation and pond aquaculture as research objects, constructs a benchmark dataset for coastal ecological supervision, improves the UNet feature fusion by integrating batch normalization and spatial dropout modules, and proposes a multi-scale deep convolutional semantic segmentation model. The model has an overall accuracy of 92% on the test set, a kappa coefficient of 0.87, and a mIoU of 82%. The experimental results show that the coupled stacking of batch normalization and feature fusion spatial dropout can effectively suppress multi- scale objectives semantic segmentation overfitting and improve the model accuracy and generalization performance. The proposed model and the constructed semantic segmentation dataset for coastal ecological supervision can provide decision support for ecological restoration, mapping and comprehensive management in coastal areas.

Key words: Coastal ecological supervision; Artificial intelligence; Mangroves; Mariculture; Benchmark dataset; Multi-scale feature fusion; Semantic segmentation