基于深度學習的航拍圖像自適應拼接方法

潘 文,張海民

(1. 宣城職業技術學院 信息工程系,安徽 宣城 242000; 2. 安徽信息工程學院 計算機與軟件工程學院,安徽 蕪湖 241000)

經濟的高速發展,使我國的工況條件、工業環境、地質地貌等均發生了很大變化,通過傳統遙感技術早已無法滿足人們在信息獲取方面的需求,此時,無人機航拍這種新型信息獲取技術應運而生。無人機擁有靈活輕巧、體積小、機動性強的特點,通過無人機航拍獲取的圖像能夠應用于海洋環境監測、災害監測和評估、衛星圖片合成、地圖測繪、危險區域偵查等多個領域。利用無人機拍攝航拍圖像時,會受到尺度變化、旋轉變化以及光照變化等因素的影響,需要對實施航拍圖像的拼接處理。

縱觀目前的研究成果,圖像拼接主要基于特征、變換域、灰度等方向實現,其中最常用的是基于特征的拼接法。隨著該領域的研究成果越來越多,也有學者提出新的拼接方法。王曉鵬等就傳統拼接方法中的重影、局部扭曲等問題進行分析,通過大視差補全法進行航拍圖像拼接,獲得了很好的拼接效果[1]。李艷玲等從局部圖像融合與簡單變換模型兩個方面對拼接效果提升途徑進行探討,通過分塊曝光補償實現局部圖像融合,降低空間和時間方面的開銷,實現拼接視角的擴大[2]。綜合以上研究成果,結合深度學習技術對航拍圖像拼接進行研究,提出一種基于深度學習的航拍圖像自適應拼接方法,實現精確、快速、高效的圖像自適應拼接。

1 基于深度學習的航拍圖像自適應拼接方法設計

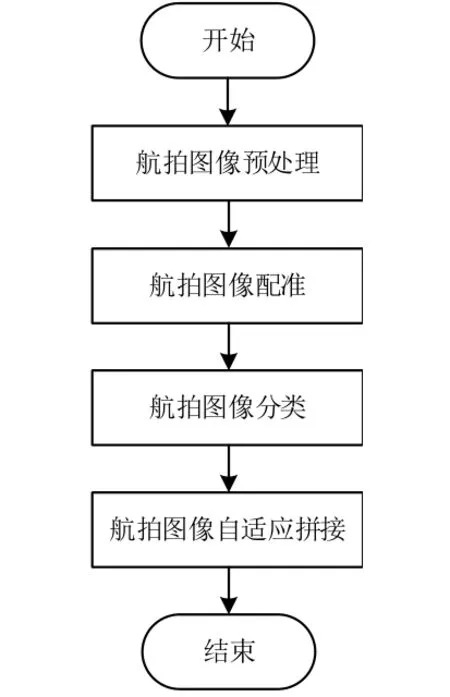

本文提出的基于深度學習的航拍圖像自適應拼接方法,通過輻射校正、幾何校正,對航拍圖像實施圖像預處理,采用精搜索和粗搜索相結合的方式,實施航拍圖像的配準處理。基于深度學習的卷積神經網絡,構建航拍圖像分類模型,實現航拍圖像的分類。通過直線特征來約束網格變形的圖像自適應拼接算法,實現航拍圖像自適應拼接。航拍圖像自適應拼接流程如圖1所示。

圖1 航拍圖像自適應拼接流程圖

1.1 航拍圖像預處理

為有效實現航拍圖像自適應拼接,首先需要預處理航拍圖像。對航拍圖像實施圖像預處理,具體步驟包括輻射校正、幾何校正[3]。

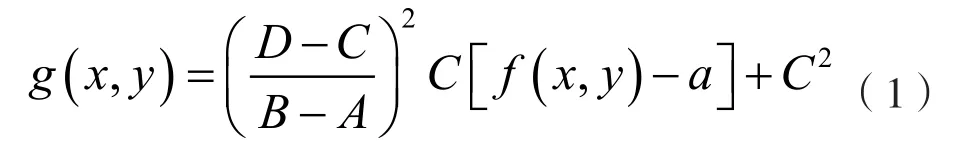

其中輻射校正采用的方法是灰度級線性變換[4]。用公式(1)表示灰度線性變換。

式(1)中g(x, y)指的是變換后(x, y)這一像素點的對應灰度值;f(x, y)是指原圖像(x,y)這一像素點的對應灰度值;B指的是原圖像實際灰度分量的對應最大值;A是指原圖像實際灰度分量的對應最小值;C指的是圖像變換后實際灰度分量的對應最小值;D指的是圖像變換后實際灰度分量的對應最大值[5]。

通常D與C的取值為255、0,此時的線性變換具體如圖2所示[6]。

圖2 線性變換

當原圖像絕大部分灰度級位于[A, B]區間時,僅有一小部分處于該區間外,需要通過公式(2)進行灰度線性變換。

式(2)中,J指的是原圖像灰度最大級[7]。

在幾何校正中,坐標系統變換采用的方法是共線方程,具體處理步驟如下:

①用Q表示攝影中心,用(XQ, YQ, ZQ)表示物空間坐標,用P表示物方空間中的一點,用(X, Y, Z)表示P點的坐標。接著用P表示影像上P點的像點。用(x, y, -t)來表示P點在像空間坐標系中的實際坐標;用(XP, YP, ZP)來表示P點在輔助像空間坐標系中的實際坐標[8]。

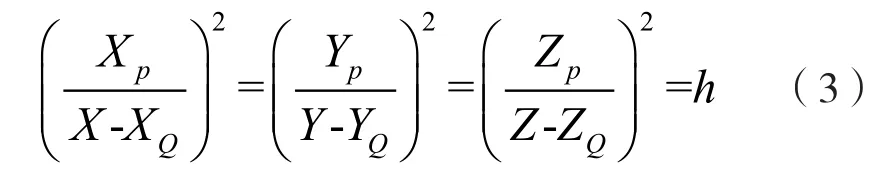

②攝影中心、物方空間中的一點、影像上P點的像點呈現三點共線的狀態,通過相似三角形理論可知像空間坐標系及其輔助坐標系的關系可以用公式(3)表示。

式(3)中,h指的是平方比例因子[9]。

接著根據(XP, YP, ZP)與(x, y, -t)的關系反算式對兩個坐標系的空間關系進行推算,其中(XP, YP, ZP)與(x, y, -t)的對應關系可以用公式(4)來表示。

在公式(7)中代入公式(3),可以獲得公式(8)的共線方程。

③根據公式(8)的共線方程進行攝影測量。

1.2 航拍圖像配準

在預處理航拍圖像后,通過精搜索和粗搜索相結合的方式實施航拍圖像的配準處理,即對相似曲線獲取的匹配位置實施適當地擴展,并將其單獨劃分出來,通過較快速度的傳統配準方法實施縮小范圍內的精匹配,以獲得耗時小、更高精度的匹配[11]。其中精匹配的方法選擇Harris角點檢測[12]。

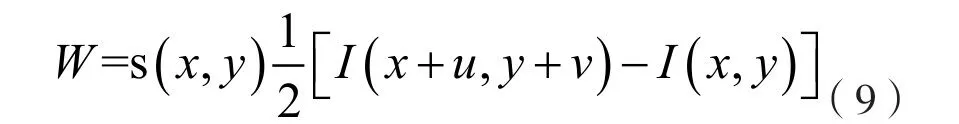

其中航拍圖像窗口平移[u, v]后,所產生的灰度變化可以用公式(9)來表示。

式(9)中,s(x, y)指的是窗口函數;I(x,y)是指航拍圖像實際灰度;I(x+u, y+v)指的是平移后航拍圖像對應灰度。

將公式(9)寫成矩陣形式,具體如公式(10)所示。

式(10)中,Ix指X方向上的差分;Iy指Y方向上的差分。

通過R分析矩陣的特征值,可以對角點、邊緣、平坦區進行判斷。當兩個特征值均較小時,即為變化較為緩慢的平坦區域;當兩個特征值一個小一個大時,即為邊緣區域;當兩個特征值均較大時,即為角點區域。

通過角點響應函數計算R矩陣的特征值,將角點響應函數定義為公式(11)。

式(11)中,L指角點響應函數;detR指R矩陣的一階差分公式;traceR指R矩陣的高斯濾波;x1、x2指角點分布閾值[13]。

1.3 航拍圖像分類

在配準處理航拍圖像的基礎上,基于深度學習實施航拍圖像分類。通過卷積神經網絡構建航拍圖像分類模型,實現航拍圖像的分類。

構建的航拍圖像分類模型中含有很多深度卷積網絡子模型,分別對深度卷積網絡子模型進行訓練,并保存模型參數[14]。當測試時,在各子模型中輸入待測試的航拍圖像,統計多個模型的對應輸出結果,出現次數最多的圖像類別即為模型實際分類結果。

構建的航拍圖像分類模型具體如圖3所示。

圖3 構建的航拍圖像分類模型

1.4 自適應拼接

根據航拍圖像分類結果,實施航拍圖像自適應拼接。設計一種通過直線特征來約束網格變形的圖像自適應拼接算法。

在設計的算法中,首先利用網格劃分航拍圖像,然后利用LSD 算法對直線特征進行提取,將網格頂點坐標集作為依據對局部相似性、全局相似性、直線保護各約束項、局部單應性的總能量函數進行定義[15]。最后于稀疏線性系統中對最小能量誤差的網格頂點集進行求解,以指導網格變形,并完成航拍圖像的融合,最終實現圖像的自適應拼接[16]。

其中求解最小能量誤差的網格頂點集主要使用稀疏線性求解器。在稀疏矩陣中代入約束項,可以獲得公式(12)。

式(12)中,K2指直線約束項的實際殘差向量;J1、J2、J3、J4指在網格頂點集E'處約束項所對應的頂點矩陣;K1指全局相似項的實際殘差向量。

通過對上式進行求解即可獲得最優頂點集E'。

航拍圖像的融合主要通過圖像映射來實現,并通過加權平均融合法實施圖像平滑處理。

2 所提方法性能測試

2.1 實驗數據

通過多組圖像序列對設計的基于深度學習的航拍圖像自適應拼接方法實施性能測試,并分別采用文獻[1]方法、文獻[2]方法和設計方法進行對比,具體評估性能指標包括時間復雜度、視覺不一致性、失真矯正度。

實驗中使用的航拍圖像數據是通過大疆無人機精靈3無人機采集獲得的,在圖像場景中存在明顯直線結構和一定的視差。實驗圖像的分辨率是3 000*4 000,具體如圖4所示。

圖4 實驗數據集

通過實驗數據集對文獻[1]方法、文獻[2]方法和設計方法的性能進行測試。

2.2 時間復雜度測試結果分析

首先測試文獻[1]方法、文獻[2]方法和設計方法的時間復雜度,即對文獻[1]方法、文獻[2]方法和設計方法的圖像預處理、圖像配準、圖像分類、自適應拼接的用時進行測試。

三組數據集的耗時測試結果具體如表1所示。

根據表1三組航拍圖像數據集的耗時測試結果,與文獻[1]方法、文獻[2]方法相比,設計方法的圖像預處理、圖像配準、圖像分類、自適應拼接的用時均較低,說明設計方法的時間復雜度較低,能夠實現較快的圖像自適應拼接。其中圖像分類、圖像預處理步驟的耗時較低;圖像配準、自適應拼接步驟的耗時較高。

表1 三組數據集的耗時測試結果

2.3 視覺不一致性測試結果分析

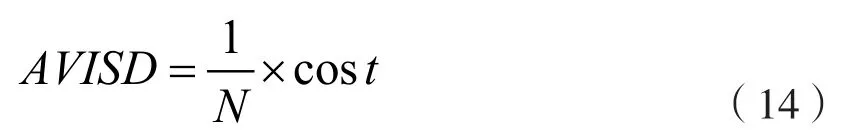

接著對文獻[1]方法、文獻[2]方法和設計方法的視覺不一致性進行測試。主要是將VISD,即視覺不一致性的均值作為評價縫合線優劣的實際度量準則,用AVISD來表示,其計算公式具體如公式13和14。

公式13和14中cost指的是誤匹配度量矩陣;sort{·}是指排序函數;cost(x, y)指的是圖像縫合線代價值;N是指圖像路徑搜索長度。

文獻[1]方法、文獻[2]方法和設計方法的AVISD測試結果具體如圖5所示。

圖5 不同方法的AVISD測試結果

根據圖5的AVISD測試數據,與文獻[1]方法、文獻[2]方法相比,設計方法在將數據集拼接圖像分為四個部分后,每個數據集四個部分的AVISD測試值都較低,說明設計方法縫合線處的拼接效果良好,擁有良好的航拍圖像自適應拼接性能。

2.4 失真矯正度測試結果分析

對文獻[1]方法、文獻[2]方法和設計方法的失真矯正度進行測試,同樣將數據集拼接圖像分為四個部分,對四個部分的失真矯正度進行分別測試,測試結果具體如表2所示。

表2 失真矯正度測試結果

根據表2的失真矯正度測試數據,與文獻[1]方法、文獻[2]方法相比,設計方法在將數據集拼接圖像分為四個部分后,數據集1、2、3四個部分的失真矯正度都較高,說明通過設計方法能夠實現航拍圖像拼接中的高度失真矯正,表示設計方法的航拍圖像自適應拼接性能良好。

3 結束語

在航拍圖像自適應拼接問題的研究中,實現了精確而快速的圖像自適應拼接,具體來說,取得了以下成果:首先,通過航拍圖像的輻射校正、幾何校正處理,實現了航拍圖像拼接前的圖像處理工作,使航拍圖像顏色趨于一致,便于進行后續的拼接處理;其次,通過精搜索和粗搜索相結合的方式進行了航拍圖像的配準處理,使航拍圖像實現了匹配與對齊,直接提升了航拍圖像自適應拼接的精度,通過深度學習實現了航拍圖像分類,便于進行圖像的自適應拼接;最后,設計了圖像自適應拼接算法。本研究取得的成果對于無人機遙感技術的發展有一定啟發意義,但仍存在很多問題尚未解決,將會在后續的研究中進行研究成果的完善。