基于圖文融合的多模態輿情分析

劉 穎,王 哲,房 杰,2,朱婷鴿,2,李琳娜,劉繼明

1.西安郵電大學圖像與信息處理研究所,西安 710121

2.西安郵電大學電子信息現場勘驗應用技術公安部重點實驗室,西安 710121

3.西安郵電大學網絡輿情監測與分析中心,西安 710121

4.西安郵電大學通信與信息工程學院,西安 710121

互聯網時代具有開放性、多元性以及互動性等特點,這促使全民信息交流日趨便利。當下網絡信息傳遞具有如下特點:(1)雙向傳播,信息發布方和接收方交流更加密切,接收方甚至可以對真假難辨的信息進行二次傳播,從而造成虛假信息爆炸式增長。(2)發布門檻走低,對于信息的發布方來說,只要注冊賬號就可以進行信息發布。一個突發的熱點問題就可能對政府和企業造成極大的損失,因而企業和政府只有對輿情事件做出合適的應對決策,才能有效化解負面輿情。目前,針對網絡輿情監測研究,主要圍繞網絡輿情概念、輿情演進特征、輿情信息獲取、輿情分析和預警監測系統建立等方面展開。其中輿情分析是最關鍵的技術之一,而網絡輿情的情感分析尤為重要,其原因在于網絡輿情分析的主要原則是根據民眾對事件的情感態度來判斷事件的走向。

“情感分析”一詞由文獻[2]提出,但最早提出情感分析任務的是Pang 等研究者,他們將文本的主觀計算過程定義為情感分析和觀點挖掘。在線評論的情感分析需要考慮情感強度和情感極性,其主要任務是識別人們所表達的主觀態度或觀點。目前大多數研究者對單模態情感進行了分析,例如文獻[4]調查了一些基于情感分析的機器學習方法,文獻[5]考察了句子層面的情緒,文獻[6]總結了情感分析的主要任務和應用。隨著網絡的多元化發展,人們不再滿足于僅僅使用文字在社交媒體上發布自己的狀態,而是更青睞于文本與圖像結合的方式表達自己的情感。因此,結合文本和圖像信息進行輿情情感分析的研究變得越來越重要。

本文的重點是對網絡輿情的情感分析進行綜述。具體來講,本文以網絡輿情監控系統的構建流程為主線,對基于圖文的網絡輿情情感分析進行了總結,并對網絡輿情情感分析面臨的挑戰和未來的發展方向進行了探討。

1 網絡輿情概述

1.1 網絡輿情的基本概念

網絡輿情是社會輿情在互聯網上反應的一種特殊形式,是網民認知、情感、態度和行為傾向的集合,更多的是民眾情感的體現,涉及時政、環境衛生、公共安全等廣泛領域。社會化媒體公眾參與度的提高促進了網絡輿論的發展,同時也使其傳播方式和演進方式不斷發生變化。針對熱點問題的輿情信息混雜著理性和非理性的成分,如果不能對輿情信息進行正確、及時的處理,可能會產生嚴重的社會后果。網絡輿情分析可以有效掌握公眾對熱點事件的看法,及時預測公共事件的發展趨勢,從而引導輿論健康發展。輿情情感分析綜合了計算機科學、社會學、數學、心理學等多個學科,通過文本、圖片或圖文融合對情感進行分類,進而分析情感趨勢,把握公眾的心理狀態。因此,通過對網絡輿情進行情感分析,可以有效掌握網民的態度、情緒和行為,從而達到疏導和控制網絡輿情事件的目的。

1.2 網絡輿情分析系統概述

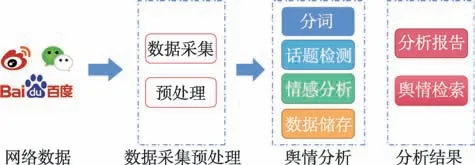

網絡輿情分析系統目的在于對社交媒體上的輿情進行價值和趨向判斷,在工作流程層面,其系統的構成主要包括四個模塊:輿情數據的采集與處理模塊、輿情數據分析模塊、分析結果管理模塊以及輿情報告導出模塊。輿情數據的采集與處理模塊包括輿情數據采集和數據的預處理,其作用是記錄管理輿情信息,同時允許用戶進行信息檢索。數據分析模塊包括話題熱度計算和極性判斷,該模塊負責對收集到的輿情信息進行情感分析。分析結果管理模塊包括分析報告、輿情結果檢索以及進行趨勢分析,其作用是將輿情分析的結果量化,同時分析趨勢并將結果展現出來。輿情報告導出模塊允許用戶將可視化結果根據不同的需要格式保存到本地。其工作流程如圖1 所示。

圖1 輿情分析系統流程圖Fig.1 Public opinion analysis system flowchart

2 基于單模態的網絡輿情情感分析

網絡輿情監測研究最早興起于國外,文獻[8]指出早在20 世紀90 年代Allan 等就將主題檢測和跟蹤技術應用到網絡輿情的數據分析中。隨著網絡的不斷普及和Twitter 等社交平臺不斷興起,Hughes 等人在2009 年通過對突發事件中Twitter 用戶的態度和行為的研究,提出了Twitter 平臺如何疏導網絡輿情的方法。國內研究相對較晚,劉英杰最早對輿情監測系統構建進行了研究,對輿情信息的情感維度在空間的特征和演化規律進行了分析。黃微等人對網絡輿情信息的語義識別技術進行了對比探討。這些早期的研究都對未來網絡輿情檢測研究奠定了基礎。在早期輿情情感分析研究中,主要研究的對象是文本或圖像,所采用的方法大多數是傳統的機器學習方法,例如貝葉斯分類、最大鄰近算法等。近年來,隨著深度學習的不斷發展,研究者們逐漸傾向于用神經網絡來學習文本或圖像的特征以實現情感分析。

2.1 基于文本數據輿情情感分析

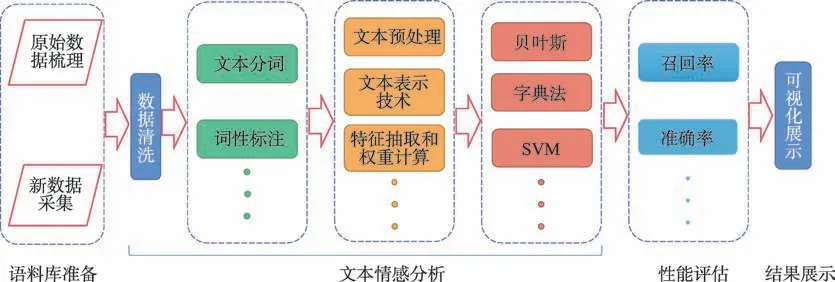

文本數據在新聞、網上評論、自媒體推文等網絡信息中較為常見,是目前網絡信息中的主要數據形式。文本數據的輿情情感分析又稱為數據挖掘,是指對帶有主觀情感色彩的文本進行情感傾向挖掘,并對其情感態度進行分類的過程。本文情感分析過程大致如圖2 所示。

常用的文本預處理策略包含分詞和詞性標注。分詞即將一個連續的句子分割成若干獨立的詞序列,作為文本信息的特征項。常用的方法有基于詞典的分詞方法和基于統計的分詞方法。基于詞典的方法是將分割的字符串與情感字典中的已有詞匯進行對比。例如崔彥琛等人利用PMI-IR(point-wise mutual information-information retrieval)、SO-PMI(semantic orientation pointwise mutual information)等算法,建立了消防輿情詞典,其中包括通用詞典、消防領域情感詞典和網絡語言情感詞典,并證明了其高效性、準確性以及在消防領域的適用性和專業性。該方法的優點是處理簡單,效率高,其不足之處則在于太過依賴于詞典的規模與判別規則。在網絡輿情中,詞語的更新速度快,詞典分詞法很難滿足要求。因此,基于統計分詞的方法得到了較為廣泛的應用,其中最經典的模型為-gram。該模型的原理是給定一個句子,gram 就可以計算出一個概率值。通過列舉出所有可能的分詞方式,再根據所有可能的分詞方式分別計算該句子的概率,選擇使句子概率最大的分詞方式作為最終分詞結果。詞性標注指在分詞的基礎上,根據上下文條件對每個詞進行詞性判斷并添加標簽的過程。例如文獻[14]通過對關鍵詞進行情感標注實現對文本數據的預處理,實驗效果大大提升。

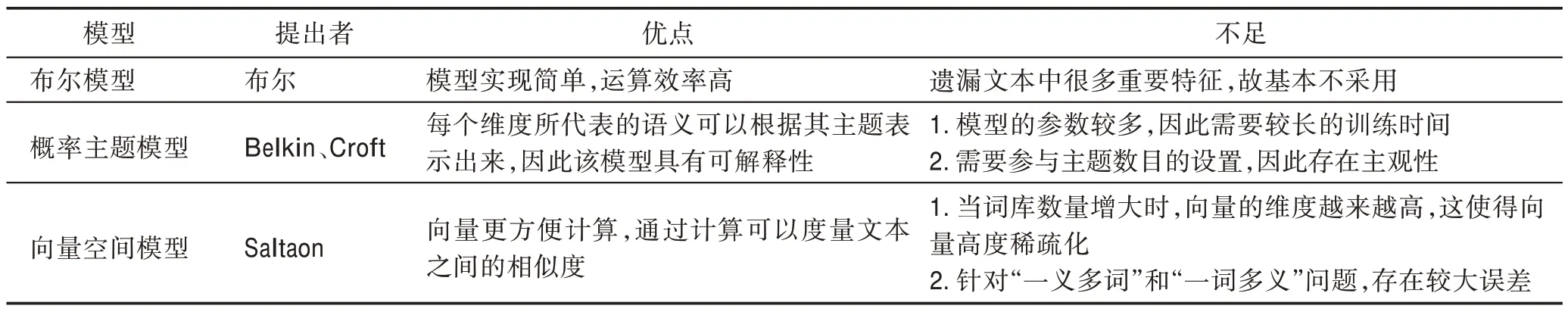

文本表示與特征提取是情感分析中最為關鍵的一步。輿情信息的情感識別,最重要的就是提取出文本中的非結構化信息,從而判斷情感傾向。因此,良好的文本表示模型對于提高情感識別效果至關重要。目前文本表示模型以及優缺點如表1 所示。

傳統上,BoW(bag-of-words)模型已用于提取自然語言處理(natural language processing,NLP)和文本挖掘中句子和文檔的特征。BoW 模型將文檔轉換為具有固定長度的數字特征向量,并對向量中的每個元素進行評分。盡管BoW 受歡迎,但其仍有一些缺點。首先,該向量的維度等于詞匯表的大小,因此隨著詞匯表大小的增加,文檔的向量表示也增加。其次,由于忽略了單詞順序,BoW 模型幾乎不能對單詞的語義進行編碼。第三,每個文檔可以在詞匯表中包含非常少量的已知單詞,導致具有大量零分數的向量,稱為稀疏向量或稀疏表示。

圖2 文本情感分析流程Fig.2 Text sentiment analysis process

表1 文本表示模型及其優缺點Table 1 Text representation model and its advantages and disadvantages

針對此問題,引入了一個更復雜的模型bag-of-grams 的分組詞匯表,這是BoW 模型的擴展,改變了詞匯的范圍,并允許一袋單詞從文檔中獲取更多的意義。該模型可以在短上下文中考慮單詞順序,但它仍然存在數據稀疏性和高維度的問題。

為了克服BoW 模型和-grams 模型的缺點,提出了詞嵌入的技術。單詞嵌入使用神經網絡來學習文本的表示,使得具有相同含義的單詞具有相似的表示。單詞嵌入將詞匯表中的單詞轉換為連續實數的向量。該技術通常涉及將高維稀疏向量嵌入到可以編碼單詞的一些語義和句法屬性的低維密集向量中。嵌入向量的每個維度表示單詞的潛在特征。目前,文本特征提取的最新趨勢集中在Glove(global vectors)或word2vec等大型語料庫上預先訓練的單詞嵌入。

(1)基于傳統方法

傳統的情感分析方法主要基于情感詞典或機器學習,并使用分類、回歸等方法實現特征提取和分類。基于詞典的方法依賴于情感詞典,情感詞典是包含情感極性信息的單詞或短語的列表。2016 年,Saif 等人提出了SentiCircles 模型,通過考慮不同語境下單詞的共現模式來捕捉語義,并更新預先分配的語義情感詞匯強度和極性,從而獲取更合適的情感詞典。該模型在Twitter 文本上的表現比SentiStrength模型更具競爭性。然而,在分析實時Web 平臺生成的評論文本時,其無法及時更新情感詞典,從而導致對新詞情感的識別難度的增加。因此僅使用基于詞典的方法,冗長的分析過程和有限的準確度將限制該技術在本領域的應用。

機器學習方法可分為有監督學習和無監督學習,在數據量足夠、數據類型多樣的情況下,該方法與基于詞典的方法相比,能夠有效避免上述問題。李婷婷等人改進了支持向量機方法和條件隨機場方法,結合多種特征組合,彌補了傳統機器學習方法中特征提取的不足。然而基于傳統的情感分析方法存在數據稀疏問題和字序問題,且需要大量標記的文本。

(2)基于深度學習方法

深度學習可以避免繁瑣的特征選擇過程,自動抽象特征,學習相應的參數,并捕獲復雜的特征。基于深度學習的方法在輸入層和輸出層之間嵌入隱藏層,以模擬其他算法無法學習的數據中間表示。該機制可以有效地從高維數據中學習更深層次的信息。

對于情感分類問題,卷積神經網絡(convolutional neural networks,CNN)由于結構簡單,訓練效率高,廣泛用于文本情感分類。Stojanovski等人使用CNN提取消息文本的特征,并融合不同的分類算法對新聞相關的Twitter 消息進行情感分析,以提供公眾對某些事件的反應見解。然而單純的CNN 模型在訓練過程中放棄了上下文之間的關系,因此無法很好地解決時序問題,也無法準確分析過渡句子等數據。Sun等人使用區域卷積神經網絡(regions with CNN features,RCNN)來保留句子的時間關系,從而捕獲單詞之間更多的語義關系。因此,他們解決了在處理基于方面的情感分析任務時,傳統神經網絡模型在句子之間的連接較少并且單詞之間的語義信息較少的問題,在基于方面的情感分析中,具有良好的適應性。Chen等人提出了一種稱為雙通道卷積神經網絡的字符嵌入情感分析方法(character embedding with dual-channel convolutional neural network,char-DCCNN)。該方法將中文語料庫劃分為單個中文,然后將它們訓練成字符向量,依次將表示文本的向量矩陣輸入到雙通道CNN 中,通過少量標記數據和少量迭代獲得良好的分類性能。實驗表明,該方法改善了微博中短評論的情感類別結果,然而字符嵌入增加了文本的分布式表示的復雜性和計算成本。

循環神經網絡(recurrent neural network,RNN)能夠循環保持信息(即使用以前的信息連接到當前的任務,并用過去的文本猜測當前的文本)。然而,RNN 有一個明顯的長期依賴性問題:當歷史文本太長時,文本的有效信息無法保存。鑒于此,裴頌文等人提出了一種特殊的RNN 結構LSTM(long shortterm memory),該模型可以充分利用目標情緒詞和句子中情緒極性詞之間的關系。受到該模型的啟發,Xing 等人提出了一種用于情感分析的方面感知LSTM(aspect-aware LSTM,AALSTM),它在上下文建模階段將方面信息整合到LSTM 單元中。該方法在給定方面保留有效信息,同時過濾掉給定方面的無用信息,并且其最終的情緒表示更有效。

羅帆等人將RNN 與CNN 相結合,提出了一種分層神經網絡(hierarchical RNN-CNN,H-RNN-CNN)作為表示情感分析文本的通用模型。為防止信息可能在長文本中丟失,使用CNN 來捕捉句子之間的關系。Rehman 等人提出了LSTM 和深層CNN 的混合模型用于情感分析。與基于CNN 的方法或基于LSTM 的方法相比,該模型具有更高的準確性,然而其更適合具有更多參數的小數據集。Liu 等人提出了一種混合模型,在CNN的基礎上,通過BiLSTM(bidirectional long short-term memory)提取與文本上下文相關的全局特征,并融合兩個互補模型提取的特征。

2.2 基于視覺數據的情感分析

社交媒體中,人們常常在發布動態、觀點等信息的同時會為其配上圖像。其原因在于圖像不僅可以在情感方面影響其他人,而且也能夠直接或間接地表達發布人的態度和情感。“視覺情感分析”的主要目的有兩點:一是模擬并檢測個人可觀察表達的情緒;二是檢測視覺媒體所發布的圖像表達其作者或在觀察者中喚起的情緒。雖然前者從個人(或群體)中提取面部表情或身體姿態從而判斷情感的研究較為成熟,然而后者對于社交媒體中非語言情感表達的基于視覺的情感分析領域研究還是一個較新的領域。在視覺情感分析中,“情感”表現為人們與視覺元素互動的結果。鑒于情感總是朝向對象或實體,視覺情感同樣被定義為視覺內容中存在的對象、場景或事件。例如,一張展示美味食物的圖像可能表達了積極情緒;通過體驗這些圖像,觀眾可能會引發積極情緒。當這些情感體驗被提煉成一組語義標簽時,可以構建計算機視覺問題,以從低級視覺多媒體(即原始像素、運動等)學習功能映射,到分類,本地化和匯總任務中的高級情感標簽。一般情況下,對于一個圖片的情感識別需要由圖像預處理、特征提取、分類器識別三部分組成,其流程如圖3 所示。

其中圖像預處理是為了減小圖像中干擾識別效果的信息,目前常用的預處理操作包括對象檢測技術、單圖像超分辨率技術、圖像增強技術(如縮放、旋轉和平移)。特征提取的目的是提取圖片中與情感相關且區分能力強的特征,是情感識別中最為關鍵的一步。圖像特征一般分為淺層特征、中層特征和深層特征。分類器的識別則是按照特征提取的結果進行分類。

計算機圖像分析算法的起點在于特征的選取。特征是一個數字圖像中“可重復性”的重要部分,算法的成功通常取決于其所使用和定義的特征的合適性。現有的圖像特征一般分為淺層特征、中層特征和深層特征。淺層特征主要指顏色、形狀、線條等特征,中層特征一般指圖像中存在的對象、目標等特征,而深層特征則是指行為、場景和情感等語義相關特征。傳統的關于視覺內容情感語義分析研究大多數是直接建立低級視覺特征和情感語義之間的映射關系,然而,由于社交媒體中的視覺情感語義是由認知語義間接驅動的,該方法不適用于社交媒體中視覺內容的情感分析。此外,社交媒體中的視覺內容也可以自由分享,多樣化的數據與其情感取向之間的關系極其復雜,語義鴻溝問題十分嚴重。

圖3 圖像情感識別流程圖Fig.3 Image sentiment recognition flowchart

為了填補這一語義空白,研究者們努力利用中層表征作為視覺底層特征和情感取向之間的橋梁。近年來,由于深度學習在計算機視覺領域取得了巨大成功,研究者們開始將深度學習技術應用于視覺內容的情感分析和觀點挖掘。因此,現有的社交媒體視覺內容特征提取可以分為基于中層表征的方法和基于深度學習的方法。

現有的基于中層表征的方法主要利用視覺底層特征形成中層情感本體進行概念檢測,而忽略了本體概念之間的區別和聯系。Yuan 等人定義了一個通過提取場景描述符的底層特征,并利用四個特征對分類器進行Liblinear 訓練,生成102 個預定義的中層屬性,然后利用這些屬性預測情感。與直接使用視覺底層特征的方法相比,該方法使得情感預測結果更具解釋性。Borth 等人提出了另一個具有代表性的中層表示框架,如圖4 所示。

他們使用形容詞-名詞對(adjective noun pairs,ANP)構建了一個大規模的視覺情感本體(visual sentiment ontology,VSO),作為視覺情感分析的中層描述符。他們還提出了一套名為SentiBank的ANP概念檢測器,用于檢測視覺內容中1 200 個ANP。ANP 的響應可以作為視覺情感預測的中間層特征。視覺內容的情感信息主要由圖像中的對象來傳達。因此,Chen 等人提出了一種基于VSO 和SentiBank 的視覺情感概念分析方法。他們首先定位視覺內容的對象,然后用形容詞來描述相關屬性,將ANP 檢測問題分解為目標定位和概念建模。該方法將情感語義分析與目標檢測相結合,為視覺情感分析提供了一個新的視角。然而,結果表明,該方法在提高情感分類性能的同時,增加了計算復雜度。為了解決基于VSO的模型中ANP 與視覺內容的情感取向相關性的問題,Cao 等人提出了一種用于視覺情感分析的視覺情感主題模型(visual sentiment topic model,VSTM)。VSTM 的主要優點是包含了對視覺內容主題的宏觀描述。現有的基于VSO 和SentiBank 的應用程序將ANP 概念的響應作為中間層特征,忽略了這些ANP概念的情感信息。為解決此問題,Li等人提出了一種充分利用ANP 文本情感信息的方法。他們根據ANP 的文本情感值和圖像中相應的響應來計算圖像的整體情感值,然后將圖像情感值作為一維特征進行圖像情感預測。實驗結果表明,利用文本情感分析提高圖像情感分析的性能是可行的。

深度學習采用多層模型將底層特征轉化為抽象的特征空間,與人工特征相比,可以更好地描述輸入數據的內在信息。更重要的是,社交媒體中大量的視覺數據可以為深度學習提供足夠的訓練樣本。現有的基于深度學習的視覺情感分析方法可以分為兩類:端到端模式和管道模式。

端到端方法嘗試使用諸如卷積神經網絡(CNN)之類的深度模型來建立圖像像素和視覺情感取向之間的映射。在端到端的方法中,文獻[42]提出了兩個條件概率神經網絡(conditional probability neural network,CPNN),稱為二進制CPNN(BCPNN)和增廣CPNN(ACPNN),其目的是預測一組已考慮的標簽上的概率分布。文獻[43]改變了預先訓練的CNN 對象分類的最后一層的維數,以提取所考慮的情緒標簽的概率分布,將原有的損失層替換為分類損失和情感分布損失通過加權組合集成的函數,然后對修改后的CNN 進行微調,以預測情緒分布。文獻[44]訓練了一個CNN 進行情緒分析,然后實證地研究了每個層的貢獻,使用每一層的激活來訓練不同的線性分類器。同時,還研究了權值初始化對微調的影響,通過改變輸出域,根據實驗結果和觀察結果提出了一種改進的CNN 架構。

圖4 中層語義情感分析流程Fig.4 Middle-level semantic sentiment analysis process

基于管道模式的視覺情感分析中,研究者首先利用深度學習模型建立視覺內容到認知語義的映射關系,然后基于認知語義預測視覺內容的情感取向。一般來說,基于管道模式的深度學習方法更易于理解,因為它們模擬了人類的視覺感知。然而,概念(或事件)檢測性能是影響這些方法性能的關鍵因素。例如,Chen 等升級了文獻[37]中提出的SentiBank。他們使用深度卷積神經網絡來檢測圖像中存在的本體概念。文獻[40]通過提取一組描述圖像的ANP 來表示圖像的情感。然后,以相應的ANP 響應作為權重,計算提取出的文本情感值的加權和。利用從圖像中提取的ANP 組成文本的情感,而不是只考慮在SentiBank中定義的ANP 響應作為中層表示,最后使用邏輯回歸器來推斷情感傾向。在最先進的方法中,與用戶的社交圖像相關的文本噪聲問題是非常普遍的。Ahsan 等人提出了一種基于管道模式的深度學習方案來分析社會事件圖像的視覺情感。他們首先生成一系列社會事件概念,并利用CNN 架構計算出相應的概念得分,然后根據這些概念得分預測社會事件圖像的情感取向。

所有這些視覺情感分析方面的工作都表明了更高精度技術的潛力,然而情緒的多面性表明單獨的視覺情感分析將無法在多媒體數據中充分衡量或描述人們的體驗傾向和意見。

3 圖文融合的輿情情感分析

近年來,在情感分析領域出現了許多新的觀點,特別是在視覺情感分析方面。例如,在人工智能領域取得巨大成功的深度學習,已經開始應用于不同類型社交媒體數據的情感分析。當前,研究者們主要致力于社交媒體文本的情感提取。然而單一模態的輿情情感分析有很多不足,其信息很容易受到其他因素的干擾,從而造成情感分析效果不理想。圖片包含著太多的個人主觀性,不利于情感判斷,圖5形象化展示了單模態的不足。目前,在輿情信息中,圖片是除文本信息以外用戶使用最為廣泛的數據,因此圖文融合的輿情情感分析成為當前的熱點。

圖5 單模態情感分析的不足Fig.5 Shortcomings of monomodal sentiment analysis

基于圖文的輿情情感分析是多模態情感分析的一部分,目前仍處于起步階段。文獻[48]采用了圖文融合的情感分析方法,該算法證明了圖像特征與文本特征的互補關系。其實驗結果表明,相較于單模態的實驗結果,基于圖文的情感分析具有更好的效果。進行圖文融合情感分析,最重要的一步是提取文本特征和圖片特征,隨后根據圖文的融合策略判斷情感類型。圖文融合輿情情感分析的一般過程如圖6所示。

圖6 圖文融合情感分析過程Fig.6 Image and text fusion sentiment analysis process

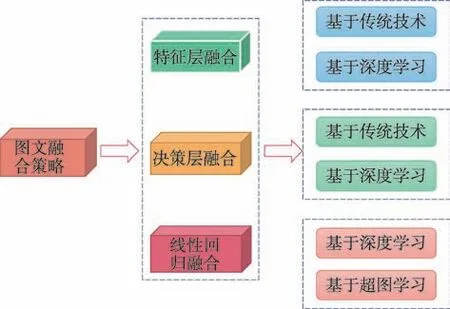

圖文融合策略主要是關于圖文信息的融合和圖文相關性的融合,包括特征層融合、決策層融合和一致性回歸融合,具體如圖7 所示。

圖7 圖文融合策略分類Fig.7 Image and text fusion strategy classification

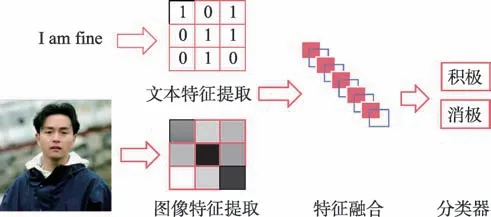

3.1 基于特征層融合的輿情情感分析

基于特征層融合的過程是在特征層上對情感信息進行處理,使其融合特征具有兩個模態的信息。首先分別提取文本和圖像的情感特征,接著將提取到的特征通過直接或加權連接的方式結合在一起而形成融合情感特征,最后輸入到分類器中進行輿情情感分類。特征層融合流程如圖8 所示。

圖8 特征層融合過程Fig.8 Feature layer fusion process

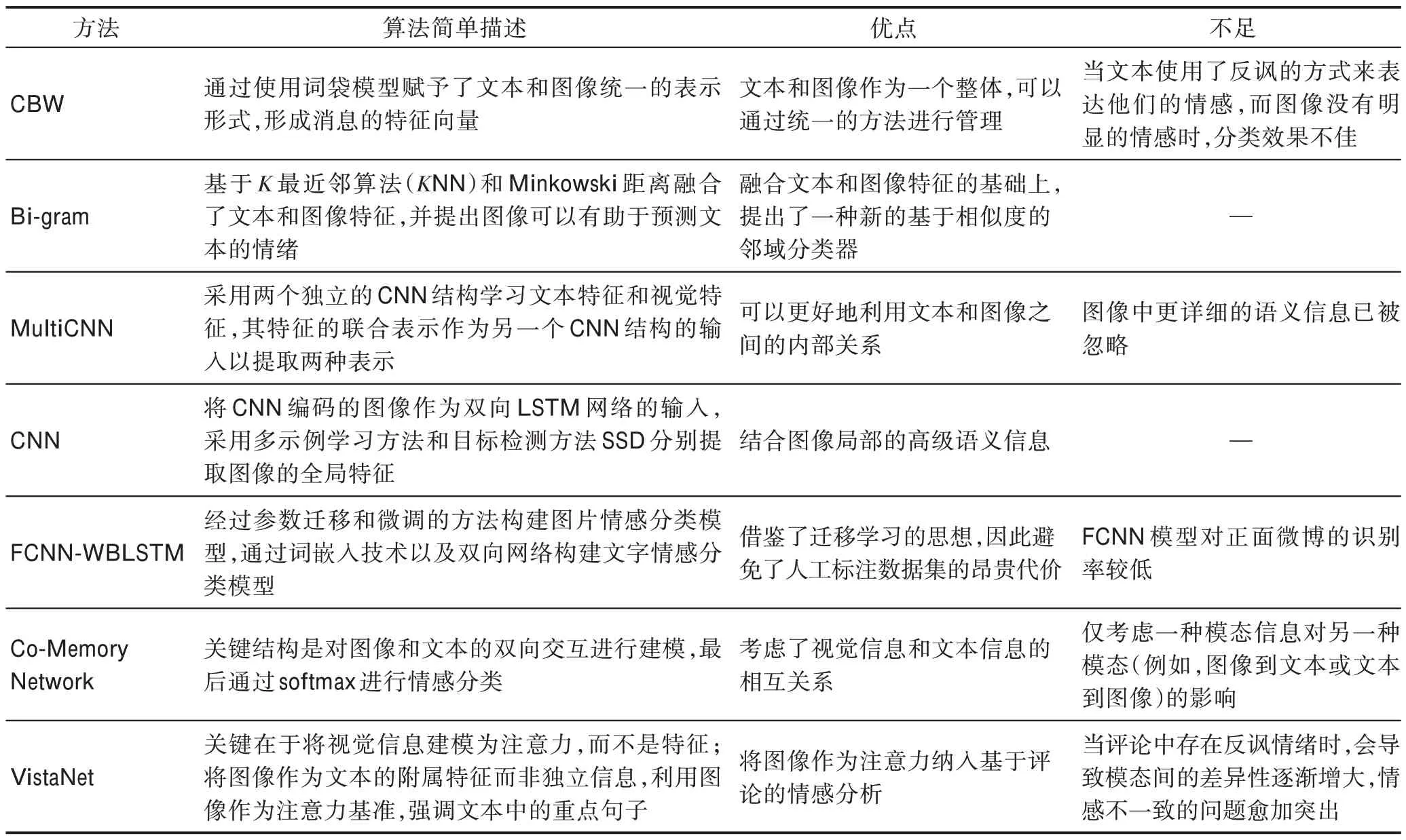

(1)基于傳統技術的情感分析

文獻[50]提出了一種跨媒體詞袋模型。對于多模態圖文分析,通過使用詞袋模型賦予文本和圖像統一的表示形式,從而形成消息的特征向量。在此基礎上,應用Logistic回歸進行情感預測。文獻[51]基于NN(-nearest neighbor)和Minkowski距離融合了文本和圖像特征,使用Bi-gram 模型進行特征提取,其提取文本特征的同時提取圖像的顏色和紋理信息,并提出了一種新的基于相似度的鄰域分類器。其主要思想為選擇有價值的特征,并處理這些消息上的情感極性分類(二分類)。具體過程為:首先計算一個測試集中的帖子和另一個訓練集中的帖子的文本和圖像的余弦相似度。然后構建一個二維空間,其中兩個軸分別代表文本和圖像,一個點由文本和圖像的余弦相似度組成。最后將該點與(1,1)之間的距離視為最終的相似度(即距離越小,這兩個帖子越相似),并基于NN 獲得該帖子的分類結果。

(2)基于深度學習的情感分析

文獻[52]提出了一種基于卷積神經網絡(CNN)的多媒體情感分析方法,其主要針對圖像中文本和視覺信息的情感預測問題。該框架的總體架構由三個組件組成:文本CNN、圖像CNN 和多CNN。通過兩個獨立的CNN 學習文本特征和視覺特征,其特征的聯合表示作為另一個CNN 的輸入以獲取兩種表示。以此為基礎使用Logistic 回歸作為分類器進行分類。文獻[53]提出了一種多模態情感分析框架,解決了圖像局部的高維語義信息問題。對于圖像特征的提取,采用了圖像描述的方法,并在圖像描述模型中采用了目標檢測與多示例學習對作為輔助,提取精細化的圖像特征。將CNN 編碼的圖像作為雙向網格LSTM 的輸入,采用多示例學習(multiple instance learning,MIL)方法和目標檢測方法(single shot multibox detector,SSD)分別提取圖像全局特征和圖像中所有獨立物體所在的矩形框。通過注意力模型(attention model)綜合了LSTM 的輸出與SSD 提取出的兩方面信息。對于文本特征,使用多層卷積神經網絡(CNN)進行文本特征提取,最后的文本特征經過softmax 全連接層輸出。特征融合階段,為了圖像特征與文本特征的統一,首先使用單層的一維卷積對圖像特征進行編碼,然后把編碼后的圖像特征與文本特征融合,并經過softmax輸出進行情感預測。文獻[54]提出了一種圖文融合的微博情感分析方法。該方法首先經過參數遷移和微調的方法構建圖片情感分類模型FCNN(fine-tuned CNN),得到圖片的情感極性概率;然后通過詞嵌入技術以及雙向網絡構建文字情感分類模型WBLSTM(word-embedding bidirectional LSTM),得到文字的情感極性概率;最后根據late fusion 融合思想對圖片情感極性概率和文本情感極性概率進行融合,從而對圖文微博的情感極性進行預測。文獻[55]提出了一種共記憶網絡模型進行多模態情感分析,其關鍵是對圖像和文本的雙向交互進行建模。首先分別使用一個視覺記憶網絡和文本記憶網絡提取特征表示,并引入注意力機制聚集關鍵內容。然后通過共同記憶網絡通過迭代將圖像特征輸入到文本記憶網絡中查詢關鍵字,將文本特征輸入到視覺記憶網絡中查詢圖像的關鍵內容,并將圖像和文本的最終特征表示向量結合起來,最終通過softmax 進行情感分類。文獻[56]提出了一種視覺方面注意網絡(visual aspect attention network,VistaNet),其關鍵在于將視覺信息建模為注意力,而不是特征。VistaNet 框架是一個三層體系結構,底層為單詞編碼層,通過軟注意力機制將每個詞語賦予一個在句子表征中的“重要性”相對應的權重。中間層為句子編碼層,從底層聚合句子級表示,使用視覺方面注意將其聚合為文檔級表示,同時利用視覺信息來增強注意機制。頂層為文檔指定情感標簽的分類層,獲得文檔的高級表示之后,利用softmax 進行情感分析。

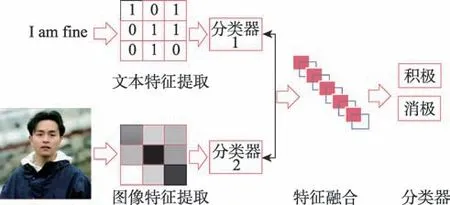

3.2 基于決策層融合的輿情情感分析

決策層融合首先分別提取文本和圖像的情感特征,并將提取的每個模態特征分別輸入各自的分類器中進行情感分類,最后根據兩個模態的分類結果選擇合適的融合規則進行融合和決策。決策層融合流程如圖9 所示。

圖9 決策層融合過程Fig.9 Decision layer fusion process

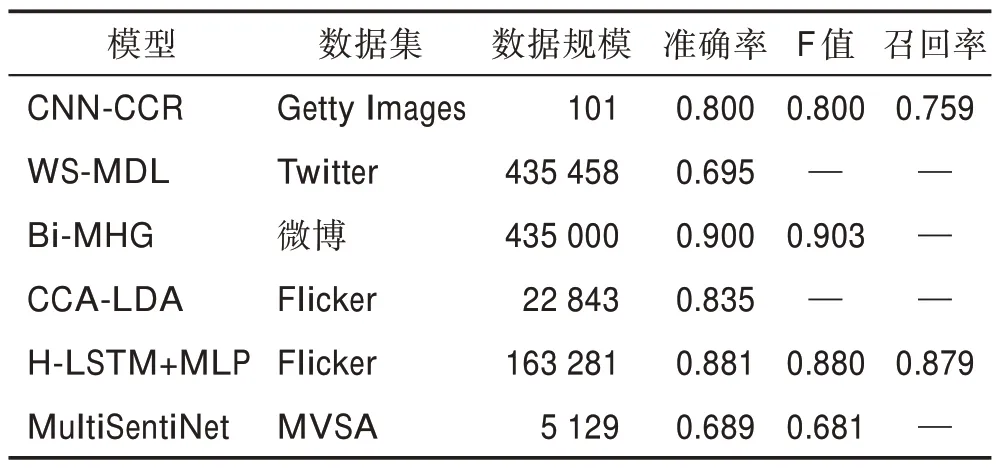

(1)基于傳統方法的情感分析

文獻[57]提出了一種基于轉移變量的圖文融合微博情感分析方法。首先基于主題情感統一模型構建USAMTV(unsupervised sentiment analysis model based on transition variable)模型(基于轉移變量的無監督情感分析模型),該模型通過添加轉發主題轉移變量和連詞情感轉移變量分別處理句子主題從屬關系和情感從屬關系,從而提取文本特征。對于圖片特征,根據文獻[58]中的視覺語義特征提取方法來進行圖片情感分析,并且將其特征以情感濃度指標的方式來影響微博的整體情感傾向,最后整體進行微博的情感分析。

(2)基于深度學習的情感分析

文獻[59]提出了一種深度多模態注意融合(deep multimodal attentive fusion,DMAF)模型,該模型利用了視覺和語義內容之間的區別特征和內在關聯。首先,提出了兩個獨立的單峰注意模型(視覺注意力模型和語義注意力模型),分別學習圖像和文本中最具辨別力的特征和情感分類。在此基礎上,提出了一種基于深度中間融合的多模態注意模型,通過利用不同模式下的互補信息和非冗余信息,將兩個單獨的注意模型結合起來,挖掘不同模式特征之間的相關性,進而進行多模態情感分析。最后,通過后期融合方案對多模態情感進行分類。

文獻[60]提出了一種基于深度卷積神經網絡的微博視覺和文本情感分析,其核心為基于CNN的模型學習信息文本和相關圖像的更高層次的表示。在文本特征提取方面,采用預先訓練的單詞向量訓練文本DNN(deep convolutional neural network)模型,提取文本特征。圖像特征提取方面,通過DropConnect來減少過度擬合來訓練模型,提取視覺特征。最后,使用后期融合來分析模型的性能,并且使用Logistic回歸進行情感預測。同樣是基于卷積神經網絡,文獻[48]試圖通過探索圖文情感特征之間的內部聯系和互補作用,增強圖文微博的情感傾向性預測的準確性。詞向量形式的文本和圖像分別經過基于CNN的情感分析模型得到對應的文本特征和圖像特征,把兩種特征分別經過三個基于CNN 的模型(wordlevel CNN、phrase-leval CNN 和sentence-level CNN)的訓練得到詞語級、短語級和句子級的圖文特征并向量化后輸入分類器WdCla、PhCla 和StCla,得到三種語義級別的圖文情感分類結果。在此基礎上構造一個集成分類器EnsCla 進行決策融合,得到最終的圖文微博的情感極性。

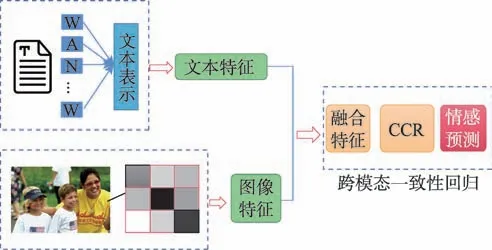

3.3 基于一致性回歸融合的輿情情感分析

特征層融合和決策層融合的方法都忽視了文本和圖像特征之間的一致性關系,但是跨模態一致性回歸模型則很好地解決了這個問題。其主要思想為同一事物通過不同模態的表示所表達的情感是一致的,因此主要是對兩種模態之間的相關性進行學習融合。首先分別提取文本和圖像的情感特征,然后將提取的兩個模態特征輸入回歸模型中,通過相關性學習算法學習相關性權重并進行輿情情感分析。一致性回歸模型流程圖如圖10 所示。

圖10 一致性回歸模型Fig.10 Consistency regression model

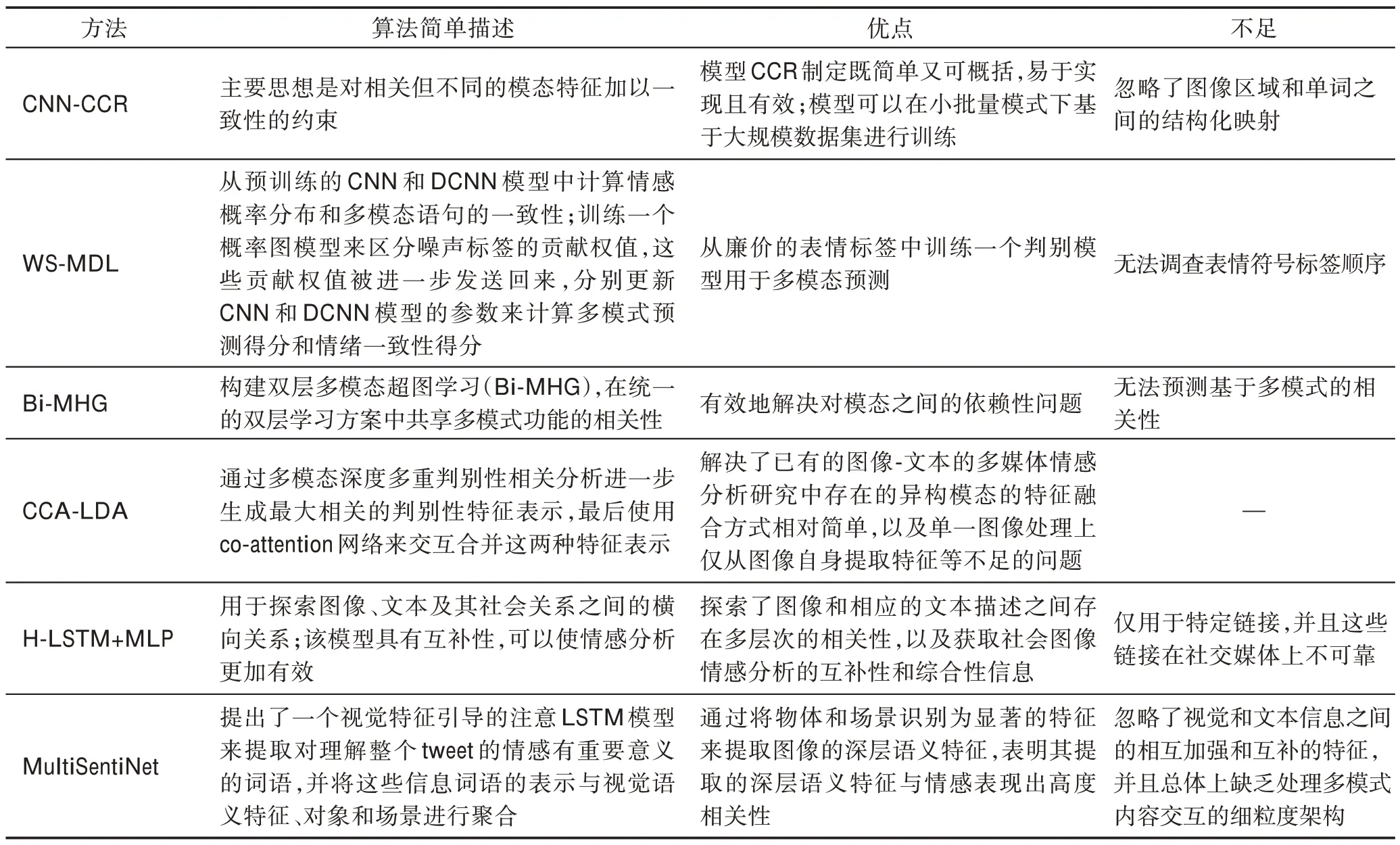

文獻[61]提出了一種跨模態一致性回歸(crossmodality consistent regression,CCR)模型,用于視覺和文本情感分析。其主要思想是對相關但不同的模態特征加以一致性的約束。在視覺特征提取方面,采用類似于文獻[62]的卷積神經網絡進行視覺情感分析,在文本特征提取方面,采用最新的分布式文檔表示進行文本情感分析。最后,通過視覺和文字的特征,訓練出一種跨模式一致的回歸模型,模型在相關但不同的模態之間施加一致的約束,通過集成不同的模態特征進行情感分析。文獻[64]提出了一個弱監督的多模式深度學習(weakly supervised multimodal deep learning,WS-MDL)模型,該模型在統一的框架中解決了目前多模態融合的兩個問題,即挖掘跨多個模態的相關性,以實現模態獨立和人工標注的負擔和主觀性,目前還沒有一個大規模的多模態情感數據集具有精確的人工標注。特別的是將來自社交媒體用戶貢獻的表情通道的情感作為弱標簽來初始化模型學習,并使用CNN 和動態CNN 從圖像和文本模態中獲取傾斜的聯合特征。同時,為了訓練多模態情感分類器,提出了一種多模態卷積神經網絡,它從不同的模式中學習有區別的聯合特征表示。為了推斷標簽噪聲,引入了一種弱監督學習范式,通過概率圖形模型描述了不同模式下預測標簽之間的相關性。實驗結果顯示,該方案在情感預測方面具有較好的效果。

基于超圖的方法除了能夠反映高階信息外,還可以利用大量的未標記數據集,采用傳遞學習的方式。鑒于此,文獻[69]提出了一種名為Bi-MHG(bi-layer multimodal hypergraph learning)的雙層多模態超圖學習方法。該方法包括兩個超圖層,即tweet級超圖和特征級超圖,其目標是捕捉異質模態之間的噪聲相關性,以及允許模型接收缺失模態作為輸入。用一種新的交替優化方法進行雙層超圖學習。最后,根據測試微博的相關度得分得到測試微博的情感極性。

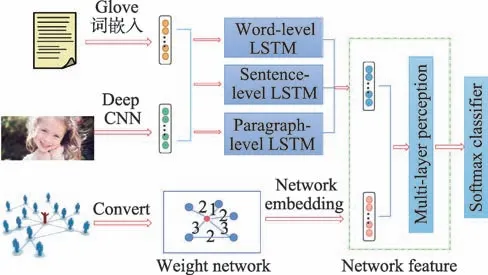

現有的多模態情感分析方法大多只考慮數據內容,這些方法很難有效地捕捉視覺和文本表示之間的非線性關系,忽略了社會圖像之間的聯系信息。針對這些問題,文獻[74]提出了一種層次深度融合(hierarchical deep fusion,HDF)模型,該模型能夠探索圖像、文本及其社會聯系之間的跨模態相關性,學習全面的互補特征,從而進行更有效的情感分析。HDF 模型結構如圖11 所示。

首先,通過三個層次化LSTM(H-LSTM)網絡將視覺內容和文本內容結合起來,并學習圖像和文本在三個層次上的相關性。然后,將社會圖像中的多種類型的鏈接轉化為一個加權關系網絡,通過DeepWalk進行網絡嵌入。最后,將聯合圖像-文本表示和節點嵌入視為輸入到多層感知器(multi-layer perceptron,MLP)的兩個視圖,該多層感知器探索非線性交叉模態相關性,捕獲互補信息以進行多模態情感預測。

圖11 HDF 模型Fig.11 HDF model

文獻[76]提出了一種用于多模態情感分析的深層語義網絡MultiSentiNet,從圖像中提取包括對象和場景在內的深層語義特征作為情感分類的附加信息。具體地,該模型將文本、對象和場景的三重特征定義為多模態tweet 的表示,并將其作為多模態情感分析任務的附加信息。模型結構如圖12 所示。

圖12 MultiSentiNet模型Fig.12 MultiSentiNet model

在視覺方面,選擇VGG模型作為視覺目標提取的目標檢測器,同時使用最先進的場景VGG 模型作為場景檢測器進行場景特征提取。為了更好地理解文本,采用LSTM 模型進行文本特征提取,同時提出了視覺特征引導的注意機制來提取對情感有重要影響的詞語,并將這些信息性詞語的表征與視覺語義特征、對象和場景進行聚合。最后利用高級的三重特性:對象、場景和文本來表示多模態tweet。首先使用融合層來聚合這些三重特征,以獲得最終的多模態表示,然后在頂部添加一個softmax 分類器進行情感分類,最后提出一個視覺特征引導的注意LSTM 模型來提取對整個tweet 的情感有重要影響的詞,并將這些詞的表達與視覺語義特征、對象和場景進行聚合。

圖13 層次化深度關聯融合網絡Fig.13 Hierarchical and deeply interlinked integration network

文獻[79]提出了一種基于層次化深度關聯融合網絡的多媒體數據情感分類模型,該模型能同時兼顧視覺模態和文本模態最大相關性和兩模態各自的線性判別性,解決了圖片和文字之間的精細語義配準問題。層次化深度關聯融合網絡模型如圖13 所示。

首先通過特征提取模型、文本模態和視覺模態特征產生最大相關的判別性特征。然后進一步通過co-attention 網絡融合特征,進而加大深層融合后的特征表示。最后合并最新的圖像視覺特征和文本語義特征,通過全連接神經網絡學習后再輸入情感分類器進行分類。

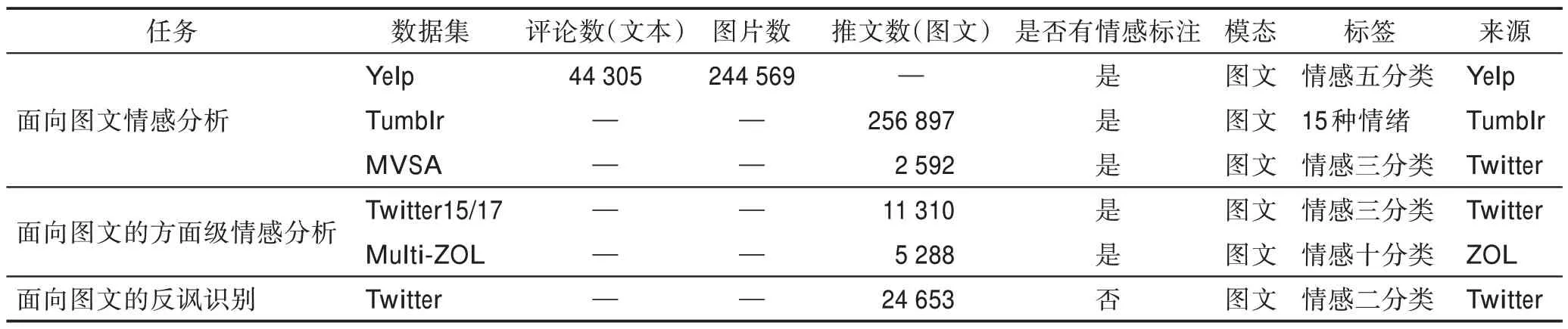

4 基于圖文輿情情感分析數據集

目前,針對圖文情感分析的數據集一般來源于個人制作,對于科研方面基本屬于半公開或不公開狀態。本文將介紹幾種典型的相關公開數據集,以便更好地推動圖文輿情情感分析領域的發展。具體如表2 所示。

Yelp 數據集:該數據集創建于2014 年,是涵蓋商戶、點評和用戶數據的一個子集,數據集包括來自于波士頓、芝加哥、洛杉磯、紐約和舊金山關于餐廳和食品的44 305 條評論,244 569 張圖片。通過1~5 這5個分值對數據集的情感傾向進行標注。可以用于個人、教育和學術。數據集由5 個文件組成,每個文件分別對應一個對象類型,該文件指定了業務ID、用戶ID、星號(介于1 和5 之間的整數值)、審查文本、日期和投票。數據集地址為https://www.kaggle.com/yelpdataset/yelp-dataset。

Tumblr 數據集:該數據集由Bourlai 等人提出。Tumblr 是一種微博服務,用戶在上面發布的多媒體內容通常包含圖片、文本和標簽等。數據集是根據選定的15 種情緒搜索對應的情緒標簽的推文,并且只選擇其中既有文本又有圖片的部分,然后進行了數據處理,刪除了那些文本中原本就包含對應情緒詞的內容,以及那些不是英文為主的推文。數據集共有256 897 個多模態推文。數據集的情感標注包含高興、悲傷、厭惡在內的15 種情緒。

MVSA 數據集:該數據集由Niu等人提出,其中的所有圖像-文本對都是采用一個公共流API的方式從Twitter 收集,同時采用了406 個情感詞匯對其進行過濾,以此來獲取有價值的推文。數據集一共有2 592條圖文數據,數據集的情感標注是積極、消極和中性3種。數據集地址為http://mcrlab.net/research/mvsa-sentiment-analysis-on-multi-view-social-data/。

表2 圖文數據集總結Table 2 Summary of image and text datasets

Flickr 數據集:Flickr 是雅虎旗下的圖片分享網站,該數據集由文獻[83]提出,用于語言相似性的指稱度量的研究。數據集由31 783 張日常活動、事件和場景的照片和158 915 個標題組成。

Twitter15/17 數據集:Twitter15(4 290/1 432/1 459)數據集由Lu 等人提出,用于多模態社交媒體帖子中的姓名標記任務。該數據集通過用體育和社會事件相關的詞語作為關鍵詞進行數據查詢,包含一對推文及其在2016 年5 月、2017 年1 月和2017 年6 月提取的相關圖片。Twitter-17(4 000/3 257/1 000)由Zhang等人提出,用于多模態命名實體識別問題。情感標注為三分類。

Multi-ZOL:該數據集收集整理了中國領先的IT信息和商業門戶網站ZOL.com 上的關于手機的評論。原始數據有5 288 條多模態評論,構成了Multi-ZOL 數據集。在這個數據集中,每條多模態數據包含一個文本內容、一個圖像集,以及至少一個但不超過六個評價方面,分別是性價比、性能配置、電池、壽命、外觀和感覺、拍攝效果和屏幕。對于每個方面,數據集的情感標注是一個從1 到10 的情感得分。數據集下載地址為https://github.com/xunan0812/MIMN。

Twitter 反諷數據集:Twitter 反諷數據集構建自Twitter 平臺,由Cai 等提出,包括2.4 萬條的tweet,圖像和圖像屬性的樣本。數據集按照80%∶10%∶10%的比例被劃分為訓練集、驗證集和測試集。數據集的情感標注為“是諷刺/不是諷刺”二分類。

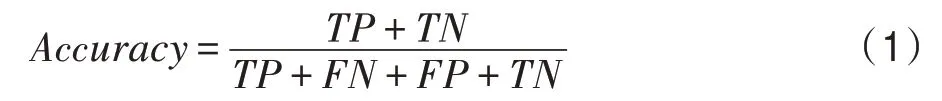

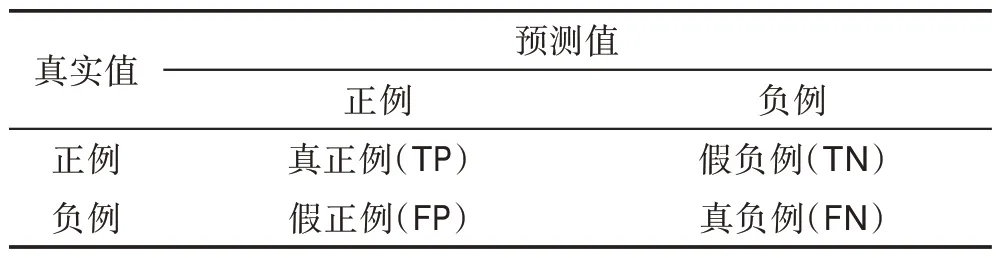

5 算法評價指標及分析

一般來說,準確度是評估不同算法性能最常用的指標。然而,考慮到基準數據集中樣本的不均勻性,僅使用這一指標進行績效評價是不公平的。為了解決這一問題,更好地展示各算法的實驗結果,本文引入準確率(Accuracy)、召回率(Recall)、F1 值三種評價指標進行綜合評價。在具體介紹之前先引入幾個符號,如表3 所示。

(1)準確率:代表所有預測正確的樣本占總樣本的比例,其定義如式(1)所示。

表3 公式符號Table 3 Formula symbols

(2)召回率:針對的是原來的樣本,指的是樣本中的正例被預測正確的概率,其定義如式(2)所示。

(3)F1值:同時把查準率和查全率考慮其中,讓二者同時達到最高,取一個平衡,其定義如式(3)所示。

5.1 基于特征層融合算法分析

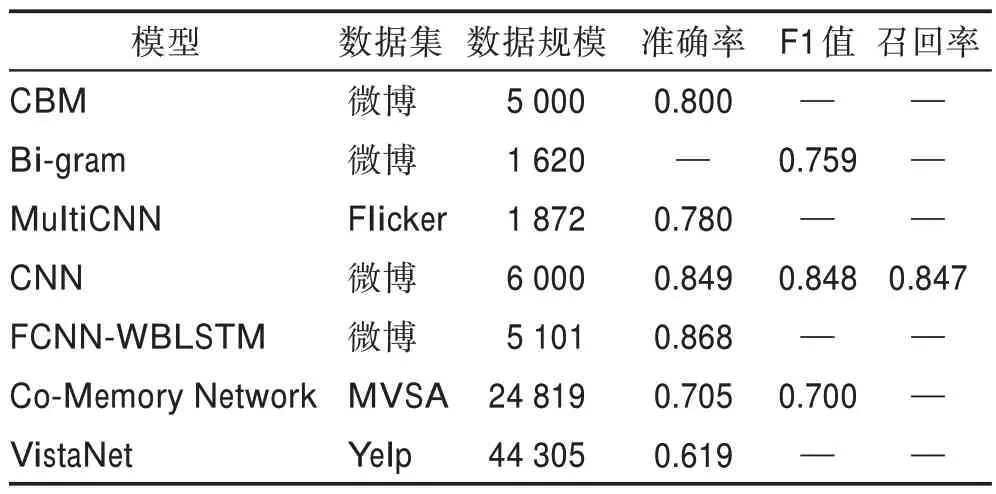

表4 給出了基于特征層融合的實驗結果。表5總結了基于特征層融合算法的優缺點。通過對其優缺點的分析可知,特征層融合方法雖然綜合考慮了兩個模態間的信息,但在處理特征間的差異問題上仍存在缺陷。例如VistaNet 模型,其優勢是第一次將圖像作為注意力納入基于評論的情感分析。然而當評論中存在反諷情緒時,會導致模態間的差異性逐漸增大,情感不一致的問題愈加突出。

表4 特征層融合算法實驗結果Table 4 Experimental results of feature layer fusion algorithms

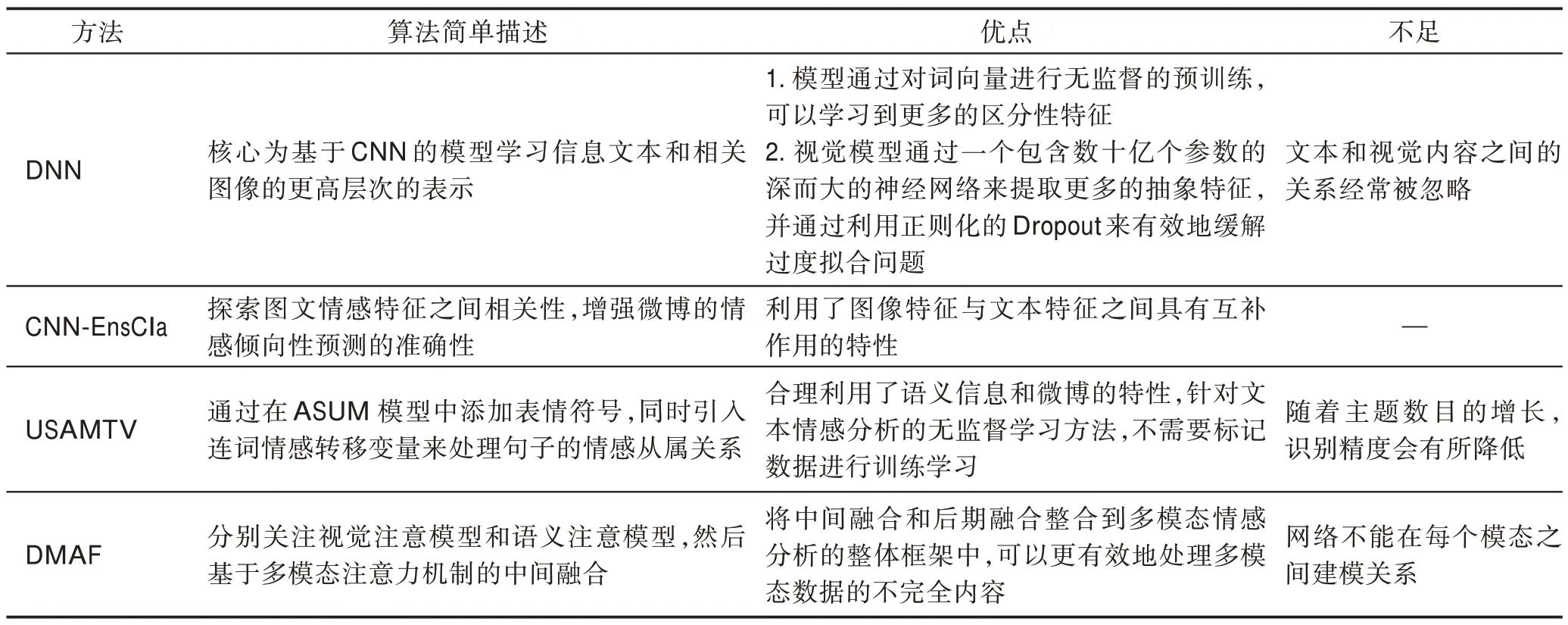

5.2 基于決策層融合的算法分析

決策層融合避免了兩種模態特征由于本質上不同造成的干擾。表6 給出了基于決策融合的實驗結果。表7 列出了決策層融合算法優缺點,從中可以看出特征層融合的不足之處是無法學習到特征之間的情感互補關系。例如DNN 模型,其不足之處是文本和視覺內容之間的關系經常被忽略。因此在某種意義上,如何將兩個模態信息進行有效融合仍是圖文融合輿情情感分析的挑戰性問題。

表5 特征層融合算法優缺點Table 5 Advantages and disadvantages of feature layer fusion algorithms

表6 決策層融合算法實驗結果Table 6 Experimental results of decision layer fusion algorithms

5.3 基于一致性回歸模型算法分析

相較于決策層融合,一致性回歸融合重點關注了文本和圖像的情感特征的一致性。表8 給出了基于一致性回歸融合的實驗結果。表9 總結了一致性回歸算法優缺點,從中可以看出,雖然一致性回歸融合關注了情感特征的一致性,但忽略了文本和圖像情感特征之間的情感異性。

表7 決策層融合算法優缺點Table 7 Advantages and disadvantages of decision layer fusion algorithms

表8 一致性回歸融合算法實驗結果Table 8 Experimental results of consistent regression fusion algorithms

6 總結和展望

總體而言,得益于深度神經網絡強大的特征表達能力,基于深度學習的聯合視覺文本情感分析和視聽內容多模態情感分析取得了突破性進展。盡管如此,社交網絡中的視覺文本數據和網絡視頻的多模態情感分析仍然有許多問題亟待解決。

(1)現有的視覺-文本聯合情感分析方法大多采用不同的融合策略來整合文本和視覺信息,忽略了文本和視覺內容之間的相關性。此外,大量深度學習模型已被應用于現有的聯合視覺-文本情感分析研究中,而社交媒體文本情感分析的豐碩成果卻往往被忽視。因此,如何將已有的文本情感分析研究成果應用到視覺-文本情感聯合分析中,仍值得深入研究。

(2)基準數據集的缺乏是多媒體情感分析,尤其是視覺分析和多模態分析的瓶頸。此外,樣本的不均勻性和情感標簽的不可靠性增加了在不同方法之間進行公平比較的難度。例如,相當多的研究人員在他們自己的數據集上進行實驗,其中許多數據集只包含有限數量的樣本,這些樣本的標簽并不完全正確。更糟糕的是,陽性樣本和陰性樣本的數量往往有很大的差異。在這些數據集上的實驗結果并不令人信服,因為沒有可信的數據集,性能評估就沒有意義。然而,現有的研究很少關注這一問題。因此,收集足夠的樣本,給它們貼上可靠的情感標簽,并將其公之于眾,也是一項有意義的任務。

(3)現有的基于管道模式的視覺情感分析研究通常使用一組概念(如形容詞和名詞)來構建描述視覺內容的本體。在概念檢測過程中,要么對整個圖像進行聚焦,要么只對其中的局部對象進行聚焦,但人類對視覺內容的感知是多維的。因此,可以對視覺內容中的概念進行整體和局部的檢測,從而形成多角度、多層次的視覺內容描述,提高情感分析的性能。然而,如何全面、統一地描述社交媒體中各種各樣的視覺內容并有效檢測情感相關語義,仍是一個有待解決的問題。

表9 一致性回歸融合算法優缺點Table 9 Advantages and disadvantages of consistent regression fusion algorithms

(4)目前,社交媒體用戶將圖像、視頻等視覺內容與文字描述一起發布是非常常見的。在大多數情況下,文本內容和視覺內容之間存在相關性。一方面,文本描述可用于為相應的視覺內容生成情感標簽。另一方面,在視覺-文本情感聯合分析中,可以綜合利用視覺和文本的內容來獲得更可靠的預測。然而,社交媒體消息的文本描述可能會產生噪音或誤導,其原因是評論可能與相應的圖像內容無關。在這種情況下,跨媒體的做法將產生負面影響。因此,無論是視覺情感分析,還是聯合視覺文本情感分析,挖掘和評價文本與視覺內容之間的相關性并加以利用都是一個關鍵問題。

7 結論

隨著社會媒體的迅速發展,多媒體數據已經成為人類情感和觀點的重要載體,因而對社交網絡中的多媒體內容進行情感分析具有重要的科學研究和實際應用價值。本文在對網絡輿情情感分析的相關文獻進行全面回顧的基礎上得出如下結論:多模態用于網絡輿情情感分析是利用互補信息渠道進行情感分析的一種有效方法,其通常優于單模態的分析方法。最后,本文深入探討了潛在的研究方向和研究趨勢。