基于改進深度強化學習的電動汽車充換電站調度技術

胡勇

(許繼電氣股份有限公司,河南許昌,461000)

0 引言

近些年來,隨著新能源技術的不斷發展,節能型汽車逐漸受到越來越多的關注,在其發展進程中,電動汽車以及油電混合汽車成為了未來主要的發展趨勢。與此同時,電力負荷中所占比例的增加要求相應的配套設施也要不斷優化[1]。其中,充換電站(batteryswappingstation,BSS)作為電動汽車能源補給的主要方式,對其進行合理調度對于提高電動汽車應用具有重要意義[2]。為此,不少學者也開展了相關研究,其中,王生生等人利用群智能算法對充換電站調度進行研究,通過模擬自然界生物種群的社會行為,隨機搜索方法可行的調度方案,有效解決了調度研究中的最優化問題,實現了對換電站資源的有效調度,但其在尋優過程中受數據基礎的影響,容易出現局部最優的情況,進而影響作用的調度結果[3-4];在對充換電站調度問題進行研究時,需要注意電池自身的充電損傷問題,由于每塊電池由于充電方式以及充電頻率,耗電速度均不同,這些都對調度決策變量的構建有直接影響,在最小化電池充電損壞的基礎上,如何實現促進充換電站穩定運行,減小其存在的運行風險是充換電站調度研究中需要關注的重點[5-7]。

基于此,本文提出基于改進強化深度學習的電動汽車充換電站調度技術研究,并通過試驗測試驗證了設計方法的有效性。通過本文的研究,以期為提高充換電站調度的合理性帶來幫助,為充換電站的合理布局提供參考價值。

1 基于改進深度強化學習的電動汽車充換電站調度

1.1 基于LSTM的充換電站需求響應模型

為了實現對充換電的合理調度,首先要分析其現有的對充換電的需求響應,為此,本文利用LSTM(LongShort-TermMemory,長短期記憶網絡)構建了充換電站需求響應模型。這種深度強化學習算法是通過在所有可選用方案中不斷“試錯”,在不斷訓練中選擇出最優的方案[8]。本文建立的充換電站響應行為模型是根據充換電站實際響應行為的特點,結合深度學習算法,以充換電站用戶側構建基于LSTM的充換電站響應網模型[9]。由于充換電站響應模型的可靠性與充換電站調度行為需求預測結果的準確性之間有著密不可分的關聯,因此,本文采用深度強化學習的方式對模型的參數進行訓練,通過這樣的方式提高最終充換電站調度的綜合決策結果的有效性[10]。考慮到基于LSTM構建的充換電站響應模型的可靠性主要受請求規模以及需求資源種類影響,本文在現有經驗的基礎上,對LSTM模型預測準確率進行了校驗。

首先,以一個二次函數近似表示需求響應充換電站的響應行為的效益,則充換電站響應模型可以表示方式為

其中,F(x)表示充換電站的響應成本;x表示用戶的實際響應量;λ和γ分別表示不定參數,該參數值以實際充電需求為基準,因此,當提出充換電的電動汽車不同、請求提出時段不同時,λ和γ的取值結果都會發生相應的變化,而二者的變化也決定著可調度資源的規模。

在對充換電站響應行為的學習過程中,本文設置λ和γ以0.25為方差,呈正態分布,且正態分布的期望中心各不相同。以此為基礎,在該分布范圍內隨機取值。此時在搜索最優調度方案的過程中,容易出現跨過空間可行域,導致最終的搜索結果超出可行域,此時得到的結果需要重新進行初始化,為了降低該類問題,本文設置了搜索區間的邊界位置。首先,將超出邊界的結果采用對立點搜索方法在搜索區間重新進行初始化,以競爭機制為基礎保留較優結果,其表示方式為

其中,la和lb分別表示搜索的上限和下限,F’(x)為F(x)的對立結果,通過這樣的方式,得到最優的充換電站需求響應方案。

1.2 電動汽車充換電站調度

在得到可靠的充換電站需求響應方案后,即可根據實際情況對電動汽車充換電站資源進行調度。對此,本文主要分2步進行,首先將充換電請求與電動汽車充換電站進行匹配,其次,根據匹配結果下發與該目標請求相匹配的激勵。但是,值得注意的是,如果將這兩個步驟分別羅列進行會造成動作空間增大,為此本文將上述兩步動作進行了分解處理。將單次需求響應請求拆分成若干個步驟。電動汽車充換電站每次只可選擇一個請求,并對其下屬的資源分發激勵,直至資源儲備的響應量與請求的需求量匹配,或資源儲備量超過請求所需的最大響應量。有考慮到由于請求數量是不穩定的,可能會在短時間內出現大幅度的增加,為此,本文采用卷積神經網絡實現對電動汽車充換電站調度的尋優。

在電動汽車充換電站內部,資源的調度實質上是狀態到動作獎勵值之間的一種映射。充換電站通過聚合電動汽車參與充換電站的不同業務,從資源交換中獲得利潤P,此時對應完成的任務量為n,第i次資源的激勵為Ii,請求的響應量為xi,則每次調度動作的獎勵值ci可表示為

在此基礎上,從時間的角度對請求的用電量以及充換電站的響應行為進行分析,不難看出二者是存在一定關聯性的,因此,本文調用了每個請求的邊緣需求資源,在每次需求響應業務開展時,充換電站首先根據歷史數據對不同請求的響應模型進行訓練,以高置信度為標準,針對每一個請求形成響應模型,以此為基礎的調度方式如下。

首先,對經驗池進行初始化處理,采用隨機值初始化的方式將請求選擇價值函數表與權重初始化值之間建立映射關系,此時的調度動作價值函數與初始化的請求目標動作價值函數是以關聯的形式存在的,當充換電站接收到需求響應業務時,基于LSTM的需求響應模型在初始化的接收激勵方案中選擇狀態值與實際調度需求一致的方案,并將對應的激勵量傳送給電站需求的LSTM模型。以此為基礎,觀察電站需求的響應情況,確定下一時刻狀態并及獎勵值,其計算方式為

其中,yi表示調度量,τ表示更新請求狀態矩陣中其接受的激勵量最大浮動量。通過這樣的方式,實現對電動汽車充換電站的調度。

2 算例與實驗分析

將本文提出的基于改進深度強化學習的電動汽車充換電站調度技術進行測試分析,采用Matlab2019作為仿真實驗測試的環境。

2.1 實驗數據

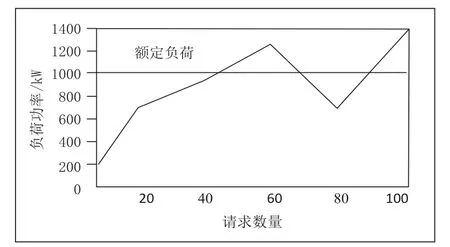

實驗所用的數據是在現實場景的基礎上進行提取的,通過全景模擬電動汽車充換電站的運行數據,計算得出最終的實驗數據。其中,本文的模擬對象為某300m2的充換電站,采集了該充換電站100天內的負荷數據,通過模擬仿真的方式,計算得到該區域的負荷曲線,并將其作為實驗算例。其中,(假設該充換電站每天提供服務的汽車規模為100輛,此時換電站電池充電功率、負荷數據綜合實際數據的均值),以此為基礎,得到的原始負荷曲線如圖1所示。

圖1 充換電站原始負荷曲線

以此為基礎,分別采用文獻[4]、文獻[5]以及本文提出的方法對其進行調度,并同樣采用仿真模擬的方式對調度后的負荷曲線進行計算。

2.2 實驗結果

在上述基礎上,對比了三種方法的調度結果,得到了負荷曲線結果如圖2所示。

圖2 調度后充換電站負荷曲線

從圖2中可以看出,以文獻[4]和文獻[5]方法相比,在本文提出的調度方法下,電動汽車充換電站的負荷處于相對穩定的狀態,未出現明顯的超負荷情況,且隨著充電需求車輛的增加,其負荷曲線的變化趨勢相對穩性;而文獻[4]和文獻[5]方法的調度結果中,對于充電請求小于100的情況,可以實現對負荷的有效控制,但是當充電請求大于100時,均出現了不同程度的超負荷情況。表明本文提出的電動汽車充換電站調度具有良好的應用價值。這是因為本文在對調度需求進行計算時,構建了邊界反彈機制,增加了求解方案的合理性,提高了算法尋優的可靠性。

3 結束語

電動汽車的發展不僅對于全球環境的保護具有重要意義,也是適應現階段能源緊缺大環境的重要舉措。基于此,電動汽車未來的發展空間是不可限量的。未來促進其健康發展,對于其配套設施的建設必須受到重視。充換電站作為電動汽車能源供應的主要方式,對于進行合理調度是確保電動汽車運行的重要基礎。本文提出基于改進深度強化學習的電動汽車充換電站調度技術,實現了對負荷的有效控制,確保負荷曲線處于相對穩定的狀態,不會由于充換電請求的改變而出現超負荷情況。