基于改進MobilenetV2網絡的聲光圖像融合水下目標分類方法?

鞏文靜 田 杰 李寶奇 劉紀元

(1 中國科學院聲學研究所 北京 100190)

(2 中國科學院大學 北京 100049)

(3 中國科學院先進水下信息技術重點實驗室 北京 100190)

0 引言

水下目標成像及分類可以通過不同的成像技術實現,利用光學傳感器獲得的圖像分辨率較高、目標較為直觀[1],在目標分類研究中有重要應用。Gleason等[2]使用監督分類的方法對水下光學圖像中的目標和海床進行分類,將海床的局部地形或高度作為附加特征添加到分類器中,具有一定的有效性;Pramunendar等[3]提出了一種應用于反向傳播神經網絡的圖像增強模型,通過選擇合適的插值方法和反向傳播神經網絡結構提高圖像分辨率,取得了較高的分類準確率;王士龍等[4]提取目標的邊界矩,利用改進的FCM 聚類算法較好地實現了對水下目標的分類識別。

雖然以上利用光圖實現水下目標分類已經取得了一定成果,但是受成像條件復雜性的影響,水下光成像作用距離近,圖像對比度較差。由于聲吶的探測距離較遠,成像范圍較大[5?6],聲成像技術的不斷發展使得利用聲吶圖像進行目標分析成為可能[7?9]。Sinai等[10]利用C-V輪廓算法將聲吶圖像分割為目標及陰影兩部分,通過人工提取幾何特征來實現水下目標分類;Williams[11]利用卷積神經網絡將水聲圖像分為有目標和無目標兩類,取得了滿意的效果;朱可卿等[12]使用高斯混合模型對聲圖的陰影部分進行提取,設計融合分類器實現對水下沉底小目標的分類,分類性能較好。

然而,受聲吶自身技術參數的限制以及水下噪聲、混響的影響,聲成像的清晰度較低,且聲圖獲取較為困難。現有水下目標分類方法的研究大多依靠單一的光學或聲學圖像數據集,通過人工提取特征或使用卷積神經網絡完成對目標的分類。但是,單一數據集對目標的描述具有一定限制,且卷積神經網絡模型較為復雜,網絡的計算和分類速度較慢。因此,如何降低模型復雜度,節約計算資源,獲得更好的分類效果,都是亟待解決的關鍵問題。

為了改善網絡的分類性能,適應小樣本背景下的水下目標分類任務,主要從以下角度解決上述問題。首先,選擇輕量化的MobilenetV2 網絡并對其結構進行改進,減小網絡的參數量,進一步提高網絡運算效率。其次,在改進網絡的基礎上設計并行網絡結構,將采集的聲、光學圖像真實數據集同時輸入網絡,采用中間層融合策略,利用融合特征得到最終的分類結果。該方法規避了單一數據集對目標描述的限制,充分利用聲、光學兩種圖像各自的優勢以及MobilenetV2網絡參數少、輕量化的特點,在節約網絡計算資源的同時,提高了算法的分類準確率。

1 改進MobilenetV2網絡

1.1 MobilenetV2網絡模型

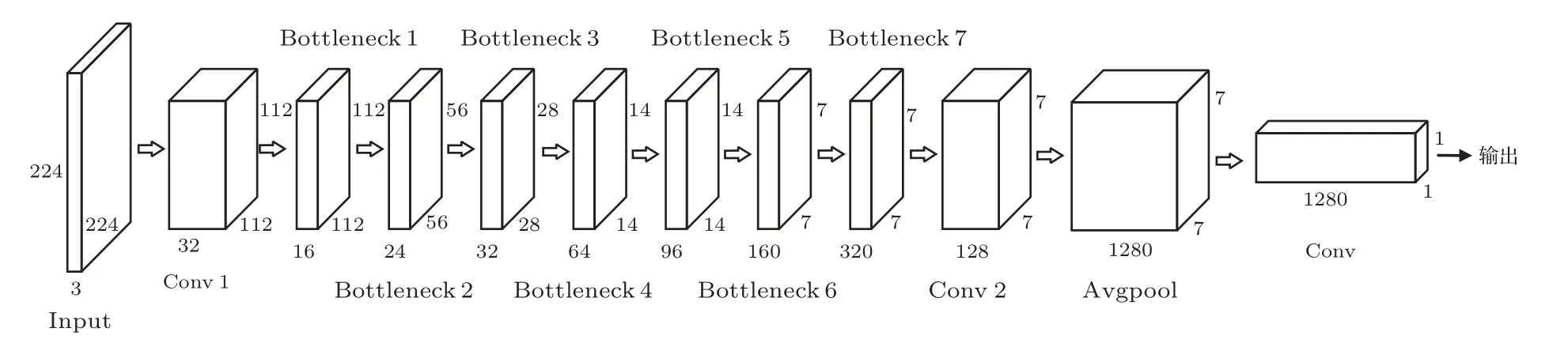

MobileNet 是Google 于2017年提出的新型輕量化網絡[13],MobileNetV2 與其相比,具有較少的網絡參數數量和更低的運算成本,相比普通的全卷積網絡能夠減少8~9 倍的計算量,網絡性得到了進一步改善,與VGG16 等常用網絡相比具有低消耗和實時性等優點,符合目標分類任務的要求[14]。MobileNetV2網絡包括普通卷積(Conv)、反向殘差結構的深度分離卷積(Bottleneck)和平均池化(Avgpool)幾部分,網絡結構如圖1所示。

圖1 MobileNetV2 網絡結構Fig.1 Network structure of Mobilenetv2

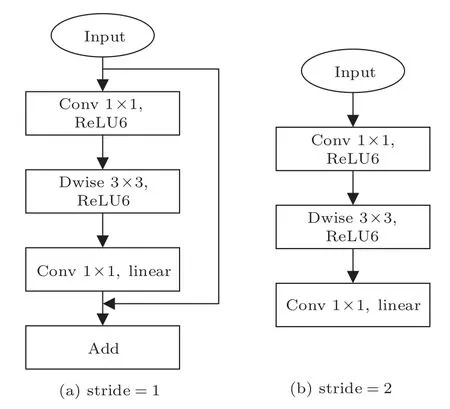

Bottleneck結構是MobileNetV2網絡的核心部分,每個Bottleneck 由兩個普通卷積和一個深度分離卷積(Dwise)組成[15]。該結構首先通過1×1的卷積進行維度擴展,再用3×3 的深度分離卷積提取特征,最后使用1×1 的卷積來壓縮數據[16],兩個普通卷積分別使用ReLU6和Linear函數進行激活,深度分離卷積使用標準化BN 層[17]和線性整流函數ReLU6[18]進行正則化和激活。圖2(a)和圖2(b)分別表示步長為1 和步長為2 時的Bottleneck 網絡結構,當步長為1 時,需要將該網絡結構的輸出與上一層的輸出進行疊加,實現不同位置的信息整合。

圖2 Bottleneck 網絡結構圖Fig.2 Bottleneck network structure

1.2 改進的MobileNetV2網絡

MobilenetV2 網絡使用ImageNet 數據集進行訓練,數據集圖片數量達到140 萬張,而水下目標圖像采集較為困難,獲取的數據數量較少,直接使用原網絡進行訓練無法得到較好的擬合效果,且ImageNet 數據集共包含圖像1000 個類別,目標種類與水下目標差別懸殊,無法直接進行遷移學習。MobilenetV2 網絡第9 層的輸出通道由320 增加到1280,通道數的增加會消耗更多的計算資源;網絡使用平均池化Avgpool 降采樣來減少特征數量,更多地保留圖像的背景信息,不完全適用于水下目標分類任務。

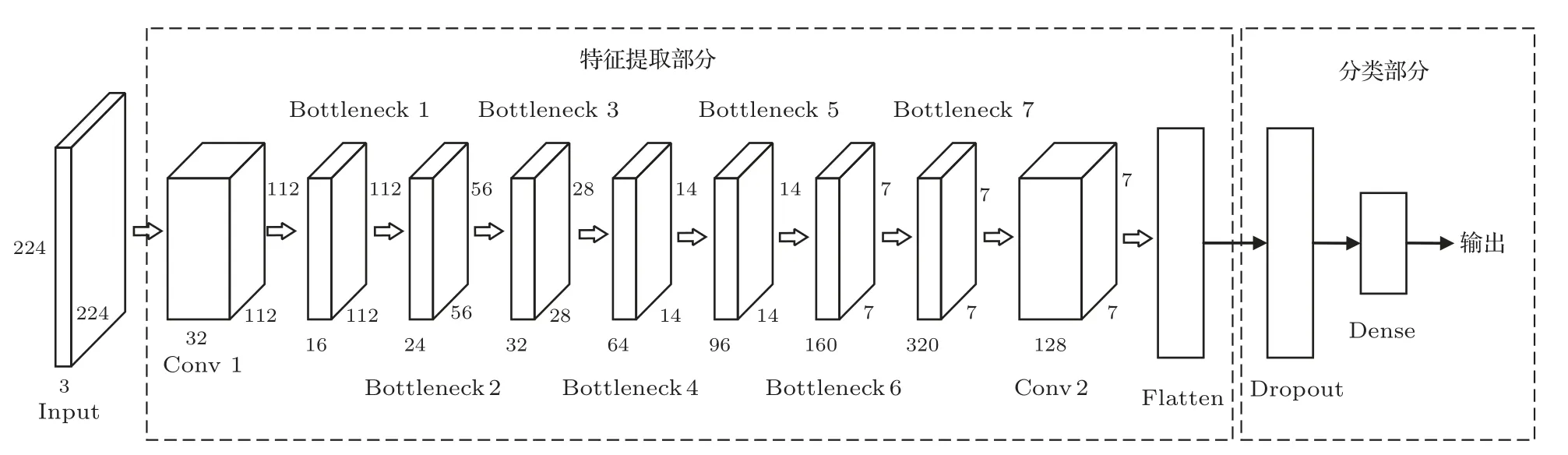

因此,為了增強網絡在水下場景的適用性,充分發揮深度分離卷積在特征提取中的優勢,提高目標分類的精確度,本文在MobileNetV2 網絡的基礎上進行了如下改進:(1) 為了在訓練網絡時進一步減少計算資源、節約內存空間,在保證精度的前提下充分考慮參數量和運算成本,借鑒文獻[14]的方法,通過多次實驗對比,本文去掉第9層之后的網絡層,并將該卷積層通道數由1280改為128。(2) 為了適應水下目標分類任務,在保留目標特征信息的同時提升網絡的收斂速率,本文使用Flatten層進行數據降維,將三維的輸出轉化為一維后,添加Dropout層改善網絡擬合,丟棄率設為0.5,最后增加一個全連接層,得到最終的分類結果。

圖3為改進MobileNetV2 網絡的結構示意圖,網絡包括特征提取和分類兩個部分。特征提取網絡包括1 個普通卷積、7 個具有反向殘差結構的深度分離卷積和1 個普通卷積,通過Flatten 層將三維特征圖轉換為一維后,使用Dropout層改善網絡擬合。分類網絡使用全連接層結構,從而得到每一個目標屬于各個類別的概率。

圖3 改進Mobilenetv2 網絡結構圖Fig.3 Network structure of improved Mobilenetv2

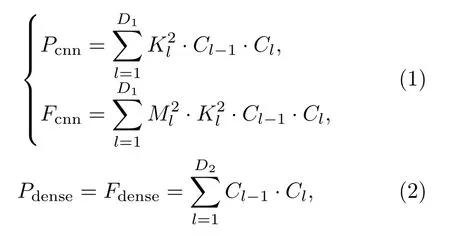

網絡的參數量和計算量作為兩個重要的指標,通常用來對網絡模型的復雜度進行評估,參數量對應的是算法的空間復雜度,表示對計算機內存資源的消耗;計算量對應時間復雜度,關系到網絡的運算時間。參數量和計算量主要來網絡中的自卷積層和全連接層,計算過程可以表示為

其中,P和F分別代表模型的參數量和計算量,下標cnn 和dense 分別表示卷積層和全連接層,Ml和Kl分別表示輸入圖片的尺寸和網絡使用的卷積核大小,Cl?1和Cl為卷積運算中輸入、輸出特征圖的通道數,D1、D2為網絡中的卷積層與全連接層個數。使用式(1)~(2)對原始及改進后的MobileNetV2網絡模型進行復雜度計算,計算結果如表1所示。

表1 原始及改進MobileNetV2 網絡復雜度Table 1 Network complexity of original and improved Mobilenetv2

MobileNetV2 網絡模型需要訓練的參數數量約為3.4 M,改進后網絡模型的參數數量約為1.9 M,與原始網絡相比,模型參數數量減少了近一倍。與此同時,改進的MobileNetV2 網絡計算量為230 M,相比原始網絡的計算量也有一定數量的減少。由此可見,改進后的網絡復雜度有所減小,能夠提高網絡運算效率,進一步節約計算資源。

2 聲光圖像融合分類網絡

聲學圖像能夠大范圍獲取,效率較高,光學圖像的高分辨率能夠實現對目標細節的描述。為了實現二者的優勢互補,提出一種聲光圖像融合分類網絡模型。目前,對異源圖像的聯合處理網絡主要有輸入前融合和輸入后融合兩種[19],前者是將圖像進行融合處理后再輸入特征提取網絡,此種方式通常需要改變第一層卷積的數量,使得訓練結果變差;后者是對圖像進行特征提取之后,將特征提取網絡的中間層信息融合[20],能夠保證網絡訓練的準確性。

本文使用輸入后融合的思想,將水下目標的聲、光兩種圖像并行輸入網絡進行特征提取,在某一層將兩個模塊輸出的特征圖進行融合,實現兩種圖像的信息交流。特征提取使用的網絡主干為1.2 節中改進的MobileNetV2 網絡,在網絡的特征提取過程中,圖像的原始信息更多地體現在網絡的淺層特征當中,網絡的深層特征較為抽象,具有更多的分類信息。因此,根據網絡的結構特點,本文選擇在網絡的深層位置進行特征融合,將網絡最后一個卷積層的輸出作為待融合特征,使用融合操作的結果實現水下目標分類,從而達到更高的分類準確率。

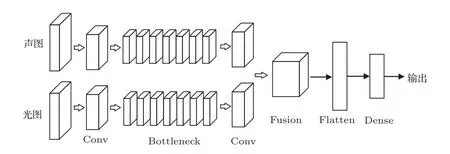

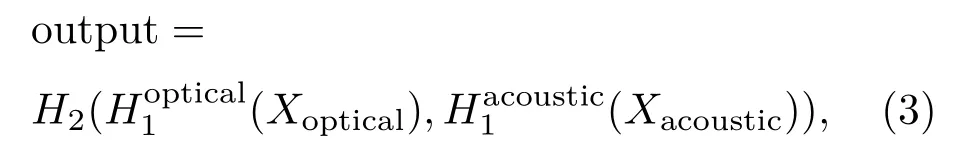

融合分類網絡模型如圖4所示,該網絡由特征提取、特征融合、融合特征提取、分類4 個部分組成。聲學圖像和光學圖像分別送入改進的MobileNetV2網絡,特征提取部分包括一個普通卷積、具有反向殘差結構的深度分離卷積及其之后的卷積層。在網絡的最后一個卷積層位置,將輸出的特征圖按通道對應實現特征融合,這里應用的融合算法是通道拼接(concatenate),融合過程的數學表達式為

圖4 基于改進MobileNetV2 的融合分類網絡Fig.4 Fusion classification network based on improved Mobilenetv2

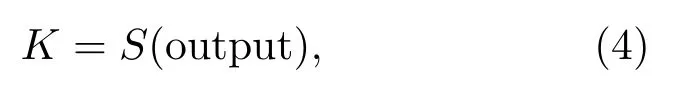

其中,Xoptical和Xacoustic表示輸入的光學圖像和聲學圖像;和表示光學圖像和聲學圖像從輸入到最后一個卷積層之間的特征提取網絡;H2代表融合操作的通道拼接算法;output 為融合后輸出的新特征,用以實現目標分類。分類過程可以表示為

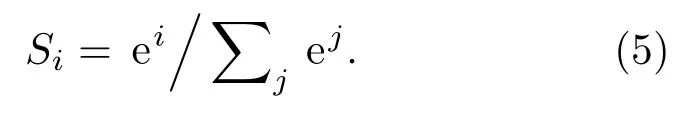

其中,K為分類結果,S代表Softmax 分類函數,將網絡最后一層的輸出轉化為輸入圖像屬于各類別的概率,公式為

3 數據獲取及預處理

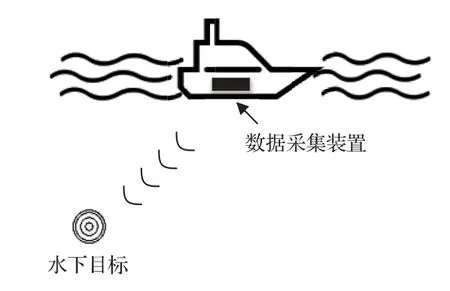

水下目標聲圖由成像聲吶獲得,三維成像聲吶具有圖像的深度信息,同時可以獲得更清晰的目標輪廓[21],因此使用前視三維聲吶獲取聲圖。本文所用的水下目標數據集由千島湖實驗獲得,實驗裝置布放如圖5所示。數據采集裝置由一個綠激光水下攝像機和一個前視三維聲吶組成,二者成對獲取水下目標圖像。其中,綠激光水下攝像機型號為WWA-6226,波長為532 nm,分辨率1920×1080,最大可視范圍設置為8 m;聲吶設備為高頻三維成像聲吶,工作頻率為300 kHz,帶寬30 kHz,波束開角45?,波束數目為128×128,實驗過程中最大工作深度設置為30 m。

圖5 實驗裝置布放圖Fig.5 Layout of experimental apparatus

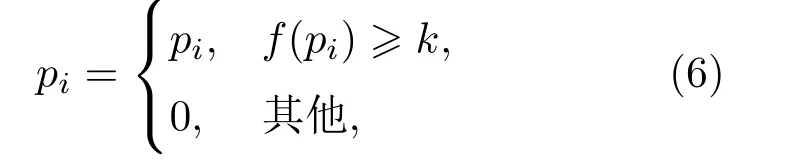

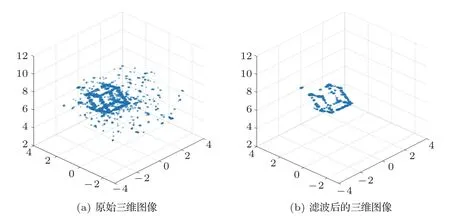

三維成像聲吶得到的數據為三維圖像,攜帶方位、距離和散射強度等信息。數據獲取過程中,受水下復雜環境以及設備自身限制的影響,可能包含一定的噪點,首先使用式(6)所示過程對歸一化后的原始數據進行濾波處理。

其中,pi=(xi,yi,zi)為三維圖像中每個點的坐標,f(pi)為該點的散射強度,k為濾波閾值。將原始三維圖像及濾波后的圖像以點云形式進行可視化,效果如圖6所示。

圖6 水下三維圖像可視化效果圖Fig.6 Visualization of underwater 3D image

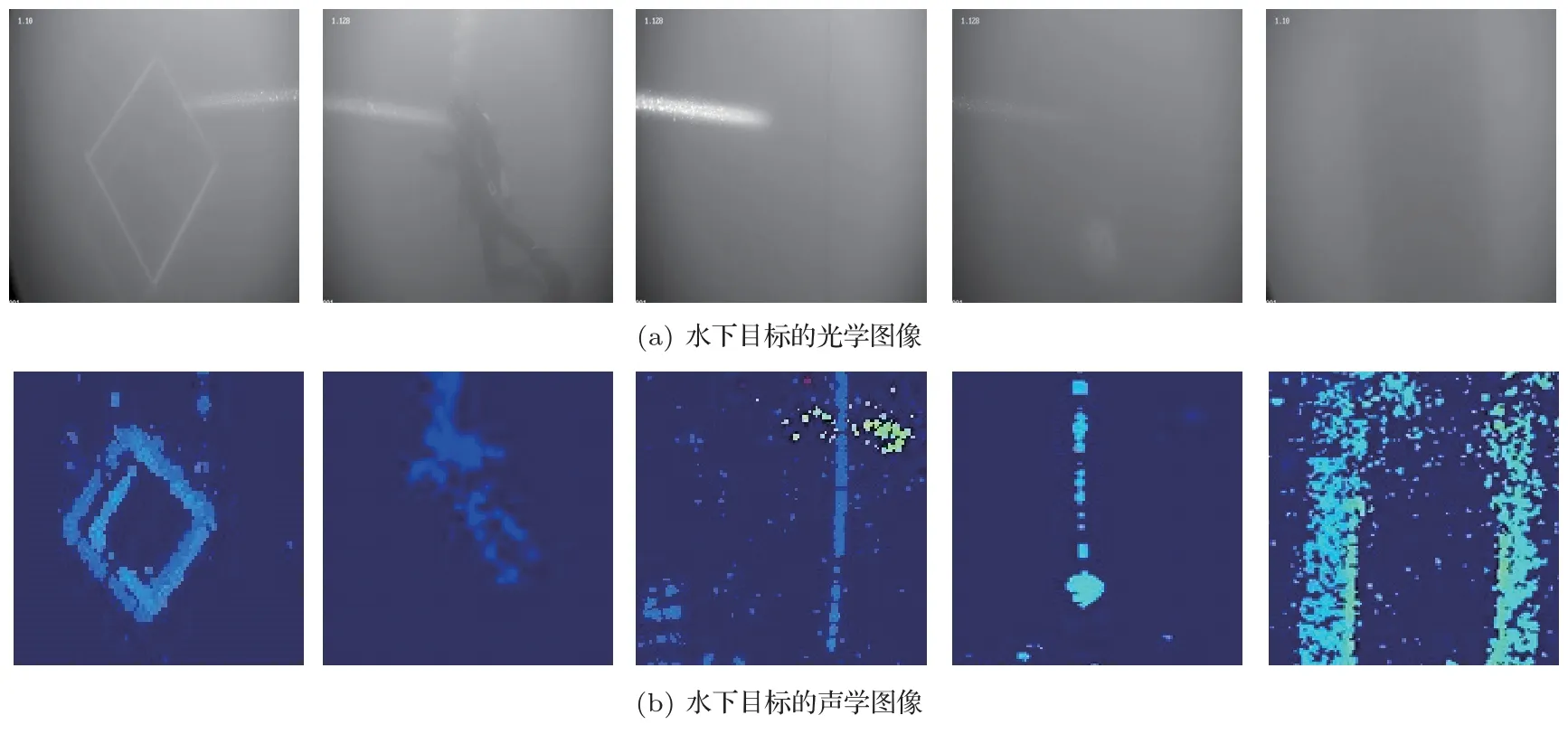

為了方便數據處理,將三維圖像距離向上散射強度最強的點投影到二維平面,用其深度值作為該點的像素值,得到目標的深度圖。將攝像機拍攝的圖像作為光學圖像數據集,三維圖像處理后得到的深度圖作為聲學圖像數據集。兩個數據集中的圖像成對存在,數據格式為三通道RGB圖像,共2196張,包括鐵框、蛙人、繩子、繩子拖曳的小球、橋墩5類水下目標,部分數據集圖像如圖7所示。

圖7 部分實驗數據集圖像Fig.7 Images of some experimental data sets

4 實驗結果與分析

為了驗證所提網絡在水下目標分類任務中的可行性,設計了以下實驗。首先采集水下目標圖像,制作實驗數據集。(1) 在光學圖像數據集上進行實驗,對比VGG16、Resnet50、MobileNetV2以及改進的MobileNetV2網絡對5種水下目標的分類性能,驗證了改進MobileNetV2 網絡在水下目標分類任務中的適用性;(2) 利用改進的MobileNetV2 網絡以及提出的聲光圖像融合分類網絡模型對水下目標進行分類,驗證融合網絡結構對水下目標分類準確率的提高;(3) 使用不同融合算法在不同位置進行融合,利用融合網絡對目標圖像進行分類,討論融合位置及融合算法對分類準確率的影響;(4)在數據缺失的條件進行融合網絡的分類實驗,記錄網絡的分類準確率,驗證網絡的魯棒性。以下實驗使用的所有網絡均基于Keras 深度學習框架搭建,并利用CUDNN進行加速處理。實驗計算機CPU 為6核i7-10750H、Win10操作系統、GPU為RTX2070。

在采集的5 類水下目標圖像中,隨機抽取20%的目標數據作為測試集,余下的作為訓練集。為了確保目標分類的準確性,在抽取數據時需要將聲學圖像和光學圖像數據一一對應。訓練集和測試集的樣本組成如表2所示。

表2 訓練集和測試集樣本數量Table 2 Sample number of training set and test set

4.1 不同分類網絡在本文數據集上的分類性能

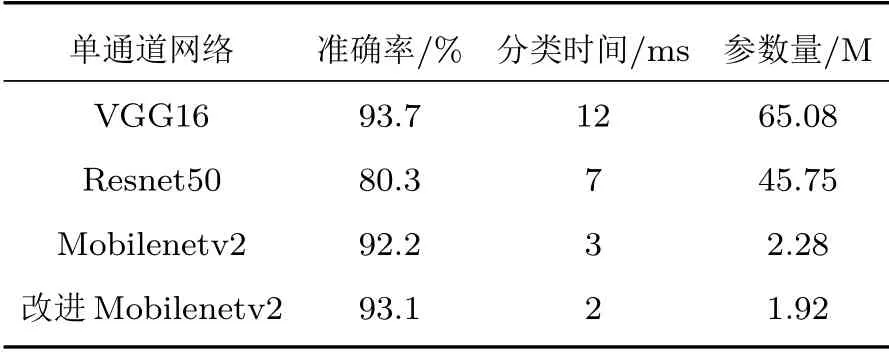

分別使用VGG16、Resnet50、MobileNetV2 以及改進的MobileNetV2 網絡對本文數據集(以光學圖像為例)進行分類,驗證幾種分類網絡對水下目標的分類性能。將水下目標圖像輸入網絡進行訓練和測試,在網絡訓練前,應用高斯分布G(μ,σ2)對網絡中的所有參數進行隨機初始化,其中μ=0,σ=1。采用Optimizers 優化器對整個網絡的參數進行優化,學習率設為0.00001。在訓練數據中每次隨機抽取16張圖像訓練網絡,迭代次數為100,網絡采用代價函數選用分類交叉熵。幾種模型的分類結果可見表3,其中,分類時間是測試過程中對一張圖像得出分類結果所用的平均時間。

表3 目標分類網絡性能比較Table 3 Comparison of performance of target classification network

由表3可以看出,分類準確率最高的是VGG16網絡,可以達到93.7%,但是其分類時間最長,參數量最大,計算代價較高。Resnet50 網絡的分類時間和計算代價有所減少,但分類準確率較低,MobilenetV2網絡與之相比準確率有所提高,在參數量上也具有一定優勢。綜合考慮分類準確率、時間、參數量幾種指標,MobilNetV2 網絡要優于另外兩種網絡模型。相比于原始MobilNetV2網絡,改進后的網絡得到的分類準確率更高,且分類時間、參數量均有減小,說明本文做出的改進對模型性能有一定的提升,更加適用于水下目標分類任務。

4.2 融合前后網絡性能比較

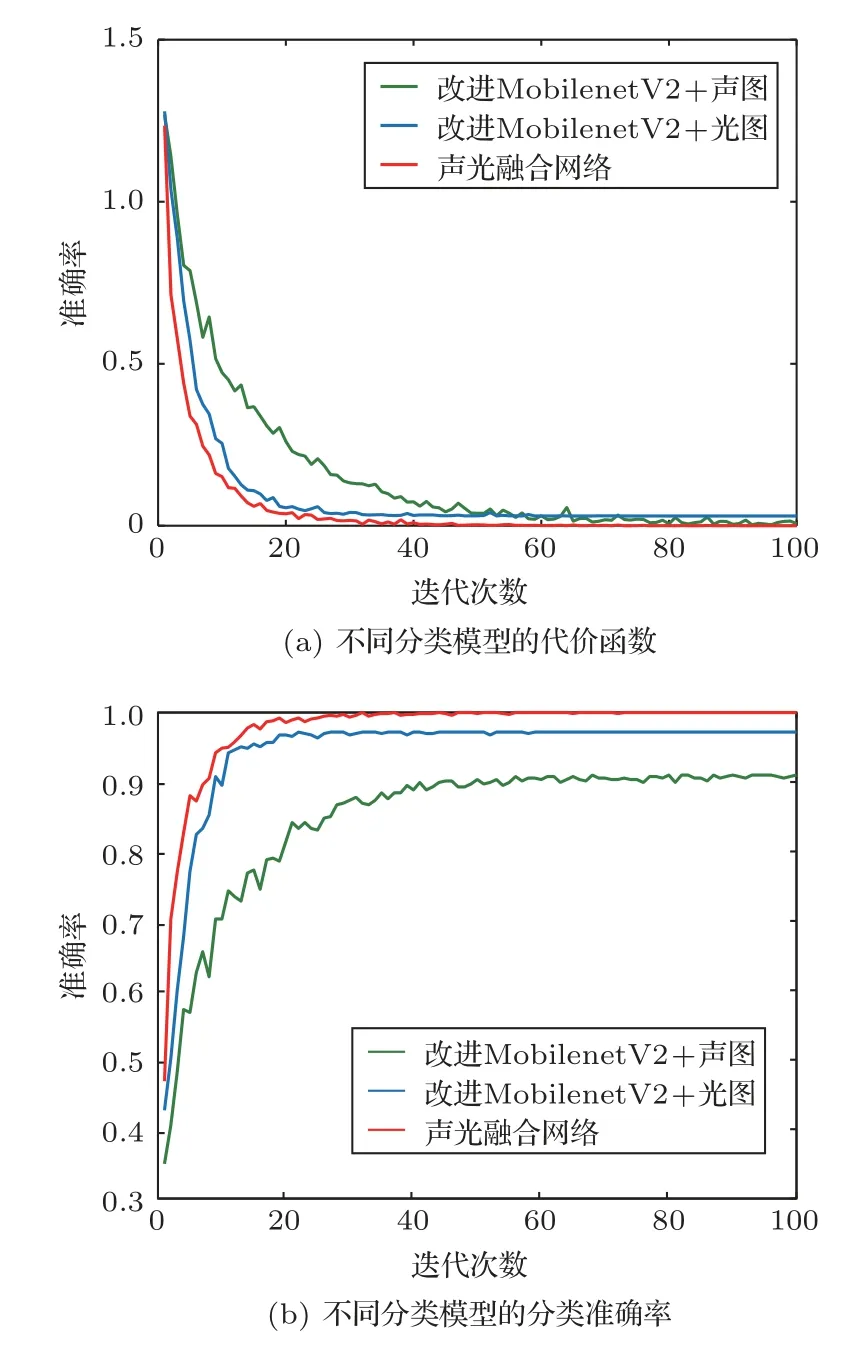

分別使用改進的MobileNetV2 網絡對聲學圖像和光學圖像進行分類,之后應用本文提出的融合分類網絡將對應的聲學圖像和光學圖像成對輸入網絡進行訓練和測試,對水下目標圖像進行分類。網絡超參數的設置均與前述實驗一致,訓練過程曲線如圖8所示。

由代價函數變化曲線可以看出,幾種模型的函數值在整個訓練過程中不斷下降,最終都逐漸趨于平穩,改進后的MobileNetV2 網絡在兩個數據集上具有較小的損失值,融合網絡的損失值最小,相比單通道的分類網絡具有更好的性能。圖8(b)為訓練過程不同分類模型的分類準確率變化曲線,將測試集輸入訓練好的網絡進行分類,檢驗模型的分類性能,改進前后與融合網絡在本文數據集上的分類準確率如表4所示。

圖8 訓練過程變化曲線Fig.8 Change curve of training process

由表4可以看出,改進MobilNetV2 網絡對兩種圖像的分類準確率分別為87.9%和93.1%,網絡模型的擬合情況較好,能適應水下目標分類的小樣本數據。本文提出的融合分類網絡對水下目標圖像的分類準確率達到96.5%,相比融合前的網絡模型對聲學圖像和光學圖像的分類準確率分別提高8.6%和3.4%,具有良好的分類性能。

表4 不同網絡的分類準確率Table 4 Classification accuracy of different networks

4.3 不同融合方式下網絡性能比較

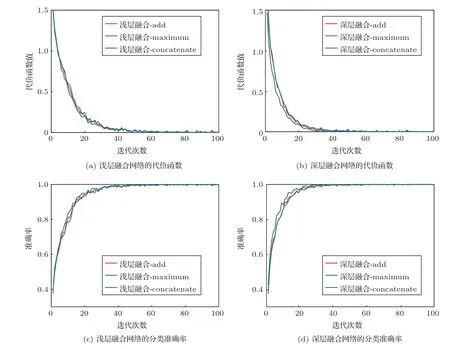

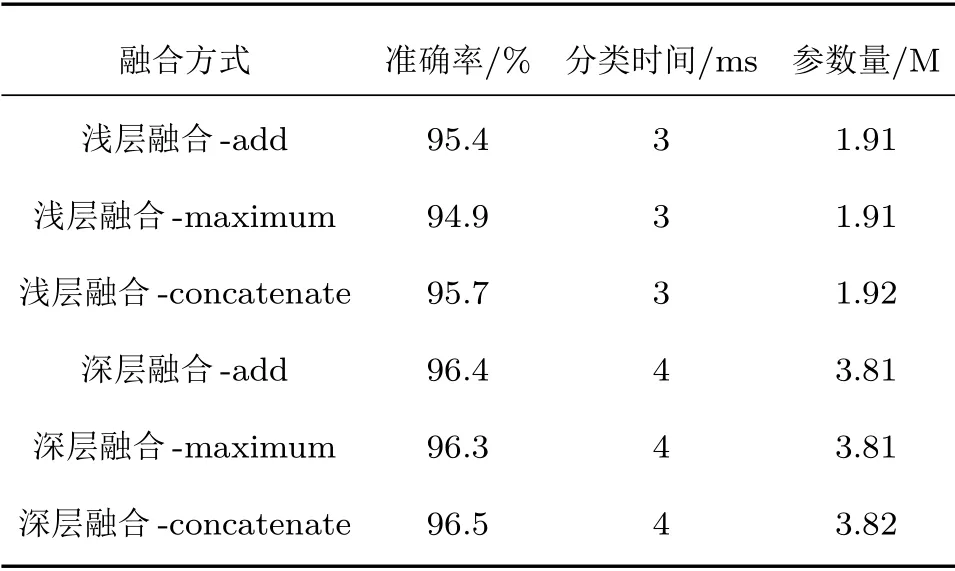

本文在對聲光圖像進行融合時使用的算法是通道拼接(concatenate),在網絡的深層位置進行特征融合。除此之外,融合算法還包括直接疊加(add)、最大化運算(maximum)等,融合位置也可以選在網絡的淺層部分。分別使用add、maximum、concatenate三種融合算法,在改進MobileNetV2網絡的第一個卷積層后進行特征融合,將該融合網絡記為淺層融合網絡,本文提出的融合網絡記為深層融合網絡,利用聲、光學圖像分別在兩種融合網絡上進行實驗,訓練過程代價函數及準確率的變化如圖9所示。

圖9 融合網絡訓練過程變化曲線Fig.9 Change curve of fusion network training process

兩種融合網絡在不同的融合算法下代價函數值均下降并收斂,融合算法的選擇對網絡性能的影響不明顯,深層融合網絡的收斂速率更快。將測試集數據輸入訓練好的融合分類網絡,得到最終分類結果,融合網絡對水下目標的分類結果可見表5。

表5 不同融合網絡對本文數據集的分類性能Table 5 Classification performance of different fusion networks on the dataset in this paper

由表5可以看出,淺層融合和本文提出深層融合的平均準確率分別達到95.3%和96.4%,相比使用單通道網絡對水下目標圖像的分類準確率均有明顯提高,深層位置的融合網絡分類準確率更高。由于深層融合需要的參數更多,運算成本也略有增加。同一融合位置下不同融合算法的選擇對分類結果的影響較小。

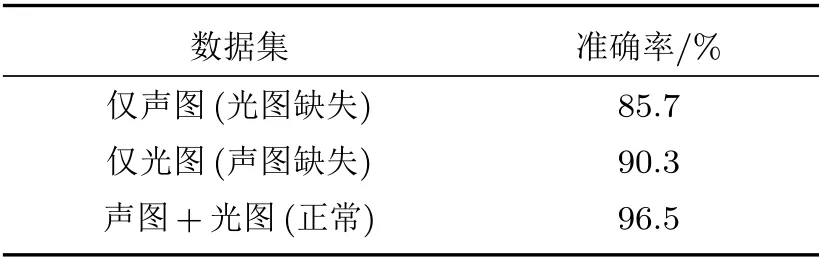

4.4 融合網絡魯棒性實驗

在實際水下應用中,由于水下攝像機和聲吶的作用距離不同,遠距離條件下只有聲吶能夠獲取到有效數據,且水下環境的復雜性及實驗過程的各種不可控因素可能會導致其中一臺設備無法正常工作。考慮到最差的情況,假設其中一臺設備失效,將該設備獲得的圖像記為一個全0 數組,另一設備獲得的為正常圖像,將其輸入本文的融合網絡進行測試,兩種情況下不同數據集在網絡中的分類結果如表6所示。

表6 不同數據集下的融合網絡分類準確率Table 6 Classification accuracy of fusion networks under different data sets

由表6可以看出,在光圖缺失的情況下,融合網絡的分類準確率為85.7%,聲圖缺失情況下的分類準確率達到90.3%,相比正常數據下的分類準確率有所降低,原因可能是融合后的特征圖中包含無效數據,對網絡具有一定干擾作用。由此可見,當一臺設備失效時,融合網絡的分類準確率會受到一定影響,但是最低仍能達到85%以上,而普通的單路網絡在此種情況下會失去分類能力,說明本文提出的融合網絡具有一定的容錯能力和魯棒性。

5 結論

本文主要以下從兩個角度改善網絡的分類性能,以適應小樣本條件下的水下目標分類任務。首先,將改進的MobilenetV2 網絡作為基礎網絡,以減小網絡訓練過程的計算開銷和內存占用,使用實驗采集的真實數據進行網絡訓練,改善網絡擬合效果。其次,將改進網絡作為融合網絡的分支,使用中間層融合策略將水下目標的聲、光學圖像特征圖進行融合,實現各自的優勢互補,進一步提高分類準確率。實驗結果表明,與其他常用分類模型相比,MobilenetV2 網絡的分類準確率較提高,在參數量上和分類時間上也具有一定優勢。改進的MobilenetV2 網絡與原網絡相比,參數量及計算資源消耗減少,分類準確率進一步提高,在水下目標分類任務中具有更好的性能。相比融合前的網絡,融合網絡模型的學習曲線收斂更快,且準確率更高,在add、maximum、concatenate三種融合算法下,融合網絡的分類準確率均有不同程度的提升。在單路數據缺失的情況下,融合網絡的分類準確率仍能達到85%以上,具有一定的魯棒性。