基于修正Mask R-CNN算法的繼電室機器人微小特征識別

陸穎杰,蘇淼,黃超

(國網寧夏檢修公司,寧夏 銀川 750011)

0 引言

繼電室主要用于電力系統的發電、輸電、配電、電能轉換以及在消耗中起通斷、控制和保護的作用,其可靠性關系著電力系統電能質量及供電的可靠性[1~3]。目前對繼電室開關柜的檢測仍采用定期人工檢修,該方法檢修周期長,不能及時發現在兩次檢修之間發生的缺陷,還可能對無故障的設備檢修過度,造成資源浪費及成本增加[4-5]。設計繼電室機器人可以使得檢測智能化,并減輕人工檢修的工作量。

視覺是機器人感知外部環境的重要方式[6],可配合機器人的結構運作來完成檢測和監控以及數據讀取,故要求其識別模塊具有實時性、可靠性、同步性以及高精度。傳統的視覺識別采用滑窗法[7],以窗口的形式對圖片遍歷分割,效率較低;文獻[6]中提出的基于Mask R-CNN(Mask region convolutional neural network,Mask R-CNN)算法模型的雙目視覺技術,可以準實時的速度進行物體的識別和定位,滿足監控模塊的實時性。本文把深度學習Mask R-CNN算法模型和雙目視覺技術相結合的方法應用于繼電室機器人的實時監控模塊,采用修正的Mask R-CNN算法來實現對開關柜上的鎖孔和開關兩個微小特征的識別。

1 繼電室機器人

繼電室開關柜的智能檢測主要包括柜門上的開鎖動作、柜內的開關操作以及電壓瓦數讀取等,其中鎖孔和開關屬于微小特征,其直徑僅為10mm,如何高效識別這些微小特征將直接影響智能檢測的效率以及智能化的程度。由于雙目攝像機對物體定位的精度較低,而一般基于深度學習的對象檢測僅用于二維圖像,將深度學習與雙目視覺相結合,利用深度學習在二維圖像上的精準定位和分類效果,結合雙目攝像機返回深度信息,最終實現三維圖像的定位識別。Mask R-CNN具有較高的精度和較快的速度,滿足繼電室機器人監控系統實時同步性和高精度的要求。

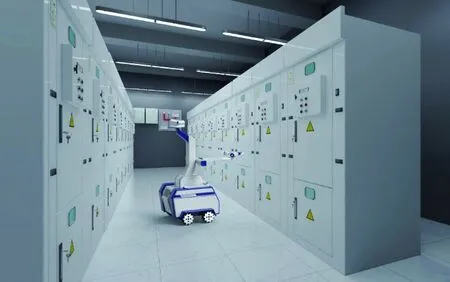

繼電室機器人的實時監控模塊運用于兩個場景:第一階段使用傳感器檢測暫態地電壓,判定開關柜運行狀態時,對于異常狀態的開關柜識別其鎖孔位置,并執行開鎖操作;第二階段識別開關柜柜內的狀態信息(指示燈狀態),必要時進行開關斷電操作。圖1為繼電室機器人在繼電室內進行鎖孔識別的情形,其要求為:識別距離>50cm,且識別特征為10mm的鎖孔和開關。對于第一階段的開鎖操作和第二階段的開關操作,其定位精度要求較高;而第二階段的對指示燈狀態讀取沒有定位要求。環境中角度、光線以及模糊等對圖像識別有干擾,并且鎖孔以及開關的材質反光也會對圖像識別帶來較大影響。

圖1 鎖孔識別現場

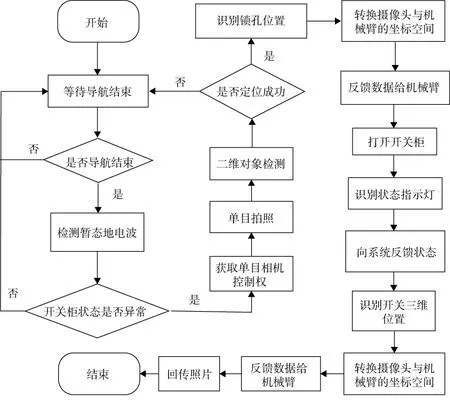

根據對實時監控模塊的基本框架要求,得到如圖2所示的系統執行流程。

圖2 實時監控模塊的系統執行流程

2 圖像識別技術

2.1 修正的Mask R-CNN算法

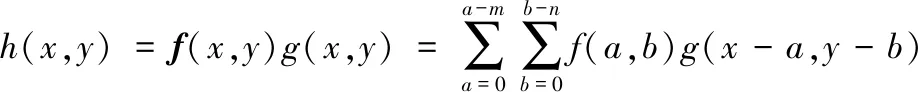

卷積神經網絡模型(convolutional neural network,CNN)是一種典型的深度學習網絡模型[8],用于圖像識別的目標檢測,分為定位和分類兩個步驟,包括卷積層、池化層和全連接層,分別進行特征提取、降維匯聚特征以及分類整合。式(1)為卷積公式[9],其中f(x,y)為圖片像素點矩陣,g(x,y)為卷積核(即圖片像素點的權重),改變卷積核則可以提取不同的特征。區域卷積神經網絡模型(region convolutional neural network,R-CNN)則是在CNN的基礎上,通過選擇性搜索操作確定候選區域,先對輸入圖片進行候選區域劃分,再通過CNN網絡模型提取特征,最后進行分類識別,避免了對沒有特征信息的區域進行無意義的卷積。

(1)

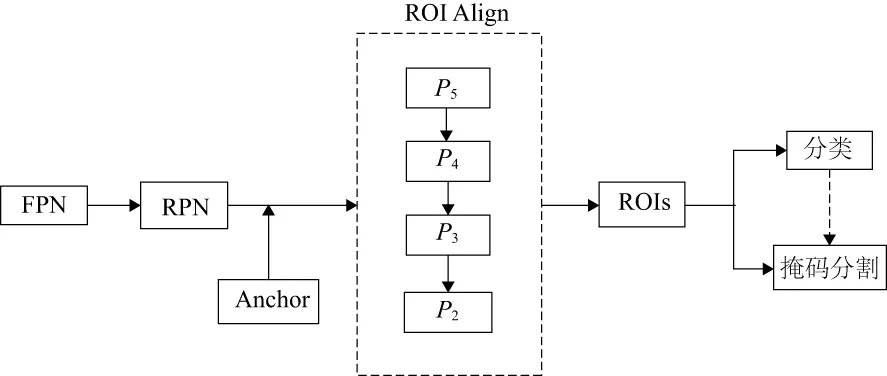

Mask R-CNN基于R-CNN網絡,延用的區域生成網絡(region proposal network,RPN)提取候選框,結合特征金字塔網絡(features pyramid network,FPN)以及感興趣區域校準(region of interest Align,ROI Align),對尺度不同物體的識別效果進行優化并得到更精確的分割。

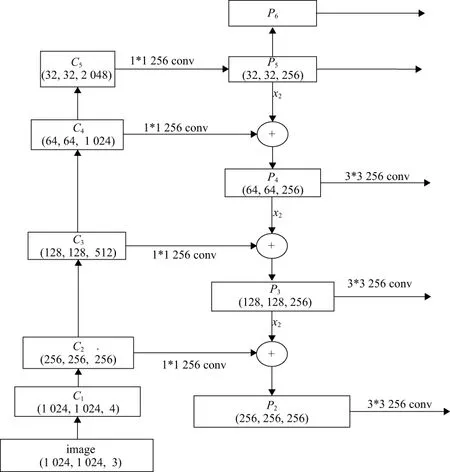

FPN融合了高層特征和低層特征(圖3),式(2)為FPN的算法公式[9],Ci為卷積生成的不同尺寸的特征圖,Pi為融合的特征,sum為元素的對位求和,conv為卷積。其中P6為P5的最大池化,即在劃分的區域網格內選擇最大值作為該區域的像素值。ROI Align保留小數計算,取消量化操作,提升準確性。

圖3 FPN示意圖

(2)

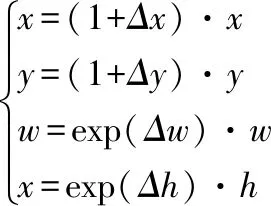

RPN基于P2、P3、P4、P5、P6特征圖(圖4),對每一個特征向量回歸一個5n維的向量,然后用以描述錨框Anchor的修正值(錨框中心坐標偏移△x、△y,錨框寬高偏移△w、△h,前后景置信度p),根據修正值來修正錨框,式(3)為修正計算公式。

圖4 Mask R-CNN網絡示意圖

(3)

2.2 雙目Mask R-CNN系統

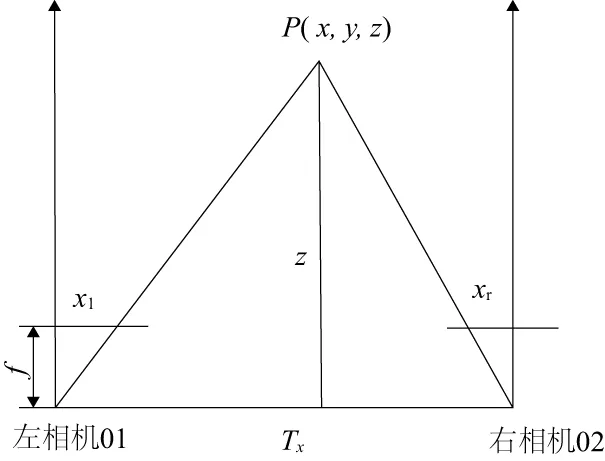

雙目視覺下,深度的測量基于視差[10]。如圖5所示,01、02分別為左右兩個攝像頭,同時拍攝同一物體P(x,y,z),f是焦距。在距攝像頭f距離的平面上得到點P的對應點Pl(xl,yl)、Pr(xr,yr)。令視差d=xl-xr,Tx為兩相機間的距離。已知視差d,兩個相機光心距離b,焦距f,可以根據式(4)求出深度z。

圖5 雙目視覺視差圖

(4)

二維圖像和位置的識別均使用單目攝像頭(左攝像頭),以左攝像頭的坐標系確定各物體位置,再使用雙目攝像頭測量物體深度。標定時,為提高相機精度,先進行單目標定后進行雙目標定,并使標定的圖像和位姿盡量多一些。

3 實時監控模塊的實現

3.1 微小特征的識別

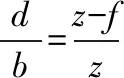

開關柜的分布如圖6所示,其中圖6(a)為開關柜上的鎖孔分布,圖6(b)開關柜內的開關分布。從圖6中可以看到開關柜的器件分布比較簡單,且背景單調容易分辨出開關柜上的各種特征。

圖6 開關柜的分布

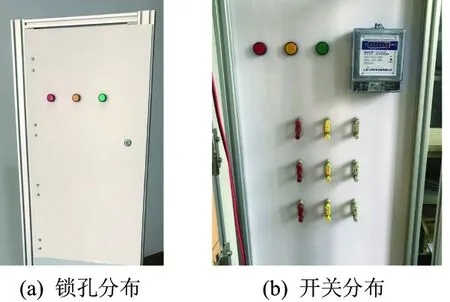

1) 鎖孔的識別

由于執行開鎖任務時涉及具體操作,不僅需要獲取準確的三維位置,還要使得鑰匙對準鎖孔,這就需要對鎖孔進行像素化定位。本文利用Mask R-CNN模型,由CNN網絡和RPN網絡實現對于鎖孔的基本識別和中心點的二維定位;通過Mask R-CNN的掩碼部分,獲取鎖孔的精確像素掩膜(圖7),通過最小外接矩算法[11]對掩膜矩陣計算分析,獲取鎖孔的角度信息。開啟雙目攝像機,獲取鎖孔的深度信息,系統將以上信息綜合,并返回給機械臂,完成開鎖操作。

圖7 鎖孔的定位和識別

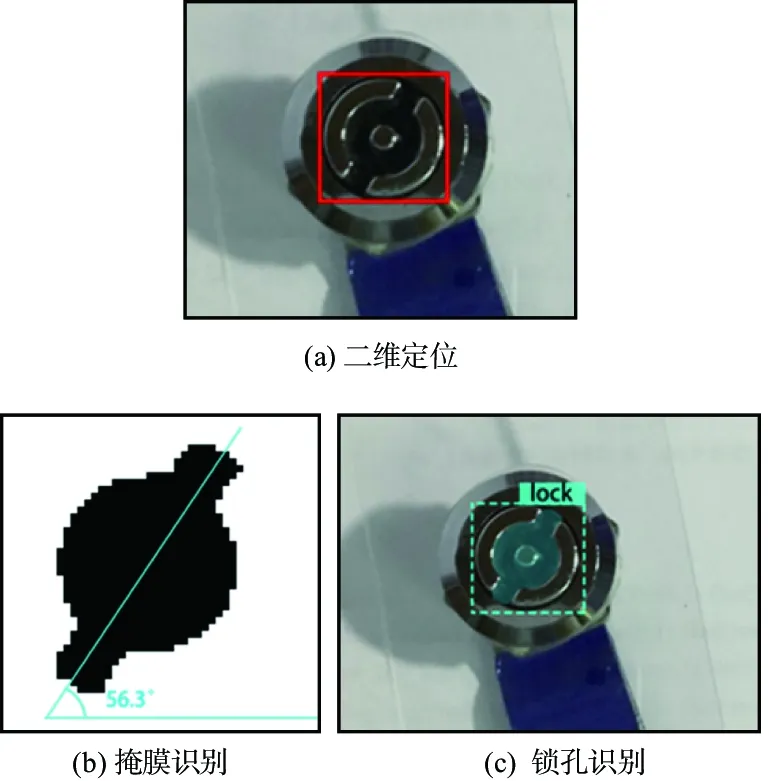

2) 開關的識別

開關的識別和鎖孔的識別原理一致,其掩膜識別如圖8所示。

圖8 開關的識別

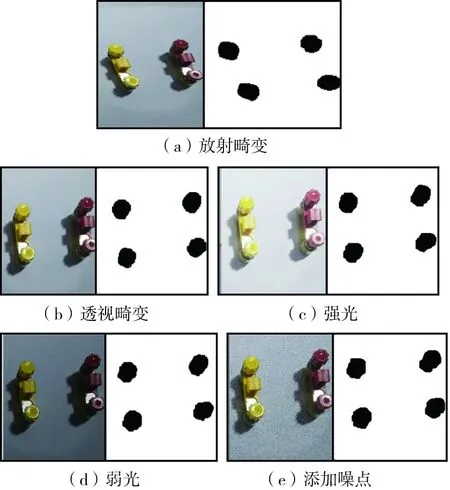

現實環境中存在角度、光線、模糊等對圖像識別的干擾。為模擬開關柜室內環境,增加模型魯棒性,對神經網絡的訓練圖像添加不同的扭曲、光照及模糊效果,并與未處理過的訓練圖像一起構成新的訓練數據集,不同情況的識別效果如圖9所示。

圖9 不同情況的掩膜識別

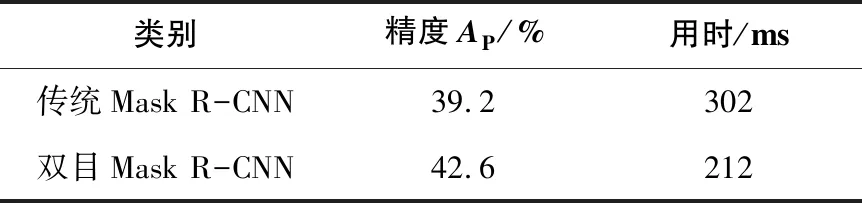

對以上幾種變形情況,計算每個類在區域級上的平均精度[12](AP);此外,對50cm范圍處的10mm特征進行識別和定位,測試所用的時間T;用AP和T來標定Mask R-CNN算法的識別性能。AP計算如式(5)所示。其中,TP和GT分別為檢測和目標真實檢測結果的像素點個數,AP為NGT個P值的求和平均。計算和測試結果如表1所示。

(5)

從圖9中可以看出各種變形的開關圖像均被像素化定位,相比傳統的Mask R-CNN,其精度有所提高,且雙目定位效率高、用時少,實現目標的高效定位及識別。

由于時間與成本限制,在訓練圖像分類模型時,對每一種類的訓練數據控制在200~500張,屬于小型數據集。借助圖像識別底層的特征提取的相似性,本文通過微調在ImageNet 1000上預訓練的卷積神經網絡,修改預訓練模型的softmax層,將已訓練好的參數作為初始化值,并通過凍結底層參數、訓練高層參數的方式,彌補數據量較小的不足。

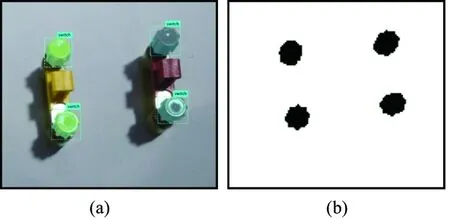

3.2 指示燈顏色識別

對于指示燈的顏色識別,定位要求低,僅需要讀取顏色信息即可,本項目使用的開關柜內置3種指示燈(圖10):紅色(故障),綠色(正常),黃色(異常),分別代表3種不同狀態,每種狀態只亮1盞燈。訓練模型時,分別對3個指示燈進行明暗判斷,并用one-hot編碼標注狀態。

圖10 指示燈示意圖

指示燈部分的標簽片段為{c1,s1,s2,s3},其中c1表示是否檢測到指示燈:若c1為0,表示模型未檢測到指示燈,則不關心s1-s3的值,即標簽片段為{0,?,?,?};若c1為1,表示檢測到指示燈。

分別用s1-s3判斷各個燈的明暗情況,其中:s1,故障(紅);s2,異常(黃);s3,正常(綠)。用1和0分別代表指示燈的亮與暗。代表正常狀態的標簽片段為{1,0,0,1},故障為{1,1,0,0}。

4 結語

本文結合深度學習和雙目視覺技術,基于雙目Mask R-CNN系統,設計了繼電室機器人的實時監控模塊,針對需要精準定位的鎖孔和開關,進行扭曲、光照以及模糊等不同變形處理的圖像訓練,形成一個小型數據集,最終經實驗檢測,該監控模塊能夠實現對鎖孔和開關的高效定位和精準識別,在50cm的范圍外對10mm物體(鎖孔開關直徑)進行定位與識別。繼電室機器人有了實時監控模塊便能感知定位,配合機械臂運行,真正意義上完成智能化檢測,減輕人工負擔,并可承擔繁重的檢測任務,對于大型繼電室具有一定的經濟價值。