基于預訓練語言模型的中文地址命名實體識別

李廷元,楊 勇

(中國民用航空飛行學院計算機學院,廣漢 618307)

0 引言

命名實體識別(named entity recognition,NER)是自然語言處理和構建知識圖譜的基礎任務,其目的是從海量的原始數據中準確識別出時間、地點、人物、組織等實體信息。命名實體識別的效果直接影響到其下游任務效果,因此顯得格外重要。通過從快遞單中識別姓名、電話、省、市、區(qū)等關鍵實體內容,形成組織結構清晰的結構化數據,可以幫助物流行業(yè)從業(yè)者快速地進行有效信息提取,從而減少客戶填單的時間成本,最終達到提高物流行業(yè)從業(yè)者工作效率的目的。

目前,常見的命名實體識別方法包括基于規(guī)則和詞典的方法、基于機器學習的方法和基于深度學習的方法這三大類。早期的命名實體識別任務中采用的方法是基于規(guī)則和詞典的方法,需要專家手動構建規(guī)則,將給定的文本數據與規(guī)則進行匹配從而得到相應的命名實體信息。該方法在處理小規(guī)模的數據時精確度會很高,但是隨著數據集的增大,規(guī)則的構建會更加復雜且困難,耗時耗力且可移植性差。

基于機器學習的方法主要包括隱馬爾可夫模型(hidden Markov model,HMM)、最大熵模型(maximum entropy,ME)、支 持 向 量 機(SVM)和條件隨機場(conditional random field,CRF)等模型。雖然相較于基于規(guī)則和字典的方法,實體識別的效果得到了進一步的提高,但是統計模型的狀態(tài)搜索空間龐大、訓練時間長、過于依賴特征選取及數據集,耗時耗力且實驗效果不顯著。

伴隨著深度學習的發(fā)展,將神經網絡應用于處理命名實體識別任務,成為目前較為流行的一種方式。Huang等提出使用長短期記憶網絡(long short-term memory,LSTM)、雙向長短期記憶網絡(bi-directional long short-term memory,BiLSTM)等模型來對文本中的上下文特征進行提取,最后通過條件隨機場(conditional random fields,CRF)來獲取最優(yōu)的序列,得出實驗最優(yōu)結果。李綱等在已建立BiLSTM-CRF算法模型的基礎之上,為了達到更好的命名實體識別效果,其通過結合垂直領域的先驗經驗,使得實體識別的效果更佳。相較于之前傳統的機器學習方法,在命名實體識別任務上基于深度學習方法表現更加出色,但是依然存在著一些局限性,如對語義特征的獲取不夠豐富,無法充分理解語義特征,訓練后的詞向量是屬于靜態(tài)編碼的一種,是固定的,無法解決一詞多義的問題,從而導致算法模型對文本數據的理解與表達的意思依舊存在一些偏差。對此,為了提高深度學習在特征提取這一方面的能力,增加其對語義特征豐富度獲取的能力,Vaswani等提出了Transformer機制。該機制通過Attention機制直接對輸入序列進行建模,極大地提高了模型的并行計算能力。之后,2018年Devlin等在Transformer機制的基礎上,提出了BERT(bidirectional encoder representation from transformer)模型,可以獲取更加豐富的語義特征,同時也極大地縮減了訓練時間。

本 文 旨 在 探 究 預 訓 練 模 型BERT、ERNIE、NEZHA結合BiGRU-CRF模型在中文地址命名實體識別上的性能。首先對以上三種預訓練模型從原理及結構兩個角度進行簡單介紹,之后在此基礎之上搭建算法模型,令其與BiGRU及CRF結合。將構建好的算法模型應用于指定的數據集中進行命名實體識別任務。最后分析實驗過程及其原因得出最終結果。

1 預訓練模型結構及原理介紹

1.1 BERT

BERT模型是由Google公司于2018年提出的基于Transformer機制的預訓練模型。BERT采用雙向Transformer網絡結構,

采用大規(guī)模的文本語料進行預訓練操作,并且其在處理單個單詞的時候,還能夠考慮到該詞之前與之后的單詞,從而得到更加豐富的上下文語義特征,最終得到一個無監(jiān)督的、泛化的預訓練模型。BERT采用新的MLM(masked language model)的方式進行預訓練,不同于傳統那樣采用單個單方向的語言模型進行預訓練或者是將兩個單方向預訓練的語言模型進行簡單拼接的方式進行預訓練過程,通過新的方式進行預訓練可以獲取到更為深層次的語言特征信息,使得預訓練的效果更優(yōu)。BERT設計了兩個任務來預訓練該模型,第一個任務是采用MLM的方式來訓練語言模型,MLM簡單來說就是以15%的概率用mask token([MASK])對任意一個訓練序列中的token進行隨機替換,之后對原[MASK]位置的字符進行預測。它通過預測被替換的字符來學習句子內部字符之間的關系,從而達到雙向預測的目的。第二個任務是采用下一句預測的方式,對句子級別的上下文關系進行獲取,從而達到預訓練效果的提升。引入這個任務可以讓模型更好地學到連續(xù)的文本片段之間的關系,從而獲取更為豐富的語義信息,使得實驗效果更佳。

從結構層面分析,BERT是由多個Transformer編碼器以某種方式疊加在一起,來對文本中的語義特征進行捕獲。而其中每一個Transformer編碼器又是由自注意力機制(selfattention)層和前饋神經網絡層兩部分組成。其中,自注意力機制是Transformer的核心機制,使用自注意力機制的優(yōu)勢在于,它不僅考慮了單個單詞對于整個文本的重要性,同時還解決了傳統循環(huán)神經網絡中存在的長期依賴的問題,在此基礎上模型的并行計算能力也得到了很大的提升。

1.2 ERNIE

ERNIE(enhanced representation through knowledge integration)是 百 度 公 司 于2019年4月 對BERT模型做了進一步的優(yōu)化后所提出的預訓練模型。ERNIE被提出之后,先是針對BERT中使用的遮掩策略進行了進一步的優(yōu)化與改正。它在預訓練時采用的遮掩策略是對文本數據中整個詞進行屏蔽,在此基礎上來學習詞與實體的表達,相對于BERT模型中僅僅只針對單個字符進行遮掩,這種方式訓練效果更好,采用這種方式不僅增強了語義表示能力,還使得在語言推斷任務上的效果更為顯著。由此可以看出,ERNIE1.0僅僅只是優(yōu)化了BERT遮掩詞策略就取得了不錯的效果,那如果使用更多較好的學習任務來訓練模型,是否會取得更好的效果?在這一想法的驅使下,ERNIE2.0應運而生。它采用多任務學習增量式方式來組建預訓練任務,同時通過持續(xù)學習的語義理解來構建預訓練框架,從而從多個維度來獲取文本數據的語法、句法、語義等信息,極大地提升了語義特征的豐富度。使得在多種自然語言處理任務中呈現的效果都優(yōu)于BERT。

1.3 NEZHA

NEZHA(Neural ContextualiZed Representation for CHinese LAnguage Understanding)是由華為諾亞方舟實驗室研發(fā)推出的中文預訓練模型。NEZHA是分別從模型、預訓練任務和訓練算法三個方面對BERT模型進行改進的預訓練模型,一經推出就備受關注。

模型方面的改進是采用相對位置編碼方式取代了BERT中的絕對位置編碼,經過大規(guī)模的文本訓練,實驗結果表明,采用相對位置編碼方式使得模型在各個下游任務中的效果得到明顯提高,更優(yōu)于采用BERT中的絕對位置編碼。

預訓練任務方面的改進是引入Span預測任務,其采用全詞Mask技術取代了原始BERT模型中Mask單個中文字或單個英文字符技術,從而獲取更為豐富的語義特征,模型訓練效果表現更佳。

訓練算法方面的改進是采用混合精度訓練(mixed precision tranining)方式結合LAMB優(yōu)化器,使得模型訓練時即使采用較大的批量大小,也可以明顯提升模型的訓練速度,從而得到較為可觀的訓練效果。

2 基于預訓練模型的中文地址命名實體識別模型搭建

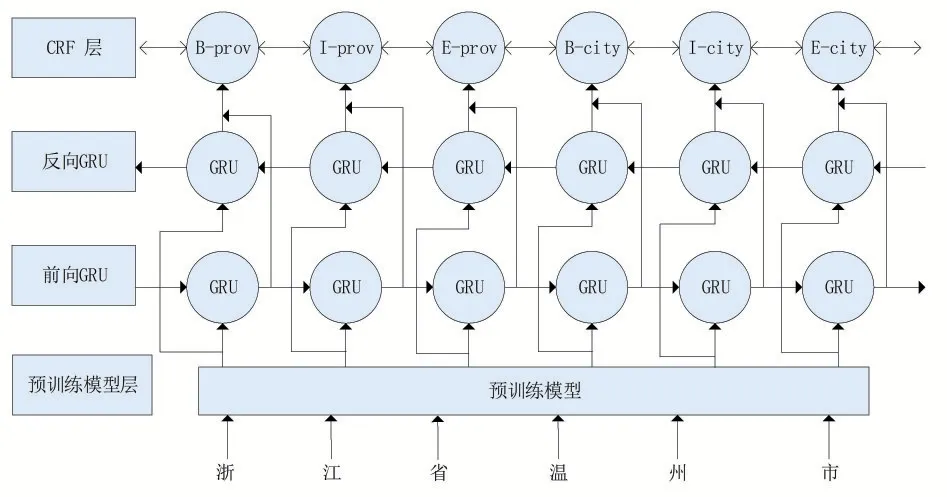

首先采用預訓練模型對給定的數據集進行語義特征提取,根據文本的上下文信息生成動態(tài)詞向量,再將預訓練的結果輸入到BiGRU模型中進行進一步的訓練,最后通過CRF對Bi-GRU訓練出的結果進行修正,得到輸出的最優(yōu)標注序列。本文之所以選擇BiGRU而不使用BiLSTM,是因為相對于BiLSTM來說,BiGRU的結構更為簡單,也可以和BiLSTM達到同樣的訓練效果。基于預訓練模型的中文地址命名實體識別模型如圖1所示。

圖1 預訓練模型-BiGRU-CRF算法模型

3 實驗

3.1 數據集

本文采用阿里中文地址要素解析比賽數據集來訓練模型。數據集采用BIOES標注方式進行標注,B代表begin,用來標注實體的開始部分;I代表inside,用來標注實體的中間部分;O代表other,用來標注與實體無關的信息;E代表end,用來標注實體的結尾部分;S代表single,用來標注單一的實體;數據集中包括訓練集、驗證集和測試集。

3.2 評估標準

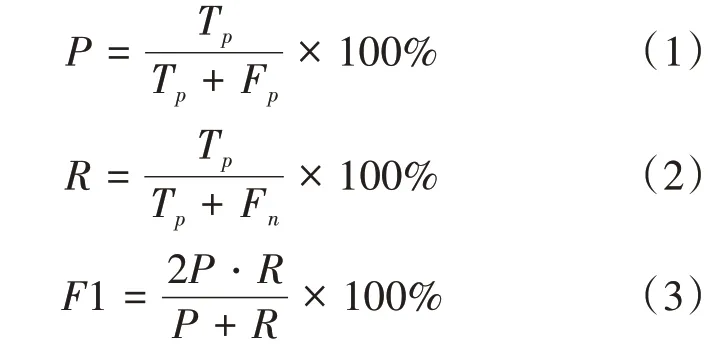

本文對其評價指標包括:準確率(Precision)、召回率(Recall)和1值,計算公式如下:

其中,T為正確識別的實體個數,F代表識別錯誤的實體個數,F代表未識別的實體個數。

3.3 參數設置

BERT中文預訓練模型(bert-base-chinese)具有12個表示層,768維隱藏層,12頭注意力機制,參數大小為108M;ERNIE預訓練模型(ernie-1.0)具有12個表示層,768維隱藏層,12頭注意力機制,參數大小為108M;NEZHA預訓練模型(nezha-base-chinese)具有12個表示層,768維隱藏層,12頭注意力機制,參數大小為108 M。本次實驗采用的優(yōu)化器為AdamW,它在Adam的基礎上加了權重衰減的優(yōu)化器,可以解決L2正則表達化失效問題。學習率設置為2×10,batch_size設置 為300,訓 練epoch設置為10,dropout設置為0.3來避免過擬合。

3.4 實驗結果

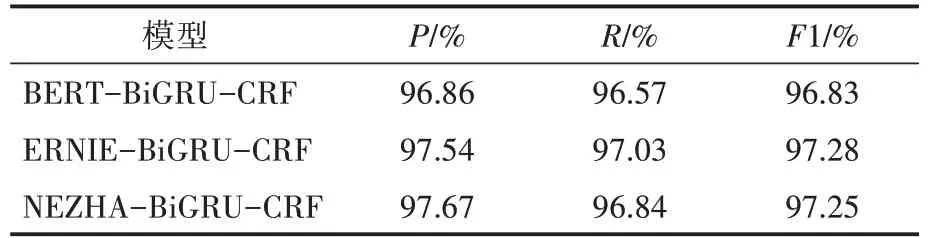

本次實驗搭建了不同的預訓練模型與BiGRU及CRF進行組合,本次實驗環(huán)境基于相同的軟硬件環(huán)境進行執(zhí)行,設計了多組對比實驗,從而驗證基于不同的預訓練模型的命名實體識別模型在中文地址識別過程中所展示的實驗效果。實驗結果如表1所示。

表1 不同模型實驗結果對比

通過比較不同的預訓練模型與BiGRU及CRF相結合組成的算法模型在數據集上得出的訓練結果可知,預訓練模型可以獲取更加豐富的語義信息,在訓練過程中,預訓練模型可以更好地結合文本數據的上下文語義信息,能夠很好地對詞向量進行表示,使得預訓練模型對于實體識別的效果更好。根據實驗結果呈現的數據來看,相較于ERNIE和BERT,NEZHA的實驗結果表現更佳,性能也更優(yōu)。

由此我們可以得出實驗結論:預訓練模型具有泛化性,可以在訓練過程中獲取更為豐富的語義信息,解決了一詞多義的問題,在命名實體識別任務中表現好、精度高,但是也依舊存在著一些問題,比如對詞邊界問題考慮不周,易對詞匯邊界識別出錯、重疊等缺陷。

4 結語

目前,國內外學者已經在中文命名實體識別方面做了很多研究工作。基于深度神經網絡的預訓練模型在自然語言處理方面有著很好的表現。在未來工作中,也會傾向于預訓練模型方面的研究。下一步將會著手于在進行預訓練模型之前對數據預處理方面的研究,嘗試對文本數據進行分詞,分清詞邊界,解決詞匯重疊等一些問題,在提高模型實體識別精確度的基礎上,對模型的性能方面做出改善,使得中文地址實驗效果表現更好。