Non-local注意力機制生成對抗網絡的油畫修復研究

何 妍, 何 嘉

(成都信息工程大學計算機學院,四川 成都 610225)

0 引言

油畫材料的特殊性、存儲方式不當等原因可能導致圖像畫質出現破損。例如存放環境的溫度、濕度的變化可能導致油畫掉色,出現破損區域,就會降低油畫的價值。通過對油畫圖像的修復,可以修復其藝術性。然而,油畫修復是一個非常耗時的精細工作,隨著深度學習圖像修復技術[1]的出現,可以高效地對油畫藝術品進行圖像修復。

圖像修復(image inpainting)最早由Bertalmio等[2]在2000年提出,是一種基于偏微分方程的圖像修復方法。主要思想是將待修復破損區域的周圍信息沿著等照度線方向由外向內傳播,此方法利用了物理學中熱擴散方程的方法。雖然,之前的圖像修復方法[3-5]在整體結構上能夠修復完整的畫面,但對圖像的修復效果處理不太令人滿意。

因此,提出一種基于Non-local注意力機制生成對抗網絡修復方法,修復破損的油畫圖像。該方法主要在3方面進行了改進:(1)使用門控卷積替換生成網絡的普通卷積層,該結構有助于網絡進行特征篩選;(2)網絡生成器分為第一、第二階段,通過雙階段設計提升圖像細節的修復效果。在第一階段,使用擴張卷積,以增大圖像的感受野,有助于捕捉到更多的圖像特征信息;在第二階段,引入Non-local注意力機制,該機制使用的是全局特征信息,讓網絡感受野的范圍進一步擴大,修復圖像的效果更好;(3)判別模型采用光譜歸一化馬爾可夫判別器,用來解決圖像邊緣不和諧的問題。在損失函數上,采用感知損失、GAN損失和L1重建損失的結合,使訓練更加穩定、生成的圖像效果也更好。實驗證明,文中提出的對不規則的破損油畫圖像進行修復的方法,與其他修復方法[6-8]相比,具有更好的修復效果。

1 相關工作

近年來隨著深度學習技術[9]的快速發展,圖像修復成了計算機視覺的熱門領域。Satoshi等[6]提出了基于雙判別器的圖像修復方法Global&Local,通過雙判別器來提升網絡對全局信息和局部信息的融合利用,使網絡在完整區域中尋找最相似紋理塊,進行圖像復原。Guilin等[7]在ECCV上首次利用部分卷積網絡PartialConvGAN來實現圖像修復。網絡主體由生成器和判別器組成,生成器用來修復破損圖像,判別器用來判斷輸入的圖片是原始圖片還是生成器生成的圖片,并將結果反饋給生成器讓其進行不斷的優化,形成一種博弈狀態,使圖像修復的效果更真實。最近,Yu等[8]提出DeepFillv2網絡,它們采用雙階段生成網絡結構。首先,在生成器第一階段,提取圖像中的語義信息;其次,在生成器第二階段將粗生成網絡的結果作為輸入,使得生成紋理結構更合理。

2 網絡結構

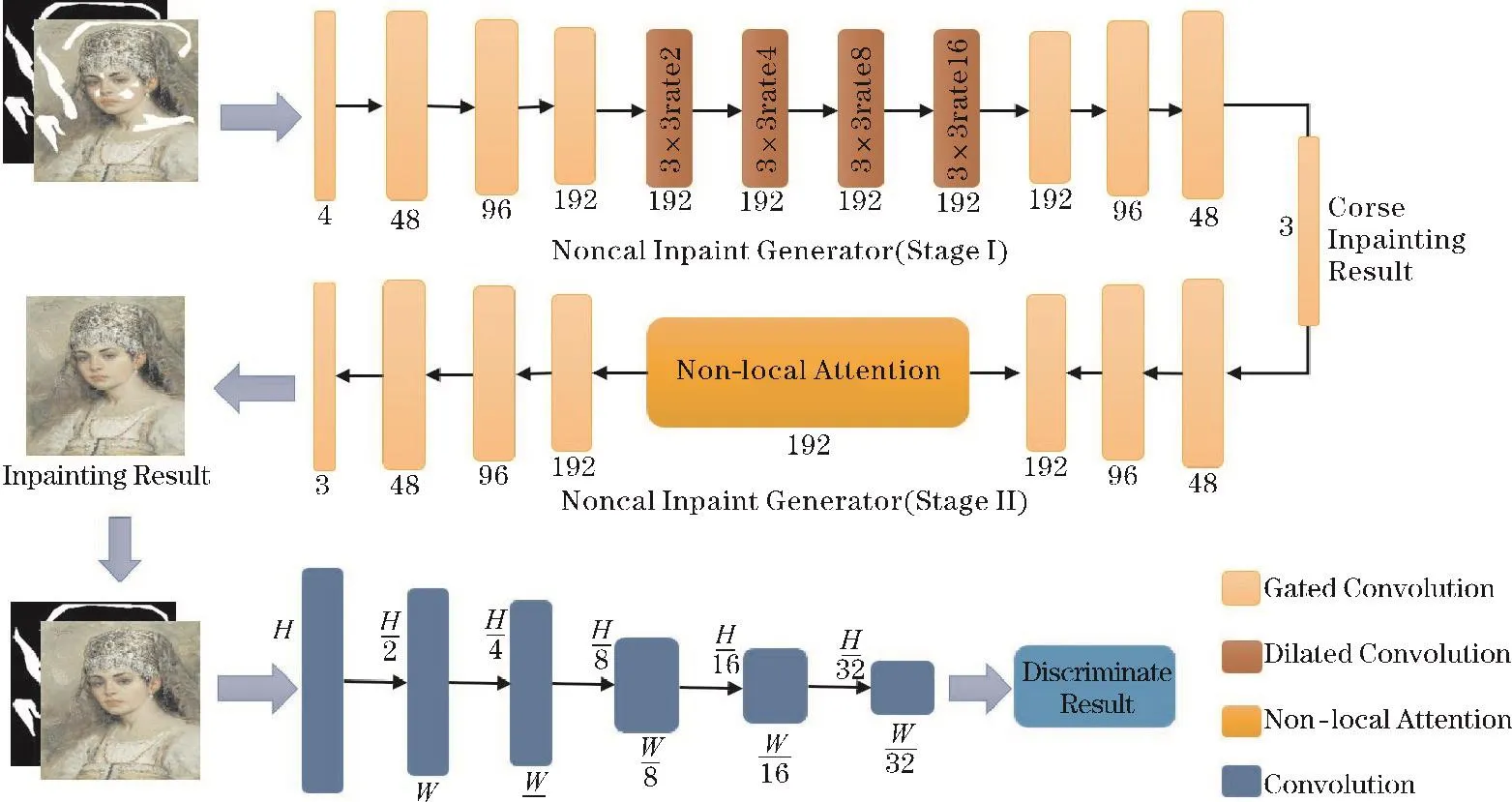

文中提出的油畫圖像修復算法的網絡結構如圖1所示,該算法以生成對抗網絡為基本的模型架構,由生成器和判別器組成。卷積單元下面數字48、96、192代表卷積后輸出通道數的大小,4和3分別是輸入和輸出通道數大小。

圖1 網絡結構

2.1 生成器

生成器輸入是RGB破損圖和掩膜灰度圖組成的四通道圖像,輸出為修復圖像。生成器是由兩個編碼器-解碼器組成,分為第一和第二階段,先得到粗略的修復結果,然后再進行精細化修復,兩者組成完整修復流程。

門控卷積是一種具有特征篩選卷積層,因此,使用門控卷積替換普通卷積。在生成器的第一階段,引入擴張卷積層[10],在空間維度上增大感受野,讓網絡獲得更多的特征信息,幫助圖像修復。在生成器的第二階段,引入Non-local[11]注意力機制,利用它建立局部特征信息和全局特征信息的聯系,讓網絡的修復可以依賴于圖像的整體結構,提升圖像的修復效果。

2.1.1 Gated Convolution門控卷積

門控卷積[12]最早出現在NLP的任務中,取得了良好的結果,Yu等[8]將其引入圖像修復任務。門控卷積的計算分3個步驟:首先,將特征圖分別輸入獨立的卷積層,獲得經過處理的特征圖和通道權重圖;然后,使用Sigmoid函數激活通道權重圖,將值調整到0~1;再將處理過的特征圖和通道權重圖進行點乘操作;最后使用ELU激活函數進行特征激活,得到最終輸出結果。

2.1.2 Dilated Convolution擴張卷積

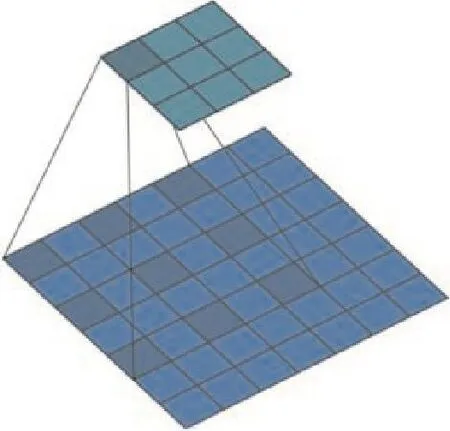

Dilated convolution擴張卷積,由Google團隊[13]在2014年提出,其思路是在普通卷積核中通過0填充的方式,在不增加參數的同時,增大圖像的感受野,從而獲取更多的特征信息。普通的卷積操作,相當于擴張率為1的擴張卷積。

圖2是擴張率為2,卷積核大小為3×3的擴張卷積[12],它通過0填充的方式,使卷積核的感受野大小變成5×5。相比標準的卷積操作,擴張卷積多了一個參數擴張率,代表擴張的大小。

圖2 擴張卷積結構

將擴張卷積應用到圖像修復中,在生成器第一階段結構的中間部分加入4層擴張卷積,隨著層數的加深,擴張卷積層的擴張率不斷變大,四層擴張率分別為2、4、8和16。通過疊加擴張率不斷變大的擴張卷積層,來實現不斷增大圖像感受野,增強網絡對圖像整體特征信息的提取能力和使用能力。

2.1.3 Non-local Attention注意力機制

Non-local[11]注意力機制通過計算特征圖任意兩個位置之間的交互信息,建立特征值遠距離依賴,不同于傳統卷積只能局限于相鄰特征點,它相當于構造一個和特征圖尺寸一樣大的卷積核,獲得更多特征信息。Non-local注意力機制通過引入全局特征信息,增大圖像的感受野,為圖像的補全獲取更多豐富的特征信息。該機制在深度學習領域得到廣泛應用[11]:語義分割、目標檢測、圖像超分辨率、圖像去噪和文本檢測。因此,文中引入Non-local注意力機制,以提升網絡的圖像修復效果。

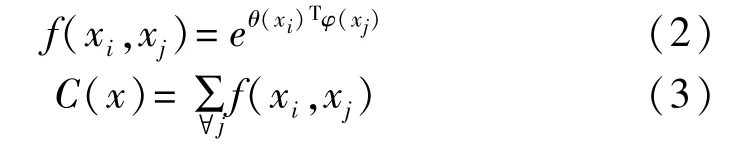

Non-local[11]如式(1)所示

式中x、y為輸入和輸出,i代表特征值當前位置的響應,j代表的是全局位置的響應。g(xj)=Wgxj,Wg為權重,f(xi,xj)如式(2)所示,C(x)如式(3)所示。

式中f(xi,xj)是 Non-local的核心計算所在。其中,θ(xi)=Wθxi,φ(xj)=Wφxj,Wθ和 Wφ是權重。 θ(xi)和φ(xj)的計算細節如表1所示。T是對矩陣進行轉置,xi和xj分別是當前位置特征值和全局位置的特征值。f(xi,xj)通過矩陣相乘的計算方式,來建立局部特征信息和全局特征信息的聯系。

表1 θ(xi)和 φ(xj)結構表

式中的C(x)是歸一化因子,以實現特征的softmax歸一化,它使特征值分布趨于中心化,避免極值的出現(極值會導致全黑或全白的修復結果)。

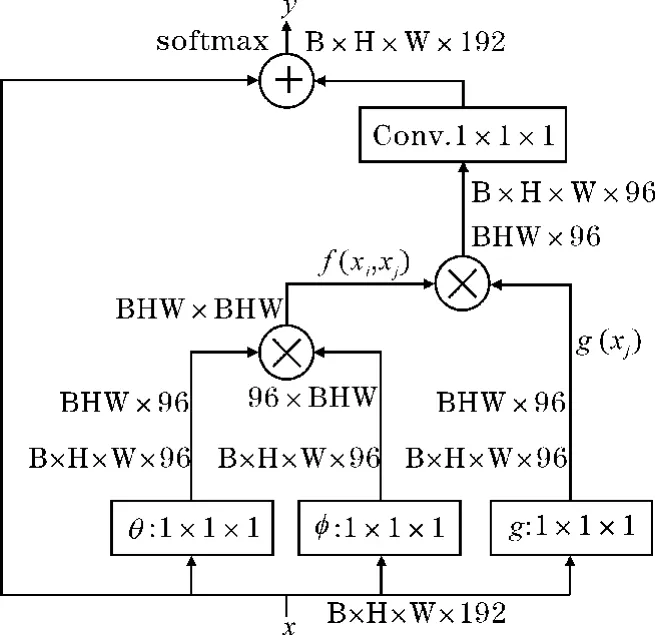

Non-local的結構如圖3所示,它涉及四次卷積、兩次矩陣相乘和一次矩陣拼接計算。其中,B(Batch Size)代表批處理大小,H(height)和W(width)代表特征圖的長和寬,192和96是特征圖的通道數量,1×1×1代表卷積核的大小以及卷積步長。?表示矩陣相乘,8表示把兩個特征圖的特征通道拼接到一起。

圖3 Non-local attention結構

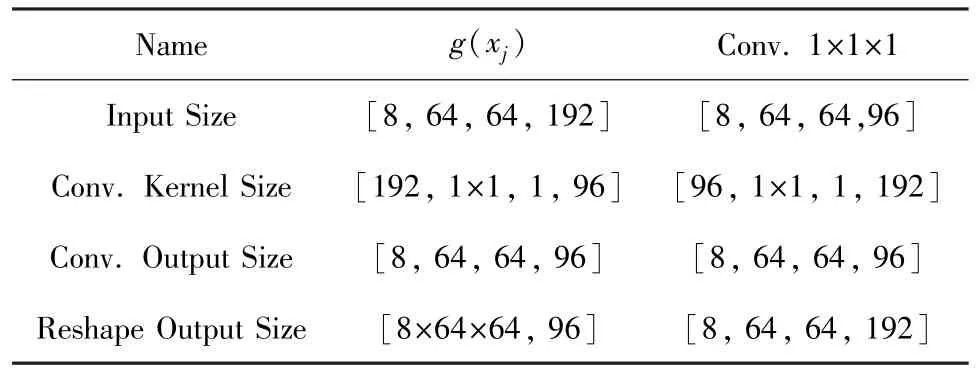

表1和表 2是對圖 3中 θ(xi)、φ(xj)、g(xi)、Conv.1×1×1結構的解釋。其中,第一行是函數的名稱;第二行Input Size和第四行Conv.Output Size分別是特征圖的輸入和輸出尺寸,4個值分別為批大小、高度、寬度和通道數;第三行Conv.Kernel Size是卷積核尺寸,4個值分別為輸入通道數、卷積核大小、卷積步長和輸出通道數;第四行Reshape Output Size是對卷積輸出變形后的特征圖大小,2個值分別為批大小乘以高度乘以寬度、通道數。

表2 g(xi)和 Conv.1×1×1結構表

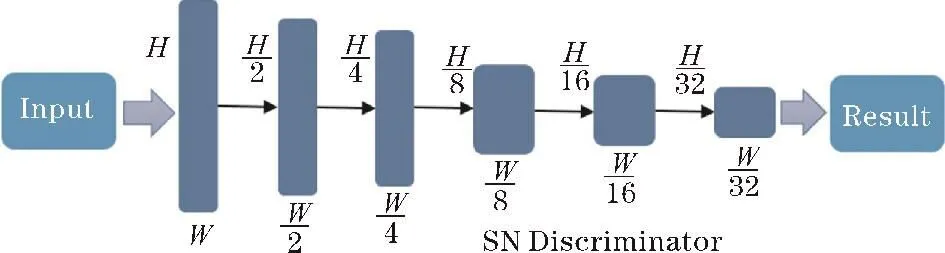

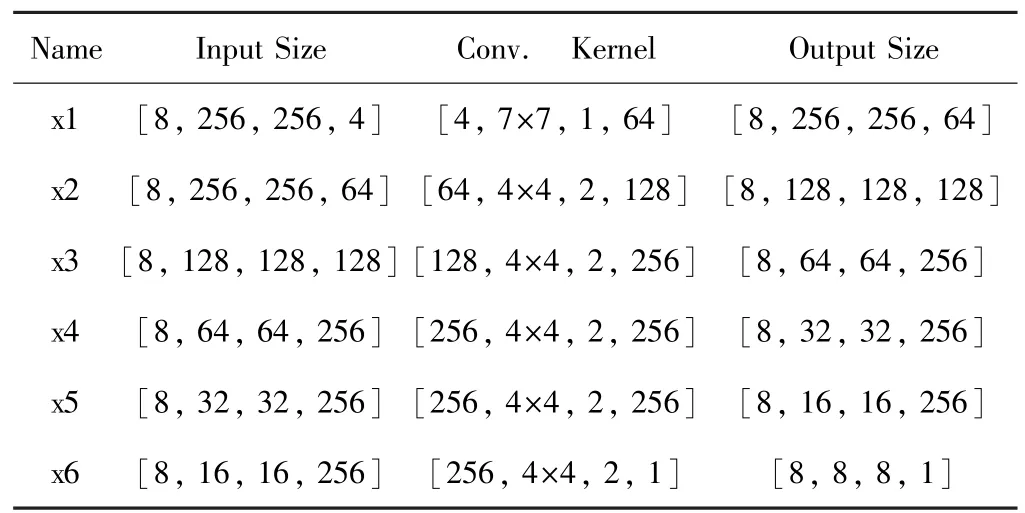

2.2 SN Discriminator判別器

采用光譜歸一化馬爾可夫判別器(SN-Discriminator)作為模型判別器,網絡通過判別器來進行對抗訓練,進而提升生成器的生成效果。判別器結構如圖4所示,圖中的H、W代表圖像的高度和寬度。

圖4 判別器結構

判別器的輸入是修復圖片和掩膜灰度圖組成的4通道圖片,輸出是判別結果。判別器的第一層采用的卷積核為7×7,大卷積核具有大的感受野,能獲取更多的特征信息;后五層采用卷積核大小4×4。表3是對SN-Discriminator判別器結構的詳細解釋。表中第一列是卷積層的名字;第二列和第四列是輸入和輸出特征圖的大小,4個參數分別為批大小、高度、寬度、通道數;第三列是卷積核的大小,4個參數分別為輸入通道數、卷積核大小、卷積步長、輸出通道數。

表3 SN-Discriminator判別器結構表

3 損失函數和優化器

3.1 損失函數

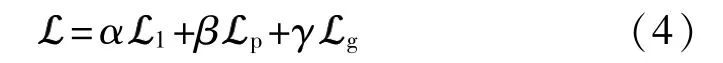

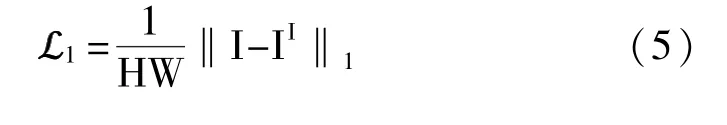

選取L1作為重建損失函數,如式(5)所示H代表圖像的高度,W代表圖像的寬度,I代表原圖,II代表破損的油畫圖像。

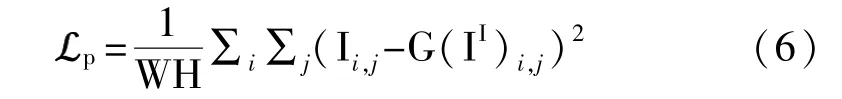

感知損失為

i和j是像素的坐標值,I是無損原圖,II是破損圖,G(II)代表的是經過修復后的油畫圖片。

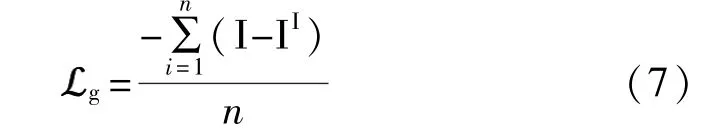

GAN損失計算的是均值誤差為

式中n是樣本總數,i是樣本序號。

3.2 Adam亞當優化器

本文算法使用的是Adam優化器[14],通過一階求導推導出偏差,得到目標函數的梯度,然后使用梯度值優化模型的參數。Adam優化器參數如下:學習率為0.0001,動量參數belta1和belta2的大小為0.5和0.999。

4 實驗數據集

4.1 數據收集

使用開源Gallerix油畫數據集,從中選取完整的油畫圖片來驗證網絡模型的性能,部分數據集如圖5所示。使用3000張印象主義風格的油畫圖像作為本文實驗數據集,圖像分辨率為256像素,飽和度為100%,使用其中2700張作為訓練集,300張作為測試數據集。

圖5 部分數據集展示

4.2 破損圖像的生成

在模型訓練時,本文算法通過隨機生成破損區域的方式進行數據增強,使用隨機角度、長度和寬度的線條去模擬破損區域,生成的破損掩碼區域為占總面積的10%~25%。每次生成的破損區域不相同,這豐富了訓練數據,使訓練出的網絡模型能夠適應多種破損形態的油畫。通過隨機生成破損區域的方式,進行數據增強,避免模型的數據過擬合問題,增強模型的泛化性能。

5 實驗及結果

5.1 實驗環境

實驗在一臺深度學習服務器上完成,本文算法通過Python語言編程實現,使用PyTorch深度學習框架。服務器的具體配置如下:CPU型號為英特爾I7-7700,操作系統是Ubantu 18.04 LTS,系統的內存大小是128 GB,計算顯卡使用的是2條11GB顯存的英偉達GTX 2080Ti深度學習圖形顯卡。

5.2 實驗參數及過程細節

本文算法模型訓練200個迭代周期,每個迭代周期的步長為10000步,BatchSize批處理的大小為8。訓練時,使用的掩模都是非連續隨機生成,占圖像面積的10% ~25%。在此范圍內,圖像修復效果比較理想,能較好地完成油畫修復的任務。模型訓練的前100個周期,損失函數值從15.01,逐漸下降到了6.50。在100~200的周期內,損失函數值徘徊在6.0附近,并逐漸趨于穩定。損失由最初的15.01,下降到最后的5.62。

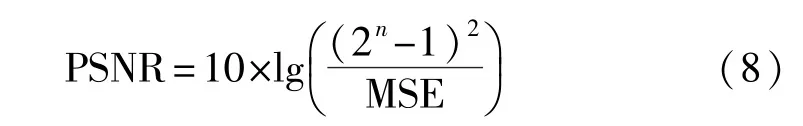

5.3 評價指標

使用兩個圖像質量評價指標來定量評估網絡的性能,分別是峰值信噪比(PSNR)和結構相似性(SSIM),數值越大,表示失真越小。

式中的MSE是均方誤差,n代表的是每個采樣值的比特數。

式中μx和μy分別代表x、y的平均值,σx和σy分別代表x和 y的標準差,σxy代表 x和 y的協方差,而 C1、C2、C3為常數,避免分母為零導致的計算錯誤。

5.4 實驗結果

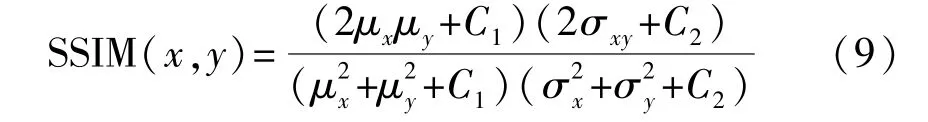

為驗證本文算法圖像修復的有效性,使用300張測試圖片,在開源Gallerix油畫數據集上進行測試。與3種經典的圖像生成對抗網絡進行比較,3種網絡分別是:使用雙判別器的圖像修復網絡Global&Local[3],使用基于部分卷積的 PartialConv-GAN[4]網絡,以及專門針對自由形式掩碼修復的Deepfillv2GAN[7]網絡,量化指標如表4所示。表4的各列依次是模型名稱、量化指標以及處理一張圖片的平均耗時(ms)。圖6是實驗的效果圖。

圖6 實驗效果圖

表4 實驗結果量化表

實驗對比模型一:Global&Local網絡。它是一種使用雙判別器的生成對抗網絡。雖然它是幾種網絡中效果較差的,但不可否認它是一種結構簡單、性能強大的網絡模型,在圖像修復領域有著重要的影響。

實驗對比模型二:PartialConvGAN網絡。它的誕生就是用于圖像修復,針對圖像中非矩形的破損區域進行修復,通過部件卷積實現對圖像中有效元素和缺失元素的區別對待。模型訓練時,卷積層僅僅對滿足有效像素條件的元素進行卷積和歸一化操作,然后根據區域權重更新規則實現對權重的更新操作。它的修復效果好于Global&Local網絡。

實驗對比模型三:Deepfillv2網絡。它被用于對人臉圖像不規則破損區域進行修復的生成對抗網絡,和本文一樣采用雙編碼器和雙解碼器的生成結構。通過注意力機制來實現對破損區域特征信息的修復,這說明了注意力機制在圖像修復中的重要性,在實驗效果上,優于Global&Local和PartialConvGAN網絡模型。

本文網絡在兩項圖像修復效果量化指標峰值信噪比和結構相似度均超過其余3種網絡。同時,通過觀察圖6的實驗效果,可以發現本文算法修復的圖像紋理更加清晰、邊緣細節上處理很好,明顯優于其余3種網絡。在表4的圖像處理速度比較中,本文算法處理一張圖像需要花39 ms,與另外3種網絡相比無明顯差異,這也體現了深度學習方法在圖像修復中處理速度上的優勢。

6 結束語

得益于深度學習圖像修復技術的發展,提出一種基于Non-local[11]的非局部注意力機制生成對抗網絡的油畫修復方法,盡可能地恢復油畫圖像的價值。該網絡受雙編碼器-解碼器生成結構、Non-local非局部注意力機制和門控卷積擴張卷積結構的啟發,在提升破損區域修復效果和色彩的同時,也能對油畫破損邊緣區域進行修復,較好地提升了油畫修復的效果。實驗結果表明:本文方法具有對不規則的油畫破損區域進行有效修復的能力。

本文網絡的損失函數仍有優化的空間,在對特征的使用上仍然具有改進的潛力,在下一步研究中將考慮加入超圖卷積等結構來優化和提升網絡。