基于“碳中和”的高性能計算集群組網建設方法探析

陳 陽, 陳堅澤

(廣東液冷時代科技有限公司,佛山 528000)

0 引言

2021 年3 月13 日,新華社公布了《中華人民共和國國民經濟和社會發展第十四個五年規劃和2035 年遠景目標綱要》(以下簡稱《綱要》),《綱要》指出以人工智能為代表的新一代信息技術,將成為我國“十四五”期間推動經濟高質量發展、建設創新型國家,實現新型工業化、信息化、城鎮化和農業現代化的重要技術保障和核心驅動力之一[1]。圍繞國家人工智能戰略布局和產業發展需求,各地政府積極建設人工智能技術支撐平臺,如人工智能基礎研究[2]、智慧交通[3]、區塊鏈金融、物聯網技術[4]等,同時啟動智慧城市大數據平臺[5]等建設,為人工智能研究和應用提供健全完善的基礎平臺服務。這些平臺建設對基礎計算算力提出了更高的要求,亟需建設一個高性能計算服務器集群公共服務平臺,為人工智能技術支撐平臺以及人工智能科學研究提供高性能、高通量的算力科研保障。同時,高計算平臺也意味著需要更高的能耗才能支撐高算力,在國家“碳中和”的政策下,如何利用新型技術,解決高性能數據中心所帶來的高能耗問題也是建立高性能數據中心的潛在研究問題。

本文以華南某科研機構建立高性能計算服務器集群建設項目為例,重點介紹高性能計算服務器集群建設中的高性能計算集群、節能建設、分布式存儲集群、高性能計算網絡等方案建設內容,并討論高性能計算服務器集群管理需求以及相應管理方法。

1 高性能計算服務器集群建設

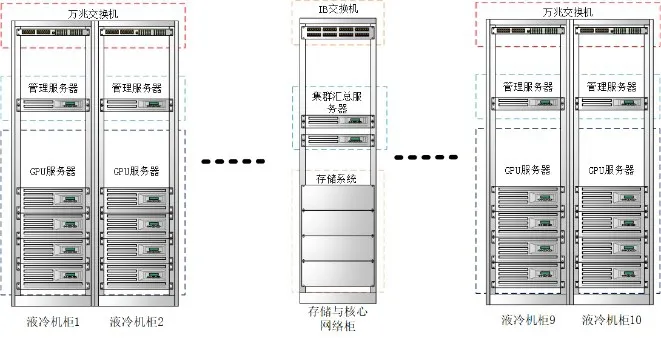

華南某科研機構在前期投資建設項目中已基本完成實驗室數據中心基礎條件建設,包括完成基礎機房環境、電氣系統、基礎綜合布線鋪設等方面的建設,現針對人工智能關鍵技術攻關的算力需求,搭建十個小型計算集群,每個計算小型集群配置算力1PFLOPS 計算資源,構建一個柔性的高性能計算集群,同時采用液冷散熱技術提升集群服務器散熱問題,減少空調機組裝配,實現“碳中和”節能目標。

圖1 高性能計算服務器集群建設機柜置放示意圖

下面從高性能計算集群、節能建設、分布式存儲集群、高性能計算網絡等方面闡述高性能計算服務器集群建設內容。

1.1 高性能計算集群方案

高性能計算集群建設基于高性能計算(High Performance Computing, HPC)技術基礎構建計算集群平臺,其中十臺管理服務器,分別用于管理十個集群,同時配備兩臺管理服務器,用于做統一集群管理。高性能計算集群總體業務架構分為以下四層遞進建設。

(1)基礎設施層:利用已建成的模塊,方便快速組裝,本項目在現有機房基礎設施上部署服務器集群、搭建高性能存儲集群、搭建內部集群網絡。

(2)平臺核心集群模塊:搭建核心GPU 計算集群、分布式存儲集群、高性能運算網絡。計算方面,搭建高性能GPU 計算服務器集群,支撐高密度算力運算需求;存儲方面,搭建分布式海量存儲集群,支撐海量數據高吞吐訪問及高容量存儲;網絡方面,搭建高速運算網絡、高速存儲網絡、管理網路。

(3)硬件上構建核心軟件中臺:主要實現集群管理與作業調度功能,其中,集群管理通過安裝部署集群管理軟件,構建服務器集群體系,實現算力資源虛擬化管理;作業調度則在集群基礎上部署作業調度管理軟件,構建算力資源調度體系,實現算力資源彈性調度管理。

(4)算力業務應用層:通過構建高性能計算開放平臺,對各用戶提供適用于各種運算業務的運算資源和數據,如大數據計算、基因測序、多模態數據模型、圖像識別等。

1.2 節能建設方案

從最新的國家政策導向可知,數據中心低碳節能已經是數據中心建設和運營很重要的一個指標,數據中心節能降耗成為國家“碳中和”“碳達峰”戰略的重要一環。因此,基礎計算平臺建設應該滿足IDC能耗政策要求。

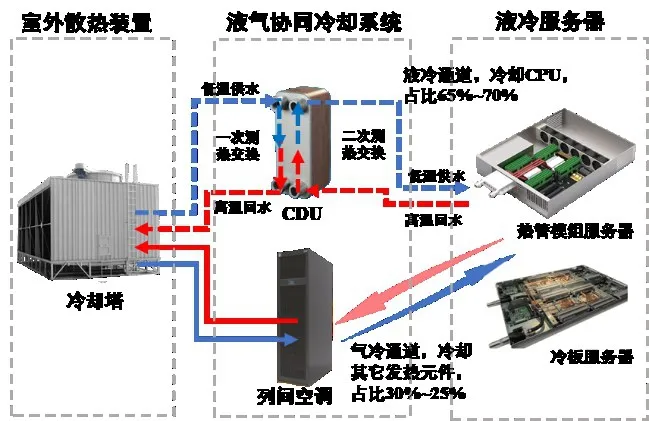

本次高性能計算服務器集群節能方案采用液冷熱管理節能技術,該技術利用超高導熱系數的液冷導熱模組將服務器高熱流密度的核心芯片熱量通過液冷模塊帶到服務器外,進一步通過水循環冷卻系統排到室外,液冷循環采用自然冷卻無需壓縮機,實現節能效果。圖2為本次建設采用的間接液冷系統熱管理架構圖,間接液冷系統由導熱液冷模組、快速接頭、液冷分配單元、冷量溫控單元、一次冷卻環路、二次冷卻環路、封閉氣冷通道、自然冷卻單元等構成,具有低能耗、高功率密度、高可靠性等優點。

圖2 間接液冷技術原理圖

1.3 分布式存儲集群方案

為構建分布式高性能存儲集群,集群建設采用基于BeeGFS 并行文件系統分布式存儲方案, 其主要優勢表現在:①分布式文件內容和元數據,有效避免架構瓶頸,一方面可跨多個服務器的條帶化文件內容,另一方面則可使文件系統的元數據存放于多個元數據服務器內。②兼容性好,BeeGFS存儲服務基于橫向擴展(Scale-Out)設計。每個BeeGFS文件系統實例可以具有一個或多個存儲服務組件,方便提高性能與空間。一個存儲服務實例具有一個或多個存儲服務組件。③緩存優化能力強,由于BeeGFS 自動使用存儲服務器上的所有可用RAM 自動進行緩存,因此它還可以在將數據寫入磁盤之前將較小的IO 請求聚合到較大的塊中。④優化高并發訪問,BeeGFS用于在高I/O負載的情況下提供最佳的穩健性和性能,優化解決簡單的文件系統(比如NFS)在高并發訪問的情況下存在嚴重的性能問題,以及在多個客戶端寫入同一個共享文件時會損壞數據等典型問題。

1.4 高性能計算網絡方案

在高性能計算場景下,由于集群之間需要相互通信,所以對網絡的帶寬和時延要求比較高(應用之間帶寬>40 Gbps,時延<10 us 微秒),現有的TCP/IP 軟硬件結構無法滿足該需求,因此需要使用RDMA(Remote Direct Memory Access)技術遠程直接內存訪問,構建IB(Infiniband)網絡實現高性能場景下高速度、高吞吐網絡傳輸需求。RDMA 模式對數據包的加工都在網卡內完成。因此就跳過了操作系統,直接把數據發送到網卡內,少了應用內存與內核數據之間的交互,所以速度上更快,時延更短。IB網絡:基于無限帶寬技術,這種網絡有很高的帶寬(100 Gb/s 以上)和非常低的時延(毫秒級)。

2 高性能計算服務器集群管理方法

2.1 高性能計算服務器集群管理需求分析

本次高性能計算服務器集群管理通過集群管理軟件,構建服務器集群體系,實現算力資源虛擬化管理。其中集群管理需求主要表現在如下方面:

(1)滿足對多種深度學習、機器學習及大數據任務的資源調度和管理需求,要求提供大規模GPU 集群調度、集群監控、任務監控、分布式存儲等功能。

(2)實現集群資源調度與服務管理統籌,提供針對GPU 優化的調度算法,實現集群資源調度高效管理。

(3)提供面向用戶的可視化接口或應用接口,網頁端可視化界面、客戶端SDK、集成開發環境(IDE)拓展接口等。

(4)提供豐富的用戶管理,集群、任務監控,任務調度,任務錯誤分析,任務監控等服務功能,提高運維人員的工作效率。

(5)實現容器化和微服務化,使得運行環境可以在開發和運維達到統一。軟件需支持任何形式的計算任務以及大部分計算框架,包括各種深度學習框架和機器學習框架(如PyTorch、Tensorflow)等。

2.2 高性能計算服務器集群管理方法探析

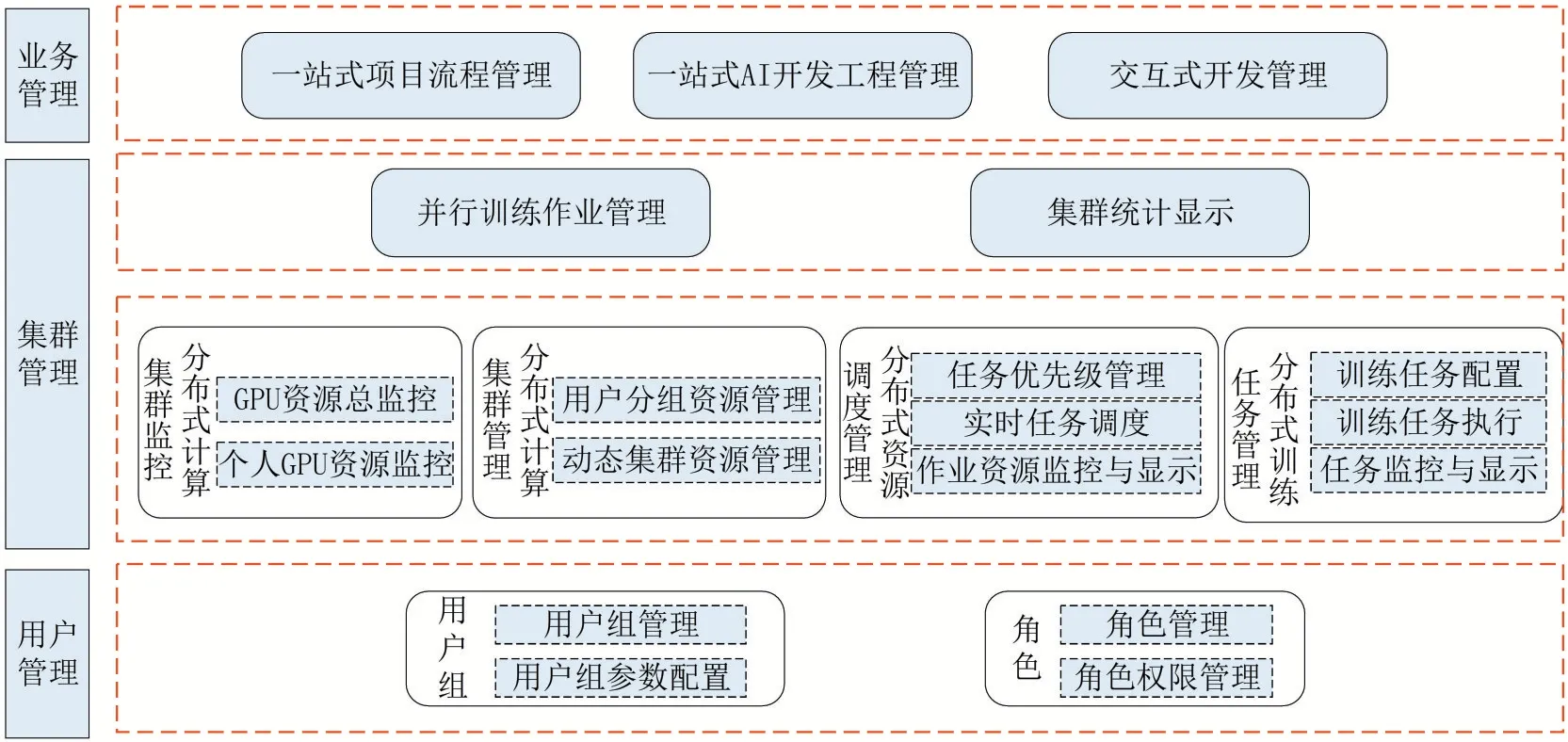

針對以上分析的高性能計算服務器集群管理需求,設計圖3的高性能計算服務器集群管理架構圖,共分為用戶管理、集群管理、業務管理三大方面。

圖3 高性能計算服務器集群管理架構圖

2.2.1 用戶管理

及對用戶組群集資源參數進行管理如用戶組的GPU 數量、存儲配額、組名、最大運行作業數、等待作業數等;支持同時在多個已分配資源的租戶空間執行任務,各用戶資源互不影響。設置不同的資源分配和服務訪問權限;不同用戶組間實現數據隔離。

2.2.2 集群管理

包括分布式管理、并行訓練作業管理、集群總計顯示等內容。分布式管理是集群管理的重點,包括如下方面:

(1)分布式計算集群監控:包括集群資源總體監控人GPU資源監控。集群資源總體監控,監控和顯示群集GPU、內存和存儲總體使用情況。

(2)分布式計算集群管理:對用戶組進行集群資源配額管理,對組內用戶進行集群資源配額管理;集群資源管理,動態添加基礎資源,動態分配和管理集群資源。

(3)分布式資源調度管理:執行任務優先級管理;實時任務資源分配和調度管理;以任務方式根據優先級分配計算資源,任務完成進行計算資源回收;計算作業資源監控和執行情況顯示。

(4)分布式訓練任務管理:訓練任務配置管理,基礎任務參數管理;訓練任務執行管理;訓練任務監控,查看模型訓練和資源使用情況。

2.2.3 業務管理

基于高性能計算服務器集群應用的一站式業務流程管理,包括一站式項目流程管理、一站式AI開發工程管理、交互式開發管理等。

(1)一站式項目流程管理:實現項目流程構建、項目流程表單設計、任務分配、團隊管理、項目流程可視化、項目檢索等項目流程管理支持。

(2)一站式AI開發工程管理:包括數據集管理、數據集推薦、模型訓練、模型部署、API調用示例、關聯用戶訓練任務與部署任務等內容。

(3)交互式開發管理:支持用戶通過平臺內置AI 鏡像進行創建交互式開發環境,環境實例可以使用CPU 資源也可以使用GPU 資源;平臺支持開發實例的持久化。

3 結語

在國家人工智能戰略布局和產業發展大背景下,高性能計算服務器集群公共服務平臺建設需求日漸突出。本文提供一種切實可行、低碳高能效的高性能計算服務器集群建設方案,并探析高性能計算服務器集群管理方法,借助自主研發集群管理軟件,構建服務器集群體系,實現算力資源虛擬化管理。相關管理方法有待在實踐中進一步優化和深化。