基于視覺一致性增強的細粒度圖像檢索

郎文溪,孫 涵

(南京航空航天大學 計算機科學與技術學院,江蘇 南京 211106)

0 引 言

圖像檢索[1]一直是計算機視覺領域的熱點問題,其基本目標是從海量圖像數據庫中查詢和返回與檢索內容相關的圖像。隨著深度學習的發展,圖像檢索任務的準確性和速度均取得突破[2-7]。然而,隨著用戶對搜索引擎檢索結果的定制化和精細化,細粒度圖像檢索近年來逐漸受到學術界和工業界的廣泛關注。對于給定的屬于同一大類(如,狗)的圖像,細粒度圖像檢索旨在進一步檢索屬于相同子類的圖像(如,沃克獵犬和巴塞特犬)。相較于經典圖像檢索,細粒度圖像檢索的主要難點包括:(1)類間差異小。不同子類的圖像高度相似,區分性的差異信息僅體現細微的局部區域;(2)類內差異大。相同子類的圖像由于姿態、光照、背景和拍攝角度的不同,差異巨大難以區分。因此,將經典圖像檢索算法應用在細粒度圖像數據集[8-11]上效果不佳,區分和檢索細粒度圖像仍然是目前具有挑戰性的研究熱點和難點。

細粒度圖像較小的類間差異使得不同子類間的差異僅體現在目標局部,而這些細微差異在特征學習時易受目標其他區域的干擾,在最終用于分類和檢索的特征圖上常被淹沒。針對這一問題,一些細粒度研究工作[12-17]致力于挖掘局部區域的判別特征。SCDA[18]使用預訓練的CNN定位顯著前景區域和無關的背景噪聲,然后引入flood-fill算法過濾噪聲獲得更具判別性的特征編碼。ExchNet[19]和WSDAN[20]均首先基于注意力機制獲取目標的判別性局部區域,然后分別設計通道約束和數據增強策略進一步增強局部區域特征的判別性。雖然這些工作能夠顯著提升細粒度圖像的識別和檢索精度,但都忽略了細粒度任務中的另一個關鍵問題。如圖1所示,對于姿態、光照、成像角度等因素變化而帶來的巨大類內差異,屬于相同子類的圖像呈現出截然不同的像素分布。在只有圖像類別標簽時,卷積神經網絡在訓練過程中很難捕捉到這些不同因素間等變的通用模式。因此,模型對類內圖像的視覺變換非常敏感,相同子類圖像的識別和檢索精度在收斂趨勢差異巨大,嚴重制約了細粒度檢索在實際應用中的性能。對于客觀存在無法消除的類內圖像變化,基于數據驅動的策略,一個簡單的解決思路是增強訓練數據中任一類別樣本的數量。然而,搜集場景豐富的足夠訓練樣本費時費力,且特征學習時模型依然無法高效地動態自適應這些類內變換。針對上述問題,本研究基于對比學習來增強類內圖像的視覺一致性,提高模型對視覺變化的容忍度來提升最終的檢索精度。具體而言,視覺一致性由兩個隱式的正則化約束實現,其基本要求為:(1)同一子類不同圖像的局部判別區域在特征空間中應該有相似的表示;(2)判別性特征應該在同一圖像的不同視圖間保持語義一致。

圖1 細粒度圖像特點示意

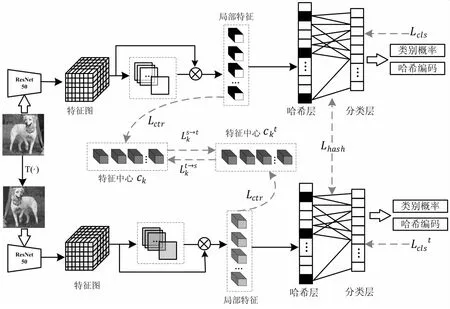

該文提出了一種基于對比學習和視覺一致性增強的細粒度圖像檢索框架(Contrastive Visual Consistency Strengthen,CVCS-Net),主要包括判別性特征挖掘、視覺一致性增強和語義哈希編碼三個關鍵模塊。對于低類間差異,CVCS-Net設計判別性特征挖掘模塊,自適應地學習空間注意力圖來定位其與類別最相關的M個判別性區域;其次,對于高類間差異,CVCS-Net受自監督算法[21-22]的啟發,設計視覺一致性增強模塊提升模型對差異巨大的類內圖像的魯棒性。視覺一致性增強模塊由判別區域一致性增強和變換圖像一致性增強構成,前者基于語義中心損失來為M個判別性區域構造語義一致的通用特征表達,而后者首先應用圖像變換策略積極增強類內訓練數據的豐富度,其次設計對比度損失懲罰變換后圖像的M個判別性區域的特征與通用特征表達間的差異。語義哈希編碼模塊引入量化損失和比特平衡損失,為視覺一致性增強后的判別性特征學習緊湊且高語義的哈希碼,最終實現對細粒度圖像的準確檢索。大量的實驗結果表明,提出的CVCS-Net能夠顯著提升細粒度檢索精度。主要貢獻如下:

(1)提出了一種基于對比學習和視覺一致性增強的細粒度圖像檢索方法CVCS-Net,在挖掘判別性特征的同時通過增強網絡對細粒度圖像類內差異的學習容忍度來提升檢索性能。

(2)分別設計語義中心損失和對比度損失來增強細粒度圖像的視覺一致性。前者能夠引導模型為同一子類的判別性區域構造語義一致的特征中心,而后者能夠顯著提升模型在檢索同一子類差異巨大的不同圖像時的魯棒性。

(3)在三個代表性細粒度數據集上進行了詳盡的對比和消融實驗,驗證了CVCS-Net的有效性。

1 相關工作

1.1 細粒度圖像檢索

早期的細粒度圖像檢索方法依賴于人工特征的使用[23]。然而人工特征在設計時依賴于大量精確的人工標注信息,無法滿足僅使用圖像標簽作為監督信息的弱監督檢索的精度需求。得益于深度學習的迅速發展,近年來越來越多的細粒度檢索方法被提出。現有的工作致力于挖掘判別性特征來解決細粒度類間圖像差異較小這一問題,主要包括有監督方法和無監督方法兩類。SCDA[18]提出了一種無監督的選擇性卷積描述符聚合方法,該方法首先定位細粒度圖像中的對象,并保留有用的深度描述符以進行細粒度圖像檢索。對于有監督檢索方法,CRL-WSL[24]使用中心排序損失和顯著區域輪廓來學習目標的辨別特征,提出一個統一的細粒度檢索框架。DCL-NC[25]進一步添加歸一化尺度層和去相關排序損失來改進CRL-WSL。不同于已有工作,該文在挖掘判別性特征的基礎上進一步考慮視覺一致性。挖掘判別性特征有利于為不同子類間高相似性的細粒度目標構建判別性的特征表達,從而實現準確檢索;而視覺一致性通過增強網絡對不同視覺變換的學習耐受力來解決類內圖像差異較大這一問題。

1.2 對比學習

對比學習(Contrastive Learning,CL)[26]在無監督表示學習領域表現出巨大的潛力,其基本動機是使用InfoNCE loss[27]來估計模型從一組無關負樣本中正確分類目標特征表示的能力。對比學習算法設計的關鍵是高質量正、負樣本的構造。khoslet等[28]設計監督對比損失(SupCon)拉近特征空間中的同類特征之間的距離,同時拉遠不同類特征的距離。Li等[29]提出了ProtoNCE損失,利用基于聚類的無監督表示方法促進對比學習精度。最近,Wang等[30]提出了一種基于像素級的密集對比學習方法,并將其用于多個視覺任務的預訓練中。該文將對比學習引入細粒度圖像檢索任務中,設計一種新的對比度損失來增強細粒度圖像的視覺一致性。

1.3 哈希編碼

在大規模圖像檢索任務中,為判別性特征構建哈希編碼被證明是高效的解決方案。通過哈希編碼,屬于相同或不同類別細粒度圖像的判別性特征能夠被嵌入到相同或不同的二進制碼中,在降低存儲成本的同時提升了查詢速度。現有的哈希方法主要包括data-independent哈希和data-dependent哈希兩類。前者通過隨機投影或手工構建二進制哈希碼,代表性工作是局部敏感的哈希函數[31](Locally Sensitive Hash,LSH)。相較于直接使用學習到的高維度判別性特征進行檢索,LSH方法雖然提升了檢索速度,但依然需要較長的哈希編碼來保證檢索性能。不同于data-independent哈希方法,data-dependent哈希方法充分挖掘數據內部的隱式內在聯系自適應的學習哈希碼。根據是否有額外的監督信息,data-dependent哈希方法又可以分為無監督和有監督的兩類。盡管無監督方法[32-34]具有更實用和更廣泛的應用前景,但目前絕大部分工作更多的基于有監督的框架,充分利用監督信息來獲得更好的檢索性能。代表性的有監督哈希算法包括卷積神經網絡散列(CNNH)[35]和深度成對監督散列(DPSH)[36]兩種。此外,最近的工作中,HashNet[37]提出用tanh激活函數不斷逼近目標,大大提高了檢索性能;DCH[38]提出了一種基于柯西分布的成對交叉熵損失,懲罰漢明距離大于給定閾值的相似圖像對來學習哈希碼。

2 方 法

該文提出了一種基于對比學習和視覺一致性增強的細粒度圖像檢索方法,能夠實現端到端的模型訓練。如圖2所示,它由三個核心模塊組成:判別性特征挖掘模塊、視覺一致性增強模塊和哈希編碼模塊。實現不同子類間圖像的準確檢索是細粒度圖像檢索任務的基礎,為此,提出的CVCS-Net首先設計判別性特征挖掘模塊,基于空間注意力機制定位目標的關鍵局部來捕捉不同類別細粒度圖像間的差異性特征。其次,CVCS-Net設計視覺一致性增強模塊提升模型對同一子類不同圖像間顯著差異的容忍度。視覺一致性增強模塊由判別區域一致性增強和變換圖像一致性增強構成,前者基于語義中心損失來為M個判別性區域構造語義一致的通用特征表達,而后者對輸入圖像隨機進行顏色或空間變換,設計對比度損失來懲罰圖像變換前后的特征差異。CVCS-Net為視覺一致性增強后的判別性特征學習緊湊的語義哈希碼實現最終的檢索。

圖2 CVCS-Net算法流程

2.1 判別特征挖掘

對于細粒度圖像分析,較小的類間差異使得捕捉不同類別間的判別性區域至關重要。在弱監督細粒度圖像檢索任務中,由于模型訓練和測試時沒有判別性區域對應的標注信息(如:bounding box),判別性特征挖掘模塊通過計算目標不同局部的類別得分來學習判別性區域的空間注意力分布圖;通過進一步抽取判別性區域對應的局部特征,最終為類內差異小的細粒度圖像構造精細的特征表達。

2.1.1 判別區域定位

對于給定的任一訓練圖像X,通過特征提取網絡首先生成一組特征圖F∈RH×W×N。其中,H、W和N分別為特征圖的長、寬和通道數。其次,特征圖F被輸入到一個額外的卷積模塊中生成注意力圖A∈RH×W×M,如公式(1)所示。

(1)

其中,f()表示卷積操作,由一個卷積核大小為1×1的卷積層和一個Relu激活層實現;Ak∈RH×W表示圖像的第k個注意力圖,描述了目標第k個局部區域的空間位置信息。

2.1.2 判別特征挖掘

進一步使用注意力圖A計算這些局部區域對應的特征,計算方法如公式(2)所示:

ck=g(Ak⊙F),k=1,2,…,M

(2)

其中,fk是第k個局部區域對應的特征,⊙表示將特征圖F和第k個注意力圖對應位置元素相乘,g()表示全局平均池化操作。為了保證局部區域的判別性,這里簡單卻有效的假設是,如果一個局部區域是判別性的,那么其對應的特征fk在分類時一定能夠高度響應其類別。因此,直接使用獲得的M個局部特征預測目標的類別,計算方法如公式(3)和(4)所示:

(3)

Lcls=CE(P,Y)

(4)

P表示softmax分類器的預測結果。在類別標簽的監督下,使用交叉熵損失CE()來約束預測結果P與其對應的真實類別Y趨向于一致。通過上述過程,模型不斷尋找與類別最相關的M個局部區域,最終捕捉細粒度圖像判別性特征。

2.2 視覺一致性增強

2.2.1 判別區域一致性增強

如圖1(b)所示,受光照、姿態、成像角度等諸多因素的影響,相同子類的不同目標差異巨大。目標固有的這些多樣性無法消除,對細粒度圖像分析帶來了極大的挑戰。這里,本研究的解決思路是首先通過不同的圖像變換模擬多樣性,然后基于對比學習的思想增強模型對這些多樣性變化的耐受性(稱之為視覺一致性)。如圖2所示,首先對原始圖像X進行視覺變換,如公式(5)所示:

Xt=T(X)

(5)

在增強視覺一致性時,首先設計語義中心損失Lctr來保證相同子類不同圖像的相似判別性區域在語義空間中有相近的特征表達(如所有沃克獵犬圖像的第k個空間注意力圖都感知其頭部)。具體而言,為每一個子類的M個判別性區域分別構造特征中,懲罰屬于同一判別性區域的局部特征間的變化,如公式(6)所示:

(6)

其中,ck是fk所對應的特征中心。ck初始化的值為0且在訓練被更新,計算方法如公式(7)所示:

ck=(1-μ)ck+μfk

(7)

2.2.2 變換圖像一致性增強

(i,j)∈ck

(8)

(i,j)∈ck

(9)

對比度損失Lcon計算M個特征中心上的所有像素點,如公式(10)所示:

(10)

2.3 語義哈希編碼

在大多數深度哈希方法中,哈希層被設計來將目標特征編碼為二進制的哈希碼,其中“1”表示類別擁有某種特征,而“-1”表示它缺乏這種特征。CVCS-Net在分類層前設計并添加了一個語義哈希編碼模塊,將視覺增強后的特征ft映射為B位的哈希碼,其基本計算方法如公式(11)所示:

(11)

其中,Hi∈RB是ft經過哈希層的輸出;δH∈B和WH∈RM×B分別表示哈希層的偏差和權重;tanh()為激活函數,計算方法如公式(12)所示:

(12)

tanh()的取值范圍為[-1,1]。由于sign函數在非零點處的梯度可能為零,出現梯度消失的問題,因此只有在測試模型時,將實值輸出的Hi映射為二維哈希碼。若Hi≥0,則Bi=1;否則,Bi=-1。

Bi=sign(Hi)

(13)

在優化sign函數時,為了避免梯度消失,CVCS-Net在訓練階段松弛了二進制哈希碼。而對于測試階段,將實值特征表示轉換為二進制化的哈希碼可能會導致量化誤差。在這種情況下,添加量化損失Lq以鼓勵實值盡可能地接近所期望的哈希碼,如公式(14)所示。

(14)

其中,e是所有元素值均為1的B維向量,B為哈希碼的長度。此外,還增加額外的位平衡損失Lb,以使哈希碼的每一個比特位為1或-1的可能性相等,如公式(15)所示:

(15)

其中,mean()的計算方法如下:

(16)

其語義編碼模塊損失為:

Lhash=Lq+Lb

(17)

整體的損失函數如公式(18)所示:

(18)

3 實驗結果與分析

3.1 數據集及評價指標

為了驗證CVCS-Net的有效性,在CUB Birds、Stanford Cars和Stanford Dogs三個細粒度數據集上進行了實驗。CUB Birds包含11 788張圖像,共200個類別。數據集包括5 794張圖像的訓練集和5 994張圖像的測試集。Stanford Cars數據集由8 144張訓練圖像和8 041張測試圖像組成,屬于196個類別。Stanford Dogs數據集由120個類別的20 580張圖像組成,包括12 000張圖像的訓練集和8 580張圖像的測試集。

使用平均檢索精度(mAP)定量評估檢索性能,計算方法如公式(19)所示:

(19)

其中,nq是需要檢索的樣本數;n是每次檢索后返回的樣本數,nj是返回的樣本n中的正樣本數量。如果返回的第j張是正樣本,則pos(j)值為1,否則值為0。

3.2 參數設置

實驗中,基于pytorch實現代碼并使用CPU Intel i5,GPU RTX 2080ti 11 GB,32 G內存的硬件平臺訓練模型。縮放訓練圖像的尺寸為448×448像素,并使用ResNet-50作為主干來提取特征并選擇Conv5層的輸出作為特征圖。對于注意力圖的生成,M的默認值為32。

盡管所有數據集都標有邊界框或零件位置,但提出的CVCS-Net僅使用類別標簽作為監督信息。在訓練階段,模型使用隨機梯度下降(SGD)訓練160個epoch,batch size為12,初始學習率設置為0.001且每2個epoch后進行指數衰減,衰減系數為0.9。在推理階段,遵循文獻[39]中的設定,使用測試圖像作為查詢集,訓練圖像作為所有實驗的檢索數據庫。

3.3 細粒度檢索性能對比分析

3.3.1 與傳統圖像檢索方法性能比較

為了驗證該方法的有效性,首先比較了CVCS-Net與其他傳統圖像檢索方法在細粒度數據集上的檢索精度。為了保證比較的公平,對所有方法均使用Resnet-50作為特征提取網絡,并使用不同長度的哈希碼分別訓練模型。

如表1所示,對于CUB數據集,CVCS-Net在12位、32位和48位哈希碼時的mAP分別為79.23%、84.69%和85.91%,較性能第二的FPH提升均超24%。對于Dogs和Cars數據集,CVCS-Net提升的趨勢依然明顯。上述結果一方面表明了細粒度圖像檢索任務與普通圖像檢索任務的巨大差異,另一方面也證明了判別性特征挖掘對細粒度圖像分析任務的重要性。此外,相較于使用全局圖像特征構建哈希碼的經典檢索方法,CVCS-Net對哈希碼長度的變化表現出更好的穩定性。例如,當哈希碼從48位降低到12位時,在CUB 200-2011 數據集上CVCS-Net的mAP僅下降約6%,遠小于FPH的11%。這一結果充分表明CVCS-Net設計判別性特征挖掘模塊的有效性,也從側面驗證了語義哈希編碼模塊在量化損失和位平衡損失的約束下能夠提升哈希碼的緊湊性和語義性。

表1 CVCS-Net與傳統圖像檢索方法在不同數據集上的mAP比較

3.3.2 與細粒度檢索方法性能比較

進一步的,還比較了CVCS-Net與已有細粒度圖像檢索方法在CUB數據集上的檢索精度。如表2所示,CVCS-Net在不同設定下均能夠取得最佳的檢索性能。

表2 CVCS-Net與細粒度圖像檢索方法在CUB數據集上的mAP比較

相較于沒有哈希模塊的細粒度檢索方法SCDA、CRL-WSL和DCL-NS,即使其特征表示的維度遠大于CVCS-Net,其精度仍然遠低于提出的CVCS-Net。可能的原因是細粒度任務對特征質量的敏感。雖然高維圖像特征包含了更多的物體信息,但在計算不同圖像的相似度時,判別性特征可能無法起主導作用,使得最終檢索結果更容易被相似的類間圖像干擾。相較于基于哈希的細粒度檢索方法ExchNet和FCAENet[40],在哈希碼長度為48位時,CVCS-Net的mAP為85.91%,分別提升約14%和5%。此外,ExchNet和FCAENet的性能還隨著哈希碼長度的變化波動劇烈。當哈希碼從12位增加到32位時,這兩種方法的mAP提高約40%,而提出的CVCS-Net僅提升6%。當哈希碼從32位增加到48位時,CVCS-Net的mAP僅增加約1%。上述的實驗結果表明,視覺一致性增強能夠顯著提升模型的魯棒性。

3.4 消融實驗

3.4.1 不同模塊有效性驗證

如表3所示,該實驗進一步驗證了CVCS-Net每個部分的有效性。以48位哈希碼為例,CVCS-Net簡單的基線是僅使用判別性特征和語義哈希編碼模塊,其mAP為80.84%。在分別加入語義中心損失和對比度損失進行視覺一致性增強后,mAP能夠提升2.05%和3.42%;而Lctr和Lcon共同作用下mAP為84.62%。上述的結果充分驗證了語義中心損失和對比度損失的有效性。首先,通過構建語義中心,CVCS-Net能充分挖掘類內不同目標的相似判別性區域;其次,對比度損失在訓練時能夠極大地提高模型對類內圖像變化的耐受性。類似的,當基線加入量化損失Lq和位平衡損失Lb后,其結果能夠從80.84%分別提升到82.46%和81.58%。實驗結果表明,量化損失和位平衡損失能夠顯著提升語義哈希編碼的質量和檢索性能。

表3 CUB數據集上不同設置時mAP的比較

3.4.2 判別性特征數量分析

對細粒度檢索任務而言,判別性特征的數量將顯著影響模型的性能。如表4所示,本小節在不同的細粒度數據集上進行了詳盡的消融實驗來分析判別性特征數據對CVCS-Net的性能影響。以最具挑戰性的CUB 200-2011數據集為例,在簡單挖掘4個判別性特征時,CVCS-Net的mAP為84.11%。這一結果隨著特征數量的增加而不斷提升,在特征數量為32和64時mAP分別為85.91%和86.52%。類似的上升趨勢也顯示在其他兩個數據集上。在實驗中,考慮計算開銷和檢索性能之間的平衡,最終選擇將CVCS-Net挖掘的判別特征數設置為32。

表4 不同數據集上判別性特征數量與CVCS-Net結果比較

3.5 可視化效果分析

3.5.1 檢索效果可視化

圖3顯示了CVCS-Net和HashNet在三個細粒度數據集上檢索的前10個樣本。可視化的結果表明,CVCS-Net能夠取得比目前最先進方法更滿足用戶期望的檢索結果。

圖3 不同數據集上CSCV-Net與HashNet檢索結果對比

3.5.2 哈希碼邊界可視化

為了分析哈希碼的質量,在Stanford Cars數據集上使用t-SNE(t-distributed stochastic neighbor embedding)將生成的哈希碼可視化。如圖4所示,隨機采樣10個類別的結果表明,CSCV-Net得益于為細粒度對象特別設計的判別性特征提取模塊和語義哈希編碼模塊,能夠將哈希碼在同類中生成的更清晰和緊湊,在不同子類間生成的邊界更明顯。

圖4 Stanford Cars上CSCV-Net與HashNet哈希碼可視化對比

4 結束語

針對細粒度圖像類間差異小類內差異大的特點,在挖掘判別性特征的基礎上基于對比學習進一步增強不同圖像間的視覺一致性,提出了一種新穎的深度哈希細粒度圖像檢索方法CSCV-Net。CSCV-Net由判別性特征挖掘模塊、視覺一致性增強模塊和語義哈希編碼模塊構成。判別性特征挖掘模塊學習空間注意力圖,能夠有效挖掘圖像的判別性局部區域;而視覺一致性增強模塊分別引入語義中心損失和對比度損失,增強模型訓練時對不同類內圖像相似判別區域語義一致性和對同一圖像不同視覺變換的魯棒性;CSCV-Net還基于量化損失和位平衡損失設計語義哈希編碼模塊,進一步提升檢索速度。通過大量實驗和消融研究,在3個常用細粒度圖像數據集CUB-200-2011、Stanford Cars和Stanford Dogs驗證了CVCS-Net的有效性。相較于當前其他檢索方法,CVCS-Net能夠取得更好的檢索結果。