一種管道蛇形機器人的裂縫視頻檢測系統

趙達, 王亞慧, 陳林林

(北京建筑大學電氣與信息工程學院, 北京 100044)

近年來,隨著中國城鎮化進程快速發展,全國各類市政管道大量的被投入使用。隨著使用年限的增加,管道會產生各種損傷,管道的定期檢查和維護是城市平穩運行的重要部分。為了檢查和維護管道,顏凱凱等[1]、邢利輝等[2]、鄧蕊等[3]研究設計了一款管道探測蛇形機器人,該機器人由多個舵機正交連接構成,通過STM32F103單片機控制,可實現在管道內部行波和蜿蜒運動等。張成林等[4]為管道探測蛇形機器人設計了一種基于捷聯慣性導航的定位系統,可以實現蛇形機器人在管道中的定位。同時在管道中準確識別管道裂紋也是一個十分重要的環節。

Durai等[5]設計了一種搭載環形激光器的管道探測機器人,激光二極管用作光源,用于捕獲高質量的檢測圖像。通過對采集圖像的高亮度像素數量得到缺陷信息。李夷進等[6]針對當前管道圖像存在白霧和光斑等干擾的問題,提出了一種管道圖像去除光斑和白霧的方法,首先根據霧氣特征,使用暗通道算法進行先驗去霧,其次使用多尺度Retinex色偏恢復算法修復去霧算法產生的色偏,最后使用改進的二維伽馬函數,實現對光斑的消除。趙謙等[7]針對工業管道內壁分辨率低、適用性差等特征,提出了一種工業管道內壁的重建方法,首先搭建了基于內窺鏡的視頻采集平臺進行數據實時采集,接著使用張正友標定法進行平面標定計算鏡頭點在圖像上的位置值,采用改進的尺度不變特征轉換算法進行特征提取和匹配,最后使用融合隨機抽樣一致和加權融合算法消除誤差,達到管道內壁重建目的。楊書娟等[8]為了實現對焊縫的快速準確識別,研究了一種激光視覺引導的焊縫跟蹤系統。該系統使用電荷耦合器件(charge coupled device,CCD)工業相機采集焊縫圖像,之后對采集的圖像進行預處理,再經過特征點提取算法獲得特征點坐標,最后進行三維重建得到三維坐標。綜上所述,目前來說,關于管道探測缺少對視頻進行自動識別缺陷的方法,上述方法都是依靠人工識別裂縫再對裂縫進行具體操作。

隨著計算機技術的深入發展,深度學習目前被大量應用在缺陷檢測中。現在被廣泛應用的算法有兩類,分別是以R-CNN系列算法[9]為代表的兩階段算法和以YOLO算法[10-11]、SSD算法[12]等為代表的一階段算法。兩者區別在于兩階段算法在結構上比一階段算法多一個生成候選區域的步驟,然后再對其進行識別和定位,而一階段算法直接對預測框進行回歸和分類預測。所以兩種算法比較起來,一階段算法雖然在檢測準確率上稍遜于兩階段算法,但其檢測速度優于兩階段算法。

因此,針對目前關于管道視頻自動檢測研究不足的現狀,現設計一種基于管道蛇形機器人的管道裂縫視頻檢測系統。系統搭載了500萬像素的攝像機以及用于輔助標定的兩個激光發生器。使用攝像機采集管道視頻,并采用YOLOv3算法對管道視頻進行檢測,以實現對管道裂縫的實時準確識別和定位,之后將檢測出裂縫的視頻幀輸出并結合激光標定和邊緣檢測算法得到該幀圖像中裂縫的實際物理信息。

同時為了提高算法精度,現對YOLOv3 算法進行改進,首先在使用距離交并作為K-means++算法損失函數的基礎上,利用K-means++算法對數據集進行聚類分析,得到合適的先驗框;同時也將距離交并比用作YOLOv3網絡的損失函數,優化和提高目標的檢測精度。

1 YOLOv3算法

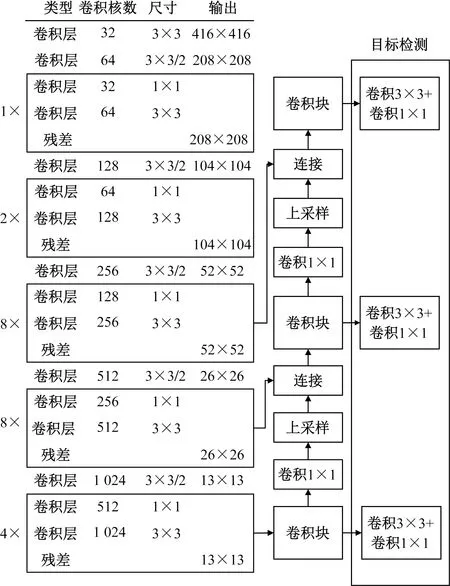

YOLOv3網絡由Darknet-53網絡和預測網絡2個部分組成,在此網絡中第1~75層為Darknet-53結構,Darknet-53結構由一系列的1×1和3×3的卷積以及殘差層構成,在交替使用后再經過步長為2的下采樣,將特征圖縮小為原來的1/2,一共經過5個下采樣最終將特征圖變為原圖的1/32。76~106層為預測網絡層,預測網絡從Darknet-53網絡中選取三個尺度的特征圖進行預測,分別是為13×13、26×26、52×52,每個尺度之間又通過卷積的方式實現交互,將感受野大的信息傳遞個感受野小的尺度。YOLOv3特征提取網絡如圖1所示。

圖1 YOLOv3網絡結構Fig.1 YOLOv3 network structure

2 裂縫檢測算法

2.1 損失函數的改進

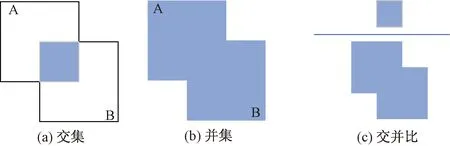

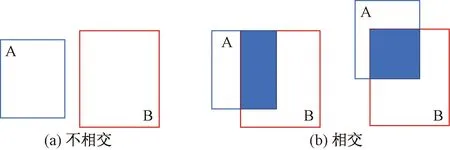

在目標檢測過程中,使用損失函數來度量預測和真實數據的差異,損失函數的優劣與網絡學習速度和模型預測效果有著重大的關系。在原始YOLOv3中,使用交并比(intersection over union, IoU)作為邊界框的損失函數,反映預測檢測框與真實檢測框的檢測效果。交并比原理如圖2所示。

圖2 交并比原理Fig.2 The principle of IoU

交并比的計算公式為

(1)

式(1)中:A、B分別為真實框和預測框,其中0≤IoU≤1。

在YOLOv3中,交并比損失函數定義為

LIoU=1-IoU

(2)

然而,一旦真實框和預測框不相交的情況下,IoU=0,此時損失函數無法表現預測框和真實框的實際距離,優化無法繼續進行,如圖3(a)所示。此外,當兩個預測框大小相同且IoU相同的情況下,損失函數同樣無法區分兩種情況,如圖3(b)所示。

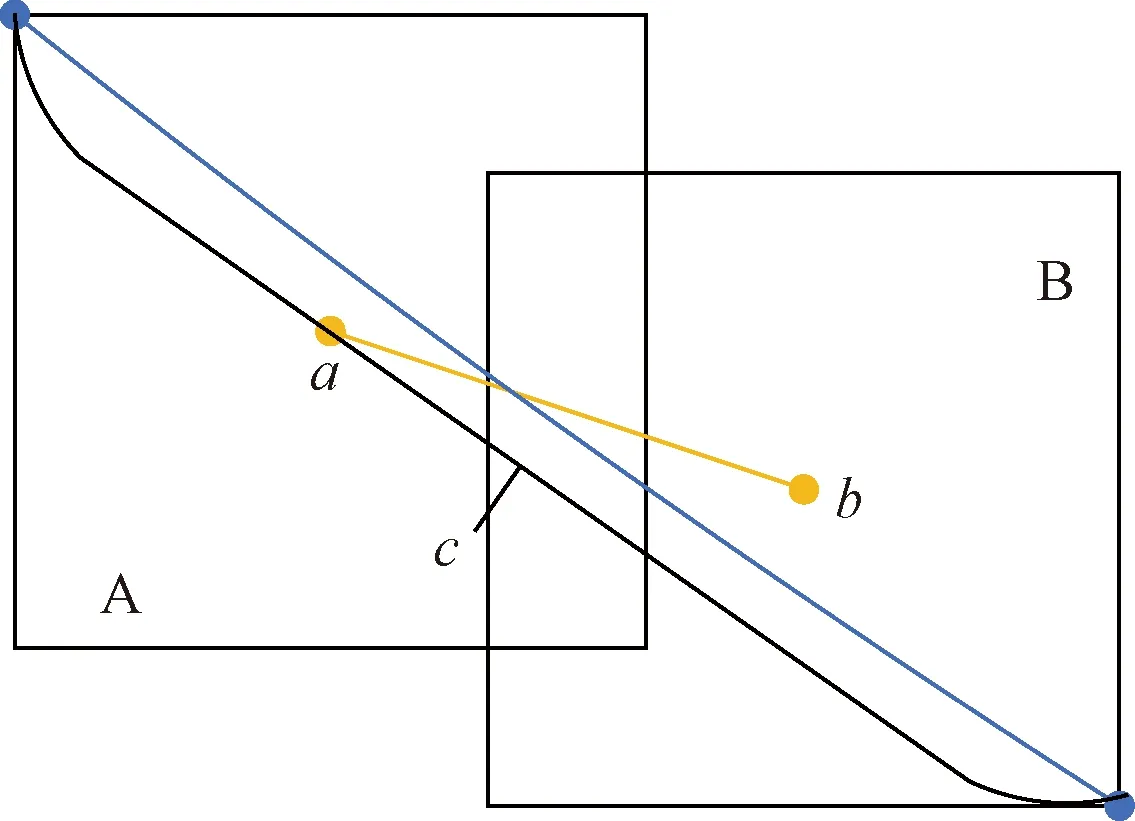

基于上述情況,提出使用距離交并比(distance intersection over union, DIoU)[13]作為邊界框的損失函數。距離交并比原理如圖4所示。

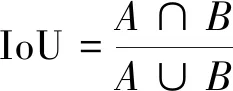

距離交并比計算公式為

(3)

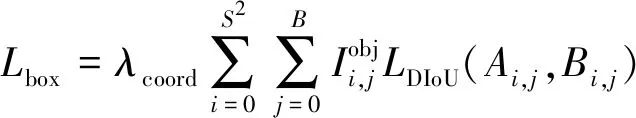

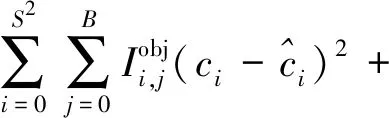

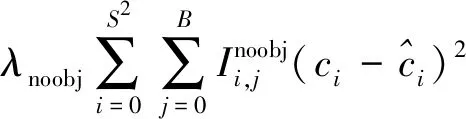

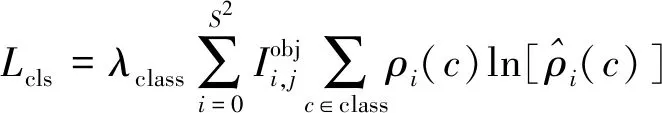

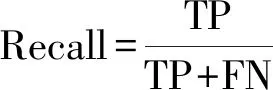

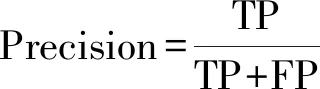

式(3)中:a、b分別為預測框和真實框的幾何中心點;ρ為計算兩個中心點的歐氏距離;c為能夠同時覆蓋預測框和真實框的最小矩形的對角線距離。由上述內容,可以得出-1 距離交并比損失函數定義為 LDIoU=1-DIoU (4) 圖3 交并比的不足Fig.3 Deficiencies of IoU 圖4 距離交并比原理Fig.4 The principle of DIoU 式(4)中:DIoU取值范圍為(-1,1],當預測框和真實框重合時,DIoU=1;當兩框不相交時,DIoU取值范圍為(-1,0),且在兩框遠離的情況下,DIoU逐漸趨向-1。由此即使兩框不相交時認可繼續優化。同時,以DIoU作為損失函數相較于IoU作為損失函數,考慮到中心點的距離,其收斂速度更快。 YOLOv3將位置損失、置信度損失和類別損失融合在一個損失函數中,所改變的是位置損失函數。改進后YOLOv3損失函數分別為 (5) (6) (7) Loss=Lbox+Lobj+Lcls (8) Loss=Lbox+Lobj (9) YOLOv3在每個尺度的特征圖中都與先設置了3個不同尺度的先驗框,并通過對先驗框的偏移實現對目標的預測,先驗框的尺寸對檢測精度有著重大的影響。原始的YOLOv3使用K-means算法聚類得到先驗框。算法流程如下:①確定要得到的先驗框數量K;②從數據集中隨機選擇K個數據點作為初始聚類中心;③針對數據集中每個樣本點,計算它們到各個聚類中心點的距離,到哪個聚類中心點的距離最小,就將其劃分到對應聚類中心的類簇中(YOLOv3中使用IoU作為距離的判斷標準,d=1-IoU);④針對每個類別,重新計算該類別的聚類中心;⑤重復流程③和流程④,直到聚類中心的位置不再變化。 傳統K-means 算法初始點的選取隨機性較大,影響聚類精度,本文使用K-means++算法[14]代替原來的K-means算法,對裂縫數據集的標記框進行聚類,得到更好的先驗框大小。具體流程如下:①確定要得到的先驗框數量K;②隨機選取數據集中的1個數據作為初始聚類中心;③針對數據集中每個樣本,計算它們到聚類中心的最短距離D(x)=1-DIoU,計算每個樣本被選為下一聚類中心的概率,通過輪盤法選擇出下一個聚類中心; ④重復步驟③,直到選擇出K個聚類中心;⑤之后的步驟和K-means算法的步驟相同。 最終經過K-means++算法得到的先驗框為[39,76],[216,34],[47,356],[391,68],[165,165],[74,396],[408,121],[127,411],[390,380]。 使用平均精確率(average precision, AP)對裂縫檢測模型進行評價,AP與召回率(recall)和精確度(precision)有關。計算公式為 (10) (11) (12) 式中:TP為正確劃分成正樣本的數量;FP為錯誤劃分成正樣本的數量;FN為錯誤劃分為負樣本的數量;P(r)為根據召回率和準確率繪制的曲線;R為召回率。 為了給予工作人員具體的裂縫信息,需要將YOLOv3識別到的裂縫圖像輸出并加以處理得到裂縫的實際物理信息。本文所研究的系統搭載在本課題組所設計的一款蛇形機器人上,考慮到蛇形機器人的整體設計的情況,系統在硬件需求方面主要是一對激光發射器以及500萬像素相機。將激光發射器安置在蛇形機器人的頭部左右兩側,并使得發出的左右兩條光線保持平行,兩者間距為20 mm。這樣,在安裝在機器人頭部的相機捕獲圖像時,激光就會在圖片上形成兩個亮點。在已知兩個激光發射器之間的實際距離的情況下,通過圖像處理技術計算出兩個亮點之間的像素數,最終便可以計算出像素與物理尺寸的關系。激光標定模型如圖5所示。 圖5 激光標定模型示意圖Fig.5 Schematic of a laser calibration model 安裝在機器人頭部左右兩側的激光發射器相互平行且處于同一水平高度,以確保發出的激光線是平行的。兩個激光發射器之間的距離d,發出的平行光線打在被測目標上形成的兩個激光點之間的距離為L。假設像平面上像素為正方形,機器人頭部的仰角與水平面之間的夾角像為α,便可以得到激光發射器水平距離d與兩激光點距離L的關系,即 (13) 假設經過圖像處理后兩個亮點之間的像素數為N,便可以計算出圖像坐標系與現實物理坐標系之間的比例系數K,即 (14) 在得到比例系數后使用Canny邊緣檢測算法[15]和形態學處理算法提取出裂縫特征,并提取計算圖像裂縫像素,將裂縫像素與比例系數相乘得到實際信息。 本文的檢測系統安裝在管道探測蛇形機器人上,蛇形機器人可應用在多種管道情形下,現以水泥管道為背景進行研究。選取從搜索引擎找到的關于水泥裂縫圖像的數據集,對其使用LabelImg軟件重新進行標注,同時使用自己采集的1 000張水泥裂縫圖片,同樣使用LabelImg軟件進行標注。將兩個數據集一起進行訓練。部分裂縫圖像樣例如圖6所示。 圖6 部分裂縫圖像樣例Fig.6 The example of a partial crack image 為了驗證蛇形機器人裂縫檢測系統,實驗器材包括管道蛇形機器人、直流穩壓電源、筆記本電腦、500萬像素相機、激光發生器等。筆記本電腦配置如下:操作系統為Windows10,CPU為Intel(R) Core(TM) i7-10750H,內存為16 GB;GPU為NVIDIA GeForce GTX 1 650 Ti,顯存為4 GB。 首先將數據集圖像劃分為訓練集和測試集,兩者比例設置為7∶3;由遷移學習的思想,加載darknet53.conv.74作為算法的預訓練權重,使用訓練集數據對改進的網絡進行訓練,在模型訓練好后,使用該模型對測試集圖片進行檢測,同時將檢測結果輸出,從而確定模型的性能優劣。在確定模型性能后,調用攝像頭使用訓練好的模型進行實際實驗,當在視頻中檢測到裂縫時,視頻中出現標記框,同時激光發生器啟動在當前位置打出兩個光點,并輸出當前圖像,運行邊緣檢測和激光標定算法得到當前圖像裂縫物理信息。裂縫檢測整體算法流程如圖7所示。 圖7 裂縫檢測整體算法流程Fig.7 Overall algorithmic flow of crack detection 對改進后的YOLOv3算法進行訓練,隨著迭代次數的增加,損失函數的變化趨勢如圖8所示。 由圖8可以看出,剛開始訓練時,模型的損失值在200左右,隨著訓練迭代次數的增加,損失值迅速逐漸減小到10左右,之后隨著訓練的繼續,損失值減小的速度開始放緩,當迭代次數到9 000次左右時,損失值在0.6左右,此時的損失值已不再有明顯的下降趨勢,即已到了合適的效果。 圖8 損失函數趨勢Fig.8 Loss function trend 對同一訓練集分別使用改進YOLOv3算法和原始YOLOv3算法訓練得到模型,之后使用同一個驗證集進行對比實驗。裂縫檢測性能指標如表1所示。算法結果對比圖如圖9所示。 表1 裂縫檢測性能指標 圖9 算法結果對比圖Fig.9 Algorithm results comparison chart 由表1可以看出:相較于與原始YOLOv3算法,本文提出的改進YOLOv3算法在平均精度方面提高了5.88%,這表明改進方法在一定程度上能夠提高網絡模型的檢測性能。 從圖9能夠發現,本文的方法相較于原始算法的檢測結果更優,與裂縫的實際位置更加吻合。 在確定了模型的可行性后,使用模型進行實際測試。本文檢測時,會在識別出裂縫后輸出不含標記框的圖片,使用不含標記框的圖片進行圖像處理得到裂縫物理信息。視頻檢測輸出的部分圖像如圖10所示。 圖10 部分輸出裂縫圖像Fig.10 Partial output crack image 之后使用檢測出的裂縫圖片驗證圖像處理算法的準確性,使用實際的一張帶有激光點的照片,使用圖像處理算法計算裂縫參數,同時實際測量該裂縫的物理信息,與計算出的參數進行對比。裂縫圖片如圖11所示。 圖11 裂縫圖像Fig.11 The crack image 本文設置的兩個激光發生器之間間距為 20 mm,測量的裂縫是兩條紅線間的裂縫數據,經過圖像處理最終得到的結果以及實際測量的結果如表2所示。 通過算法計算出的長度誤差為2.6%,寬度誤差為4.5%,兩者誤差皆在5%以內。同時由于探測時攝像頭與被測量面間距離很短,故檢測到的裂縫大小也有限。5%的誤差可以滿足實際的應用。 表2 測量結果 針對管道裂縫自動檢測存在的問題,本文基于改進YOLOv3算法為管道蛇形機器人設計了基于一個快速檢測識別管道視頻裂縫的系統。新算法首先使用DIoU代替IoU作為損失函數用于先驗框聚類計算損失值,以及用于YOLOv3算法訓練時的損失值計算;其次,使用K-means++算法對裂縫數據集的標記框進行聚類;最后使用圖像處理算法對檢測出的裂縫圖像進行測量。得出如下結論。 (1)通過使用DIoU作為損失函數優化YOLOv3算法,以及使用K-means++算法進行聚類得到合適的先驗框。實驗結果表明,本文算法比原始YOLOv3算法AP提高了5.88%。 (2)進行實際實驗,訓練好的模型在使用中可以識別視頻中的裂縫并定位。同時輸出識別出裂縫的視頻幀。 (3)建立了激光標定模型,針對從視頻中檢測出的裂縫圖像使用邊緣檢測算法和形態學處理提取裂縫特征,之后結合激光標定得出裂縫物理信息。實驗表明,該算法得到的結果與實際結果誤差范圍在5%以內,滿足實際需求。

2.2 先驗框聚類改進

2.3 評價標準

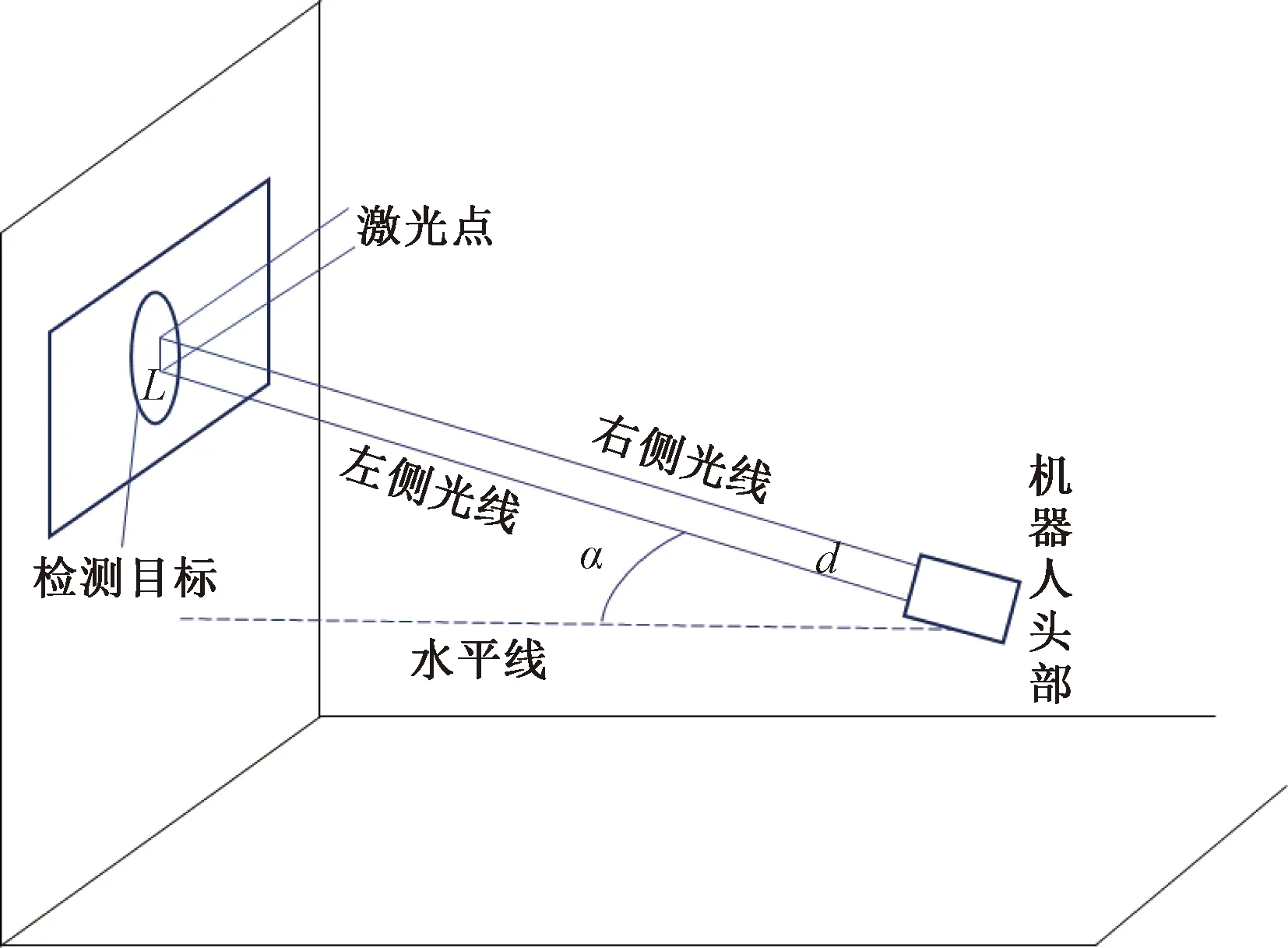

2.4 圖像處理算法

3 實驗與分析

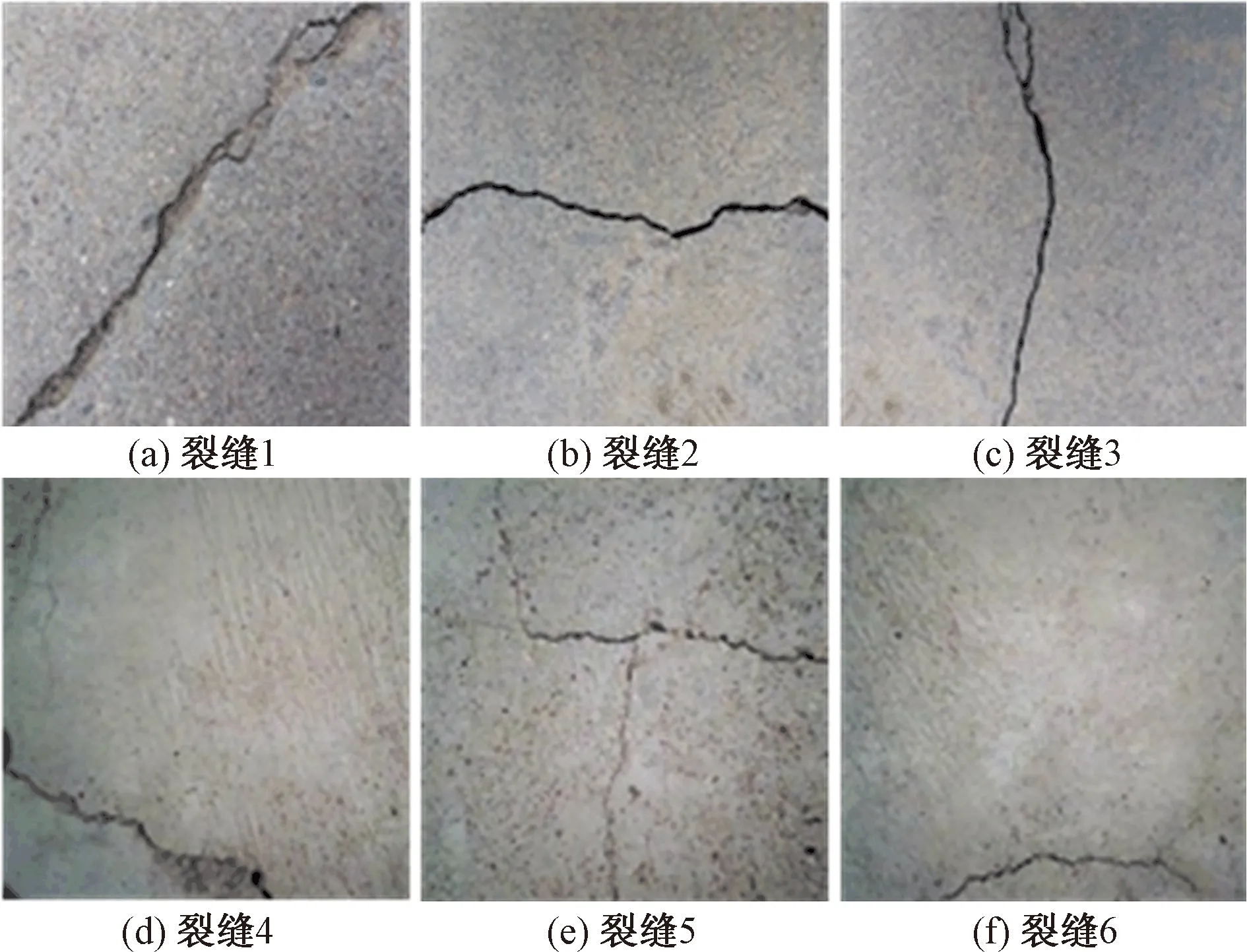

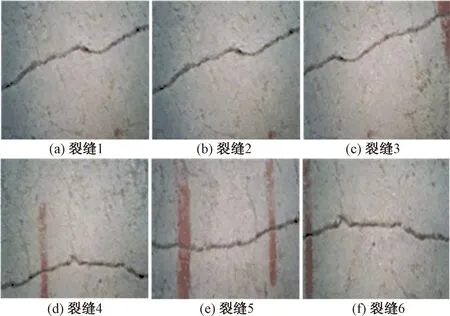

3.1 數據集

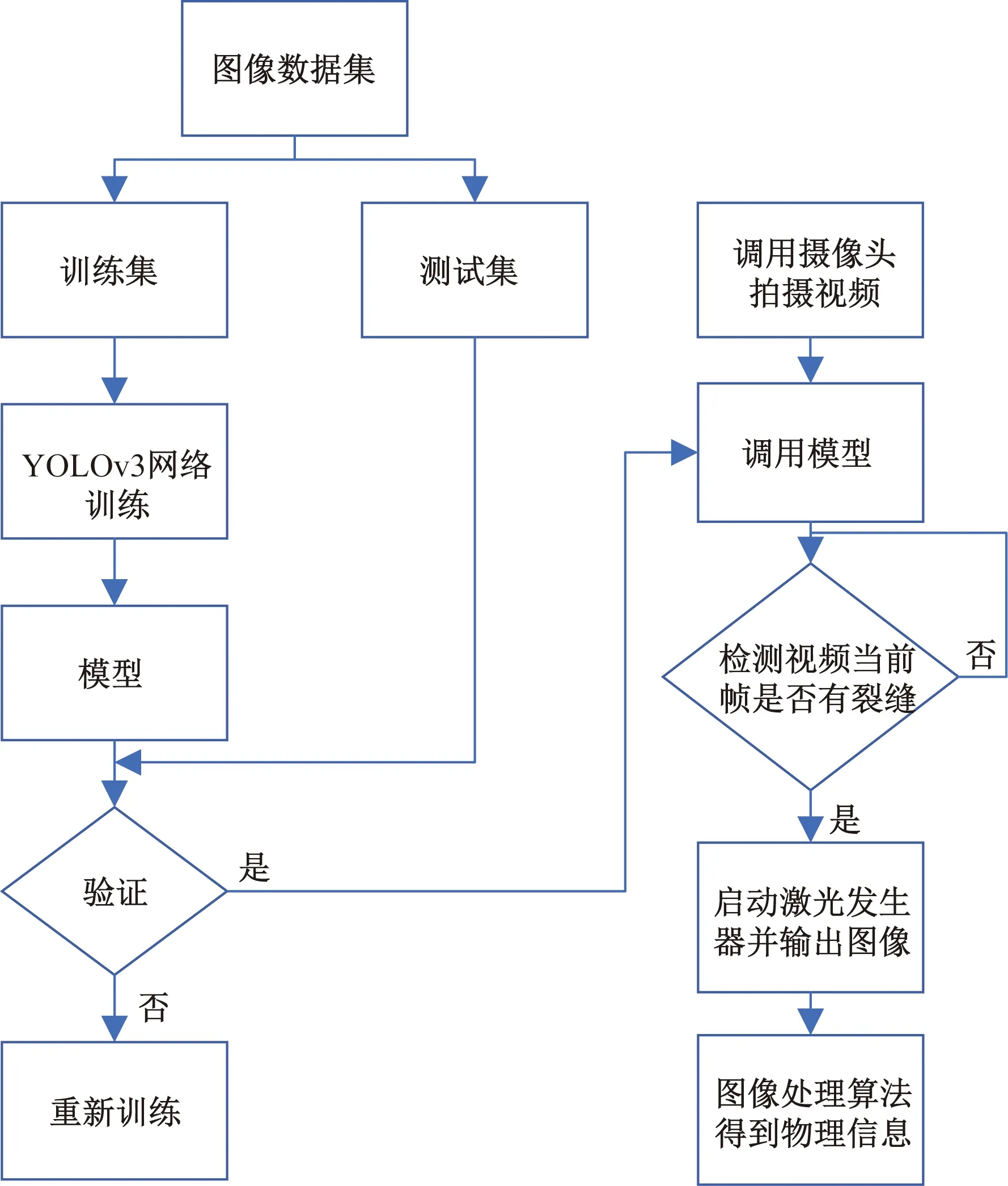

3.2 實驗條件及步驟

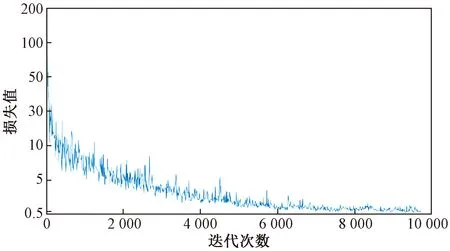

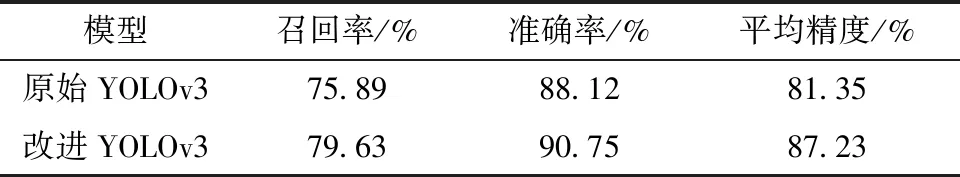

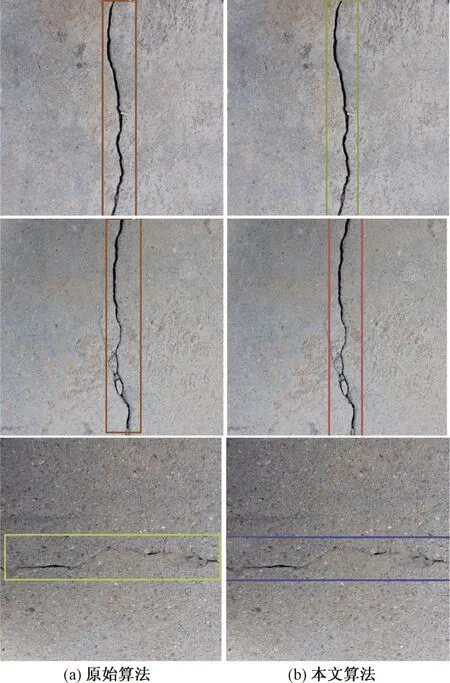

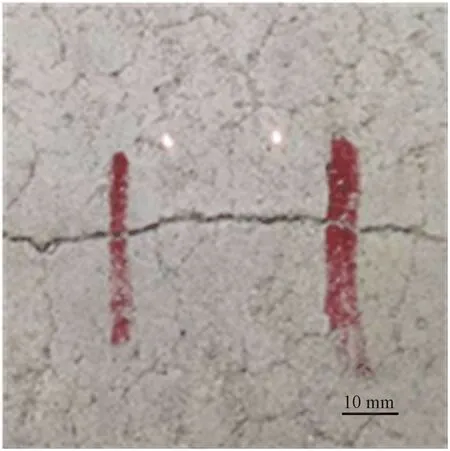

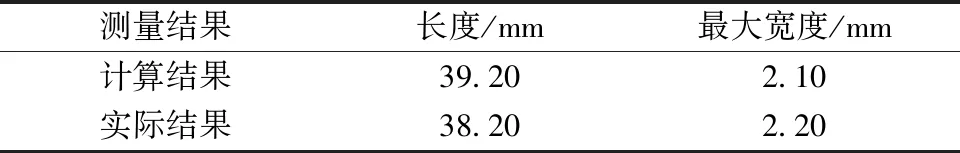

3.3 實驗結果及分析

4 結論