基于改進DenseNet和遷移學習的荷葉病蟲害識別模型

張國忠,呂紫薇,劉浩蓬,劉婉茹,龍長江,黃成龍

基于改進DenseNet和遷移學習的荷葉病蟲害識別模型

張國忠1,2,呂紫薇1,2,劉浩蓬1,2,劉婉茹1,2,龍長江1,2,黃成龍1,3※

(1. 華中農業大學工學院,武漢 430070;2. 農業農村部長江中下游農業裝備重點實驗室,武漢 430070;3. 華中農業大學作物遺傳改良國家重點實驗室,武漢 430070)

病蟲害的發生將會嚴重影響蓮藕品質與產量,開展病害診斷與識別對藕田病蟲害及時對癥對病診治、提升蓮藕生產質量與經濟效益具有重要意義。該研究以荷葉病蟲害高效、準確識別為目標,提出了一種基于改進DenseNet和遷移學習的荷葉病蟲害識別模型。采用分支結構對模型的淺層特征提取模塊進行改進,并在Dense Block與TransitionLayer中引入Squeeze and Excitation注意力機制模塊和銳化的余弦卷積,最后基于Plantvillage數據集進行遷移學習,實現了91.34%的識別準確率。該研究實現了對荷葉腐敗病、病毒病、斜紋夜蛾、葉腐病、葉斑病的識別,并將改進后的模型推廣應用于基于無人機圖像的藕田病蟲害檢測,實現了病害分布可視化,可對蓮藕病蟲害的智能化防治提供有益指導。

模型;無人機;病蟲害識別;荷葉;DenseNet;注意力機制;余弦相似度;遷移學習

0 引 言

蓮又名荷、蓮藕,是中國重要的水生蔬菜,其根莖、葉、花、種子均具有較高的食用與觀賞價值[1-3]。隨著生活水平的提升和飲食多樣化的發展,人們對綠色、高產、高品質農產品的需求日益提升。近年來,腐敗病、病毒病、斜紋夜蛾等病蟲害高發,其中腐敗病可導致蓮藕減產40%以上,病蟲害的發生將嚴重影響蓮藕的品質與產量[4-5]。蓮為大面積水田作物,其獨特的農藝和生長特點使得田間穿行困難,不利于病蟲害的監測與識別,加大了病蟲害的防控難度。目前,蓮的病蟲害鑒別主要依賴人工判別與病原檢測技術。人工判別主觀性強,而病原檢測存在成本高、采樣難度大等不足之處,且多數種植戶缺乏專業的病蟲害防治知識,無法實現對蓮病蟲害的準確判別。隨著人工智能技術與農業的融合,基于機器學習與模式識別的圖像分類、目標檢測等技術在植物病害檢測中得到廣泛應用,對提升識別效率與降低病蟲害防控成本具有顯著成效。

葉片病斑的顏色和形態特征是病害識別的重要依據[6]。蓮雖為根莖類作物,但病蟲害特征主要集中于葉片,葉片感染不同病害時具有不同的顏色、形態特征[7-8],因此荷葉的生長狀態可以反映蓮病蟲害的發生情況[9]。傳統機器學習方法利用圖像處理技術提取葉片病斑的顏色、形狀、紋理等特征進行植物病害識別,其分類性能依賴于病斑特征的提取效果,且算法具有專用性,泛化能力較差[10]。深度學習技術通過自動提取圖像特征可快速、準確實現病蟲害識別,近年來被廣泛應用于植物病蟲害識別領域,并取得了優異成果。如黃建平等[11]提出一種基于神經結構搜索的植物葉片病害識別方法,根據特定數據集自動學習、搜索合適的深度神經網絡結構,實現了葉片病害的分類識別。XU等[12]通過引入自約束注意力增強分支改進X-ception模型,增強了模型對局部特征的提取能力,實現了對花生病害的識別。以上研究的數據集均在背景單一、環境條件一致的實驗室內采集,而實際田間環境存在背景復雜、光照條件不一致、遮擋等干擾因素。田間環境下獲取的數據集比實驗室條件下的數據集其模型識別準確率低約30%~40%[13]。提高應用于田間病蟲害識別的模型性能有利于病蟲害自動識別技術的推廣與應用。復雜背景中存在與疾病特征相似的元素導致病害識別難度增加,為解決該問題,丁永軍等[14]以VGG-16模型為基礎構建卷積膠囊網絡對百合病害進行識別,提升了模型的抗噪能力,更適用于實際生產環境。孫俊等[15]通過多尺度特征融合、嵌入坐標注意力機制等設計手段改善了MobileNet-V2中存在的感興趣區域分散以及特征提取尺度單一等問題。蘇仕芳等[16]采用TensorFlow_Lite將模型部署到智能手機移動終端,實現了移動端對葡萄葉片病害的快捷、智能化診斷。ZHOU等[17]提出一種基于區域提議和漸進學習的PRPNet模型,以98.26%的平均識別準確率實現了復雜背景下蔬菜病害的識別。彭紅星等[18]在MobileNet V2的反向殘差模塊中嵌入坐標注意力機制,并采用深度可分離卷積設計了雙分支特征融合模塊,能快速實現葡萄病蟲害的識別。徐艷蕾等[19]采用雙分支結構對圖像的局部特征與全局特征進行融合,在自然環境下蘋果葉片病害的識別精度達到80%。目前,基于CNN對作物病害自動識別的研究主要集中于番茄、蘋果、玉米、水稻、黃瓜、小麥等[12,20-22],以水生蔬菜病蟲害智能識別為例,現有研究主要集中于芋頭病害的識別,如陳林琳等[23]和王佳[24]基于機器學習方法分別實現了對芋頭和香芋病害的識別,仍缺乏蓮藕病蟲害智能化識別的相關研究。

荷葉病蟲害特征具有一定的相似性,輕癥病害特征不顯著,受復雜水田環境與光照條件等因素的影響增加了病蟲害識別難度,基于深度學習技術進行荷葉病蟲害的自動識別可以提升藕田病蟲害的防控效率。本文基于DenseNet[25]模型結構進行改進,通過引入多層小卷積提升感受野,提升淺層網絡的特征表達能力;引入SE(squeeze and excitation)注意力機制模塊[26]提升對病害特征的學習能力;采用銳化的余弦卷積(sharpened cosine similarity convolution,SCS)[27]代替傳統卷積以避免梯度爆炸,減小方差;通過遷移學習模型在Plantvillage數據集上的知識提升模型的收斂速度避免過擬合。經過以上改進,期冀提升模型對細節特征的提取能力和抗干擾能力,從而實現對荷葉病蟲害的快速識別與檢測。

1 材料與方法

1.1 數據采集

荷葉主要病蟲害與特征描述如表1所示。為提升模型對不同來源數據的泛化能力,本研究于2022年6—9月在國家種質武漢水生蔬菜資源圃、武漢市江夏區武當村,采用多種設備進行數據采集。采用大疆御MAVIC2無人機采集藕田內部圖像,為保留葉片病害特征結合蓮藕種植農藝特點,將飛行高度設置為距離荷葉冠層3 m;采用2 000萬像素的佳能EOS6D數碼相機,以及OnePlus 6T、小米8智能手機距離荷葉冠層1~2 m在田邊進行數據采集,共獲取6類荷葉病蟲害圖片2 295張,其中腐敗病322張、病毒病327張、葉斑病382張、葉腐病490張、斜紋夜蛾302張、健康葉片472張,數據集示例如圖1所示。

表1 荷葉主要病蟲害及其特征

圖1 荷葉病蟲害圖像示例

1.2 數據預處理

由于采集的原始圖像來自不同設備,圖像分辨率大小不一致且包含過多冗余信息,對原始數據進行裁剪并將大小統一調整為300×300像素。為提升模型泛化能力,避免測試集內數據信息帶入訓練集,將數據集按6∶4的比例隨機劃分為訓練集和測試集。

數據增強按照數據存儲方式可分為離線數據增強和在線數據增強兩種。離線數據增強將數據集進行擴增后存儲在磁盤中,大量數據擴增會增加存儲成本;在線數據增強又稱動態數據增強,其使用生成器在訓練期間對即將喂入網絡的數據進行動態變換,擴充后的數據直接喂入網絡而不進行存儲,降低了存儲成本[28]。本文采用在線數據增強的方法對讀取的數據進行數據變換。由于數據增強中包含隨機因子,因此每輪次讀取的數據均不同從而達到數據增強效果。數據集大小影響模型的泛化能力,相同數據集采用不同的數據增強策略對模型性能提升效果不同[29]。采用縮放(resize)、隨機裁剪(random resized crop,RRC)、隨機旋轉(random rotation,RR)、隨機水平翻轉(random horizontal flip,RHF)、隨機調整銳度(random adjust sharpness,RAS)共5種數據增強方法進行組合,以探究不同數據增強方式對荷葉病害數據集的模型性能影響。

1.3 荷葉病害分類模型比較

深度學習模型通過構建深層網絡結構實現端到端的自動學習[30]。AlexNet[31]、VGG[32]、ResNet[33]、ResNeXt[34]、DenseNet等深度學習模型廣泛應用于圖像識別領域。為選擇性能最優模型進行改進,本文采用相同的訓練策略進行試驗。為適應模型大小將圖片統一縮放至224×224像素并進行歸一化,受硬件條件約束批處理大小(Batch-size)設置為16,模型迭代次數共100 epoch,初始學習率設為0.01,每經過30 epoch,學習率衰減為原來的0.1,所采用隨機梯度下降(stochastic gradient descent,SGD)優化器。在自建的荷葉病蟲害數據集上對VGG-16、AlexNet、ResNet50、ResnNeXt50、DenseNet121模型進行訓練,模型準確率分別為66.23%、75.55%、76.32%、78.18%、81.47%。模型準確率與損失曲線如圖2所示,VGG-16的損失值最快收斂到穩定狀態,但模型準確率較低,DenseNet121準確率最高且損失值在第65 epoch后逐漸到達穩定狀態,故本文基于DenseNet121(下文簡述為DenseNet)模型進行改進。

圖2 模型性能比較

1.4 DenseNet模型結構改進

DenseNet通過建立層與層之間的密集連接將前面所有層的特征圖作為該層的輸入,在很大程度上解決了深度卷積網絡梯度消失的問題,加強了特征的傳遞和重用。密集連接的正則化效應在一定程度上可以降低小數據集的過擬合問題。此外,由于不需要重新學習冗余的特征映射,減少了網絡的參數量。

1.4.1 Stem模塊

淺層網絡可以實現對圖像邊緣、細節紋理等信息的提取。如圖3a所示,Stem-A為DenseNet的Stem模塊,由步長為2的7×7卷積層和步長為2的3×3最大池化組成。如圖3b所示,Stem-B在1×1卷積前添加步長為2的最大池化作為新添加路徑,可減少特征丟失,提升模型性能[35]。如圖3c所示,參考VGG網絡采用3個3×3的卷積堆疊代替7×7卷積可以獲得更大感受野,提升特征的表達能力。為提升淺層網絡對圖像的邊緣、紋理等特征的提取能力,采用步長為2的3×3卷積進行快速降維,然后通過分支結構將3×3卷積與最大池化組合,再利用1×1的卷積進行降維,以較少的計算開銷提升模型的準確率[36],如圖3d所示。

1.4.2 銳化的余弦卷積

傳統的多層神經網絡使用上一層的輸出向量與輸入權重向量的點積作為激活函數的輸入,神經元的方差較大使模型對輸入分布的變化敏感,泛化效果差,并加劇了內部協變量的移位,從而降低了訓練速度。將余弦相似度與卷積網絡相結合,通過余弦歸一化[37](cosine normalization)(如式(1)所示)將激活函數限制在-1~1,可避免梯度爆炸,減小方差。兩個完全不同的輸入向量可能具有相似的余弦相似度,且當輸入接近0時,余弦相似度在數值上會變得不穩定。因此,本文采用銳化的余弦卷積作為傳統卷積的一種替代方案。銳化的余弦相似度(sharpened cosine similarity,SharpCosSim)如式(2)所示,通過添加兩個超參數和進一步改進余弦相似度。余弦相似度的峰值為1,利用參數以把余弦相似度提高到指數次方,在輸入向量中添加另一個參數即預期本底噪聲的大小,將防止匹配項對噪聲進行注冊,將銳化的余弦相似度與卷積相結合,即引入銳化的余弦卷積(SCS)具有更好的特征提取能力。

注:conv代表卷積;1×1、3×3、7×7為卷積核尺寸;2×2為池化核尺寸;s為步長;p為邊界擴充;maxpool為最大池化。下同。

1.4.3 Squeeze and Excitation注意力機制模塊

SE注意力機制在注意力模式下可以確定不同通道之間的權重關系,提升對感興趣通道的注意力,其結構如圖4所示,SE注意力機制模塊通過全局平均池化對特征圖進行壓縮,實現全局上下文信息的融合,然后通過全連接層→線性整流函數(Rectified linear units,Relu)→全連接層→Sigmoid激活函數(Sigmoid)生成每個特征通道的權重,最后將原始輸入的特征圖與獲得的通道權重進行點乘,在通道維度上實現對特征的標定。

注:H、W、C分別表示圖像的高、寬、通道數,FC表示全連接層。下同。

改進前后模型結構對比如表2所示,DenseNet由Stem模塊、4個Dense Block和3個Transition Layer組成。本文將DenseNet的Stem模塊(Stem-A如圖3a所示)改為具有更大感受野的Stem-D(如圖3d所示),通過分支結構以較小的計算開銷提升模型對淺層特征的提取能力;將Dense Block與Transition Layer內的卷積更換為銳化的余弦卷積可以提升模型的泛化能力和對邊緣等特征的提取能力;在Dense Block每個Denselayer的1×1卷積前以及Transition Layer內引入SE注意力機制模塊以提升模型對通道特征的敏感性。

表2 模型結構

注:SE block為SE注意力機制模塊;SCS為銳化的余弦卷積。

Note: SE block represents SE attention mechanism block; SCS represents sharpened cosine similarity convolution.

1.5 AdaMax優化器

采用隨機梯度下降算法(stochastic gradient descent,SGD)時模型的收斂速度快,但選擇合適的學習率較困難。學習率過小使模型收斂緩慢。學習率過高時模型收斂波動較大,容易收斂到局部最優解,且容易被困在鞍點。AdaMax是Adam(adaptive moment estimation)基于無窮范數的一種變體[38]。在Adam中,單個權重的更新規則是將其梯度與當前和過去梯度的2范數成反比例縮放。AdaMax是在Adam基礎上將基于2范數的更新規則泛化到基于L范數的更新規則。AdaMax會因范數較大在數值上變得不穩定,但當范數→∞時,如式(3)所示,時刻的指數加權無窮范數u基于∞范數更新規則會得到一個簡單、穩定的算法,學習率的邊界范圍更簡單,且當初始值00時,不需要糾正初始化偏差。

1.6 試驗設置與模型性能評價指標

所有試驗均在Ubuntu 20.04 LTS 64位系統環境下運行,模型采用深度學習開源框架Pytorch1.10.1和Python3.8.0搭建。計算機搭載的處理器為Intel Core i7-10700K@3.80GHz八核,運行內存32 GB,GPU為GTX 3070Ti 8G。輸入模型的圖像尺寸大小為224×224像素,受硬件條件的約束,批處理大小(Batch-size)設置為16,模型迭代次數共100 epoch,初始學習率設置為0.01,采用余弦退火學習率更新策略。

本文采用準確率(Accuracy)、精確率(Precision)、召回率(Recall)、準確率與召回率加權調和平均值—1值(1-score)來衡量模型的分類性能,以上評價指標越高模型性能越好。

2 試驗結果與分析

2.1 不同動態數據增強方式性能評估

采用SGD優化器對不同數據增強方式進行試驗,結果如表3所示。方案2將圖片先縮放至256×256像素再隨機裁剪至224×224像素比直接縮放至224×224像素準確率提升1.43個百分點,圖片縮放尺寸變化較大時可能丟失較多細節信息而降低模型識別效果;在方案2的基礎上引入隨機水平翻轉、隨機旋轉、隨機調整銳度等不同數據增強方法后模型準確率均得到提升,其中隨機調整銳度效果最佳。結果表明數據增強方案8效果最佳,準確率為85.01%。故選用方案8作為數據增強方案可減少圖片過度縮放導致的細節信息丟失,同時對圖片進行水平翻轉和隨機調整銳度以模擬不同的拍攝角度和質量可提升模型泛化能力。為驗證AdaMax優化器的優越性,本研究基于數據增強方案8將SGD優化器替換為AdaMax優化器后模型的準確率為88.05%,較方案8提升了3.04個百分點,因此后續試驗均采用該優化策略。

表3 不同數據增強方式下DenseNet準確率

注:Resize(224,224):將原圖像縮放至224×224像素;Resize256:對圖像的短邊按原圖長寬比統一縮放至256像素;RRC:隨機裁剪圖像并將其調整至224×224像素;RHF:以給定概率對圖片進行隨機水平翻轉;RR30:將圖片隨機旋轉30°;RAS:以給定概率隨機調整圖像銳度。

Note: Resize(224,224): Resize the input image to 224×224; Resize256: Uniformly resize the short edges of the image to 256 according to the aspect ratio of the original image; RRC: Random resized crop a random portion of image and resize it to 224×224; RHF: Random horizontal flip the given image randomly with a given probability; RR30: Random rotate the image by 30°; RAS: Random adjust the sharpness of the image randomly with a given probability.

2.2 荷葉病蟲害識別最優Stem模塊

為提升模型淺層網絡的特征提取能力,在DenseNet中插入不同的Stem模塊進行消融試驗,結果如表4所示。引入Stem-B模塊較原模型(DenseNet-Stem-A)的計算量和參數量變化較小,但模型準確率僅提升0.36個百分點。Stem-C擴大了模型的感受野,準確率提升1.10個百分點,但參數量提升了0.07 M,計算量提升0.84 G。引入Stem-D比原模型的準確率提高1.10個百分點,參數量和計算量僅分別增加0.02 M、0.02 G,該模塊在不過多增加計算量和參數量的基礎上提升了模型的特征提取能力。

2.3 DenseNet優化策略消融試驗

1)DenseNet模型引入不同模塊的消融試驗結果如表 5所示。在DenseNet中引入銳化的余弦卷積(SCS)比表4原模型的準確率和1值分別提升0.99、1.18個百分點,驗證了銳化的余弦卷積能夠提升模型對特征的提取能力,引入SE注意力機制模塊后模型性能稍有提升。DenseNet-SE-SCS-Stem-D將SCS、SE注意力機制模塊、Stem-D模塊進行組合,模型的準確率、精確率、召回率、F1值分別提升至90.13%、91.33%、89.82%、90.05%。

遷移學習可以減小模型訓練的代價,讓卷積神經網絡更適應小樣本數據,提升模型的泛化能力。基于Plantvillage數據集對DenseNet-SE-SCS-Stem-D進行遷學習,學習率設置為0.001,進行遷移學習后模型的準確率、精確率、召回率、1值分別為91.34%、91.43%、91.23%、91.29%,進一步提升了模型的性能,其中準確率較優化前表3方案1提升9.87個百分點。

表4 引入不同Stem模塊的模型性能比較

表5 不同改進方法模型性能對比

2)為驗證遷移學習后模型的性能,測試集的混淆矩陣如圖5所示,通過比較混淆矩陣中主對角線上預測正確的樣本量可知,改進后的模型提升了對各類病害的識別能力,模型對健康荷葉、葉斑病、病毒病識別準確率分別提升了11.70、17.11、20.77個百分點。但模型將葉斑病錯誤識別為病毒病的數量提升,推測是由于模型對細節紋理信息提取能力的增強,使得改進后模型將部分輕度卷曲且光照不均的葉斑病錯誤識別為病毒病。

注:0為腐敗病;1為健康葉片;2為斜紋夜蛾;3為葉斑病;4為葉腐病,5為病毒病。下同。

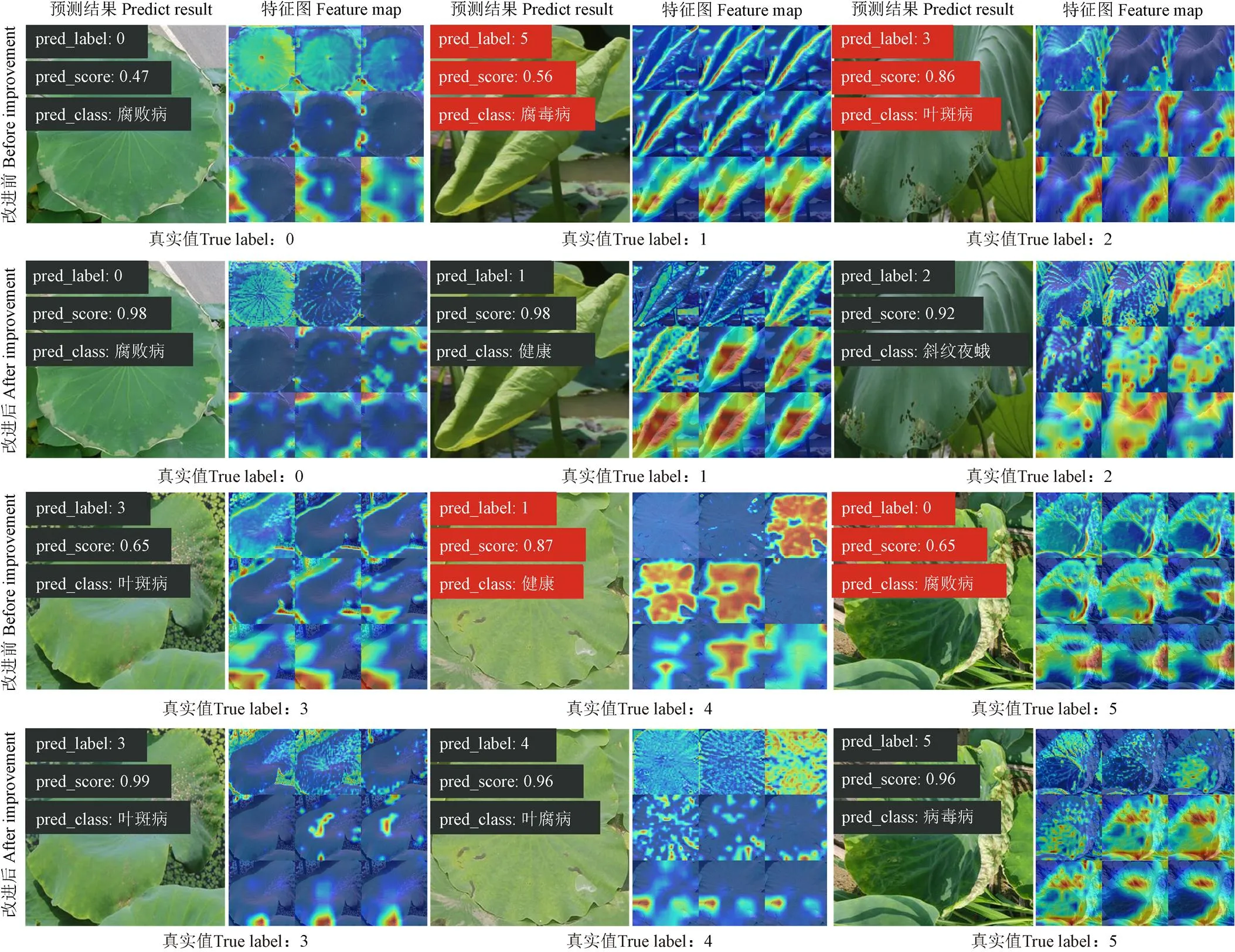

3)圖6為模型改進前后病害預測結果示例和類激活特征圖可視化結果,圖中9個特征圖依次為表2模型結構圖中8個Layers和模型最后一個Batch Normalization(BN)層的類激活特征圖。改進后模型的淺層卷積對葉片細節紋理信息的提取能力提升,能更好地實現對細小病斑的識別。改進后模型能更加準確地判斷病斑在葉片上的發生區域,如對腐敗病更加關注葉片邊緣特征,對葉斑病、斜紋夜蛾、葉腐病更加關注葉片內部病斑區域,對幼嫩健康葉片與病毒病則更關注全局信息。

注:pred_label代表圖片的預測類別標簽,True label表示圖片的真實類別標簽,pred_score表示預測為該類別的概率,pred_class表示預測標簽對應的病害類別。

2.4 基于無人機圖像的藕田病蟲害識別

采用大疆御MAVIC2無人機將飛行高度設置為6.5 m拍攝藕田圖片,并對荷葉圖片的葉片區域進行標定獲取葉片的坐標信息。批量讀取葉片的坐標信息并對圖片進行裁剪,將裁剪后的圖片送入遷移學習后的DenseNet-SE-SCS-Stem-D模型進行推理預測,并根據預測結果在無人機圖片的相應坐標區域添加不同顏色掩膜以生成藕田荷葉病蟲害分布圖,如圖7所示。

通過荷葉病蟲害分布圖可以直觀了解到藕田內各類病害的分布情況與嚴重程度,實現藕田內荷葉病蟲害的評估。根據荷葉標定數據與推理結果可獲取區域內各類病害的發生比例,其中病毒病為1.86%,腐敗病為19.25%,健康為32.30%,葉斑病為27.33%,斜紋夜蛾為9.94%,葉腐病9.32%。在后期研究中可將目標檢測網絡與荷葉病蟲害分類識別網絡相結合,先對荷葉進行自動提取,再利用分類網絡進行識別以降低復雜田間背景對不同病害識別的影響,以實現大面積藕田的病蟲害識別與動態監測。

圖7 藕田荷葉病蟲害分布圖

3 結 論

本文提出了一種基于改進DenseNet和遷移學習的荷葉病蟲害識別模型,并將其應用于基于無人機圖像的藕田荷葉病蟲害檢測,得出以下結論:

1)采用動態數據增強,對不同數據增強組合方法進行比較,結果表明對圖片先縮放再隨機裁剪比直接縮放至相同大小模型的準確率更高,大幅度進行圖片縮放可能會導致圖片部分細節信息丟失,影響模型識別效果。隨機縮放、隨機裁剪、隨機旋轉、隨機調整銳度的數據增強方式相組合更具優勢。

2)在DenseNet模型的Dense Block模塊和Transition模塊中引入銳化的余弦卷積,驗證了銳化的余弦卷積提升模型性能的有效性;通過優化模型淺層特征提取模塊,引入Squeeze and Excitation注意力機制模塊提升了模型對細節特征的提取能力和對病害的識別能力。荷葉病蟲害的識別準確率達到91.34%。

3)將改進后的分類模型應用于無人機圖片進行藕田內荷葉病蟲害識別。對荷葉所在區域標定裁剪后進行分類識別,并根據模型預測結果生成不同掩膜添加在無人機圖片上生成藕田荷葉病蟲害分布圖,實現了藕田荷葉病蟲害的識別,解決了藕田內部病蟲害監測困難的問題,為藕田的病蟲害識別與動態監測奠定基礎。

本文實現了對荷葉病蟲害的自動分類識別,為高效、準確、動態監測藕田病蟲害提供了新方法,為藕田植保無人機的變量施藥和飛行路徑規劃提供了信息支撐。

[1] 李峰,周雄祥,柯衛東,等. 湖北省蓮產業發展調研報告[J]. 湖北農業科學,2020,59(23):101-106. LI Feng, ZHOU Xiongxiang, KE Weidong, et al. Research report on lotus industry development in Hubei province[J]. Hubei Agricultural Sciences, 2020, 59(23): 101-106. (in Chinese with English abstract)

[2] 程婷婷,惠小涵,尚欣欣,等. 10個產地蓮藕營養成分分析與品質綜合評價[J]. 食品工業科技,2021,42(8):320-325. CHENG Tingting, XI Xiaohan, SHANG Xinxin, et a1. Nutrient composition analysis and quality comprehensive evaluation of lotus root in 10 producing areas[J]. Science and Technology of Food Industry, 2021, 42(8): 320-325. (in Chinese with English abstract)

[3] 賈彩鳳,時江蕾,周敬娜,等. 白洋淀地區水生藥用植物資源開發利用研究進展[J]. 醫學研究與教育,2019,36(1):28-33. JIA Caifeng, SHI Jianglei, ZHOU Jingna, et al. Advances on exploitation of aquatic medicinal plant resources in Baiyangdian Lake[J]. Medical Research and Education, 2019, 36(1): 28-33. (in Chinese with English abstract)

[4] 魏林,梁懷志. 蓮藕病蟲草害識別與綜合防治[M]. 北京:中國農業科學技術出版社,2013.

[5] 唐光美,楊馨語,張小樂,等. 蓮藕腐敗病致病菌的鑒定與防治[J]. 云南大學學報(自然科學版),2022,44(6):1280-1287. TANG Guangmei, YANG Xinyu, ZHANG Xiaole, et al. Identification and control of pathogenic fungi of lotus rhizome rot[J]. Journal of Yunnan University (Natural Sciences Edition), 2022, 44(6): 1280-1287. (in Chinese with English abstract)

[6] 于明,李若曦,閻剛,等. 基于顏色掩膜網絡和自注意力機制的葉片病害識別方法[J]. 農業機械學報,2022,53(8):337-344. YU Ming, LI Ruoxi, YAN Gang, et al. Crop diseases recognition method via fusion color mask and self-attention mechanism[J]. Transactions of the Chinese Society for Agricultural Machinery, 2022, 53(8): 337-344. (in Chinese with English abstract)

[7] 呂佩珂,蘇慧蘭,高振江. 多年生蔬菜水生蔬菜病蟲害診治原色圖鑒[M]. 北京:化學工業出版社,2013.

[8] 高澤普. 不同設施栽培模式對蓮藕生長發育的影響及腐敗病防治效果研究[D]. 邯鄲:河北工程大學,2021. GAO Zepu. The Effect of Different Cultivation Modes on the Growth and Development of Lotus Root and the Study on the Control Effectiveness of Lotus Rot Disease[D]. Handan: Hebei University of Engineering, 2021. (in Chinese with English abstract)

[9] 丁自立,吳金平,刁英,等. 蓮藕主要病害及其綜合防治[J]. 湖北農業科學,2011,50(15):3078-3079. DING Zili, WU Jinping, DIAO Ying, et al. The main disease and comprehensive prevention of[J]. Hubei Agricultural Sciences, 2011, 50(15): 3078-3079. (in Chinese with English abstract)

[10] 孫亮,柯宇航,劉輝,等. 計算機視覺技術在植物病害識別上的研究進展[J]. 熱帶生物學報,2022,13(6):651-658. SUN Liang, KE Yuhang, LIU Hui, et al. Advances in recognition of plant diseases based on computer vision[J]. Journal of Tropical Biology, 2022, 13(6): 651-658. (in Chinese with English abstract)

[11] 黃建平,陳鏡旭,李克新,等. 基于神經結構搜索的多種植物葉片病害識別[J]. 農業工程學報,2020,36(16):166-173. HUANG Jianping, CHEN Jingxu, LI Kexin, et al. Identification of multiple plant leaf diseases using neural architecture search[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2020, 36(16): 166-173. (in Chinese with English abstract)

[12] XU L, CAO B, NING S, et al. Peanut leaf disease identification with deep learning algorithms[J]. Molecular Breeding, 2023, 43(4): 25.

[13] ABADE A, FERREIRA PA, DE BARROS V F. Plant diseases recognition on images using convolutional neural networks: A systematic review[J]. Computers and Electronics in Agriculture, 2021, 185: 106125.

[14] 丁永軍,張晶晶,李民贊. 基于卷積膠囊網絡的百合病害識別研究[J]. 農業機械學報,2020,51(12):246-251. DING Yongjun, ZHANG Jingjing, LI Minzan. Disease detection of lily based on convolutional capsule network[J]. Transactions of the Chinese Society for Agricultural Machinery, 2020, 51(12): 246-251. (in Chinese with English abstract)

[15] 孫俊,朱偉棟,羅元秋,等. 基于改進 MobileNet-V2 的田間農作物葉片病害識別[J]. 農業工程學報,2021,37(22):161-169. SUN Jun, ZHU Weidong, LUO Yuanqiu, et al. Recognizing the diseases of crop leaves in fields using improved Mobilenet-V2[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2021, 37(22): 161-169. (in Chinese with English abstract)

[16] 蘇仕芳,喬焰,饒元. 基于遷移學習的葡萄葉片病害識別及移動端應用[J]. 農業工程學報,2021,37(10):127-134. SU Shifang, QIAO Yan, RAO Yuan. Recognition of grape leaf diseases and mobile application based on transfer learning[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2021, 37(10): 127-134. (in Chinese with English abstract)

[17] ZHOU J, LI J, WANG C, et al. A vegetable disease recognition model for complex background based on region proposal and progressive learning[J]. Computers and Electronics in Agriculture, 2021, 184: 106101.

[18] 彭紅星,徐慧明,劉華鼐,等. 融合雙分支特征和注意力機制的葡萄病蟲害識別模型[J]. 農業工程學報,2022,38(10):156-165. PENG Hongxing, XU Huiming, LIU Huanai, et al. Model for identifying grape pests and diseases based on two-branch feature fusion and attention mechanism[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2022, 38(10): 156-165. (in Chinese with English abstract)

[19] 徐艷蕾,孔朔琳,陳清源,等. 基于Transformer的強泛化蘋果葉片病害識別模型[J]. 農業工程學報,2022,38(16):198-206. XU Yanlei, KONG Shuolin, CHEN Qingyuan, et al. Model for identifying strong generalization apple leaf disease using Transformer[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2022, 38(16): 198-206. (in Chinese with English abstract)

[20] 鮑文霞,孫慶,胡根生,等. 基于多路卷積神經網絡的大田小麥赤霉病圖像識別[J]. 農業工程學報,2020,36(11):174-181. BAO Wenxia, SUN Qing, HU Gensheng, et al. Image recognition of field wheat scab based on multi-way convolutional neural network[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2020, 36(11): 174-181. (in Chinese with English abstract)

[21] 謝州益,馮亞枝,胡彥蓉,等. 基于 ResNet18 特征編碼器的水稻病蟲害圖像描述生成[J]. 農業工程學報,2022,38(12):197-206. XIE Zhouyi, FENG Yazhi, HU Yanrong, et al. Generating image description of rice pests and diseases using a ResNet18 feature encoder[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2022, 38(12): 197-206. (in Chinese with English abstract)

[22] 賈兆紅,張袁源,王海濤,等. 基于Res2Net和雙線性注意力的番茄病害時期識別方法[J]. 農業機械學報,2022,53(7):259-266. JIA Zhaohong, ZHANG Yuanyan, WANG Haitao, et al. Identification method of tomato disease period based on Res2Net and Bilinear attention mechanism[J]. Transactions of the Chinese Society for Agricultural Machinery, 2022, 53(7): 259-266. (in Chinese with English abstract)

[23] 陳林琳,姜大慶,蔡銀杰,等. 基于計算機視覺的芋頭病害監測與識別[J]. 農機化研究,2020,42(6):224-229. CHEN Linlin, JIANG Daqing, CAI Yinjie, et al. Monitoring and identification of the taro disease based on the computer vision[J]. Journal of Agricultural Mechanization Research, 2020, 42(6): 224-229. (in Chinese with English abstract)

[24] 王佳. 計算機視覺在香芋病害檢測中的應用研究[J]. 農機化研究,2020,42(8):241-244. WANG Jia. The applied research of computer vision in the taro disease detection[J]. Journal of Agricultural Mechanization Research, 2020, 42(8): 241-244. (in Chinese with English abstract)

[25] HUANG G, LIU Z, VAN DER MAATEN L, et al. Densely connected convolutional networks[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition (CVPR), San Juan: IEEE, 2017: 4700-4708.

[26] HU J, SHEN L, SUN G. Squeeze-and-excitation networks[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition (CVPR), Salt Lake City: IEEE, 2018: 7132-7141.

[27] RAPHAEL P. Sharpened cosine distance as an alternative for convolutions[EB/OL]. 2022[2022-01-06]. https: //www. rpisoni. dev/posts/cossim-convolution/

[28] JIA S, WANG P, JIA P, et al. Research on data augmentation for image classification based on convolution neural networks[C]//Chinese Automation Congress (CAC), Jinan: IEEE, 2017: 4165-4170.

[29] 甘雨,郭慶文,王春桃,等. 基于改進EfficientNet模型的作物害蟲識別[J]. 農業工程學報,2022,38(1):203-211. GAN Yu, GUO Qingwen, WANG Chuntao, et al. Recognizing crop pests using an improved EfficientNet model[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2022, 38(1): 203-211. (in Chinese with English abstract)

[30] VISNOI V K, KUMAR K, KUMAR B. Plant disease detection using computational intelligence and image processing[J]. Journal of Plant Diseases and Protection, 2021, 128(1): 19-53.

[31] KRIZHEVSKY A, SUTSKEVER I, HINTON G E. Imagenet classification with deep convolutional neural networks[J]. Communications of the ACM, 2017, 60(6): 84-90.

[32] SIMONYAN K, ZISSERMAN A. Very deep convolutional networks for large-scale image recognition[C]//International Conference on Learning Representations (ICLR), San Diego: ICLR, 2015: 1-14.

[33] HE K, ZHANG X, REN S, et al. Deep residual learning for image recognition[C]//Proceedings of the IEEE conference on computer vision and pattern recognition (CVPR), Las Vegas: IEEE, 2016: 770-778.

[34] XIE S, GIRSHICK R, DOLLáR P, et al. Aggregated residual transformations for deep neural networks[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition (CVPR), San Juan: IEEE, 2017: 1492-1500.

[35] HE T, ZHANG Z, ZHANG H, et al. Bag of tricks for image classification with convolutional neural networks[C]// Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR), Long Beach: IEEE, 2019: 558-567.

[36] WANG R J, LI X, LING C X. Pelee: A real-time object detection system on mobile devices[C]//Advances in neural information processing systems (NeurIPS), Montreal: Neural Information Processing Systems Foundation, 2018, 31: 1963-1972.

[37] LUO C, ZHAN J, XUE X, et al. Cosine normalization: Using cosine similarity instead of dot product in neural networks[C]//International Conference on Artificial Neural Networks (ICANN), Cham: Springer, 2018: 382-391.

[38] KINGMA D P, BA J. Adam: A Method for Stochastic Optimization[C]//International Conference for Learning Representations (ICLR), San Diego: ICLR, 2015: 1-13.

Model for identifying lotus leaf pests and diseases using improved DenseNet and transfer learning

ZHANG Guozhong1,2, LYU Ziwei1,2, LIU Haopeng1,2, LIU Wanru1,2, LONG Changjiang1,2, HUANG Chenglong1,3※

(1.,,430070,; 2.-,,430070,; 3.,.43000,)

Influenced by the ecological environment and other factors, the quality and yield of lotus root have been seriously affected by the occurrence of diseases and insect pests in recent years. With the improvement of living standards and the development of the lotus industry chain, people are looking for green food, high-yield and high-quality products. Nowadays, many farmers and planters are unable to accurately identify the diseases and pests of lotus due to lack of professional knowledge of diseases and insect pests control. There is a shortage of efficient, low-cost and automatic identification technology for the prevention and control of lotus diseases and insect pests. The diagnosis and identification of diseases and insect pests are of great significance for the prevention and control of diseases and insect pests in lotus fields. Over the past few years, deep learning technology has been widely used in the field of plant diseases and insect pests recognition to automatically extract the features of plant diseases and insect pests. In order to achieve an efficient and accurate diagnosis of lotus leaf diseases and insect pests, lotus leaf diseases and insect pests dataset was constructed and preliminary experiments were constructed on AlexNet, VGG-16, ResNet50, ResNeXt50, and DenseNet121 models. The experimental results indicated that DenseNet121 has the best performance on the dataset, lotus leaf diseases and insect pests identification model based on improved DenseNet was improved. Firstly, different methods for dynamic data enhancement were compared in this paper. The results show that resizing and randomly resizing the image is more accurate than directly resizing to the same size. The loss of detail information in part of the image is caused by over-compressing the image size, which affects the model’s recognition effect. The accuracy of the model was increased from 81.47% to 85.01% by using the data enhancement method of resize, random resized crop, random horizontal flip and random adjust sharpness. AdaMax optimizer was used to replace Stochastic Gradient Optimization optimizer and the accuracy of DenseNet model has been improved by 3.04 percentage points. The Stem block uses multi-layer small convolution for fast dimensionality reduction and a branch structure to combine convolution and maximum pooling. It improves the ability of the model to extract shallow features at a lower operating cost. The Squeeze and Excitation attention mechanism block and sharpen cosine similarity convolution were introduced in the Denselayer of the Dense Block and the Transition Layer. This method improved the recognition ability of the model to lotus leaf diseases, and verified the effectiveness of sharpen cosine convolution to improve the performance of the model. Transfer learning was performed on the Plantvillage dataset. The accuracy of the improved model is 91.34%, which 9.87 percentage points higher than before improvement and optimization. In order to solve the problem of monitoring diseases and insect pests in lotus fields, the improved model was applied to the identification of lotus field diseases and insect pests in UAV images. The calibration area of lotus leaf was cut and predicted by reasoning, then different masks were generated according to the model prediction results and added to the UAV image to generate a distribution map of lotus field diseases and insect pests. The recognition of lotus field diseases and insect pests in the UAV image was investigated, automatic classification and recognition of leaf spot, viral disease,, lotusleaf rot and lotus rhizome rot were realized. It provides a new method for efficient and accurate identification and dynamic monitoring of lotus diseases. It also supplies information supports for variable pesticide application and flight path planning in plant disease prevention and control based on UAV.

models; UAV; identification of pests and diseases; lotus leaf; DenseNet; attention mechanism; cosine similarity; transfer learning

2023-01-30

2023-04-07

國家特色蔬菜產業技術體系專項資助項目(CARS-24-D-02);湖北省高等學校優秀中青年科技創新團隊計劃項目(T201934);中央高校基本科研業務費專項基金資助(2662020GXPY012)

張國忠,教授,博士生導師,研究方向為現代農業裝備設計與測控。Email:zhanggz@mail.hzau.edu.cn

黃成龍,副教授,碩士生導師,研究方向為智慧農業技術與裝備、植物表型研究。Email:hcl@mail.hzau.edu.cn

10.11975/j.issn.1002-6819.202301122

TP391.4;S24

A

1002-6819(2023)-08-0188-09

張國忠,呂紫薇,劉浩蓬,等. 基于改進DenseNet和遷移學習的荷葉病蟲害識別模型[J]. 農業工程學報,2023,39(8):188-196. doi:10.11975/j.issn.1002-6819.202301122 http://www.tcsae.org

ZHANG Guozhong, LYU Ziwei, LIU Haopeng, et al. Model for identifying lotus leaf pests and diseases using improved DenseNet and transfer learning[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2023, 39(8): 188-196. (in Chinese with English abstract) doi:10.11975/j.issn.1002-6819.202301122 http://www.tcsae.org