聯合引導式深度圖像超分辨的單目深度估計方法

劉鵬 王建龍 竇新宇

摘? 要:針對基于編解碼結構的單目深度估計網絡模型,對細粒度深度信息估計精度差和算力需求大的問題,提出了一種聯合引導式深度圖像超分辨率的單目深度估計方法。該方法設計了一種基于選擇性特征融合的引導式深度圖像超分辨率網絡模型,并將其與單目深度估計網絡模型結合在一個監督學習框架下估計深度。在NYU-Depth-V2數據集上,以三種單目深度估計網絡模型開展實驗,結果證明該方法具有更好的深度邊界預測效果和較低的算力消耗指標。關鍵詞:單目深度估計;深度圖像超分辨;特征融合;編解碼結構

中圖分類號:TP391.4? 文獻標識碼:A? 文章編號:2096-4706(2023)11-0011-04

Monocular Depth Estimation Method Combining Guided Depth Image Super-Resolution

LIU Peng, WANG Jianlong, DOU Xinyu

(Intelligence and Information Engineering College, Tangshan University, Tangshan? 063000, China)

Abstract: Aiming at the problem of poor fine-grained depth information estimation precision and high demand for computational power in monocular depth estimation network models based on encoder-decoder structure, a monocular depth estimation method combining guided depth image super-resolution is proposed. This method designs a guided depth image super-resolution network model based on selective feature fusion, and combines it with monocular depth estimation network model to estimate depth under a supervised learning framework. This paper performs experiments with three monocular depth estimation network models on NYU-Depth-V2 dataset, and the results prove that the method has a better depth boundary prediction effect and lower computational power consumption index.

Keywords: monocular depth estimation; depth image super-resolution; feature fusion; encoder-decoder structure

0? 引? 言

深度圖像每個像素點記錄著攝像機與場景中物體之間的距離信息,能夠準確反映出場景三維空間結構信息,在自動駕駛、場景理解、三維重建等領域有著廣泛的應用。從單幅RGB圖像中恢復深度圖像的單目深度估計方法,是移動設備感知環境的主要手段之一,但單目深度估計病態性的本質[1],使其一直是計算機視覺領域的難點課題。

目前效果較好的單目深度估計均采用的是基于深度學習的方法[2,3],從大量單幅RGB圖像到對應視角的深度圖像的映射過程中提取深度線索,完成深度圖像的單目估計。其中,基于編解碼結構的卷積神經網絡(Convolutional Neural Network, CNN)是主流的設計模型。這類模型的設計思路是:編碼器基于圖像分類網絡,通過在大型圖像分類庫(如ImageNet[4])上的預訓練完成參數的初始化,在對輸入圖像進行漸進下采樣過程中,逐步增加感受野,將RGB圖像低級特征分組為抽象的高級特征;解碼器聚合來自編碼器的特征,并將其轉換為最終的深度估計。這類模型主要存在以下不足:1) 編碼器的下采樣操作,會帶來特征分辨率和粒度在模型的較深階段丟失。盡管各種深度學習方法(如跳躍連接[5]、多尺度特征提取[6,7]、注意機制[8-10]等)被融入到了解碼器的設計過程中,提高了特征的聚合質量,但對深度圖像邊界輪廓等細粒度信息的預測仍不夠清晰。2)以更高分辨率的輸入數據集進行訓練和測試,可以減輕特征粒度損失[11,12],但更高分辨率的模型有著更高的硬件算力需求,這大大限制了此類模型的應用場合。

與深度估計類似,引導式深度圖像超分辨也是針對深度圖像的重要計算機視覺任務,受到了廣泛的研究。引導式深度圖像超分辨是提高深度圖像分辨率的重要途徑,通過將RGB圖像的特征信息有效融入深度圖像的超分辨過程,來引導深度圖像細粒度特征的修復。目前,基于深度學習的引導式深度圖像超分辨方法[13,14],能較好地實現深度圖像的高分辨率恢復。

針對基于編解碼結構的單目深度估計網絡模型存在的不足之處,本文結合引導式深度圖像超分辨的技術特性,提出一種聯合引導式深度圖像超分辨的單目深度估計方法,對現有單目深度估計網絡模型進行改進。具體做法是:使現有單目深度估計網絡模型負責估計包含場景深度一致性結構信息的低分辨率深度圖像;設計一種基于選擇性特征融合(Selective Feature Fusion)的引導式深度圖像超分辨網絡模型SFFNet,負責從RGB圖像中提取有效的高頻細節信息,以彌補深度圖像上采樣過程中的細粒度結構損失;兩個網絡模型組合在一個監督學習框架內,完成深度圖像的單目估計任務,從而使單目深度估計具有細粒度估計效果的同時,也具有較少的算力需求。

1? 相關工作

在單目深度估計研究領域,相比較傳統的環境假設法和機器學習法,深度學習方法因其強大的特征學習和映射能力,使得單目深度估計性能得到了大范圍的提升。

Eigen等[15]首次將CNN引入到深度圖像的單目估計任務中,該方法首先用CNN對場景全局深度信息進行粗估計,再對深度圖像局部信息進行精估計。隨后,編解碼結構的CNN模型成為主流的設計模型,例如,Zheng等[6]通過自定義的特征多尺度上卷積操作,將編碼器不同分辨率的層次化特征進行有效整合,實現了編碼器特征從粗到精處理的映射;Chen等[7]用一種自適應密集特征聚合模塊融合多尺度特征,實現了場景深度圖像結構信息的有效推斷;Liu等[8]使用跳躍連接將卷積神經網絡不同階段的相同分辨率特征進行有效融合,提高了深度圖像邊緣細節的估計精度;Huynh等[9]引入非局部共平面性約束和非局部注意機制來提高深度圖像中平面結構區域的估計效果;Lee等[10]在解碼器的每個階段特征的處理中,設計了一種局部平面約束的操作,提高了深度圖像的整體估計效果。

為了處理編碼器下采樣操作時,深度特征分辨率和粒度丟失的問題,Miangoleh[11]等設計了一種將多個分辨率深度預測結果進行融合的機制。最近,各類視覺轉換器(Transformer)模型[16,17]也被應用在單目深度估計任務中,通過RGB圖像分塊的方式,維持在較高分辨率下提取特征,進一步提高了深度估計效果。以更高分辨率的輸入數據集進行訓練和測試,可以減輕特征粒度損失,但如何合理設計網絡模型,同時保證計算效率和預測精度,目前仍需進一步的研究。

2? 方法設計

2.1? 網絡結構

本文方法的網絡結構如圖1所示,包括單目深度估計和SFFNet兩個子網絡。對分辨率為W×H的RGB圖像,單目深度估計子網絡采用典型的單目深度估計模型結構,以降采樣后的RGB圖像為輸入,完成W/4×H/4分辨率深度圖像的估計,此深度圖像為最終輸出的W×H分辨率深度圖像提供全局一致性結構信息。設計的SFFNet以單目深度估計子網絡估計出的深度圖像和原始分辨率的RGB圖像為輸入,完成上采樣率為4的深度圖像重建。兩個子網絡相互配合,在一個監督學習框架內完成深度圖像的單目估計任務。

2.2? SFFNet子網絡模型

本文設計的SFFNet采用了漸進式特征聚合的設計模式,結構如圖1所示。首先,對深度圖像和RGB圖像進行淺層特征提取,這里采用了兩個3×3卷積+ ReLU激活函數和一個1×1卷積+ ReLU激活函數串聯組合實現。然后,通過跨步卷積+ ReLU激活函數對RGB圖像的淺層特征進行逐步下采樣操作。接著,在深度圖像逐步上采樣操作過程中,先通過一個選擇性特征融合模塊實現相同分辨率RGB圖像特征和深度圖像特征的融合,然后通過卷積+像素重組(Pixel Shuffle,PS)實現深度圖像的上采樣。最后,在到達目標分辨率后,通過3×3卷積實現對深度圖像插值上采樣殘差的預測。

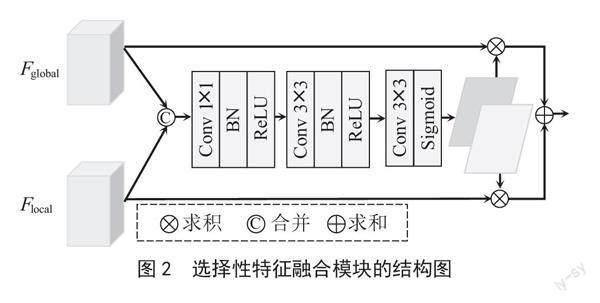

選擇性特征融合模塊結構如圖2所示,模塊設計目的是通過特征空間域二維注意力圖的獲取,自適應地完成RGB圖像特征和深度圖像特征的融合,達到細化特征處理以捕獲細粒度信息的目的。這里,將包含場景結構上下文線索的深度圖像特征,稱為全局特征Fglobal;將可彌補深度圖像上采樣過程中邊界輪廓結構損失的RGB圖像特征,稱為局部特征Flocal。對這些全局和局部特征,首先,通過1×1卷積操作將特征沿著信道維度合并起來。然后,通過兩個3×3卷積+批量歸一化(Batch Normalization, BN)+ReLU激活函數的操作,進行合并特征的融合和約減。接著,通過3×3卷積和Sigmoid函數產生兩個空間域二維注意力圖,并將這兩個注意力圖與對應的局部和全局特征相乘,以達到對特征的細化處理。最后,將這些細化后的特征按元素相加以構建最后的融合特征。

2.3? 損失函數

本文網絡模型訓練時,總損失函數為單目深度估計訓練損失LMDE和SFFNet訓練損失LSFFNet的和,即L = LMDE + LSFFNet。其中,LMDE表示對應方法中典型單目深度估計子網絡選擇的損失函數,LSFFNet本文使用Charbonnier損失函數[18],計算方法如下:

式中,y*表示真實深度值,y表示重建深度值,n表示每個訓練批次的總像素個數,ε表示值為1×10-3的常數。

3? 實驗過程與結果分析

3.1? 數據集

實驗選擇NYU-Depth-V2數據集[19],進行模型的訓練和測試。按照單目深度估計通用的分類方式,使用249個場景,約5萬組RGB-D圖像對用于網絡的訓練;使用215個場景,約654組RGB-D圖像對用于網絡的測試。訓練集和測試集均居中剪切為608×456,以去除圖像邊緣區域相對準確率不高的深度值。

3.2? 實施細節

網絡的實現采用PyTorch深度學習框架。硬件平臺使用四個NVIDIA RTX 2080 Ti顯卡,實現高性能的GPU并行運算。Adam梯度優化算法作為網絡的優化器,基本學習率設置為0.000 1,并且每5個周期降低10%,參數β1 = 0.9,β2 = 0.999,使用0.000 1的衰減率。網絡訓練參數Batch的大小為16。各種對比網絡的訓練次數均設置為30個Epoch。

3.3? 評估指標

選用單目深度估計任務常用的誤差和精度評價指標,對模型進行定量對比分析。評價指標和對應計算公式為:

1)均方根誤差(RMSE):

2)絕對相對差(Abs Rel):

3)均方對數誤差(Log10):

4)相對誤差在1.25k以內的像素比例,其中

3.4? 實驗結果

為了驗證本文方法的通用性,選擇SARPN、JADN、BTS三種典型單目深度估計網絡模型為方法中的單目深度估計子網絡。因為SARPN和JADN的輸出分辨率是輸入分辨率的一半,因此圖1所示的本文方法對輸入RGB圖像進行1/2降采樣,而BTS的輸入和輸出分辨率相同,因此圖1中使用的是1/4降采樣。三種網絡直接完成深度圖像的單目估計時,各項指標如表1的一、三、五行所示。將三種網絡分別聯合本文設計的SFFNet,進行單目深度估計,各項指標如表1的二、四、六行所示。表1同時給出了模型參數及算力需求的變化情況。可見,本文方法在保證三種典型模型獲得同等水平評價指標的同時,以非常小的參數代

價(0.6 M),大幅度降低了模型對算力的需求,對于性能指標GFLOPS,SARPN降低了66.7%,JADN降低了48.1%,BTS降低了40.7%。

圖3顯示了以BTS為方法中的單目深度估計子網絡時,加入SFFNet前后,對NYU-Depth-V2測試數據集不同場景的定性比較結果,這里選擇了廚房、臥室、餐廳三種典型應用場景。通過對比可以發現,用本文提出的方法改造后,對場景全局結構深度信息的預測變化不大,但深度圖像具有更清晰的邊緣和更細節的信息,比如圖3深度圖像中框標出的廚房置物架、臥室酒瓶、餐廳家居等部分。這表明了通過本方法對原有網絡模型的改進后,深度圖像細粒度信息的預測效果得到了提升。

4? 結? 論

本文提出了一種聯合引導式深度圖像超分辨的單目深度估計方法。該方法將常用單目深度估計模型與設計的SFFNet網絡模型進行合理結合,使常用的單目深度估計網絡模型推斷包含場景全局一致性結構信息的低分辨率深度圖像,利用SFFNet將從RGB圖像中提取到的高頻細節信息補充到深度圖像的超分辨重建過程,兩個網絡在一個監督學習框架下。實驗結果表明,提出的方法可保證深度估計精度的情況下,有效提升細粒度信息的預測效果,并降低模型的硬件算力需求。

參考文獻:

[1] HE L,WANG G,HU Z. Learning depth from single images with deep neural network embedding focal length [J]. IEEE Transactions on Image Processing,2018,9(27):4676-4689.

[2] 羅會蘭,周逸風.深度學習單目深度估計研究進展 [J].中國圖象圖形學報,2022,27(2):390-403.

[3] 江俊君,李震宇,劉賢明.基于深度學習的單目深度估計方法綜述 [J].計算機學報,2022,45(6):1276-1307.

[4] DENG J,DONG W,SOCHER R,et al. ImageNet:A large-scale hierarchical image database [C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition.Miami:IEEE,2009:248-255.

[5] CHEN T,AN S,ZHANG Y,et al. Improving monocular depth estimation by leveraging structural awareness and complementary datasets [C]//Proceedings of the European Conference on Computer Vision.Glasgow:IEEE,2020:90-108.

[6] ZHENG Z,XU C,YANG J,et al. Deep hierarchical guidance and regularization learning for end-to-end depth estimation [J].Pattern Recognition,2018,83:430-442.

[7] CHEN X,CHEN X,ZHA Z. Structure aware residual pyramid network for monocular depth estimation [C]//Proceedings of the International Joint Conference on Artificial Intelligence.Macao:AAAI Press,2019:694-700.

[8] LIU J,LI Q,CAO R,et al. A contextual conditional random field network for monocular depth estimation [J].Image and Vision Computing,2020,98:103922-103934.

[9] HUYNH L,NGUYEN-HA P,MATAS J,et al. Guiding monocular depth estimation using depth-attention volume [C]//Proceedings of the European Conference on Computer Vision.Glasgow:IEEE,2020:581-597.

[10] LEE J H,HAN M K,KO D W,et al. From big to small:multi-scale local planar guidance for monocular depth estimation [J/OL].arXiv:1907.10326 [cs.CV].(2021-08-23).https://arxiv.org/abs/1907.10326.

[11] MIANGOLEH S M,DILLE S,MAI L,et al. Boosting monocular depth estimation models to high-resolution via content-adaptive multi-resolution merging [C]//2021 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR).Nashville:IEEE,2021:9685-9694.

[12] RANFTL R,BOCHKOVSKIY A,KOLTUN V. Vision transformers for dense prediction [C]//2021 IEEE/CVF International Conference on Computer Vision (ICCV).Montreal:IEEE,2021:12159-12168.

[13] YE X,SUN B,WANG Z,et al. PMBANet:Progressive multi-branch aggregation network for scene depth super-resolution [J].IEEE Transactions on Image Processing,2020,29:7427-7442.

[14] LIU P,ZHANG Z,MENG Z,et al. PDR-Net:Progressive depth reconstruction network for color guided depth map super-resolution [J].Neurocomputing,2022,479:75-88.

[15] EIGEN D,PUHRSCH C,FERGUS R. Depth map prediction from a single image using a multi-scale deep network [C]//Proceedings of the IEEE Conference and Workshop on Neural Information Processing Systems.Montreal:IEEE,2014:2366-2374.

[16] BHAT S F,ALHASHIM I,WONKA P. AdaBins:Depth estimation using adaptive bins [C]//2021 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR).Nashville:IEEE,2021:4009-4018.

[17] PATIL V,SAKARIDIS C,LINIGER A,et al. P3Depth:Monocular depth estimation with a piecewise planarity prior [C]//2022 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR).New Orleans:IEEE,2022:1600-1611.

[18] BRUHN A,WEICKERT J,SCHNORR C. Combining local and global optic flow methods [J].International Journal of Computer Vision,2005,61(3):211-231.

[19] SILBERMANM N,HOIEM D,KOHLI D,et al. Indoor segmentation and support inference from RGBD images [C]//Proceedings of the European Conference on Computer Vision.Florence:Springer,2012:746-760.

作者簡介:劉鵬(1982—),男,漢族,遼寧沈陽人,講師,碩士,研究方向:深度學習、單目深度估計;王建龍(1983—),男,漢族,河北唐山人,講師,碩士,研究方向:圖像處理、深度學習;竇新宇(1983—),男,漢族,河北唐山人,副教授,博士,研究方向:深度學習。

收稿日期:2023-01-04

基金項目:唐山市市級科技計劃項目(22130205H)