基于集成遷移學(xué)習(xí)的新裝備裝甲車輛分類

劉懿, 任濟(jì)寰, 吳祥, 薄煜明

(南京理工大學(xué) 自動化學(xué)院, 江蘇 南京 210094)

0 引言

在現(xiàn)代戰(zhàn)爭中,以坦克為代表的裝甲車輛是陸地戰(zhàn)場上的重要武器。許多國家都開發(fā)了不同種類的裝甲車輛,其中一些在外觀上是相似的,例如俄羅斯的T-72和T-90坦克。但是這些外觀相似的裝甲車輛在防護(hù)性能上可能差別很大,為了有效抵御不同的裝甲目標(biāo),有必要迅速識別這些裝甲車輛[1],并選擇適當(dāng)?shù)姆烙淦鳌?/p>

傳統(tǒng)基于圖像的裝甲車輛分類方法通常包括兩個步驟:首先利用人工設(shè)計(jì)的特征提取算法提取圖像特征;然后設(shè)計(jì)一個分類器基于圖像中提取的特征進(jìn)行分類。常見的人工設(shè)計(jì)特征提取方法有尺度不變特征轉(zhuǎn)換(SIFT)特征[2]、加速增強(qiáng)特征(SURF)[3]和定向梯度直方圖(HOG)特征[4]等,而常用的分類器包括K-近鄰(KNN)分類器、決策樹算法、貝葉斯分類器和支持向量機(jī)(SVM)[5]等。針對不同的任務(wù),設(shè)計(jì)者會根據(jù)自身對任務(wù)的理解,選擇和搭配不同的特征提取器和分類器,以達(dá)到良好的表現(xiàn),這無疑需要設(shè)計(jì)者具備一定的知識經(jīng)驗(yàn),且付出大量的時間和勞動。對于新裝備的裝甲車,特別是來自其他國家裝甲車的分類,這樣的設(shè)計(jì)思路有較大的難度。

近十年來,數(shù)據(jù)驅(qū)動的分類方法在計(jì)算機(jī)視覺領(lǐng)域逐漸興起。卷積神經(jīng)網(wǎng)絡(luò)(CNN)作為最成功的數(shù)據(jù)驅(qū)動分類方法之一,在圖像分類任務(wù)[6]和識別任務(wù)[7-9]中獲得了巨大成功。文獻(xiàn)[10]利用ImageNet數(shù)據(jù)集足夠多的樣本進(jìn)行訓(xùn)練,發(fā)展出優(yōu)秀的特征提取能力,在圖像分類領(lǐng)域中取得了重大突破。文獻(xiàn)[11]的研究更加成功,在二十余個大型數(shù)據(jù)集上達(dá)到了很好的效果,不僅如此,在小樣本數(shù)據(jù)集上同樣成就斐然。但是,充分的訓(xùn)練是CNN模型獲得良好性能的關(guān)鍵。CNN模型要達(dá)到優(yōu)秀的表現(xiàn)往往需要大量有完備標(biāo)簽的訓(xùn)練樣本,而為新裝備的裝甲車輛構(gòu)建大規(guī)模的、有完備標(biāo)簽的數(shù)據(jù)集是非常困難的,因?yàn)楹茈y獲得這類裝備的圖像及相關(guān)信息。

在計(jì)算機(jī)視覺領(lǐng)域,圖像隨機(jī)裁剪、平移和旋轉(zhuǎn)等數(shù)據(jù)增強(qiáng)方法[12-13]可以一定程度上緩解訓(xùn)練樣本缺乏的問題。這些數(shù)據(jù)增強(qiáng)方法可以使特征提取更加有效,不能在小樣本任務(wù)中為模型學(xué)習(xí)提供額外的知識。近年來,基于對抗的方法由于其較好的性能表現(xiàn)受到了大部分研究者的青睞,文獻(xiàn)[14-15]基于對抗生成網(wǎng)絡(luò)(GAN)[16]擴(kuò)充數(shù)據(jù)集,達(dá)到提升分類準(zhǔn)確率的目的;然而這類算法生成圖片只是對真實(shí)樣本的簡單改動,生成圖片的質(zhì)量參差不齊,并且不能保證圖片中目標(biāo)物體全局結(jié)構(gòu)的準(zhǔn)確性。為了更有效地解決訓(xùn)練樣本缺乏問題,本文采用遷移學(xué)習(xí)方法將既往任務(wù)中學(xué)到的知識遷移到有一定相關(guān)性的新任務(wù)中。

遷移學(xué)習(xí)的主要流派包括基于特征的遷移學(xué)習(xí)方法[17]和基于模型的遷移學(xué)習(xí)方法[18]。前者的核心是找到源域和目標(biāo)域之間共同的特征表示,然后基于共同的特征表示進(jìn)行知識遷移。后者則基于源數(shù)據(jù)集和目標(biāo)數(shù)據(jù)集的模型之間共同的參數(shù)或先驗(yàn)分布,通過進(jìn)一步的處理來遷移知識。遷移學(xué)習(xí)目前最主流的手段是特征提取[19]和模型微調(diào)[20]。

特征提取方法[21-22]是利用一個數(shù)據(jù)豐富的數(shù)據(jù)集訓(xùn)練一個泛化性能良好的神經(jīng)網(wǎng)絡(luò),保留該模型除最后一層外的所有參數(shù)。然后,將倒數(shù)第2層的激活值(網(wǎng)絡(luò)輸出)送入一個新創(chuàng)建的分類器,該分類器可以是傳統(tǒng)的SVM算法,也可以是新的神經(jīng)網(wǎng)絡(luò)全連接層,用于訓(xùn)練和分類。模型微調(diào)[23]是一種修改預(yù)訓(xùn)練神經(jīng)網(wǎng)絡(luò)模型的部分參數(shù)的方法。具體來說,就是替換掉預(yù)訓(xùn)練模型的輸出層后,用新的任務(wù)數(shù)據(jù)以較小的學(xué)習(xí)率進(jìn)行更進(jìn)一步地全局訓(xùn)練。參數(shù)微調(diào)是一種簡單有效的知識遷移方法,已經(jīng)被廣泛用于許多領(lǐng)域,包括自然語言處理[24]、文本識別[25]、圖像分類[26-27]和目標(biāo)檢測[28]等。一些基于微調(diào)的改進(jìn)方法,如自適應(yīng)微調(diào)[29-30],在自然語言處理任務(wù)中已經(jīng)達(dá)到了學(xué)術(shù)界最先進(jìn)的性能。

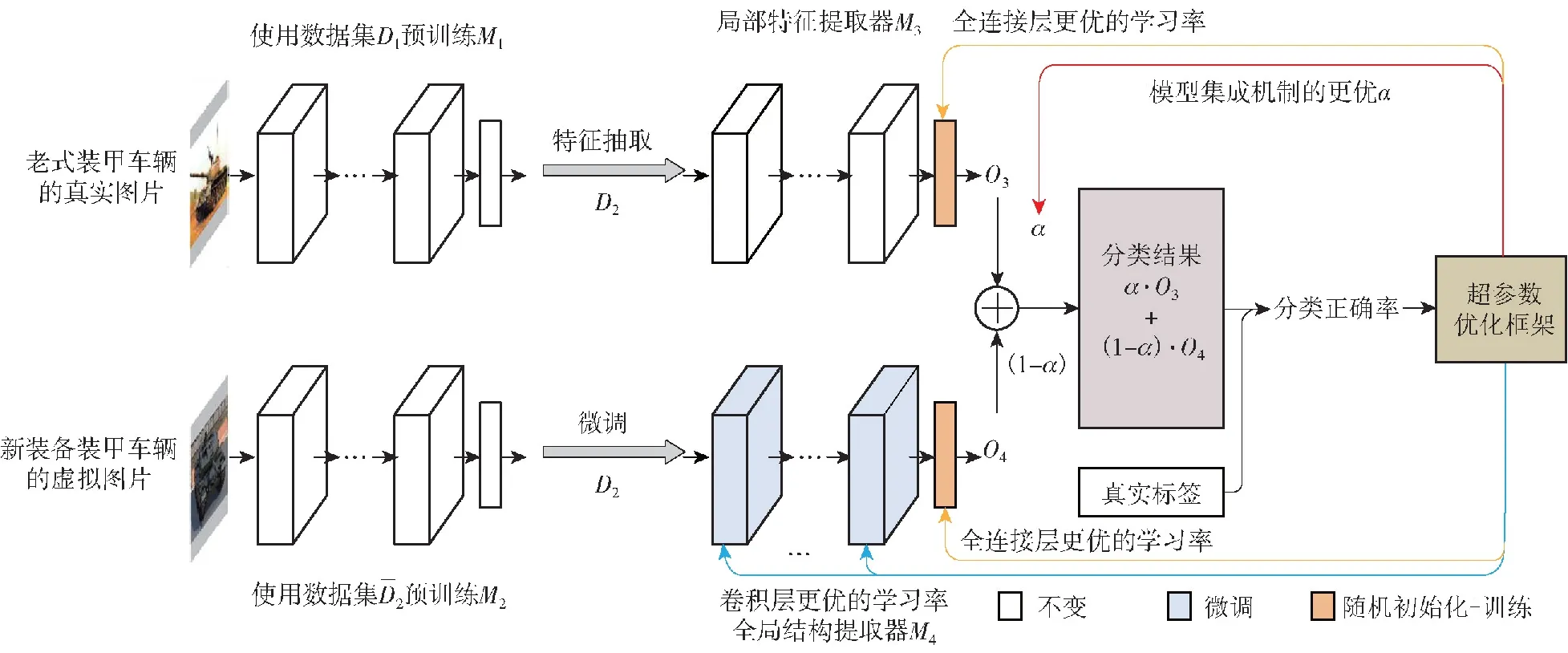

針對傳統(tǒng)數(shù)據(jù)增強(qiáng)方法和基于對抗的方法的不足,本文在兩個獲取難度低的相關(guān)數(shù)據(jù)集上預(yù)訓(xùn)練模型的基礎(chǔ)上,使用特征提取、模型微調(diào)的兩個不同遷移學(xué)習(xí)策略的調(diào)整,更加充分使用預(yù)訓(xùn)練數(shù)據(jù),緩解訓(xùn)練數(shù)據(jù)缺少的問題,以提高模型對特征的表征能力,并最終提高分類任務(wù)準(zhǔn)確率。具體來說,由于不同裝甲車輛的局部特征(裝甲紋理、負(fù)重輪外形等)具有一定的相似性,本文設(shè)計(jì)了局部特征提取器來遷移局部特征知識。又由于同一裝甲車輛的虛擬圖像和真實(shí)圖像的全局結(jié)構(gòu)具有高度相似性,設(shè)計(jì)了基于微調(diào)方法的全局特征提取器來遷移全局結(jié)構(gòu)知識。其次,為了實(shí)現(xiàn)更有效的知識遷移,同時獲取輸入圖像中的全局結(jié)構(gòu)特征和局部特征,本文設(shè)計(jì)了模型集成機(jī)制將兩個遷移學(xué)習(xí)模型結(jié)合起來并自主加權(quán)兩個神經(jīng)網(wǎng)絡(luò)的輸出作為最終結(jié)果。此外,本文設(shè)計(jì)了超參數(shù)優(yōu)化框架提升模型的最終表現(xiàn)并有效降低訓(xùn)練難度。遷移學(xué)習(xí)的使用放寬了訓(xùn)練數(shù)據(jù)必須與測試數(shù)據(jù)獨(dú)立且相同分布的假設(shè)[31],這有效地提高了訓(xùn)練樣本有限的新裝備的裝甲車輛分類任務(wù)的性能。最終,本文提出的分類方法在構(gòu)建的裝甲車輛圖像數(shù)據(jù)集表現(xiàn)優(yōu)異,分類準(zhǔn)確率優(yōu)于目前主流的深度學(xué)習(xí)方法和傳統(tǒng)的分類方法。為了更好地證明所提方法的有效性,實(shí)驗(yàn)中使用類激活映射(CAM)[32]來可視化模型的注意力。從本文集成模型中不同CNN的網(wǎng)絡(luò)注意力圖,可以看到這些網(wǎng)絡(luò)重點(diǎn)關(guān)注的區(qū)域,從而進(jìn)一步分析了它們的作用。

1 基于集成遷移學(xué)習(xí)的圖像分類方法

本文的主要目標(biāo)是對訓(xùn)練圖像不足的裝甲車輛進(jìn)行分類,特別是新裝備的裝甲車輛。由于常規(guī)的深度學(xué)習(xí)算法在缺乏訓(xùn)練數(shù)據(jù)的情況下難以取得很好的性能,使用基于深度學(xué)習(xí)的方法對新裝備的裝甲車輛的圖像進(jìn)行分類存在一定的難度。而本文則采用遷移學(xué)習(xí)算法來緩解新裝備裝甲車輛圖像難以獲得的問題。

與新裝備裝甲車輛的真實(shí)圖像相比,老式裝甲車輛的圖像和新裝備裝甲車輛的虛擬圖像往往更容易獲得,所以本文用這些更容易獲得的圖像來預(yù)訓(xùn)練模型,再使用遷移學(xué)習(xí)方法將學(xué)習(xí)到的知識遷移到最終網(wǎng)絡(luò)。而獲取難度相對高的、數(shù)量相對有限的新裝備裝甲車輛的真實(shí)圖像則用于調(diào)整獲得預(yù)訓(xùn)練知識的模型和最終的裝甲車輛分類算法性能測試。

老式裝甲車輛和新裝備裝甲車輛的真實(shí)圖像之間共享一定的領(lǐng)域知識,包括相似的組成部分、某些零件以及局部紋理特征。但組成數(shù)據(jù)集時的劃分類別不同,即裝甲車輛種類不同。因此,可以利用在老式裝甲車輛圖像上預(yù)訓(xùn)練的模型作為新裝備裝甲車輛分類任務(wù)的局部特征提取器。相同車型的新裝備裝甲車輛的虛擬圖像和真實(shí)圖像之間的主要區(qū)別是它們的數(shù)據(jù)來源不同。虛擬圖像來自虛擬的游戲世界,其中的裝甲車輛是通過3D建模建立的。雖然游戲圖像的精確性不足以直接用于訓(xùn)練學(xué)習(xí)模型,但它們對比于相同車型的真實(shí)圖像來說獲取更加簡單,而且二者之間的整體結(jié)構(gòu)特征高度相似。因此,可以將在新裝備裝甲車輛的虛擬圖像上預(yù)訓(xùn)練的模型作為裝甲車輛分類任務(wù)的全局結(jié)構(gòu)提取器。

圖1 基于集成遷移學(xué)習(xí)的圖像分類方法流程圖

1.1 局部特征提取器

為了緩解裝甲車輛分類任務(wù)中新裝備的裝甲車輛訓(xùn)練圖像不足的問題,本文使用老式裝甲車輛的圖像預(yù)訓(xùn)練一個CNN模型,并將其學(xué)到的知識遷移到新模型中,用于新裝備裝甲車輛分類任務(wù)中局部特征的提取。

在搭建神經(jīng)網(wǎng)絡(luò)并隨機(jī)初始化神經(jīng)網(wǎng)絡(luò)內(nèi)參數(shù)W后,使用老式裝甲車輛的圖像訓(xùn)練該網(wǎng)絡(luò),通過使用數(shù)據(jù)集D以最小化損失函數(shù)L(D|W)的方式優(yōu)化參數(shù)W。由于所提出的方法最終面向圖像分類任務(wù),所以選擇交叉熵函數(shù)作為損失函數(shù):

(1)

式中:x為輸入的圖像樣本,p(x)是該輸入圖像數(shù)據(jù)對應(yīng)的真實(shí)類別標(biāo)簽;q(x)是本文算法對該輸入樣本的預(yù)測結(jié)果。經(jīng)過充分的訓(xùn)練,可以得到在老式裝甲車輛圖像分類任務(wù)中表現(xiàn)良好的網(wǎng)絡(luò)M1。

對于使用老式裝甲車輛圖像進(jìn)行預(yù)訓(xùn)練的神經(jīng)網(wǎng)絡(luò)M1來說,其獲得的部分領(lǐng)域知識可以用于新裝備裝甲車輛的圖像分類任務(wù)。具體而言,盡管老式裝甲車輛和新裝備的裝甲車輛的全局結(jié)構(gòu)往往存在一定的不同,但它們的一些局部特征是相似的,如日本90式坦克和德國豹2AV坦克的整體外形有一定的不同,但它們的炮塔外形較為相似。因此,訓(xùn)練完成的M1網(wǎng)絡(luò)可以為數(shù)據(jù)量不足的新裝備裝甲車輛分類任務(wù)提供局部特征方面的參考信息。

為了更好地保留在老式裝甲車輛數(shù)據(jù)集上獲取的局部特征知識,同時讓模型更好地適應(yīng)新裝備裝甲車輛分類任務(wù),本文使用遷移學(xué)習(xí)中的特征提取技術(shù)。對新裝備裝甲車輛進(jìn)行分類時,替換網(wǎng)絡(luò)模型M1的最后一個全連接層,保留M1網(wǎng)絡(luò)的其他全部參數(shù)。再使用有限的新裝備裝甲車輛的真實(shí)圖像數(shù)據(jù)訓(xùn)練,并更新最后一層的所有新參數(shù),其余參數(shù)保持不變,得到網(wǎng)絡(luò)模型M3。M3網(wǎng)絡(luò)將在新裝備裝甲車輛的分類任務(wù)中主要負(fù)責(zé)局部特征的提取與學(xué)習(xí)。

1.2 全局結(jié)構(gòu)提取器

為了進(jìn)一步緩解訓(xùn)練數(shù)據(jù)不足的問題,本文還考慮利用與新裝備裝甲車輛真實(shí)圖像總體結(jié)構(gòu)極為相似的虛擬圖像預(yù)訓(xùn)練一個神經(jīng)網(wǎng)絡(luò)模型M2。由于虛擬3D模型的精確度有限,獲取的虛擬圖像細(xì)節(jié)往往不夠細(xì)膩,局部紋理細(xì)節(jié)等特征與實(shí)物相似度很低。綜上考慮,基于較低質(zhì)量虛擬圖像訓(xùn)練的網(wǎng)絡(luò)模型M2可以被用作最終模型的全局結(jié)構(gòu)提取器。

由于車輛的全局架構(gòu)由模型全部參數(shù)表征,為進(jìn)一步提升全局結(jié)構(gòu)的表征準(zhǔn)確度,本文采用遷移學(xué)習(xí)中的微調(diào)技術(shù),保持模型總體架構(gòu)不變,利用新裝備裝甲車輛的真實(shí)圖像來細(xì)微調(diào)整網(wǎng)絡(luò)模型M2的所有參數(shù),得到網(wǎng)絡(luò)模型M4。與M3網(wǎng)絡(luò)中的特征提取模塊中參數(shù)保持不變的策略不同,M4網(wǎng)絡(luò)的卷積層是以相對較小的學(xué)習(xí)速率小幅度微調(diào)的,以使從虛擬圖像中學(xué)到的知識適應(yīng)真實(shí)圖像。

為了取得更好的微調(diào)效果,M4網(wǎng)絡(luò)的不同模塊使用了不同的學(xué)習(xí)率。其中,隨機(jī)初始化的全連接層中參數(shù)的學(xué)習(xí)率較大,以加快全連接層對新裝備裝甲車輛的學(xué)習(xí)進(jìn)程,而預(yù)訓(xùn)練的卷積層則用較小的學(xué)習(xí)率更新參數(shù),這種操作可以盡快彌補(bǔ)分類器模塊和特征提取模塊之間的學(xué)習(xí)不平衡。

1.3 模型集成機(jī)制

對M3和M4網(wǎng)絡(luò)模型的輸出進(jìn)行加權(quán)求和,可得到輸入圖像的最終分類結(jié)果。最終模型對全局結(jié)構(gòu)信息的理解主要來自M4網(wǎng)絡(luò),而細(xì)節(jié)的局部特征則由M3網(wǎng)絡(luò)提取。為達(dá)到這一目的,兩個模型的輸出O3和O4被加權(quán)為

Ot=α·O3+(1-α)·O4

(2)

式中:Ot是算法的最終輸出。通過本文設(shè)計(jì)的基于Optuna算法的超參數(shù)優(yōu)化框架,在訓(xùn)練迭代過程中,算法自動對集成模型加權(quán)權(quán)重α進(jìn)行調(diào)整,分配模型輸出中全局特征和局部特征所占權(quán)重。最終,通過整合這兩個模型,本文的方法可以更好地兼顧局部特征和全局特征。

1.4 超參數(shù)優(yōu)化框架

此外,本文使用Optuna算法[33]迭代訓(xùn)練來獲得最佳的超參數(shù)。根據(jù)每批樣本的分類結(jié)果和對應(yīng)標(biāo)簽計(jì)算分類準(zhǔn)確率,然后輸入Optuna算法,計(jì)算出當(dāng)前情況下更適合整個算法的超參數(shù),包括不同卷積模塊和全連接模塊的學(xué)習(xí)率,模型集成機(jī)制的模型權(quán)重超參數(shù)α。網(wǎng)絡(luò)使用新的超參數(shù)繼續(xù)學(xué)習(xí)和更新模型內(nèi)的參數(shù),以獲得更好的分類結(jié)果。

以模型權(quán)重超參數(shù)α為例,本文利用Optuna算法動態(tài)地構(gòu)建α的搜索空間,令α落在0和1之間,并根據(jù)模型在驗(yàn)證集上的性能變化動態(tài)地調(diào)整α。由于Optuna算法的高效搜索和修剪功能,參數(shù)調(diào)整的時間大大減少,因此本文算法的訓(xùn)練難度有所降低,且最終性能得到了小幅提升。

1.5 模型實(shí)現(xiàn)細(xì)節(jié)

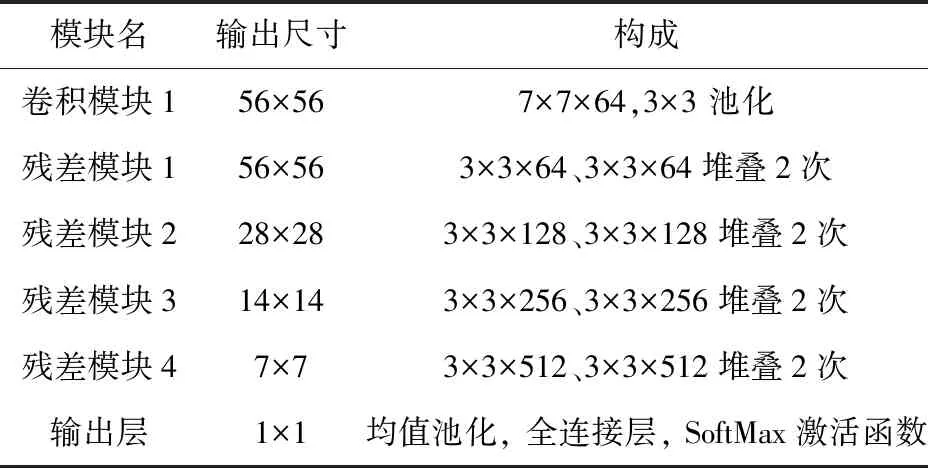

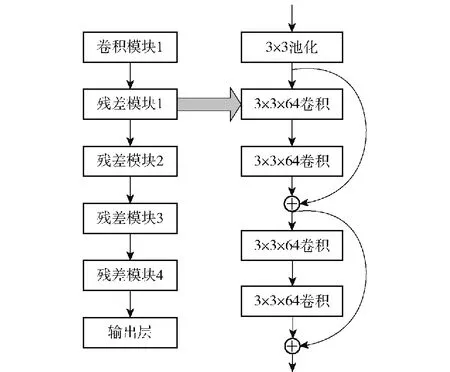

本文中負(fù)責(zé)局部和全局特征學(xué)習(xí)的兩個模型均使用ResNet-18網(wǎng)絡(luò)[34]作為主干網(wǎng)絡(luò)。在圖像分類和識別領(lǐng)域,ResNet-18網(wǎng)絡(luò)中的卷積層能夠提取任務(wù)所需的大量特征。目前深度學(xué)習(xí)領(lǐng)域遇到的一大困難是:為了更好的特征提取能力,神經(jīng)網(wǎng)絡(luò)正變得越來越深,但更深的神經(jīng)網(wǎng)絡(luò)訓(xùn)練起來往往更加困難[35],而在ResNet網(wǎng)絡(luò)中使用的殘差學(xué)習(xí)理念可以在增加網(wǎng)絡(luò)層數(shù)的情況下大幅度減輕訓(xùn)練深度網(wǎng)絡(luò)的負(fù)擔(dān)。圖2中展示了算法使用的ResNet-18網(wǎng)絡(luò),其由1個卷積模塊、4種殘差模塊和1個輸出層組成。卷積模塊由1個卷積層和池化層組成。之后,構(gòu)建的是由卷積層和捷徑連接組成4種類型的殘差模塊。每個殘差模塊由重復(fù)堆疊兩次的殘差塊組成,即兩個相同組成的殘差塊依次連接組成一個殘差模塊,每個殘差塊由兩個3×3的卷積層組成,每個殘差塊的頭和尾都構(gòu)建一個shortcut,其有助于深層和淺層特征的融合以及在訓(xùn)練過程中便于殘差的向上傳播。最后的輸出層則由池化層和全連接層組成。模型的輸入維度是224×224×3。模型中卷積模塊和4種殘差模塊對應(yīng)的卷積核數(shù)量分別是64、64、128、256和512,卷積步長分別為1像素、1像素、2像素、2像素和2像素。卷積模塊中卷積核的大小是7×7,4種殘差模塊的卷積核大小則均為 3×3。卷積模塊和殘差模塊卷積核的填充大小都是1像素。圖2的左側(cè)是ResNet網(wǎng)絡(luò)的整體結(jié)構(gòu),其中層的名稱與表1中的名稱相對應(yīng)。圖2的右側(cè)是ResNet網(wǎng)絡(luò)中一個殘差模塊的詳細(xì)結(jié)構(gòu)。

表1 ResNet-18網(wǎng)絡(luò)結(jié)構(gòu)

圖2 ResNet-18網(wǎng)絡(luò)結(jié)構(gòu)的示意圖

ResNet-18網(wǎng)絡(luò)中的所有卷積層的激活函數(shù)都是修正線性單元(ReLU),最后一個全連接層的激活函數(shù)是SoftMax。使用ReLU的主要原因是其單邊抑制特性使得只有一小部分神經(jīng)元處于活躍狀態(tài),可以有效地緩解梯度分散問題,并顯著加快網(wǎng)絡(luò)的收斂過程。

本文通過最小化損失函數(shù)的值來進(jìn)行參數(shù)優(yōu)化。此外,選擇的參數(shù)優(yōu)化器為自適應(yīng)矩(Adam)估計(jì)。為了更快地收斂到最優(yōu)解并減少訓(xùn)練時間,本文還引入了指數(shù)衰減的學(xué)習(xí)率更新方法,即在訓(xùn)練的初始階段設(shè)置了一個較大的學(xué)習(xí)率。然后再以指數(shù)衰減的方式逐漸降低學(xué)習(xí)率,以避免在學(xué)習(xí)的后期階段由于學(xué)習(xí)率較大導(dǎo)致劇烈振蕩。指數(shù)式學(xué)習(xí)率衰減的更新方式為

LR=LR0-DCSC/SD

(3)

式中:LR表示指數(shù)衰減計(jì)算后當(dāng)前訓(xùn)練輪次應(yīng)使用的學(xué)習(xí)率;LR0是起始階段的初始學(xué)習(xí)率;DC是指數(shù)衰減的系數(shù);SC指的是當(dāng)前的訓(xùn)練輪次;SD指的是指數(shù)衰減的步長,學(xué)習(xí)率在每SD個訓(xùn)練輪次后衰減一次。

2 實(shí)驗(yàn)結(jié)果和分析

2.1 數(shù)據(jù)集的構(gòu)建

D2中新裝備的5類裝甲車輛是99A式(Type 99A)主戰(zhàn)坦克、挑戰(zhàn)者II型主戰(zhàn)坦克、豹2A7主戰(zhàn)坦克、勒克萊爾主戰(zhàn)坦克和T-14主戰(zhàn)坦克。這5類坦克分類難度較高,因?yàn)樗鼈冾愰g的相似度很高,并且訓(xùn)練數(shù)據(jù)有限。此外,本文構(gòu)建的數(shù)據(jù)集D1選擇了裝備量大、累計(jì)服役時間久、數(shù)據(jù)容易獲取的5類老式坦克,包括59式中型坦克、日本74式主戰(zhàn)坦克、M60主戰(zhàn)坦克、酋長主戰(zhàn)坦克和T-72 主戰(zhàn)坦克。

老式坦克圖像的類間相似度比新裝備裝甲車輛圖像低,這是因?yàn)槔鲜教箍说耐庥^設(shè)計(jì)往往要對特定的設(shè)定妥協(xié),例如KV-2重型坦克為了更高穿深搭載的152 mm榴彈炮,導(dǎo)致炮塔外觀辨識度很高。正是由于老式坦克的這些個性化的設(shè)計(jì),使得這些老式坦克在分類任務(wù)中更加容易區(qū)分。而坦克設(shè)計(jì)技術(shù)經(jīng)過一個多世紀(jì)的發(fā)展,性能優(yōu)秀的坦克設(shè)計(jì)已經(jīng)趨同,其外觀設(shè)計(jì)的考慮更加全面。因此,新式坦克的類間相似度比老式坦克的類間相似度要大很多,從而導(dǎo)致最終的新裝備裝甲車輛圖像分類任務(wù)難度較高。

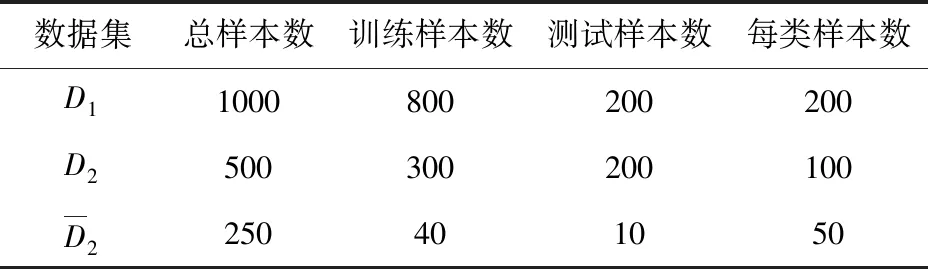

表2 數(shù)據(jù)集的介紹

圖3 數(shù)據(jù)集類別組成

在完成數(shù)據(jù)樣本的收集后,對所有樣本進(jìn)行 3個步驟的預(yù)處理:

1)統(tǒng)一圖像大小。使用OpenCV將圖像的長邊按原始比例縮放到224像素,然后將短邊用灰色像素填充到224像素,使得每張圖像大小統(tǒng)一為 224像素×224像素。

2)建立索引。用一個獨(dú)熱向量來標(biāo)記3個數(shù)據(jù)集中的每個樣本,然后用一個CSV文件來記錄圖像的索引和相應(yīng)的類別標(biāo)簽。這個文件將在隨后的訓(xùn)練和測試步驟中被讀取使用。

2.2 運(yùn)行環(huán)境

本文的實(shí)驗(yàn)是在一臺配備英特爾酷睿i9-11900k(3.5 GHz)、128 GB內(nèi)存和Nvidia GeForce RTX 3090(24 GB顯存)的工作站上運(yùn)行的。實(shí)驗(yàn)使用PyTorch框架來構(gòu)建神經(jīng)網(wǎng)絡(luò)并使用GPU來加速這些模型的訓(xùn)練和測試。考慮到訓(xùn)練成本,模型訓(xùn)練和測試的樣本批量大小被設(shè)定為50。驗(yàn)證和記錄結(jié)果的時間間隔被設(shè)置為1個訓(xùn)練輪次。

2.3 實(shí)驗(yàn)結(jié)果

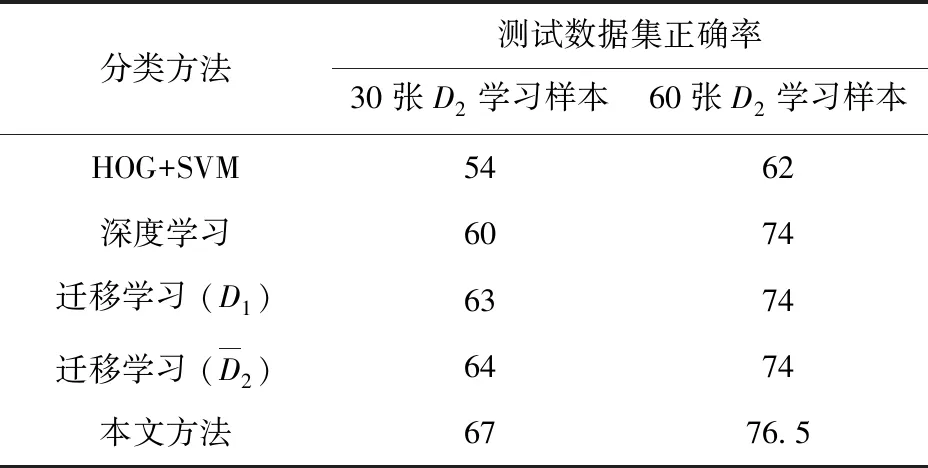

表3 實(shí)驗(yàn)結(jié)果

在最終的新裝備裝甲車輛分類任務(wù)中,本文提出的集成遷移學(xué)習(xí)方法在D2的每個類別只用30個訓(xùn)練樣本的條件下,取得了67%的分類準(zhǔn)確率,高于同一神經(jīng)網(wǎng)絡(luò)隨機(jī)初始化并訓(xùn)練的60%準(zhǔn)確率。在使用D2中的每個類別60個訓(xùn)練樣本的情況下,本文方法的結(jié)果也比其他對比方法好。此外,在D1和D2上,深度學(xué)習(xí)方法(ResNet網(wǎng)絡(luò))的準(zhǔn)確率都比傳統(tǒng)方法(HOG+SVM)高。在其他實(shí)驗(yàn)條件保持一致的情況下,對比從頭訓(xùn)練的深度學(xué)習(xí)方法,本文方法的最終準(zhǔn)確率分別高7%(30個學(xué)習(xí)樣本)和2.5%(60個學(xué)習(xí)樣本),這說明本文方法在訓(xùn)練數(shù)據(jù)越缺乏的情況下優(yōu)勢越明顯。

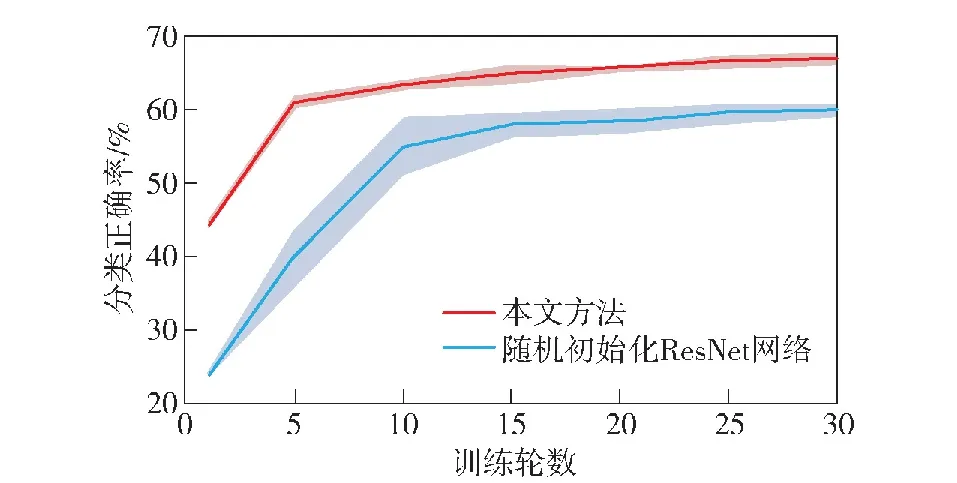

2.3.1 遷移學(xué)習(xí)對模型性能的影響

在表3中,除了傳統(tǒng)方法(HOG+SVM)外,所有模型的訓(xùn)練次數(shù)都是一樣的,都是30訓(xùn)練輪次。在訓(xùn)練的早期階段,遷移學(xué)習(xí)方法的損失函數(shù)值比隨機(jī)初始化訓(xùn)練ResNet網(wǎng)絡(luò)的損失下降得快。另外,在圖4中,本文選擇了1、5、10、15、20、25、30 七個采樣點(diǎn),重復(fù)5次實(shí)驗(yàn)記錄了對應(yīng)訓(xùn)練輪次的分類準(zhǔn)確率。圖4中深色的實(shí)線代表該種方法分類準(zhǔn)確率的平均值,淺色的陰影代表5次實(shí)驗(yàn)準(zhǔn)確率的標(biāo)準(zhǔn)差,淺色陰影的范圍展示了模型分類能力的波動程度。從圖4的對比中不難看出,本文方法的分類結(jié)果遠(yuǎn)遠(yuǎn)好于隨機(jī)初始化訓(xùn)練ResNet網(wǎng)絡(luò)的結(jié)果,特別是在訓(xùn)練的初始階段。以上兩點(diǎn)都表明,遷移學(xué)習(xí)在一定程度上使網(wǎng)絡(luò)收斂得更快。同時,在大多數(shù)訓(xùn)練情況下,本文方法分類結(jié)果的標(biāo)準(zhǔn)差總是優(yōu)于隨機(jī)初始化訓(xùn)練神經(jīng)網(wǎng)絡(luò)。這意味著本文方法的分類準(zhǔn)確率波動較小,算法的穩(wěn)定性更好。從表3中不難看出,在最好的情況下,使用本文提出的集成遷移學(xué)習(xí)算法的最終分類結(jié)果比隨機(jī)初始化訓(xùn)練網(wǎng)絡(luò)好7%。此外,不管有多少訓(xùn)練樣本,所有使用遷移學(xué)習(xí)的實(shí)驗(yàn)結(jié)果都不會比隨機(jī)初始化訓(xùn)練神經(jīng)網(wǎng)絡(luò)的結(jié)果差。綜上,本文提出的方法在新裝備裝甲車輛的圖像分類任務(wù)中不僅加快了模型的收斂速度,而且還提高了分類性能。

圖4 兩種方法的分類準(zhǔn)確率均值和標(biāo)準(zhǔn)差示意圖

2.3.2 模型集成機(jī)制對模型性能的影響

本文提出的方法中引入了一種模型集成機(jī)制,該機(jī)制整合了兩個遷移學(xué)習(xí)模型以獲得不同層次的信息。在這兩個被集成的模型中,局部特征提取器可以從輸入數(shù)據(jù)中獲得局部紋理信息,而全局結(jié)構(gòu)提取器可以從輸入數(shù)據(jù)中獲得全局信息。

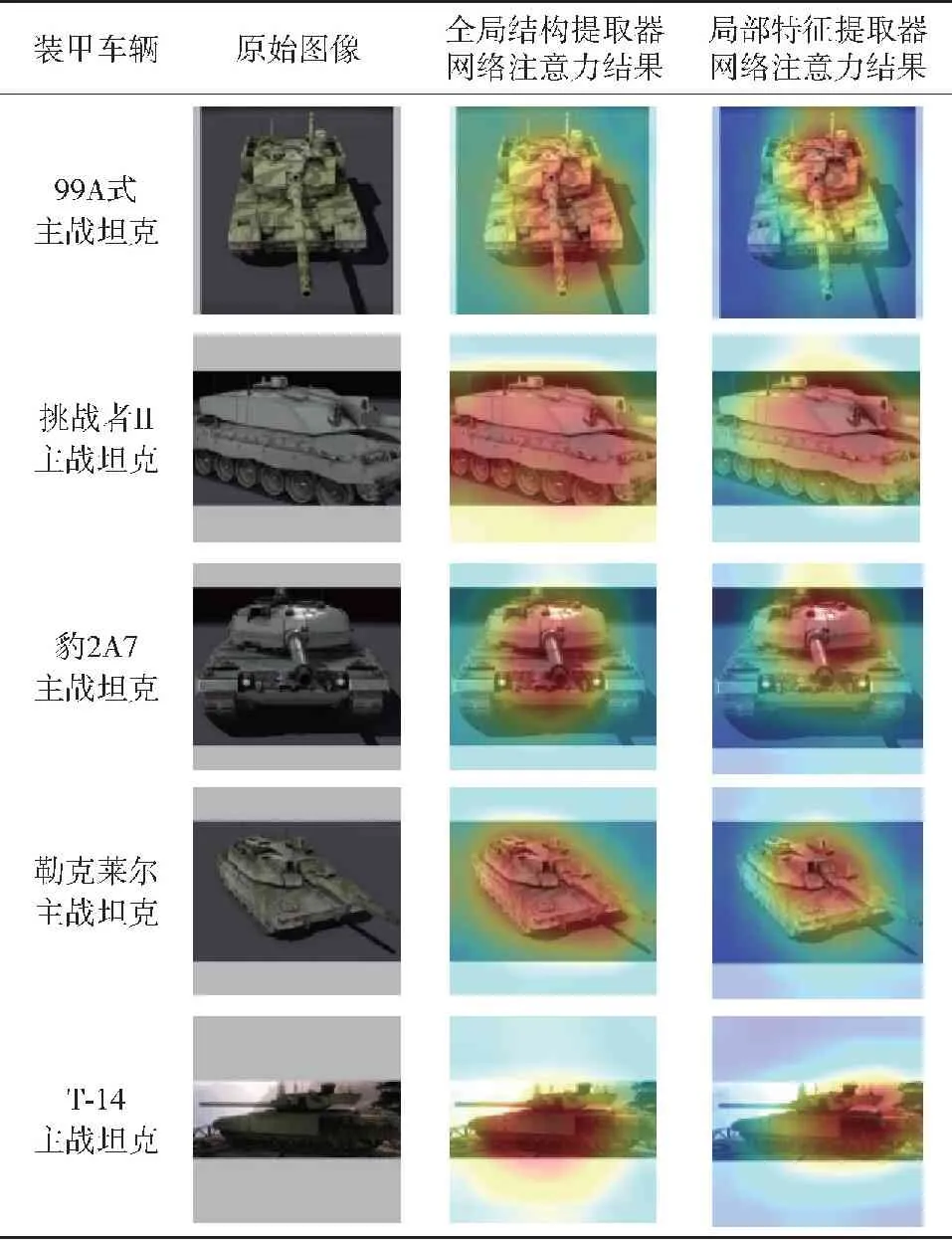

本文使用CAM來可視化網(wǎng)絡(luò)注意力,其可更直觀地說明局部特征提取器和全局結(jié)構(gòu)提取器之間的區(qū)別。CAM可以通過跟蹤模型的輸出概率并將其反饋到模型的最后一層卷積層中來生成圖像樣本的熱力圖。在生成的熱力圖中,暖色調(diào)到冷色調(diào)的轉(zhuǎn)變代表了溫度從高到低的轉(zhuǎn)變,高溫(用紅色標(biāo)記)表示圖像樣本的該區(qū)域與當(dāng)前的輸出更相關(guān),即該部分對模型的分類結(jié)果影響程度更大。在表4中展示了本文方法中的全局結(jié)構(gòu)提取器和局部特征提取器之間的網(wǎng)絡(luò)注意力的差異。表4中樣本都是從新裝備坦克的測試圖像中隨機(jī)抽取,對于每個樣本,從左到右分別列出其標(biāo)簽、原始圖像以及全局結(jié)構(gòu)提取器和局部特征提取器的網(wǎng)絡(luò)注意力結(jié)果。表4結(jié)果證實(shí)了本文提出的集成模型中局部特征提取器更關(guān)注局部紋理信息,而全局結(jié)構(gòu)提取器更關(guān)注全局信息的觀點(diǎn)。因此,通過整合這兩個模型,本文方法可以更好地理解局部紋理和全局結(jié)構(gòu)特征。

表4 全局結(jié)構(gòu)提取器和局部特征提取器網(wǎng)絡(luò)注意力結(jié)果

3 結(jié)論

本文提出一種集成遷移學(xué)習(xí)方法用于新裝備裝甲車輛的分類任務(wù)。利用從不同數(shù)據(jù)集中學(xué)習(xí)到的相關(guān)領(lǐng)域知識,緩解目標(biāo)任務(wù)中缺乏訓(xùn)練樣本的問題。得出以下主要結(jié)論:

1)所提方法的模型集成機(jī)制能夠通過超參數(shù)優(yōu)化框架自動調(diào)整參數(shù),來更好地理解輸入數(shù)據(jù)的局部紋理特征和全局結(jié)構(gòu)特征,提高最終分類準(zhǔn)確率。

2)所提方法的遷移學(xué)習(xí)機(jī)制不僅可以加快模型的收斂速度,而且還提高了算法穩(wěn)定性。最終,所提出的集成遷移學(xué)習(xí)方法的分類表現(xiàn)優(yōu)于對比方法,這在一定程度上證明本文方法在實(shí)踐中是有使用前景的。未來,將利用遷移學(xué)習(xí)方法對更多戰(zhàn)場目標(biāo)的圖像分類和跟蹤任務(wù)進(jìn)行進(jìn)一步的研究。