基于誤差回傳機制的多尺度去霧網絡

楊愛萍 李曉曉 張騰飛 王朝臣 王 建

在霧天采集到的圖像會出現對比度降低、顏色退化、細節丟失等問題,嚴重影響目標檢測、自動駕駛、視頻監控和遙感等戶外計算機視覺系統的性能.因此,霧天圖像復原具有重要的研究意義.

隨著圖像去霧方法不斷發展,可將現有方法分為基于圖像增強的方法、基于圖像復原的方法和基于深度學習的方法.基于圖像增強的去霧方法不考慮霧天圖像退化機理,僅僅是從空域或頻域對圖像進行處理,來增強圖像的對比度或對圖像進行顏色校正.常見方法有直方圖均衡化[1]、Retinex 算法[2]、同態濾波[3]算法等.以上方法均未考慮圖像退化原因,直接對有霧圖進行處理,會出現顏色失真、去霧不徹底等問題.

基于圖像復原的方法以大氣散射模型為基礎,把圖像去霧轉化為估計模型參數.He 等[4]提出暗通道先驗理論,能實現簡單、快速去霧;Tarel 等[5]借助中值濾波估計透射率,并通過大氣散射模型得到去霧圖像.Zhu 等[6]提出顏色衰減先驗理論,學習線性函數來預測有霧圖像的深度.Berman 等[7]提出一種非局部先驗去霧方法.張小剛等[8]結合雙區域濾波和圖像融合提出一種去霧算法,可有效減少暈輪效應.汪云飛等[9]借助超像素分割提高了透射率估計精度.該類方法雖然取得了一定的效果,但在先驗假設不成立的情況下,難以準確恢復無霧圖像.

基于深度學習的方法通過在大規模數據集上訓練卷積神經網絡(Convolutional neural networks,CNN)來估計無霧圖像.Cai 等[10]和Ren 等[11]構建CNN 估計透射率,并代入成像模型得到復原圖像.但其將大氣光設置為全局常量,去霧后的圖像易出現偽影和顏色失真等問題.Zhang 等[12]構建一種密集連接金字塔網絡,可同時估計透射率和大氣光值.Li 等[13]將透射率和大氣光組合為一個變量K,構建一種輕量級網絡AODNet 估計K.上述方法均基于物理模型構建CNN 估計變量,這在一定程度上會限制網絡的學習能力.Chen 等[14]在引入平滑擴張卷積的基礎上,提出了一種端到端的門控上/下文聚合網絡,可融合不同層次的特征.Liu 等[15]構建了一種基于注意力機制的多尺度網格網絡,該網絡采用并行多尺度機制,解決了串行多尺度網絡中普遍存在的誤差傳遞問題,但該網絡忽略了非相鄰尺度之間的聯系.Dong 等[16]基于大氣散射模型設計了一種特征去霧單元,但物理模型的限制仍會在一定程度上削弱網絡的學習能力.Yang 等[17]通過聚合多尺度特征圖來重建無霧圖像,但該網絡結構較簡單且需對原圖進行多次下采樣,易造成圖像細節丟失.此類端到端方法可以不受物理模型的限制,直接學習有霧-無霧圖像之間的映射關系,但仍存在感受野有限、結構信息丟失等問題,網絡聚合不同尺度特征信息的能力有待加強.

為了增大網絡感受野以充分提取圖像空間上/下文信息,進而實現對目標圖像更精準的預測,多尺度端到端網絡得到了廣泛應用.但現有多尺度去霧網絡往往忽略了子網絡感受野大小不同導致的特征信息差異,直接將低分辨率特征與高分辨率特征進行融合.Liu 等[15]采用一種注意力機制,將各級子網絡特征圖由低分辨率子網絡向高分辨率子網絡進行逐級相加.Deng 等[18]將相鄰子網絡生成的特征圖直接相加,再輸入到基礎模塊進行融合.可以發現,該類方法直接合并各級特征圖后,小尺度網絡提取到的信息在融合特征中的占比減小,削弱了小尺度網絡感受野較大的優勢,造成圖像結構信息丟失,無法準確識別較大特征目標,出現去霧不徹底和顏色失真現象.

基于此,本文提出一種基于誤差回傳機制的多尺度去霧網絡.首先,為了提高網絡識別大尺度特征目標的準確性,設計誤差回傳模塊(Error-backward block,EB)生成包含豐富結構信息和上/下文信息的誤差圖,并用其指導大尺度子網絡訓練,增大結構信息在合并特征中的占比.現有直接融合策略和本文基于誤差回傳策略的多尺度網絡結構如圖1 所示.可以看出,誤差回傳模塊通過生成誤差圖,實現各子網絡之間的交互.同時,考慮到真實有霧圖像霧氣分布不均勻等特點,本文設計一種霧霾感知單元(Haze aware unit,HAU),將密集殘差塊與霧濃度自適應檢測塊(Haze density adaptive detection block,HDADB)相結合,可識別濃霧區域和薄霧區域并據此調整去霧強度,實現自適應去霧.另外,為了靈活高效復用各子網絡特征,使用門控融合模塊(Gated fusion module,GFM)抑制噪聲干擾,這也是首次嘗試將門控網絡用于多尺度去霧特征圖融合.

圖1 直接融合策略和誤差回傳策略示意圖Fig.1 Illustration of direct-integration strategy and error-backward strategy for multi-scale network

1 本文方法

本文提出的基于誤差回傳機制的多尺度去霧網絡結構如圖2 所示.網絡包括誤差回傳多尺度去霧組(Error-backward multi-scale dehazing group,EMDG)、GFM 和優化模塊.EMDG 共有3 個不同尺度的子網絡,各子網絡以HAU 為核心,并設計EB 實現各子網絡之間的交互;門控融合模塊用于融合所有子網絡的輸出;優化模塊采用Unet[19]結構,將初步去霧結果進一步優化.

圖2 基于誤差回傳機制的多尺度去霧網絡Fig.2 Architecture of multi-scale dehazing network based on error-backward mechanism

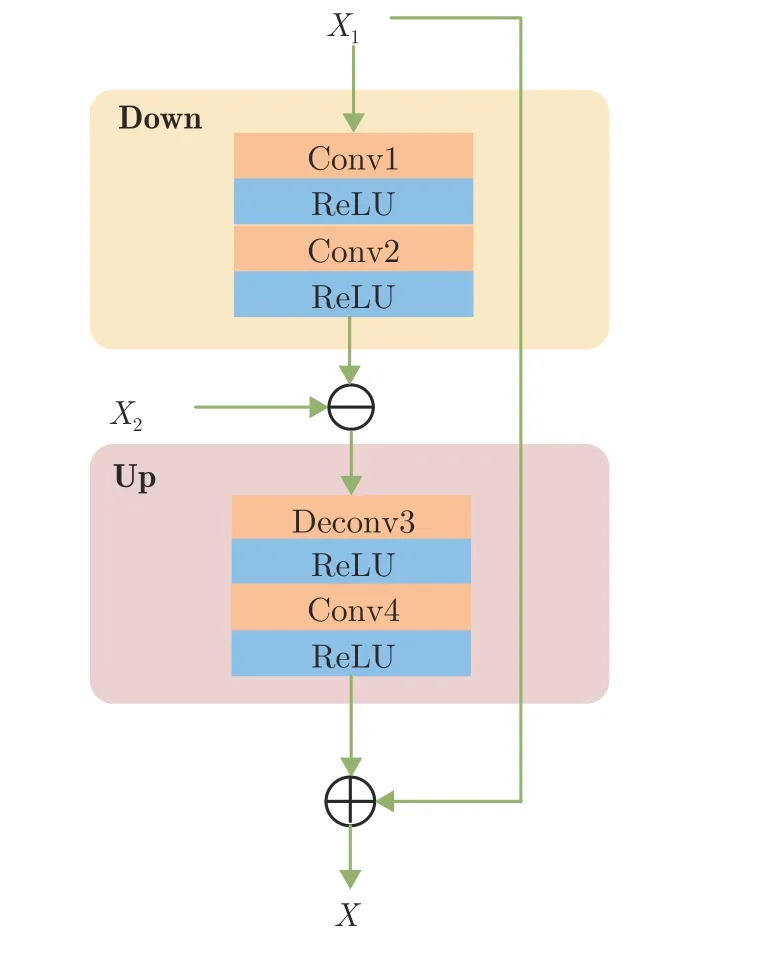

1.1 誤差回傳模塊

為了補充大尺度網絡缺失的結構信息和上/下文信息,本文設計了誤差回傳模塊,將小尺度網絡提取的信息回傳至大尺度網絡.如圖2 所示,各尺度子網絡均包含三個串聯的霧霾感知單元,除最小尺度子網絡外,所有霧霾感知單元的輸出都由EB進行修正.

EB 模塊具體結構如圖3 所示.首先計算高/低分辨率特征圖之間的差值生成誤差圖,并將誤差圖向上回傳,將之與高分辨率特征圖進行合并,實現對結構信息和空間上/下文信息的復用.另外,圖2網絡中每列霧霾感知單元工作的前提是其前一列單元均已完成特征提取任務,這在增加網絡深度的同時,也可避免小尺度網絡中間特征信息丟失.EB 模塊具體算法可表示為:

圖3 誤差回傳模塊結構Fig.3 Architecture of the error-backward block

式中,X1代表大尺度子網絡特征圖,X2代表小尺度子網絡特征圖,X2的大小是X1的1/2.如圖3 所示,D own 表示下采樣操作,由圖3 中的Conv1 和Conv2 完成對特征圖X1進行1/2 下采樣.計算Down(X1)與X2的差值并將其記作誤差圖,誤差圖中包含了大尺度子網絡中缺失的特征信息.隨后,使用 U p 對誤差圖上采樣,U p 由Deconv3 和Conv4組成,將 U p 輸出結果反饋給大尺度子網絡,指導大尺度子網絡訓練.X為修正后的輸出,此過程可實現對大尺度子網絡所缺失的結構信息進行及時補充.

1.2 霧霾感知單元

真實場景中霧氣分布通常是不均勻的,若能區分出濃霧和薄霧區域,便可實現高效靈活去霧.為此,本文設計一種霧霾感知單元,具體結構如圖4所示.HAU 由殘差密集塊(Residual dense block,RDB)和HDADB 組成.RDB 采用密集連接和殘差學習機制,能夠多次連接淺層和深層特征,充分提取圖像的細節特征和局部特征.HDADB 通過識別某區域的霧濃度大小并據此決定對該區域的去霧強度,可徹底地去除濃霧區域的霧氣,同時能夠有效避免對薄霧區域進行過度去霧.

圖4 霧霾感知單元結構Fig.4 The structure of the haze aware unit

1.2.1 殘差密集塊

殘差密集塊由5 個卷積層密集連接組成,具體結構如圖5 所示.密集連接機制可實現對淺層特征的多次復用,同時也利于加快網絡收斂.前4 個卷積層用來提取圖像中包含的大量信息,均采用3 ×3 的卷積核;最后一個卷積層用于改變特征圖的通道數,采用1 × 1 的卷積核,輸出通道數為16.所有卷積層步長均設置為1.

圖5 殘差密集塊結構Fig.5 The structure of the residual dense block

1.2.2 霧濃度自適應檢測塊

霧濃度自適應檢測塊包括霧濃度逐通道檢測和逐像素檢測,如圖6 所示.在模塊前端,逐通道檢測霧濃度分布.針對濃霧通道,增大其特征圖復用程度,對薄霧通道則減少其復用.具體運算過程如下:

圖6 霧濃度自適應檢測塊結構Fig.6 The structure of the haze density adaptive detection block

首先,輸入特征圖F0,使用Conv1 和Conv2 分別對其進行預處理,得到特征圖F1和F2:

式中,δ表示ReLU 激活函數層.隨后將特征圖F2大小由C×H ×W壓縮至C×1×1,并經過非線性處理,得到各通道權重圖WC:

式中,σ表示Sigmoid 激活函數層,GAP (Global average pooling)表示全局平均池化.

網絡訓練完成后,將各通道的權值與預處理后的F1逐元素相乘,得通道加權后的特征圖:

然后,在模塊后端進行逐像素霧濃度檢測,實現空域自適應去霧.首先,對特征圖FC進一步提取特征,得到:

最后,將尺寸為C×H ×W的特征圖F4在空間域上壓縮,其壓縮后可生成尺寸為 1×H ×W的權重圖WS:

網絡訓練的目標是使濃霧區域處的權重WS的值較大,薄霧區域處權重WS的值較小.使用WS對特征圖F4進行加權,可實現網絡對濃霧區域重點去霧,FS為霧濃度自適應檢測塊的最終輸出:

1.3 門控融合模塊

不同于現有的多尺度融合方法對有效信息和干擾信息無差別對待,本文設計的門控融合模塊融合了3 個不同尺度的子網絡得到輸出特征圖,可實現對有效信息的復用,減少冗余信息.

如圖2 所示,門控融合模塊通過學習各子網絡特征圖的最優權重,再對其進行加權融合,實現對干擾信息的過濾.將3 個子網絡特征圖從上到下分別記為J0、J1和J2.由于各尺度特征圖的尺寸不同,先利用上采樣模塊對J1和J2進行上采樣得J1↑和J2↑.上采樣模塊由一個步長為2 的轉置卷積層和一個步長為1 的卷積層組成,可將各尺度特征圖恢復至相同尺寸,并進一步提煉信息.然后,堆疊預處理后的特征圖,通過卷積操作逐像素判斷各特征圖中的干擾信息,學習對應于J0、J1↑和J2↑的權重圖W0、W1和W2.特征圖包含的有效信息越多,其權重圖的權值越大.多尺度特征門控融合運算可表示為:

1.4 損失函數

本文采用了平滑L1損失和感知損失[20].平滑L1損失可以計算網絡恢復的無霧圖像與清晰圖像之間的像素差值,其在零點附近使用了平方函數,解決了零點處導數不唯一的問題.平滑L1損失函數可表示為:

式中,G(I)表示網絡恢復的無霧圖像,J表示清晰圖像,x表示像素點位置,N表示像素個數,i=1,2,3分別表示R、G、B三通道.

特征圖中包含大量的語義特征和全局結構等高層信息.本文加載ImageNet[21]預訓練的VGG-16[22]網絡模型,從去霧圖像和清晰圖像中分別提取特征圖,將特征圖間的差值作為感知損失,借此量化去霧圖像與清晰圖像間的視覺誤差.感知損失函數LP可表示為:

式中,J為真實清晰圖像,G(I)為恢復的無霧圖像,φ為VGG-16 特征提取操作,j為VGG 網絡特征圖的索引標號,C、H和W分別為圖像的通道數、高度和寬度.

因此,總損失函數為:

式中,λ為權重系數,可以調節兩個損失函數所占的比例.

2 實驗與結果分析

2.1 數據集

本文分別在RESIDE 公共數據集[23]和NTIRE(New trends in image restoration and enhancement)2018 去霧挑戰賽提出的O-Haze 數據集[24]上訓練和測試網絡.

RESIDE 數據集包含大量的室內有霧圖像和室外有霧圖像,本文選用室內訓練集(Indoor training set,ITS)和室外訓練集(Outdoor training set,OTS).其中ITS 包含由1399 張室內清晰圖像合成的13990 張室內有霧圖像,OTS 包含由8477 張室外清晰圖像合成的296695 張室外有霧圖像.測試集選用SOTS (Synthetic objective testing set)測試集和HSTS (Hybird subjective testing set)合成測試集.其中SOTS 測試集包含500 張室內有霧圖像和500 張室外有霧圖像,HSTS 合成測試集包含10 張室外有霧圖像.

O-Haze 數據集共包含45 張室外有霧圖像及其對應的無霧圖像.根據NTIRE 2018 去霧挑戰賽的挑戰協議,本文選用35 張有霧圖像做訓練集,10 張有霧圖像做測試集.

為了更加客觀地評價本文所提網絡的去霧性能,本文在合成數據集上計算了恢復圖像與清晰圖像之間的峰值信噪比(Peak signal to noise ratio,PSNR)和結構相似性(Structural similarity,SSIM).

2.2 實驗設置

本文提出的去霧方法基于Pytorch 框架實現,在Win10 環境下使用NVIDIA 1080Ti GPU 加速網絡的訓練.從每張訓練圖像中隨機截取220×220像素的圖像塊,作為網絡的輸入.網絡采用動量衰減指數β1=0.9、β2=0.999 的適應性矩估計(Adaptive moment estimation,ADAM)優化器進行優化,初始學習率設置為0.001,在ITS 上訓練160 個訓練周期,每20 個訓練周期學習率減半;在OTS上訓練10 個訓練周期,每2 個訓練周期學習率減半;在O-Haze 上訓練100 個訓練周期,每10 個訓練周期學習率減半.訓練時的批量大小設置為8,損失函數LP的權重因子λ設置為0.04.

2.3 在合成數據集上實驗

為了驗證本文方法的去霧性能,與現有的優勢去霧算法進行實驗對比.將ITS 中包含的全體無霧-有霧圖像對用作室內訓練集,從OTS 中隨機選取2500張清晰圖像及其對應的有霧圖像作室外訓練集.隨后,采用SOTS 測試集包含的500 張室內有霧圖像和500 張室外有霧圖像對模型進行測試.

在SOTS 室內測試集上進行去霧評價,并與其他方法進行對比,結果如表1 所示.可以看出,相比于深度學習方法,傳統暗通道先驗(Dark channel prior,DCP)[4]方法去霧效果較差,PSNR 和SSIM值最小;DehazeNet[10]、AODNet[13]和基于多尺度卷積神經網絡(Multi-scale convolutional neural networks,MSCNN)[14]的去霧方法利用網絡估計去霧模型參數,其PSNR 和SSIM 較DCP 有小幅提升;增強型Pix2pix 去霧網絡(Enhanced Pix2pix dehazing network,EPDN)[25]、門控上/下文聚合網絡(Gated context aggregation network,GCANet)[14]、GridDehazeNet[15]、基于物理模型的特征去霧網絡(Physics-based feature dehazing networks,PFDN)[26]和多尺度增強去霧網絡(Multi-scale boosted dehazing network,MSBDN)[26]以及本文方法均為端到端去霧網絡,評價指標有了顯著提升;YNet[17]因為網絡過淺,不能充分提取圖像特征,所以表現并不突出.在SOTS 室外測試集上進行去霧評價,結果如表2 所示.在O-Haze 數據集上進行去霧評價,結果如表3 所示.由表1、表2 和表3 可以看出,相比于其他端到端網絡,本文提出的網絡在幾個測試集均取得了最高的PSNR 值和較高的SSIM 值.其中MSBDN 和GridDehazeNet 因網絡較深,對SOTS 測試集的擬合能力較強,其SSIM指標略高于本文網絡.但二者對空間上/下文信息的復用程度較低,導致其在實際去霧過程中無法準確估計大尺度特征,在真實場景下的去霧效果并不理想.

表1 SOTS 室內測試集去霧結果的定量比較Table 1 Qualitative comparisons of dehazing results on SOTS indoor test-set

表2 SOTS 室外測試集去霧結果的定量比較Table 2 Qualitative comparisons of dehazing results on SOTS outdoor test-set

表3 O-Haze 數據集去霧結果定量比較Table 3 Qualitative comparisons of dehazing results on O-Haze data-set

此外,本文從SOTS 室內測試集和室外測試集中,分別選取4 張有霧圖進行主觀質量評價,各方法去霧效果如圖7 所示.其中,上面4 行是室內圖像去霧結果,下面4 行是室外圖像去霧結果.由于DCP 方法利用暗通道先驗估計透射率,其去霧圖像整體顏色偏暗,尤其當圖像中存在大面積的天空區域或白色物體時,會出現偽影和顏色失真現象(如圖7(b)中的白色桌面和天空區域).經DehazeNet和AODNet 去霧后的圖像中,仍有大量霧氣殘留(如圖7(c)中的紅色墻壁和藍色天空),原因是所用網絡太淺,不能充分學習圖像特征.另外,GCANet 由于下采樣會丟失部分高頻信息(如圖7(e)的桌子紋理和物體邊緣),在藍色天空區域也會出現局部過暗的情況.與之相似,圖7(g)中物體邊緣和紋理出現模糊現象.GridDehazeNet 和本文網絡均可取得較好的去霧效果,但對比圖7(f)和圖7(h)可以發現,本文方法可以更好地保持圖像結構信息和細節信息.

表4 給出了本文算法與對比方法在HSTS 測試集上的比較結果.可以看出,DCP 去霧效果最差,依賴顏色投射的圖像去霧(Color cast dependent image dehazing,CCDID)[27]評價指標有一定提升,但并不顯著,本文算法取得最優PSNR 和SSIM 值.圖8 給出了HSTS 測試集中3 個有霧場景下各方法的去霧結果,其中,DCP、AODNet 和EPDN 產生較嚴重的顏色失真,DehazeNet 和YNet 去霧不夠徹底.相比之下,本文算法去霧結果更接近清晰圖像,具有更好的顏色保持能力,這是更加關注小尺度網絡提取的特征信息帶來的優勢.

表4 HSTS 測試集去霧結果的定量比較Table 4 Qualitative comparisons of dehazing results on HSTS test-set

圖8 HSTS 測試集上與現有方法去霧結果對比Fig.8 Comparisons of dehazing results with state-of-the-art methods on HSTS

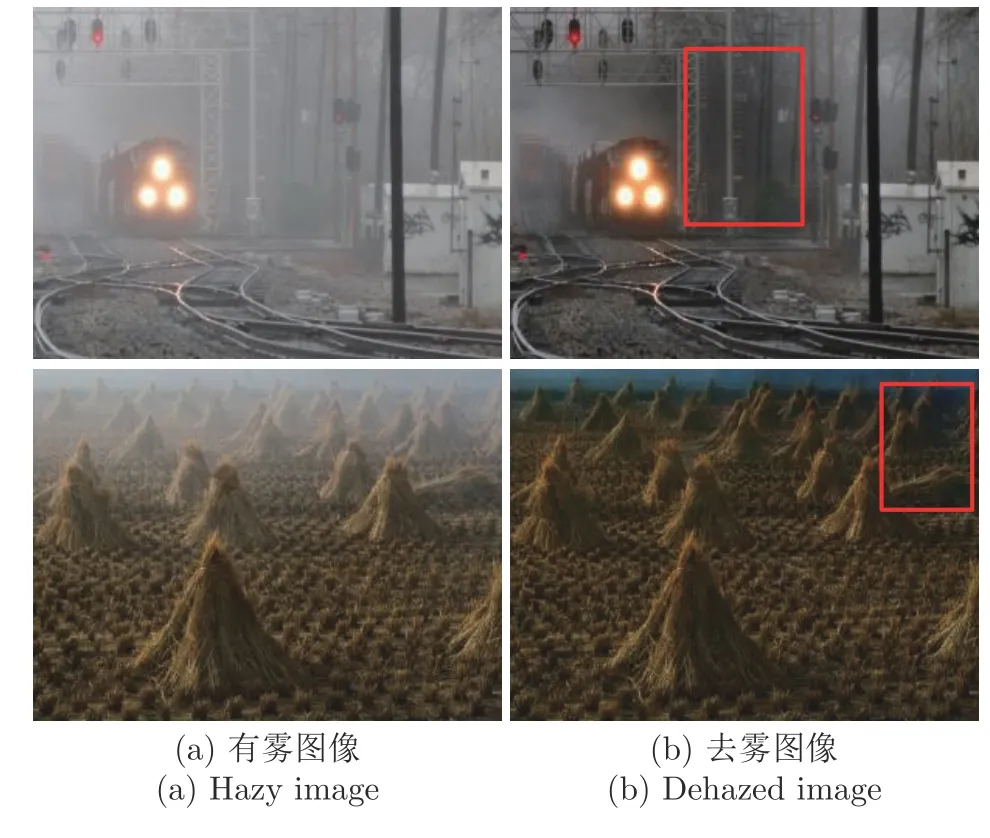

2.4 在真實數據集上實驗

為了驗證本文提出的網絡在真實場景下的適用性,在真實有霧圖像上,對網絡模型進行了測試.由于真實數據集沒有標簽圖像,本文挑選了4 幅真實有霧圖像進行主觀視覺評估,圖9 給出了本文方法與目前的幾種優勢算法的去霧結果.如圖9(b)所示,DCP 在處理包含大面積天空區域的圖像時,暗通道先驗失效,導致圖像顏色失真.如圖9(d)所示,AODNet 受物理模型的限制,易導致處理后的圖像飽和度過高,恢復圖像的顏色相比于原圖像過于鮮艷.同時,GCANet 在恢復一些真實有霧圖像的過程中,也會產生失真現象,例如圖9(e)中第2、3 幅圖像的藍色天空區域出現顏色失真以及第4 幅圖像遠景區域過亮等.相比于前幾種方法,DehazeNet能較好地保持原圖中物體的顏色,但其對遠景部分的去霧能力不足,如圖9(c)中的遠山區域仍有白色霧氣殘留.另外,放大圖9(f)的遠景區域(如圖9(f)第2 幅圖像的遠山部分和第4 幅圖像遠處的草地),可以看出,GridDehazeNet 處理后的圖像在遠景處出現一定的顏色失真.由圖9(g)可以看出,YNet 因連續下采樣操作,恢復出的無霧圖像部分高頻信息丟失(如圖9(g)第1 幅圖中的人臉五官不夠清晰).

圖9 與現有方法在真實有霧圖像上去霧結果對比Fig.9 Comparisons of dehazing results with state-of-the-art methods on real hazy images

由于采用了霧霾感知單元和誤差回傳機制,本文算法可有效保持原圖中豐富的結構信息和顏色信息,尤其是對遠景霧氣去除效果更佳.對比圖9 第4幅圖像的去霧結果,可以明顯看出,圖9(b)~圖9(g)所示算法均不能有效去除遠景霧氣,紅色方框內草地上方仍有大量霧霾殘留.本文算法(見圖9(h))可有效解決現有方法存在的遠景區域霧氣較難去除的問題,恢復圖像更為清晰自然.

2.5 消融實驗和分析

為了進一步驗證本文提出網絡結構的合理性和各模塊的必要性,針對網絡中的不同模塊,分別進行消融實驗.消融實驗主要考慮的因素有: 1)每個子網絡包含的RDB 模塊的總個數;2)是否使用GFM模塊對3 個子網絡的特征圖進行加權融合;3)是否使用誤差回傳機制,利用低分辨率子網絡改善高分辨率子網絡提取特征;4)是否使用霧濃度自適應檢測塊對RDB 提取的特征進行逐通道霧濃度測量和逐像素霧濃度測量.

為了分析上述各因素對網絡性能的影響,以向網絡中遞增添加各模塊的方式進行消融實驗.在ITS數據集上訓練不同配置的網絡(實驗設置與第2.2節設置相同),隨后在SOTS 室內測試集上測試模型.測試結果的PSNR 值如表5 所示,其中“√”表示包含對應該行的第1 列網絡模塊.表5 最后一行給出了采取不同配置時,網絡在SOTS 室內測試集上取得的PSNR 值.其中,右邊5 列分別對應5 種不同的網絡配置.A 列表示每個尺度子網絡僅包含5 個RDB 模塊,各個子網絡特征圖直接相加;B 列表示每個子網絡包含5 個RDB,但采用了門控融合方法融合各子網絡特征圖;C 列表示將每個子網絡包含的RDB 數量由5 個變為9 個;D 列表示在C 列配置的基礎上加入了誤差回傳模塊EB;E 列較前一列加入了本文霧濃度自適應檢測塊HDADB,此時網絡取得的PSNR 值最高,去霧性能最佳.

表5 基于不同模塊的網絡性能比較Table 5 Comparisons of network performance based on different modules

2.6 運行時間分析

為了評估本文方法的復雜性和計算效率,在包含500 張 620×460 像素圖像的SOTS 室內測試集上進行了實驗,比較了本文算法與其他主流算法的平均運行時間,統計結果如表6 所示.其中DCP、DehazeNet、MSCNN[14]方法在CPU 上實現,其他基于深度學習的方法在GPU 上實現.本文方法處理尺寸為 620×460 像素圖像大約需要0.73 s.結合表6 和前述實驗結果可以看出,本文方法較特征融合注意網絡(Feature fusion attention network,FFANet)[28]效率顯著提升,與GridDehazeNet 方法效率相當,但去霧性能有較大提升.

表6 各方法平均運行時間對比Table 6 Average computing time comparison of various methods

2.7 算法局限性分析

通過實驗可以看出,本文算法取得了較好的去霧效果.但本文網絡在處理亮度較低的圖像時,有一定概率會出現圖像部分區域色度偏暗的現象,具體情況如圖10 所示.今后,將針對這一問題,對網絡進行進一步改進.

圖10 部分區域色度偏暗的去霧圖Fig.10 Dehazed images with some darker areas

3 結束語

本文提出一種基于誤差回傳機制的多尺度去霧網絡,該網絡通過構造誤差回傳模塊,補充高分辨率特征圖缺失的結構信息和上/下文信息,同時設計霧霾感知單元,實現針對霧濃度的自適應去霧,并使用門控融合模塊,以避免干擾信息對圖像結構和細節的破壞,再經優化模塊,得到最終復原圖像.在合成有霧圖像和真實有霧圖像上的大量實驗結果表明,本文方法恢復的圖像更接近清晰圖像,解決了現有去霧方法易產生顏色失真和遠景去霧不徹底的問題.