基于輕量化融合損失網絡的單目深度估計

周潤民, 王曉紅, 王 輝, 蘇 靖, 劉 璐

(1 貴州大學 礦業學院, 貴陽 550025; 2 貴州大學 林學院,貴陽 550025)

0 引 言

場景深度感知是重建周圍環境的關鍵環節,包含了目標的三維結構信息,對于室內三維測圖、無人機避障和自動駕駛等研究領域都具有重要的意義[1]。

目前深度信息的獲取可以分為主動式和被動式。 主動式獲取方式有激光雷達、RGB-D 相機和3D 結構光等,均是通過反射物體表面來獲取深度信息,但通常設備價格昂貴、體積重及功耗高;被動式獲取是基于圖像序列,利用相機捕獲同一場景下單攝或者多攝目標的影像,通過三角測量方式獲取深度信息,拍攝時要求時間同步,通常拍攝設備體積較大,不適用于微型機器人平臺(例如微型航空和地面自動駕駛),因此研究成本低、體積小和能源效率高的單目相機進行場景深度感知具有重要的現實意義。 當前采用的編碼端模型臃腫、參數量大,如何得到輕量化且精準的圖像深度估計模型成為了關鍵性挑戰。

1 相關工作

傳統單目深度估計依靠手工提取特征,輸出的深度圖像比較模糊,而且場景中物體細節部分信息丟失,導致估計的圖像深度信息不理想。 隨著深度學習的發展,極大的促進了深度估計領域的發展。對于高精度的深度估計任務,文獻[2]提出將卷積神經網絡(Convolutional Neural Networks, CNN)用于預測單目圖像深度估計,設計了一個由粗到細的兩個堆棧組成的卷積神經網絡,粗尺度網絡預測圖像的全局深度,細尺度網絡提取局部深度并優化圖像的 局 部 細 節; 文 獻[3]將 連 續 條 件 隨 機 場(Conditional Random Field, CRF)和深度卷積神經網絡相結合,構建深度卷積神經場模型來提升深度估計效果;文獻[4]同樣采用雙尺度網絡模型進行深度估計,同時引入了感知損失使預測深度進一步提高;文獻[5]構建了一種基于殘差學習的全卷積網絡架構用于預測圖像的深度估計,該模型編碼器采用ResNet50 模型結構,該結構層次更深同時能夠提取更加豐富的特征信息,但是更深的網絡導致模型臃腫、參數量增加、計算復雜度高;文獻[6]構建了一種輕量金字塔解碼結構的單目深度估計模型,編碼器使用ResNet50 用于特征提取,解碼器將輕量金字塔解碼模塊提取到的不同感受野特征圖進行融合,并采用跳躍連接實現知識共享,以提升深度估計的性能。

近年來深度學習不斷發展,網絡模型結構的輕量化、高效越來越重要。 文獻[7]通過深度可分離卷積代替標準卷積,提出了一種輕量化的網絡模型MobileNet,網絡的運行速度有很大的提升,但該網絡模型結構簡單,沒有復用圖像特征進行特征融合,隨后提出了更加高效的網絡模型;文獻[8]構建了一種以MoblieNet 為基礎,適合在嵌入式系統上使用的模型,該模型的推理速度得到了進一步提升,但是由于解碼器采用的是傳統U-Net 結構上采樣,導致預測深度圖目標輪廓模糊、邊緣細節不夠銳利;文獻[9]提出了一種可以進行量化的單目深度估計模型,并完成對該模型的量化壓縮工作,該模型實現了網絡模型的輕量化,但是以犧牲深度估計的準確性為代價的。

本文構建一種基于輕量化融合損失網絡的模型結構,對預測結果在多個網絡上進行特征約束。 模型在編碼階段提取全局特征,解碼階段通過特征融合整合全局和局部特征信息,使得預測的深度圖具有很好的深度連續性,最后預測的深度圖通過損失網絡更好地懲罰預測信息和目標信息,進一步提高深度估計精度。

2 整體模型框架

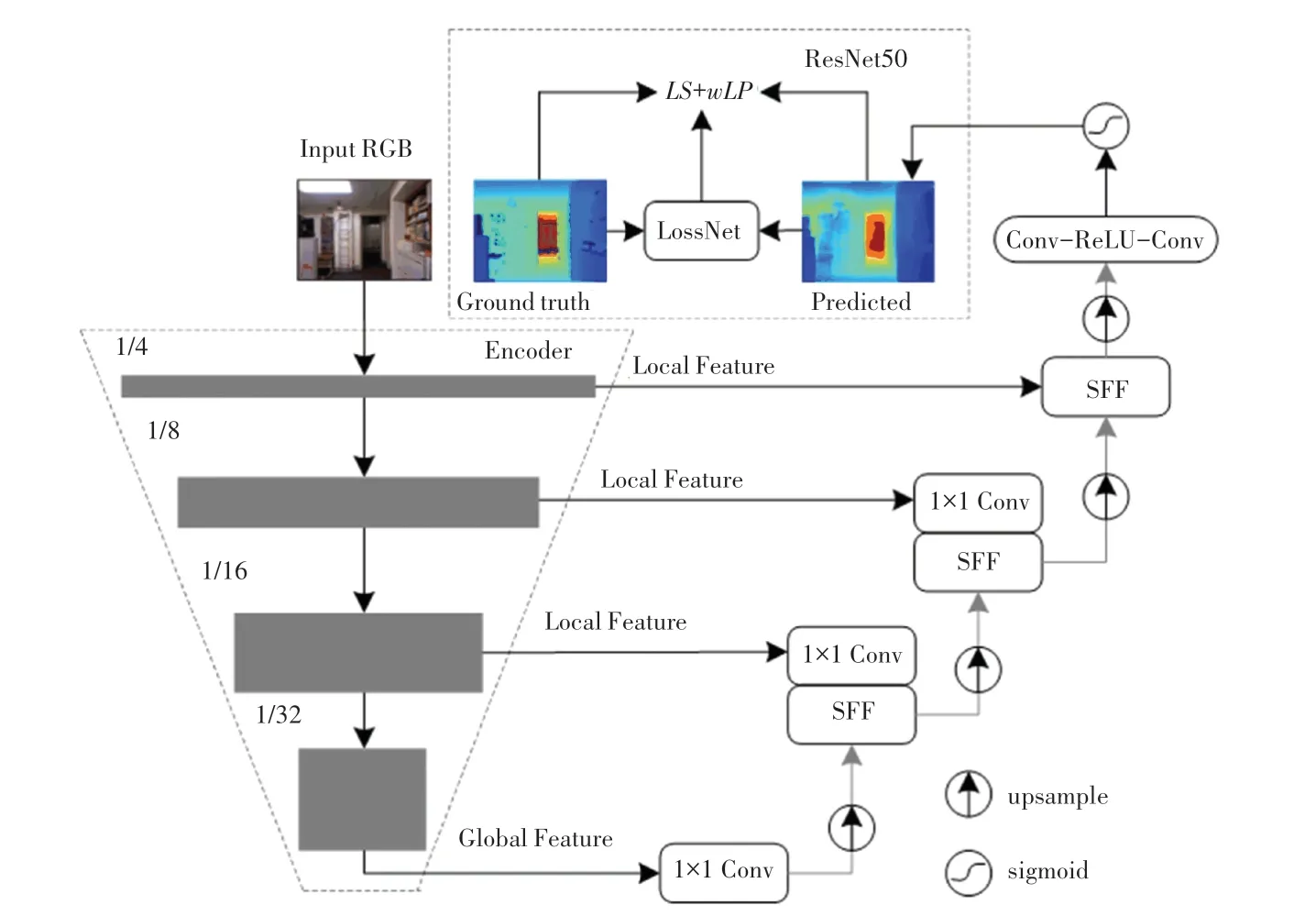

基于輕量化融合損失網絡的模型結構如圖1 所示。 在整體模型框架中,編碼器階段是圖像特征的提取階段,低維特征分辨率較高,包含豐富的特征信息,而高維特征分辨率較低,提取到的圖像特征更加抽象;解碼器階段是提取特征的恢復階段,將編碼器提取的高維特征與跨層共享的低維特征進行特征融合,生成清晰準確的特征預測圖;最后,預測深度傳遞到ResNet50 損失網絡進行融合感知。

圖1 基于輕量化融合損失網絡的模型結構Fig.1 Model structure based on lightweight fusion loss network

2.1 編碼器結構

在樣本數據較少的情況下,為獲得更高的準確率,通常會擴展深度學習模型的深度、寬度以及分辨率。 常規卷積神經網絡盡管可以任意調整其中的幾個維度,但是都需要手動調節參數,且很可能伴隨著模型性能和效率的下降。 EfficientNet 是一種結合神經網絡搜索技術的多維度混合放縮模型,在EfficientNet-B0 的基線上調整深度、寬度以及分辨率縮放獲得[10]。 式(1):

其中,α、β、γ為常數,是模型深度、寬度和分辨率的網絡搜索技術參數,縮放系數θ是模型的擴張量。

目前深度估計任務編碼器大部分采用ResNet 作為特征提取器,通過不斷加深網絡的深度以獲取更高的精度。 但隨著網絡的加深,模型變得十分龐大,計算效率低。 因此,從實際應用的角度,綜合考慮參數尺寸及模型復雜度,本文選擇EfficientNet-B2 模型并運用遷移學習加載預訓練模型,提高深度預測性能的同時加速網絡收斂,防止梯度彌散和梯度爆炸等問題。

2.2 解碼器結構

解碼器通過編碼器輸出的特征圖進行上采樣,并在空間維度上恢復特征映射,生成與輸入尺寸相同的深度圖。 傳統的解碼器采用卷積與插值的UNet 結構恢復深度圖,本文使用一種全新的解碼器結構SU-Net(Selective Feature Fusion-based UNet),主要包含選擇特征融合模塊(Selective Feature Fusion,SFF),相鄰SFF 模塊之間通過跳躍連接和雙線性插值上采樣恢復到對應尺度,其中1x1 卷積層使輸入值的通道維度減少,與編碼器對應的跳躍連接輸出值在通道維度上相等,然后經過兩個卷積層和一個Sigmoid 函數得到預測深度圖[11]。

SFF 模塊類似于空間注意力模塊如圖2 所示,將淺層局部特征、深層全局特征分別表示為f1∈RW×H×C1、f2∈RW×H×C2,空間位置集合R ={(x,y)|x =1,2,…,W;y =1,2,…,H},(x,y) 為空間特征的坐標信息。 為了獲取空間特征的注意力圖,將局部特征和全局特征在通道維度上進行特征拼接,將拼接特征通過三層3x3 卷積操作得到雙通道空間注意力圖,通過Sigmoid 函數運算將其映射至[0,1],然后將局部特征和全局特征分別與空間注意力通道矩陣相乘,得到專注于空間關系的有效特征,最后使兩種特征矩陣相加。 SFF 模塊生成的雙通道特征注意力圖能夠自適應地選擇和融合特征值,使網絡從局部和全局信息出發,選擇對網絡性能好的空間特征權重,抑制無效權重。 雙通道空間注意力特征和選擇特征融合模塊計算如式(2)和式(3)所示:

圖2 選擇特征融合模塊Fig.2 Feature selection and fusion module

其中,σ表示Sigmoid 激活函數;Conv為卷積層運算;MS(F) 表示雙通道注意力特征。

3 損失函數

損失函數是神經網絡優化中至關重要的一部分。 選擇合適的損失網絡不僅可以加快網絡收斂,同時能夠保證模型尋找到全局最優解,衡量模型預測能力,L1、L2 函數是目前應用比較廣泛的損失函數。 本文根據單目深度估計以往研究方法,采用尺度不變對數誤差損失函數和基于本文構建的殘差感知損失函數聯合相加得到聯合損失函數。 聯合損失函數的表達式(4):

其中,Ltotal表示聯合損失函數;L為尺度不變對數誤差損失函數;Lp為殘差感知損失函數;w∈[0,1] 為殘差感知損失函數的平衡因子,試驗中設置為0.5。

3.1 尺度不變對數誤差損失函數

在模型訓練期間,目標深度圖中的物體邊緣、弱紋理區域和鏡面反射等周圍會出現丟值現象。 本文利用簡單的掩膜方法來處理這些缺失值,即通過目標深度圖獲取一個掩膜矩陣,重新計算預測與真值深度圖的像素值,使模型在有效點上計算損失,排除無效點的影響。 損失函數表達式(5):

式中:λ∈ [0,1] 為尺度因子,di =log10Y -log10,Y、分別為模型預測深度圖與真實深度圖的集合,,試驗設置λ =0.5。

3.2 殘差感知損失函數

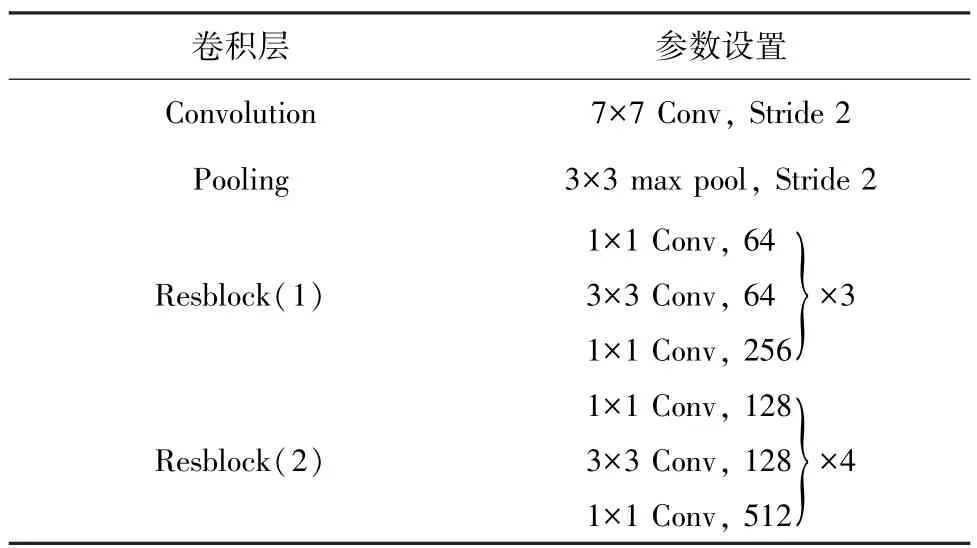

目前有監督的深度估計任務核心是對預測深度圖與真實深度圖進行差異評估,傳統的解決方法是建立逐像素損失函數,這種方式簡單高效。 最近也有部分研究將感知損失用于遙感影像去噪、醫學影像去噪和單目深度估計,以上均是采用預訓練的VGG(Visual Geomtry Group)網絡,對輸入圖像提取高維度特征,隨后使用優化的感知損失函數評估特征之間的差異[12-13]。 采用VGG 網絡模型預測圖像,預測結果圖質量好,物體邊緣銳利,但是訓練優化模型時開銷時間較大。 本文綜合以上的優點,構建一種具有殘差的感知損失函數,ResNet50 相對于其他網絡具有更深的網絡層數和更抽象的高層特征。 當預測深度φ(Y) 的特征偏離目標深度φ(Y^)時,感知損失會懲罰預測深度(Y) 的特征,懲罰邊緣、紋理和輪廓等差異。 殘差感知損失網絡結構見表1,感知損失表達式(6):

表1 殘差感知損失網絡結構參數Tab.1 Residual perceived loss network structural parameters

其中,φ表示損失網絡,φ(Y) 、φ() 分別表示真實深度圖和預測深度圖經過第i層后提取到的特征集合。

4 試驗結果與分析

4.1 試驗設置與數據集

本文采用紐約大學公開的室內環境數據集NYU-Depth V2,原始RGΒ-D 數據由Kinect 相機拍攝采集的464 個室內場景,包括12 萬對彩色圖像與深度圖像,場景的深度范圍為0 ~10 m,在249 個場景中選取約2 萬張子集用于訓練,其余215 個場景用官方劃分的654 張圖像子集作為測試。 本文網絡結構的原始圖像輸入大小為480×640,在訓練過程中對輸入的彩色圖片按隨機概率50%進行水平翻轉、隨機裁剪、顏色變換等,并且引入CutDepth 策略進行數據增強。

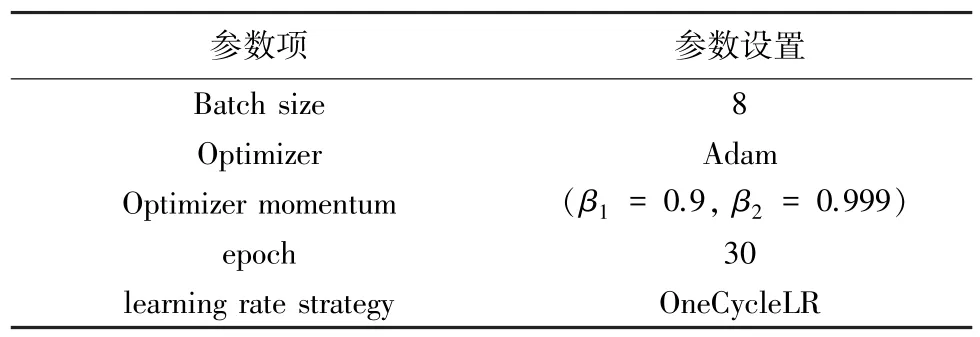

本文試驗操作系統為Ubuntu,試驗基于Pytorch 1.9 深度學習框架,試驗硬件配置為Intel(R) Xeon(R) CPU E5-2680 v4 @ 2.40 GHz 處理器,內存為16 GB,模型在GPU 顯存為12 G NVIDIA TITAN XP的顯卡上訓練,具體試驗參數見表2。

表2 試驗參數Tab.2 Test parameters

4.2 定量評價指標

本文按照6 項指標來評價本文構建模型的試驗結果,將模型預測與真實標簽估計效果進行比較。

(1)絕對值相對誤差(Abs Rel),式(7):

(2)均方根誤差(RMSE),式(8):

(3)對數平均誤差(log),式(9):

(4)閾值相似度δ,式(10):

其中,閾值thr ={1.25,1.252,1.253};i是像素索引;di、分別為像素i處的預測深度值和真實深度值;N是測試集深度圖中所有像素數目的總和。

4.3 消融試驗

為了驗證數據增強、選擇特征融合模塊和損失網絡3 個消融因素對本文模型的有效性,本文采用以下的方式進行消融試驗分析:編碼器均統一采用EfficientNet-B2,解碼器為U-Net(模型1)、解碼器為U-Net 采用CutDepth(模型2)、解碼器為SU-Net(模型3)、解碼器為SU-Net 采用CutDepth(模型4)以及構建的損失網絡(模型5)。 3 種因素對網絡消融試驗的結果見表3,結果表明各項評估指標在解碼器SU-Net 比U-Net 有一定的精度提升,這歸因于選擇特征融合模塊中雙通道空間注意力圖,通過對全局與局部路徑的空間特征權重的重標定,對特征圖進行自適應性的恢復校準,從而提高模型識別恢復路徑的準確性。 通常情況下,數據增強策略使樣本多樣性增多,模型精度越高。 模型2 基于UNet 與模型4 基于SU-Net,在數據增強策略下,模型的誤差小、準確度高,與實際情況相符。

表3 不同模塊誤差對比Tab.3 Error comparison of different modules

本文構建的模型與其余4 種模型相比,誤差更小,準確率更高。 這得益于模型不僅汲取了數據增強與SU-Net 的兩個優點,還得到了損失網絡對預測輸出的進一步感知。 損失網絡結合遷移學習中的高級特征信息,通過對預測深度與真實深度的融合感知,提高了網絡對標簽信息的重構使用,提取更為詳細的細節信息,彌補編碼-解碼階段特征信息表達能力不足的問題。

5 種消融試驗預測深度如圖3 所示,可見本文最終構建模型相比前4 種消融試驗在深度預測更加接近真實深度,存在鏡面反射時預測深度有明顯的提升,對于目標的輪廓清晰可見,邊緣更加銳利,這得益于損失網絡強大的損失感知,使預測深度圖感知到與真實深度圖之間存在的差異,通過每一次感知損失函數的修正進一步提升預測精度。

圖3 構建模型深度效果Fig.3 Depth results of proposed model

4.4 對比試驗

為了驗證本文模型的深度估計精度,將其與近年來其他應用深度學習的單目深度估計在NYUDepth V2 數據集上的對比試驗結果見表4。 試驗結果表明,本文模型的絕對值相對誤差(Abs Rel)、均方根誤差(RMSE)、對數平均誤差(log)以及不同閾值下的準確率(δ) 在對比試驗中優于其他方法。文獻[14]采用ResNet101 模型作為深度估計的基礎網絡并結合DenseASPP 部分結構,提出了一個DCDN(Deep Convolution DenseASPP Network)新的卷積神經網絡模型;而本文構建模型將EfficientNet-B2 結構作為編碼器,其模型參數量更加的輕量,在絕對值相對誤差、均方根誤差以及對數平均誤差分別減少了15.8%、13.1%、11.8%,在閾值為δ <1.25、δ <1.252、δ <1.253的準確度分別提升4.3%、1.4%、0.2%。

表4 NYU Depth v2 數據集上的試驗結果對比Tab.4 Comparison of test results on NYU Depth v2 dataset

將本文構建模型與文獻[5]的模型進行定性評價,得到的預測深度圖如圖4 所示。 從圖4 可以看出,采用本文模型,小型物體輪廓明顯邊緣更加銳利,遠距離的深度預測效果有較大改善,說明本文模型對于提取目標輪廓邊緣有顯著提升,解決了小型物體輪廓模糊的問題,同時提高了深度估計的性能,具有更好的預測深度能力。

圖4 深度預測圖對比Fig.4 Comparison of different depth maps

5 結束語

針對現有的深度估計任務中存在的編碼器模型參數量大和計算復雜度高等問題,本文構建了一種基于輕量化融合損失網絡的單目深度估計模型,并利用NYU-Depth V2 公開數據集開展了試驗研究。試驗結果表明,該模型中損失網絡汲取到了圖像的高級特征信息,能對預測深度與真實深度進行融合感知,提高模型對信息的重構使用,彌補編碼-解碼階段特征信息表達能力不足的問題;該模型不僅誤差更小,準確率更高,而且優于現有的部分深度估計模型。