結合區域提取和改進卷積神經網絡的水下小目標檢測*

符書楠 許 楓 劉 佳 逄 巖

(1 中國科學院聲學研究所 北京 100190)

(2 中國科學院大學 北京 100049)

0 引言

水下小目標檢測是水聲領域的熱點之一,在水下搜救、石油勘探和可疑物探測等方面有著重要應用[1-3]。電磁波等探測媒介在水下傳播衰減明顯,相比之下,聲波的衰減較小,聲吶成為最常用的水下探測設備。然而由于水下環境復雜多變,聲吶圖像存在低信噪比、干擾嚴重的問題,同時小目標相對于海底背景較小、所含信息較為有限,難以提取出表達力強的特征,導致水下小目標的檢測效率低、漏檢嚴重[4]。因此,如何更好地利用小目標的特征信息,實現準確、低虛警的水下小目標檢測已成為當前亟需解決的問題之一。

針對上述問題,相關學者提出了許多基于傳統機器學習和深度學習的水下小目標檢測方法。王梁等[5]利用擬合的超橢圓曲線的尺寸、形狀和位置參數構建分類特征對水下小目標進行分類,實驗證實該方法可行有效,但對于極不規則的小目標識別效果不佳。Abu等[6]利用目標統計特征對分割后的區域進行分類實現了一種無監督水下小目標探測方法,該方法實現了較高的檢測率和虛警率,然而實時性較差。Zhou 等[7]提出了一種基于脈沖耦合神經網絡和Fisher 判別的水下遠距離小目標實時檢測方法,優于常用的深度學習方法,步驟卻較為繁瑣復雜。諶雨章等[8]采用多速率空洞卷積方法檢測復雜水下環境中的小目標,提高了對水下小目標的檢測能力,但該方法使用反卷積操作會產生偽影現象,影響目標檢測性能。Chen等[9]基于樣本加權混合網絡提出了一種有效處理水下弱小目標的深度集成檢測器,然而計算復雜度較高。

水下小目標檢測任務通常分為區域提取和分類兩個階段,即先從存在較多干擾的聲圖中提取感興趣區域(Region of interest,ROI),確保潛在目標被篩選出來,同時盡可能多地消除虛警,然后利用分類算法對潛在目標區域進行分類。區域提取階段常用方法有閾值分割法、區域生長算法、馬爾可夫隨機場(Markov random field,MRF)分割方法[10]等。其中,MRF分割算法因參數設置少、分割效果好,而被廣泛應用于聲吶圖像的區域提取[11-13]。分類階段的關鍵是提取出具有代表性的特征,通常利用人為設計的多種特征提取算法進行提取,操作難度較高。而深度特征是一種通過卷積神經網絡(Convolutional neural network,CNN)自主提取,具有豐富特征表達的隱式特征,常用于水下目標分類[14-16]。但CNN 的多層卷積和池化易導致部分底層特征信息丟失[17],較難取得理想的檢測效果。為進一步增強CNN 對目標特征的表征能力,可將目標的基礎特征融入CNN,形成更有利于分類的網絡,提高目標檢測效率。

綜上所述,針對水下小目標信息量有限而難以提取有效特征導致目標檢測性能不佳的問題,本文提出了一種基于區域提取和融合Hu 矩特征的改進CNN 水下小目標檢測方法。該方法包括區域提取和分類兩個階段。首先,利用基于MRF分割算法的區域提取方法從聲圖中提取ROI,實現潛在目標定位。然后為進一步降低區域提取階段帶來的虛警,同時保持較高的檢測率,將ROI 輸入融合Hu 矩特征的改進CNN 中完成水下小目標檢測。第一階段的區域提取方法可以有效地從復雜水下環境中篩選出潛在目標,避免后續的分類被環境因素影響。分類階段的改進CNN 融合了潛在目標的深度特征和形狀特征,形成形狀特征表征能力更強的特征融合網絡,有利于提升目標檢測性能。最后以側掃聲吶實測數據為例進行處理分析,實驗結果表明,本文提出的方法可以有效提高對水下小目標的發現概率和正確報警率,同時對不同側掃聲吶獲取的數據進行驗證,證明該方法具有一定的泛化性。

1 區域提取

1.1 MRF分割算法原理

為定位潛在目標區域并保留其完整性,本文對聲圖進行分割處理。MRF 分割算法常用于對圖像特征(區域標簽、邊緣等)的連續性進行建模,能夠最大限度地保留目標完整性[18],因此本文選擇基于MRF 分割算法對聲吶圖像進行區域提取。MRF 分割算法本質上是一種對聲圖的每個數據點進行標記的統計方法,利用MRF 對數據點的空間域進行建模,并將其作為先驗知識,在貝葉斯準則下對聲圖的數據點進行分類。

設一個M×N的聲圖是一個MRF,S={(i,j)|1 ≤i≤M,1 ≤j≤N}是該聲圖上定義的空間位置集合。設Y={ys,s ∈S}是觀測到的聲圖數據,稱為觀測場;X={xs,s ∈S}是數據點的類別標簽,稱為標記場,即聲圖的分割結果。根據貝葉斯定理:

其中,P(Y|X)為待分割聲圖的概率模型,P(X)和P(X|Y)分別為標記場的先驗概率和后驗概率,P(Y)為計算中未考慮的常數。因此,聲圖的分割問題可以轉化為最大后驗問題,即當后驗概率P(X|Y)達到最大值時,得到此時的標記場:

其中,似然函數P(Y|X)可由混合高斯模型表示:

其中,n為聲圖數據點的標簽類別數,μs和Σxs分別是隸屬不同類別的觀測場數據的均值和協方差矩陣。

由Hammcrslcy-Clifford 定理,MRF 與Gibbs隨機場具有等價性,則MRF先驗概率可表示如下:

其中耦合系數β一般取值[0,2],本文中該系數取為1。

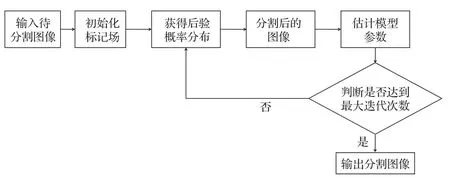

算法具體流程圖如圖1所示。

圖1 MRF 算法流程圖Fig.1 The flowchart of MRF algorithm

1.2 基于MRF分割的區域提取方法

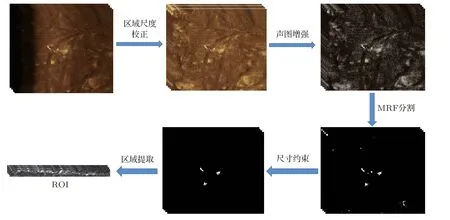

受海水介質、成像環境、混響等因素影響,聲吶圖像存在較多噪聲干擾,為準確提取潛在目標區域,在圖像分割之前需要進行預處理操作。同時,由于分割后的區域仍存在與目標尺寸差距較大的干擾,需要對分割區域進行篩選,從而精準地獲取潛在目標區域。本文提出的區域提取方法如圖2 所示,該方法主要由5個步驟組成,具體操作如表1所示。

表1 區域提取步驟Table 1 Region extraction steps

圖2 區域提取流程圖Fig.2 The flowchart of region extraction

2 特征融合分類網絡

2.1 Hu矩特征

水下小目標的基礎特征是形狀特征、尺寸特征等,可作為主要特征用于目標分類。Hu 矩特征[19]是一種有效描述目標形狀的矩特征,具有平移、旋轉和尺度不變性,不受目標位置和方向影響,常作為水下目標特征,應用于小目標分類[20-21]。

設f(x,y)(x=1,···,M,y=1,···,N)為大小M×N圖像在(x,y)處的灰度值,則它的p+q階幾何矩mpq定義為

通過幾何矩mpq構建的中心矩反映了圖像灰度相對于灰度重心的分布,p+q階中心矩μpq如式(8)所示:

其中,(x0,y0)是圖像的重心坐標,x0=m10/m00,y0=m01/m00。

該圖像的p+q階歸一化中心矩ηpq定義為

其中,r=(p+q)/2+1。

通過式(9)歸一化中心矩的多種線性組合,可計算出7個Hu矩,如式(10)~(16)所示:

上述7 個Hu 矩構成了目標的形狀特征H=(H1,H2,H3,H4,H5,H6,H7)。

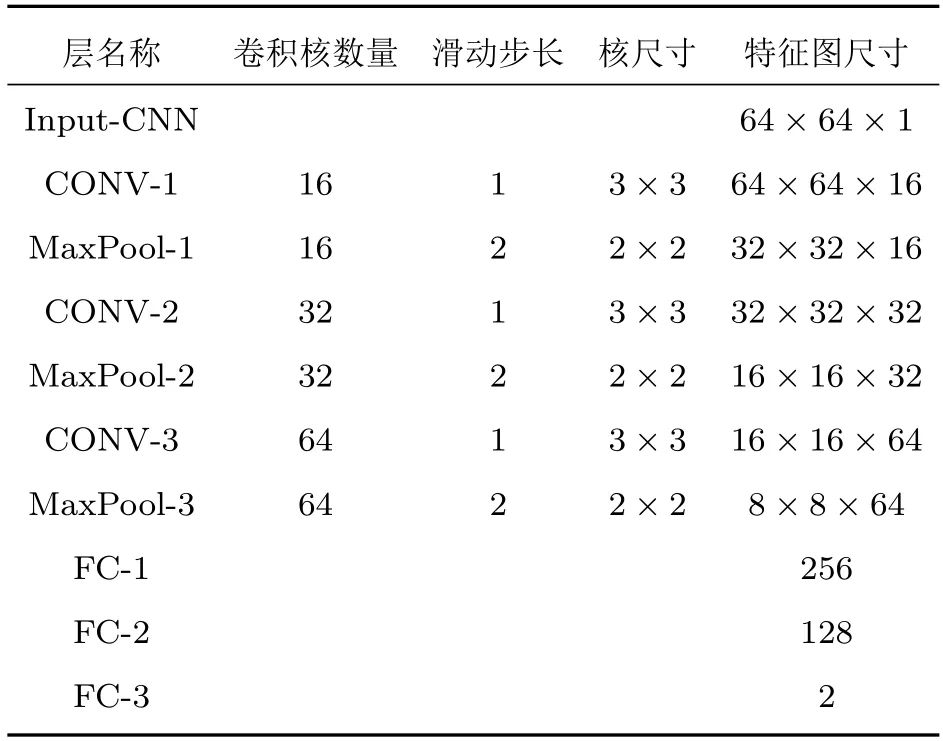

2.2 融合Hu矩特征的改進CNN

LeNet-5[22]是由Lecun于1998年提出的7層CNN,主要用于手寫數字識別,常用于低分辨率圖像的分類。本文以LeNet-5為基礎,設計包含3 個卷積層、3 個池化層、3 個全連接層的基礎CNN 結構,其中激活函數采用ReLU 函數。各網絡層詳情如表2所示。

表2 基礎CNN 各網絡層詳情Table 2 Details of basic CNN

由于CNN 的多層卷積和池化易使潛在目標的部分底層特征丟失,為進一步增強CNN分類特征的表征能力,在基礎CNN 中融入Hu 矩特征,構建融合Hu 矩的改進CNN (Hu-CNN),最終構建的由兩條分支網絡構成的Hu-CNN 網絡結構如圖3 所示。其中,基礎CNN 分支網絡提取目標深度特征,輸入FC-1全連接層進行映射;另一條分支網絡提取目標Hu 矩特征,輸入FC-4 全連接層進行映射;最后將兩條分支網絡映射得到的特征向量進行融合,經過FC-2 全連接層映射后輸入FC-3 層進行目標分類。Hu-CNN的具體細節如下:

圖3 改進的分類網絡結構(Hu-CNN)Fig.3 Structure of the improved classification network (Hu-CNN)

(1) CNN 深度特征提取:由于提取的ROI尺寸不同,所以在提取深度特征之前對ROI進行雙線性插值,將大小調整為64×64。然后將其輸入設計的基礎CNN中,通過FC-1層輸出為256維特征向量。

(2) Hu 矩特征提取:為保留目標更多的特征信息,直接提取原始ROI 的七維Hu 矩特征,并通過FC-4全連接層映射為48維。

(3) 特征融合與分類:將步驟(1)和步驟(2)中得到的256 維和48 維特征向量進行拼接融合,形成304 維特征向量,由具有128 個節點的FC-2 層映射輸出后,通過FC-3層得到最終分類結果。

3 實驗驗證

3.1 數據集介紹

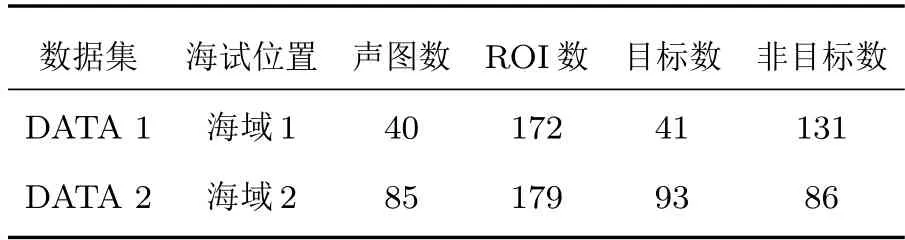

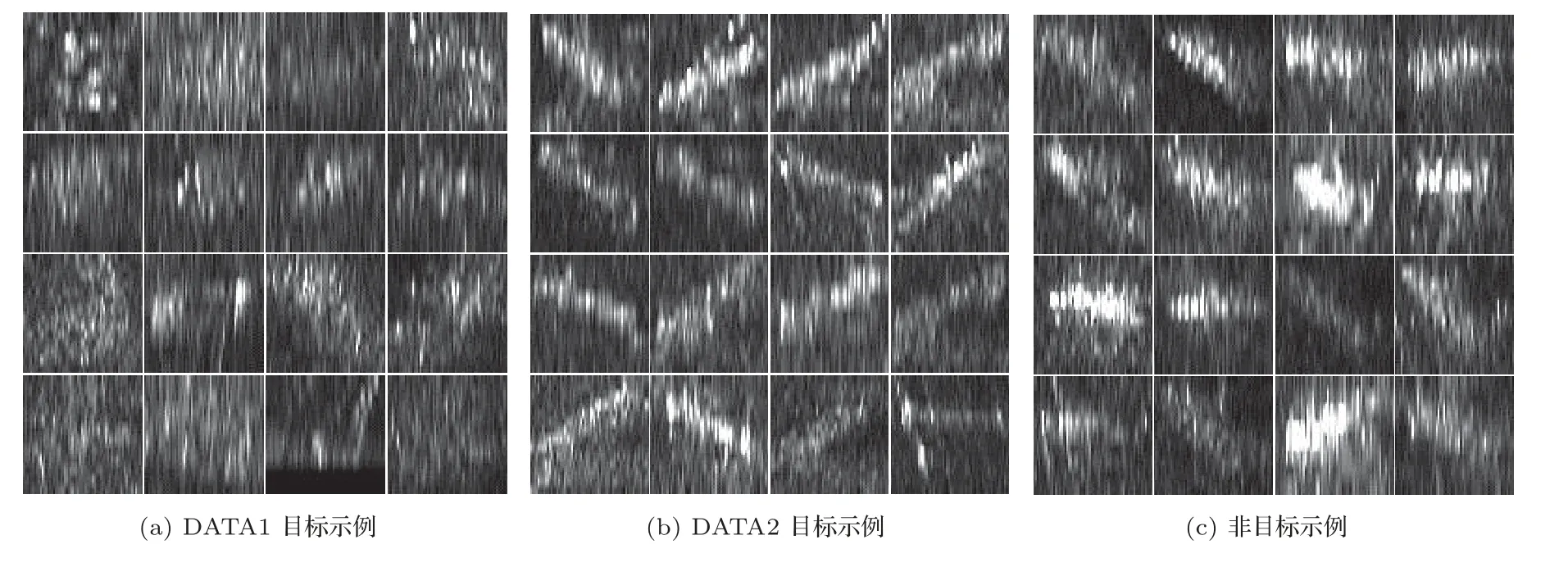

以側掃聲吶實測圓柱目標數據為例,對方法的有效性進行分析。本節數據集來自不同海域,分別記為DATA 1和DATA 2。從DATA 1和DATA 2的40 張和85 張聲圖中分別提取得到了172 個和179個ROI,其中DATA 1 得到41 個目標和131 個非目標,DATA 2 得到93 個目標和86 個非目標。實驗數據集詳細情況如表3 所示。圖4 為大小調整為64×64 的ROI 示例,即CNN 端的輸入,其中包括DATA 1 和DATA 2 中的目標和非目標。

表3 數據集詳情Table 3 Datasets details

圖4 提取出的ROI 示例Fig.4 Examples of extracted ROI

3.2 性能指標

本文采用發現概率(Detection rate,DR)、正確報警率(Correct alarm rate,CAR)以及AUC 值3個性能指標來評價實驗結果。

發現概率反映正確檢測到的目標占目標總數的比例,正確報警率反映所有預測目標中正確的比例,其計算公式如式(17)~(18)所示:

其中,TP 表示正確檢測到的目標數,FP 表示誤檢為目標的數量,TN表示正確檢測到的非目標數,FN表示誤檢為非目標的數量。

AUC 值為受試者工作特性(Receiver operating characteristic,ROC)曲線下的面積,ROC 曲線是根據不同的閾值,以模型分類結果的假陽性率(False positive rate,FPR)為橫坐標,真陽性率(True positive rate,TPR)為縱坐標繪制的曲線,其中

曲線越靠近左上角,即AUC 值越接近1,則模型的整體性能越好。

3.3 實驗設置

為驗證該方法的有效性,分別進行實驗1 和實驗2,同時采用五折交叉驗證評估方法的性能。在實驗1 中,將DATA 2 隨機分成5 份,其中一份作為測試集,剩余4份作為訓練集,重復訓練測試5次,該實驗中的測試集記為測試集1;同時利用訓練好的5個模型分類DATA 1 (記為測試集2),以驗證方法對不同環境的適用性。在實驗2 中,所有數據(DATA 1和DATA 2)隨機分成5 份,按4:1 的比例重復訓練和測試5 次。兩次實驗中均取五次測試結果平均值作為最終的結果。

考慮到試驗海域水聲環境、試驗工況等因素對目標聲圖的影響,為保證算法的泛化性,對兩個實驗的訓練集進行數據增強,分別進行旋轉90°、180°、270°、水平翻轉、垂直翻轉、變亮、變暗、加入高斯帶限噪聲的操作,將訓練集擴充為原來的9倍,測試集保持不變。

為驗證本文提出方法的優越性,本文使用常用的水下目標分類器(Haar+AdaBoost)[23]、小波包變換(Wavelet packet transform,WPT)+支持向量機(Support vector machine,SVM)[24]、方向梯度直方圖(Histogram of oriented gradient,HOG)+SVM[25]和傳統CNN)進行比較,不同分類器對輸入特征的敏感性不同,識別精度也不同,設置每個分類器的參數如下:

(1) 基于WPT+SVM的分類器采用db3小波函數,對輸入進行5 層分解,支持向量機采用RBF核函數;

(2)基于Haar+AdaBoost 的分類器中迭代次數設為50;

(3) 基于HOG+SVM 的分類器,也采用RBF核函數;

(4) 對于傳統的基于CNN 的分類器和本文提出的分類方法(Hu-CNN),采用隨機梯度下降算法和交叉熵損失函數,學習率設置為0.01,批大小設置為64,epoch設置為100。

3.4 實驗結果與分析

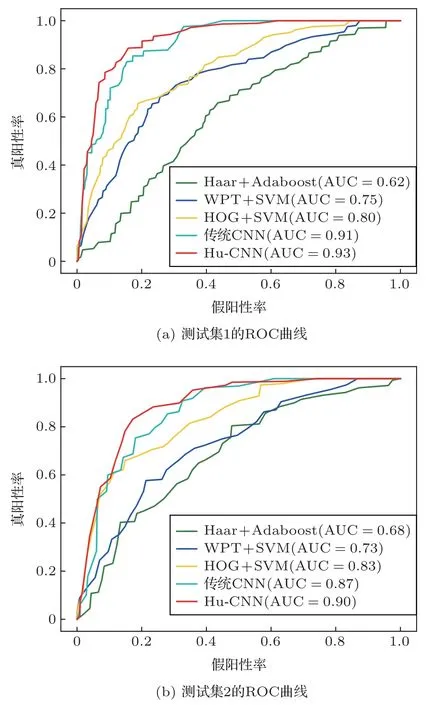

兩次實驗的檢測結果如表4 和表5 所示,ROC曲線如圖5 和圖6 所示。由表4 可以看出,在實驗1中,對于測試集1,由于訓練集和測試集均來自于DATA 1,發現概率可達93.2%,性能指標均優于其他方法。其中相較于傳統CNN,Hu-CNN 的發現概率和正確報警率分別提高了5.0%和2.7%。對于來自不同海域的測試集2,由于成像環境不同、噪聲干擾等因素的影響,檢測性能略低于測試集1,但Hu-CNN 的性能指標均高于其他方法,發現概率達到87.8%,比傳統CNN 提高了4.9%。實驗1 結果表明Hu-CNN可以有效檢測不同環境下的小目標。

表4 實驗1 結果Table 4 Experimental 1 results

圖5 實驗1 的ROC 曲線及AUC 值Fig.5 ROC curves and AUC values of Experiment 1

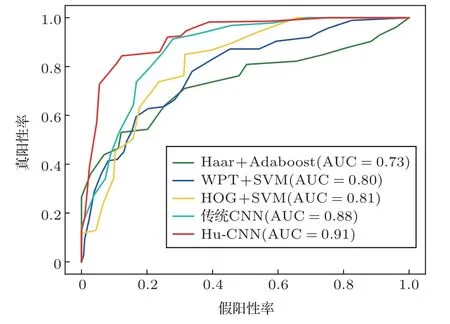

圖6 實驗2 的ROC 曲線及AUC 值Fig.6 ROC curves and AUC values of Experiment 2

通過表5 可以看出,在實驗2 中,Hu-CNN 的發現概率和正確報警率分別達到89.0%和86.4%,與其他方法相比,性能指標均得到顯著提升。同時相較于傳統CNN,Hu-CNN 的發現概率提高了6.6%,正確報警率提高了6.2%,證明了改進方法的有效性。

從圖5 的ROC 曲線及AUC 值可以看出,對于實驗1 的不同測試集,Hu-CNN 的AUC 值分別為0.93 和0.90,均高于其他4 種方法。同時由圖6 的ROC 曲線可以看出,實驗2 中Hu-CNN 的AUC 值為0.91,比傳統CNN 提高了0.03,證明了改進方法的優越性。

Hu-CNN 融合Hu 矩特征和CNN 深度特征,克服CNN 卷積和池化操作導致底層特征信息丟失帶來的影響,形成具有形狀特征表征能力更強的改進CNN,有效利用了小目標關鍵特征信息,從而提高目標檢測的準確性。

3.5 泛化性驗證

為檢驗提出方法的泛化性,采用不同側掃聲吶獲取的數據進行泛化性測試。本節數據集共14 張聲圖,提取ROI 得到16 個目標和121 個非目標,輸入實驗2 得到的5 個分類模型中進行目標分類,結果如表6所示。

表6 泛化性驗證結果Table 6 Generalization verification results

由表6 可以看出,本文方法對不同側掃聲吶測得的數據仍然具有較好的檢測性能,相較于傳統CNN,改進后的Hu-CNN 發現概率提高了6.3%,達到96.3%,正確報警率提高了2.1%。泛化性驗證實驗結果表明,該方法具有良好的泛化性能,可以有效應用于不同側掃聲吶獲取的數據。

4 結論

本文提出了一種結合區域提取和融合Hu 矩特征的改進CNN 的水下小目標檢測方法,該方法由區域提取和分類兩部分組成。區域提取階段根據目標特征采用基于MRF 分割算法的5 個步驟提取聲圖中的ROI,實現潛在目標定位。在分類階段,本文提出的Hu-CNN 特征融合網絡將CNN 深度特征與Hu矩特征融合,形成更具代表性和精確性的融合特征,可有效區分目標與偽目標,提升目標檢測性能。在不同數據集上的實驗結果表明,該方法對不同側掃聲吶數據均具有較優越的檢測性能和泛化性,對水下小目標的檢測具有一定的研究意義。