基于深度學習初始位姿估計的機器人攝影測量視點規劃

姜 濤 崔海華 程筱勝 田 威

傳統的攝影測量技術是利用單相機從多個角度拍攝大量圖片進行物體三維重建的技術[1],在機器人系統[2-3]、遙感測繪、制造測量[4]、航空航天[5-6]等領域應用廣泛.近年來,利用機器人進行測量檢測的研究和應用逐漸增加,視覺與機器人系統的集成提升了視覺測量與檢測的效率和自動化水平.然而,機器人攝影測量系統中,機器人相對測量對象初始位姿需要標定和人工輸入,導致機器人離線編程受到實際測量環境影響.

機器人攝影測量系統的核心問題是安裝視覺系統后,具有可視能力的機器人視點規劃與路徑規劃問題.Kinnell 等[7]對機器人三維視覺系統框架做出了詳細論述.Kwon 等[8]研究了機器人掃描系統,提出重掃描策略,縮短了掃描時間,增強了機器人檢測的穩定性.Raffaeli 等[9]提出基于理論數模的機器人掃描路徑離線編程算法,但是離線程序依賴于在線校準.Li 等[10]提出基于鄰域搜索方法來確定機器人二維掃描的方向,但其路徑規劃不連續,需要后期多組測量數據的再次融合.為實現以最小的拍攝視點獲得最豐富的重建信息,需要依據視點可見性對拍攝視點進行優化[11].“Generate-test”方法在基于模型的視點規劃中得到了廣泛的應用[12].它生成大量的候選視點,并計算每個視點下的可見矩陣.然后將覆蓋問題轉化為可見矩陣的最優選擇問題[12].Jing 等[13]采用迭代隨機抽樣和概率勢場方法以非確定性方式生成候選視點.在較高的覆蓋率下,保證了較好的視點規劃效果.然后,Jing 等[14]將視點規劃和路徑規劃結合為一個單一的規劃問題,取得較好的全局最優效果.在實際測量中,機器人視覺系統必須確定被測對象相對于自身的實際位姿,并以此為初始姿態進行掃描路徑的規劃.基于視覺的目標位姿測量方法主要有PNP (Perspective-Npoint)[15]方法和三維剛體變換法[16],這些方法需要精確已知被測對象特征,提取并重建出必要的特征要素進行位姿計算,雖然位姿計算精度高,但是在可變化的環境中特征提取不穩定,容易產生誤差.深度學習技術在位姿估計方面具有環境適應性強、自動化程度高等優勢.近年來,利用卷積神經網絡(Convolutional neural network,CNN)進行位姿估計的研究發展迅速[17-19].PoseNet[20]網絡直接利用CNN 從單幅RGB 圖像中估計相機6D 姿態,但是其將旋轉分量和平移分量單獨輸出,訓練過程必須調整參數來平衡兩個分量的損失.為避免這個問題,PoseCNN[21]網絡則直接將位姿誤差作為損失函數而更加適應于位姿優化.文獻[22-23]中,CNN 沒有直接用于位姿估計,而是通過估計特征點然后計算三維姿態的方法,提高了位姿估計的速度和精度.二維物體識別與預測主要有Faster R-CNN (Faster region-CNN)、YOLO (You only look once)、SSD (Single shot multibox detector)[22]等網絡結構,且均有良好的預測效果.Tekin 等[17]和Rad 等[23]分別利用YOLO 和SSD 提出了基于單幅圖像的位姿估計模型,提升了位姿估計速度.

可見,利用深度學習進行位姿估計,并與機器人視點規劃相結合,是機器人自動化高效率攝影測量的新的方式.本文針對機器人攝影測量系統中初始位姿估計、機器人掃描路徑規劃兩個主要問題,研究提升機器人攝影測量效率和自動化程度的新方法.提出融合深度學習位姿估計的機器人攝影測量系統視點規劃策略(第2 節).主要貢獻在于: 1)基于YOLO 模型與PNP 算法實現了單相機快速位姿估計,替代傳統的初始位姿現場校準的工作(第2.1 節);2)提出基于相機成像2D-3D 正逆性映射的被測模型可見性矩陣估計(第2.2 節);3)提出基于初始位姿約束和熵權法的機器人攝影測量視點規劃和路徑規劃方法(第2.3 節).利用幾種具有典型特征的零件進行實驗驗證,獲得了優異的位姿估計效果和攝影重建結果(第3 節).

1 測量系統組成及方法

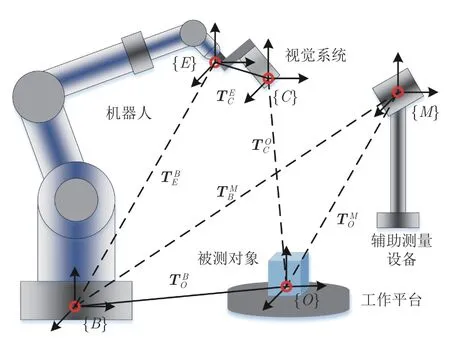

攝影測量是利用多視角拍攝大量圖像進行物體三維重建的技術.機器人攝影測量系統組成包括:機器人本體、視覺末端、計算機及控制器等.視覺系統固定安裝在機器人末端執行器,視覺坐標系與機器人末端坐標系精確標定后,視覺數據可變換到機器人坐標系下.機器人攝影測量系統中,機器人作為執行機構,搭載相機達到指定位置,并以優化的視角獲取被測對象數據.圖1 為機器人攝影測量系統簡圖.

圖1 機器人攝影測量系統簡圖Fig.1 Diagram of the robotic photogrammetric system

如圖1 所示,被測對象放置在固定的工作平臺上,機器人攜帶視覺系統從不同角度拍攝圖像,然后發送至攝影測量系統進行重建.由于擺放位置隨意性,傳統機器人攝影測量必須借助輔助測量設備標定機器人基坐標系{B}和物體坐標系{O}的相對變換然后利用這個固定關系和視覺系統可見信息規劃機器人末端位姿這一過程依賴初始標定結果,使得離線編程結果受到實際操作限制.本文從逆向出發,利用視覺系統自身可定位能力實現被測對象相對于視覺系統的變換矩陣估計,然后根據手眼矩陣計算出機器人姿態,并根據可見性規劃機器人完成掃描的最優位姿.

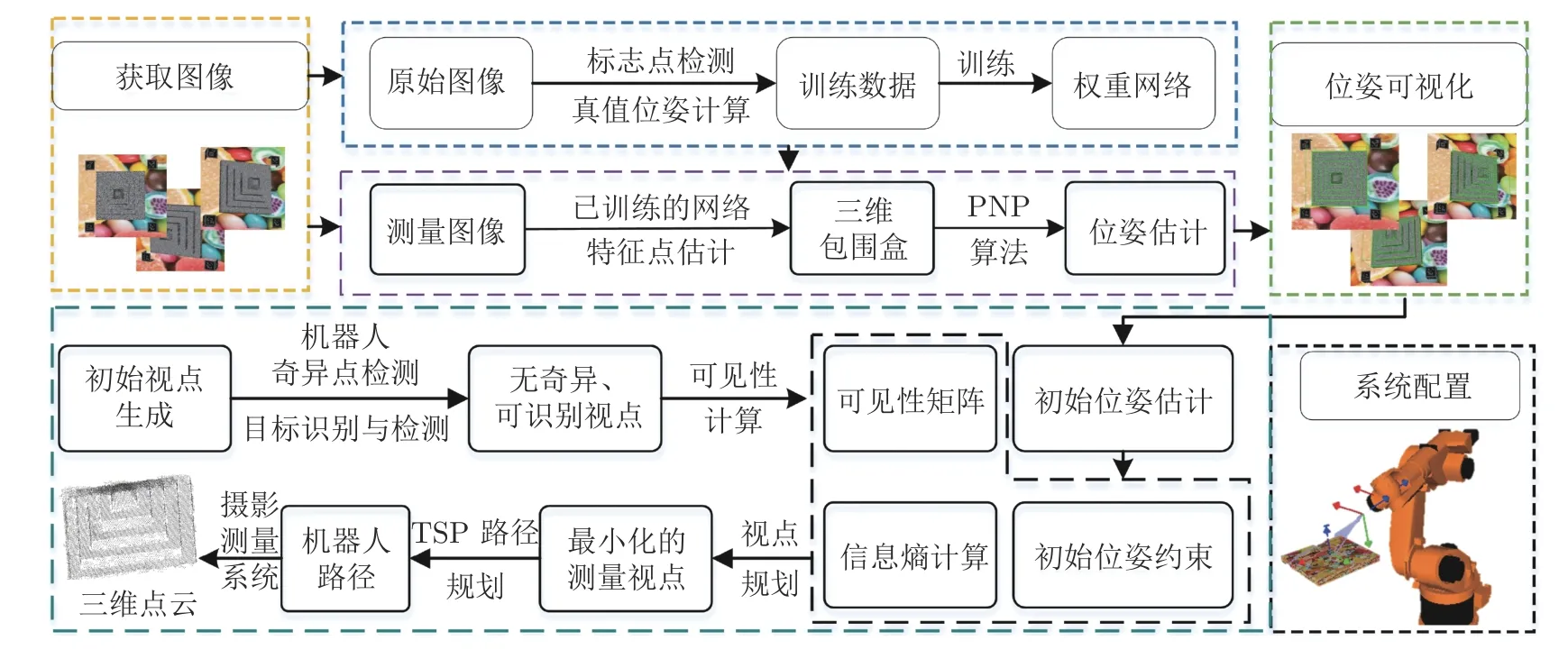

如圖2 所示,整個視點規劃策略可分為3 部分:初始位姿估計、可見性矩陣估計、視點與軌跡規劃.被測對象隨意放置在測量平臺,機器人視覺系統僅通過初始圖像即獲取被測對象位姿,而無需標定.獲得初始姿態后再根據可見性信息規劃視點和機器人路徑.

圖2 融合初始位姿估計的視點規劃策略Fig.2 Viewpoint planning strategy with estimated initial pose

視點規劃策略具體如下: 1)基于深度學習的初始位姿估計: 訓練YOLO 網絡[17]獲得網絡權重.被測對象放置在測量系統前時采集初始圖像,利用已訓練的網絡估計初始位姿.2)可見性矩陣計算: 隨機生成測量視點.根據相機成像的2D-3D 正逆性映射,以三角網格模型為對象,根據深度原則判斷該視角下每個三角面片可見性,生成可見性矩陣.3)視點規劃建模與求解: 引入熵權法計算該視角下被測對象可重建的信息權值,約束初始視角,優化求解視點規劃模型和旅行商模型獲得最優視點和機器人掃描軌跡.

2 視點規劃策略

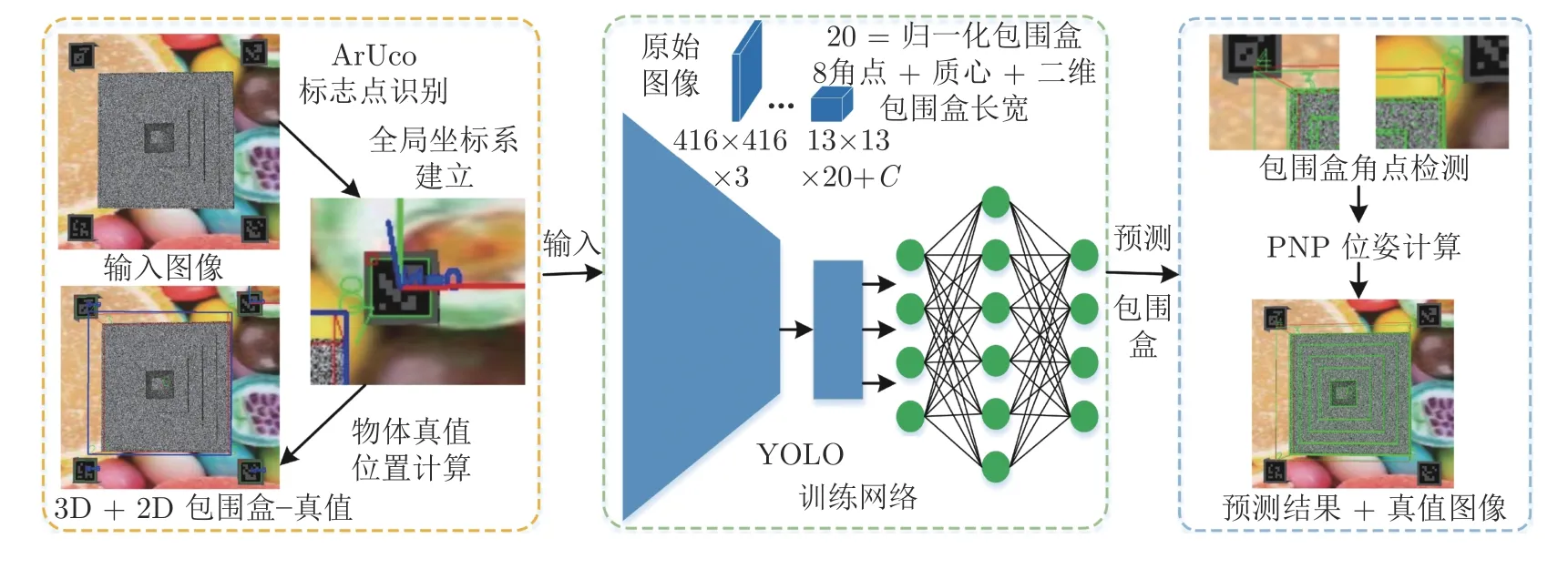

2.1 基于深度學習的單幅圖像初始位姿估計

采用深度學習方法以實現在可變測量環境下被測目標的穩定位姿估計[17].采用的網絡基于YOLO模型,其通過識別對象包圍盒及質心,并利用PNP方法計算對象位姿.該網絡可以實現單幅圖像的快速位姿估計.圖3 為實現單幅圖像位姿估計的網絡結構和流程.

圖3 深度學習實現單幅圖像位姿估計流程Fig.3 Outline of single-shot pose estimation with deep learning

如圖3 所示,本文采用文獻[17]的網絡結構,本網絡中定義可信度函數為

其中,DT(x)表示圖像平面兩個像素點的歐氏距離;α為指數函數的控制參數,根據實際訓練經驗設置為2;dth為像素差異閾值.根據指定的測量對象,在訓練過程中,定義融合點誤差和致信誤差的復合損失函數,不考慮被測對象種類識別的損失,則

其中,Lpt和Lconf分別表示圖像點和可信度的損失函數,利用均方根誤差計算;λpt表示坐標點損失系數,設置其值為1;λconf為可信度損失系數,訓練時對圖像的每個元胞進行搜索,若該元胞內有目標物體,λconf=5,否則λconf=0.1.

本文利用ArUco[22]編碼標志點作為全局控制點,并以其中一個編碼標志點作為坐標系原點建立坐標系.ArUco 具有較穩定的可識別性,且可實現自身的位姿計算.真值位姿為相機坐標系相對于全局坐標系的變換矩陣.利用真值位姿可計算被測對象相關的任意投影圖像點.即對于k個拍攝視角,若測得編碼坐標系相對相機坐標系的真值位姿為Tk,目標物體三維包圍盒角點及質心在該坐標系下的坐標為Mi=(Xi,Yi,Zi,1)T,i=0,1,···,8,相機參數矩陣為K,則可根據相機成像原理獲得圖像點mi,則

其中s為尺度因子.獲得圖像點后,根據圖像分辨率大小對圖像點進行歸一化處理.利用這些圖像點擬合最小的2D 包圍盒,并對2D 包圍盒的長寬進行歸一化處理.訓練網絡需要準備的真值數據包括:被測目標3D 包圍盒8 個角點的歸一化坐標、質心歸一化坐標、圖像2D 包圍盒長寬歸一化數值以及目標物體編碼,共21 個參數.根據被測對象不同,預先準備訓練數據包括: 原始圖像(三通道彩色)、掩膜圖像(二值圖)、目標物體三維模型、相機參數以及上述21 個數值.測試網絡的輸入為原始圖像,其通過在隨機生成的視點處拍攝得到,輸出為上述21 個參數.利用圖3 網絡訓練后進行目標特征點預測,獲得目標的包圍盒圖像坐標后,利用PNP估計位姿.記預測的被測目標包圍盒角點及質心圖像坐標為其相機坐標系下歸一化平面坐標預測位姿為3×4 的矩陣,根據相機3D-2D 投影關系(式(3))和PNP 算法,建立位姿計算的方程式,即

利用網絡預測的8 個角點坐標及質心坐標,建立線性方程組

2.2 基于2D-3D 映射的可見性矩陣計算

為優化視點,以最少的圖片數量完成對象重建,建立以可見性矩陣為目標函數的優化模型.可見性矩陣是描述在某個視角下對象表面某個部分是否可見的二值化矩陣.本文研究三角網格模型,可見性矩陣描述為

本文提出一種基于相機模型的空間映射方法確定可見性矩陣.

首先,在被測對象自身建立局部坐標系,隨機生成空間三維點,觀測方向法向于原點.記初始視點為V1=(x1i,y1i,z1i,δ1i,φ1i,γ1i),其中,

其中,ri,αi,βi為隨機生成,δ1i,φ1i,γ1i為歐拉角.按照式(8)和式(9)生成的隨機視點分布在空間一個局部環體中,與實際拍攝視點相符.根據手眼矩陣將V1變換到機器人末端坐標系,然后根據機器人逆運動學求解得到機器人關節角度.若求解失敗或關節角度超出機器人理論關節角范圍,則將該視點移除.初步濾除后的視點記為V2.控制機器人到達V2后拍攝圖像,利用第2.1 節深度學習的方法從圖像中提取被測物體并估計當前姿態,記為V2為設計的視點,位姿信息為已知.為估計的參數,位姿信息是估計得到的.

算法 1.可見性矩陣計算算法

輸入.候選視點集合模型的所有三角面片集合P;相機參數矩陣K.

2.3 測量視點優化與軌跡規劃

為實現以最小圖片數量對被測對象進行完整重建,本文以最小化視點數量為目標函數,可見性為約束條件,建立基于最小化信息熵的優化模型,即

不失一般性,x1=1 表示第一個視點為必須的視點,其是當被測對象放置于測量系統前第一次拍攝的視點.同時,第一個視角下的位姿是利用深度學習方法估計得到的;γ是一個向量,表示每個三角面片需要被重復拍攝的次數,在攝影測量中,根據重復測量的特征點計算相對位姿,故必須保證每個特征點至少被測量2 次,本文設定為4;wi表示視點xi下被測物體能夠被重建的權重,本文利用信息熵權的方法確定.根據第2.3 節算法流程可得每個視角下無遮擋的投影圖像Ic,其對應一個投影矩陣T(Ic)=[R(Ic)|t(Ic)],考慮到拍攝視角距離被測物體越近意味著更有可能實現特征識別和重建,所以建立新的投影矩陣其中,表示相機的最近可測深度,其與相機景深有關.利用T′將被測物體投影可得圖像定義vi個視點可重建概率

其中,size(I)表示圖像I中像素值非零元素的個數.概率越大,該視點被選作最終視點的可能性越大.本文目標函數為最小化,根據信息熵理論,定義信息熵為

信息熵與概率成反函數,所以信息熵越小,目標函數越小.信息熵表明該視角下能夠重建的信息值,可重建信息熵值越小,獲得的優化的視點數越小.利用線性規劃的方法求解式(11),可得到優化的視點集合V3.

下一步即是根據最短路徑原則,為機器人規劃運動軌跡.從vi到vj有多條路徑,定義機器人在兩個視點之間的路徑長度d(vi,vj)為各個結點間距離總和.為避免機器人運動至奇異點,通常采用插值的方法在兩個視點之間插入中間點,本文采取自適應隨機游走算法(Adaptive random walks,ARW)[24]對插值點和整個運動軌跡進行優化計算,利用Robwork 機器人編程庫實現[25].可建立機器人路徑規劃的旅行商問題(Travelling saleman problem,TSP)模型

利用MATLAB 中求解TSP 的工具箱進行求解,可以得到最佳掃描路徑.

3 實驗與結果分析

3.1 單幅圖像位姿估計結果分析

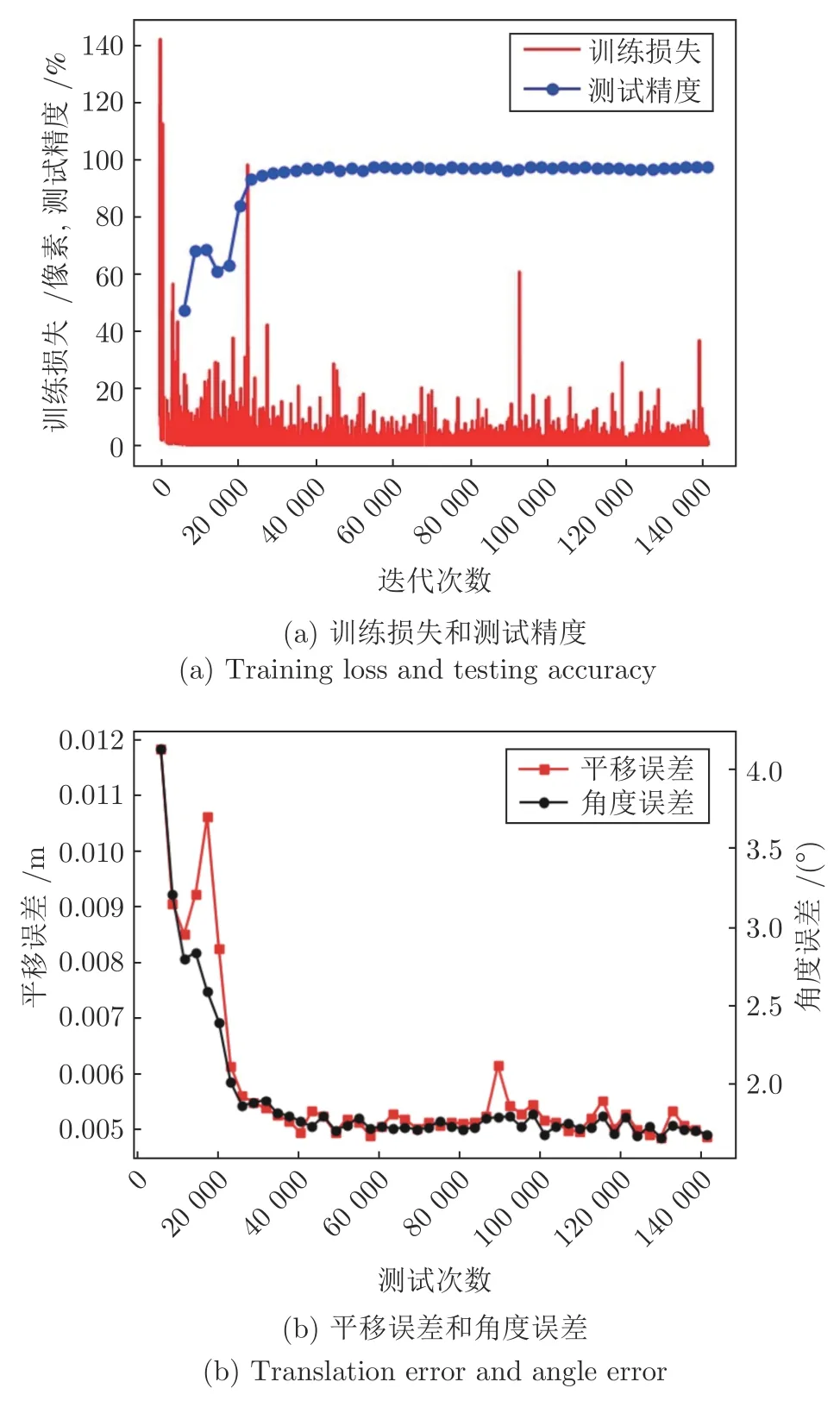

本文選擇一個3D 打印件作為算法驗證對象.在實驗中,根據式(8)和式(9)生成1 600 個初始視點,利用機器人逆向運動學和關節角度范圍進行初步濾除,獲得1 443 個有效視點.從中隨機選擇1 155個視點拍攝圖像進行訓練,其余288 個視點獲得的圖像進行測試,圖像分辨率為1 024× 768 像素.根據第2.1 節準備測試數據進行網絡訓練.目標物體與空間標志點的相對位置通過文獻[15]方法求解.訓練損失與精度變化曲線如圖4(a)所示,測試集平移和旋轉誤差如圖4(b)所示.

圖4 訓練和測量結果Fig.4 Results of training and testing

其中測試精度是每次訓練后,預測的包圍盒角點與真實角點像素偏差小于5 pixels 的角點所占的比率.由圖4(a)可知,測試精度最終穩定在100%,表明所有預測的目標包圍盒均滿足像素偏差小于5像素的要求.平移精度和旋轉精度定義如下:

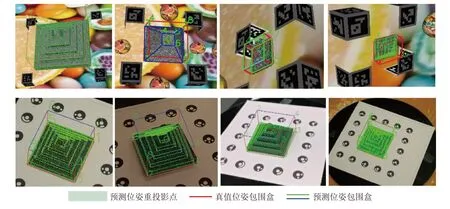

其中,Trsie,Trsi0分別表示估計的平移向量和真實平移向量;Angie,Angi0分別表示估計歐拉角度和真實的歐拉角度.從圖4(b)可以看出,訓練穩定時,平移精度為0.00481 m,角度精度為1.6478°.位姿估計的可視化結果如圖5 所示.

圖5 位姿估計可視化結果Fig.5 Visualization of pose estimation

圖5 表示利用真值位姿和估計位姿將空間點重投影到圖像平面的結果,從圖像可以看出,重投影的空間物體與實際物體吻合得很好,結合圖4 可得,在機器人攝影系統中,本網絡結構可以實現較高精度的位姿估計.單幅圖像測得的空間位姿,為機器人掃描路徑規劃提供準確的初始姿態.

3.2 可見性矩陣實驗結果分析

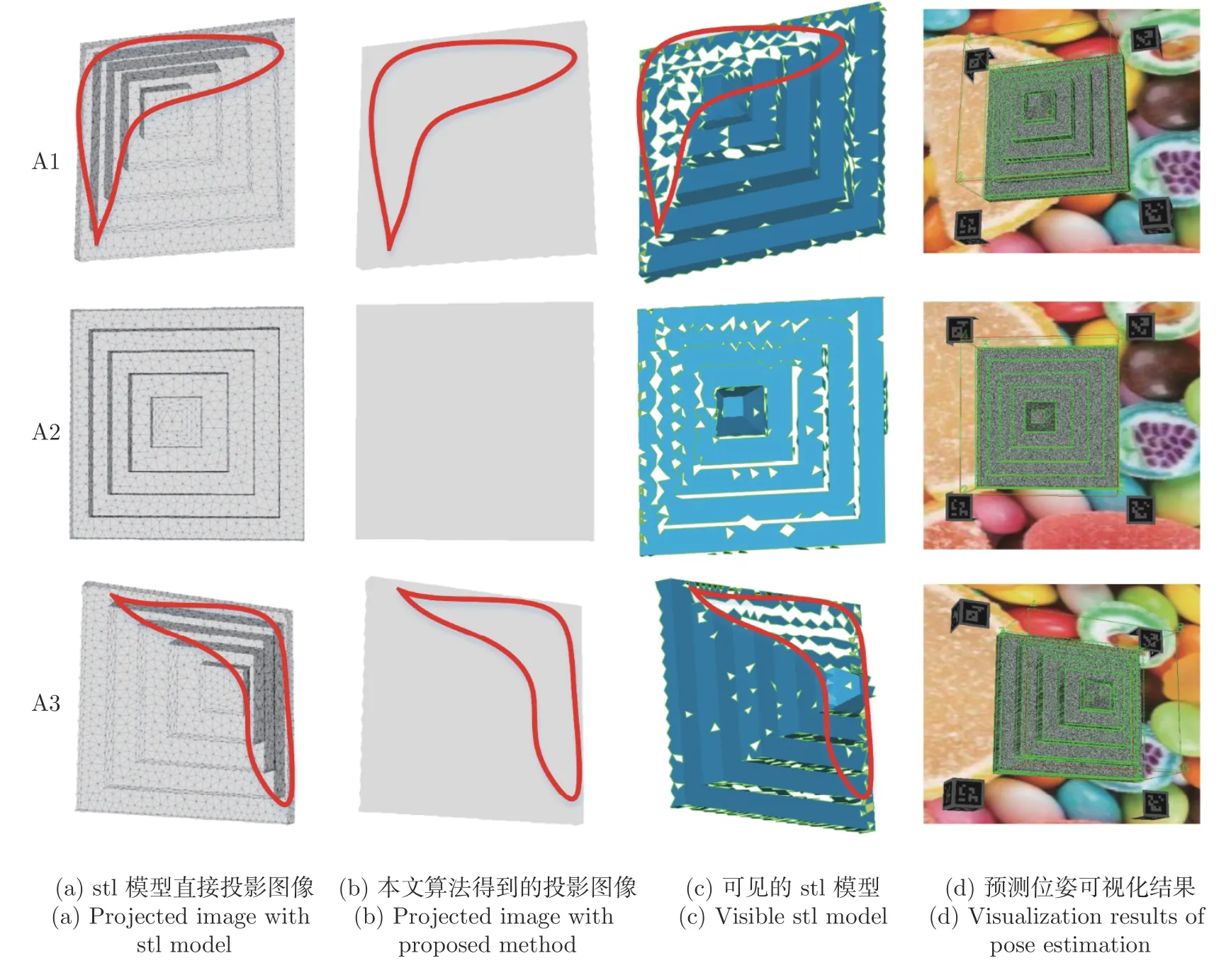

本文以三角網格為研究對象,首先將網格劃分更加密集,以提高可見性矩陣有效性和解析能力.將測試集的288 個視點作為候選視點,按照第2.2節可見性矩陣的計算算法,求解288 個視點下的可見性.部分計算結果如圖6 所示.

圖6 不同視角下模型可見性算例對比Fig.6 Comparison cases of visibility in different views

圖6(a)表示直接將stl 模型投影到圖像平面所形成的投影圖.若圖像中某個像素點只由一個空間點投影產生,則該點的灰度值減少一次,本文規定一次減少的灰度值為30.則可知減少的次數越多,灰度值越小,表明該像素點由多個空間點投影產生,即產生了將不可見空間面片投影到圖像平面的錯誤投影.由圖6(a)可以看出,投影區域的灰度值并不統一,尤其在紅色曲線內,灰度值較小.圖6(b)是利用本文算法獲得的投影圖像,灰度值完全相同,表明所有像素點均是可見面片的投影.圖6(c)為對應視角下可見的三角面片,其與投影圖像相符.圖6(d)展示了該視角下拍攝圖像,然后進行位姿估計的結果,這說明可以利用估計的位姿代替真值位姿進行可見性計算,這更適用于實際工程應用.通過標記每一個像素點對應空間面片的編號,可以得到該面片在該視角下是否可見,最終獲得的可見性矩陣為二值化矩陣.

3.3 信息熵權法實驗分析

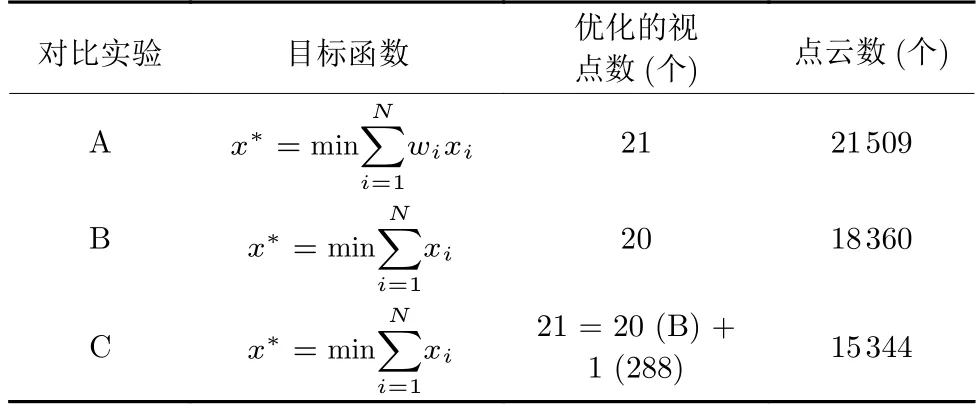

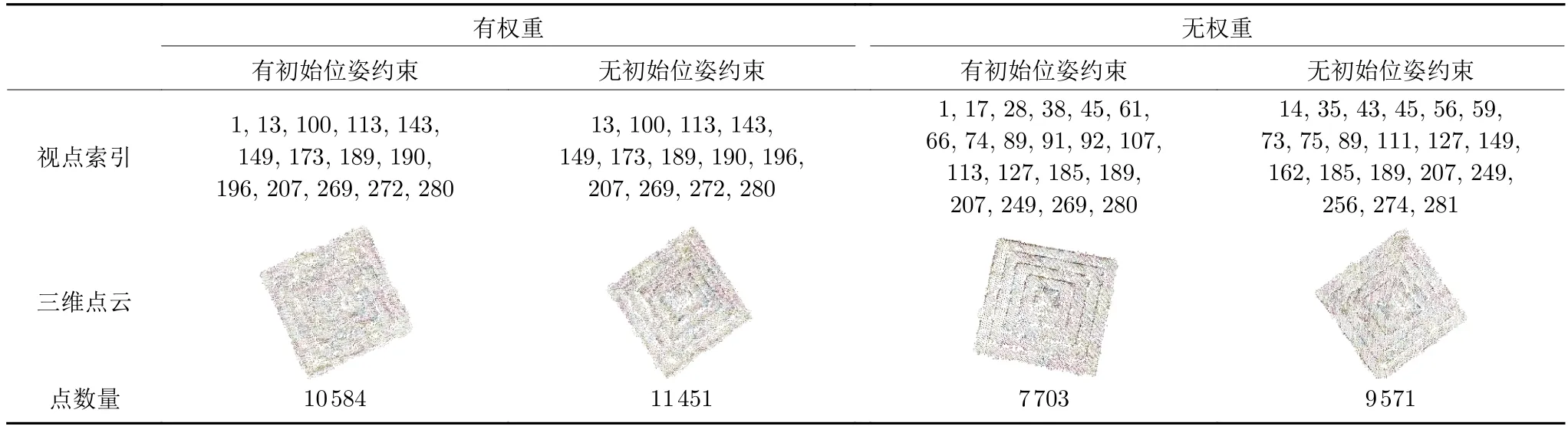

獲得可見性矩陣后,利用式(11)~(14)即可以確定優化的測量視點和對應的掃描路徑.為探究本文提出的信息熵權法對于全局重建的影響,本文對比考慮有權重和無權重情況下三維重建的質量,結果如表1 所示.

表1 信息熵權有效性驗證表Table 1 Effectiveness test for entropy weight

表1 中A、B、C 三組實驗,分別設定了不同的目標函數.A 組實驗目標函數考慮了權重,而B、C組實驗均沒有考慮權重.在表1 中,優化的視點數表示經過優化求解后獲得優化的視點數量,點云數表示攝影測量系統重建的點云包含三維點的數量,點云數越多表明被重建的特征越多,重建質量越高.對比A、B 實驗可看出,增加了信息熵權的方法求解的視點數為21,其視點數相對沒有考慮權重的方法多了一個視點,點云數增加了3 149,說明考慮權重后點云質量提高.C 的目標函數和B 相同,所以得到的優化的視點數和B 相同,均為20 個.但是為說明輸入圖像數量不同對于重建質量的影響,本文從候選的288 個視點中隨機選擇一個視點,故C 共有21 個視點.比較重建點云數量可看出,其重建的點云數量小于B,說明同樣21 個視點情況下,本文信息熵的方法可獲得最優的視點數和三維重建質量.

進一步,綜合考慮初始姿態和權重情況下,探究重建質量.為提高重建速度,在式(11)中控制每一個面片可見次數為2.實驗結果如表2 所示.

表2 綜合權重和初始姿態下重建質量對比Table 2 Comparison of reconstruction quality with weight and first-sight pose

表2 對比了考慮權重和初始姿態情況下重建質量.不失一般性,統一將索引為1 的視點作為初始視點.其中有初始位姿約束表示約束候選視點中索引為1 的視點為必選視點,然后求解最優視點;無初始位姿約束表示不考慮視點1 是否為必選而直接求解最優視點.表2 結果保證了只有初始位姿是不同的.對比表2 第2 列和第3 列,考慮初始姿態時,視點數量增加1 個,但重建的點云數量相比較小.這說明增加的初始姿態的約束造成了全局重建質量的下降.對比第4、第5 列有相同結論.需要注意的是,4、5 兩列雖然視點索引號不同,但其均是視點優化的結果,且僅保證了初始位姿是不同的.比較2、4 兩列可看出,考慮權重的情況下,不論是否約束初始姿態,重建質量均提高.

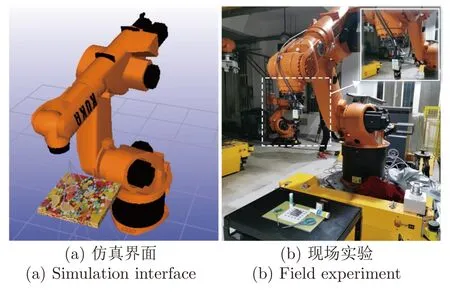

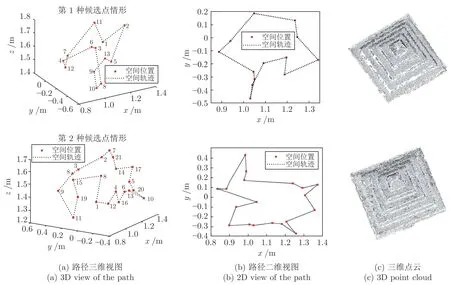

3.4 掃描路徑與重建結果分析

獲得優化的測量視點后,最終按照式 (14)規劃機器人的最短掃描路徑.本文采用插值的方法,在任意兩個視點中插入中間過渡點以保證機器人運動過程不會產生干涉,最優路徑通過自適應游走算法進行計算.由于本文方法不需要進行現場校準,被測物體任意放置在測量系統前,初始姿態具有任意性,通過表2 也說明初始姿態對于重建結果的影響.所以機器人運動軌跡受到初始姿態的影響,但是在具有相同的初始姿態下,機器人軌跡相對固定.機器人軌跡計算方法也直接用于現場實驗,圖7 展示了利用本文機器人規劃算法設計的仿真界面和現場實驗.圖7(a)為仿真界面,圖7(b)為現場實驗.利用本文的測量策略,在實際測量時,控制末端相機采圖,并估計目標物體位姿.然后將該位姿作為初始位姿進行后續視點和路徑規劃.規劃得到最優路徑發送至機器人實現自動測量.圖8(a)展示了兩種候選匹配點下的掃描路徑.

圖7 機器人掃描規劃仿真界面和現場實驗Fig.7 Simulation interface and field experiment of the robot scanning planning

圖8 不同候選匹配點下掃描路徑對比Fig.8 Comparison of scanning paths with different candidate view point

改變候選視點數量,進一步探究不同候選點下掃描路徑與重建質量,探究最優掃描路徑在不同候選視點的提升程度.圖8 展示了不同候選點集下獲得的機器人路徑.不同候選點獲得的優化的視點數量不同,掃描軌跡也不同.

由圖8 可看出,更多的優化視點獲得三維點云數量較多,重建質量較高,機器人運動的路徑相對較長.不同的候選點將產生不同的掃描路徑,但本文全部算法流程可根據實際應用中不同初始姿態、不同候選點等情況生成最優的掃描路徑.本文為實現快速攝影測量重建,重建的點云密度略低于精密攝影測量.同時,通過增加候選點數量和重疊點數量(式(11))實現重建質量提高.

利用估計的姿態進行攝影重建,21 個視點重建的時間為90 s.沒有估計姿態直接進行三維重建的時間為111 s,相對提高了18.92%,大幅提升了重建速度.因為沒有輸入姿態的情況下,攝影測量系統必須根據特征點估計出相機姿態,然后進行優化和重建,故重建速度低.另外,結合快速位姿估計、視點優化以及最短路徑規劃等綜合提升了測量系統速度.

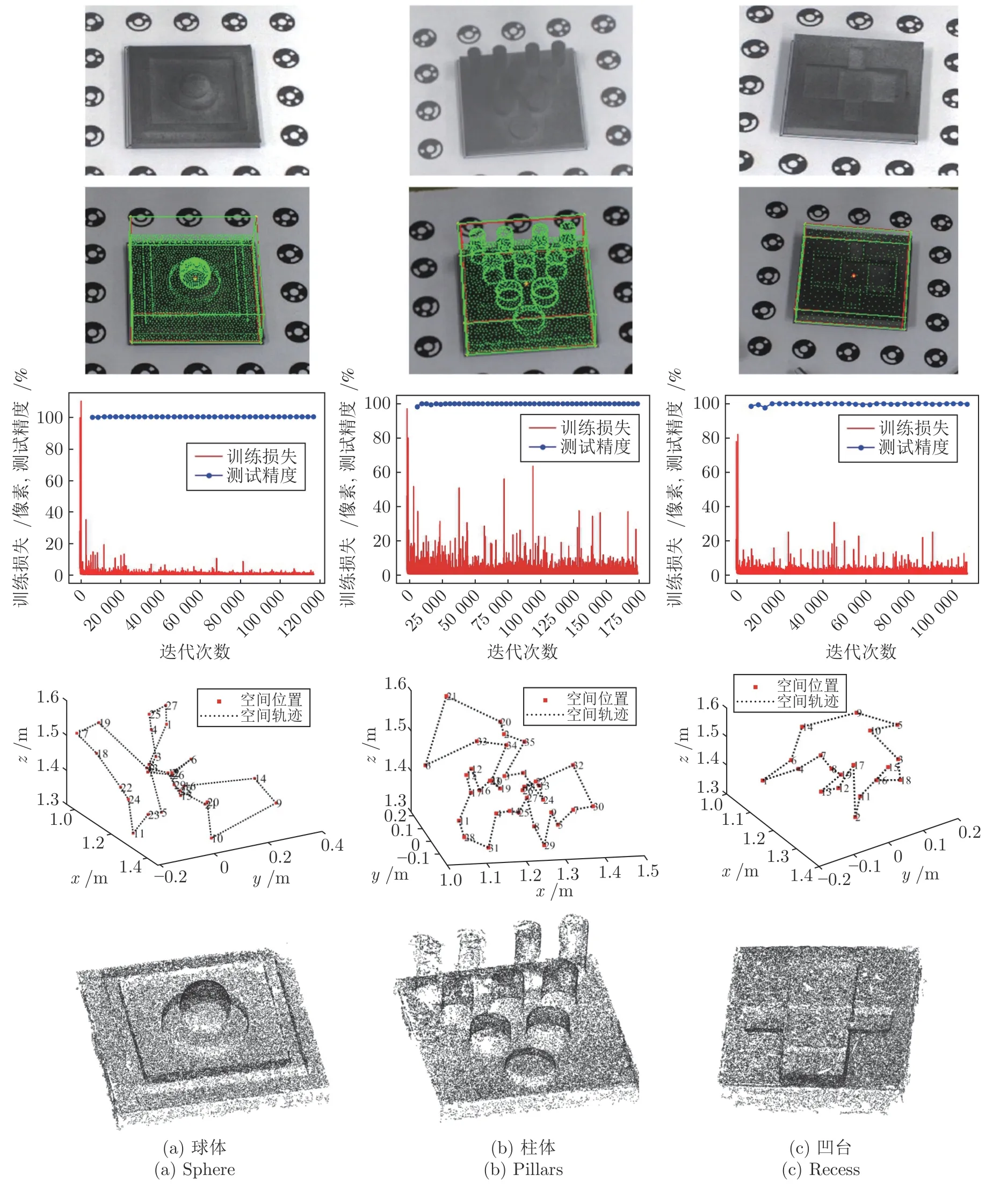

3.5 典型特征的攝影測量驗證

上文以“金字塔”狀凸臺零件驗證了所提算法.為驗證模型的泛化能力和適用性,增加球體、柱體、凹臺這三類零件的測量位姿估計與視點規劃實驗.3D 打印件如圖9 的第1 行所示.

圖9 具有典型特征的零件攝影測量位姿估計與視點規劃Fig.9 The pose estimation and viewpoint planning of part with typical features for photogrammetry

圖9 中第1 行~第5 行分別展示了3D 打印件的原始圖像、位姿估計可視化結果、網絡訓練結果、最優掃描路徑和攝影重建結果.圖9(a)~9(c)表明所提的機器人攝影測量策略適用于常規的零件,包括球體、柱體和凹臺,具有一定的通用性,更多的目標物體只需要按照本文方法進行位姿估計、可見性計算、測量規劃等工作.由圖中第2 行可見可視化的位姿與被測物體十分吻合,質心坐標重合,結合第3 行測試結果可得出目標包圍盒的估計準確率為100%,同時平移估計精度均優于5 mm,旋轉估計精度優于2°.第4 行給出了最優掃描路徑,其中模型的可見性均滿足無重疊投影的要求.第5 行為利用規劃的視點進行機器人路徑規劃得到的攝影重建結果.

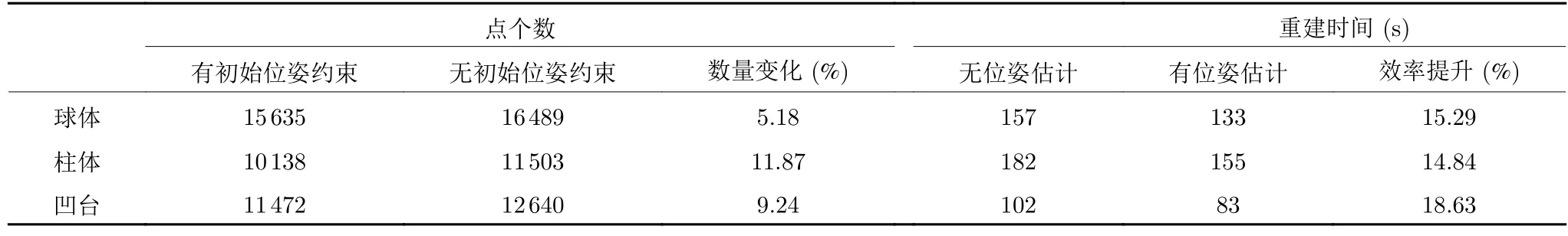

同樣,利用估計的位姿進行攝影測量重建,重建效率對比如表3 所示.本文攝影重建均采用增量式稀疏重建方法,可縮短整體重建時間,由于表2驗證了熵權對于重建質量的提升,此處均采用熵權法進行視點優化求解.

表3 利用深度學習位姿估計的攝影測量效率對比Table 3 Comparison on effectiveness of photogrammetry with estimated pose using deep learning

由表3 可以看出,考慮初始位姿約束的情況下,三種模型重建的點云數量均略有減少,這說明本文方法更加適合稀疏點云的快速重建,而不能獲得稠密的攝影重建.而融合了位姿估計的攝影測量系統效率均有所提升,球體、柱體、凹臺零件重建效率分別提升15.29%、14.84%和18.63%,因為利用深度學習的方法進行位姿估計節省了傳統攝影測量中位姿依賴本質矩陣分解的計算時間.綜上分析,融合了初始位姿估計的機器人攝影測量可實現快速稀疏點云重建,而利用深度學習替代傳統依賴特征計算的方法對于攝影測量具有重大意義.

4 結束語

提出一種基于深度學習初始位姿估計的機器人攝影測量系統視點規劃方法,實現了利用單相機快速位姿估計,平移精度優于5 mm,角度精度優于2°.提出基于相機成像映射的可見性矩陣計算.利用所提的視點規劃策略提升了攝影測量重建的效率.對幾種具有典型特征的零件進行攝影測量,本文方法在位姿估計、重建效率方面均表現優異,重建質量因初始位姿約束有所下降,故適用于快速稀疏攝影重建.本文方法促進了機器人攝影測量系統現場測量的智能性、靈活性和自動化程度,對工業攝影測量具有重要的推進意義.

本文網絡為開源網絡,為擴展網絡應用價值,公開本文中圓柱體模型的數據集供同行使用.本文所使用的模型均來自英國諾丁漢大學制造測量團隊.